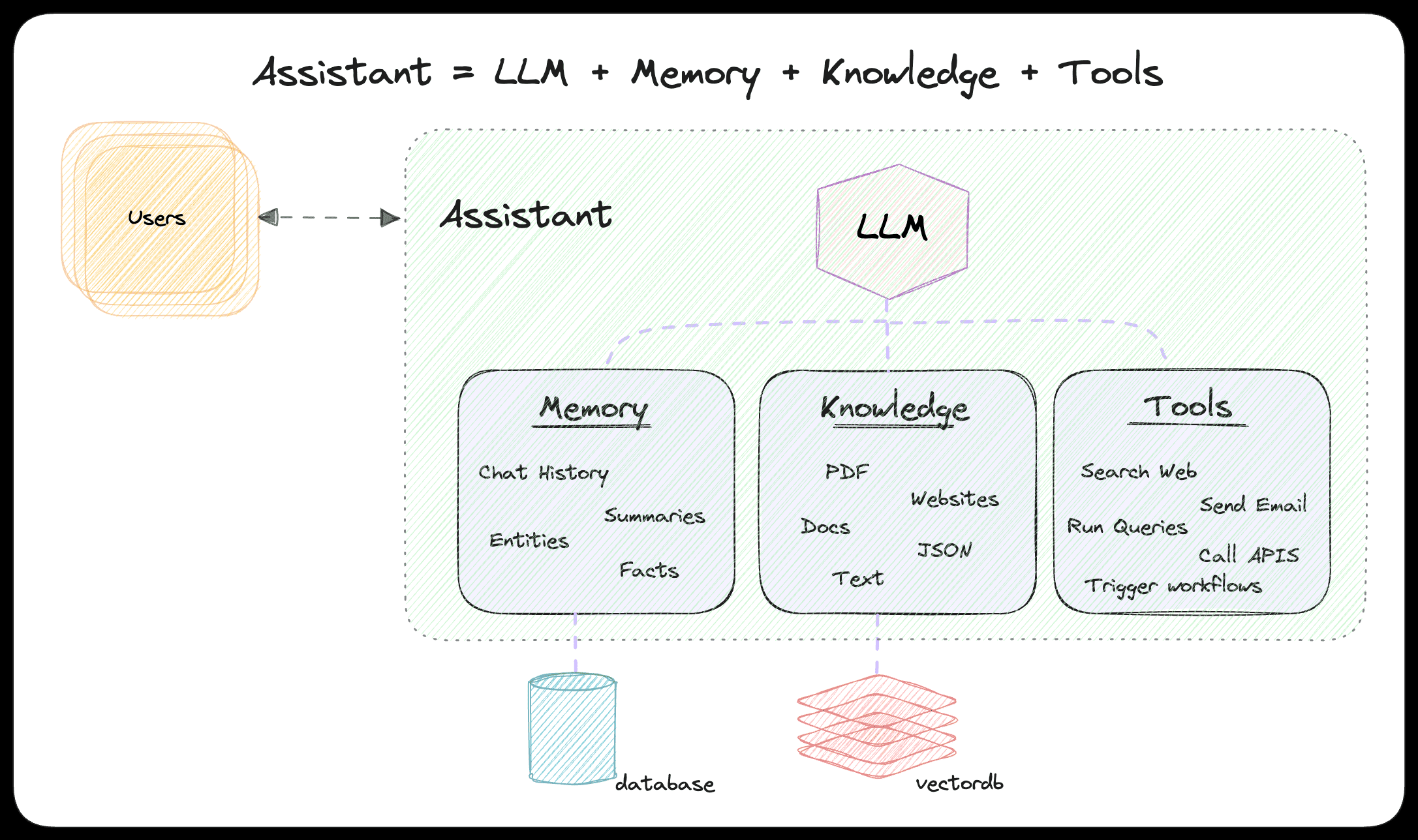

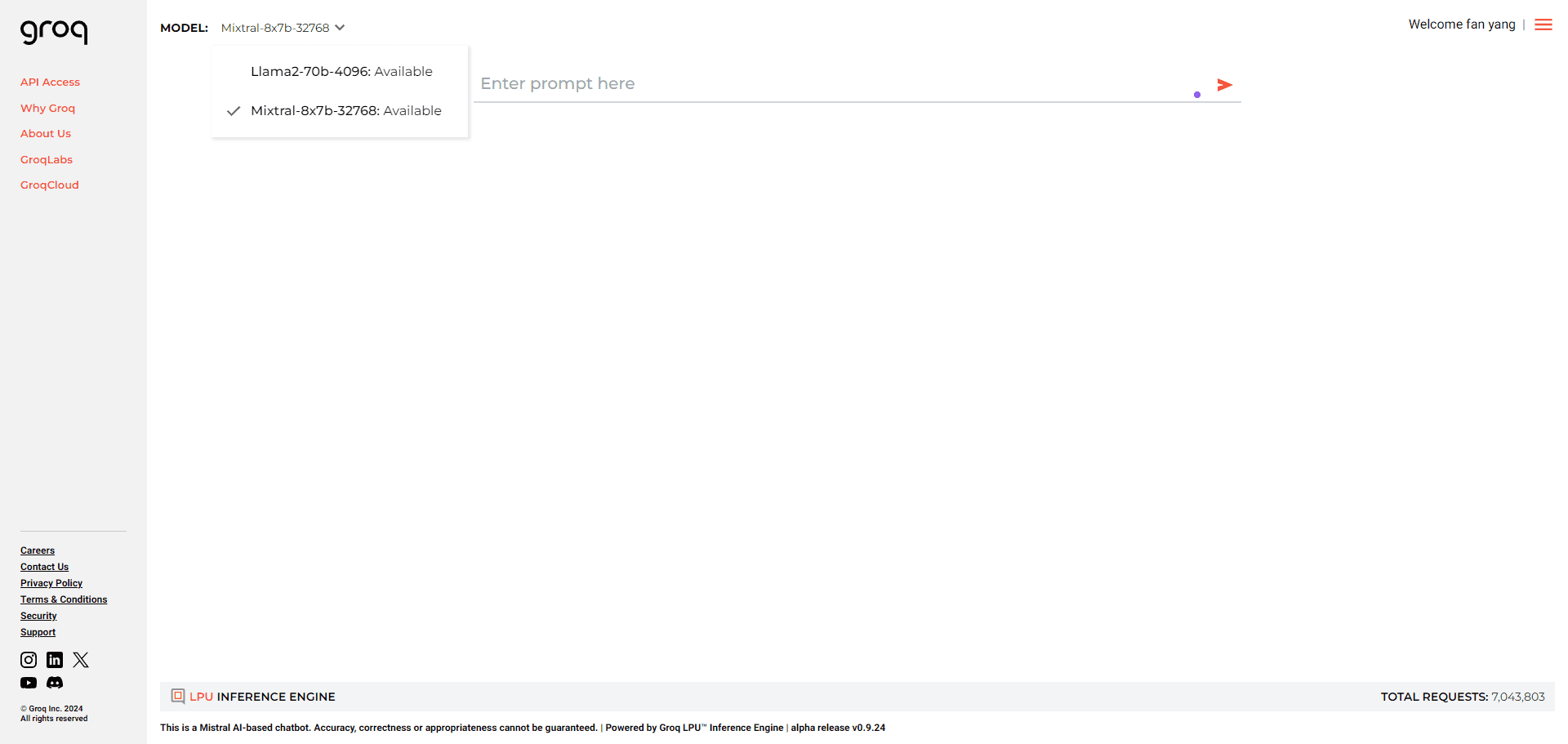

Groq: provedor de soluções de aceleração de inferência de modelo grande de IA, interface de modelo grande gratuita e de alta velocidade

Introdução geral ao Groq

A Groq, uma empresa sediada em Mountain View, Califórnia, desenvolveu o GroqChip™ e a Language Processing Unit™ (LPU). Conhecida por suas unidades de processamento de tensores desenvolvidas para aplicativos de IA de baixa latência.

A Groq foi fundada em 2016 e seu nome foi oficialmente registrado no mesmo ano. O principal produto da Groq é a Unidade de Processamento de Linguagem (LPU), uma nova classe de chips projetados não para treinar modelos de IA, mas para executá-los rapidamente, linguagem natural) e superar o desempenho das GPUs.

Seu objetivo é fornecer soluções para aplicativos de IA em tempo real, reivindicando desempenho líder de IA em centros de computação, caracterizado por velocidade e precisão. O Groq oferece suporte a estruturas padrão de aprendizado de máquina, como PyTorch, TensorFlow e ONNX. Além disso, eles oferecem o pacote GroqWare™, que inclui ferramentas para desenvolvimento personalizado e otimização de cargas de trabalho, como o Groq Compiler.

Lista de recursos do Groq

- Processamento de aplicativos de IA em tempo real

- Suporte para estruturas padrão de aprendizado de máquina

- Suporte para hardware leve de SaaS e PaaS

- Oferecendo desempenho de IA rápido e preciso

- GroqWare™ Suite para cargas de trabalho personalizadas e otimizadas

- Garantia de um desempenho de inferência em larga escala preciso, eficiente em termos de energia e repetível

Ajuda do Groq

- Os desenvolvedores podem fornecer acesso de desenvolvedor por conta própria via Playground no GroqCloud

- Se você estiver usando atualmente a API OpenAI, precisará apenas de três coisas para converter para o Groq: uma chave de API do Groq, um ponto de extremidade, um modelo

- Se você precisa do raciocínio mais rápido em escala de data center, devemos conversar

Você pode.Clique aquiSolicite o APIKEY gratuitamente e escolha o modelo após a conclusão da solicitação:

Conclusão do bate-papo

| ID | Solicitações por minuto | Solicitações por dia | Tokens por minuto | Tokens por dia |

|---|---|---|---|---|

| gemma-7b-it | 30 | 14,400 | 15,000 | 500,000 |

| gemma2-9b-it | 30 | 14,400 | 15,000 | 500,000 |

| llama-3.1-70b-versatile | 30 | 14,400 | 20,000 | 500,000 |

| llama-3.1-8b-instant | 30 | 14,400 | 20,000 | 500,000 |

| llama-3.2-11b-text-preview | 30 | 7,000 | 7,000 | 500,000 |

| llama-3.2-1b-preview | 30 | 7,000 | 7,000 | 500,000 |

| llama-3.2-3b-preview | 30 | 7,000 | 7,000 | 500,000 |

| llama-3.2-90b-text-preview | 30 | 7,000 | 7,000 | 500,000 |

| llama-guard-3-8b | 30 | 14,400 | 15,000 | 500,000 |

| llama3-70b-8192 | 30 | 14,400 | 6,000 | 500,000 |

| llama3-8b-8192 | 30 | 14,400 | 30,000 | 500,000 |

| llama3-groq-70b-8192-tool-use-preview | 30 | 14,400 | 15,000 | 500,000 |

| llama3-groq-8b-8192-tool-use-preview | 30 | 14,400 | 15,000 | 500,000 |

| llava-v1.5-7b-4096-preview | 30 | 14,400 | 30,000 | (Sem limite) |

| mixtral-8x7b-32768 | 30 | 14,400 | 5,000 | 500,000 |

Fala para texto

| ID | Solicitações por minuto | Solicitações por dia | Segundos de áudio por hora | Segundos de áudio por dia |

|---|---|---|---|---|

| distil-whisper-large-v3-pt | 20 | 2,000 | 7,200 | 28,800 |

| whisper-large-v3 | 20 | 2,000 | 7,200 | 28,800 |

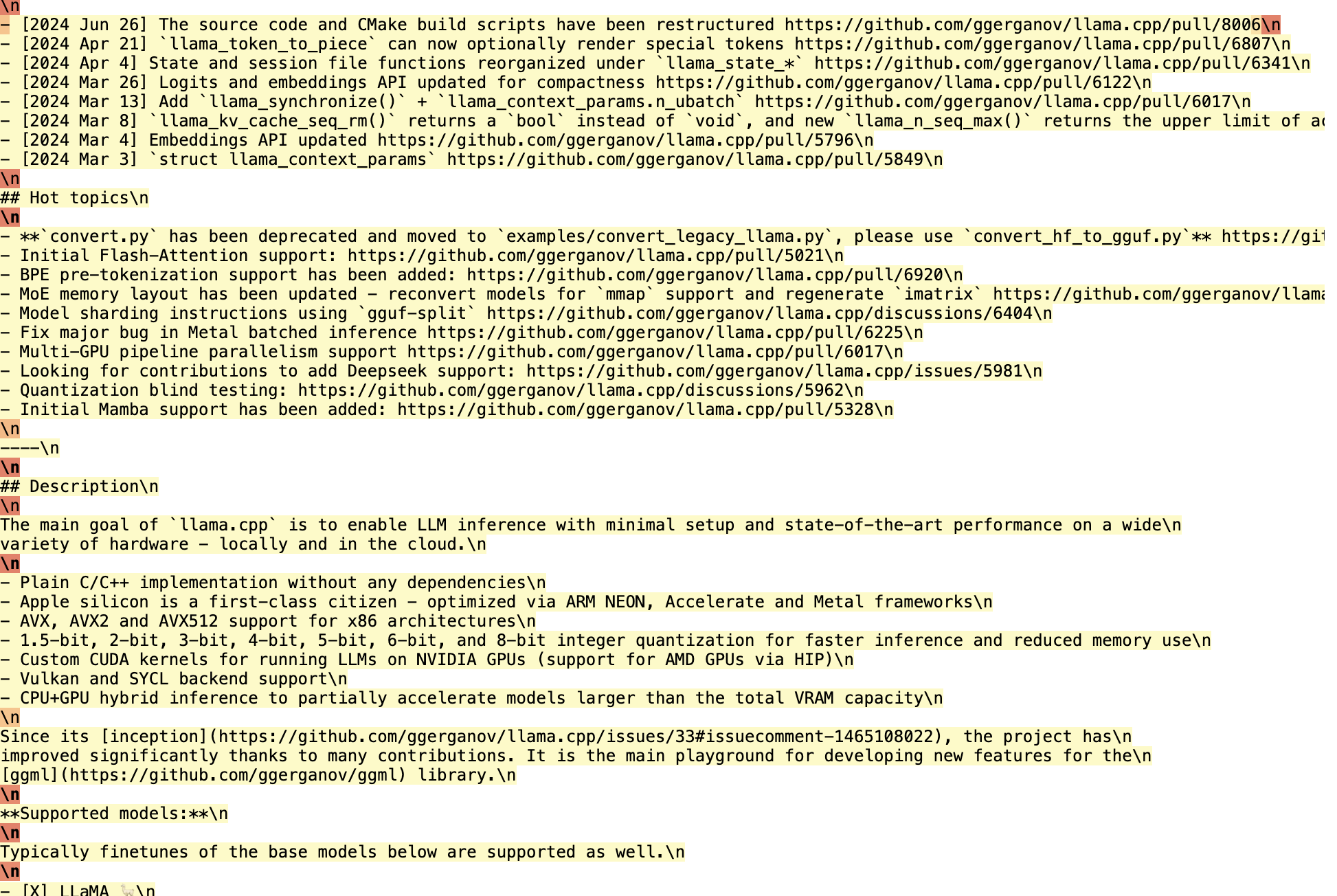

Em seguida, tome o formato curl como exemplo, essa interface é compatível com o formato da interface OPENAI, portanto, use sua imaginação, desde que haja interfaces que permitam a personalização da API OPENAI, bem como o uso do Groq.

curl -X POST "https://api.groq.com/openai/v1/chat/completions" \

-H "Autorização: Portador $GROQ_API_KEY" \

-H "Content-Type: application/json" \

-d '{"messages": [{"role": "user", "content": "Explain the importance of low latency LLMs"}], "model": "mixtral-8x7b-32768"}'

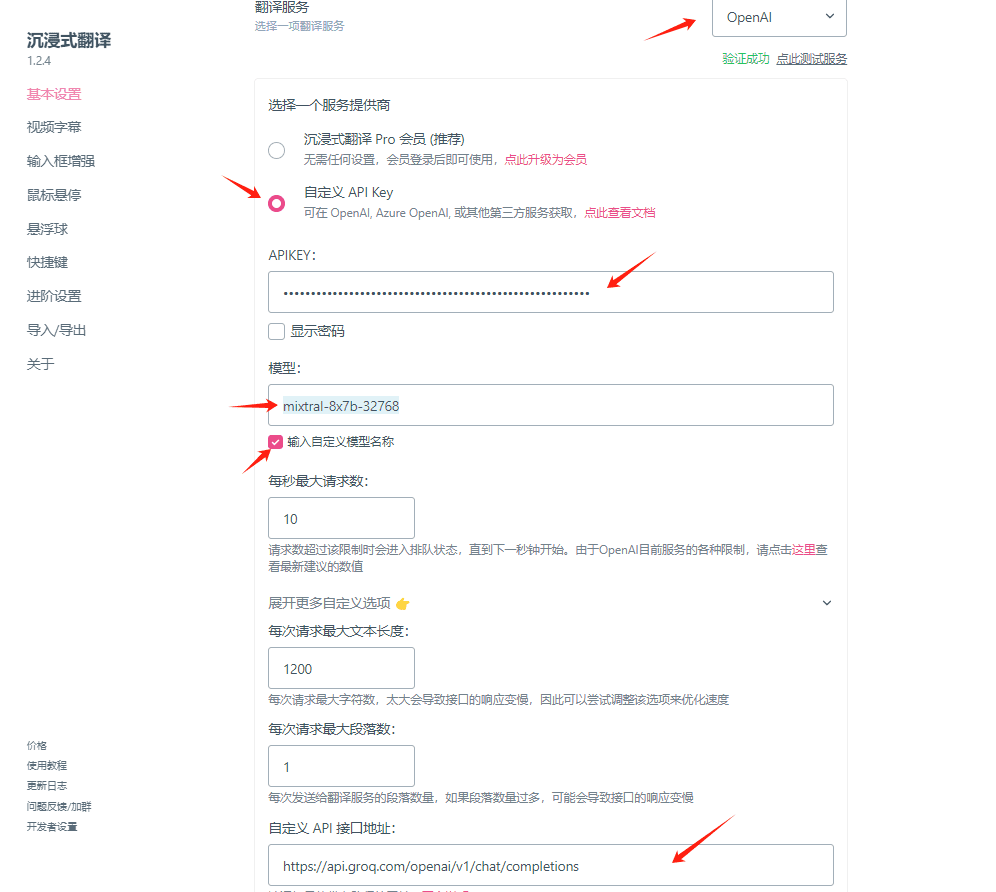

Exemplo de uso: Configuração de chaves Groq para uso no plug-in de tradução imersiva

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...