O Google lança o modelo Gemma 3 QAT: trazendo os melhores modelos de IA para as GPUs dos consumidores

Após o lançamento de uma nova geração de modelos abertos no mês passado Gemma 3 Recentemente, o Google expandiu seu ecossistema de modelos com uma nova versão otimizada para o treinamento com reconhecimento de quantização (QAT). O Gemma 3 foi usado anteriormente em BF16 A precisão é menor do que a de uma única GPU de ponta (por exemplo NVIDIA H100A versão QAT foi projetada para reduzir significativamente os requisitos de memória dos modelos e, ao mesmo tempo, manter a saída da mais alta qualidade possível, permitindo que modelos avançados de IA sejam executados em um hardware mais adequado ao consumidor. A versão QAT, no entanto, foi projetada para reduzir significativamente os requisitos de memória do modelo e, ao mesmo tempo, manter a mais alta qualidade de saída possível, permitindo que modelos avançados de IA sejam executados em um hardware mais adequado ao consumidor.

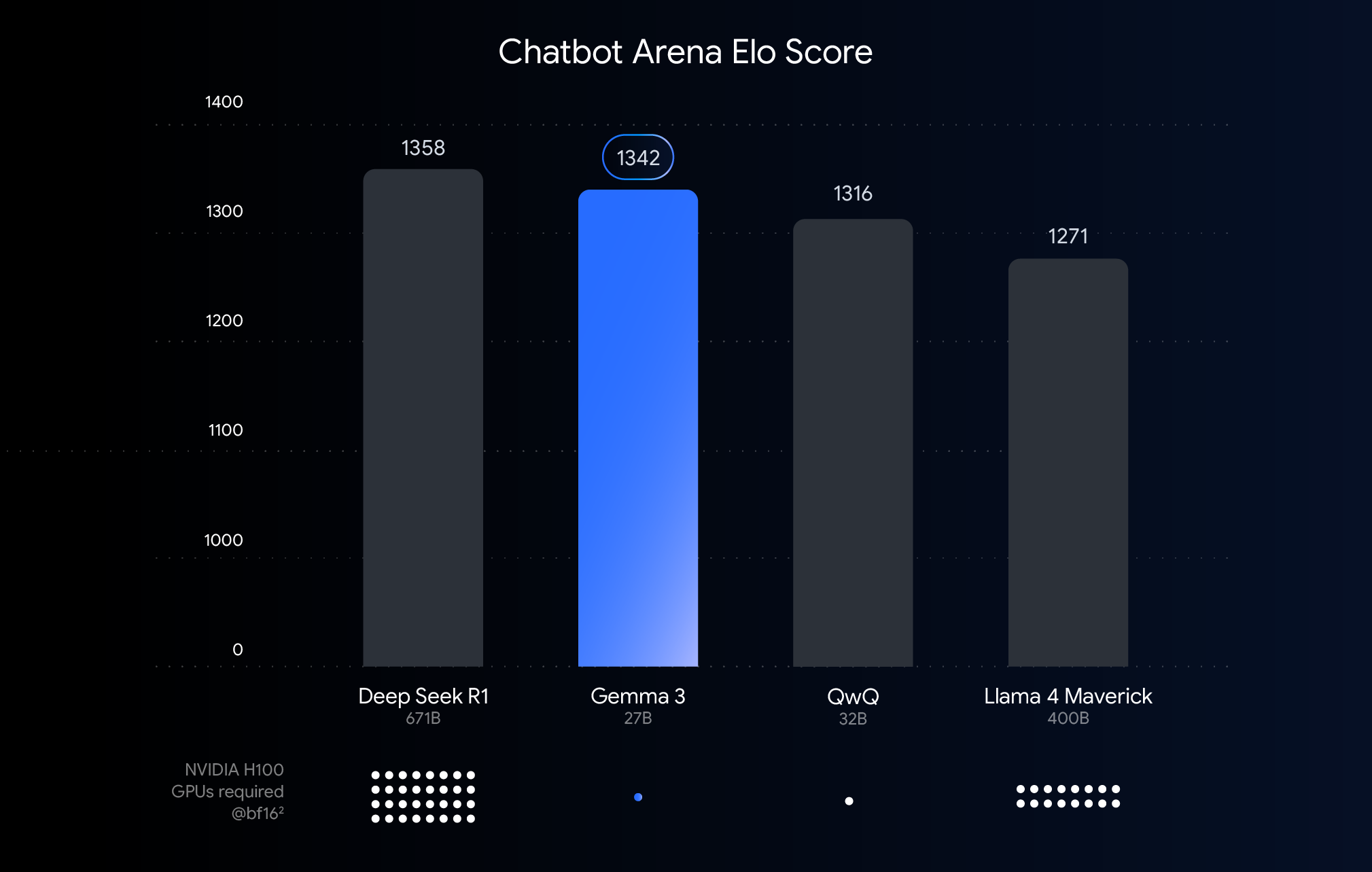

Este gráfico classifica os modelos de IA com base nas pontuações Elo do Chatbot Arena, sendo que as pontuações mais altas representam maior preferência do usuário. Os pontos indicam o que o modelo precisa para ser executado NVIDIA H100 O número estimado de GPUs.

Compreensão dos limites de desempenho, precisão e quantificação

O gráfico acima mostra uma comparação do desempenho (pontuações Elo) de modelos de linguagem grandes lançados recentemente. Barras mais altas significam que os modelos têm melhor desempenho em comparações anônimas lado a lado realizadas por avaliadores humanos. A parte inferior do gráfico rotula o desempenho no BF16 necessário para executar cada modelo no tipo de dados NVIDIA H100 Número estimado de GPU.

opção BF16 A comparação é feita porque esse é um formato numérico comumente usado para muitas inferências de modelos em larga escala, representando parâmetros de modelos armazenados com precisão de 16 bits. No caso do modelo unificado BF16 As comparações com a configuração ajudam a avaliar os recursos inerentes do próprio modelo na mesma configuração de inferência, excluindo as variáveis introduzidas por diferentes hardwares ou técnicas de otimização, como a quantificação.

Vale a pena observar que, embora o gráfico use BF16 faz uma comparação justa, mas na implantação real de modelos muito grandes, para reduzir a enorme demanda de hardware (por exemplo, o número de processadores gráficos), muitas vezes é necessário usar um sistema como o FP8 e outros formatos de menor precisão, o que pode exigir uma compensação entre desempenho e viabilidade.

Rompendo barreiras de hardware: tornando a IA mais acessível

Embora o Gemma 3 tenha um bom desempenho em hardware de ponta para implementações em nuvem e cenários de pesquisa, o feedback dos usuários indica claramente que o mercado espera poder utilizar os recursos do Gemma 3 no hardware existente. Impulsionar a adoção de tecnologias avançadas de IA significa que os modelos precisam ser executados com eficiência em GPUs de nível de consumidor, comumente encontradas em desktops, laptops e até mesmo em dispositivos móveis. A execução de modelos grandes localmente não apenas aumenta a privacidade dos dados, reduz a latência da rede e oferece suporte a aplicativos off-line, mas também oferece mais espaço para a personalização do usuário.

Tecnologia QAT: a chave para equilibrar desempenho e acessibilidade

As técnicas de quantificação são fundamentais para atingir esse objetivo. Na modelagem de IA, a quantização visa reduzir a precisão dos números (ou seja, parâmetros do modelo) usados no armazenamento e na computação do modelo. Isso é semelhante à compactação de uma imagem, reduzindo o número de cores usadas na imagem. Em comparação com o uso de 16 bits por número (BF16), a quantificação pode usar menos bits, por exemplo, 8 bits (int8) ou até mesmo de 4 bits (int4).

adoção int4 Isso significa que cada dígito é representado por apenas 4 bits e o tamanho dos dados é menor do que o tamanho do BF16 Reduzido por um fator de 4. Os métodos tradicionais de quantificação (por exemplo, quantificação pós-treinamento PTQ) geralmente são executados depois que o modelo foi treinado, o que é fácil de implementar, mas pode levar a uma degradação significativa do desempenho. A técnica de QAT usada pelo Google é diferente.

O QAT introduz uma etapa de quantificação durante o treinamento do modelo para simular operações de baixa precisão. Essa abordagem permite que o modelo se adapte ao ambiente de baixa precisão enquanto ainda está em treinamento, o que permite manter melhor a precisão durante a quantificação subsequente, possibilitando modelos menores e mais rápidos. Especificamente, o Google aplicou aproximadamente 5.000 etapas de QAT ao modelo Gemma 3, visando à probabilidade de um ponto de verificação não quantificado. Dessa forma, afirma-se que, após a quantificação para Q4_0 A perplexidade, uma medida da capacidade de previsão do modelo, diminui em 54% quando o formato (usando o llama.cpp (Avaliação).

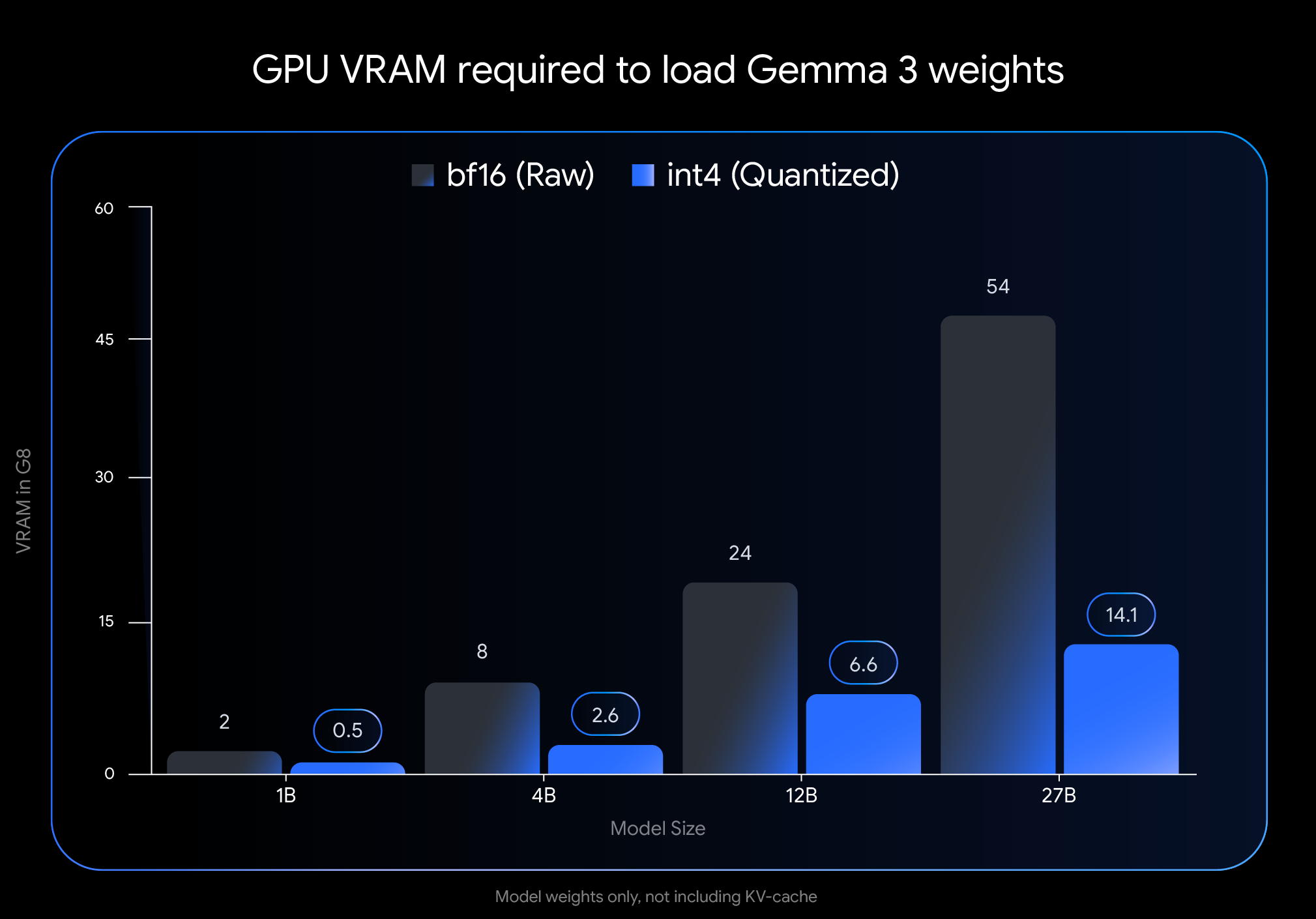

Efeito significativo: o uso de VRAM é reduzido drasticamente

int4 O impacto da quantificação é significativo, especialmente em termos da quantidade de memória de vídeo (VRAM) necessária para carregar os pesos do modelo:

- Gemma 3 27B. A partir de 54 GB (

BF16) para 14,1 GB (int4) - Gemma 3 12B. A partir de 24 GB (

BF16) Redução para 6,6 GB (int4) - Gemma 3 4B. A partir de 8 GB (

BF16) Reduzido para 2,6 GB (int4) - Gemma 3 1B. A partir de 2 GB (

BF16) para 0,5 GB (int4)

Cuidado. Esses dados representam apenas a VRAM necessária para carregar os pesos do modelo. A execução do modelo também requer VRAM adicional para o cache KV, que armazena informações de contexto de diálogo, cujo tamanho depende do comprimento do contexto.

Execute o Gemma 3 em seu dispositivo!

A redução drástica dos requisitos de memória gráfica possibilita a execução de modelos maiores e mais avançados em hardware de nível de consumidor amplamente disponível:

- Gemma 3 27B (

int4): Agora é fácil de executar em uma única classe de desktop com 24 GB de VRAMNVIDIA RTX 3090ou placas de vídeo semelhantes, os usuários puderam executar localmente a maior variante Gemma 3 do Google. - Gemma 3 12B (

int4): A capacidade de usar uma GPU de laptop com 8 GB de VRAM, como aNVIDIA RTX 4060 Laptop GPUA empresa também traz recursos avançados de IA para dispositivos portáteis. - Modelos menores (4B, 1B). Oferece maior acessibilidade a sistemas com recursos mais limitados, incluindo alguns dispositivos móveis.

Fácil integração com as principais ferramentas

Para facilitar aos usuários o uso desses modelos em seus próprios fluxos de trabalho, o Google criou o Hugging Face responder cantando Kaggle O oficial int4 responder cantando Q4_0 Modelos QAT não quantificados. Ao mesmo tempo, o Google fez uma parceria com várias ferramentas de desenvolvimento populares para permitir que os usuários experimentem sem problemas os pontos de verificação quantificados baseados em QAT:

- Ollama. Rápido de executar com um simples comando, todos os modelos Gemma 3 QAT são suportados nativamente.

- Estúdio LM. Fornece uma interface amigável para baixar e executar facilmente os modelos Gemma 3 QAT no seu desktop.

- MLX. Utilizar

MLXA estrutura está emApple SiliconInferência eficiente e otimizada dos modelos Gemma 3 QAT no - Gemma.cpp. Uma implementação C++ dedicada do Google para inferência eficiente na CPU.

- llama.cpp. Suporte nativo para modelos QAT no formato GGUF para facilitar a integração em fluxos de trabalho existentes.

Mais opções quantitativas na ecologia do Gemmaverse

Além do modelo de QAT publicado oficialmente, o Gemmaverse A comunidade também oferece muitas alternativas. Esses esquemas normalmente usam técnicas de quantificação pós-treinamento (PTQ), que são usadas pelo Bartowski, Unsloth, GGML e outras contribuições de membros da comunidade, e em Hugging Face Disponível em. A exploração dessas opções de comunidade oferece aos usuários uma gama mais ampla de opções para compensações entre tamanho, velocidade e qualidade do modelo para atender a necessidades específicas.

Comece agora!

Trazer o desempenho de IA de ponta para um hardware de fácil acesso é uma etapa essencial para democratizar o desenvolvimento da IA. Com os modelos Gemma 3 otimizados por meio do QAT, os usuários agora podem aproveitar os recursos de IA de ponta em seu próprio desktop ou laptop. Isso não apenas reduz a barreira para que desenvolvedores e pesquisadores explorem modelos de linguagem em larga escala, mas também sinaliza o potencial para aplicativos de IA de ponta mais avançados.

Explore modelos quantitativos e comece a criá-los:

- Uso em um PC

OllamaEm execução:https://ollama.com/library/gemma3 - existir

Hugging Faceresponder cantandoKaggleProcure o modelo em: - Funciona em dispositivos móveis (via

Google AI Edge):https://developers.googleblog.com/en/gemma-3-on-mobile-and-web-with-google-ai-edge/

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...