glhf.chat: executa quase (todos) os grandes modelos de código aberto, acesso gratuito a recursos de GPU e serviços de API (período beta)

Introdução geral

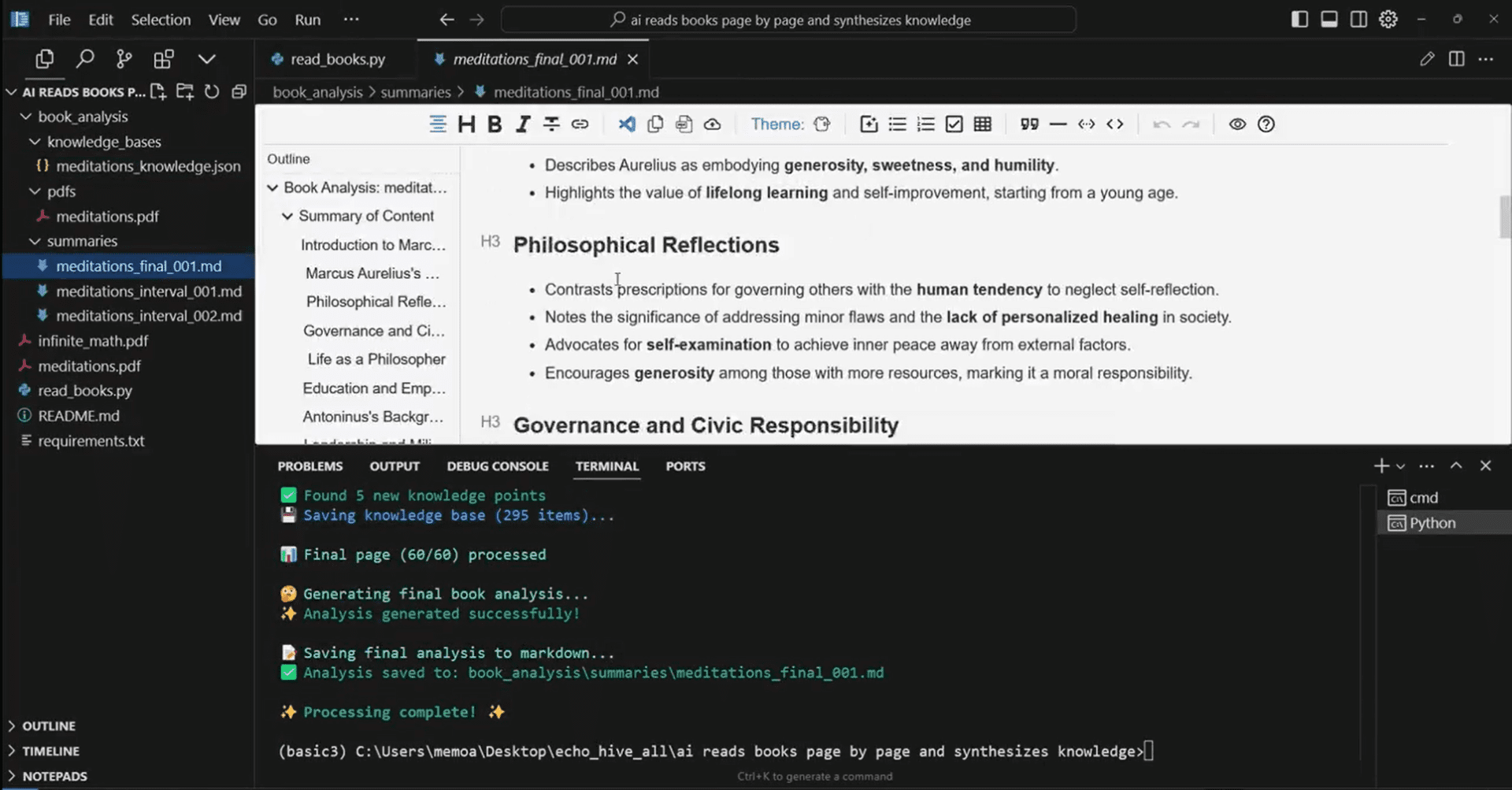

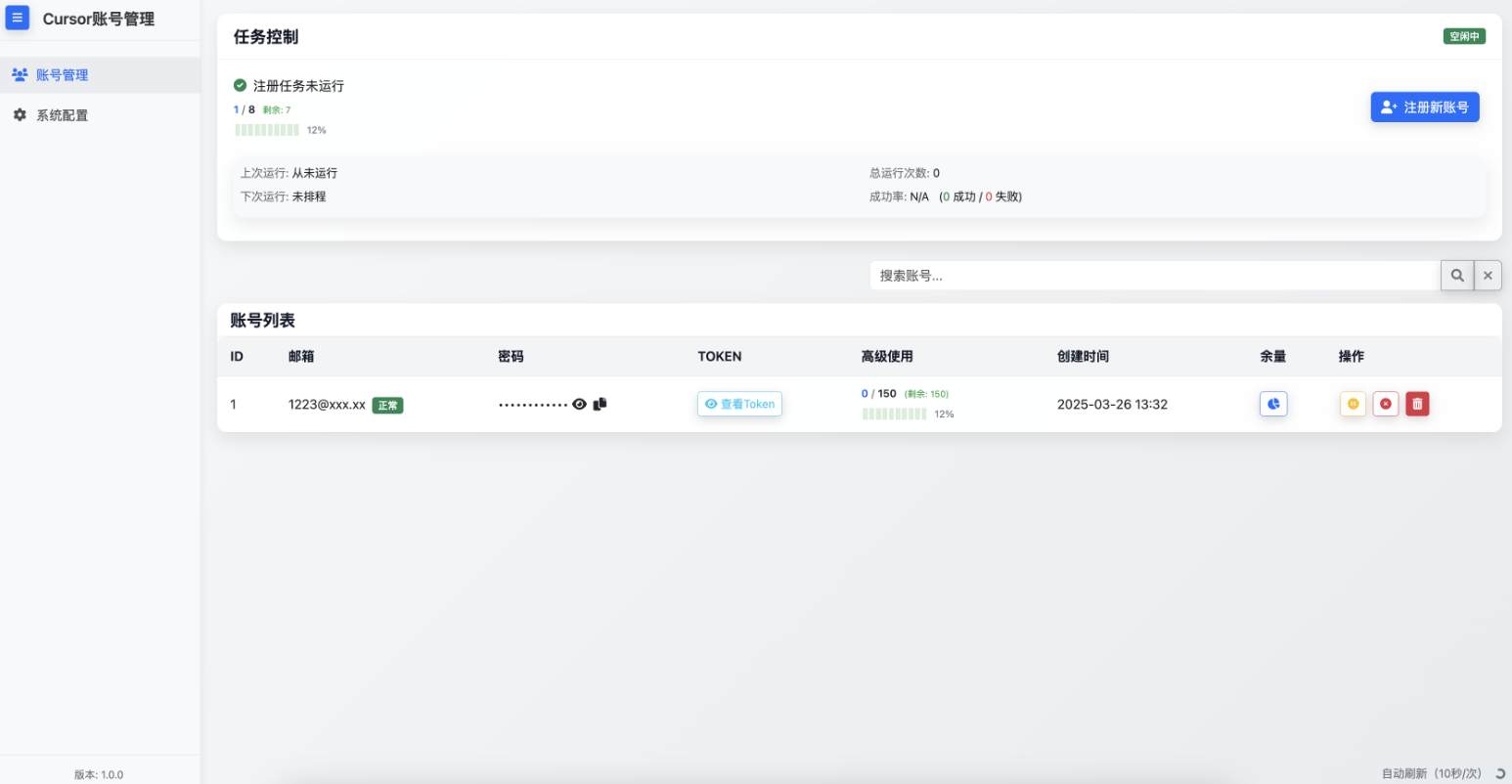

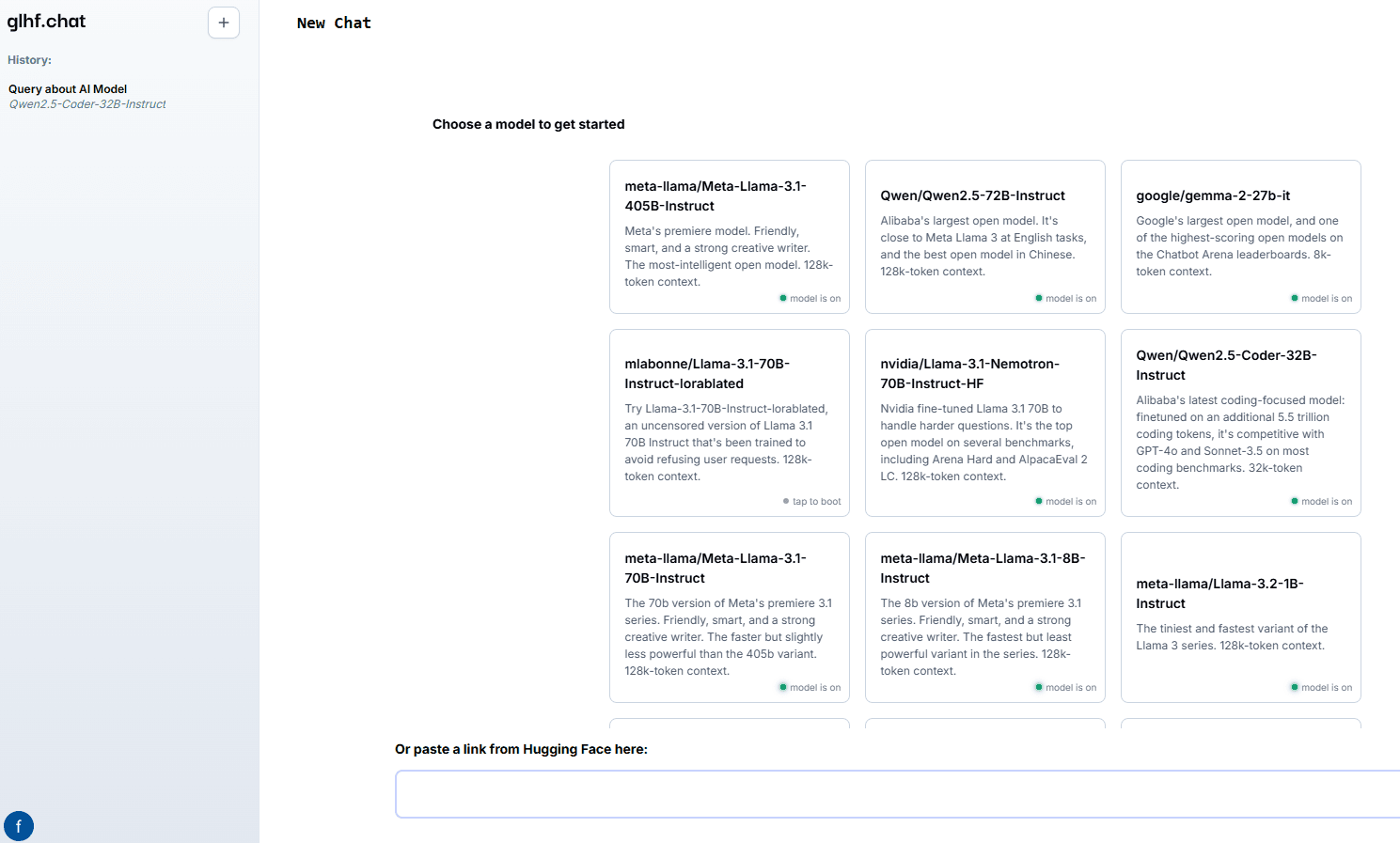

good luck have fun (glhf.chat) é um site que oferece um serviço de bate-papo de modelo grande de código aberto. A plataforma permite que os usuários executem praticamente qualquer modelo grande de código aberto usando o vLLM e um agendador de GPU de dimensionamento automático personalizado. Os usuários podem simplesmente colar um link no repositório do Hugging Face e interagir usando a interface de bate-papo ou APIs compatíveis com OpenAI. A plataforma está sendo oferecida gratuitamente durante o período beta e estará disponível no futuro a um preço mais baixo do que os principais provedores de GPU em nuvem.

Lista de funções

- Oferece suporte a uma variedade de macromodelos de código aberto, incluindo Meta Llama, Qwen, Mixtral etc.

- Fornece acesso a até oito GPUs Nvidia A100 de 80 Gb

- Serviços de raciocínio para modelos de população de agentes automatizados

- Inicialização e desligamento sob demanda de clusters para otimizar o uso de recursos

- Fornece APIs compatíveis com OpenAI para facilitar a integração

Usando a Ajuda

Instalação e uso

- Registro e login: Acessoglhf.chate registre-se para obter uma conta e faça login quando terminar.

- Selecione o modeloSelecione o macromodelo desejado na página inicial da plataforma. Os modelos compatíveis incluem Meta Llama, Qwen, Mixtral e outros.

- Colar o linkColar o link do repositório Hugging Face no local especificado e a plataforma carregará automaticamente o modelo.

- Usando a interface de bate-papoInteraja com o modelo por meio da interface de bate-papo fornecida no site, digitando perguntas ou comandos, e o modelo gerará respostas em tempo real.

- Integração de APIIntegração: Integre a funcionalidade da plataforma em seus próprios aplicativos usando APIs compatíveis com a OpenAI, conforme detalhado na documentação da API na Central de Ajuda do site.

Fluxo de operação detalhado da função

- Seleção e carregamento de modelos::

- Depois de fazer o login, você será levado à página de seleção de modelos.

- Navegue pela lista de modelos compatíveis e clique no modelo desejado.

- Cole o link para o repositório do Hugging Face na caixa de diálogo pop-up e clique no botão "Load Model" (Carregar modelo).

- Aguarde até que o modelo termine de carregar. O tempo de carregamento depende do tamanho do modelo e das condições da rede.

- Uso da interface de bate-papo::

- Depois que o modelo for carregado, entre na tela de bate-papo.

- Digite uma pergunta ou instrução na caixa de entrada e clique em Enviar.

- O modelo gera uma resposta com base na entrada e a resposta é exibida na janela de bate-papo.

- Várias perguntas ou comandos podem ser inseridos em sucessão, e o modelo processará e responderá a eles um a um.

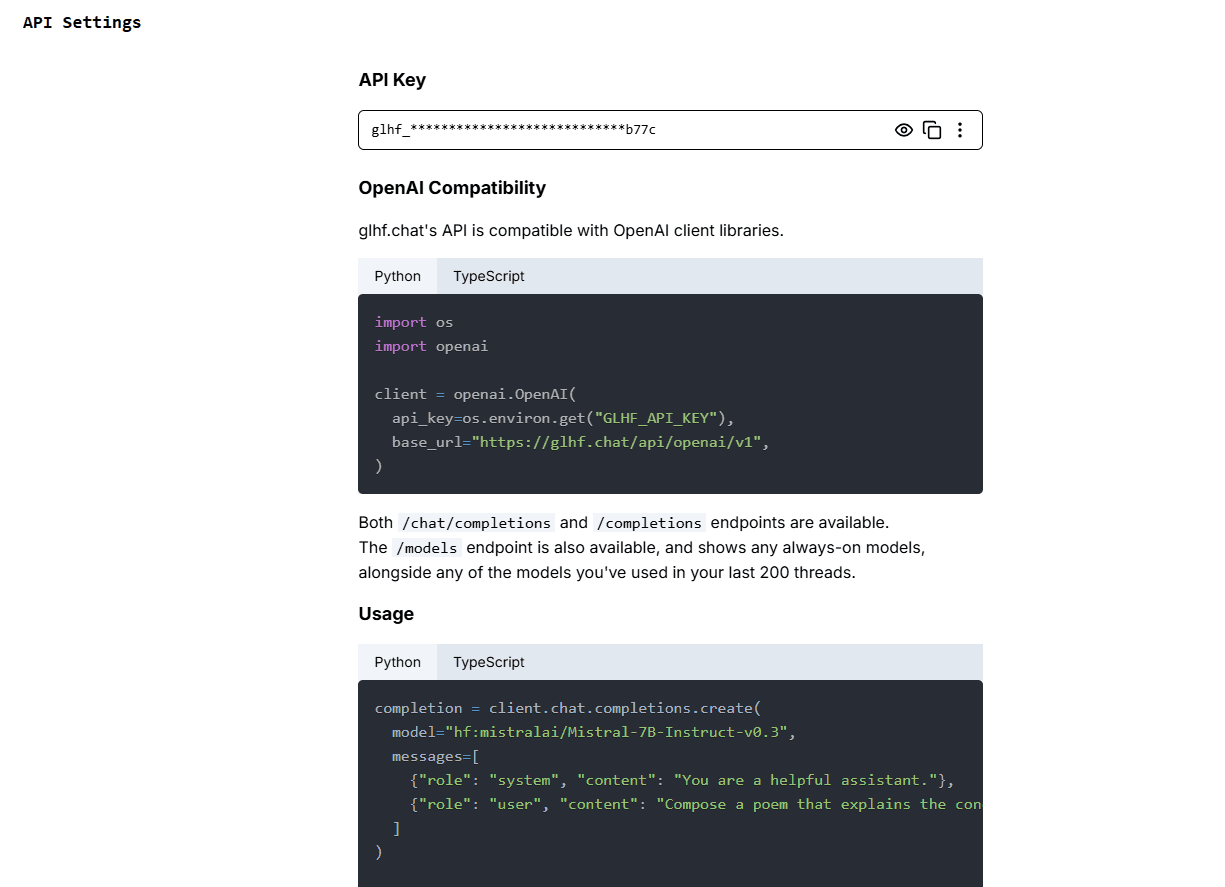

- Uso da API::

- Visite a página de documentação da API para obter as chaves e instruções da API.

- Integre a API em seu aplicativo e siga o código de exemplo fornecido na documentação para fazer chamadas.

- Envie uma solicitação por meio da API para obter uma resposta gerada por modelo.

- A API é compatível com várias linguagens de programação; consulte a documentação para obter um código de amostra específico.

Gerenciamento e otimização de recursos

- Expansão automáticaA plataforma usa um agendador de GPU personalizado que aumenta e diminui automaticamente os recursos de GPU com base na demanda do usuário para garantir uma utilização eficiente.

- ativação sob demandaPara modelos que não são usados com frequência, a plataforma inicia clusters sob demanda e os desliga automaticamente quando são usados, economizando recursos.

- Teste gratuitoDurante o período de teste beta, os usuários terão acesso gratuito a todos os recursos oferecidos pela plataforma, e um plano de preços com desconto estará disponível no final do teste.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...