FunClip: edição inteligente de conteúdo de vídeo em curtas-metragens, fácil de obter extração/corte precisos de clipes de vídeo

Introdução geral

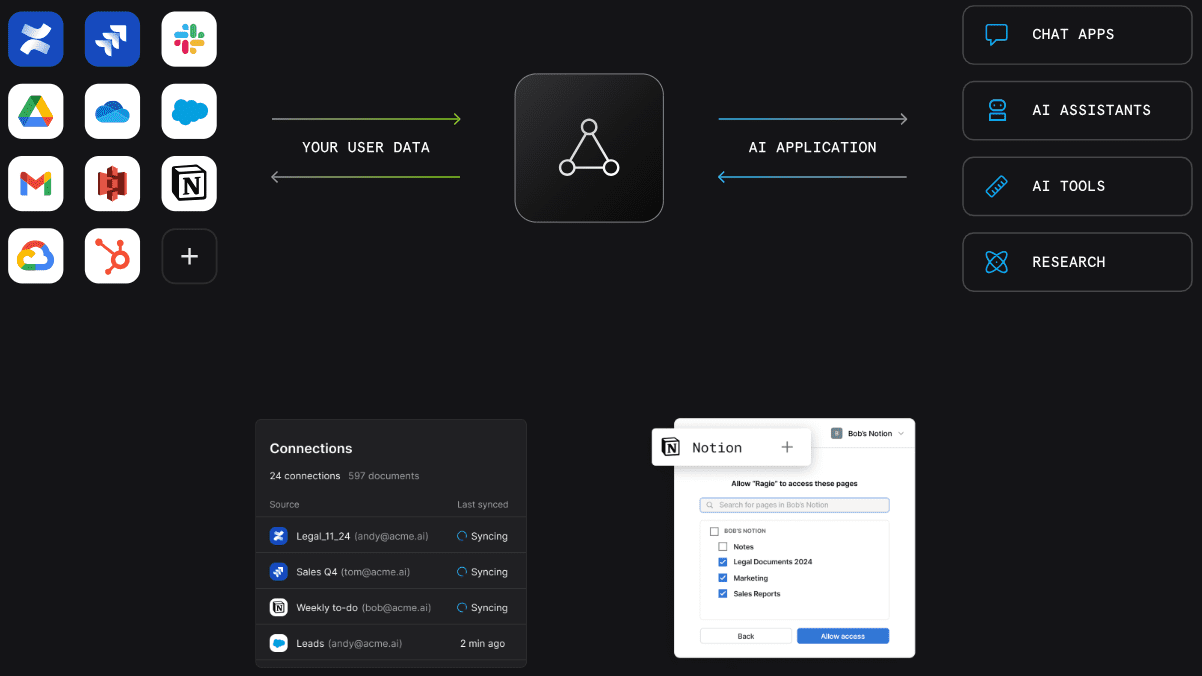

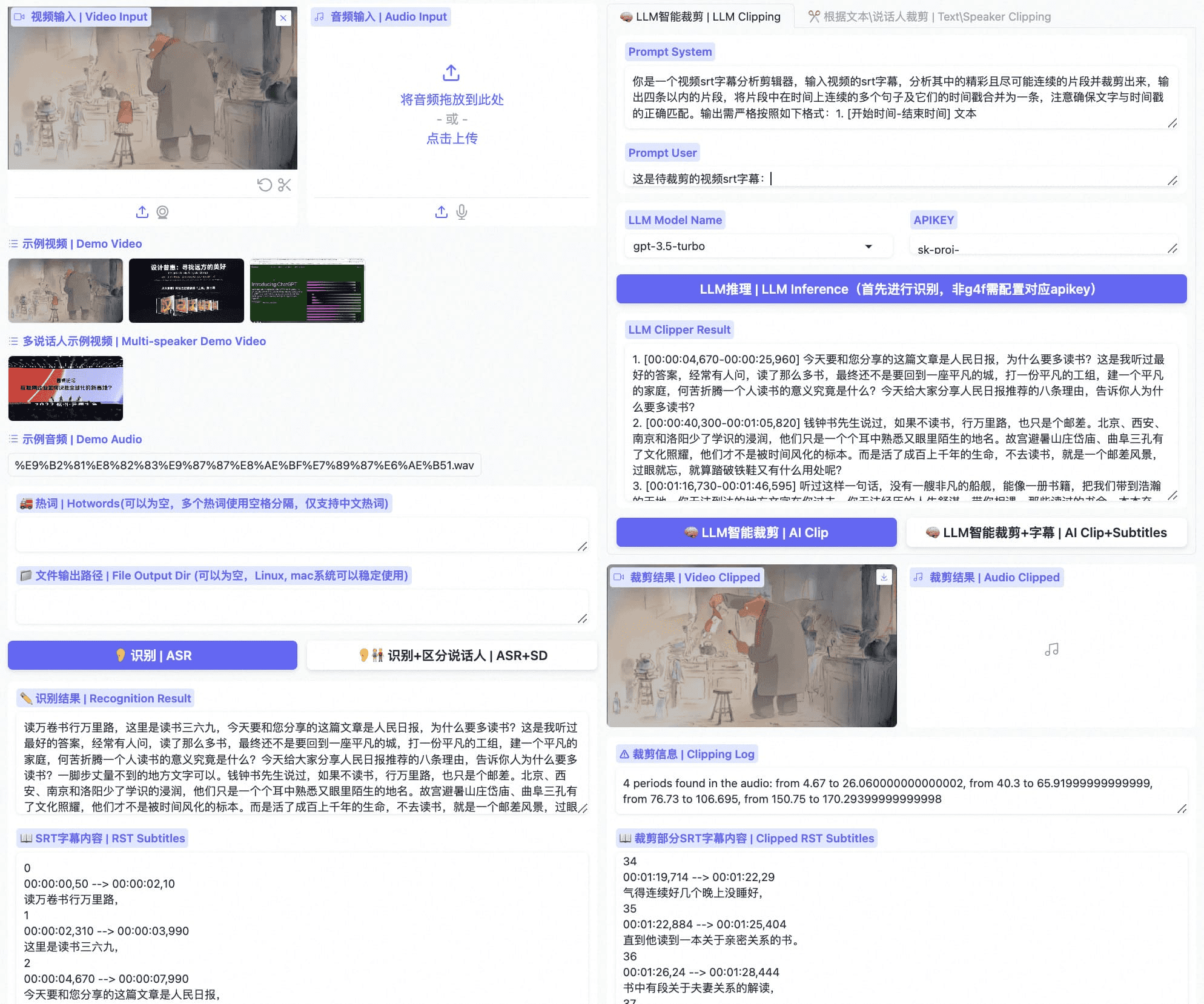

O FunClip é uma ferramenta de edição de vídeo automatizada, localizada e de código aberto, desenvolvida pelo TONGYI Speech Lab do Alibaba Dharma Institute. A ferramenta integra o modelo de reconhecimento de fala Paraformer-Large de nível industrial, que pode identificar com precisão o conteúdo da fala no vídeo e convertê-lo em texto. O recurso especial é que o FunClip oferece suporte à edição inteligente por meio do Large Language Modelling (LLM) e integra o reconhecimento de locutor para identificar automaticamente diferentes locutores. Os usuários podem selecionar os clipes de texto de interesse e exportar os clipes de vídeo correspondentes com um clique, por meio de uma operação de interface simples. A ferramenta é compatível com a edição livre de vários segmentos e pode gerar automaticamente arquivos de legendas SRT completos e legendas para segmentos de destino, proporcionando aos usuários uma experiência de processamento de vídeo simples e conveniente. A versão mais recente é compatível com reconhecimento bilíngue e oferece funções avançadas de incorporação e exportação de legendas, sendo uma ferramenta de processamento de vídeo de código aberto avançada e fácil de usar.

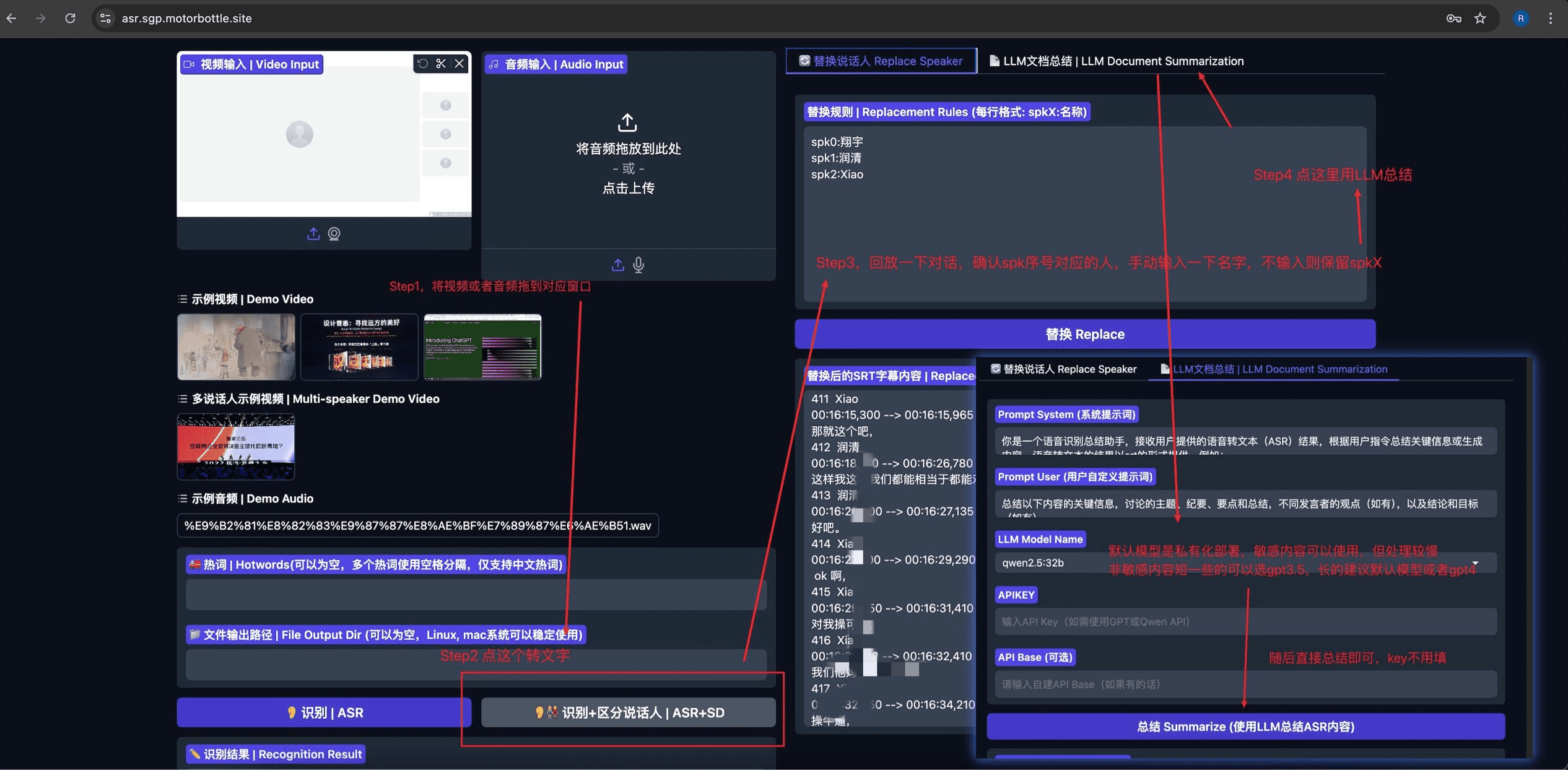

FunClip otimizado - Private-ASR

Privado-ASR Baseado em projetos de código aberto FunClip Modificado para integrar o reconhecimento automático de fala (ASR), a separação de alto-falantes, a edição de legendas SRT e o resumo baseado em LLM. O projeto usa Gradio Oferece uma interface de usuário intuitiva e fácil de usar.

Lista de funções

- Reconhecimento preciso de fala: integração do modelo de código aberto Paraformer-Large da Alibaba, com suporte ao reconhecimento de fala em chinês e inglês.

- LLM Intelligent Clip: oferece suporte à análise inteligente de conteúdo e à determinação automática de pontos de corte por meio de um grande modelo de linguagem

- Reconhecimento de alto-falantes: integração do modelo de reconhecimento de alto-falantes CAM++, que pode reconhecer automaticamente a identidade de diferentes alto-falantes

- Personalização de palavras quentes: suporte à função de personalização de palavras quentes do SeACo-Paraformer para melhorar a precisão do reconhecimento de palavras específicas.

- Edição de vários segmentos: suporta a seleção livre de vários segmentos de texto para edição em lote

- Geração de legendas: gera automaticamente legendas SRT de vídeo completo e legendas de clipes de destino.

- Suporte bilíngue: suporta reconhecimento e edição de vídeo em chinês e inglês

- Implementação local: código-fonte totalmente aberto, suporte para implementação local, proteção da privacidade e segurança dos dados

- Interface amigável: com base no desenvolvimento da estrutura Gradio, oferece uma interface da Web simples e intuitiva

Usando a Ajuda

1. instalação e implementação

Instalação básica do ambiente

- Clonar o repositório de código:

git clone https://github.com/alibaba-damo-academy/FunClip.git

cd FunClip

- Instale as dependências do Python:

pip install -r ./requirements.txt

Instalação de recurso opcional (para legendas incorporadas)

Para usar o recurso de incorporação de legendas, você precisa instalar o ffmpeg e o imagemagick:

- Ubuntu:

apt-get -y update && apt-get -y install ffmpeg imagemagick

sed -i 's/none/read,write/g' /etc/ImageMagick-6/policy.xml

- MacOS:

brew install imagemagick

sed -i 's/none/read,write/g' /usr/local/Cellar/imagemagick/7.1.1-8_1/etc/ImageMagick-7/policy.xml

- Windows:

- Faça o download e instale o imagemagick no site oficial: https://imagemagick.org/script/download.php#windows

- Localize o caminho de instalação do Python e altere a variável

site-packages\moviepy\config_defaults.pyacertou em cheioIMAGEMAGICK_BINARYCaminho de instalação do imagemagick - Faça o download do arquivo da fonte:

wget https://isv-data.oss-cn-hangzhou.aliyuncs.com/ics/MaaS/ClipVideo/STHeitiMedium.ttc -O font/STHeitiMedium.ttc

2 Métodos de uso

A. Uso do serviço local do Gradio

- Inicie o serviço:

python funclip/launch.py

# 使用 -l en 参数支持英文识别

# 使用 -p xxx 设置端口号

# 使用 -s True 开启公共访问

- entrevistas

localhost:7860Siga as etapas abaixo:

- Etapa 1: Faça upload de arquivos de vídeo

- Etapa 2: Copie o clipe de texto desejado para a área "Text to Clip".

- Etapa 3: Ajuste as configurações de legenda conforme necessário

- Etapa 4: Clique em "Clip" ou "Clip and Generate Subtitles" para editar.

B. LLM Smart Clips

- Após a conclusão do reconhecimento, selecione o modelo de idioma grande e configure o apikey

- Clique no botão "LLM Inference" e o sistema combinará automaticamente as legendas de vídeo com as dicas predefinidas.

- Clique no botão "AI Clip" para extrair automaticamente os registros de data e hora para edição com base na saída do modelo de linguagem grande.

- O resultado de um modelo de linguagem grande pode ser otimizado modificando as palavras-chave

C. Uso da linha de comando

- Reconhecimento de fala:

python funclip/videoclipper.py --stage 1 \

--file examples/video.mp4 \

--output_dir ./output

- Vídeo Clip:

python funclip/videoclipper.py --stage 2 \

--file examples/video.mp4 \

--output_dir ./output \

--dest_text '待剪辑文本' \

--start_ost 0 \

--end_ost 100 \

--output_file './output/res.mp4'

Além disso, os usuários podem experimentar o FunClip por meio das seguintes plataformas on-line:

- Espaço do ModelScope:FunClip@Modelscope Space

- Espaço HuggingFace:Espaço FunClip@HuggingFace

Se você tiver problemas com o uso, poderá obter suporte da comunidade por meio do grupo de pinning ou do grupo do weibo fornecido pelo projeto.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...