FunASR: kit de ferramentas de reconhecimento de fala de código aberto, separação de locutor / reconhecimento de fala de diálogo com várias pessoas

Introdução geral

O FunASR é um kit de ferramentas de reconhecimento de fala de código aberto desenvolvido pelo Dharma Institute da Alibaba para unir pesquisa acadêmica e aplicações industriais. Ele oferece suporte a uma ampla gama de funções de reconhecimento de fala, incluindo reconhecimento de fala (ASR), detecção de ponto final de voz (VAD), recuperação de pontuação, modelagem de linguagem, verificação de locutor, separação de locutor e reconhecimento de fala de diálogo com várias pessoas. O FunASR oferece scripts e tutoriais convenientes para dar suporte à inferência e ao ajuste fino de modelos pré-treinados, ajudando os usuários a criar rapidamente serviços eficientes de reconhecimento de fala.

Suporta uma variedade de formatos de entrada de áudio e vídeo, pode identificar dezenas de horas de áudio e vídeo longos em texto com pontuação, suporta centenas de solicitações de transcrição simultânea. Suporta chinês, inglês, japonês, cantonês e coreano.

Experiência on-line: https://www.funasr.com/

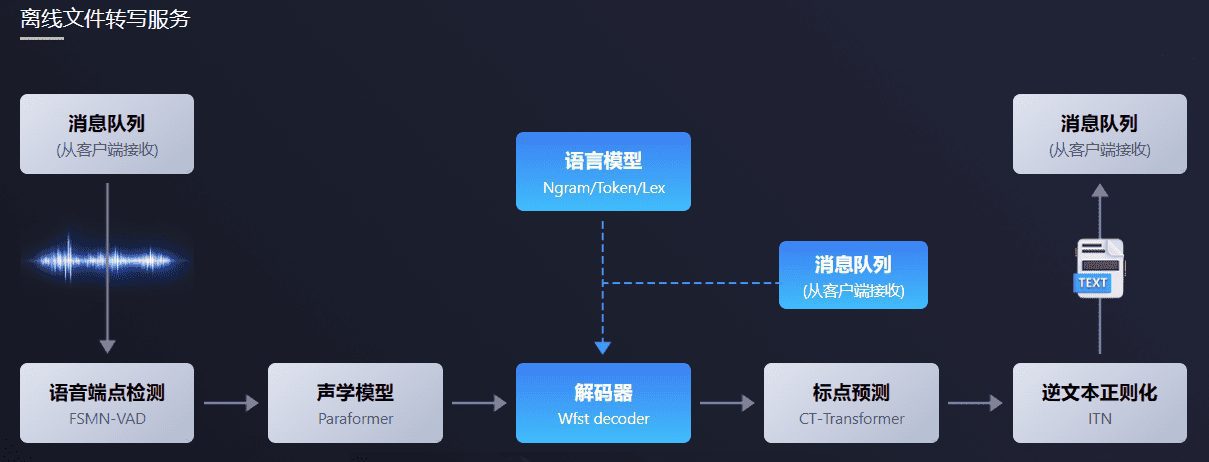

O pacote de software de transcrição de arquivos off-line FunASR oferece um serviço avançado de transcrição de arquivos off-line de fala. Com um link de reconhecimento de fala completo, combinando detecção de ponto final de fala, reconhecimento de fala, pontuação e outros modelos, ele pode reconhecer dezenas de horas de áudio e vídeo longos como texto pontuado e suporta centenas de solicitações de transcrição simultânea. A saída é um texto pontuado com carimbos de data e hora no nível da palavra e é compatível com ITN e palavras-chave definidas pelo usuário. Integração do lado do servidor com o ffmpeg, suporte a uma variedade de formatos de entrada de áudio e vídeo. O pacote fornece cliente de html, python, c++, java e c# e outras linguagens de programação, que o usuário pode usar diretamente e desenvolver mais.

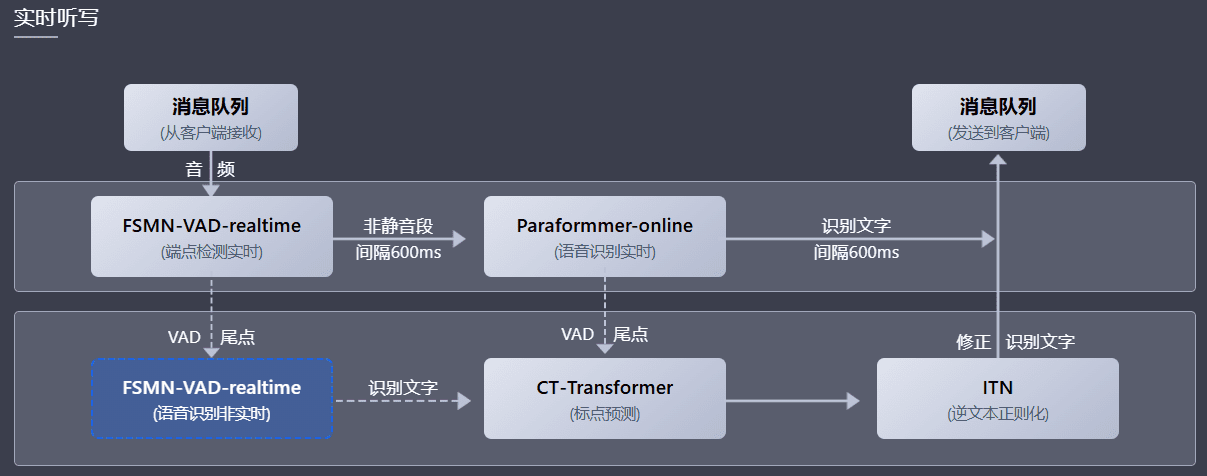

O pacote de software de ditado de fala em tempo real FunASR integra versões em tempo real de modelos de detecção de ponto final de fala, reconhecimento de fala, reconhecimento de voz, modelos de previsão de pontuação e assim por diante. Usando a sinergia de vários modelos, ele pode não apenas realizar a conversão de fala em texto em tempo real, mas também corrigir a saída com texto de transcrição de alta precisão no final da frase, o texto de saída com pontuação e suporte para várias solicitações. De acordo com diferentes cenários de usuários, ele suporta três modos de serviço: serviço de ditado de fala em tempo real (on-line), transcrição de frases em tempo não real (off-line) e colaboração integrada em tempo real e não real (2pass). O pacote de software oferece várias linguagens de programação, como html, python, c++, java e cliente c#, que os usuários podem usar diretamente e desenvolver mais.

Lista de funções

- Reconhecimento de fala (ASR): suporta reconhecimento de fala off-line e em tempo real.

- Detecção de ponto final de voz (VAD): detecta o início e o fim do sinal de voz.

- Recuperação de pontuação: adiciona pontuação automaticamente para melhorar a legibilidade do texto.

- Modelos de linguagem: oferece suporte à integração de vários modelos de linguagem.

- Verificação do orador: verifica a identidade do orador.

- Separação de alto-falantes: distinguir a fala de diferentes alto-falantes.

- Reconhecimento de fala para várias conversas: suporta o reconhecimento de fala para várias conversas simultâneas.

- Inferência e ajuste fino do modelo: fornece funções de inferência e ajuste fino para modelos pré-treinados.

Usando a Ajuda

Processo de instalação

- Preparação ambiental::

- Certifique-se de que o Python 3.7 ou superior esteja instalado.

- Instale as bibliotecas de dependência necessárias:

pip install -r requirements.txt

- Modelos para download::

- Faça o download de modelos pré-treinados do ModelScope ou do HuggingFace:

git clone https://github.com/modelscope/FunASR.git cd FunASR

- Faça o download de modelos pré-treinados do ModelScope ou do HuggingFace:

- Ambiente de configuração::

- Configurar variáveis de ambiente:

export MODEL_DIR=/path/to/your/model

- Configurar variáveis de ambiente:

Processo de uso

- reconhecimento de fala::

- Use a linha de comando para reconhecimento de fala:

python recognize.py --model paraformer --input your_audio.wav - Reconhecimento de fala usando código Python:

from funasr import AutoModel model = AutoModel.from_pretrained("paraformer") result = model.recognize("your_audio.wav") print(result)

- Use a linha de comando para reconhecimento de fala:

- detecção de ponto de extremidade de voz::

- Use a linha de comando para detecção de ponto de extremidade de voz:

python vad.py --model fsmn-vad --input your_audio.wav - Detecção de ponto final de fala usando código Python:

from funasr import AutoModel vad_model = AutoModel.from_pretrained("fsmn-vad") vad_result = vad_model.detect("your_audio.wav") print(vad_result)

- Use a linha de comando para detecção de ponto de extremidade de voz:

- Recuperação de pontuação::

- Use a linha de comando para recuperação de pontuação:

python punctuate.py --model ct-punc --input your_text.txt - Recuperação de pontuação usando código Python:

from funasr import AutoModel punc_model = AutoModel.from_pretrained("ct-punc") punc_result = punc_model.punctuate("your_text.txt") print(punc_result)

- Use a linha de comando para recuperação de pontuação:

- Verificação do palestrante::

- Use a linha de comando para verificar o alto-falante:

python verify.py --model speaker-verification --input your_audio.wav - Verificação do alto-falante usando código Python:

from funasr import AutoModel verify_model = AutoModel.from_pretrained("speaker-verification") verify_result = verify_model.verify("your_audio.wav") print(verify_result)

- Use a linha de comando para verificar o alto-falante:

- Reconhecimento de fala multi-fala::

- Reconhecimento de fala para diálogos multijogador usando a linha de comando:

python multi_asr.py --model multi-talker-asr --input your_audio.wav - Reconhecimento de fala para conversas com várias pessoas usando código Python:

from funasr import AutoModel multi_asr_model = AutoModel.from_pretrained("multi-talker-asr") multi_asr_result = multi_asr_model.recognize("your_audio.wav") print(multi_asr_result)

- Reconhecimento de fala para diálogos multijogador usando a linha de comando:

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...