Easy Dataset: uma ferramenta fácil para criar grandes conjuntos de dados com ajuste fino de modelos

Introdução geral

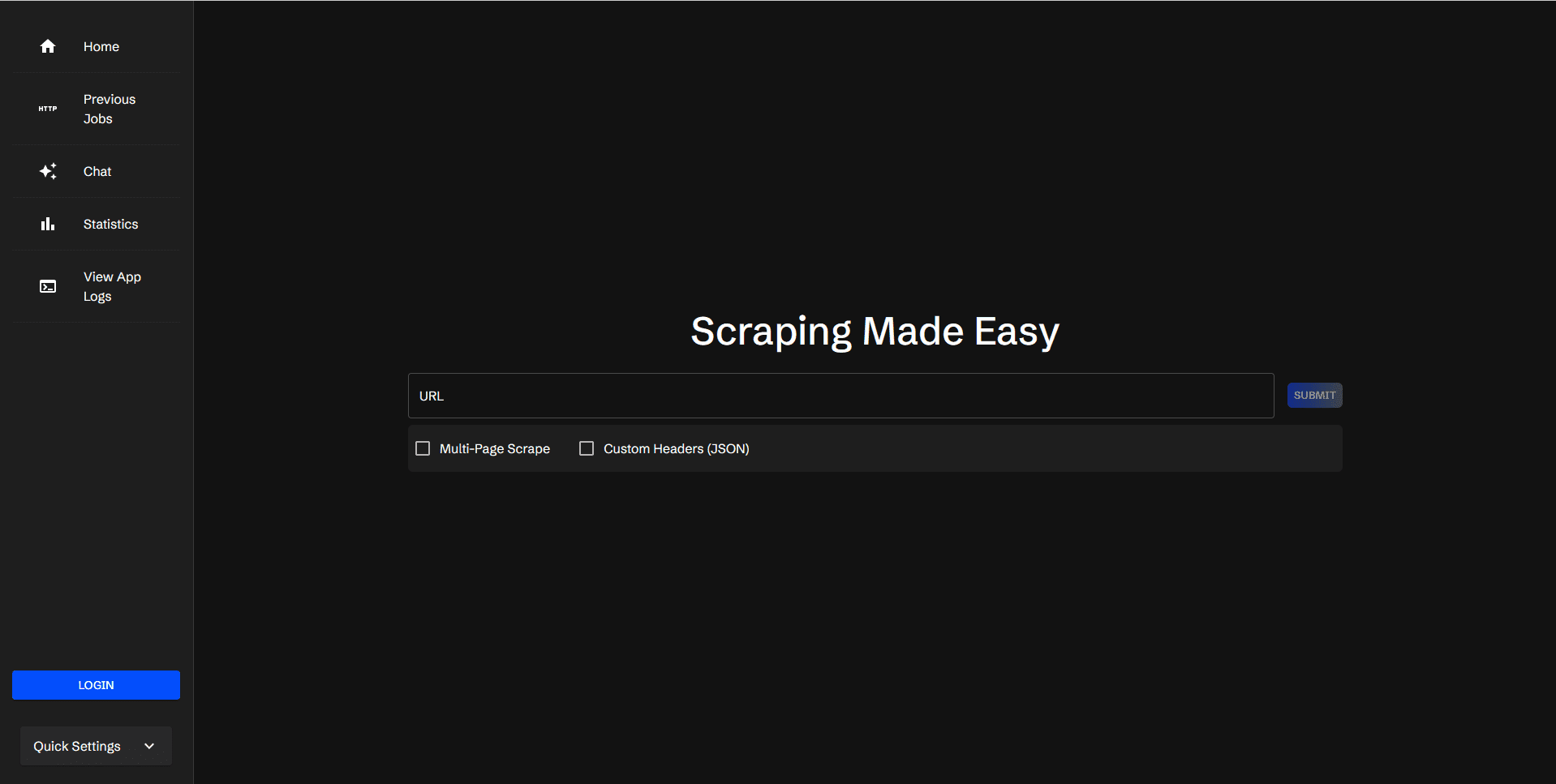

O Easy Dataset é uma ferramenta de código aberto projetada especificamente para o ajuste fino de modelos grandes (LLMs), hospedada no GitHub. Ela oferece uma interface fácil de usar que permite aos usuários fazer upload de arquivos, segmentar automaticamente o conteúdo, gerar perguntas e respostas e, por fim, gerar conjuntos de dados estruturados adequados para o ajuste fino. O desenvolvedor Conard Li criou essa ferramenta para ajudar os usuários a transformar o conhecimento do domínio em dados de treinamento de alta qualidade. Ela oferece suporte a vários formatos de exportação, como JSON e Alpaca, e é compatível com todas as APIs LLM que seguem o formato OpenAI. Portanto, seja você um especialista técnico ou apenas um usuário casual, essa ferramenta facilita o início e a criação rápida de conjuntos de dados.

Lista de funções

- Processamento inteligente de documentosQuando você carrega um arquivo Markdown, a ferramenta o divide automaticamente em partes menores.

- Geração de perguntasGeração automática de perguntas relevantes com base no texto segmentado.

- Geração de respostasChamada da API do LLM para gerar respostas detalhadas para cada pergunta.

- Edição flexívelSuporte para modificação de perguntas, respostas ou conteúdo de conjuntos de dados em qualquer estágio.

- Vários formatos de exportaçãoConjuntos de dados: os conjuntos de dados podem ser exportados para os formatos JSON, JSONL ou Alpaca.

- Amplo suporte a modelosCompatível com todas as APIs LLM que seguem o formato OpenAI.

- Interface amigávelDesign: O design é intuitivo e adequado para usuários técnicos e não técnicos.

- Dicas personalizadasPermitir que o usuário adicione avisos do sistema que orientem o modelo a gerar um estilo específico de resposta.

Usando a Ajuda

Processo de instalação

O Easy Dataset oferece duas maneiras principais de usá-lo: implantando-o via Docker ou executando-o a partir de fontes locais. Veja a seguir as etapas detalhadas:

Instalação via Docker

- Instalando o Docker

Se o seu computador ainda não tiver o Docker, faça o download e instale o Docker Desktop. Quando a instalação estiver concluída, abra um terminal para verificar se foi bem-sucedida:

docker --version

Se o número da versão for exibido, isso significa que ele está instalado.

- Extraia a imagem e execute

Digite o seguinte comando no terminal para obter a imagem oficial e iniciar o serviço:

docker run -d -p 3000:3000 -v {你的本地路径}:/app/local-db --name easy-dataset conardli17/easy-dataset:latest

{你的本地路径}Você precisa substituí-lo pelo caminho para a pasta em seu computador que você usa para armazenar os dados, por exemploC:\data(Windows) ou/home/user/data(Linux/Mac).-p 3000:3000Indica que a porta 3000 dentro do contêiner é mapeada para a porta 3000 localmente.-vIsso evita que os dados sejam perdidos depois que o contêiner for reiniciado.

- interface de acesso

Após o lançamento bem-sucedido, abra seu navegador e digitehttp://localhost:3000Você verá a página inicial do Easy Dataset. Você verá a página inicial do Easy Dataset, clique no botão "Create Project" (Criar projeto) para começar.

Executar localmente por meio do código-fonte

- Preparação do ambiente

- Certifique-se de ter o Node.js (versão 18.x ou superior) e o npm instalados em seu computador.

- Método de verificação: Entre no terminal

node -vresponder cantandonpm -vApenas veja o número da versão.

- armazém de clones

Digite-o no terminal:

git clone https://github.com/ConardLi/easy-dataset.git

cd easy-dataset

- Instalação de dependências

É executado dentro da pasta do projeto:

npm install

- Início dos serviços

Digite o seguinte comando para compilar e executar:

npm run build

npm run start

Depois disso, abra seu navegador e acesse http://localhost:3000A interface da ferramenta pode ser acessada clicando no botão "Tools" (Ferramentas).

Funções principais

Criar um projeto

- Na página inicial, clique no botão "Create Project" (Criar projeto).

- Digite o nome do projeto, por exemplo, "My Dataset".

- Clique em "Confirm" (Confirmar) e o sistema criará um novo espaço de projeto para você.

Carregamento e processamento de documentos

- Na página do projeto, localize a opção "Text Split" ou "Text Split".

- Clique em "Upload file" e selecione um arquivo Markdown local (por exemplo

example.md). - Após o upload, a ferramenta dividirá automaticamente o conteúdo do arquivo em pequenos segmentos. Cada segmento é exibido na interface e você pode ajustar manualmente o resultado da divisão.

Gerar perguntas e respostas

- Vá para a página "Perguntas" ou "Gerenciamento de perguntas".

- Clique no botão "Generate Questions" (Gerar perguntas) e a ferramenta gerará perguntas com base em cada texto.

- Verifique a pergunta gerada e, se não estiver satisfeito, você pode alterá-la clicando no botão Edit (Editar) ao lado da pergunta.

- Clique em "Generate Answers" (Gerar respostas), selecione uma API do LLM (você precisa configurar a chave da API com antecedência) e a ferramenta gerará respostas para cada pergunta.

- Depois que as respostas forem geradas, você poderá editá-las manualmente para garantir que o conteúdo atenda aos requisitos.

Exportação de um conjunto de dados

- Vá para a tela Datasets ou Dataset Management.

- Clique no botão "Export" (Exportar) e selecione o formato de exportação (por exemplo, JSON ou Alpaca).

- O sistema gerará um arquivo, clique em Download e salve-o localmente.

Operação da função em destaque

Configuração da API do LLM

- Na página Settings ou Settings, localize Model Configuration.

- Digite sua chave de API do LLM (por exemplo, a chave de API do OpenAI).

- Selecione o tipo de modelo (há suporte para muitos modelos comuns) e salve a configuração.

- Uma vez configurado, esse modelo será chamado ao gerar respostas.

Alertas personalizados do sistema

- Na página Settings (Configurações), localize Prompts ou Prompt Templates (Modelos de prompt).

- Insira prompts personalizados, como "Please answer the question in simple language" (Responda à pergunta em linguagem simples).

- Depois de salvas, as respostas serão geradas com o estilo ajustado de acordo com suas instruções.

Otimização do conjunto de dados

- Na tela Datasets, clique no botão Optimise (Otimizar).

- O sistema analisa o conjunto de dados e remove as duplicatas ou otimiza o formato.

- O conjunto de dados otimizado é mais adequado para uso direto no ajuste fino do modelo.

advertência

- Se estiver implantando com o Docker, não se esqueça de fazer backups regulares!

{你的本地路径}Os dados contidos nele. - Ao executar localmente, certifique-se de que a rede esteja aberta, pois a geração de respostas requer uma conexão com a Internet para chamar a API.

- Se encontrar um erro, você pode verificar a página "Releases" no GitHub para fazer download da versão mais recente e corrigir o problema.

cenário do aplicativo

- Desenvolvedores de modelos ajustam o LLM

Os desenvolvedores podem usar o Easy Dataset para processar documentos técnicos, gerar pares de perguntas e respostas, produzir rapidamente conjuntos de treinamento e melhorar o desempenho do modelo em domínios específicos. - Produção de materiais didáticos por educadores

Os professores podem fazer upload de apostilas do curso e gerar perguntas e respostas para revisão dos alunos ou criação de conteúdo de curso on-line. - Os pesquisadores reúnem o conhecimento do domínio

Os pesquisadores podem fazer upload de documentos ou relatórios, extrair as principais perguntas e respostas e organizá-las em dados estruturados para análise.

QA

- Quais formatos de arquivo são compatíveis com o Easy Dataset?

Atualmente, o principal suporte é para arquivos Markdown (.md), outro suporte a formatos pode ser adicionado no futuro. - Preciso fornecer minha própria API do LLM?

Sim, a ferramenta em si não fornece serviços LLM e exige que o usuário configure sua própria chave de API, como OpenAI ou outros modelos compatíveis. - Para quais modelos o conjunto de dados exportado pode ser usado?

Desde que o modelo seja compatível com os formatos OpenAI (por exemplo, LLaMA, GPT, etc.), o conjunto de dados exportado pode ser usado diretamente.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...