Por trás da tempestade DeepSeek: Ng alerta que a competição de modelos abertos remodelará o cenário de valores de IA nos EUA e na China

Caros amigos.

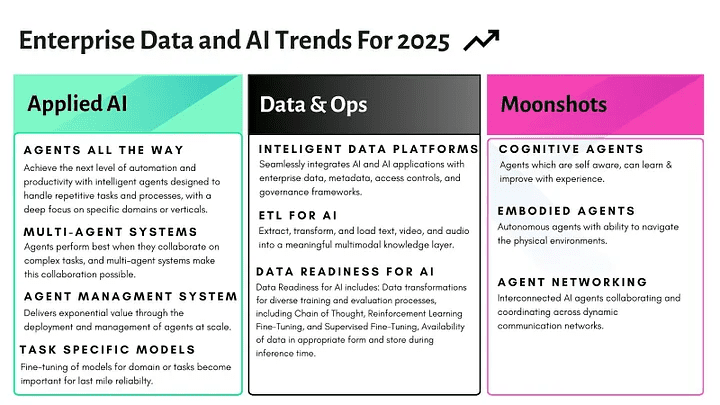

esta semana DeepSeek O burburinho gerado deixou claro para muitos várias tendências importantes: (i) a China está se aproximando dos EUA em IA generativa, o que está tendo um impacto significativo na cadeia de suprimentos de IA; (ii) os modelos de ponderação abertos estão comoditizando a camada do modelo básico, criando oportunidades para os desenvolvedores de aplicativos; e (iii) o aumento de escala não é a única maneira de a IA progredir. Apesar do grande foco e do hype do setor no poder aritmético, a inovação algorítmica está reduzindo rapidamente os custos de treinamento.

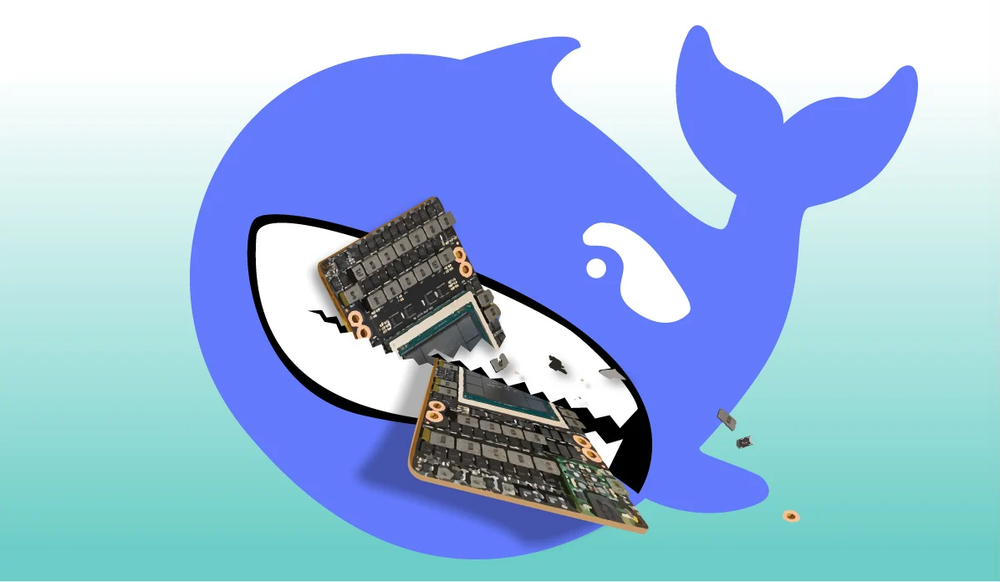

Há cerca de uma semana, a empresa chinesa DeepSeek lançou o DeepSeek-R1 O modelo, que tem desempenho comparável ao do OpenAI o1 em benchmarks, abre os pesos sob a licença MIT. Na semana passada, em Davos, muitos líderes empresariais de formação não técnica me perguntaram sobre isso. Houve uma "liquidação do DeepSeek" no mercado de ações na segunda-feira: as ações de várias empresas de tecnologia dos EUA, incluindo a NVIDIA, caíram (e se recuperaram parcialmente até o momento da redação deste artigo).

Acho que o DeepSeek mostra os seguintes pontos:

A IA geradora chinesa está diminuindo a distância em relação aos EUA.. Quando o ChatGPT for lançado em novembro de 2022, os EUA estarão significativamente à frente da China em IA generativa. As percepções das pessoas demoram a mudar, então, recentemente, ainda há amigos na China e nos EUA que acham que a China está ficando para trás. Mas, na verdade, essa diferença vem diminuindo rapidamente nos últimos dois anos. via lit. dez mil perguntas sobre princípios gerais (expressão idiomática); fig. uma longa lista de perguntas e respostas (Minha equipe o utiliza há meses), Kimi Com modelos chineses como o InternVL e o DeepSeek, fica claro que a China está diminuindo a diferença e até mesmo teve uma liderança temporária em áreas como a geração de vídeos.

Estou animado com o fato de o DeepSeek-R1 estar sendo lançado como código aberto com um relatório técnico detalhado. Em contrapartida, várias empresas norte-americanas promoveram políticas que restringem o código-fonte aberto ao divulgar riscos hipotéticos, como a "extinção da IA". Agora está claro que os modelos de código-fonte aberto/ponderação aberta se tornaram uma parte importante da cadeia de suprimentos de IA: muitas empresas os adotarão. Se os EUA continuarem a bloquear o código aberto, a China dominará a cadeia de suprimentos e, por fim, a maioria das empresas usará modelos que refletem mais os valores chineses do que os valores americanos.

Os modelos de ponderação abertos estão comoditizando a camada do modelo básico. Como mencionei anteriormente, os preços dos tokens de modelos de linguagem grandes estão caindo rapidamente, e a ponderação aberta acelera essa tendência e oferece mais opções para os desenvolvedores. O openAI o1 cobra US$ 60 por milhão de tokens de saída.E o DeepSeek R1 custa apenas US$ 2,19A diferença de preço de quase 30 vezes levou a uma preocupação generalizada sobre a tendência de redução de preços. Essa diferença de quase 30 vezes levou a uma tendência de redução de preços que atraiu a atenção de todos.

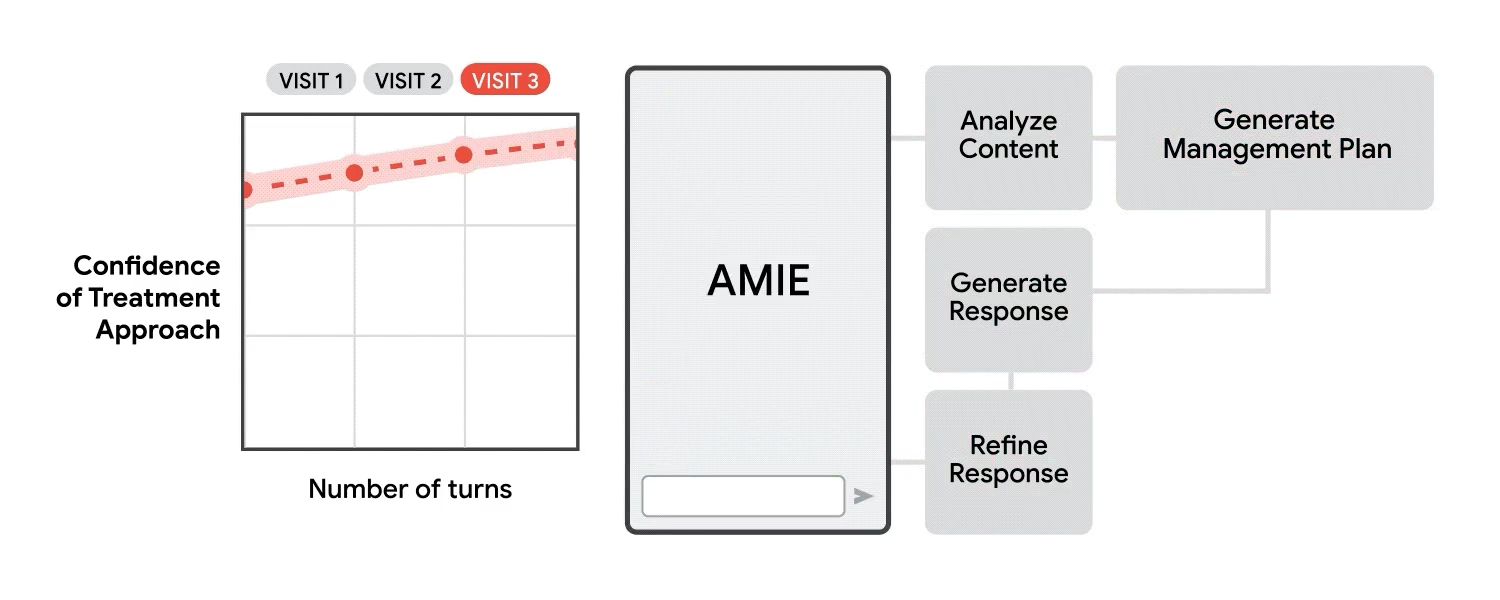

O negócio de treinamento de modelos básicos e venda de acesso à API é repleto de desafios. Muitas empresas nesse espaço ainda estão procurando maneiras de recuperar o alto custo do treinamento. O artigo "AI's $600 Billion Conundrum" descreve esse desafio de forma eloquente (mas, para deixar claro, acho que as empresas de modelos básicos estão fazendo um ótimo trabalho e espero que tenham sucesso). Em contrapartida, há uma enorme oportunidade de negócios na criação de aplicativos baseados em modelos básicos. Como outras empresas investiram bilhões em modelos de treinamento, você pode obtê-los por alguns dólares para desenvolver aplicativos como chatbots de atendimento ao cliente, resumidores de e-mail, médicos com IA, assistentes de documentos jurídicos e muito mais.

Os avanços da IA não dependem apenas de escalonamento.. O argumento de que o aumento de escala dos modelos impulsiona o progresso é muito difundido. Para ser justo, eu fui um dos primeiros defensores do argumento da escala. As empresas levantaram bilhões de dólares promovendo a narrativa de que mais capital (i) aumentaria a escala e (ii) melhoraria o desempenho de forma constante. Isso levou a um foco excessivo no aumento de escala em detrimento de várias outras vias de progresso. Impulsionada pela proibição de chips de IA nos EUA, a equipe do DeepSeek teve que inovar muitas otimizações nas GPUs H800 mais fracas, o que acabou mantendo o custo de treinamento do modelo (excluindo o investimento em pesquisa) abaixo de US$ 6 milhões.

Resta saber se isso realmente reduzirá a demanda aritmética. Às vezes, uma redução no preço unitário dos produtos leva a um aumento no gasto total. Acredito que, a longo prazo, quase não há limite superior para a demanda humana por inteligência e poder aritmético, portanto, mesmo que o custo diminua, os seres humanos continuarão consumindo mais recursos inteligentes.

A mídia social tem estado repleta de interpretações conflitantes do progresso do DeepSeek, mapeando diferentes posições como um teste de Rorschach. Acho que o impacto geopolítico do DeepSeek-R1 ainda não foi totalmente percebido, mas é uma vantagem para os desenvolvedores de aplicativos de IA. Minha equipe já começou a fazer um brainstorming de novas ideias que só podem ser realizadas com a ajuda de modelos de inferência abertos e avançados. Este ainda é o melhor momento para criar aplicativos de IA!

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...