DeepSeek lança compreensão multimodal unificada e modelos generativos: do JanusFlow ao Janus-Pro

Leitura rápida JanusFlow

DeepSeek A equipe lançou outro novo modelo, lançando o Janus-Pro, uma estrutura multimodal inovadora na madrugada do dia 28, que é um modelo unificado capaz de lidar com tarefas de compreensão e geração multimodais simultaneamente. Criado com base no DeepSeek-LLM-1.5b-base/DeepSeek-LLM-7b-base, o modelo suporta entrada de imagens 384 x 384 e usa um tokenizador específico para geração de imagens. O recurso mais importante é a divisão da codificação visual em canais separados, mantendo um único transformador arquitetura para processamento.

Esse design inovador não apenas resolve o problema das funções conflitantes dos modelos tradicionais em codificadores visuais, mas também torna todo o sistema mais flexível. Na prática, o Janus-Pro supera os modelos unificados anteriores e até mesmo rivaliza com modelos dedicados baseados em tarefas em algumas tarefas. Ele superou o DALL-E 3 e o Stable Diffusion da OpenAI nos benchmarks GenEval e DPG-Bench.

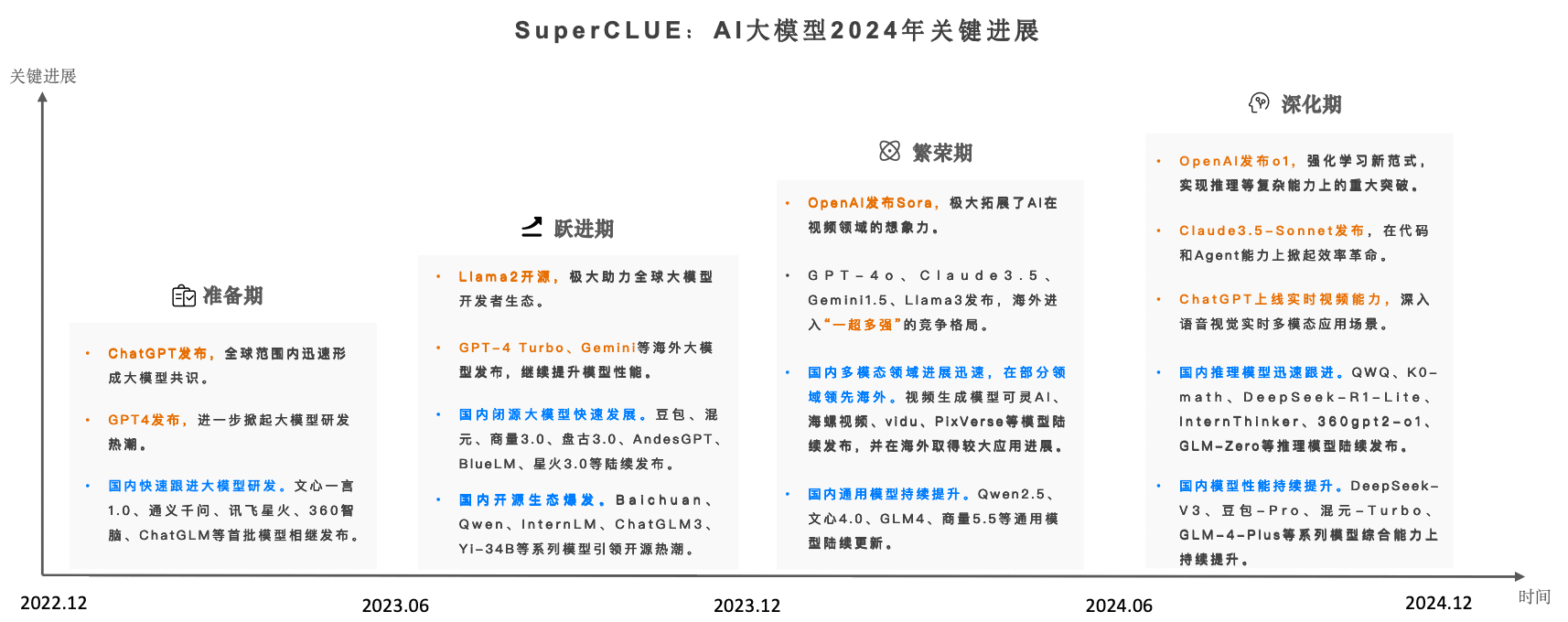

A linha de modelos Janus, que começou com o JanusFlowcom o objetivo de construir umUma estrutura unificada para compreensão e geração multimodalA ideia central é combinar um modelo de linguagem autorregressivo (LLM) com um modelo de geração de fluxo retificado. A ideia central é combinar um modelo de linguagem autorregressivo (LLM) com um modelo de geração de fluxo retificado, com o objetivo de obter uma compreensão visual superior e recursos de geração de imagens de alta qualidade em um único modelo.Janus-Pro Como uma versão avançada do Janus, o desempenho do modelo Janus foi aprimorado ainda mais por meio de otimizações abrangentes na estratégia de treinamento, no tamanho dos dados e nas dimensões do modelo, e alcançou um progresso significativo em vários testes de referência. Neste artigo, analisamos sistematicamente a evolução do modelo Janus, do JanusFlow ao Janus-Pro, concentrando-nos em sua funcionalidade, características dos parâmetros e principais aprimoramentos.

1. JanusFlow: a pedra angular da arquitetura unificada

endereço de papel:: https://arxiv.org/pdf/2411.07975

JanusFlow A principal inovação é suaArquitetura unificada minimalistaEle integra de forma inteligente o modelo de geração de fluxo modificado à estrutura autorregressiva do LLM sem a necessidade de modificações complexas na estrutura do LLM. Os principais recursos dessa arquitetura incluem:

- Correção da geração de imagens de streaming: O JanusFlow utiliza um modelo de fluxo modificado para geração de imagens, começando com ruído gaussiano, prevendo iterativamente vetores de velocidade para atualizar a representação do espaço latente da imagem e, por fim, gerando imagens de alta qualidade por meio de um decodificador. Essa abordagem evita a limitação dos métodos tradicionais em que o LLM atua apenas como um gerador condicional e não tem capacidade de geração direta.

- Codificador visual desacoplado: Para otimizar o desempenho do modelo unificado, o JanusFlow usa oCodificador desacopladoNa estratégia de compreensão, codificadores visuais separados são usados para lidar com a tarefa de compreensão e a tarefa de geração, respectivamente:

- Compreensão de codificadores (fenc): Usando o treinamento prévio SigLIP-Large-Patch/16 que é responsável pela extração de recursos semânticos de imagens para aprimorar a compreensão multimodal.

- Gerar codificador (genc) e decodificador (gdec): treinamento de arranhões ConvNeXt módulo dedicado a tarefas de geração de imagens para otimizar a qualidade da geração.

- Mecanismos de alinhamento de representações: Durante o processo de treinamento de unificação, o JanusFlow apresentaalinhamento de caracteresmecanismo que alinha as representações intermediárias dos módulos de geração e compreensão, melhorando assim a coerência e a consistência semântica no processo de geração.

- Uma estratégia de treinamento em três fases: A JanusFlow elaborou um programa de treinamento detalhado em três etapas:

- Estágio 1: Inicialização aleatória Adaptação do componente - A camada linear, o codificador gerador e o decodificador são treinados para trabalhar com os codificadores LLM e SigLIP pré-treinados como uma fase de inicialização para o treinamento subsequente.

- Etapa 2: Harmonização do pré-treinamento - Treine todo o modelo, exceto o codificador visual, fundindo a compreensão multimodal, a geração de imagens e os dados de texto simples para estabelecer inicialmente os recursos unificadores do modelo.

- Etapa 3: Monitoramento do ajuste fino - Os dados de ajuste fino do comando são usados para treinar ainda mais o modelo para melhorar a resposta aos comandos do usuário e para descongelar os parâmetros do codificador SigLIP nesse estágio.

Características dos parâmetros:

- Foundation LLM: Arquitetura LLM leve com 1,3 bilhão de parâmetros.

- Codificador visual: SigLIP-Large-Patch/16 (compreensão), ConvNeXt (geração de codificadores e decodificadores).

- Resolução da imagem: 384 × 384 pixels.

Desempenho: O JanusFlow alcança um desempenho significativo nas tarefas de geração de texto para imagem e de compreensão multimodal, superando muitos modelos especializados e comprovando a eficácia de sua arquitetura unificada.

2. Janus-Pro: uma atualização completa de dados, modelos e estratégias

endereço de papel:: https://github.com/deepseek-ai/Janus/blob/main/janus_pro_tech_report.pdf

Janus-Pro Como uma versão aprimorada do Janus, o JanusFlow foi atualizado em três áreas principais:

- Estratégias de treinamento otimizadas: O Janus-Pro ajusta a estratégia de treinamento em três estágios do JanusFlow, com o objetivo de abordar a eficiência do treinamento e os gargalos de desempenho:

- Etapa 1: Treinamento do conjunto de dados ImageNet estendido - O aumento do número de etapas de treinamento no conjunto de dados ImageNet permite que o modelo aprenda as dependências de pixel de forma mais completa, melhorando os recursos subjacentes da geração de imagens.

- Etapa 2: Foco no treinamento de dados de texto para imagem - No treinamento do Estágio 2, os dados do ImageNet são removidos e o conjunto de dados regular de texto para imagem é usado diretamente, permitindo que o modelo aprenda com mais eficiência a gerar imagens de alta qualidade com base em descrições de texto densas.

- Etapa 3: Dimensionamento dos dados - Na fase de ajuste fino supervisionado, as proporções de dados de compreensão multimodal, dados de texto simples e dados de texto para imagem foram ajustadas (de 7:3:10 para 5:1:4) para melhorar ainda mais o desempenho da compreensão multimodal e, ao mesmo tempo, garantir a capacidade de geração visual.

- Dados de treinamento estendidos: O Janus-Pro dimensiona drasticamente o tamanho e a diversidade dos dados de treinamento para melhorar a capacidade de generalização e a qualidade de geração do modelo:

- Compreensão multimodal de dados: Na fase de pré-treinamento do Estágio 2, cerca de 90 milhões de novas amostras foram adicionadas, abrangendo uma gama mais ampla de dados de legendas de imagens (por exemplo, YFCC), bem como dados de tabelas, gráficos e compreensão de documentos (por exemplo, Docmatix). No ajuste fino do Estágio 3, outras amostras são introduzidas. DeepSeek-VL2 bem como a compreensão MEME, dados de diálogo chinês, etc., o que melhora significativamente a capacidade de diálogo e a capacidade multitarefa do modelo.

- Dados gerados visualmente: Para melhorar a qualidade estética e a estabilidade das imagens geradas, o Janus-Pro introduz cerca de 72 milhões de dados estéticos sintéticos de alta qualidade e ajusta a proporção de dados reais para dados sintéticos para 1:1. As experiências mostram que a adição de dados sintéticos acelera a convergência do modelo e melhora significativamente a qualidade estética e a estabilidade das imagens geradas.

- Tamanho estendido do modelo: O Janus-Pro não apenas mantém o modelo paramétrico de 1,5B do JanusFlow, mas também o amplia para incluir o Parâmetros 7Be fornece Série Janus-Pro nos tamanhos de modelo 1,5B e 7B.Os resultados experimentais mostram que o LLM de maior escala pode melhorar significativamente o desempenho do modelo e acelerar a velocidade de convergência. Os resultados experimentais mostram que os LLMs de maior escala podem melhorar significativamente o desempenho do modelo e acelerar a velocidade de convergência, validando a escalabilidade da arquitetura do modelo Janus.

Características dos parâmetros:

- Dimensões do modelo: Disponível nos tamanhos de modelo 1.5B e 7B.

- Arquitetura: Segue a arquitetura do codificador visual desacoplado do JanusFlow.

- Dados de treinamento: Dados de treinamento significativamente expandidos e otimizados para compreensão multimodal e geração visual.

- Resolução da imagem: A resolução da imagem usada nos experimentos permaneceu em 384 × 384 pixels.

Desempenho: O Janus-Pro demonstrou a eficácia das atualizações de dados, modelos e estratégias ao obter ganhos significativos de desempenho em todos os benchmarks, especialmente no benchmark de compreensão multimodal MMBench e nos benchmarks de geração de texto para imagem GenEval e DPG-Bench, que superaram o JanusFlow e outros modelos avançados unificados e especializados.

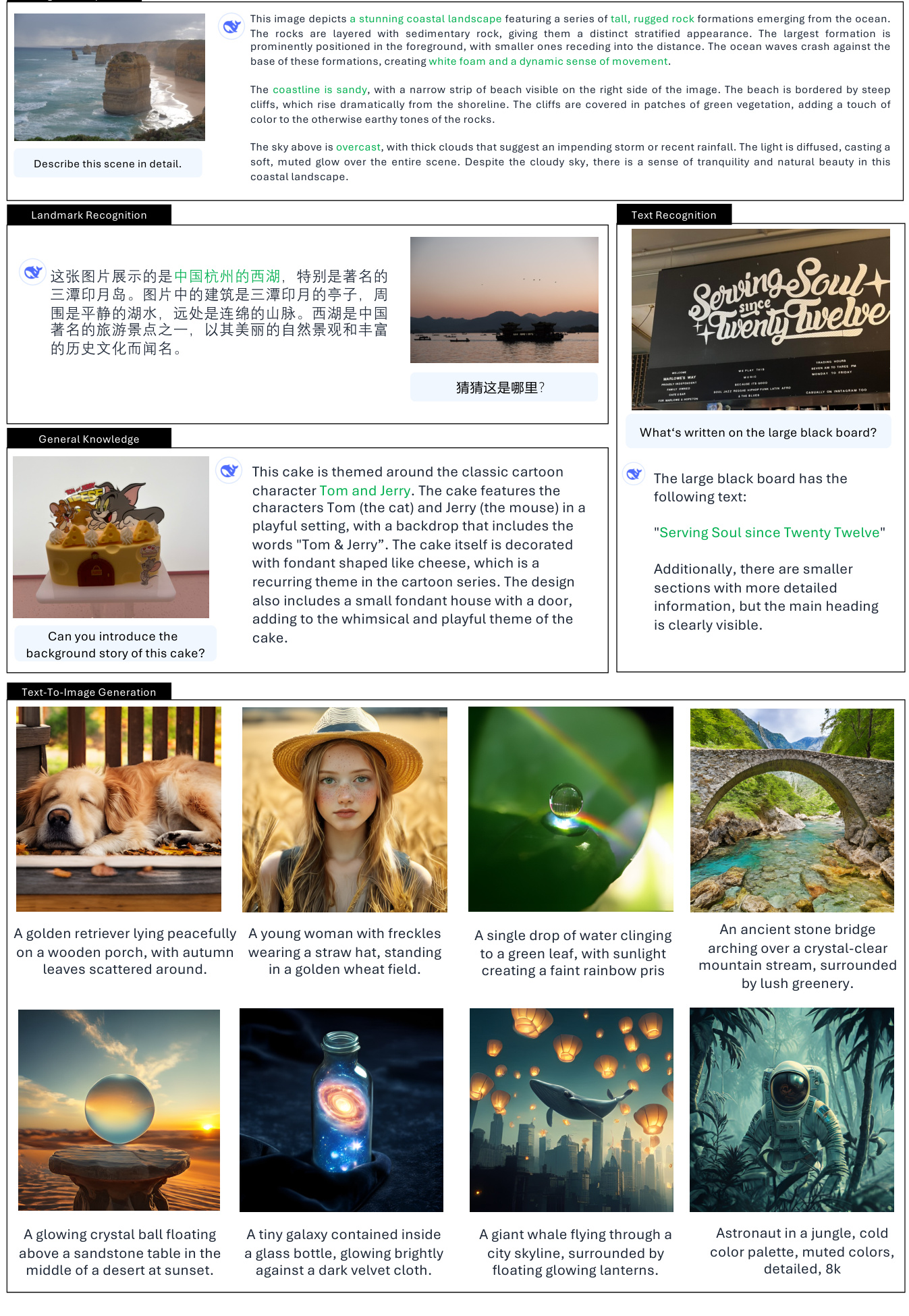

3.Janus cenários de uso real

Funções de compreensão visual:

- Descrição/captação da imagem.

- Descrição detalhada da cena: Pode gerar descrições de texto detalhadas com base no conteúdo da imagem, incluindo elementos da cena, objetos, atmosfera ambiental etc. (Exemplo: descrição das três piscinas do Lago Oeste, da paisagem à beira-mar etc.) (Exemplo: descrição das Três Piscinas do Lago Oeste, da paisagem à beira-mar etc.)

- Descrição gráfica: ser capaz de compreender e descrever informações em gráficos e quadros, como representação de dados e análise de tendências de gráficos de barras. (Exemplo: Interpretar o gráfico de barras "Kid's Favourite Fruits" (Frutas favoritas das crianças))

- Reconhecimento/Classificação de objetos.

- Identificar tipos de objetos em uma imagem: ser capaz de identificar e listar categorias de objetos que aparecem em uma imagem. (Exemplo: Identificar o tipo de fruta em uma imagem)

- Contagem de objetos.

- Contar com precisão o número de objetos em uma imagem: capacidade de contar com precisão o número de objetos específicos em uma imagem. (Exemplo: contar o número de pinguins na imagem)

- Reconhecimento de marco histórico.

- Identificar pontos de referência famosos em imagens: Ser capaz de identificar pontos de referência ou locais que aparecem em uma imagem. (Exemplo: Identificar as três piscinas do Lago Oeste)

- Reconhecimento de texto/OCR.

- Reconhecer o conteúdo de texto em imagens: ser capaz de reconhecer o texto que aparece em uma imagem e extrair informações sobre o texto. (Exemplo: Identificar "Serving Soul since Twenty Twelve" em um quadro negro)

- Resposta visual a perguntas.

- Responder a perguntas com base no conteúdo da imagem: ser capaz de entender o conteúdo de uma imagem e dar uma resposta razoável com base na pergunta do usuário. (Exemplo: perguntar "Que fruta está na foto?" em resposta a uma imagem).

- Raciocínio visual/integração de conhecimento.

- Compreender os significados e as associações por trás das imagens: ser capaz de raciocinar visualmente em um nível mais profundo e contextualizar o conhecimento. (Exemplos: explicar o humor da imagem do cachorro da Mona Lisa, entender o contexto temático do desenho animado do bolo)

- Geração de código (Python para plotagem).

- Gerar código com base nos comandos do usuário: entenda os requisitos do usuário para a criação de gráficos e gere o código Python de acordo. (Exemplo: gerar código Python para desenhar um gráfico de barras)

Função de geração de texto para imagem:

- Geração de imagens orientada por texto.

- Gerar imagens com base em descrições de texto: pode gerar imagens semanticamente relacionadas com base em prompts de texto inseridos pelo usuário.

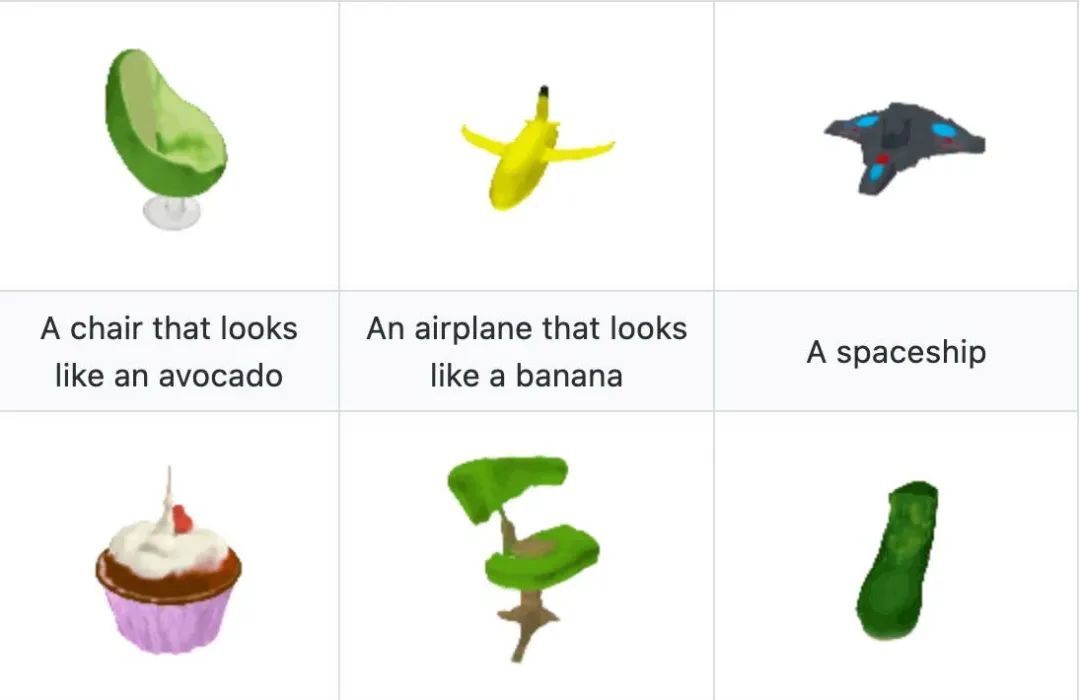

- Geração de imagens criativas: capacidade de entender solicitações de texto abstratas e imaginativas para gerar imagens criativas e artísticas. (Exemplos: baleia voadora, corgi de nebulosa cósmica, etc.)

- Geração de imagens estilizadas: Gere imagens com estilos artísticos específicos de acordo com a descrição do estilo nos prompts de texto. (Exemplos: igreja em estilo renascentista, vila montanhosa em estilo de pintura a tinta chinesa etc.)

- Geração de texto simples em imagens: Capacidade de gerar imagens com elementos de texto simples. (Exemplo: escrever "Hello" em um quadro negro)

Exemplos de cenários de aplicação prática:

- Assistente inteligente: atua como um assistente inteligente multimodal que entende as imagens carregadas pelo usuário e realiza perguntas e respostas, descrições, análises etc.

- Criação de conteúdo: ajude os criadores de conteúdo a gerar rapidamente materiais de imagem de alta qualidade, como gráficos de mídia social, ilustrações de artigos e muito mais.

- Aplicações educacionais: usado para ensinar reconhecimento de imagens, interpretação de diagramas, etc., para ajudar os alunos a entender as informações visuais.

- Recuperação de informações: fornece resultados de recuperação mais avançados por meio da pesquisa de imagens combinada com recursos de compreensão e geração de texto.

- Criação artística: como uma ferramenta criativa, ajuda os artistas a criar imagens e explorar novas formas de expressão visual.

Características e limitações dos parâmetros que devem ser observadas:

- Limitações de resolução de imagem: o treinamento e o teste do modelo atual baseiam-se principalmente em imagens com resolução de 384x384, o que pode ter limitações para cenários que exigem uma resolução mais alta.

- Finura de detalhes: embora a imagem seja semanticamente rica, ainda pode haver espaço para melhorias na finura de detalhes devido à perda de resolução e reconstrução do tokenizador de visão, por exemplo, áreas de rosto de tamanho pequeno podem não ser suficientemente finas.

4. resumo e perspectivas

A família de modelos Janus, do JanusFlow ao Janus-Pro, demonstra o potencial para avanços contínuos no campo da compreensão e geração multimodal unificada. O JanusFlow estabeleceu a base para uma arquitetura unificada, enquanto o Janus-Pro obteve um salto quântico no desempenho por meio da otimização da estratégia de treinamento, aumento de escala de dados e atualizações do tamanho do modelo. O sucesso do Janus-Pro validaExtensões de modelos e orientadas por dados são essenciais para melhorar o desempenho de modelos unificadosA evolução da família de modelos Janus não apenas impulsiona o progresso dos modelos multimodais, mas também estabelece uma base sólida para a criação de sistemas de IA mais versáteis e inteligentes.

Artigo completo "Janus-Pro: um modelo gerador e de compreensão multimodal unificado, viabilizado por extensões de dados e modelos

autor: Xiaokang Chen, Zhiyu Wu, Xingchao Liu, Zizheng Pan, Wen Liu, Zhenda Xie, Xingkai Yu, Chong Ruan

página do projeto: https://github.com/deepseek-ai/Janus

resumos

Neste trabalho, apresentamos o Janus-Pro, uma versão aprimorada do modelo Janus anterior. Especificamente, o Janus-Pro integra (1) uma estratégia de treinamento otimizada, (2) dados de treinamento ampliados e (3) escalonamento para modelos de tamanhos maiores. Com esses aprimoramentos, o Janus-Pro faz avanços significativos na compreensão multimodal e nos recursos de acompanhamento de comandos para imagens geradas por texto, além de aumentar a estabilidade das imagens geradas por texto. Esperamos que este trabalho estimule uma maior exploração nessa área. O código e o modelo estão disponíveis publicamente.

1. introdução

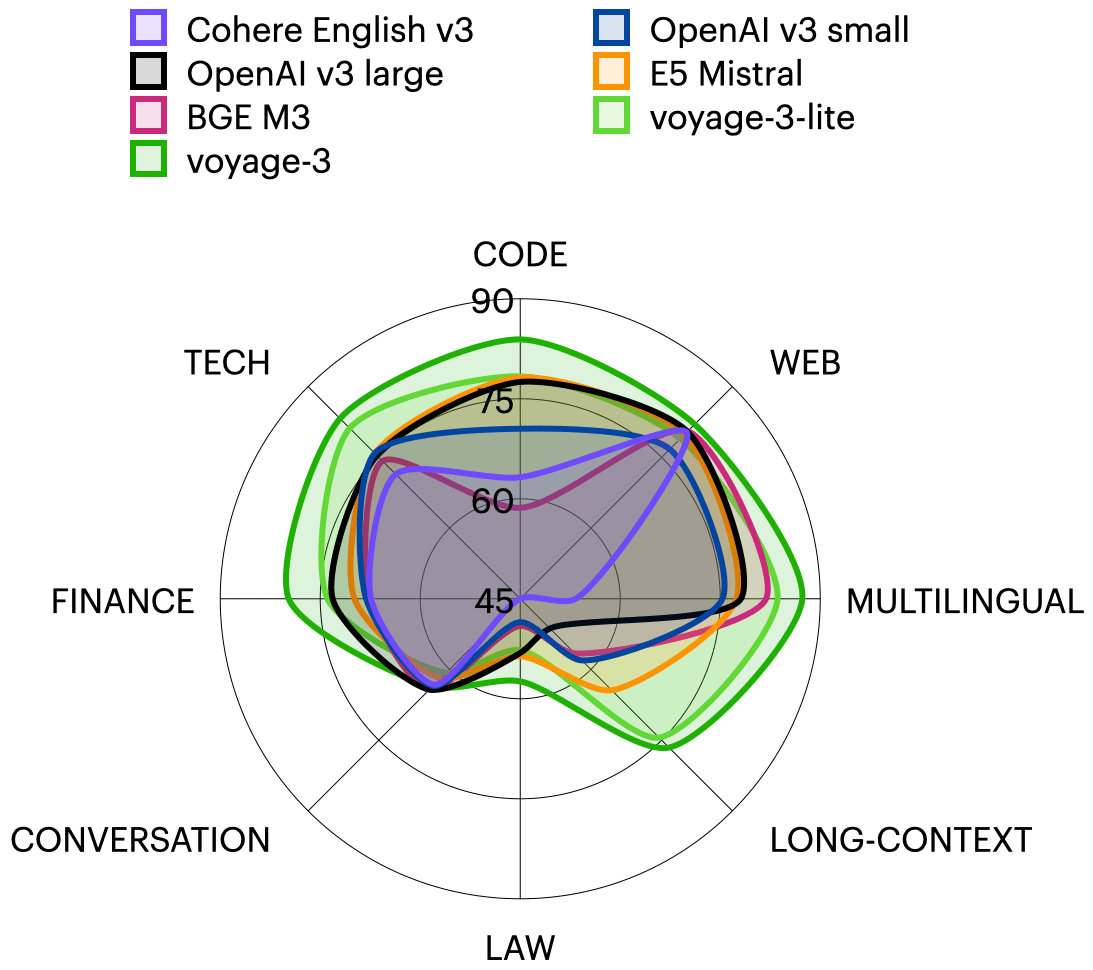

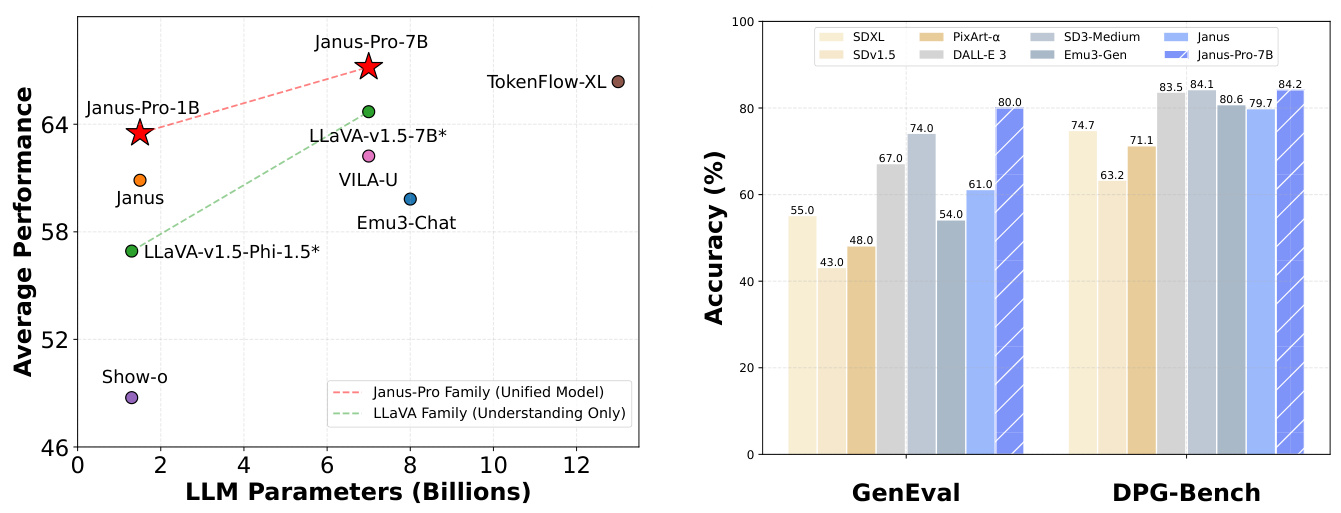

(a) Desempenho médio de quatro padrões de referência de compreensão multimodal. (b) Desempenho da instrução texto-para-gerar-imagem após os padrões de referência.

Figura 1 Resultados de compreensão multimodal e geração visual para o Janus-Pro. Para a compreensão multimodal, calculamos a média da precisão do POPE, do MME-Perception, do GQA e do MMMU. A pontuação do MME-Perception foi dividida por 20 para ser dimensionada no intervalo [0, 100]. Para a geração visual, avaliamos o desempenho dos benchmarks de acompanhamento de comandos GenEval e DPG-Bench. Em geral, o Janus-Pro supera os modelos multimodais unificados de última geração anteriores, bem como alguns modelos específicos de tarefas. Os melhores resultados foram obtidos para a visualização na tela.

1. uma foto simples de uma tangerina laranja 2. um quadro negro limpo com uma superfície verde e a palavra "Hello" escrita com precisão e clareza em giz branco 3. um close-up de um girassol simbolizando prosperidade, com caules e folhas verdes, pétalas em plena floração e uma abelha pousada sobre ele, com suas asas brilhando à luz do sol.

Figura 2 Comparação de imagens geradas por texto do Janus-Pro e de seu antecessor, o Janus. O Janus-Pro oferece uma saída mais consistente para prompts curtos, com maior qualidade visual, mais detalhes e a capacidade de gerar texto simples. A resolução da imagem é de 384x384 e é melhor visualizada em uma tela.

Recentemente, houve um progresso significativo na unificação da compreensão multimodal e dos modelos generativos [30, 40, 45, 46, 48, 50, 54, 55]. Foi demonstrado que essas abordagens melhoram a adesão às instruções em tarefas de geração visual e reduzem a redundância de modelos. A maioria dessas abordagens usa o mesmo codificador visual para processar as entradas das tarefas de compreensão e geração multimodais. Em geral, isso resulta em um desempenho ruim da compreensão multimodal devido às diferentes representações necessárias para as duas tarefas. Para resolver esse problema, Janus [46] propôs a codificação visual desacoplada, que alivia o conflito entre as tarefas de compreensão e geração multimodais, obtendo excelente desempenho em ambas as tarefas.

Como um modelo pioneiro, o Janus foi validado em uma escala de parâmetros 1B. No entanto, devido às limitações dos dados de treinamento e à capacidade relativamente pequena do modelo, ele apresenta várias desvantagens, como o baixo desempenho na geração de imagens de dicas curtas e a qualidade inconsistente das imagens geradas por texto. Neste artigo, apresentamos o Janus-Pro, uma versão aprimorada do Janus que melhora três aspectos: estratégia de treinamento, dados e tamanho do modelo. A família Janus-Pro consiste em dois tamanhos de modelo: 1B e 7B, demonstrando a escalabilidade do método de codificação e decodificação visual.

Avaliamos o Janus-Pro em vários benchmarks, e os resultados mostram uma compreensão multimodal superior e um desempenho significativamente melhor para a adesão às instruções de imagens geradas por texto. Especificamente, a Janus-Pro-7B obteve uma pontuação de 79,2 no benchmark de compreensão multimodal MMBench [29], superando os modelos multimodais unificados de última geração anteriores, como Janus [46] (69,4), TokenFlow [34] (68,9) e MetaMorph [42] (75,2). Além disso, o Janus-Pro-7B obteve uma pontuação de 0,80 na diretriz texto-para-gerar-imagens seguindo a tabela de classificação GenEval [14], superando o Janus [46] (0,61), o DALL-E 3 (0,67) e o Stable Diffusion 3 Medium [11] (0,74).

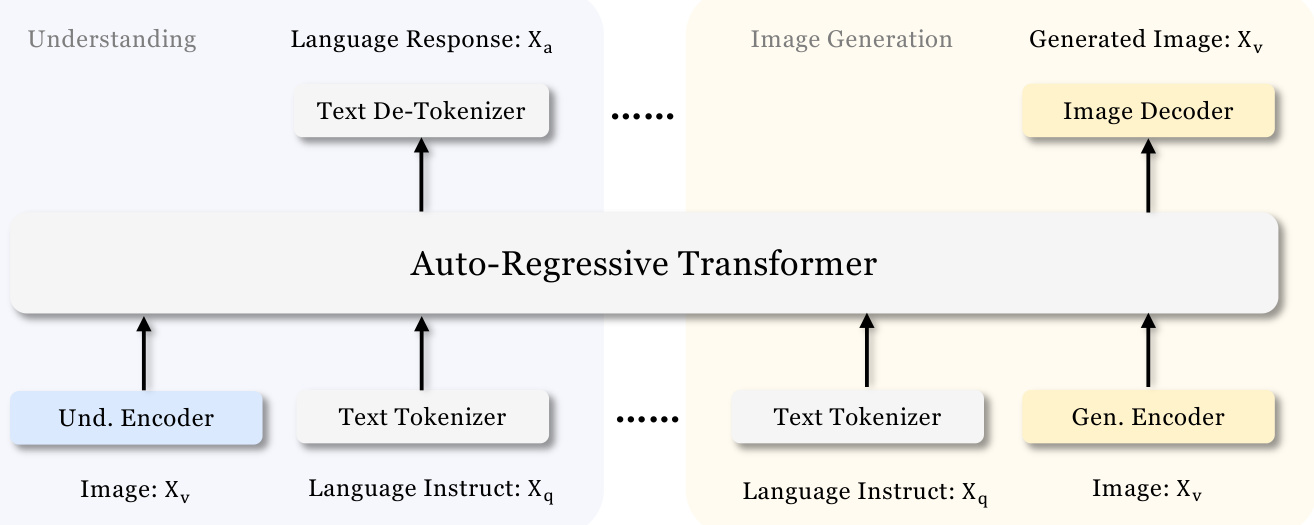

Figura 3 Arquitetura do Janus-Pro. Desacoplamos a codificação visual para compreensão multimodal e geração visual. "Und. Encoder" e "Gen. Encoder" são abreviações de "Understanding Encoder" e "Generation Encoder", respectivamente. "Und. Encoder" e "Gen. Encoder" são abreviações de "Understanding Encoder" e "Generation Encoder", respectivamente. Melhor visualizado na tela.

2. metodologia

2.1.

A arquitetura do Janus-Pro é mostrada na Figura 3 e é a mesma do Janus [46]. O princípio central do projeto da arquitetura geral é desacoplar a codificação visual para compreensão e geração multimodal. Aplicamos métodos de codificação independentes para converter entradas brutas em recursos, que são então processados por um transformador autorregressivo unificado. Para a compreensão multimodal, usamos o codificador SigLIP [53] para extrair recursos semânticos de alta dimensão das imagens. Esses recursos são distribuídos de uma malha 2-D para uma sequência 1-D, e esses recursos de imagem são mapeados para o espaço de entrada do LLM usando um adaptador de compreensão. Para a tarefa de geração visual, usamos o VQ tagger de [38] para converter imagens em IDs discretos. Depois de achatar as sequências de IDs para 1-D, usamos um adaptador generativo para mapear os embeddings de codebook correspondentes a cada ID para o espaço de entrada do LLM. Em seguida, concatenamos essas sequências de recursos para formar uma sequência de recursos multimodais, que é posteriormente alimentada no LLM para processamento. Além do cabeçalho de previsão incorporado no LLM, usamos um cabeçalho de previsão inicializado aleatoriamente para a previsão de imagens em tarefas de geração visual. Todo o modelo segue uma estrutura autorregressiva.

2.2 Estratégias de treinamento otimizadas

A versão anterior do Janus usava um processo de treinamento em três estágios. O primeiro estágio concentra-se no treinamento de adaptadores e cabeçotes de imagem. A segunda fase tratou do pré-treinamento uniforme, em que todos os componentes, exceto o codificador de compreensão e o codificador de geração, atualizam seus parâmetros. A terceira fase é o ajuste fino supervisionado, que se baseia na segunda fase, desbloqueando ainda mais os parâmetros do codificador de compreensão durante o processo de treinamento. Há alguns problemas com essa estratégia de treinamento. Na segunda fase, o Janus divide o treinamento do recurso de conversão de texto em imagem em duas partes, seguindo o PixArt [4]. A primeira parte foi treinada com dados do ImageNet [9], usando nomes de categorias de imagens como dicas para imagens geradas por texto, com o objetivo de modelar dependências de pixels. A segunda parte foi treinada usando dados de imagens geradas por texto simples. Na implementação, 66,67% das etapas de treinamento de imagens geradas por texto na segunda fase foram alocadas para a primeira parte. No entanto, por meio de outros experimentos, descobrimos que essa estratégia não é a ideal e leva a ineficiências computacionais significativas.

Duas alterações foram feitas para resolver esse problema.

- Treinamento mais longo na primeira faseAdicionamos uma etapa de treinamento de primeiro estágio que permite o treinamento completo no conjunto de dados ImageNet. Nossas descobertas mostram que, mesmo com parâmetros LLM fixos, o modelo pode modelar com eficiência as dependências de pixel e gerar imagens sensatas com base em nomes de categorias.

- Treinamento focado na Fase IINa segunda fase, abandonamos os dados do ImageNet e utilizamos diretamente os dados de imagem gerados por texto simples para treinar o modelo para gerar imagens com base em descrições densas. Essa abordagem reformulada permite que a segunda fase utilize dados de imagens geradas por texto com mais eficiência, melhorando assim a eficiência do treinamento e o desempenho geral.

Também ajustamos as proporções de dados dos diferentes tipos de conjuntos de dados no terceiro estágio do processo de ajuste fino supervisionado, alterando a proporção de dados multimodais, dados somente de texto e dados de imagens geradas por texto de 7:3:10 para 5:1:4. Ao diminuir ligeiramente a proporção de dados de imagens geradas por texto, observamos que esse ajuste nos permitiu obter um melhor desempenho de compreensão multimodal e, ao mesmo tempo, manter fortes recursos de geração visual.

2.3 Extensões de dados

Ampliamos os dados de treinamento usados pelo Janus na compreensão multimodal e na geração de visão.

- compreensão multimodalPara os dados de pré-treinamento do segundo estágio, nos referimos ao DeepSeekVL2 [49] e adicionamos cerca de 90 milhões de amostras. Esses dados incluem conjuntos de dados de legendas de imagens (por exemplo, YFCC [31]), bem como dados para compreensão de tabelas, gráficos e documentos (por exemplo, Docmatix [20]). Para o terceiro estágio de dados de ajuste fino supervisionado, também adicionamos conjuntos de dados adicionais do DeepSeek-VL2, como compreensão de MEME, dados de diálogo chinês e conjuntos de dados projetados para aprimorar a experiência de diálogo. Essas adições ampliam significativamente os recursos do modelo, enriquecendo sua capacidade de lidar com uma variedade de tarefas e, ao mesmo tempo, melhorando a experiência geral de diálogo.

- produção visualJanus-Pro: Observamos que os dados do mundo real usados na versão anterior do Janus não tinham qualidade e continham um ruído significativo, o que geralmente resultava em imagens instáveis geradas por texto, levando a um resultado esteticamente ruim. No Janus-Pro, incluímos aproximadamente 72 milhões de amostras de dados estéticos sintéticos para elevar a proporção de dados reais e sintéticos para 1:1 na fase de pré-treinamento unificado. As experiências mostraram que, ao treinar com dados sintéticos, o modelo converge mais rapidamente e produz não apenas uma imagem gerada por texto mais estável, mas também uma qualidade estética significativamente melhor.

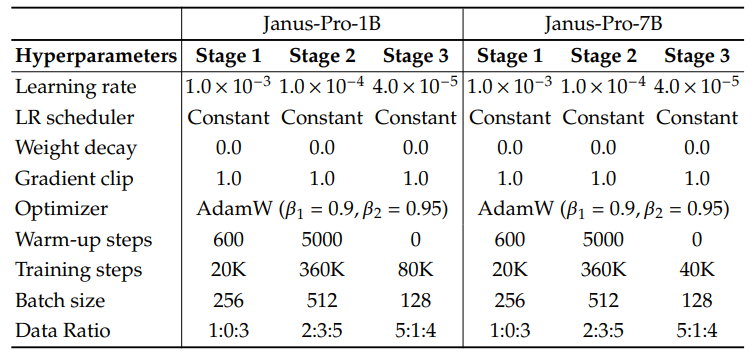

2.4 Extensões do modelo

Uma versão anterior do Janus verificou a eficácia do uso do LLM de 1,5B para a dissociação da codificação visual. No Janus-Pro, estendemos o modelo para 7B, e os hiperparâmetros dos LLMs de 1,5B e 7B estão detalhados na Tabela 1. Observamos um aumento significativo na velocidade de convergência da compreensão multimodal e da perda de geração visual ao usar LLMs maiores em comparação com modelos menores. Essa descoberta valida ainda mais a escalabilidade robusta dessa abordagem.

Tabela 1 Configuração da arquitetura do Janus-Pro. Listamos os hiperparâmetros da arquitetura.

| Janus-Pro-1B | Janus-Pro-7B | |

| Tamanho do vocabulário | 100K | 100K |

| Tamanho da incorporação | 2048 | 4096 |

| janela de contexto | 4096 | 4096 |

| capacidade de atenção | 16 | 32 |

| andar | 24 | 30 |

Tabela 2 Hiperparâmetros detalhados para o treinamento do Janus-Pro. A proporção de dados refere-se à proporção de dados de compreensão multimodal, dados de texto simples e dados gerados visualmente.

3. experimentos

3.1 Detalhes da implementação

Em nossos experimentos, usamos o DeepSeek-LLM (1,5B e 7B) [3] como modelo de linguagem de base com um comprimento máximo de sequência suportado de 4096. Para o codificador visual usado na tarefa de compreensão, escolhemos o SigLIP-Large-Patch16-384 [53]. O codificador de geração tem um livro de códigos de tamanho 16.384 e reduz a amostragem da imagem 16 vezes. Tanto o adaptador de compreensão quanto o adaptador de geração são MLPs de duas camadas. Os hiperparâmetros detalhados para cada estágio são fornecidos na Tabela 2. Todas as imagens foram redimensionadas para 384x384 pixels. Para os dados de compreensão multimodal, redimensionamos o lado longo da imagem para 384 e preenchemos o lado curto com a cor de fundo (RGB: 127, 127, 127) para chegar a 384. Para os dados de geração visual, o lado curto é redimensionado para 384 e o lado longo é cortado para 384. Usamos o empacotamento de sequências durante o processo de treinamento para aumentar a eficiência do treinamento. Misturamos todos os tipos de dados de acordo com as proporções especificadas em uma única etapa de treinamento. Nosso Janus é treinado e avaliado usando o HAI-LLM [15], uma estrutura de treinamento distribuída leve e eficiente criada com base no PyTorch. Todo o processo de treinamento levou aproximadamente 7/14 dias em um cluster de 16/32 nós equipado com 8 GPUs Nvidia A100 (40GB) para modelos de 1,5B/7B.

3.2 Avaliação das configurações

Compreensão multimodal: Para avaliar a compreensão multimodal, avaliamos nosso modelo em benchmarks visuais-verbais baseados em imagens amplamente reconhecidos, incluindo GQA [17], POPE [23], MME [12], SEED [21], MMB [29], MM-Vet [51] e MMMU [52].

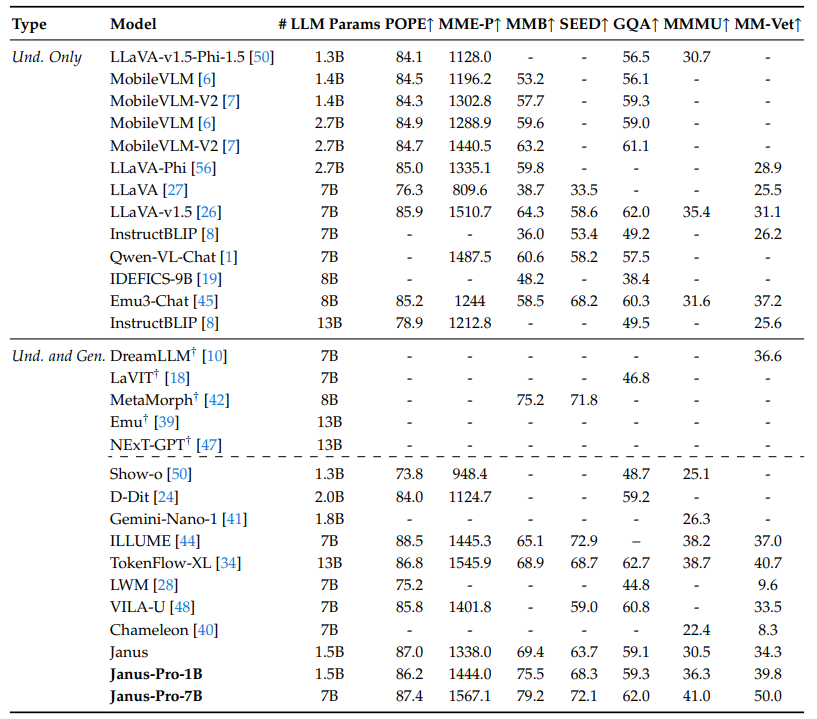

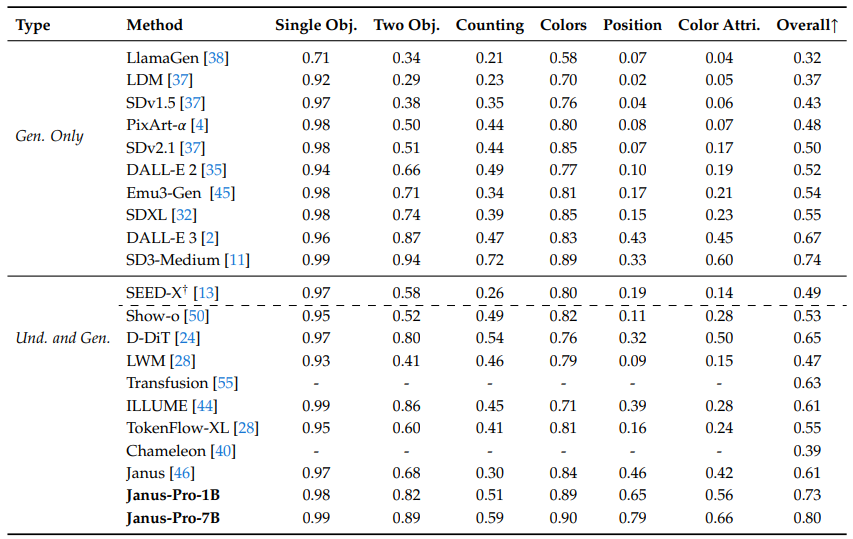

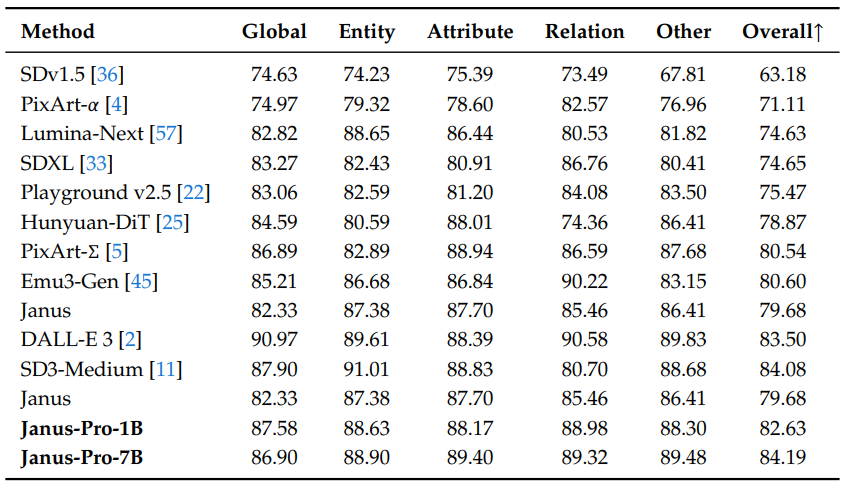

Tabela 3 Comparação com técnicas de última geração em benchmarking de compreensão multimodal. "Und." e "Gen." indicam "Compreensão" e "Geração", respectivamente. Os modelos que usam modelos de difusão externos pré-treinados são marcados com †.

Geração visual: Para avaliar os recursos de geração visual, usamos o GenEval [14] e o DPG-Bench [16]. O GenEval é um benchmark desafiador de geração de imagem para texto projetado para refletir todos os recursos de geração de um modelo de geração visual por meio de uma análise detalhada em nível de instância de seus recursos combinatórios. 1065 dicas longas e densas em um conjunto de dados abrangente projetado para avaliar os complexos recursos de alinhamento semântico dos modelos de texto para imagem.

3.3 Comparação com o estado da arte

Desempenho de compreensão multimodal: Na Tabela 3, comparamos a abordagem proposta com os modelos unificados e somente de compreensão de última geração. Isso pode ser atribuído à dissociação da compreensão multimodal e da codificação visual gerada, o que alivia o conflito entre essas duas tarefas. O Janus-Pro continua altamente competitivo quando comparado a modelos muito maiores. Por exemplo, o Janus-Pro-7B supera o TokenFlow-XL (13B) em todos os benchmarks, exceto no GQA.

Tabela 4 Avaliação da geração de texto para imagem no benchmark GenEval. "Und." e "Gen." indicam "Compreensão" e "Geração", respectivamente. Os modelos que usam modelos de difusão pré-treinados externos são marcados com †.

Tabela 5 desempenho no DPG-Bench. Com exceção do Janus e do Janus-Pro, todos os métodos dessa tabela são específicos do modelo usado para gerar a tarefa.

Desempenho de geração visual: Relatamos o desempenho da geração visual no GenEval e no DPG-Bench. Conforme mostrado na Tabela 4, nosso Janus-Pro-7B obtém uma precisão geral de 80% no GenEval, o que supera todos os outros métodos unificados ou com suporte somente para geração, por exemplo, Transfusion [55] (63%), SD3-Medium (74%) e DALL-E 3 (67%). Isso mostra que nosso método tem melhor capacidade de seguir instruções. Conforme mostrado na Tabela 5, o Janus-Pro obteve uma pontuação de 84,19 no DPG-Bench, superando todos os outros métodos. Isso mostra que o Janus-Pro é bom em seguir instruções densas para a geração de texto para imagem.

3.4 Resultados qualitativos

Mostramos os resultados da compreensão multimodal na Fig. 4. O Janus-Pro mostra uma compreensão impressionante ao processar entradas de diferentes contextos, demonstrando seu poder. Também mostramos alguns resultados de geração de imagens geradas por texto na parte inferior da Fig. 4. As imagens geradas pelo Janus-Pro-7B são muito realistas e contêm muitos detalhes, embora a resolução seja de apenas $384\times384$. Para cenários imaginativos e criativos, o Janus-Pro-7B captura com precisão as informações semânticas nos prompts e gera imagens sensatas e coerentes.

Figura 4 Resultados qualitativos da compreensão multimodal e dos recursos de geração visual. O modelo é o Janus-Pro-7B, e a saída da imagem gerada visualmente tem uma resolução de $384\times384$. É melhor visualizá-la em uma tela.

4. conclusão

Neste documento, são feitos aprimoramentos no Janus em termos de estratégia de treinamento, dados e tamanho do modelo. Esses aprimoramentos resultam em melhorias significativas na compreensão multimodal e no comando de imagem de geração de texto a seguir. No entanto, o Janus-Pro ainda tem algumas limitações. Para a compreensão multimodal, a resolução de entrada é limitada a $384\times384$, o que afeta seu desempenho em tarefas de granulação fina, como OCR. Para imagens geradas por texto, a baixa resolução, juntamente com a perda de reconstrução introduzida pelo marcador visual, resulta em imagens semanticamente ricas, mas que ainda carecem de detalhes. Por exemplo, pequenas regiões faciais que ocupam espaço limitado na imagem podem não parecer ter detalhes suficientes. O aumento da resolução da imagem pode aliviar esses problemas.

bibliografia

[1] J. Bai, S. Bai, S. Yang, S. Wang, S. Tan, P. Wang, J. Lin, C. Zhou e J. Zhou. qwen-vl: um modelo de linguagem visual de ponta em grande escala com versatilidade. arXiv preprint arXiv:2308.12966, 2023.[2] J. Betker, G. Goh, L. Jing, T. Brooks, J. Wang, L. Li, L. Ouyang, J. Zhuang, J. Lee, Y. Guo, et al. Improving image generation through better captioning (Melhorando a geração de imagens por meio de legendas melhores). Computer Science. https://cdn.openai.com/papers/dall-e-3.pdf, 2(3):8, 2023.

[3] X. Bi, D. Chen, G. Chen, S. Chen, D. Dai, C. Deng, H. Ding, K. Dong, Q. Du, Z. Fu, et al. DeepSeek LLM: Extending open source language models using long-termism. arXiv preprint arXiv:2401.02954, 2024.

[4] J. Chen, J. Yu, C. Ge, L. Yao, E. Xie, Y. Wu, Z. Wang, J. Kwok, P. Luo, H. Lu, et al. PixArtℎ: transformador de difusão de treinamento rápido para síntese de imagem de geração de texto foto-realista. arXiv preprint arXiv:2310.00426, 2023.

[5] J. Chen, C. Ge, E. Xie, Y. Wu, L. Yao, X. Ren, Z. Wang, P. Luo, H. Lu e Z. Li. PixArt-Sigma: weak-to-strong diffusion transformer training for 4K text generation image generation. arXiv preprint arXiv:2403.04692, 2024.

[6] X. Chu, L. Qiao, X. Lin, S. Xu, Y. Yang, Y. Hu, F. Wei, X. Zhang, B. Zhang, X. Wei, et al. Mobilevlm: um assistente de linguagem visual rápido, reproduzível e poderoso para dispositivos móveis. arXiv preprint arXiv:2312.16886, 2023.

[7] X. Chu, L. Qiao, X. Zhang, S. Xu, F. Wei, Y. Yang, X. Sun, Y. Hu, X. Lin, B. Zhang, et al. Mobilevlm v2: A faster and more powerful basis for visual language modelling. arXiv preprint arXiv:2402.03766, 2024.

[8] W. Dai, J. Li, D. Li, A. M. H. Tiong, J. Zhao, W. Wang, B. Li, P. Fung e S. Hoi. Instructblip: rumo a um modelo de linguagem visual generalizado com ajuste fino de comando, 2023.

[9] J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li e L. Fei-Fei. Imagenet: um banco de dados de imagens hierárquicas em grande escala. Em Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition, páginas 248-255, Institute of Electrical and Electronics Engineers, 2009.

[10] R. Dong, C. Han, Y. Peng, Z. Qi, Z. Ge, J. Yang, L. Zhao, J. Sun, H. Zhou, H. Wei, et al. Dreamllm: multimodal collaborative understanding and creation. arXiv preprint arXiv:2309.11499, 2023.

[11] P. Esser, S. Kulal, A. Blattmann, R. Entezari, J. Mller, H. Saini, Y. Levi, D. Lorenz, A. Sauer, F. Boesel, D. Podell, T. Dockhorn, Z. English, K. Lacey A. Goodwin, Y. Marek e R. Rombach. scaling-corrected stream transformer for high-resolution image synthesis (Transformador de fluxo com correção de escala para síntese de imagem de alta resolução), 2024. URL https://arxiv.org/abs/2403.03206.

[12] C. Fu, P. Chen, Y. Shen, Y. Qin, M. Zhang, X. Lin, J. Yang, X. Zheng, K. Li, X. Sun, et al. MME: a comprehensive evaluation benchmark for multimodal large language models. arXiv preprint arXiv:2306.13394, 2023.

[13] Y. Ge, S. Zhao, J. Zhu, Y. Ge, K. Yi, L. Song, C. Li, X. Ding e Y. Shan. SEED-X: um modelo multimodal com geração e compreensão unificada de multigranularidade. arXiv preprint arXiv:2404.14396, 2024.

[14] D. Ghosh, H. Hajishirzi e L. Schmidt. GenEval: uma estrutura orientada a objetos para avaliar o alinhamento de imagens geradas por texto. Advances in Neural Information Processing Systems, 36, 2024.

[15] High-flyer. HAI-LLM: An Efficient and Lightweight Large Model Training Tool, 2023. URL https://www.high-flyer.cn/en/blog/hai-llm.

[16] X. Hu, R. Wang, Y. Fang, B. Fu, P. Cheng e G. Yu. ELLA: Equipping diffusion models for enhanced semantic alignment (Equipando modelos de difusão para alinhamento semântico aprimorado). arXiv preprint arXiv:2403.05135, 2024.

[17] D. A. Hudson e C. D. Manning. gqa: um novo conjunto de dados para raciocínio visual do mundo real e questionamento combinatório. Em Anais da Conferência IEEE/CVF sobre Visão Computacional e Reconhecimento de Padrões, páginas 6700-6709, 2019.

[18] Y. Jin, K. Xu, L. Chen, C. Liao, J. Tan, B. Chen, C. Lei, A. Liu, C. Song, X. Lei, et al. Dynamic discrete visual tokenisation for visual pre-training in unified language. arXiv preprint arXiv:2309.04669, 2023.

[19] H. Laurenon, D. van Strien, S. Bekman, L. Tronchon, L. Saulnier, T. Wang, S. Karamcheti, A. Singh, G. Pistilli, Y. Jernite e et al. Introducing IDEFICS: an open model for reproducing state-of-the-art visual language models (Apresentando o IDEFICS: um modelo aberto para reproduzir modelos de linguagem visual de última geração), 2023. URL https://huggingface.co/blog/id efics.

[20] H. Laurenon, A. Marafioti, V. Sanh e L. Tronchon. Building and better understanding visual language models: insights and future directions, 2024.

[21] B. Li, R. Wang, G. Wang, Y. Ge, Y. Ge e Y. Shan. SEED-Bench: benchmarking de LLMs multimodais usando compreensão generativa. arXiv preprint arXiv:2307.16125, 2023.

[22] D. Li, A. Kamko, E. Akhgari, A. Sabet, L. Xu e S. Doshi. Playground v2.5: Três pontos de percepção para aprimorar a qualidade estética da geração de imagens geradas por texto. arXiv preprint arXiv:2402.17245, 2024.

[23] Y. Li, Y. Du, K. Zhou, J. Wang, W. X. Zhao e J.-R. Wen. Evaluating object illusions in large-scale visual language models. arXiv preprint arXiv:2305.10355, 2023.

[24] Z. Li, H. Li, Y. Shi, A. B. Farimani, Y. Kluger, L. Yang e P. Wang. double diffusion for unified image generation and understanding. arXiv preprint arXiv:2501.00289, 2024.

[25] Z. Li, J. Zhang, Q. Lin, J. Xiong, Y. Long, X. Deng, Y. Zhang, X. Liu, M. Huang, Z. Xiao, et al. Hunyuan-DiT: um poderoso transformador de difusão multirresolução com excelente compreensão do chinês. arXiv preprint arXiv:2405.08748, 2024.

[26] H. Liu, C. Li, Y. Li e Y. J. Lee. Linhas de base de ajuste fino aprimoradas para comandos visuais. Em Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, páginas 26296-26306, 2024.

[27] H. Liu, C. Li, Q. Wu e Y. J. Lee. visual command fine-tuning. Advances in Neural Information Processing Systems, 36, 2024.

[28] H. Liu, W. Yan, M. Zaharia e P. Abbeel. world model on million-length videos and languages using ring attention. arXiv preprint arXiv:2402.08268, 2024.

[29] Y. Liu, H. Duan, Y. Zhang, B. Li, S. Zhang, W. Zhao, Y. Yuan, J. Wang, C. He, Z. Liu, et al. MMBench: seu modelo multimodal é versátil? arXiv preprint arXiv:2307.06281, 2023.

[30] Y. Ma, X. Liu, X. Chen, W. Liu, C. Wu, Z. Wu, Z. Pan, Z. Xie, H. Zhang, X. yu, L. Zhao, Y. Wang, J. Liu e C. Ruan. Janusflow: reconciliando fluxos autorregressivos e corretivos para geração e compreensão multimodal unificada, 2024.

[31] mehdidc. yfcc-huggingface. https://huggingface.co/datasets/mehdidc/yfcc15 m, 2024.

[32] D. Podell, Z. English, K. Lacey, A. Blattmann, T. Dockhorn, J. Mller, J. Penna e R. Rombach. sdxl: improving potential diffusion models for high-resolution image synthesis. arXiv preprint arXiv:2307.01952,. 2023.

[33] D. Podell, Z. English, K. Lacey, A. Blattmann, T. Dockhorn, J. Mller, J. Penna e R. Rombach. sdxl: improving potential diffusion models for high resolution image synthesis. 2024.

[34] L. Qu, H. Zhang, Y. Liu, X. Wang, Y. Jiang, Y. Gao, H. Ye, D. K. Du, Z. Yuan e X. Wu. Tokenflow: a unified image tagger for multimodal understanding and generation. arXiv preprint arXiv:2412.03069, 2024.

[35] A. Ramesh, P. Dhariwal, A. Nichol, C. Chu e M. Chen. hierarchical text-conditional image generation using CLIP latent values. arXiv preprint arXiv:2204.06125, 1(2):3, 2022.

[36] R. Rombach, A. Blattmann, D. Lorenz, P. Esser e B. Ommer. Síntese de imagens de alta resolução usando um modelo de difusão latente. 2022.

[37] R. Rombach, A. Blattmann, D. Lorenz, P. Esser e B. Ommer. Síntese de imagens de alta resolução usando modelos de difusão latente. Em Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, páginas 10684-10695, 2022.

[38] P. Sun, Y. Jiang, S. Chen, S. Zhang, B. Peng, P. Luo e Z. Yuan. Autoregressive models beat diffusion: the LLama for scalable image generation. arXiv preprint arXiv:2406.06525, 2024.

[39] Q. Sun, Q. Yu, Y. Cui, F. Zhang, X. Zhang, Y. Wang, H. Gao, J. Liu, T. Huang e X. Wang. multimodal generative pretraining. arXiv preprint arXiv:2307.05222, 2023.

[40] C. Team. Chameleon: Um modelo básico para fusão antecipada de modos mistos. arXiv preprint arXiv:2405.09818, 2024.

[41] G. Team, R. Anil, S. Borgeaud, Y. Wu, J.-B. Alayrac, J. Yu, R. Soricut, J. Schalkwyk, A. M. Dai, A. Hauth, et al. Gêmeos: uma família de modelos multimodais capazes. arXiv preprint arXiv:2312.11805, 2023.

[42] S. Tong, D. Fan, J. Zhu, Y. Xiong, X. Chen, K. Sinha, M. Rabbat, Y. LeCun, S. Xie e Z. Liu. Metamorph: multimodal understanding and generation through instruction fine-tuning. arXiv preprint arXiv:2412.14164,. 2024.

[43] Vivym. Meio da jornada Conjunto de dados do prompt. https://huggingface.co/datasets/vivym/midjourney-prompts, 2023. Data da visita: [insira a data da visita, por exemplo, 2023-10-15].

[44] C. Wang, G. Lu, J. Yang, R. Huang, J. Han, L. Hou, W. Zhang e H. Xu. Illume: illuminating your LLMs to see, draw, and self-enhance. arXiv preprint arXiv:2412.06673, 2024.

[45] X. Wang, X. Zhang, Z. Luo, Q. Sun, Y. Cui, J. Wang, F. Zhang, Y. Wang, Z. Li, Q. Yu, et al. Emu3: the next tag prediction is all you need. arXiv preprint arXiv:2409.18869, 2024.

[46] C. Wu, X. Chen, Z. Wu, Y. Ma, X. Liu, Z. Pan, W. Liu, Z. Xie, X. Yu, C. Ruan, et al. Janus: decoupling visual coding for unified multimodal understanding and generation. arXiv preprint arXiv:2410.13848, 2024.

[47] S. Wu, H. Fei, L. Qu, W. Ji e T.-S. Chua. next-gpt: any-to-any multimodal LLM. arXiv preprint arXiv:2309.05519, 2023.

[48] Y. Wu, Z. Zhang, J. Chen, H. Tang, D. Li, Y. Fang, L. Zhu, E. Xie, H. Yin, L. Yi, et al. VILA-U: a foundational model for integrating visual understanding and generation. arXiv preprint arXiv:2409.04429, 2024.

[49] Z. Wu, X. Chen, Z. Pan, X. Liu, W. Liu, D. Dai, H. Gao, Y. Ma, C. Wu, B. Wang, et al. DeepSeek-VL2: modelo de linguagem visual especializado híbrido para compreensão multimodal avançada. arXiv preprint arXiv:2412.10302, 2024.

[50] J. Xie, W. Mao, Z. Bai, D. J. Zhang, W. Wang, K. Q. Lin, Y. Gu, Z. Chen, Z. Yang e M. Z. Shou. show-o: a single converter for unified multimodal understanding and generation. arXiv preprint arXiv:2408.12528,. 2024.

[51] W. Yu, Z. Yang, L. Li, J. Wang, K. Lin, Z. Liu, X. Wang e L. Wang. MM-Vet: assessing the integrative power of large multimodal models. arXiv preprint arXiv:2308.02490, 2023.

[52] X. Yue, Y. Ni, K. Zhang, T. Zheng, R. Liu, G. Zhang, S. Stevens, D. Jiang, W. Ren, Y. Sun, et al. MMMU: A large-scale multidisciplinary multimodal understanding and inference benchmark for expert AGI. in Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 9556-9567, 2024.

[53] X. Zhai, B. Mustafa, A. Kolesnikov e L. Beyer. sigmoid loss for language image pretraining. Em Proceedings of the IEEE/CVF International Conference on Computer Vision, páginas 11975-11986, 2023.

[54] C. Zhao, Y. Song, W. Wang, H. Feng, E. Ding, Y. Sun, X. Xiao e J. Wang. Monoformer: a single converter for diffusion and autoregression. arXiv preprint arXiv:2409.16280, 2024.

[55] C. Zhou, L. Yu, A. Babu, K. Tirumala, M. Yasunaga, L. Shamis, J. Kahn, X. Ma, L. Zettlemoyer e O. Levy. Transfusion: predicting the next labelled and diffused image using a multimodal model. arXiv Preprint. arXiv:2408.11039, 2024.

[56] Y. Zhu, M. Zhu, N. Liu, Z. Ou, X. Mou e J. Tang. lLAVA-Phi: Efficient multimodal assistant with small language models. arXiv preprint arXiv:2401.02330, 2024.[57] L. Zhuo, R. Du, H. Xiao, Y. Li, D. Liu, R. Huang, W. Liu, L. Zhao, F.-Y. Wang, Z. Ma, et al. Lumina-Next: tornando o Lumina-T2X mais poderoso e mais rápido com o Next-DiT. arXiv preprint arXiv:2406.18583, 2024.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...