DeepSeek-VL2: um modelo de linguagem visual especializado para compreensão multimodal avançada

Introdução geral

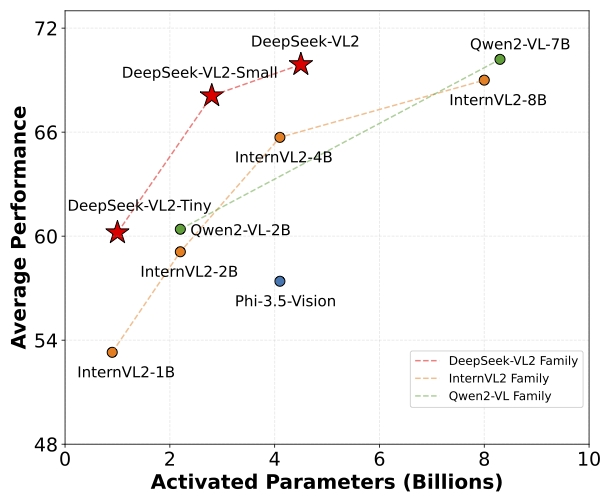

O DeepSeek-VL2 é uma série de modelos avançados de linguagem visual Mixture-of-Experts (MoE) que melhoram significativamente o desempenho de seu antecessor, o DeepSeek-VL. Os modelos se destacam em tarefas como resposta visual a perguntas, reconhecimento óptico de caracteres, compreensão de documentos/tabelas/diagramas e localização visual. A família DeepSeek-VL2 consiste em três variantes: DeepSeek-VL2-Tiny, DeepSeek-VL2-Small e DeepSeek-VL2, que têm 1,0B, 2,8B e 4,5B parâmetros de ativação, respectivamente. parâmetros de ativação, respectivamente. Os modelos alcançam desempenho comparável ou superior aos modelos densos e MoE de código aberto existentes com número de parâmetros semelhante ou menor.

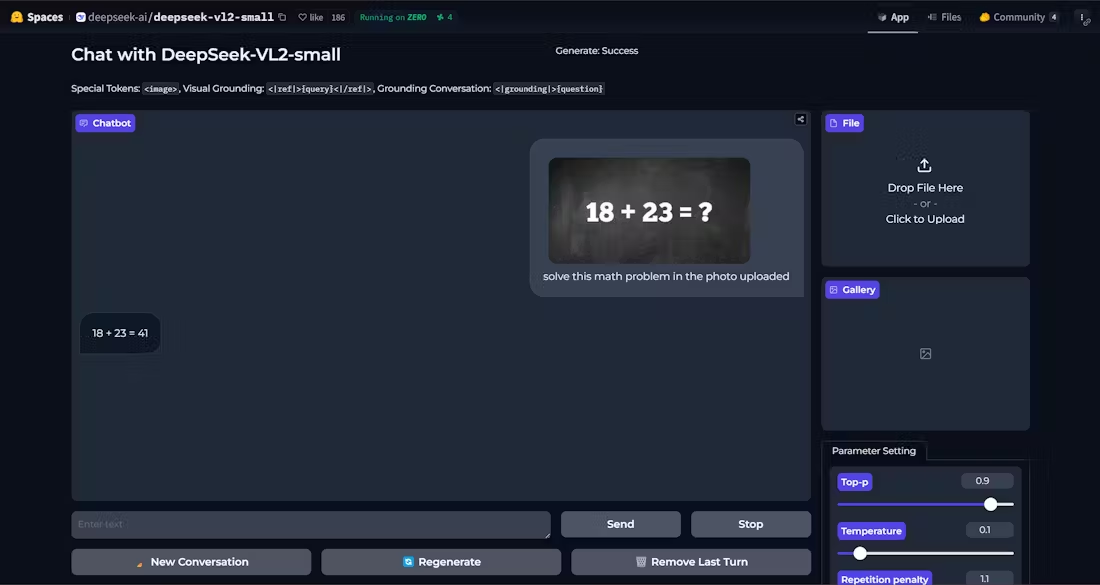

Demonstração: https://huggingface.co/spaces/deepseek-ai/deepseek-vl2-small

Lista de funções

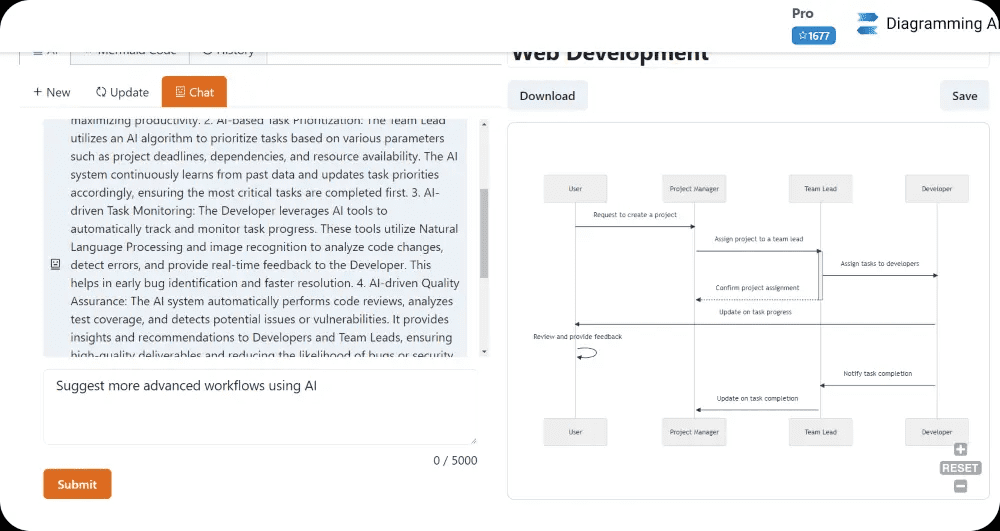

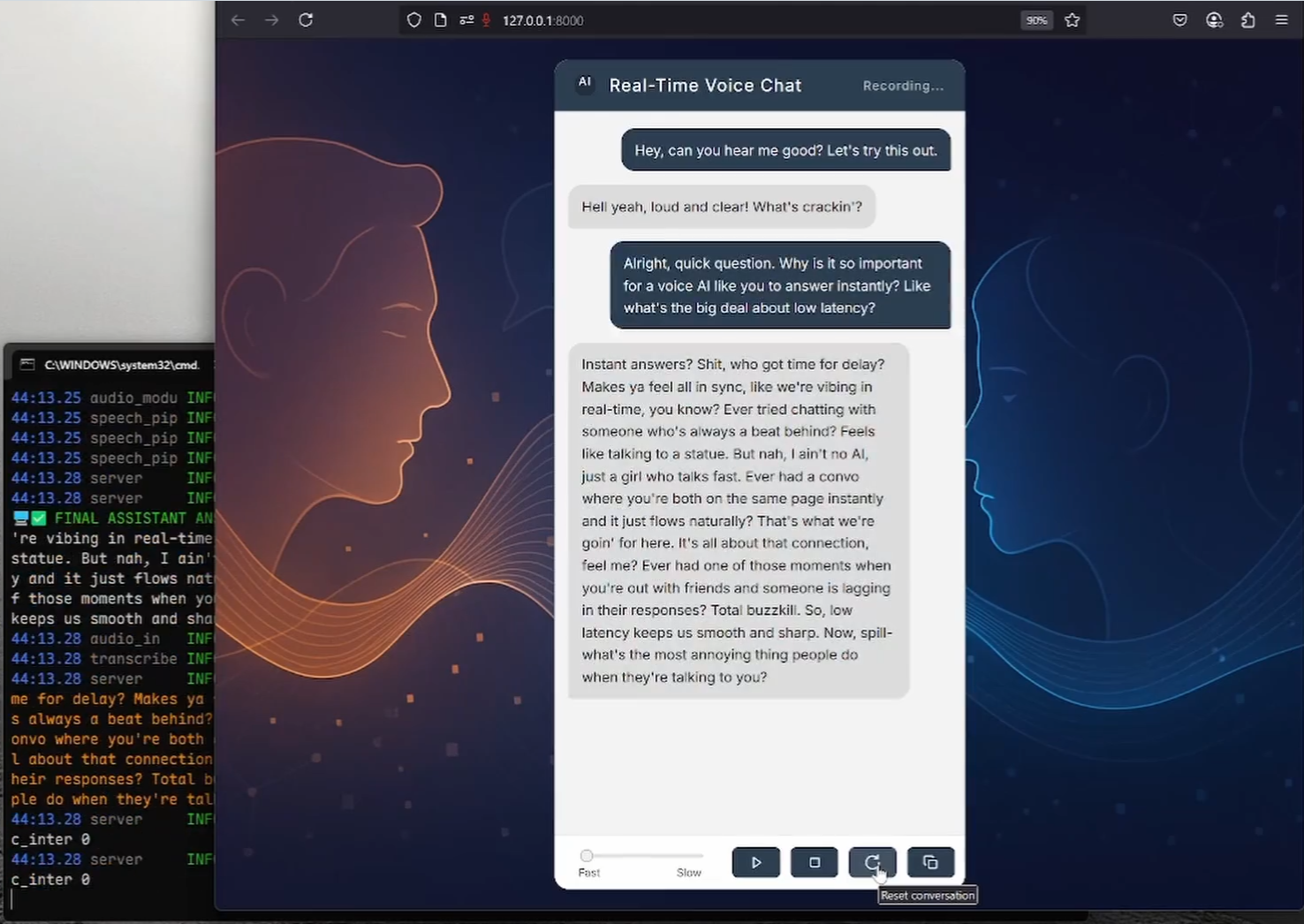

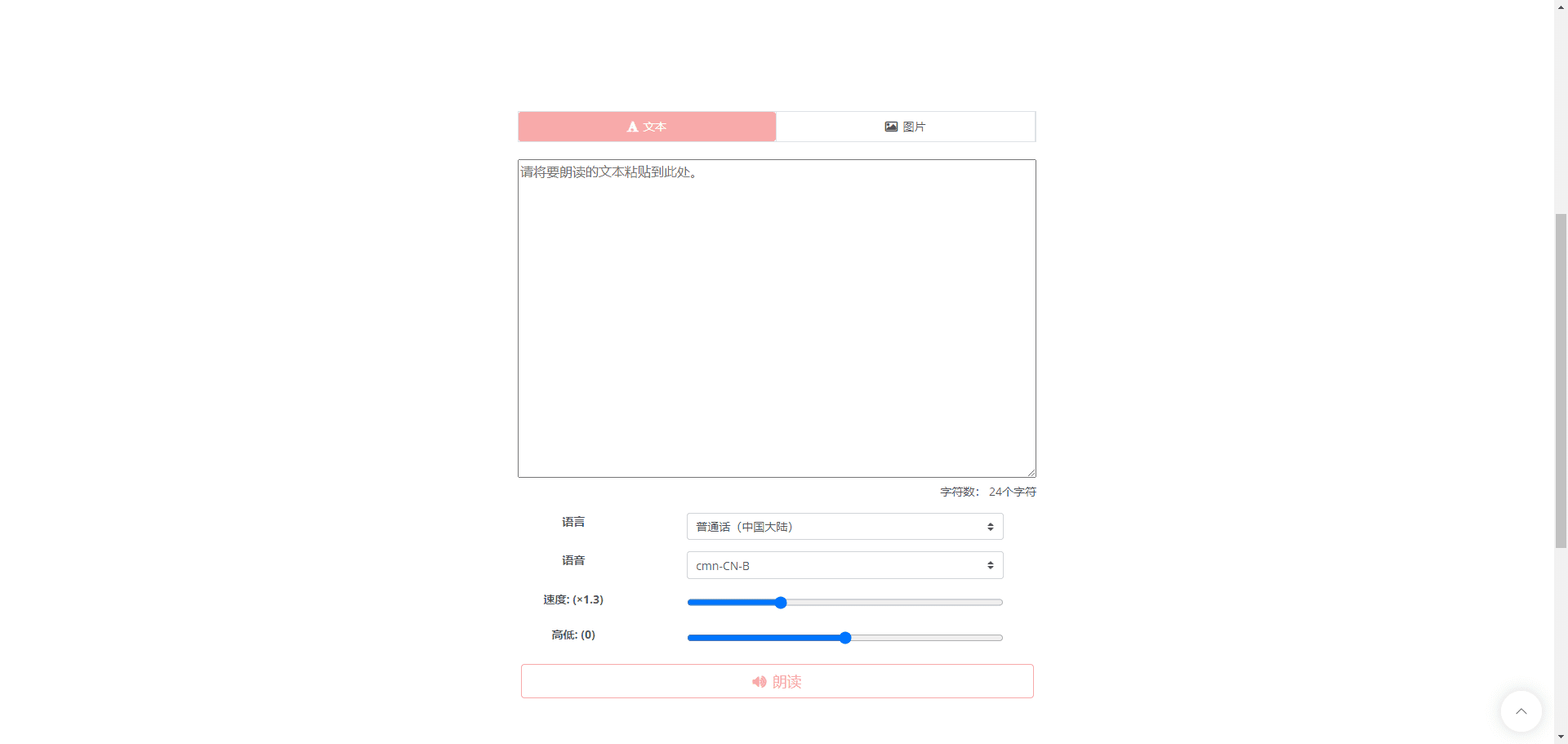

- Perguntas e respostas visuaisSuporte a tarefas complexas de questionários visuais, fornecendo respostas precisas.

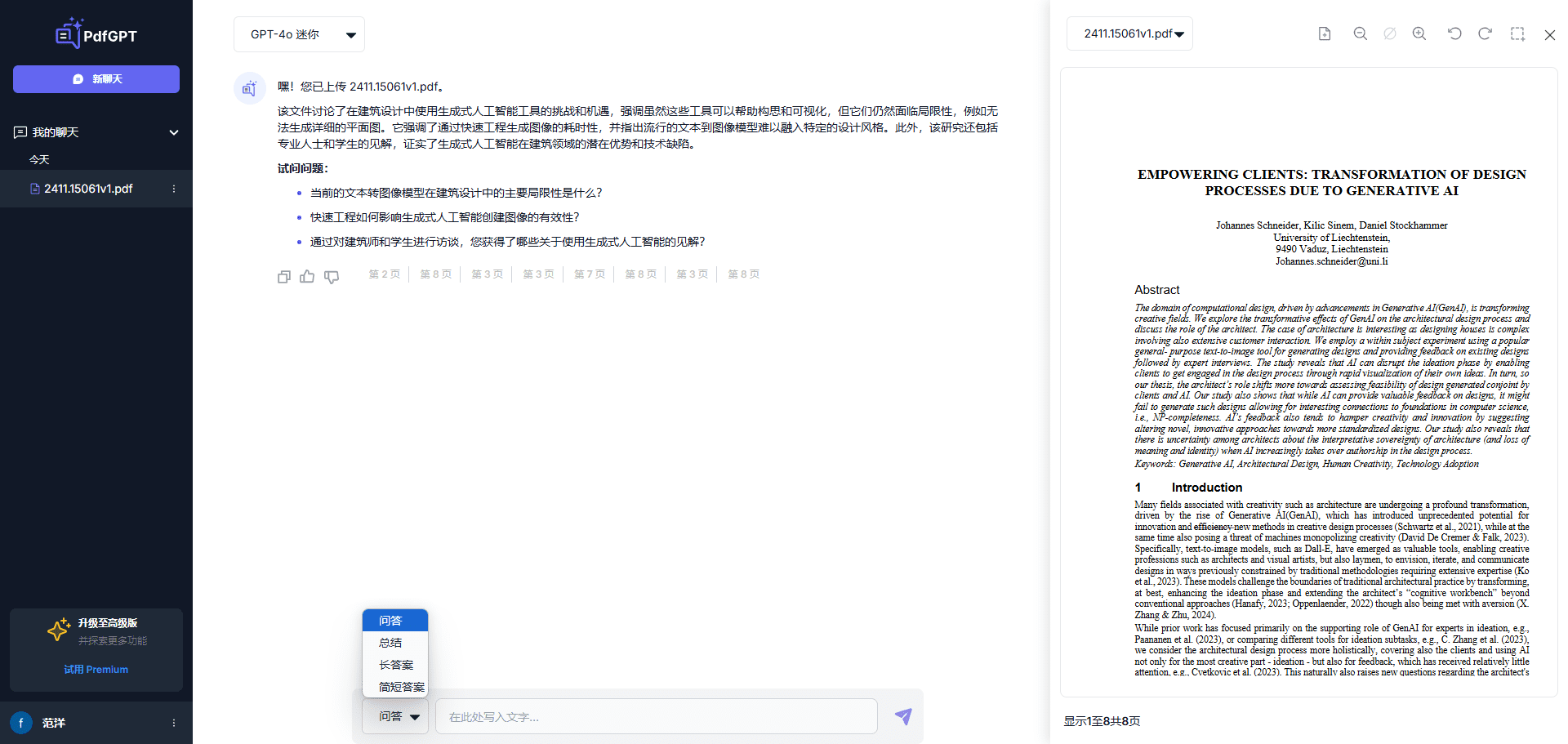

- Reconhecimento óptico de caracteres (OCR)Reconhecimento eficiente de conteúdo de texto em imagens.

- Compreensão do documentoAnálise e compreensão da estrutura e do conteúdo de documentos complexos.

- Compreensão de formuláriosIdentificação e processamento de dados tabulares para extrair informações úteis.

- Compreensão gráficaAnálise e interpretação de dados e tendências em gráficos e quadros.

- orientação visualLocalize com precisão o objeto-alvo na imagem.

- Suporte a várias variantesOs modelos Tiny, Small e Standard estão disponíveis para atender a diferentes necessidades.

- Alto desempenhoRedução do número de parâmetros de ativação, mantendo o alto desempenho.

Usando a Ajuda

Processo de instalação

- Certifique-se de que a versão do Python seja >= 3.8.

- Clonagem do repositório DeepSeek-VL2:

git clone https://github.com/deepseek-ai/DeepSeek-VL2.git

- Vá para o diretório do projeto e instale as dependências necessárias:

cd DeepSeek-VL2

pip install -e .

exemplo de uso

Exemplo de raciocínio simples

Abaixo está um código de amostra para inferência simples usando o DeepSeek-VL2:

import torch

from transformers import AutoModelForCausalLM

from deepseek_vl2.models import DeepseekVLV2Processor, DeepseekVLV2ForCausalLM

from deepseek_vl2.utils.io import load_pil_images

# 指定模型路径

model_path = "deepseek-ai/deepseek-vl2-tiny"

vl_chat_processor = DeepseekVLV2Processor.from_pretrained(model_path)

vl_model = DeepseekVLV2ForCausalLM.from_pretrained(model_path)

# 加载图像

images = load_pil_images(["path_to_image.jpg"])

# 推理

inputs = vl_chat_processor(images=images, return_tensors="pt")

outputs = vl_model.generate(**inputs)

print(outputs)

Fluxo de operação detalhado da função

- Perguntas e respostas visuais::

- Carregue modelos e processadores.

- Insira uma imagem e uma pergunta e o modelo retornará a resposta.

- Reconhecimento óptico de caracteres (OCR)::

- fazer uso de

DeepseekVLV2ProcessorCarregar imagem. - O modelo é chamado para inferência para extrair o texto na imagem.

- fazer uso de

- Compreensão do documento::

- Carrega a entrada que contém a imagem do documento.

- O modelo analisa a estrutura do documento e retorna o resultado da análise.

- Compreensão de formulários::

- Insira uma imagem que contenha o formulário.

- O modelo reconhece a estrutura e o conteúdo do formulário e extrai as principais informações.

- Compreensão gráfica::

- Carregar a imagem do gráfico.

- O modelo analisa dados gráficos, fornecendo interpretação e análise de tendências.

- orientação visual::

- Insira uma descrição e uma imagem do objeto de destino.

- O modelo localiza o objeto-alvo na imagem e retorna as coordenadas de posição.

Com as etapas acima, os usuários podem aproveitar ao máximo o poder do DeepSeek-VL2 para concluir uma variedade de tarefas complexas de linguagem visual.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...