DeepSeek R1 vs. o3-mini: quem é o modelo de inferência mais econômico para 2025?

OpenAI o3-mini junto com DeepSeek R1: Uma comparação detalhada dos modelos avançados de inferência de IA para entender as principais diferenças entre os dois principais modelos de inferência.

No campo em constante mudança da tecnologia de inteligência artificial (IA), os modelos de inferência se tornaram o ponto focal da inovação tecnológica. O o3-mini da openAI é o primeiro de seu tipo no mundo a ser usado no campo. DeepSeek R1 da mesma forma que essa tendência Surgiram dois modelos excepcionais. Ambos são dedicados à solução de problemas complexos, desafios de programação e tarefas científicas, mas diferem significativamente em sua filosofia de projeto, desempenho, estrutura de custos e caminho para a realização.

Este artigo tem como objetivo fornecer uma análise aprofundada das principais diferenças entre o OpenAI o3-mini e o DeepSeek R1 em termos profissionais e concisos. O artigo analisará cuidadosamente comparações O projeto arquitetônico, os benchmarks de desempenho, as estratégias de preços e os cenários típicos de aplicativos dos dois modelos buscam fornecer aos leitores objetivo análises, ajudando assim os leitores a tomar decisões com base em suas necessidades ideal Selecione.

OpenAI o3-mini com DeepSeek R1

Visão geral do OpenAI o3-mini

O lançamento do o3-mini no início de 2025 é uma parte importante da estratégia da OpenAI para continuar a refinar seus modelos de inferência eficientes e precisos. O o3-mini será lançado no início de 2025 por meio do ChatGPT A comunidade oferece acesso ao o3-mini aos usuários, incluindo usuários gratuitos com acesso limitado, bem como assinantes Plus, Team e Pro de maior prioridade. Comentário: descrever as iterações de tecnologia em empresas de tecnologia como um "esforço contínuo" é um pouco vazio, mas, na verdade, são atualizações regulares impulsionadas pela concorrência no mercado. O ponto forte do o3-mini é sua capacidade de lidar com uma ampla gama de tarefas de forma rápida e precisa, com especialização especial em raciocínio lógico, geração de código e solução de problemas em assuntos STEM.

Principais recursos do o3-mini

- Habilidades de raciocínio avançado. O o3-mini foi projetado para simular o processo cognitivo do "pensamento passo a passo", permitindo que ele divida problemas complexos em subproblemas mais gerenciáveis, melhorando assim a eficiência e a precisão da solução de problemas. Comentário: Embora o "pensamento passo a passo" seja uma descrição antropomórfica, ele é, na verdade, uma técnica algorítmica e não deve ser interpretado como se a IA tivesse um pensamento semelhante ao humano.

- Tempo de resposta rápido. Os benchmarks mostram que o o3-mini é capaz de fornecer respostas a tarefas como quebra-cabeças de codificação e matemática em segundos, demonstrando excelente capacidade de resposta.

- Arquitetura de transformador denso. O o3-mini usa intensivamente Transformador arquitetura, cada entrada Token são tratados pelo conjunto completo de parâmetros do modelo, garantindo que o modelo permaneça em uma variedade de tarefas estabelecido Desempenho.

- Excelência em codificação e STEM. O o3-mini provou ser excelente na geração de códigos, na resolução de quebra-cabeças lógicos e no processamento de consultas relacionadas à ciência, e demonstrou grande potencial para uso em aplicativos STEM em particular.

- Profundamente integrado ao ChatGPT. O modelo o3-mini é o principal driver da API do ChatGPT e os recursos avançados da interface da Web, fornecendo suporte técnico sólido para o aplicativo inteligente do ChatGPT.

Preços do o3-mini

O preço do o3-mini é mais ou menos o seguinte, com base nos dados comparativos mais recentes do mercado:

- US$ 1,10 por milhão de tokens de entrada

- US$ 4,40 por milhão de produção de tokens

Com preço em token, o preço da o3-mini se compara favoravelmente com alguns dos concorrência Um pouco mais alto, mas com sua excelente velocidade e precisão, o muitos casos chegar a (uma decisão, conclusão etc.) provar A razoabilidade desse custo. Comentário: a frase "geralmente justifica o custo" é um pouco subjetiva, e o fator preço continua sendo fundamental para usuários sensíveis ao orçamento.

Visão geral do DeepSeek R1

Objetivos de publicação e design

O DeepSeek R1 foi desenvolvido pela startup chinesa de IA DeepSeek, fundada por Wenfeng Liang. O DeepSeek R1 foi lançado oficialmente em janeiro de 2025, com o agora mesmo Ele é notável por sua capacidade de obter um controle de custos competitivo e, ao mesmo tempo, garantir recursos avançados de raciocínio. Além disso, o DeepSeek R1 optou por um modelo de código aberto, o que significa que os desenvolvedores são livres para acessar e modificar seu código-fonte para vários tipos Necessidades individualizadas. Comentário: o argumento de venda de "custo muito baixo" do DeepSeek R1 pode sugerir que ele fez algumas concessões em termos de desempenho, e que a regra "barato não é bom o suficiente" também é verdadeira no mundo da tecnologia.

Principais recursos do DeepSeek R1

- Recursos de código aberto. O design de código aberto do DeepSeek R1 torna seu código disponível para qualquer pessoa baixar e integrar, e esse alto nível de transparência é importante para a Apoiadores do conceito de código aberto é certamente de grande apelo para os desenvolvedores do

- Excelente relação custo-benefício. DeepSeek R1 em design priorizar pensar sobre Eficiência. Graças à arquitetura Mixture-of-Experts (MoE), o DeepSeek R1 consome menos recursos computacionais no tempo de execução, o que reduz significativamente os custos operacionais.

- Visualização da cadeia de pensamento. Ao contrário do processo de inferência implícita do o3-mini, o DeepSeek R1 geralmente em detalhes Apresentação das etapas de raciocínio. Alguns usuários consideraram essa "cadeia de raciocínio visível" útil para obter uma compreensão mais profunda da lógica interna das conclusões do modelo. Comentário: "Cadeia de raciocínio visível" pode parecer um ponto forte do DeepSeek R1, mas um processo de raciocínio excessivamente detalhado pode levar à redundância e até mesmo à confusão para os usuários.

- Arquitetura de combinação de especialistas. O DeepSeek R1 adota a arquitetura MoE, em que o modelo ativa apenas alguns dos parâmetros (ou seja, "especialistas") para cada token. Essa estratégia de design torna o DeepSeek R1 mais eficiente para lidar com tarefas de grande escala.

- Foco na eficiência. Arquitetura do DeepSeek R1 fundamentalmente Focado na redução do custo de treinamento e raciocínio para um orçamento finito As vantagens são óbvias nos cenários de aplicação.

Preços do DeepSeek R1

Em comparação com o OpenAI o3-mini, o DeepSeek R1 em termos de custos de token estatisticamente significativo Inferior:

- Aprox. US$ 0,14 por milhão de tokens de entrada (acerto no cache), com um pequeno aumento de preço quando o cache não é atingido.

- Aproximadamente US$ 2,19 por milhão de produção de tokens.

Comparação da arquitetura técnica

Projeto arquitetônico de modelos de IA direto afeta seu desempenho, custo e eficiência operacional. A tabela a seguir bem Os principais recursos arquitetônicos do OpenAI o3-mini são comparados ao DeepSeek R1.

Arquitetura e comparação de preços

| propriedade de diagnóstico | OpenAI o3-mini | DeepSeek R1 |

|---|---|---|

| Tipo de arquitetura | Transformador denso | Mistura de especialistas (MoE) |

| Parâmetros por token | Processamento totalmente intensivo (todos os parâmetros ativos) | Parcialmente ativado (por exemplo, apenas 2 dos 16 especialistas ativados) |

| janela de contexto | Até 200 mil tokens (dependendo do caso de uso específico) | O valor típico é 128K Token |

| transparência | Proprietário (código fechado) | Código aberto; código e detalhes de treinamento disponíveis publicamente |

| Custo do token de entrada | ~$1,10 por milhão de tokens | ~$0,14 (acessos em cache)/um pouco mais alto em caso de falhas |

| Custo do token de saída | ~$4,40 por milhão de tokens | ~$2,19 por milhão de tokens |

| caso de uso | Codificação, raciocínio lógico, solução de problemas STEM | Raciocínio eficiente, tarefas econômicas |

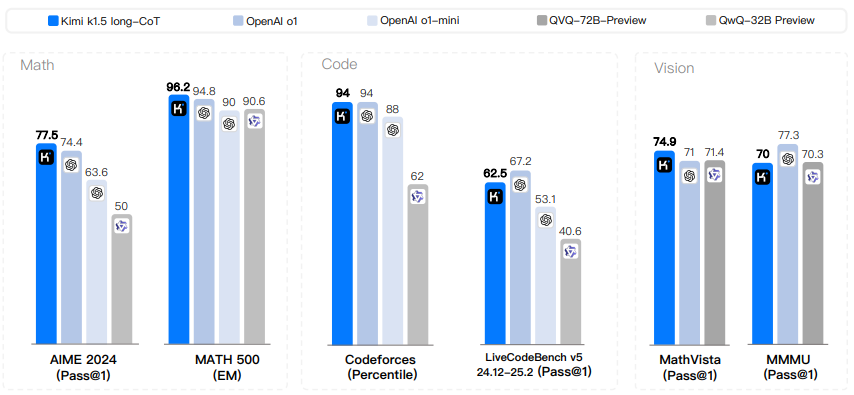

Benchmarks de desempenho no mundo real

para objetivamente Ao avaliar o desempenho dos dois modelos no mundo real, os pesquisadores realizaram uma série de tarefas típicas, como codificação, raciocínio lógico e solução de problemas STEM abrangente Testes. A seguir, um resumo e uma análise dos principais indicadores de desempenho.

tarefa de codificação

Nas análises comparativas desta seção, os pesquisadores apresentaram o OpenAI o3-mini com o modelo DeepSeek R1 ao mesmo tempo que o preferências A mesma tarefa de codificação foi realizada com o objetivo de examinar a diferença de desempenho entre os dois modelos em termos de geração de código. A avaliação se concentra na geração de código que consome tempo, bem como na precisão do código.

- OpenAI o3-mini.

- A geração de código é extremamente rápida (por exemplo, uma tarefa de animação JavaScript leva apenas cerca de 27 segundos para ser concluída).

- O código gerado é bem estruturado, bem organizado e responde com precisão aos requisitos da tarefa.

- DeepSeek R1.

- A geração de código é relativamente demorada (cerca de 1 minuto e 45 segundos para a mesma tarefa de animação em JavaScript).

- Embora o DeepSeek R1 seja capaz de fornecer explicações completas sobre o código, as respostas que ele gera às vezes contêm detalhes ou recursos adicionais não solicitados explicitamente pelo usuário, o que pode parecer redundante em alguns cenários. Comentários: o DeepSeek R1 é lento nas tarefas de codificação e pode produzir informações redundantes, o que sugere que ele pode não ser tão prático quanto o o3-mini para a geração de códigos.

inferência lógica

- OpenAI o3-mini.

- Ser capaz de fornecer um processo de raciocínio passo a passo e uma validação eficaz das conclusões obtidas.

- As respostas são de alta qualidade e as explicações são sucintas.

- DeepSeek R1.

- Apresentar um processo de raciocínio detalhado e mais conversacional do tipo "cadeia de pensamento visível".

- Embora o DeepSeek R1 tenha um bom desempenho em termos de precisão no raciocínio lógico OK mas sua explicação detalhada levar a Tempo de resposta mais longo. Comentário: A "visibilidade detalhada e conversacional da Cadeia de Pensamento" pode ser obtida às custas da velocidade, e seu valor precisará ser ponderado em relação a cenários de aplicativos específicos.

Solução de problemas STEM

- OpenAI o3-mini.

- Resolver problemas STEM em um tempo muito curto (por exemplo, um problema de cálculo de circuito RLC levou apenas 11 segundos).

- Demonstrar etapas claras e estruturadas para cálculos e, quando necessário distinto Arredondamento.

- DeepSeek R1.

- A execução de tarefas STEM semelhantes pode exigir mais longo tempo, até 80 segundos.

- O DeepSeek R1 é igualmente capaz de fornecer uma explicação exaustiva, mas este nível de detalhamento é obtido às custas da velocidade de computação. COMENTÁRIO: O DeepSeek R1 fica significativamente atrás do o3-mini na solução de problemas STEM, o que é mais uma evidência de sua falta de desempenho.

Resumo da comparação de desempenho em tempo real

| Tipo de missão | OpenAI o3-mini | DeepSeek R1 |

|---|---|---|

| Tempo de resposta da codificação | Menos de 1 minuto | 1 minuto ou mais |

| inferência lógica | Rápido, claro e passo a passo (até aproximadamente 90 segundos) | Explicações detalhadas, mas relativamente lentas, em tom de conversa |

| Solução de problemas STEM | 11 segundos, etapas simples | 80 segundos para uma explicação completa |

| precisão | Altamente preciso; as respostas foram mais uma vez Inspeção e validação | Preciso, mas às vezes contém discreto ponto |

| Visibilidade da cadeia de pensamento | Ocultar (somente as respostas finais são apresentadas) | visíveis; mostram cada etapa do processo de raciocínio |

Análise do mecanismo de trabalho da cadeia de pensamento

Dicas de cadeia de pensamento Tecnologia permissível A modelagem leva a problemas complexos se decompõem como Uma série de etapas menores e gerenciáveis. No o3-mini, quando o modelo recebe um problema complexo, ele gera internamente uma série de etapas de raciocínio (mesmo que elas sejam invisíveis para o usuário final) e, por fim, renderiza o eventual Respostas. Esse mecanismo ajuda a obter respostas mais precisas e exatas para consultas complexas com elaborado Resposta.

Casos de uso e cenários de aplicativos

Os modelos OpenAI o3-mini e DeepSeek R1 capaz de cumprir (condições ou requisitos) Amplamente utilizado em vários tipos do cenário da missão habilidades . Os casos de uso típicos de cada um deles estão listados abaixo:

Casos de uso do OpenAI o3-mini

- Codificação e desenvolvimento de software.

- Gere rapidamente trechos de código compatíveis com a sintaxe.

- Integração perfeita com IDEs e vários auxílios de programação para aumentar a eficiência do desenvolvimento.

- Solução de problemas STEM.

- Resolva quebra-cabeças de matemática e cálculos de física com eficiência.

- Fornecimento de consultas complexas no domínio científico incremental Explicação.

- Tarefas de raciocínio lógico.

- Usar etapas claras e concisas para resolver problemas difíceis e lógicos de forma eficaz.

- Aplicativos empresariais.

- Ajudando grandes empresas a automatizar o processo de extração e análise de dados.

- Varredura de segurança.

- Detecte rapidamente possíveis vulnerabilidades em seu código e forneça recomendações direcionadas para corrigi-las.

Casos de uso do DeepSeek R1

- Projeto de código aberto.

- Um ajuste profundo para desenvolvedores que preferem soluções de código aberto personalizáveis.

- Visualização do processo de raciocínio detalhado.

- O recurso de visualização da "cadeia de raciocínio" do DeepSeek R1 é vantajoso em cenários de aplicativos em que a transparência do processo de raciocínio é necessária, como depuração ou educação.

- Ambientes sensíveis ao custo.

- Aplicável a custos de token Extremamente sensível cenários de aplicativos e com uma certa tolerância à latência de resposta.

- Processamento de dados em grande escala.

- Competente para projetos que precisam lidar com solicitações de consulta em massa, mas têm controle rígido sobre o custo de uma única solicitação.

- Pesquisa e experimentação.

- Ideal para pesquisas acadêmicas ou projetos experimentais que exijam personalização profunda do modelo terraço.

Limitações e desafios

Embora o OpenAI o3-mini e o DeepSeek R1 tenham demonstrado excelente desempenho em várias áreas, cada um deles tem limitações.

Limitações do OpenAI o3-mini

- Custo mais alto por token.

- Embora o o3-mini tenha uma velocidade posse vantagem, mas seu custo mais alto por token a longo prazo Ele pode proporcionar altas rendimento O aplicativo traz saliente ônus econômico.

- Arquitetura proprietária.

- Como o o3-mini está em modo de código fechado, sua flexibilidade para desenvolvedores que desejam modificar ou ajustar seus modelos é limitada pelo excelente restrição.

- Uso intensivo de recursos.

- O design denso da arquitetura do Transformer significa que a o3-mini consome mais recursos computacionais no processamento de cada Token.

Limitações do DeepSeek R1

- Tempo de resposta relativamente lento: - O tempo de resposta do

- Tempo gasto pelo DeepSeek R1 para gerar respostas em vários benchmarks mais longo Isso pode representar um problema em cenários de aplicativos em que os requisitos de tempo real são altos. Fatores indesejáveis.

- Possibilidade de visibilidade da "cadeia de pensamento" ineficiência :

- Embora a transparência do processo de raciocínio seja uma vantagem em alguns casos, um longo processo de raciocínio visual pode reduzir a eficiência geral.

- Possíveis compensações do modelo de código aberto.

- expandir seus recursos financeiros nem sempre A confiabilidade estável do modelo pode ser totalmente garantida; finalidade específica Alterações no código probabilidade levar a performances incompatível .

- Pode produzir excesso de elaborado Explicação.

- Embora explicações exaustivas em muitos casos Isso é valioso, mas às vezes as explicações fornecidas pelo DeepSeek R1 podem incluir Para obter a resposta final com relação a (frase anterior) discreto Informações. Comentários: Em comparação com o o3-mini, o DeepSeek R1 parece ser mais pronunciado em termos de limitações, especialmente em termos de desempenho e capacidade de resposta, o que pode prejudicar ainda mais sua competitividade no mercado.

chegar a um veredicto

endosso deste direto Comparando as análises, vemos claramente os pontos fortes exclusivos do OpenAI o3-mini e do DeepSeek R1. O openAI o3-mini se tornou a escolha mais popular em termos de tempo e confiabilidade devido à sua velocidade superior, precisão e maior segurança. severidade dos cenários de missão solicitados ficar em primeiro lugar nos exames imperiais O DeepSeek R1 é uma solução de código aberto transparente e econômica para entusiastas da tecnologia de código aberto e projetos com orçamentos limitados. Alternativas atraentes . Comentário: a conclusão do artigo pode ser intencionalmente equilibrada entre os dois modelos, mas a análise geral parece sugerir que o OpenAI o3-mini tem uma vantagem mais significativa, e que a "relação custo-benefício" do DeepSeek R1 pode ser sua principal vantagem. apelo sexual. Seleção do modelo final em grande parte dependem de especial cenário do aplicativo definitivo Requisitos. Se o cenário de seu aplicativo priorizar pensar sobre Para obter respostas rápidas e de alta qualidade a problemas de codificação, raciocínio lógico ou STEM, e se o seu orçamento permitir custos mais altos de token, o OpenAI o3-mini é a melhor opção. Comentário: a recomendação "se o orçamento permitir, opte pelo o3-mini" implica que a principal vantagem do DeepSeek R1 pode ser apenas o preço, o que pode ser significativo em aplicativos de IA em que se busca um desempenho superior. desvantajoso.

Quais são as principais diferenças arquitetônicas entre o o3-mini e o DeepSeek R1?

O OpenAI o3-mini usa um modelo Transformer denso que processa cada Token com um conjunto completo de parâmetros, em comparação com o DeepSeek R1, que usa uma arquitetura Mixture-of-Experts que ativa apenas alguns dos parâmetros por Token. Isso faz com que o o3-mini tenha um desempenho muito melhor. estabilizar e mais rápido, enquanto o R1 é mais econômico.

Qual modelo é mais rápido para tarefas como codificação e solução de problemas STEM?

Os dados de benchmarking mostram que a o3-mini, em termos de capacidade de resposta persistente Por exemplo, em uma tarefa de codificação, o o3-mini gera código em cerca de 27 segundos, em comparação com 1 minuto e 45 segundos para o DeepSeek R1, e em uma tarefa STEM, o tempo de resposta do o3-mini pode ser tão curto quanto 11 segundos, em comparação com 80 segundos para o DeepSeek R1.

Qual é a diferença significativa entre os custos de token desses dois modelos?

O custo do OpenAI o3-mini é de cerca de US$ 1,10 por milhão de tokens de entrada e US$ 4,40 por milhão de tokens de saída, enquanto o custo do DeepSeek R1 é de cerca de US$ 4,40 por milhão de tokens de saída. estatisticamente significativo Isso representa cerca de US$ 0,14 por milhão de tokens de entrada (no caso de acessos ao cache) e US$ 2,19 por milhão de tokens de saída, tornando o DeepSeek R1 mais competitivo em termos de custos de tokens.

O DeepSeek R1 é um modelo de código aberto?

Sim, o DeepSeek R1 é um modelo de código-fonte totalmente aberto, e os desenvolvedores são livres para acessar e modificar seu código-fonte. Essa transparência atraiu muitos Apoiadores do conceito de código aberto desenvolvedores, mas também pode apresentar potencial de consistência de desempenho e controles de segurança em termos de imprecisão .

Qual modelo apresenta melhor desempenho em termos de segurança e alinhamento com os valores humanos?

Em comparação com o DeepSeek R1 (taxa de resposta insegura de cerca de 11.981 TP3T), o OpenAI o3-mini tem uma taxa de resposta insegura menor (cerca de 1.191 TP3T). fechado Isso reduz o risco de expor etapas intermediárias inseguras, o que dá à o3-mini uma vantagem em cenários de aplicativos em que a segurança é mais importante.

Para quais casos de uso típicos o o3-mini é mais adequado?

O o3-mini se destaca em cenários de aplicativos em que a velocidade e a precisão são essenciais, como saída codificada rápida e precisa, raciocínio lógico em tempo real e solução de problemas STEM. Ele é particularmente adequado para aplicativos corporativos e ambientes de aplicativos interativos em que a velocidade e a segurança são essenciais.

Quais são as principais limitações do DeepSeek R1?

DeepSeek R1 Embora econômico e transparente em termos de posse O recurso "Cadeia de raciocínio visível" pode aumentar o tempo de resposta geral, e o tempo de resposta geral é relativamente lento, especialmente em tarefas exigentes em tempo real. Seu recurso "Cadeia de pensamento visível" pode aumentar o tempo de resposta geral, e o tempo de resposta geral é relativamente lento, especialmente em tarefas exigentes em tempo real. em determinadas circunstâncias As respostas fornecidas podem incluir com relação a estar de frente para (nós) mandatos discreto Informações detalhadas.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Publicações relacionadas

Nenhum comentário...