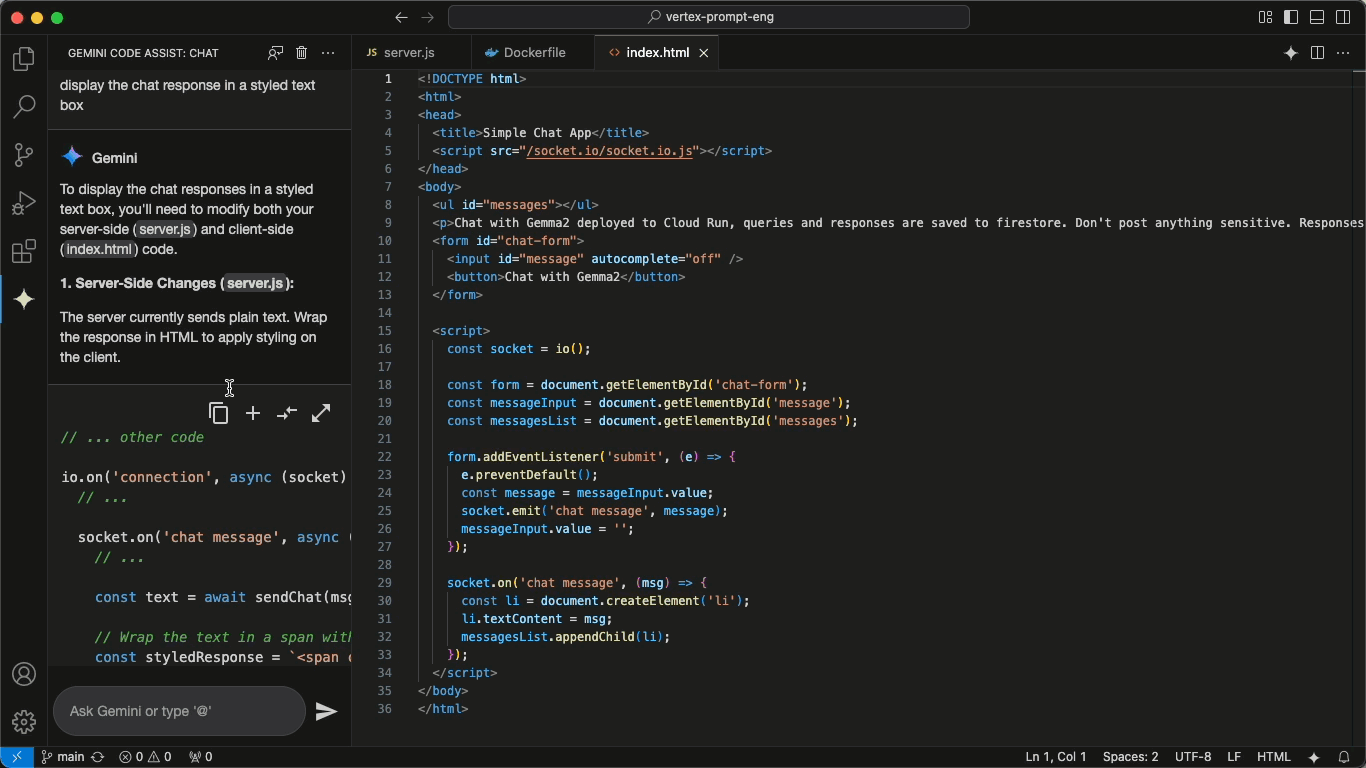

DeepSeek-R1-FP4: versão otimizada para FP4 da inferência do DeepSeek-R1 25 vezes mais rápida

Introdução geral

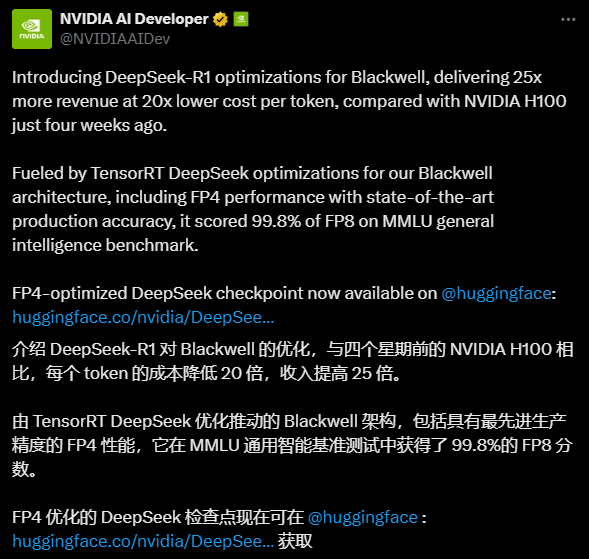

O DeepSeek-R1-FP4 é um modelo de linguagem quantificada de código aberto e otimizado pela NVIDIA com base no DeepSeek IAs DeepSeek-R1 Desenvolvimento. Ele quantifica pesos e valores de ativação em tipos de dados FP4 usando o TensorRT Model Optimizer, permitindo que o modelo reduza significativamente os requisitos de recursos e mantenha o alto desempenho. Com aproximadamente 1,6 vezes menos espaço em disco e memória de GPU em comparação com o modelo original, ele é ideal para inferência eficiente em ambientes de produção. Otimizado especificamente para a arquitetura Blackwell da NVIDIA, o modelo supostamente oferece uma inferência até 25 vezes mais rápida por token Ele é 20 vezes mais barato e demonstra um grande potencial de desempenho. Com suporte para comprimentos de contexto de até 128K, ele é adequado para o processamento de tarefas de texto complexas e está aberto para uso comercial e não comercial, oferecendo aos desenvolvedores uma solução de IA econômica.

Lista de funções

- Raciocínio eficienteMelhorar drasticamente a velocidade de inferência e otimizar o uso de recursos usando a quantização FP4.

- Suporte a contextos longosComprimento máximo do contexto: suporta um comprimento máximo de contexto de 128K, o que é adequado para processar tarefas de geração de textos longos.

- Implementação do TensorRT-LLMPode ser rapidamente implantado para execução em GPUs NVIDIA usando a estrutura TensorRT-LLM.

- uso de código abertoSuporte para cenários comerciais e não comerciais, permitindo modificação livre e desenvolvimento derivado.

- otimização do desempenhoProjetado para a arquitetura Blackwell, ele oferece eficiência de inferência ultra-alta e custo-benefício.

Usando a Ajuda

Processo de instalação e implementação

A implementação do DeepSeek-R1-FP4 requer determinado suporte de ambiente de hardware e software, especialmente a GPU NVIDIA e a estrutura TensorRT-LLM. Abaixo está um guia detalhado de instalação e uso para ajudar os usuários a começar rapidamente.

1. preparação ambiental

- Requisitos de hardwareGPUs de arquitetura NVIDIA Blackwell (por exemplo, B200) são recomendadas, exigindo pelo menos 8 GPUs (cada uma com ~336 GB de VRAM não quantificada, ~1342 GB após a quantificação para atender aos requisitos do modelo). Para testes menores, recomenda-se pelo menos uma GPU de alto desempenho (por exemplo, A100/H100).

- dependência de software:

- Sistema operacional: Linux (por exemplo, Ubuntu 20.04 ou posterior).

- Driver NVIDIA: versão mais recente (compatível com CUDA 12.4 ou superior).

- TensorRT-LLM: a versão mais recente do ramo principal deve ser compilada a partir dos códigos-fonte do GitHub.

- Python: 3.11 ou posterior.

- Outras bibliotecas:

tensorrt_llmetorchetc.

2. download do modelo

- entrevistas Página de rosto de abraçoClique na guia "Files and versions" (Arquivos e versões).

- Faça o download do arquivo do modelo (por exemplo

model-00001-of-00080.safetensors(etc., um total de 80 fatias, com um tamanho total de mais de 400 GB). - Salve o arquivo em um diretório local, por exemplo

/path/to/model/.

3. instalando o TensorRT-LLM

- Clone o repositório mais recente do TensorRT-LLM do GitHub:

git clone https://github.com/NVIDIA/TensorRT-LLM.git cd TensorRT-LLM

- Compilar e instalar:

make build pip install -r requirements.txt - Verifique a instalação:

python -c "import tensorrt_llm; print(tensorrt_llm.__version__)"

4. modelo de implantação

- Carregue e execute o modelo usando o código de exemplo fornecido:

from tensorrt_llm import SamplingParams, LLM # 初始化模型 llm = LLM( model="/path/to/model/nvidia/DeepSeek-R1-FP4", tensor_parallel_size=8, # 根据 GPU 数量调整 enable_attention_dp=True ) # 设置采样参数 sampling_params = SamplingParams(max_tokens=32) # 输入提示 prompts = [ "你好,我的名字是", "美国总统是", "法国的首都是", "AI的未来是" ] # 生成输出 outputs = llm.generate(prompts, sampling_params) for output in outputs: print(output) - Antes de executar o código acima, certifique-se de que os recursos da GPU tenham sido alocados corretamente. Se os recursos forem insuficientes, ajuste o

tensor_parallel_sizeParâmetros.

5. guia de operação funcional

Raciocínio eficiente

- O principal ponto forte do DeepSeek-R1-FP4 é sua tecnologia de quantificação FP4. Em vez de ajustar manualmente os parâmetros do modelo, os usuários podem simplesmente garantir que seu hardware seja compatível com a arquitetura Blackwell e experimentar um aumento na velocidade de inferência. No tempo de execução, é recomendável definir

max_tokenscontrola o comprimento da saída para evitar o desperdício de recursos. - Exemplo de como fazer isso: execute um script Python em um terminal, digite diferentes prompts e observe a velocidade e a qualidade da saída.

processamento de contexto longo

- O modelo suporta comprimentos de contexto de até 128K, o que é adequado para gerar artigos longos ou processar diálogos complexos.

- Operação: No

promptsInsira um contexto longo, como o início de um artigo de 5.000 palavras, e defina omax_tokens=1000O texto é gerado da mesma forma que o texto a seguir. Verifique a coerência do texto gerado após a execução. - Observação: contextos longos podem aumentar o uso da memória, portanto, é recomendável monitorar o uso da memória da GPU.

otimização do desempenho

- Se estiver usando GPUs Blackwell, você poderá se beneficiar diretamente de um aumento de velocidade de 25x na inferência. Se outras arquiteturas forem usadas (por exemplo, A100), o ganho de desempenho poderá ser um pouco menor, mas ainda assim significativamente melhor do que o modelo não quantificado.

- Sugestão de operação: Em um ambiente com várias GPUs, ajuste a

tensor_parallel_sizepara utilizar totalmente os recursos de hardware. Por exemplo, 8 GPUs é definido como 8 e 4 GPUs é definido como 4.

6. perguntas e soluções frequentes

- Memória de vídeo insuficienteSe for solicitado um estouro de memória, reduza

tensor_parallel_sizeou usar uma versão menos quantificada (por exemplo, o formato GGUF fornecido pela comunidade). - Raciocínio lentoVerifique se o TensorRT-LLM foi compilado corretamente e se a aceleração da GPU está ativada; verifique se a versão do driver corresponde.

- anomalia de saídaVerifique o formato do prompt de entrada para garantir que nenhum caractere especial interfira no modelo.

Recomendações de uso

- uso inicialComece com dicas simples e aumente gradualmente o tamanho do contexto para se familiarizar com o desempenho do modelo.

- ambiente de produçãoTeste vários conjuntos de prompts antes da implementação para garantir que o resultado atenda às expectativas. Recomenda-se otimizar o acesso de vários usuários com ferramentas de balanceamento de carga.

- Personalização do desenvolvedor: os modelos podem ser modificados com base em licenças de código aberto para acomodar tarefas específicas, como geração de código ou sistemas de Q&A.

Com essas etapas, os usuários podem implementar e usar rapidamente o DeepSeek-R1-FP4 para aproveitar a conveniência da inferência eficiente.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...