DeepSeek Debate: Liderança da China em custo, custos reais de treinamento e impacto nos lucros dos modelos de código fechado

Palavras-chave: picos de preço do h100, preço inferido subsidiado, controles de exportação, MLAs

Narrativa da DeepSeek impressiona o mundo

DeepSeek Tomando o mundo de assalto. Na última semana, o DeepSeek tem sido o único tópico sobre o qual todos no mundo querem falar. Atualmente, o DeepSeek tem muito mais tráfego diário do que o Claude, o Perplexity ou mesmo o Gemini.

Mas para aqueles que acompanham o campo de perto, essa não é exatamente uma notícia "nova". Estamos falando sobre a DeepSeek há meses (cada link é um exemplo). A empresa não é nova, mas o hype é, e a SemiAnalysis há muito tempo argumenta que a DeepSeek é muito talentosa e que o público americano em geral não se importa. Quando o mundo finalmente prestou atenção, o fez em um hype frenético que não refletia a realidade.

Gostaríamos de enfatizar que essa declaração mudou em relação ao mês passado, quando as Leis de Escalonamento foram quebradas e dissipamos o equívoco de que os algoritmos agora estão melhorando muito rapidamente, o que, de certa forma, também é ruim para a Nvidia e as GPUs.

Histórico: 11 de dezembro de 2024 Leis de dimensionamento - arquitetura do O1 Pro, infraestrutura de treinamento de inferência, Orion e Claude 3.5 Opus "falhas"

A narrativa agora é que o DeepSeek é tão eficiente que não precisamos de mais cálculos e que agora há um enorme excesso de capacidade em tudo devido às mudanças de modelo. Embora o Paradoxo de Jevons também seja exagerado, Jevons está mais próximo da realidade, e esses modelos induziram uma demanda que teve um impacto tangível no preço do H100 e do H200.

DeepSeek e High-Flyer

O High-Flyer é um fundo de hedge chinês e um dos primeiros a adotar o uso de IA em seus algoritmos de negociação. Eles perceberam logo no início o potencial da IA fora do setor financeiro e os principais insights de dimensionamento. Como resultado, eles têm aumentado seu fornecimento de GPU. Depois de fazer experimentos com modelos usando clusters de milhares de GPUs, a High Flyer investiu em 10.000 GPUs A100 em 2021 * antes de qualquer restrição de exportação. * Isso valeu a pena. À medida que a High-Flyer se aprimorava, eles perceberam que era hora de separar a "DeepSeek" em maio de 2023, com o objetivo de buscar mais recursos de IA de forma mais focada. A High-Flyer autofinanciou a empresa, pois havia pouco interesse em IA na época por parte de investidores externos, sendo a falta de um modelo de negócios a principal preocupação. Atualmente, a High-Flyer e a DeepSeek compartilham frequentemente recursos, tanto humanos quanto computacionais.

A DeepSeek agora evoluiu para um empreendimento sério e colaborativo que está longe de ser a "atividade paralela" que muitos na mídia afirmam ser. Acreditamos que seu investimento em GPU seja superior a US$ 500 milhões, mesmo levando em conta os controles de exportação.

Fonte: SemiAnalysis, Lennart Heim.

Situação da GPU

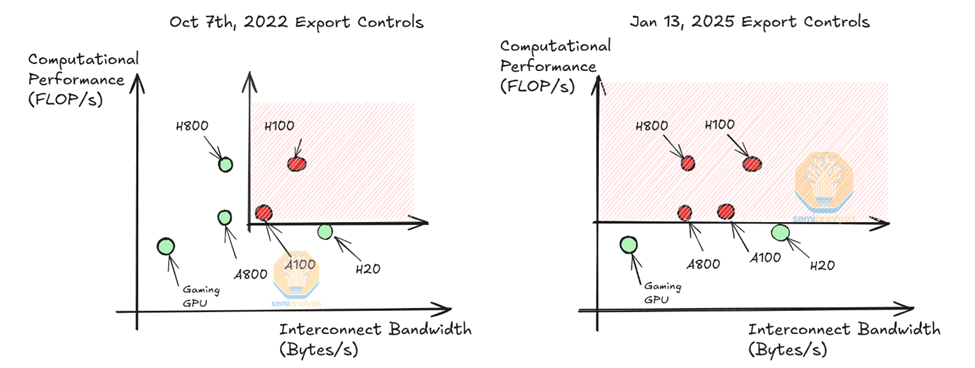

Acreditamos que eles poderiam usar cerca de 50.000. GPU de funilA Nvidia fabrica diferentes modelos de H100 para atender a diferentes regulamentações (H800, H20) e, atualmente, apenas o H20 está disponível para os provedores de modelos na China. Observe que o H800 tem a mesma capacidade de computação que o H100, mas com menor largura de banda de rede.

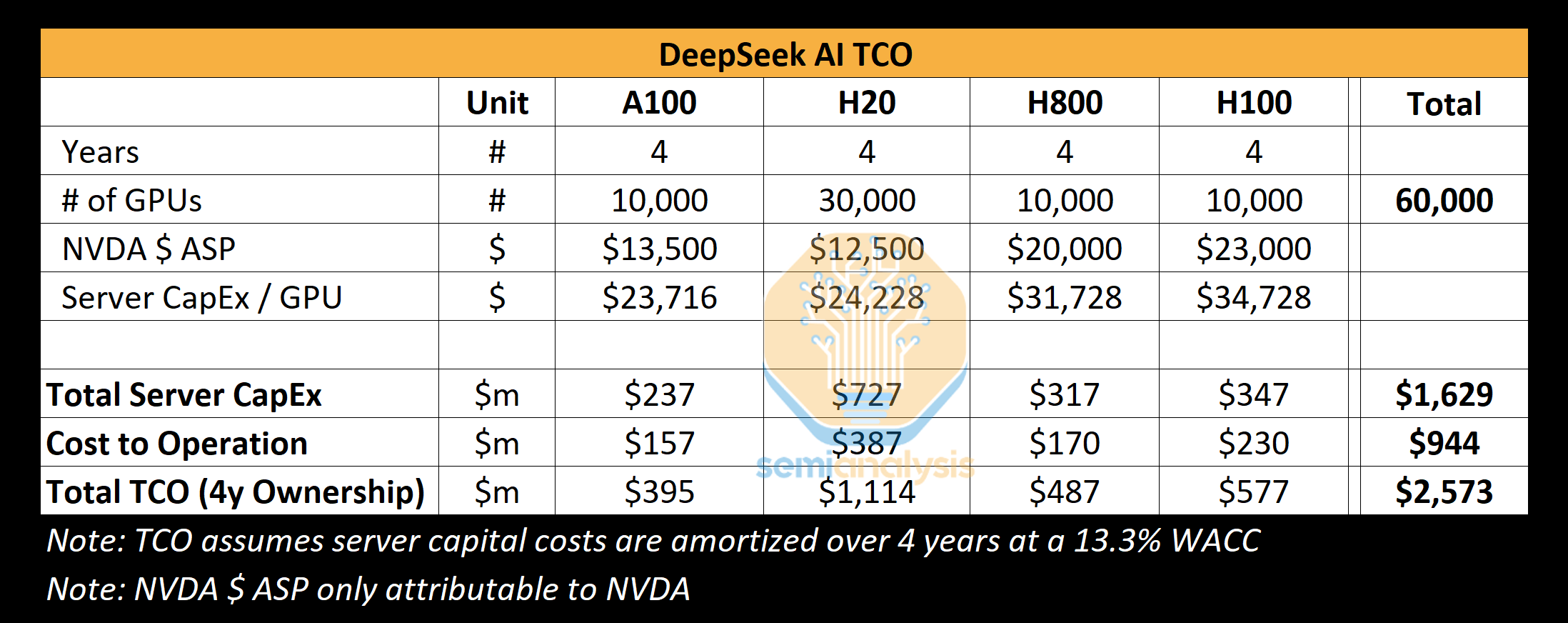

Acreditamos que o DeepSeek poderia usar cerca de 10.000 H800s e 10.000 H100s. Além disso, eles encomendaram mais H20s, e a Nvidia produziu mais de 1 milhão de GPUs específicas para a China nos últimos 9 meses. Essas GPUs são compartilhadas entre o High-Flyer e o DeepSeek, e são de certa forma distribuídas geograficamente. Elas são usadas para negociação, inferência e treinamento. Elas são usadas para negociação, inferência, treinamento e pesquisa. Para uma análise mais específica e detalhada, consulte nosso modelo de acelerador.

Fonte: SemiAnalysis

Nossa análise mostra que o capex total de servidores da DeepSeek é de aproximadamente US$ 1,6 bilhão, com custos associados à operação desses clusters que chegam a US$ 944 milhões. Da mesma forma, todos os laboratórios de IA e hiperescaladores têm mais GPUs para uma variedade de tarefas, incluindo pesquisa e treinamento, do que para uma única execução de treinamento, pois o agrupamento de recursos é um desafio. x.AI é um laboratório de IA exclusivo com todas as suas GPUs em um único local.

A DeepSeek é especializada em buscar talentos na China, independentemente de qualificações anteriores, com um forte foco em competência e curiosidade, e realiza regularmente eventos de recrutamento nas principais universidades, como Peking e Zhejiang, onde muitos de seus funcionários se formaram. Os cargos não são necessariamente pré-definidos e os recrutadores têm flexibilidade, com anúncios de emprego que oferecem acesso a mais de 10.000 GPUs sem limite de uso. A empresa é extremamente competitiva e, segundo informações, oferece salários superiores a US$ 1,3 milhão a candidatos promissores, muito mais altos do que os de grandes empresas chinesas de tecnologia e laboratórios de IA como o Moonshot.

A história mostra que uma startup pequena, bem financiada e focada pode, muitas vezes, ultrapassar os limites do que é possível. A DeepSeek não tem a burocracia de uma empresa como o Google e, por ser autofinanciada, pode levar as ideias adiante rapidamente. Entretanto, assim como o Google, a DeepSeek (em sua maior parte) administra seu próprio data center e não depende de terceiros ou provedores externos. Isso abre mais espaço para experimentação e permite que eles inovem em toda a pilha.

Acreditamos que eles são o melhor laboratório de "pesos abertos" da atualidade, superando o Meta's Llama, o Mistral e outros.

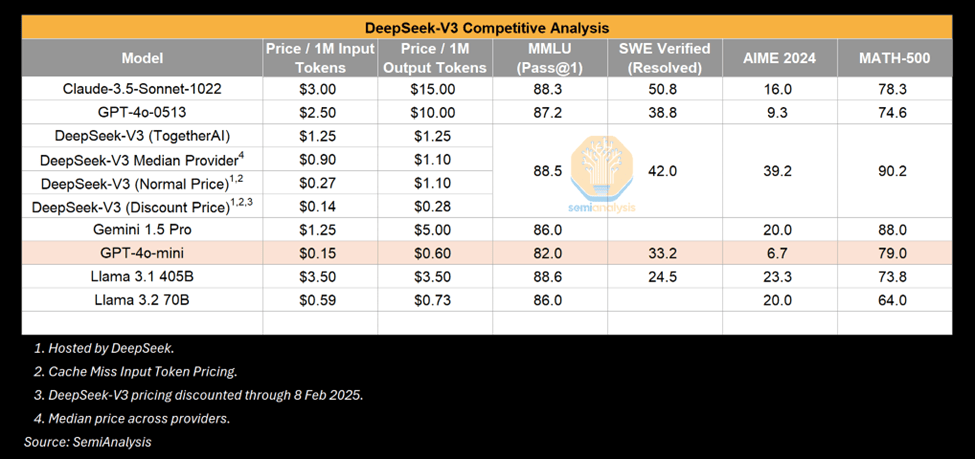

Custo e desempenho do DeepSeek

Os preços e a eficiência do DeepSeek provocaram um frenesi nesta semana, com a principal manchete sendo o custo de treinamento de "US$ 6 milhões" do DeepSeek V3. Isso está errado. Isso é semelhante a apontar para uma parte específica da lista de materiais de um produto e atribuí-la ao custo total. Os custos de pré-treinamento são uma parte muito pequena do custo total.

Custos de treinamento

Acreditamos que os números do pré-treinamento estão longe do gasto real com o modelo. Acreditamos que eles gastaram muito mais do que US$ 500 milhões em hardware ao longo da história da empresa. Para desenvolver inovações arquitetônicas, há um gasto considerável com testes de novas ideias, novas ideias arquitetônicas e ablação durante o desenvolvimento do modelo. A Multi-Head Latent Attention, uma inovação fundamental do DeepSeek, levou meses para ser desenvolvida e custou a toda a equipe mão de obra e tempo de GPU.

O custo de US$ 6 milhões no artigo é atribuível apenas ao custo de GPU das execuções de pré-treinamento, que é apenas uma fração do custo total do modelo. Para referência, o Claude 3.5 Sonnet custou dezenas de milhões de dólares para ser treinado e, se isso fosse tudo o que a Anthropic precisava, eles não estariam arrecadando bilhões de dólares do Google e dezenas de bilhões da Amazon. Isso ocorre porque eles precisam fazer experimentos, criar novas arquiteturas, coletar e limpar dados, pagar seus funcionários, etc.

Então, como o DeepSeek tem um cluster tão grande? O atraso nos controles de exportação é fundamental e será discutido na seção de exportação abaixo.

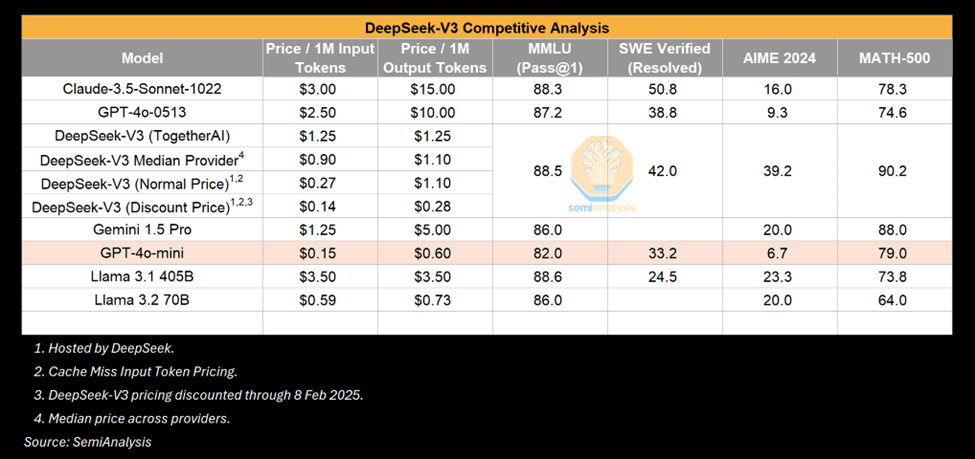

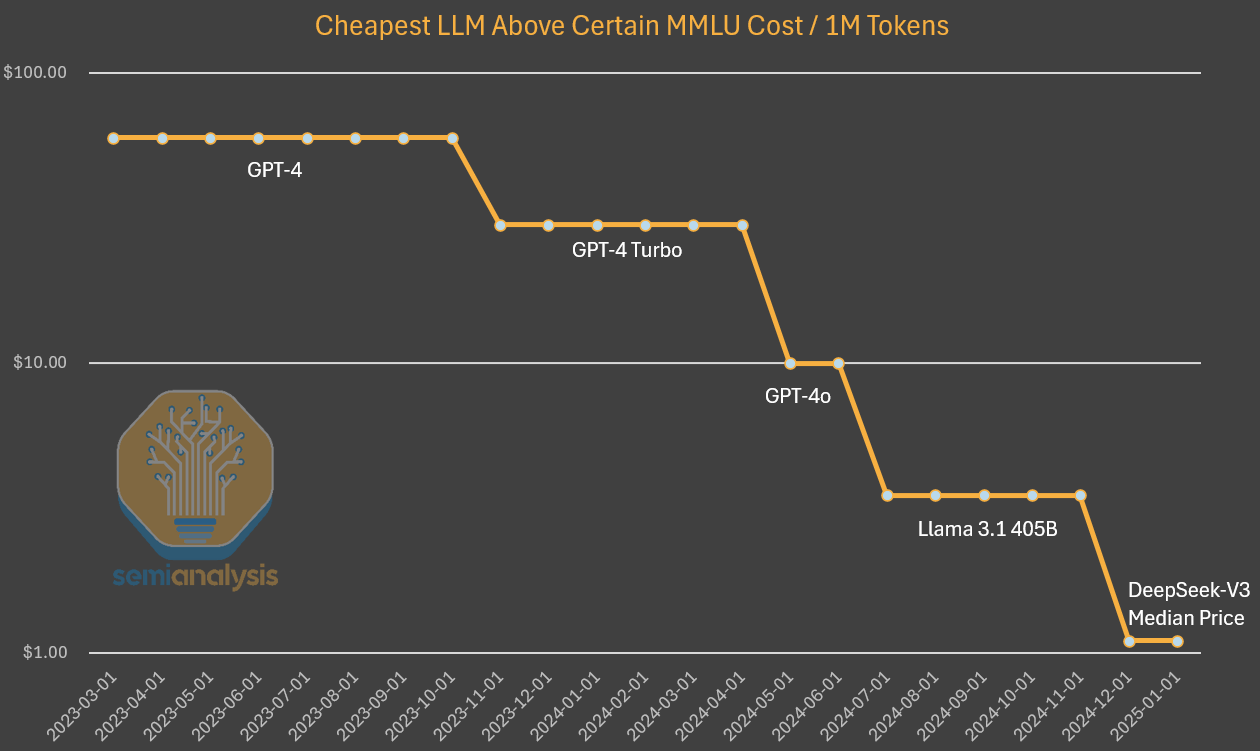

Fechando a lacuna - Desempenho da V3

O V3 é, sem dúvida, um modelo impressionante, mas vale a pena enfatizar que Em oposição ao que é impressionante.. Muitos compararam o V3 com o GPT-4o e enfatizaram como o V3 supera o desempenho do 4o. Isso é verdade, mas o GPT-4o está na faixa de Maio de 2024A IA lançada está evoluindo rapidamente e maio de 2024 será outra era em termos de aprimoramentos algorítmicos. Além disso, não nos surpreende ver uma potência comparável ou maior obtida com menos cálculos após um determinado período de tempo. O colapso dos custos de inferência é um sinal de aprimoramento da IA.

Fonte: SemiAnalysis

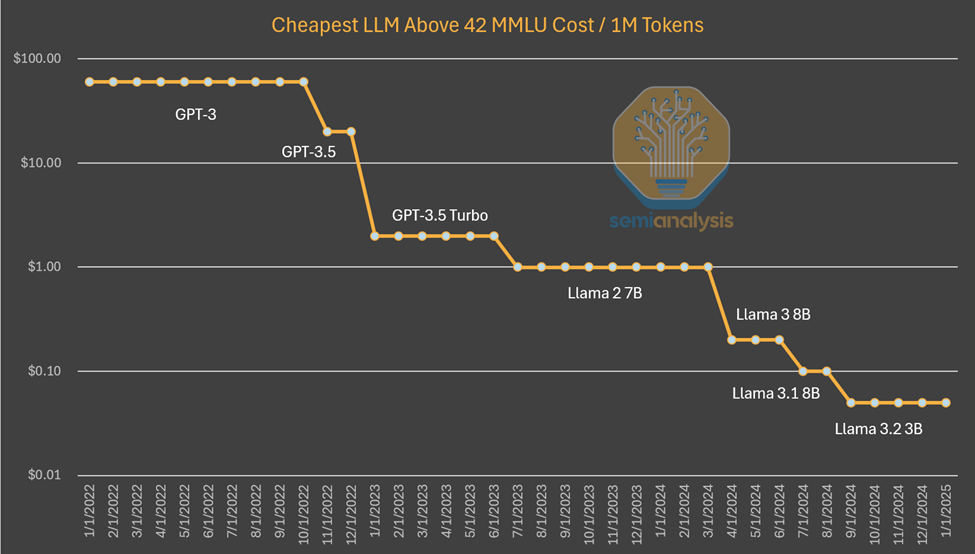

Um exemplo é que modelos pequenos que podem ser executados em laptops têm desempenho comparável ao do GPT-3, que requer um supercomputador para treinamento e várias GPUs para inferência. Em outras palavras, as melhorias algorítmicas permitem menos cálculos para treinar e raciocinar sobre modelos com os mesmos recursos, e o padrão funciona repetidamente. Desta vez, o mundo notou o fato porque ele veio do sino de um laboratório. Mas o fato de os modelos menores ficarem melhores não é novidade.

Fontes: SemiAnalysis, Artificialanalysis.ai, Anakin.ai, a16z

Esse padrão que testemunhamos até agora é que os laboratórios de IA estão gastando mais dólares absolutos para obter mais A inteligência da Anthropic. Estima-se que o progresso algorítmico seja de 4x ao ano, o que significa que a cada ano que passa são necessárias apenas 4x menos computações para atingir a mesma capacidade. Dario, CEO da Anthropic, acredita que o progresso algorítmico é ainda mais rápido, produzindo uma melhoria de 10x. No caso do preço de inferência de qualidade GPT-3, o custo caiu em um fator de 1200.

Ao investigar os custos do GPT-4, observamos uma redução semelhante nos custos, embora mais cedo na curva. Embora a diminuição da diferença de custo ao longo do tempo possa ser explicada pelo fato de não mantermos mais a capacidade constante, como no gráfico acima. Nesse caso, vemos que as melhorias e otimizações algorítmicas levaram a uma redução de 10 vezes no custo e a um aumento de 10 vezes na capacidade.

Fontes: SemiAnalysis, OpenAI, Juntos.ai

Para ser claro, a DeepSeek é única no fato de ter alcançado esse nível de custo e capacidade em primeiro lugar. Eles são únicos na liberação de pesos abertos, mas o anterior Mistral O DeepSeek alcançou esse nível de custo, mas não se surpreenda se o custo cair mais cinco vezes até o final do ano.

O desempenho do R1 é comparável ao do o1?

Por outro lado, o R1 conseguiu obter resultados comparáveis aos do o1, que só foi anunciado em setembro. Como o DeepSeek conseguiu se recuperar tão rapidamente?

A resposta é que a inferência é um novo paradigma com taxas de iteração mais rápidas e metas mais viáveis, em que uma pequena quantidade de computação pode gerar ganhos significativos em comparação com os paradigmas anteriores. Conforme descrito em nosso relatório Scaling Laws, os paradigmas anteriores dependiam do pré-treinamento, que está se tornando cada vez mais caro e difícil de obter ganhos robustos.

O novo paradigma se concentra em habilitar os recursos de inferência por meio da geração de dados sintéticos e da aprendizagem por reforço no pós-treinamento de modelos existentes, resultando em ganhos mais rápidos a um preço mais baixo. A barreira mais baixa para a entrada, juntamente com otimizações simples, significa que o DeepSeek é capaz de replicar a abordagem o1 mais rapidamente do que o normal. À medida que os participantes descobrem como escalar mais nesse novo paradigma, esperamos que a lacuna de tempo nos recursos de correspondência aumente.

Observe que o documento R1 Não mencionado cálculos utilizados. Isso não é por acaso - é preciso muito cálculo para gerar os dados sintéticos usados no pós-treinamento do R1. Isso não inclui o aprendizado por reforço. r1 é um modelo muito bom, não contestamos isso, e alcançar a vantagem da inferência tão rapidamente é objetivamente impressionante. o fato de o DeepSeek ser chinês e ter alcançado o mesmo nível com menos recursos torna isso ainda mais impressionante.

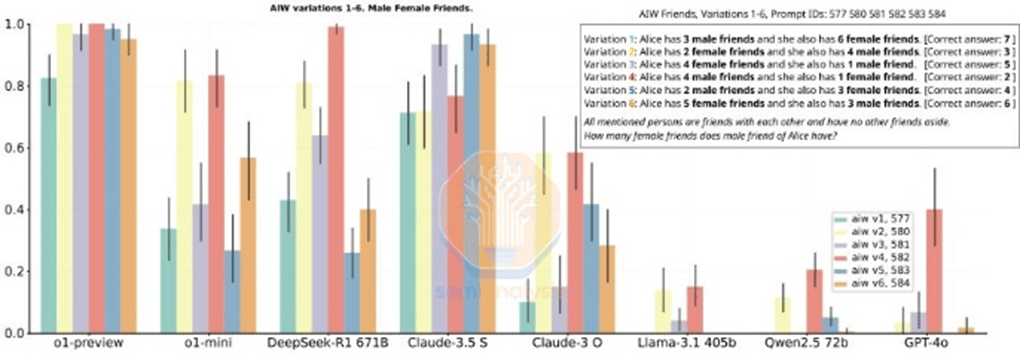

Mas alguns dos benchmarks que R1 menciona também enganosa. Comparar o R1 com o o1 é complicado porque o R1 não menciona especificamente os benchmarks em que não é líder. Embora o R1 seja igual em desempenho de inferência, ele não é um vencedor claro em todas as métricas e, em muitos casos, é pior que o o1.

Fonte: (Mais) uma história de ascensão e queda. DeepSeek R1

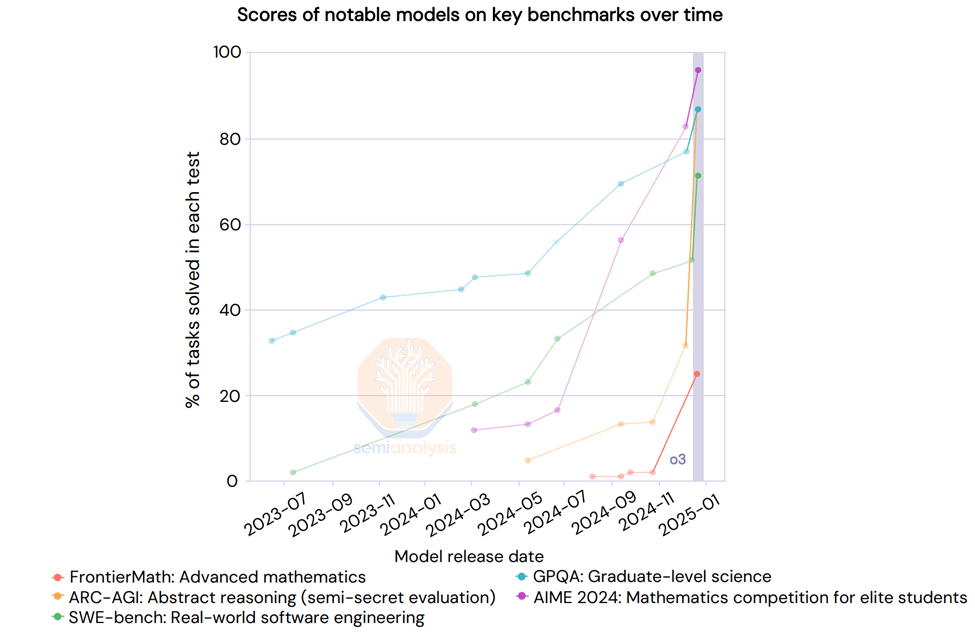

Ainda não mencionamos o o3. O o3 é significativamente mais capaz do que o R1 ou o o1. Na verdade, a OpenAI compartilhou recentemente os resultados do o3 em que a escala de referência era vertical. "A aprendizagem profunda atingiu o limite", mas de uma maneira diferente.

Fonte: AI Action Summit

O modelo de inferência do Google é tão bom quanto o R1

Embora tenha havido uma onda de entusiasmo frenético em torno do R1, uma empresa norte-americana de US$ 2,5 trilhões lançou um modelo de inferência mais barato há um mês: o Google's Gêmeos Pensando no Flash 2.0, o modelo está disponível e pode ser acessado por meio da API Muito mais barato do que o R1.mesmo que o comprimento do contexto do modelo seja maior.

O Flash 2.0 Thinking supera o R1 nos benchmarks relatados, embora os benchmarks não contem toda a história. O Google divulgou apenas 3 benchmarks, portanto, o quadro é incompleto. No entanto, acreditamos que o modelo do Google é robusto e pode competir com o R1 em muitos aspectos, mas não está sujeito a nenhum exagero. Isso pode ser devido à falta de estratégia de entrada no mercado do Google e à má experiência do usuário, mas o R1 também foi uma surpresa na China.

Fonte: SemiAnalysis

Para ser claro, nada disso diminui a excelência do DeepSeek, cuja estrutura como uma startup de crescimento rápido, bem financiada, inteligente e focada é tal que supera as probabilidades em termos de publicação de modelos de inferência Meta e outros gigantes por um motivo que é louvável.

Realizações técnicas

O DeepSeek decifrou o código e desbloqueou inovações ainda não realizadas pelos principais laboratórios. Esperamos que todas as melhorias lançadas pelo DeepSeek sejam replicadas pelos laboratórios ocidentais quase que imediatamente.

Quais são esses aprimoramentos? A maioria das conquistas arquitetônicas está especificamente relacionada à V3, que também é o modelo básico do R1. Vamos descrever essas inovações em mais detalhes.

Treinamento (pré e pós-treinamento)

O DeepSeek V3 aproveita a escala sem precedentes de vários Token (MTP), são módulos de atenção adicionais que preveem os próximos tokens em vez de um único token, o que melhora o desempenho do modelo durante o treinamento e pode ser descartado durante a inferência. Esse é um exemplo de inovação algorítmica que alcança melhor desempenho com menor esforço computacional.

Há outras ressalvas, como a precisão do FP8 no treinamento, mas os principais laboratórios dos EUA vêm realizando o treinamento do FP8 há algum tempo.

O DeepSeek v3 também é um modelo de especialista híbrido, que é um modelo grande que consiste em muitos outros especialistas menores que se especializam em coisas diferentes, um tipo de comportamento emergente. Um dos desafios enfrentados pelo modelo MoE é como determinar qual Token vai para qual submodelo ou "especialista". O DeepSeek implementa uma "rede fechada" que encaminha o Token para o especialista correto de forma equilibrada, sem afetar o desempenho do modelo. Isso significa que o roteamento é muito eficiente e cada token altera apenas alguns parâmetros durante o treinamento em relação ao tamanho geral do modelo. Isso aumenta a eficiência do treinamento e reduz os custos de inferência.

Apesar das preocupações de que os ganhos de eficiência dos especialistas híbridos (MoE) possam reduzir o investimento, Dario ressalta que a economia de modelos de IA mais poderosos é tão grande que qualquer economia é rapidamente reinvestida na criação de modelos maiores. Essas empresas se concentram em dimensionar modelos para mais cálculos e torná-los mais eficientes por meio de algoritmos.

No caso do R1, ele se beneficiou do fato de ter um modelo de base forte (v3), em parte devido ao aprendizado por reforço (RL). Isso se deve em parte ao aprendizado por reforço (RL), que tem dois focos principais: formatação (para garantir que ele forneça um resultado coerente) e utilidade e inocuidade (para garantir que o modelo seja útil). O poder de raciocínio surge em um conjunto de dados sintéticos durante o ajuste fino do modelo. Isso.Conforme descrito em nosso artigo Leis de escalonamentoFoi o que aconteceu com o1. Observe que não há menção à computação no artigo do R1, porque mencionar a quantidade de computação usada indicaria que eles tinham mais GPUs do que a narrativa sugere. A RL nessa escala requer muita computação, especialmente para gerar dados sintéticos.

Além disso, alguns dos dados usados pelo DeepSeek parecem vir dos modelos da OpenAI, o que acreditamos que terá um impacto na estratégia de extração do resultado. Isso já é ilegal nos Termos de Serviço, mas, olhando para o futuro, uma nova tendência pode ser uma forma de KYC (Know Your Customer) para bloquear extrações.

Por falar em extração, talvez a parte mais interessante do documento do R1 seja a capacidade de ajustar os minimodelos de não inferência usando os resultados dos modelos de inferência para transformá-los em modelos de inferência. O gerenciamento do conjunto de dados contém um total de 800.000 amostras, e agora qualquer pessoa pode criar seus próprios conjuntos de dados usando as saídas CoT do R1 e criar modelos de inferência com a ajuda dessas saídas. É provável que vejamos mais modelos pequenos demonstrando recursos de inferência, melhorando assim o desempenho de modelos pequenos.

Atenção em vários níveis (MLA)

O MLA é uma inovação fundamental que levou a uma redução significativa no preço de inferência do DeepSeek. O motivo é que, em comparação com a atenção padrão, o MLA reduz a quantidade de cache KV necessária por consulta em cerca de 93.3%O cache KV é Transformador Um mecanismo de memória no modelo para armazenar dados que representam o contexto de um diálogo, reduzindo assim a computação desnecessária.

Conforme discutido em nosso artigo sobre leis de dimensionamento, o cache KV cresce à medida que o contexto do diálogo aumenta e cria um limite de memória considerável. Reduzir significativamente a quantidade de cache KV necessária por consulta reduziria a quantidade de hardware necessária por consulta, reduzindo assim os custos. No entanto, acreditamos que o DeepSeek está oferecendo inferência a preço de custo para ganhar participação no mercado sem realmente ganhar dinheiro. o Google Gemini Flash 2 Thinking ainda é mais barato e é improvável que o Google o ofereça a preço de custo. o MLA, em particular, atraiu a atenção de muitos dos principais laboratórios dos EUA. o MLA está no mercado desde maio de 2024 O MLA é lançado no DeepSeek V2, que deve ser lançado em maio de 2024. O DeepSeek também desfruta de maior eficiência de carga de trabalho de inferência com o H20 em comparação com o H100 devido à maior largura de banda e capacidade de memória do H20. Eles também anunciaram uma parceria com a Huawei, mas até agora houve muito pouco trabalho na computação Ascend.

Acreditamos que as implicações mais interessantes são particularmente o impacto sobre as margens e o que isso significa para o ecossistema como um todo. Abaixo, damos uma olhada na futura estrutura de preços em todo o setor de IA e detalhamos por que achamos que a DeepSeek está subsidiando os preços e por que estamos vendo os primeiros sinais do Paradoxo de Jevons entrando em ação. Comentamos as implicações para os controles de exportação, como as CCPs podem reagir à medida que o domínio da DeepSeek cresce e muito mais.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...