A DeepSeek lançou a primeira versão de código aberto de seu modelo v3, agora com o recurso de código mais forte (na China)

O DeepSeek-V3 é um poderoso modelo de linguagem Mixture-of-Experts (MoE) com 671 bilhões de parâmetros totais e 3,7 bilhões de parâmetros ativados para cada token. O modelo emprega uma arquitetura inovadora de atenção latente de várias cabeças (MLA) juntamente com a arquitetura comprovada do DeepSeekMoE. O CogAgent implementa uma estratégia de balanceamento de carga sem perda auxiliar e propõe um objetivo de treinamento de previsão de vários tokens para melhorar significativamente o desempenho do modelo. Ele é pré-treinado em 14,8 milhões de tokens diversos e de alta qualidade e passa por fases supervisionadas de ajuste fino e aprendizado por reforço para explorar todo o seu potencial.

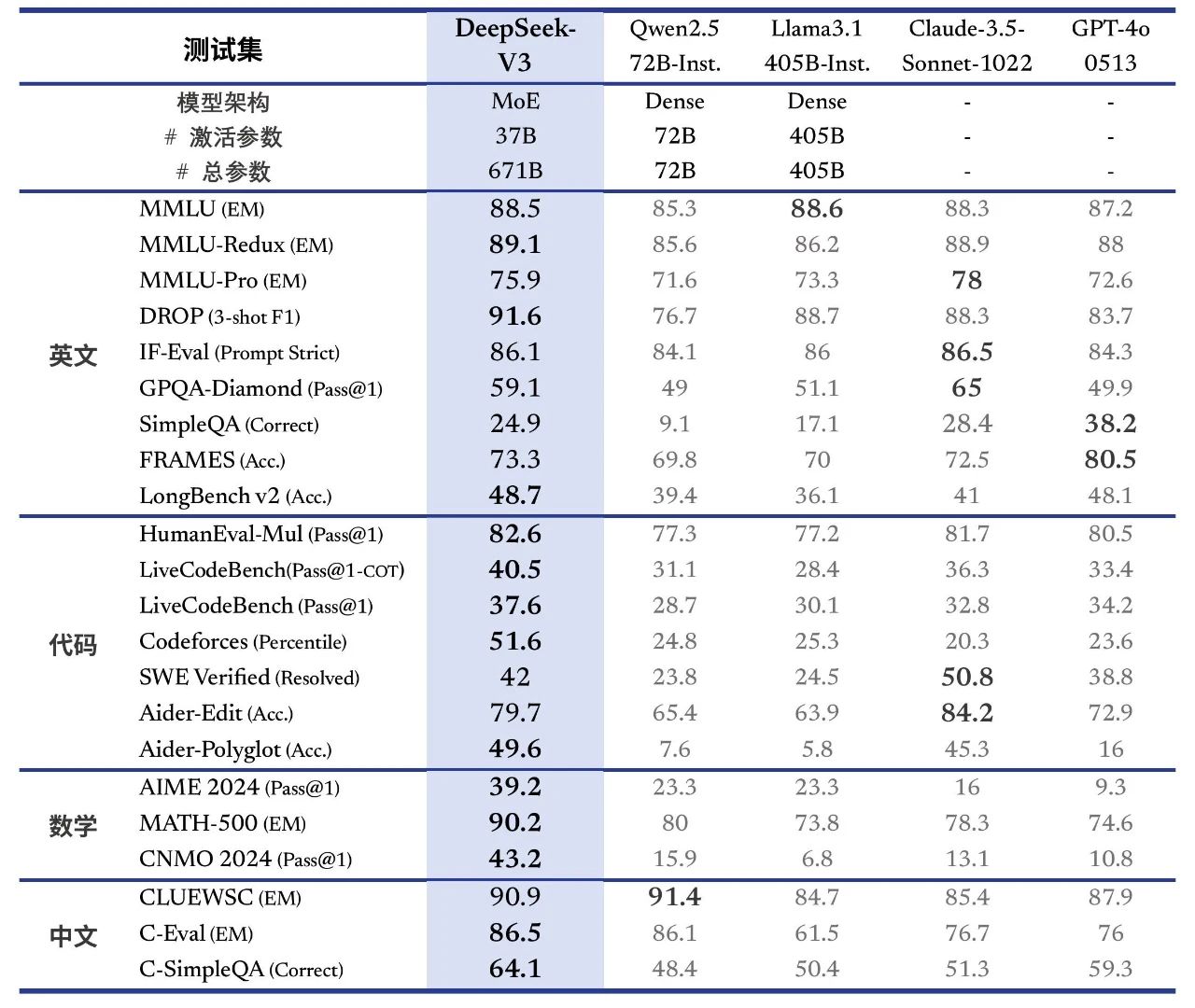

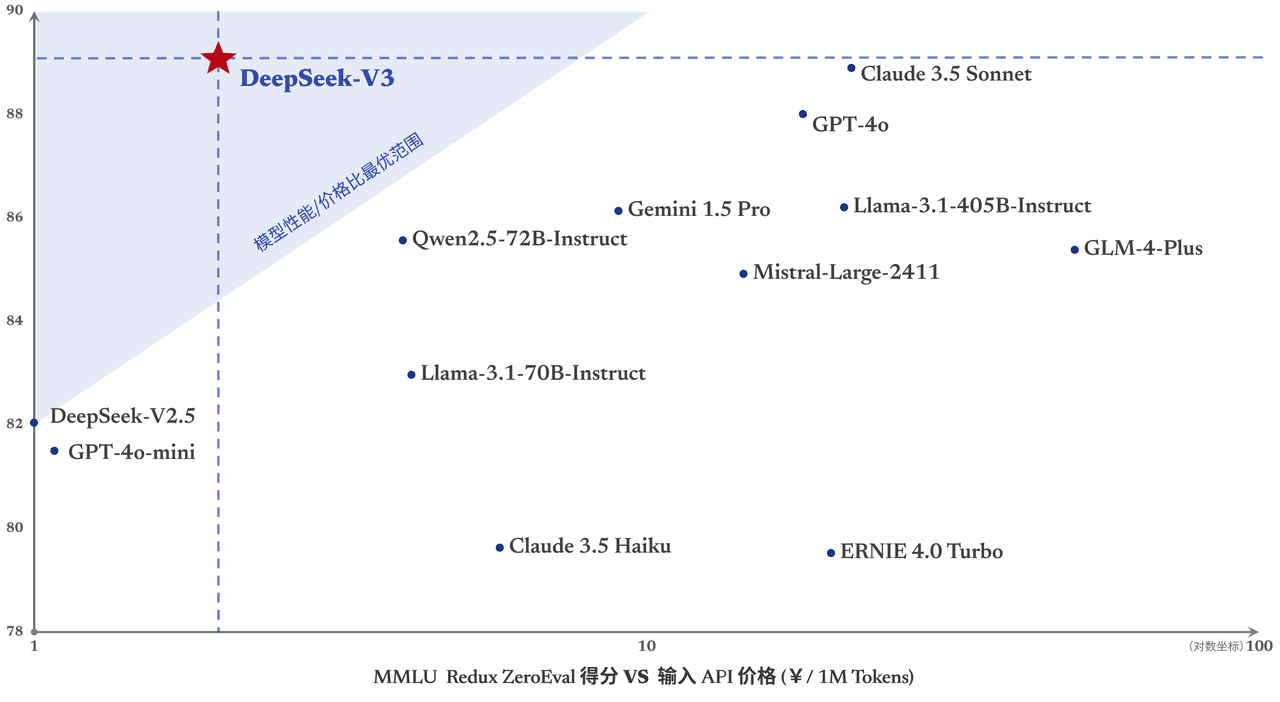

O DeepSeek-V3 tem um bom desempenho em muitos benchmarks padrão, especialmente em tarefas de matemática e código, o que o torna o modelo básico de código aberto mais forte disponível atualmente, com baixos custos de treinamento, e sua estabilidade durante o treinamento é altamente reconhecida.

Ontem, a primeira versão da nova série de modelos do DeepSeek, o DeepSeek-V3, foi lançada e teve seu código aberto ao mesmo tempo. Você pode conversar com a versão mais recente do modelo V3 fazendo login em chat.deepseek.com. O serviço de API foi atualizado simultaneamente, portanto, não há necessidade de alterar a configuração da interface. A versão atual do DeepSeek-V3 não é compatível com entrada e saída multimodal.

Alinhamento de desempenho Líder estrangeiro Modelos de fonte fechada

O DeepSeek-V3 é um modelo MoE desenvolvido internamente com 671B parâmetros e 37B ativações a 14,8T token O pré-treinamento foi realizado no

Link para o artigo:

https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

O DeepSeek-V3 supera o desempenho de outros modelos de código aberto, como o Qwen2.5-72B e o Llama-3.1-405B, em várias análises, e iguala o desempenho dos principais modelos de código fechado do mundo, o GPT-4o e o Claude-3.5-Sonnet.

- conhecimento enciclopédicoO nível do DeepSeek-V3 em tarefas baseadas em conhecimento (MMLU, MMLU-Pro, GPQA, SimpleQA) melhorou significativamente em comparação com seu predecessor, DeepSeek-V2.5, e está próximo do modelo atual de melhor desempenho, Claude-3.5-Sonnet-1022.

- texto longoEm média, o DeepSeek-V3 supera os outros modelos no DROP, FRAMES e LongBench v2 em medidas de texto longo.

- codificação::O DeepSeek-V3 está muito à frente de todos os modelos não-O1 disponíveis no mercado em termos de forças de código algorítmico.e se aproxima do Claude-3.5-Sonnet-1022 no cenário de código de classe de engenharia (SWE-Bench Verified).

- matemáticaO DeepSeek-V3 superou amplamente todos os modelos de código aberto de código fechado na Competição Americana de Matemática (AIME 2024, MATH) e na Liga Nacional de Matemática do Ensino Médio (CNMO 2024).

- Habilidades no idioma chinêsO DeepSeek-V3 tem desempenho semelhante ao do Qwen2.5-72B nos conjuntos de avaliação C-Eval e Desambiguação de Pronomes em Educação, mas é mais avançado no C-SimpleQA em Conhecimento Factual.

Geração até 3 vezes mais rápida

Por meio de inovações algorítmicas e de engenharia, o DeepSeek-V3 aumenta drasticamente a velocidade de geração de palavras de 20 TPS para 60 TPS, um aumento de três vezes em comparação com o modelo V2.5, proporcionando aos usuários uma experiência mais rápida e suave.

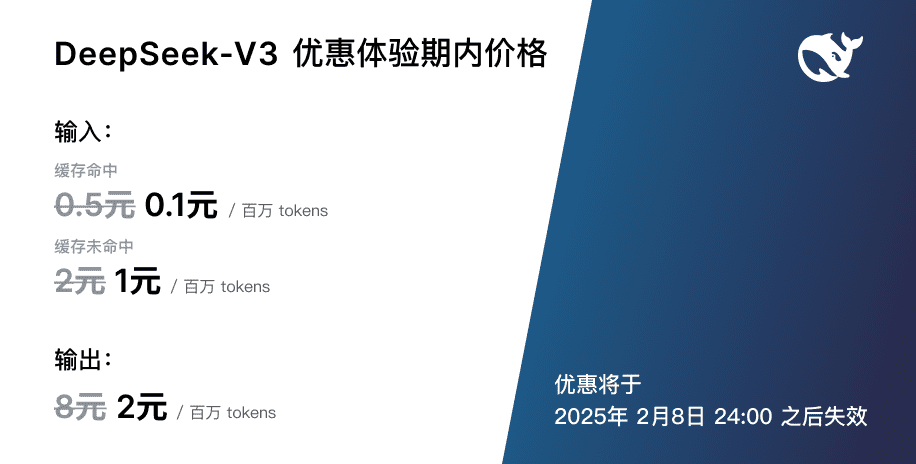

Ajuste de preço de serviço API

Quando a atualização mais avançada e rápida do DeepSeek-V3 for lançada, o preço do nosso serviço de API de modelo será ajustado para0,5 por milhão de tokens de entrada (acessos ao cache) / US$ 2 (falhas no cache), US$ 8 por milhão de tokens de saídaO objetivo é poder oferecer melhores serviços de modelagem a todos, de forma contínua.  Ao mesmo tempo, decidimos oferecer o novo modelo por até 45 dias: de agora até 8 de fevereiro de 2025, o preço do serviço de API do DeepSeek-V3 permanecerá no preço familiar de0,1 por milhão de tokens de entrada (acessos ao cache) / US$ 1 (falhas no cache), US$ 2 por milhão de tokens de saídaAs tarifas com desconto acima estão disponíveis tanto para usuários existentes quanto para novos usuários que se registrarem durante esse período.

Ao mesmo tempo, decidimos oferecer o novo modelo por até 45 dias: de agora até 8 de fevereiro de 2025, o preço do serviço de API do DeepSeek-V3 permanecerá no preço familiar de0,1 por milhão de tokens de entrada (acessos ao cache) / US$ 1 (falhas no cache), US$ 2 por milhão de tokens de saídaAs tarifas com desconto acima estão disponíveis tanto para usuários existentes quanto para novos usuários que se registrarem durante esse período.

Pesos de código aberto e implementação local

O DeepSeek-V3 usa treinamento FP8 e pesos FP8 nativos de código aberto. Graças ao apoio da comunidade de código aberto, o SGLang e o LMDeploy suportam a inferência nativa de FP8 do modelo V3 pela primeira vez, enquanto o TensorRT-LLM e o MindIE implementam a inferência BF16. Além disso, fornecemos scripts de conversão de FP8 para BF16 para a conveniência da comunidade, a fim de adaptar e expandir os cenários de aplicativos.

O download dos pesos do modelo e mais informações sobre a implantação local podem ser encontrados em:

https://huggingface.co/deepseek-ai/DeepSeek-V3-Base

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Publicações relacionadas

Nenhum comentário...