O DeepSeek incendeia o Ollama. Sua implantação local está segura? Cuidado com a aritmética "roubada"!

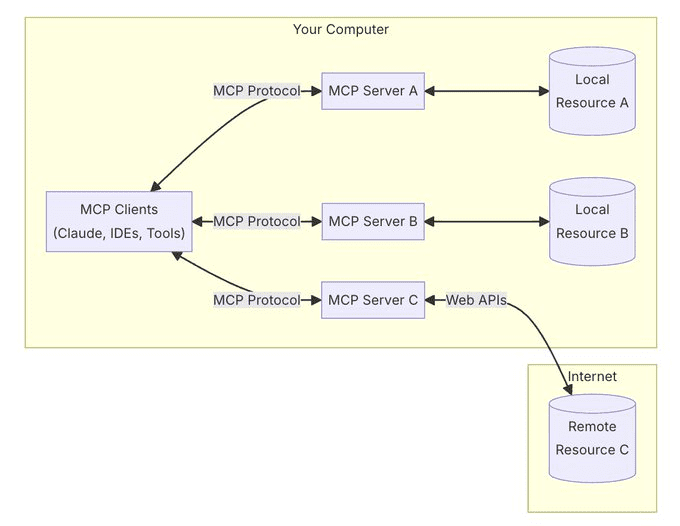

Nos últimos anos, a tecnologia de Modelagem de Linguagem Grande (LLM) vem crescendo a uma taxa sem precedentes e penetrando gradualmente em vários setores. Ao mesmo tempo, a demanda por implementação local de LLMs também está crescendo. O ollama, como uma ferramenta conveniente de implementação local de modelos grandes, é bem conhecido por sua facilidade de uso e sua capacidade de DeepSeek e outros modelos avançados são os preferidos dos desenvolvedores e entusiastas da tecnologia.

No entanto, ao buscar a conveniência tecnológica, os riscos de segurança são facilmente ignorados. Alguns usuários implementam localmente Ollama Após o serviço, a porta de serviço da Ollama pode ser exposta à Internet devido a uma configuração inadequada ou a uma consciência de segurança fraca, estabelecendo a base para possíveis riscos de segurança. Neste documento, analisaremos esse risco de segurança do início ao fim e forneceremos as medidas preventivas correspondentes.

1. conveniência e possíveis riscos de segurança da Ollama

O advento do Ollama reduziu as barreiras à implantação local e ao uso de grandes modelos de linguagem, permitindo que os usuários executem facilmente modelos de alto desempenho, como o DeepSeek, em seus PCs ou servidores. Essa conveniência atraiu um grande número de usuários, mas também criou um problema que não pode ser ignorado:O serviço Ollama, em sua configuração padrão, pode estar em risco de acesso não autorizado pela Internet.

Especificamente, se um usuário implantar o serviço Ollama sem fazer as configurações de segurança necessárias, como restringir endereços de escuta ou definir regras de firewall, a porta 11434, na qual o Ollama escuta por padrão, poderá estar aberta ao público. Isso significa que qualquer usuário da Internet pode acessar o serviço Ollama pela rede eUsar seus recursos de computação gratuitamente pode até causar problemas de segurança mais sérios.

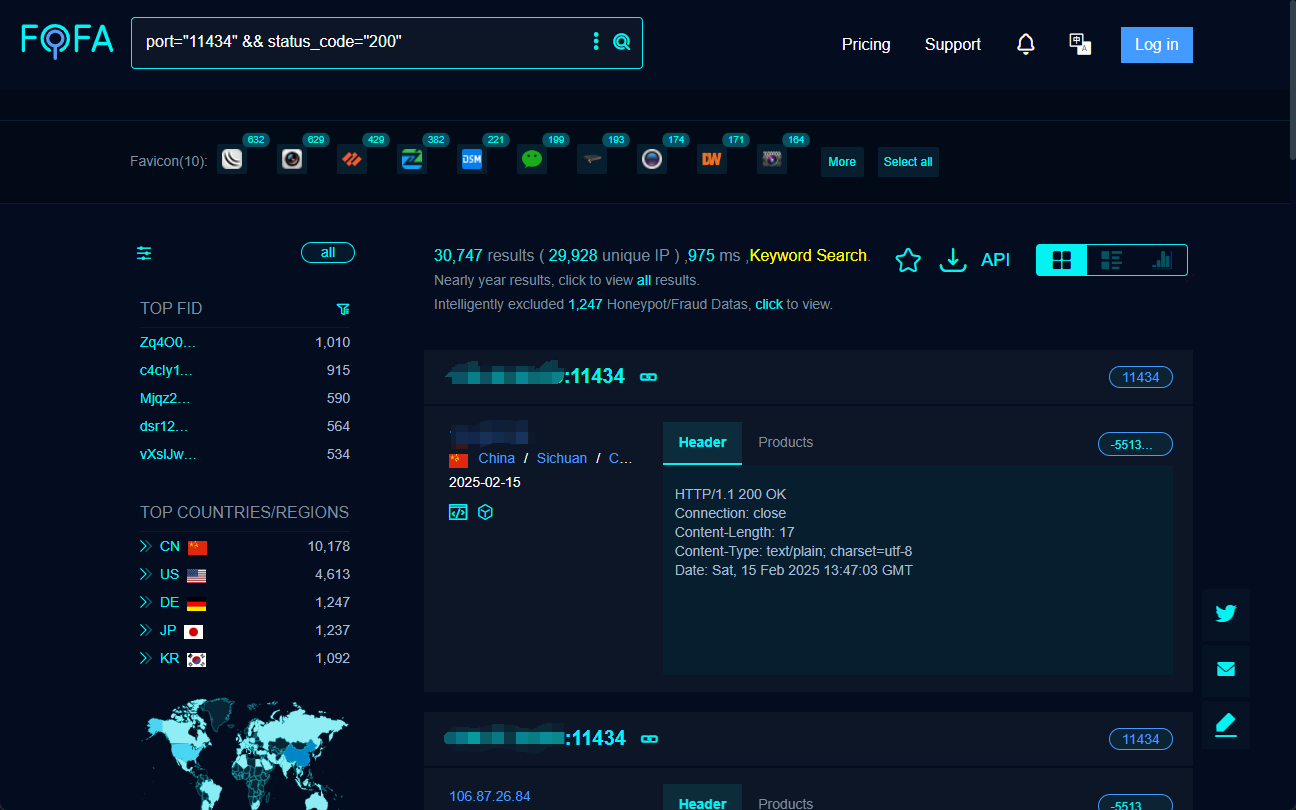

2) Como descobrir os serviços expostos da Ollama na Internet? -- Mecanismo de busca FOFA

Para entender até que ponto os serviços da Ollama estão expostos na Internet e a gama de riscos potenciais, precisamos da ajuda de um mecanismo de busca no ciberespaço.FOFA Trata-se de uma ferramenta poderosa que nos ajuda a recuperar e localizar rapidamente serviços da Web expostos publicamente em todo o mundo.

Ao construir cuidadosamente as instruções de pesquisa FOFA, podemos encontrar efetivamente hosts que expõem as portas de serviço do Ollama à Internet. Por exemplo, a seguinte instrução de pesquisa FOFA pode ser usada para encontrar alvos com a porta aberta 11434 e o código de status 200:

port="11434" && status_code="200"

Ao realizar a pesquisa acima, a FOFA lista endereços IP de destino qualificados que provavelmente estão executando serviços da Ollama que são abertos ao público.

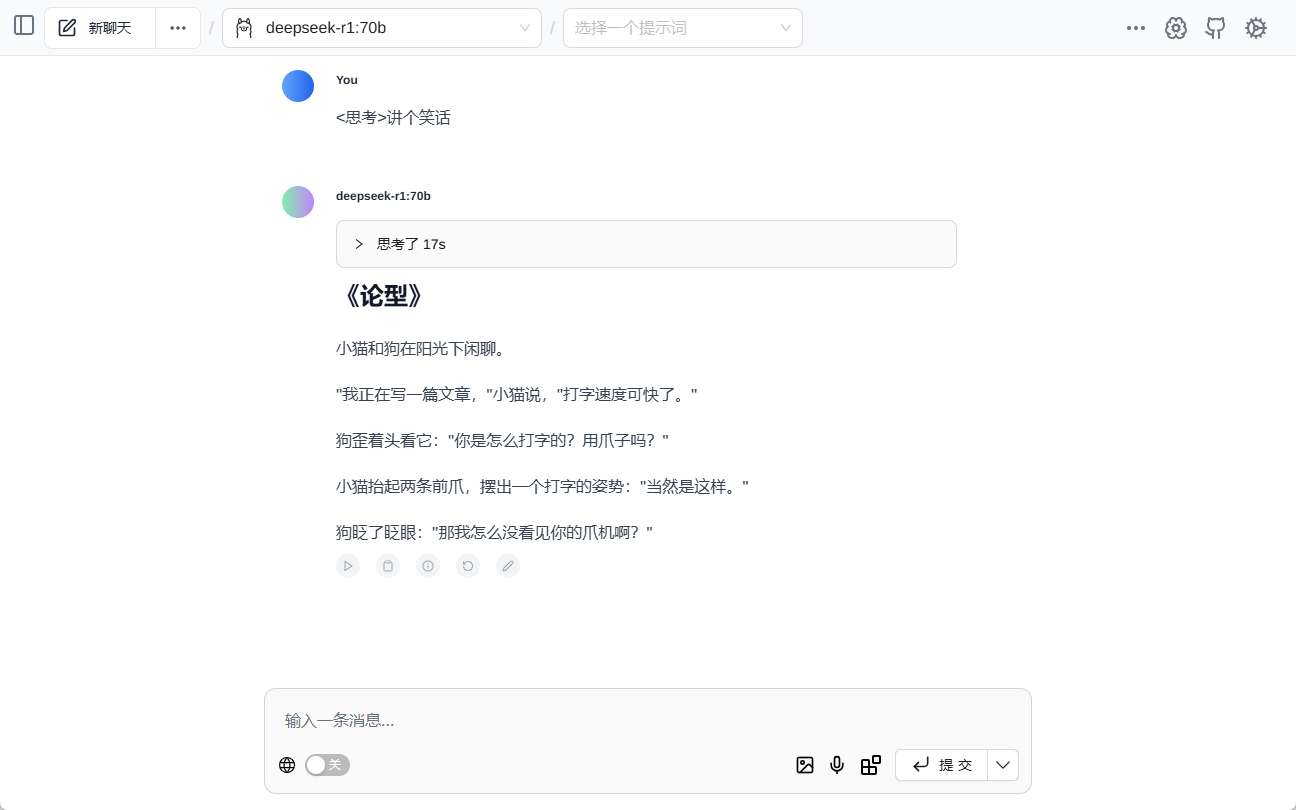

3. como conectar e "prostituir" o serviço aberto do Ollama? -- ChatBox e Cherry Studio

Depois que a interface aberta do serviço Ollama for encontrada por meio da FOFA, a próxima etapa é conectar-se e interagir com ela usando ferramentas do lado do cliente.ChatBox responder cantando Estúdio Cherry são dois softwares clientes de IA comumente usados, ambos compatíveis com a conexão ao serviço Ollama com chamadas de modelo e diálogo.

3.1 Uso do ChatBox para se conectar ao serviço Open Ollama

ChatBox Conhecido por sua simplicidade e facilidade de uso, as etapas para se conectar ao serviço Open Ollama são muito simples:

- Faça o download e instale o cliente ChatBox.

- Configure o endereço da API: existir ChatBox Configurações, defina o endereço da API como o endereço IP e a porta do servidor de destino, por exemplo

http://目标IP:11434/. - Selecione o modelo e inicie o diálogo: Quando a configuração estiver concluída, você poderá selecionar o modelo e iniciar um diálogo com o serviço remoto da Ollama.

3.2 Conexão ao Open Ollama Service com o Cherry Studio

Estúdio Cherry Ele é mais abrangente e oferece suporte a recursos avançados, como o gerenciamento da base de conhecimento, além das funções de diálogo. As etapas para se conectar são as seguintes:

- Faça o download e instale o cliente Cherry Studio.

- Configure a interface Ollama: existir Estúdio Cherry Em "Settings" → "Model Services" → "Ollama", defina o endereço da API como

http://目标IP:11434. - Adicionar e validar o modelo: Adicione o modelo de destino na página de gerenciamento de modelos, como "deepseek-r1:1.5b", e teste a conexão, e você poderá usá-la após o sucesso.

Por meio de clientes como o ChatBox ou o Cherry Studio, os usuários podem se conectar facilmente aos serviços da Ollama expostos na Internet eUso gratuito e não autorizado de recursos de computação e recursos de modelagem de terceiros.

Depois de obter um endereço aleatório, experimente o plug-in da Web que suporta nativamente a leitura de modelos Ollama Assistência à página Diálogo no meio:

4. riscos de segurança por trás do "almoço grátis": roubo de energia, vazamento de dados e armadilhas legais

Por trás do aparente "almoço grátis", há muitos riscos de segurança ocultos e possíveis problemas legais:

- Roubo aritmético (uso indevido de recursos). O risco mais imediato é que o poder de computação da GPU de um provedor de serviços da Ollama seja usado por outros sem compensação, levando ao desperdício de recursos e à degradação do desempenho. Os invasores podem usar scripts automatizados para fazer varreduras em massa e se conectar a serviços abertos do Ollama, transformando suas GPUs em "oficinas" para treinar modelos mal-intencionados.

- Violação de dados. Se dados confidenciais forem armazenados ou processados no serviço Ollama, há o risco de vazamento desses dados em um ambiente de rede aberta. Os registros de diálogo dos usuários, os dados de treinamento etc. podem ser transmitidos por canais não criptografados e ser maliciosamente ouvidos ou roubados.

- Modelos para venda. Os arquivos de modelos não criptografados são facilmente baixados e copiados e, se modelos grandes de setores comercialmente valiosos forem usados nos serviços da Ollama, há o risco de que os modelos sejam roubados e vendidos, resultando em perdas financeiras significativas.

- Intrusão no sistema. O serviço Ollama em si pode ter uma vulnerabilidade de segurança que, se explorada por um hacker, pode levar à execução remota de código, permitindo que um invasor assuma o controle total do servidor da vítima, transformando-o em um servidor de segurança.mudar paraParte de um botnet usado para lançar ataques cibernéticos de grande escala.

- Riscos legais. O acesso e o uso não autorizados dos serviços da Ollama de outras pessoas, ou mesmo o uso malicioso deles, podem violar as leis e os regulamentos pertinentes e acarretar responsabilidade legal.

5. os usuários chineses estão mais seguros? -- IP dinâmico não é uma barreira absoluta

Argumentou-se que "os usuários chineses estão relativamente seguros contra esse risco de 'prostituição branca' devido ao baixo número de propriedades de IP independentes". Essa visão é um tanto unilateral.

É verdade que uma porcentagem maior de usuários chineses de banda larga doméstica usa IPs dinâmicos em comparação com os países ocidentais, o que reduz o risco de exposição até certo ponto. A incerteza dos IPs dinâmicos torna difícil para os invasores rastrear e localizar usuários específicos ao longo do tempo.

Mas isso não significa, de forma alguma, que os usuários chineses possam ficar tranquilos. Primeiro, ainda há um grande número de servidores Ollama no ambiente de Internet chinês, inclusive muitos com IPs fixos. Em segundo lugar, mesmo os IPs dinâmicos podem permanecer inalterados por um determinado período de tempo, e ainda é possível que um invasor realize um ataque durante o período em que o endereço IP não foi alterado. Mais importante ainda.A segurança não pode ser deixada para a "sorte" ou "barreiras naturais", mas deve se basear em medidas de segurança proativas.

6. diretrizes de segurança do serviço local da Ollama: como evitar se tornar um "frango"

Para proteger os serviços Ollama implantados localmente contra o uso indevido por terceiros, os usuários precisam tomar medidas de segurança proativas e eficazes. Abaixo estão algumas diretrizes para usuários iniciantes:

6.1 Restrição de endereços de escuta do serviço Ollama

Altere o endereço de escuta do serviço Ollama do padrão 0.0.0.0 modificar para 127.0.0.1Não tem problema.Força o serviço Ollama a ouvir apenas solicitações da máquina local e a negar o acesso direto de redes externas. As etapas são as seguintes:

- Localize o arquivo de configuração: Os arquivos de configuração do Ollama geralmente estão localizados no diretório

/etc/ollama/config.conf.. Abra o arquivo (ou crie-o, caso não exista), localize ou adicione obind_addressItem de configuração. - Modificar o endereço de vinculação: comandante-em-chefe (militar)

bind_addressé definido como o valor de127.0.0.1e garantir queportdefinido como11434. Um exemplo de configuração completa é mostrado abaixo:bind_address = 127.0.0.1 port = 11434 - Salve e reinicie o serviço: Depois de salvar o arquivo de configuração, execute o comando

sudo systemctl restart ollamapara reiniciar o serviço Ollama para que a configuração tenha efeito.

6.2 Configuração de regras de firewall

Ao configurar as regras de firewall, você podeControle preciso sobre o intervalo de endereços IP e portas que podem acessar o serviço Ollama. Por exemplo, você pode permitir que apenas os endereços IP da sua LAN acessem a porta 11434 e bloquear todas as solicitações de acesso da rede pública. A seguir, descrevemos como configurar o firewall nos ambientes Windows e Linux, respectivamente:

Etapas de configuração do ambiente Windows:

- Ative o Firewall do Windows Defender com segurança avançada: No "Painel de controle", localize "Sistema e segurança", clique em "Firewall do Windows Defender" e selecione "Configurações avançadas". Configurações avançadas".

- Crie uma nova regra de entrada: Em "Inbound Rules" (Regras de entrada), clique em "New Rule..." (Nova regra...), selecione o tipo de regra "Port" (Porta) e clique em "Next" (Avançar). Próximo".

- Especifica a porta e o protocolo: O protocolo é selecionado como "TCP" e a porta local específica é definida como

11434, clique em "Next" (Avançar). - Selecione a operação: Selecione "Allow connection" (Permitir conexão) e clique em "Next" (Avançar).

- Configure o escopo (opcional): Você pode configurar os escopos das regras conforme necessário; em geral, basta manter as configurações padrão e clicar em Next.

- Especifique o nome e a descrição: Atribua um nome facilmente reconhecível à regra (por exemplo, "Ollama Service Port Restriction"), adicione uma descrição (opcional) e clique em "Finish" (Concluir) para concluir a criação da regra.

Ambiente Linux (firewall ufw, por exemplo) Etapas de configuração:

- Ativar o firewall ufw: Se o ufw ainda não estiver ativado, execute o seguinte no terminal

sudo ufw enablepara ativar o firewall. - Permitir acesso à LAN: realizar

sudo ufw allow from 192.168.1.0/24 to any port 11434que permite o comando192.168.1.0/24O endereço IP do segmento de LAN acessa a porta 11434. Modifique o intervalo de endereços IP de acordo com o segmento real da LAN. - Negar outro acesso (opcional): Se a política padrão for permitir todo o acesso externo, você poderá executar o comando

sudo ufw deny 11434para negar o acesso à porta 11434 a endereços IP de todas as outras origens. - Exibir o status do firewall: realizar

sudo ufw status verbosepara verificar o status da regra do firewall e confirmar que a configuração foi efetivada.

6.3 Habilitação de autenticação e controle de acesso

Para cenários em que você precisa fornecer serviços Ollama externamente, certifique-se deAtivação de mecanismos de autenticação. para impedir o acesso não autorizado. Veja a seguir alguns métodos comuns de autenticação:

- Autenticação básica de HTTP: A autenticação básica HTTP pode ser configurada por meio de um servidor da Web, como o Apache ou o Nginx. Esse método é simples e fácil de usar, mas a segurança é relativamente baixa, adequada para cenários que não exigem alta segurança. Depois de configurar a autenticação básica, os usuários precisam fornecer nome de usuário e senha ao acessar os serviços da Ollama.

- Chave de API: Adicionar mecanismo de verificação de chave de API ao front-end do serviço Ollama. Quando um cliente solicita o serviço Ollama, ele precisa incluir uma chave de API predefinida no cabeçalho da solicitação ou nos parâmetros da solicitação. O lado do servidor verifica a validade da chave e somente as solicitações com a chave correta são processadas. Essa abordagem é mais segura do que a autenticação básica e é fácil de integrar aos aplicativos.

- Mecanismos de autorização de autenticação mais avançados, como o OAuth 2.0: Para cenários com requisitos de segurança mais altos, estruturas de autenticação e autorização mais complexas, como o OAuth 2.0, podem ser consideradas. O OAuth 2.0 oferece um processo perfeito de autorização e autenticação, é compatível com vários modos de autorização e pode obter um controle de acesso refinado. No entanto, a configuração e a integração do OAuth 2.0 são relativamente complexas e exigem um certo esforço de desenvolvimento.

A escolha do método de autenticação precisa se basear em uma combinação de fatores, como cenários de aplicativos, requisitos de segurança e custo da implementação técnica do serviço Ollama.

6.4 Uso de um proxy reverso

Usando um servidor proxy reverso (como o Nginx), você podeAtua como um front-end para o serviço Ollama, ocultando o endereço IP e a porta reais do serviço Ollama e fornecendo recursos de segurança adicionais.Por exemplo:

- Oculte o servidor back-end: Os usuários externos só podem ver o endereço IP do servidor proxy reverso e não podem acessar diretamente o servidor real onde o serviço Ollama está localizado, o que aumenta a segurança.

- Balanceamento de carga: Se o serviço Ollama for implantado em vários servidores, o servidor proxy reverso poderá implementar o balanceamento de carga para distribuir as solicitações dos usuários a diferentes servidores, melhorando a disponibilidade e o desempenho do serviço.

- Criptografia SSL/TLS: Os servidores proxy reversos podem ser configurados com certificados SSL/TLS para permitir o acesso criptografado HTTPS e proteger a segurança da transmissão de dados.

- Firewall de aplicativos da Web (WAF): Alguns servidores proxy reverso integram a funcionalidade WAF para detectar e se defender contra ataques comuns da Web, como injeção de SQL, ataques de script entre sites (XSS) etc., aumentando ainda mais a segurança do serviço Ollama.

- Controle de acesso: Os servidores proxy reversos podem ser configurados com políticas de controle de acesso mais flexíveis, como o controle de acesso baseado no endereço IP, na identidade do usuário e no conteúdo da solicitação.

7 Conclusão: conscientização sobre segurança e responsabilidade em ação

A popularidade de ferramentas de modelos grandes implantadas localmente, como o Ollama, facilitou a inovação e os aplicativos tecnológicos, mas também impôs novos desafios à segurança cibernética. O serviço Ollama, exposto na Internet como "de uso gratuito", pode parecer atraente, mas traz riscos ocultos. Esse comportamento pode não apenas violar leis e regulamentos e a ética cibernética, mas também representar uma ameaça à sua própria segurança cibernética e à de outras pessoas.

Para os implementadores de serviços da Ollama, aumentar a conscientização sobre a segurança e tomar as medidas de segurança necessárias é a responsabilidade de proteger seus próprios recursos de computação e a segurança dos dados, bem como de manter um ambiente de rede saudável. Não transforme seus servidores em "frangos de corte aritméticos" nem se torne cúmplice de ataques cibernéticos por causa de uma negligência momentânea.

Enquanto aproveitam os dividendos da tecnologia, todos os usuários da Internet devem estar sempre atentos, estabelecer uma visão correta da segurança da rede e trabalhar juntos para criar um ecossistema de aplicativos de IA seguro, confiável e sustentável.

ALERTA DE RISCO MAIS UMA VEZ: verifique e proteja seu serviço Ollama imediatamente! Segurança não é pouca coisa!

A popularidade do modelo DeepSeek e da ferramenta Ollama é, sem dúvida, um exemplo do desenvolvimento da tecnologia de IA. No entanto, a segurança é sempre a pedra angular do avanço tecnológico que não pode ser ignorada. Por favor, usuários do OllamaAnalise imediatamente a configuração de sua implementação local, avalie os possíveis riscos de segurança e tome as medidas de proteção necessárias. Não é tarde demais para consertar.

Para aqueles que ainda não instalaram o Ollama ou estão pensando em implantá-lo, certifique-se também deReconheça totalmente os riscos de segurança da implantação local de ferramentas de big model, avalie com prudência seus próprios recursos técnicos e o nível de proteção de segurança e use-os adequadamente com a premissa de garantir a segurança. Lembre-se de que a segurança cibernética é responsabilidade de todos, e a melhor estratégia é prevenir antes que aconteça.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...