Aplicação em larga escala da API DeepSeek da tecnologia de cache de disco rígido: uma etapa fundamental na civilização de modelos grandes

-- Uma discussão sobre a lógica mais profunda das grandes guerras de preços de APIs de modelos, otimização da experiência do usuário e inclusão de tecnologia

Crédito da imagem: Documentação oficial do DeepSeek

Em um momento em que a concorrência no campo de grandes modelos de IA está esquentando, a DeepSeek anunciou recentemente que seu serviço de API usa de forma inovadora oTecnologia de cache de disco rígidoO ajuste de preço da DeepSeek é chocante - o preço da parte de acerto do cache é reduzido diretamente para um décimo do preço anterior, mais uma vez atualizando o resultado final do preço do setor. Como revisor terceirizado que há muito tempo se preocupa com a tecnologia de modelos grandes e as tendências do setor, acredito que a mudança da DeepSeek não é apenas uma revolução de custos impulsionada pela inovação tecnológica, mas também uma otimização profunda da experiência do usuário da API de modelos grandes e uma etapa importante para acelerar a generalização da tecnologia de modelos grandes.

Inovação tecnológica: sutilezas do cache do disco rígido e saltos de desempenho

O DeepSeek está profundamente ciente dos problemas de alto custo e latência que há muito tempo restringem a adoção generalizada de APIs de grandes modelos, e a duplicação contextual generalizada das solicitações do usuário é um dos principais contribuintes para esses problemas. Por exemplo, em diálogos de várias rodadas, o histórico do diálogo anterior precisa ser reinserido em cada rodada; em tarefas de processamento de texto longo, o Prompt geralmente contém referências repetidas. Computação repetitiva Token Isso desperdiça aritmética e aumenta a latência.

Para resolver esse problema, o DeepSeek introduziu de forma criativa a tecnologia de cache de disco rígido contextual. O princípio básico é armazenar em cache de forma inteligente o conteúdo contextual que se prevê que será reutilizado no futuro, como histórico de conversas, predefinições do sistema, exemplos de poucas fotos etc., em uma matriz de disco rígido distribuída. Quando um usuário inicia uma nova solicitação de API, o sistema detecta automaticamente se a parte do prefixo da entrada corresponde ao conteúdo armazenado em cache (observação: o prefixo deve ser idêntico para atingir o cache). Se corresponder, o sistema lê a duplicata diretamente do cache do disco rígido de alta velocidade sem recalcular, otimizando a latência e o custo.

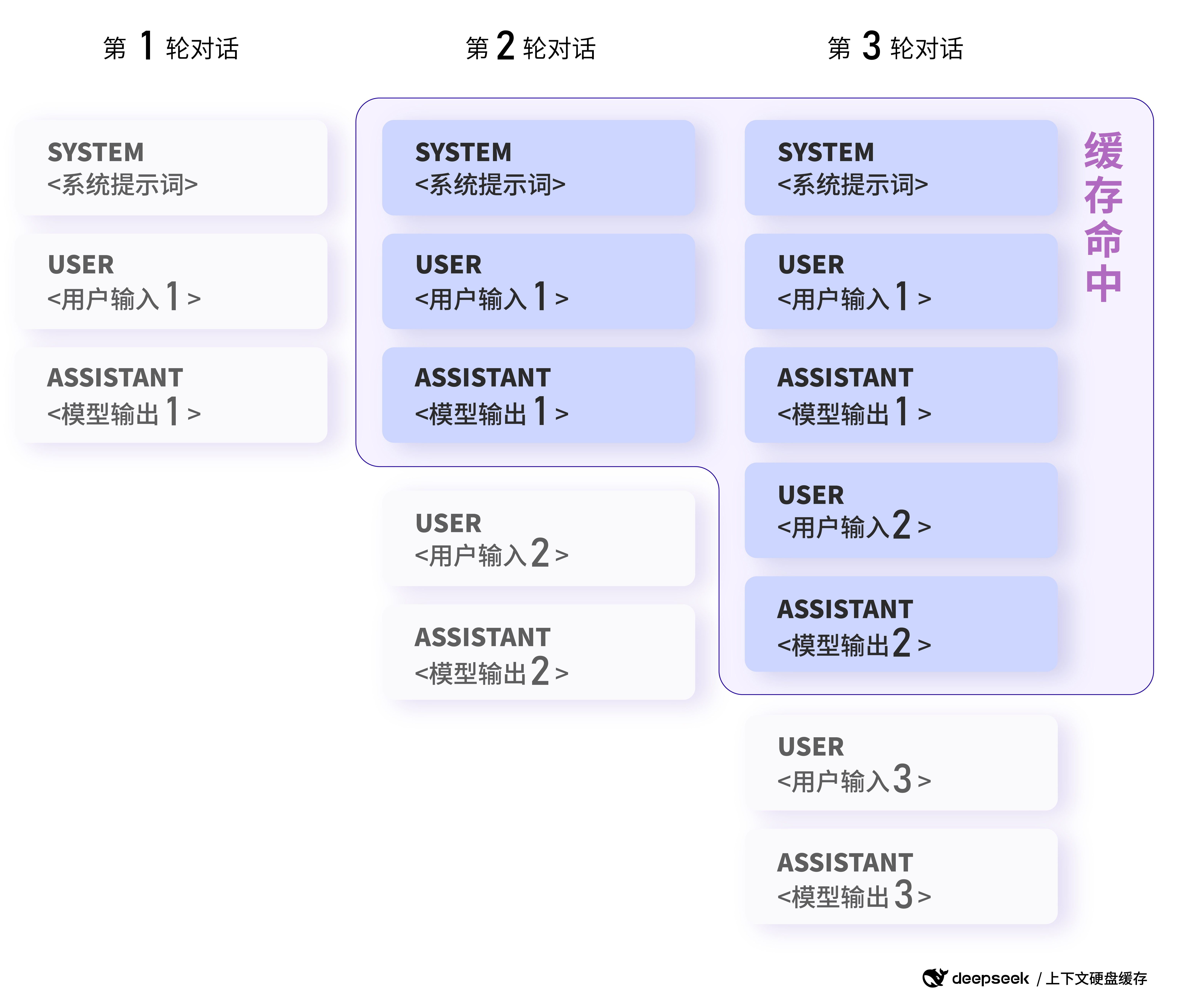

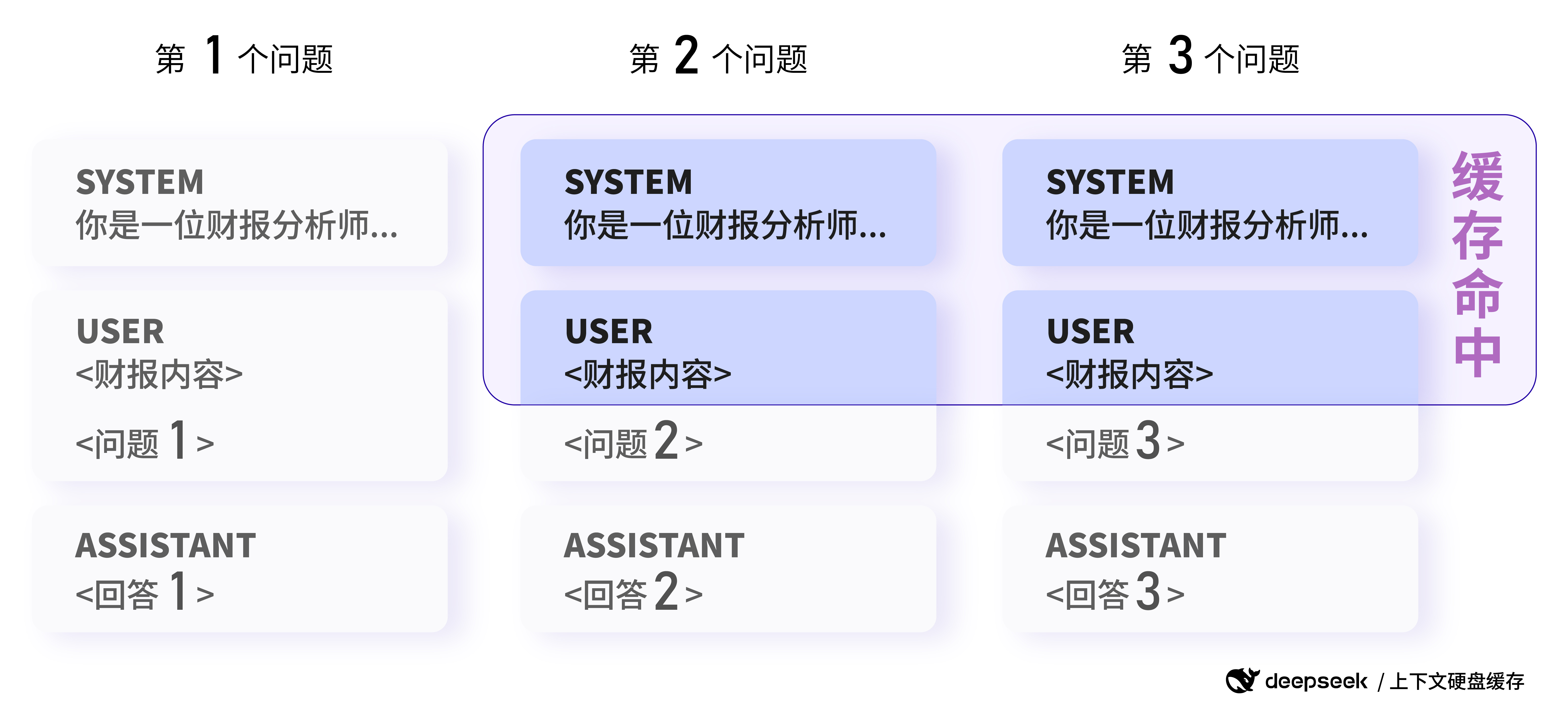

Para entender melhor como o armazenamento em cache funciona, vamos dar uma olhada em alguns exemplos de DeepSeek Exemplo oficial fornecido:

Exemplo 1: Cenário de diálogo em várias rodadas

Recurso principal: as rodadas de diálogo subsequentes acessam automaticamente o cache de contexto da rodada anterior.

Em um diálogo de várias rodadas, em que os usuários normalmente fazem perguntas sucessivas sobre um único tópico, o armazenamento em cache do disco rígido do DeepSeek pode reutilizar efetivamente o contexto do diálogo. Por exemplo, no seguinte cenário de diálogo:

Primeira solicitação:

messages: [

{"role": "system", "content": "你是一位乐于助人的助手"},

{"role": "user", "content": "中国的首都是哪里?"}

]

Segunda solicitação:

messages: [

{"role": "system", "content": "你是一位乐于助人的助手"},

{"role": "user", "content": "中国的首都是哪里?"},

{"role": "assistant", "content": "中国的首都是北京。"},

{"role": "user", "content": "美国的首都是哪里?"}

]

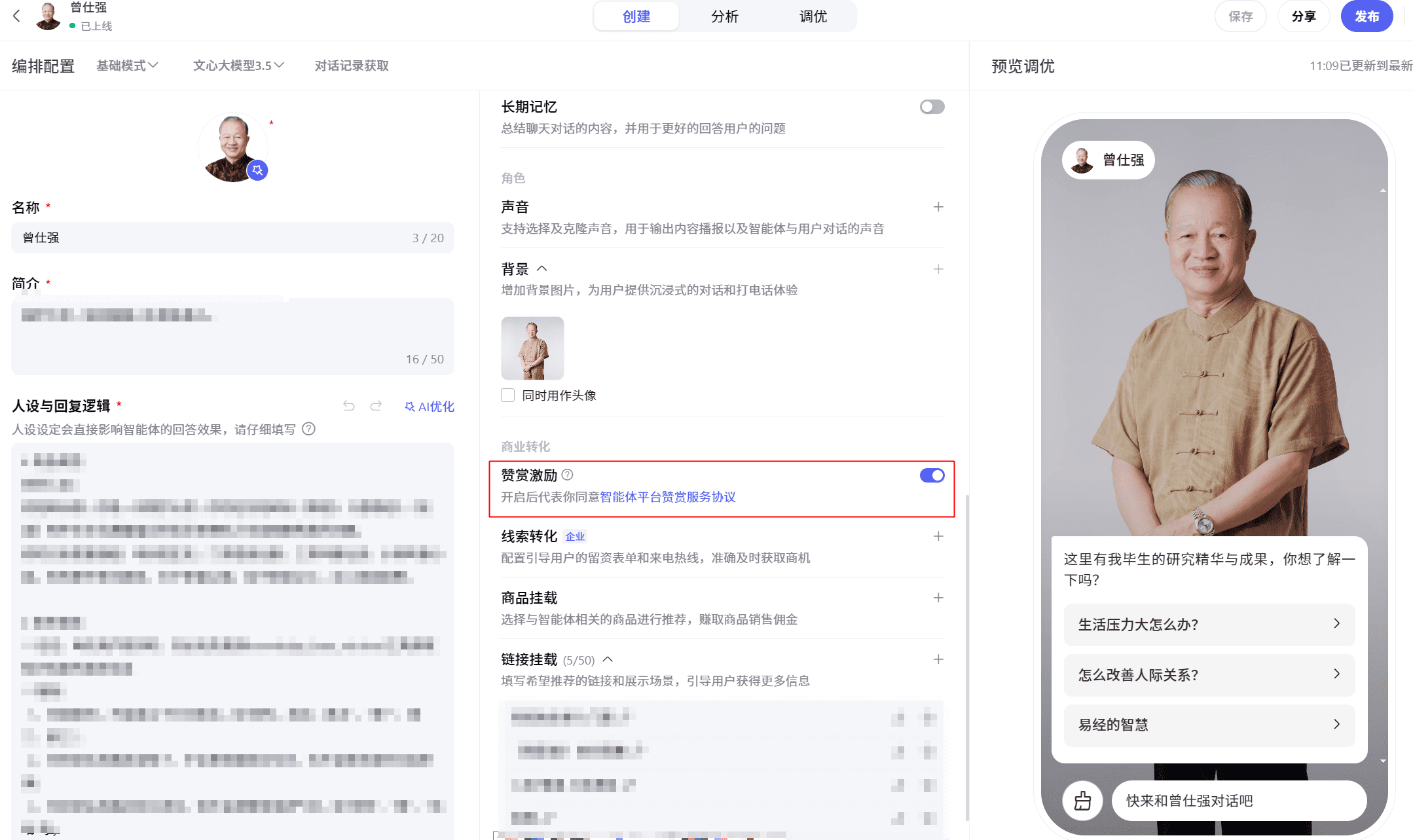

Crédito da imagem: Documentação oficial do DeepSeek

Exemplo de um cache atingido em um cenário de diálogo de várias rodadas: as rodadas de diálogo subsequentes atingem automaticamente o cache de contexto da rodada anterior.

Na segunda solicitação, como a parte do prefixo (mensagem do sistema + primeira mensagem do usuário) é exatamente igual à da primeira solicitação, essa parte será atingida pelo cache sem a necessidade de repetir o cálculo, reduzindo assim a latência e o custo.

De acordo com os dados oficiais do DeepSeek, em cenários extremos com 128 mil entradas e a maioria das repetições, a latência medida do primeiro token caiu de 13 segundos para 500 milissegundos, o que representa uma incrível melhoria de desempenho. Mesmo em cenários não extremos, ele pode reduzir efetivamente a latência e melhorar a experiência do usuário.

Além disso, o serviço de armazenamento em cache do disco rígido do DeepSeek é totalmente automatizado e independente do usuário. Você pode aproveitar as vantagens de desempenho e preço do armazenamento em cache sem precisar alterar qualquer código ou interface de API. O novo prompt_cache_hit_tokens (hits de cache) no campo de uso retornado pela API permite que os usuários vejam o número de hits de cache que receberam. tokens (número de tokens) e prompt_cache_miss_tokens (número de tokens perdidos) para monitorar os acessos ao cache em tempo real e avaliar e otimizar melhor o desempenho do cache.

O DeepSeek é capaz de assumir a liderança na aplicação da tecnologia de cache de disco rígido em grande escala, o que é inseparável de sua arquitetura de modelo avançada. A estrutura MLA (Multi-head Latent Attention) proposta pelo DeepSeek V2 comprime significativamente o tamanho do cache KV contextual, garantindo o desempenho do modelo, possibilitando o armazenamento do cache KV em um disco rígido de baixo custo, o que estabelece a base para a tecnologia de cache de disco rígido se enraizar no mercado. Isso possibilita o armazenamento do KV Cache em um disco rígido de baixo custo, estabelecendo a base para a tecnologia de cache de disco rígido.

entendimentos DeepSeek-R1 API Cache Hit vs. Preço:Perguntas frequentes sobre o uso da API DeepSeek-R1

Cenários de aplicativos: de perguntas e respostas de texto longo a análise de código, os limites são infinitamente expansíveis!

Há uma grande variedade de cenários em que a tecnologia de cache de disco rígido pode ser usada, e praticamente qualquer aplicativo de modelo grande que envolva entrada contextual pode se beneficiar dela. O artigo original lista os seguintes cenários típicos e fornece exemplos mais específicos:

- Um assistente de quiz com palavras-chave longas e predefinidas:

- Recurso principal: os prompts fixos do sistema podem ser armazenados em cache, reduzindo o custo por solicitação.

- Exemplo:

Exemplo 2: Cenário de perguntas e respostas com texto longo

Recurso principal: várias análises do mesmo documento podem atingir o cache.

Os usuários precisam analisar o mesmo relatório de ganhos e fazer perguntas diferentes:

Primeira solicitação:

messages: [

{"role": "system", "content": "你是一位资深的财报分析师..."},

{"role": "user", "content": "<财报内容>\n\n请总结一下这份财报的关键信息。"}

]

Segunda solicitação:

messages: [

{"role": "system", "content": "你是一位资深的财报分析师..."},

{"role": "user", "content": "<财报内容>\n\n请分析一下这份财报的盈利情况。"}

]

Na segunda solicitação, como a parte da mensagem do sistema e da mensagem do usuário tem o mesmo prefixo da primeira solicitação, essa parte pode ser atingida pelo cache para economizar recursos de computação.

- Aplicativos de interpretação de papéis com várias rodadas de diálogo:

- Principais recursos: alta reutilização do histórico de diálogo e armazenamento em cache significativo.

- (O Exemplo 1 foi mostrado em detalhes)

- Análise de dados para coleções de textos fixos:

- Principais recursos: várias análises e questionários sobre o mesmo documento com alta repetição de prefixos.

- Por exemplo, várias análises e sessões de perguntas e respostas sobre o mesmo relatório financeiro ou documento jurídico. (O Exemplo 2 foi mostrado em detalhes)

- Ferramentas de análise de código e solução de problemas no nível do repositório de código:

- Recurso principal: as tarefas de análise de código geralmente envolvem uma grande quantidade de contexto, e o armazenamento em cache pode ser eficaz na redução de custos.

- Aprendizado com poucos disparos:

- Recurso principal: os exemplos de poucos disparos prefixados com Prompt podem ser armazenados em cache, reduzindo o custo de várias chamadas de poucos disparos.

- Exemplo:

Exemplo 3: Cenário de aprendizado com poucos disparos

Recurso principal: o mesmo exemplo Few-shot pode ser armazenado em cache como um prefixo.

Os usuários usam o aprendizado Few-shot para melhorar a eficácia do modelo no questionário de conhecimento histórico:

Primeira solicitação:

messages: [

{"role": "system", "content": "你是一位历史学专家,用户将提供一系列问题,你的回答应当简明扼要,并以`Answer:`开头"},

{"role": "user", "content": "请问秦始皇统一六国是在哪一年?"},

{"role": "assistant", "content": "Answer:公元前221年"},

{"role": "user", "content": "请问汉朝的建立者是谁?"},

{"role": "assistant", "content": "Answer:刘邦"},

{"role": "user", "content": "请问唐朝最后一任皇帝是谁"},

{"role": "assistant", "content": "Answer:李柷"},

{"role": "user", "content": "请问明朝的开国皇帝是谁?"},

{"role": "assistant", "content": "Answer:朱元璋"},

{"role": "user", "content": "请问清朝的开国皇帝是谁?"}

]

Segunda solicitação:

messages: [

{"role": "system", "content": "你是一位历史学专家,用户将提供一系列问题,你的回答应当简明扼要,并以`Answer:`开头"},

{"role": "user", "content": "请问秦始皇统一六国是在哪一年?"},

{"role": "assistant", "content": "Answer:公元前221年"},

{"role": "user", "content": "请问汉朝的建立者是谁?"},

{"role": "assistant", "content": "Answer:刘邦"},

{"role": "user", "content": "请问唐朝最后一任皇帝是谁"},

{"role": "assistant", "content": "Answer:李柷"},

{"role": "user", "content": "请问明朝的开国皇帝是谁?"},

{"role": "assistant", "content": "Answer:朱元璋"},

{"role": "user", "content": "请问商朝是什么时候灭亡的"},

]

Na segunda solicitação, como o mesmo exemplo de 4 disparos é usado como prefixo, essa parte pode ser atingida pelo cache e somente a última pergunta precisa ser recalculada, reduzindo significativamente o custo do aprendizado de poucos disparos.

Crédito da imagem: Documentação oficial do DeepSeek

Exemplo de um acerto de cache em um cenário de análise de dados: solicitações com o mesmo prefixo podem acertar o cache (observação: a imagem aqui segue o exemplo original de análise de dados, que se concentra mais no conceito de duplicação de prefixo, e o cenário de exemplo de poucas fotos pode ser interpretado da mesma forma).

Esses cenários são apenas a ponta do iceberg. A aplicação da tecnologia de cache de disco rígido realmente abre a imaginação para a aplicação de APIs de modelos grandes de contexto longo. Por exemplo, podemos criar ferramentas mais avançadas de criação de textos longos, lidar com tarefas mais complexas que exigem muito conhecimento e desenvolver aplicativos de IA de conversação mais profundos e memoráveis.

Referência: Inspirado por Claude

Vantagem de custo: os preços caem em ordens de magnitude para beneficiar a grande ecologia do modelo

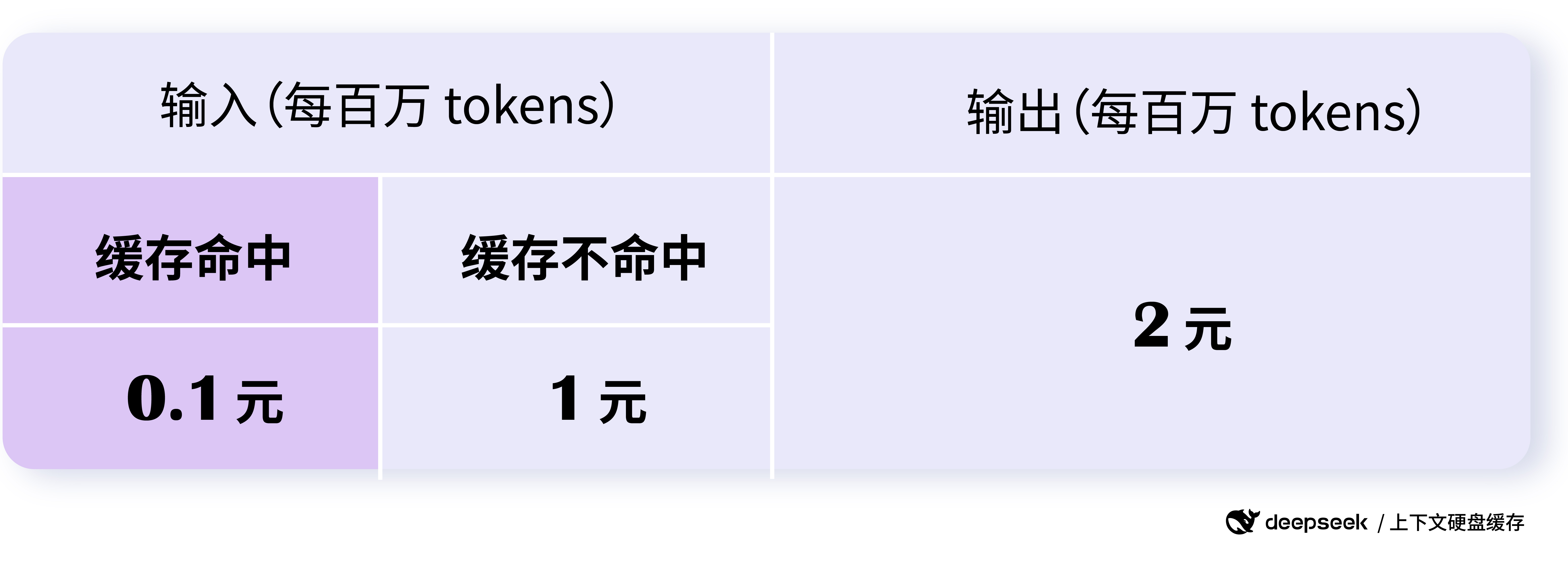

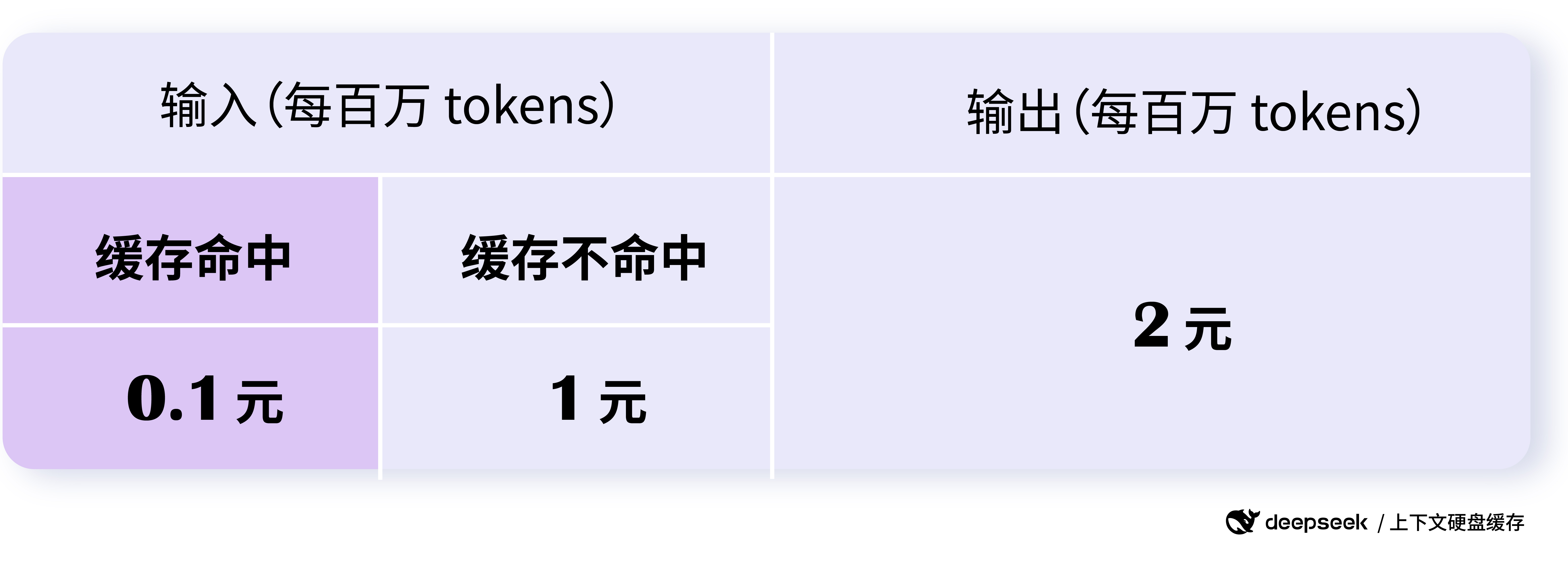

O ajuste de preço para a API DeepSeek é "épico", com a parte de acerto de cache da API com preço de US$ 0,10/milhão de tokens e a parte de acerto com US$ 1/milhão de tokens. O preço de um acerto de cache é de apenas US$ 0,1 por milhão de tokens, e o preço de um erro é de apenas US$ 1 por milhão de tokens, o que é uma ordem de magnitude menor do que o preço anterior para um acerto de cache.

De acordo com os dados oficiais do DeepSeek, ele pode economizar até 90% e, mesmo sem nenhuma otimização, os usuários podem economizar mais de 50% em geral. Essa vantagem de custo é de grande importância para reduzir o limite de aplicação de modelos grandes e acelerar a popularidade dos modelos grandes.

O que é mais interessante é a estratégia de preços do DeepSeek. O preço dos acertos e erros do cache é escalonado para incentivar os usuários a usar o cache o máximo possível, otimizar o design do Prompt e aumentar a taxa de acerto do cache, reduzindo assim ainda mais o custo. Ao mesmo tempo, nem o próprio serviço de cache nem o espaço de armazenamento do cache cobram taxas extras, o que é realmente fácil de usar.

Crédito da imagem: Documentação oficial do DeepSeek

O preço da API do DeepSeek foi reduzido significativamente, com acessos ao cache custando apenas US$ 0,1/milhão de tokens.

A redução significativa de preços da DeepSeek API, sem dúvida, acelerará a evolução da guerra de preços dos grandes modelos. No entanto, ao contrário da simples concorrência de preços anterior, a redução de preços da DeepSeek é uma redução de preços racional baseada na inovação tecnológica e na otimização de custos, que é mais sustentável e orientada para o setor. Essa concorrência saudável de preços acabará beneficiando todo o ecossistema de modelos grandes, de modo que mais desenvolvedores e empresas possam aproveitar a tecnologia avançada de modelos grandes a um custo menor.

Fluxo e simultaneidade ilimitados, serviços de cache seguros e confiáveis

Além das vantagens de desempenho e preço, a estabilidade e a segurança do DeepSeek API também são confiáveis. O serviço DeepSeek API foi projetado de acordo com a capacidade de 1 trilhão de tokens por dia, com streaming e concorrência ilimitados para todos os usuários, o que garante a qualidade do serviço em condições de alta carga.

O DeepSeek também levou em consideração a segurança dos dados. O cache de cada usuário é separado e logicamente isolado um do outro, garantindo a segurança e a privacidade dos dados do usuário. Os caches que não forem usados por um longo período serão esvaziados automaticamente (geralmente de algumas horas a alguns dias) e não serão mantidos por um longo período ou usados para outros fins, reduzindo ainda mais os possíveis riscos de segurança.

Deve-se observar que o sistema de cache usa 64 tokens como unidade de armazenamento, e qualquer coisa com menos de 64 tokens não será armazenada em cache. Além disso, o sistema de cache é o "melhor esforço" e não garante 100% de acessos ao cache. Além disso, a construção do cache leva segundos, mas para cenários de contexto longo, isso é perfeitamente aceitável.

Atualização do modelo e perspectiva futura

Vale a pena mencionar que, juntamente com o lançamento da tecnologia de cache de disco rígido, o DeepSeek também anunciou que o modelo deepseek-chat foi atualizado para o DeepSeek-V3, e o modelo deepseek-reasoner é o novo modelo DeepSeek-R1. Os novos modelos oferecem desempenho e recursos aprimorados a um preço significativamente mais baixo, aumentando ainda mais a competitividade da API do DeepSeek. a competitividade da API do DeepSeek.

De acordo com as informações oficiais de preços, a API DeepSeek-V3 (deepseek-chat) desfruta de um preço com desconto até as 24:00 de 8 de fevereiro de 2025, com um preço de apenas US$ 0,1/milhão de tokens para acertos em cache, US$ 1/milhão de tokens para entradas perdidas e US$ 2/milhões de tokens para saídas. A API DeepSeek-R1 (deepseek-reasoner) está posicionada como um modelo de inferência com um comprimento de cadeia de pensamento de 32K e comprimento máximo de saída de 8K, com um preço de entrada (acertos em cache) de US$ 1/milhão de tokens. A API DeepSeek-R1 (deepseek-reasoner) é posicionada como um modelo de inferência com comprimentos de cadeia de pensamento de 32K e comprimentos máximos de saída de 8K, com um preço de entrada de US$ 1/milhão de tokens para acertos em cache, US$ 4/milhão de tokens para entradas perdidas e US$ 16/milhão de tokens para saídas (todos os tokens para a cadeia de pensamento e a resposta final). e todos os tokens da resposta final).

A série de iniciativas inovadoras da DeepSeek demonstra seu investimento contínuo em tecnologia e sua filosofia de colocar o usuário em primeiro lugar. Temos motivos para acreditar que, com o DeepSeek e mais forças inovadoras, a tecnologia de modelos grandes acelerará sua maturidade, se tornará mais inclusiva e trará mudanças mais abrangentes para vários setores.

observações finais

O uso inovador da tecnologia de cache de disco rígido e a redução significativa de preço da DeepSeek API é um avanço histórico. A etapa da DeepSeek pode redefinir o padrão de concorrência das APIs de grandes modelos, acelerar a popularidade e a aplicação da tecnologia de IA e, por fim, criar um ecossistema de grandes modelos mais próspero, aberto e inclusivo.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...