CogVLM2: modelo multimodal de código aberto para apoiar a compreensão de vídeos e várias rodadas de diálogo

Introdução geral

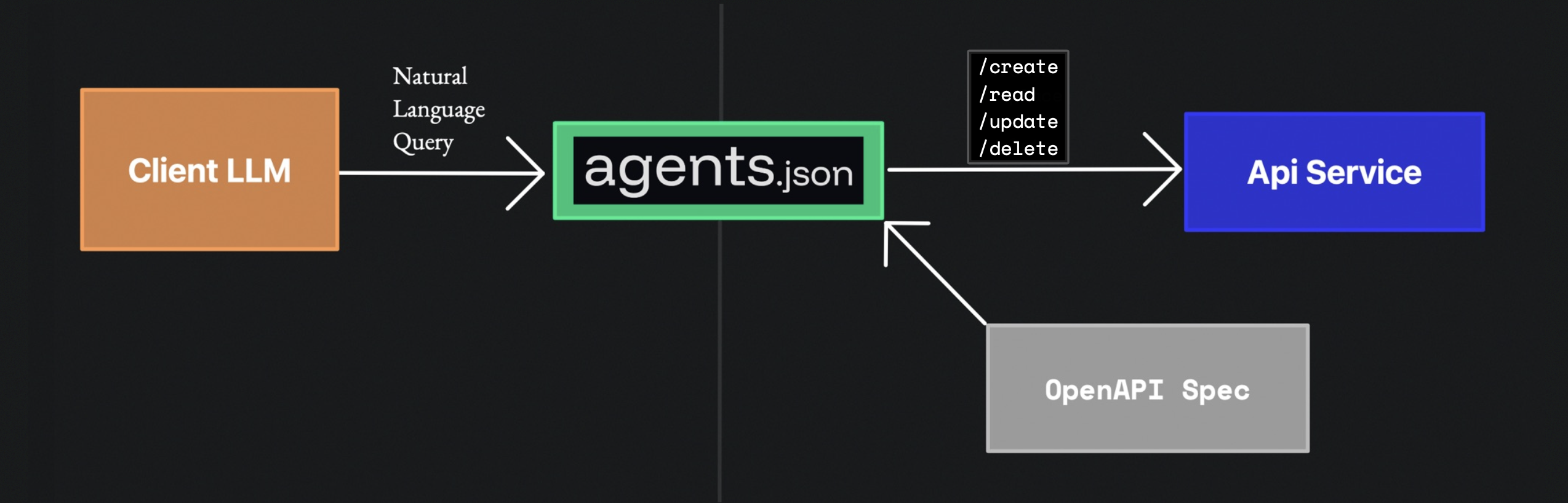

O CogVLM2 é um modelo multimodal de código aberto desenvolvido pelo Grupo de Pesquisa em Mineração de Dados da Universidade de Tsinghua (THUDM), baseado na arquitetura Llama3-8B e projetado para oferecer desempenho comparável ou até melhor que o GPT-4V. O modelo oferece suporte à compreensão de imagens, ao diálogo em várias rodadas e à compreensão de vídeos, além de ser capaz de processar conteúdo de até 8K e suportar resoluções de imagem de até 1344x1344. A família CogVLM2 consiste em vários submodelos otimizados para diferentes tarefas, como perguntas e respostas sobre texto, perguntas e respostas sobre documentos e perguntas e respostas sobre vídeos. Os modelos não são apenas bilíngues, mas também oferecem uma variedade de experiências on-line e métodos de implementação para os usuários testarem e aplicarem.

Informações relacionadas:Por quanto tempo um modelo grande consegue entender um vídeo? Smart Spectrum GLM-4V-Plus: 2 horas

Lista de funções

- compreensão gráficaSuporte para a compreensão e o processamento de imagens de alta resolução.

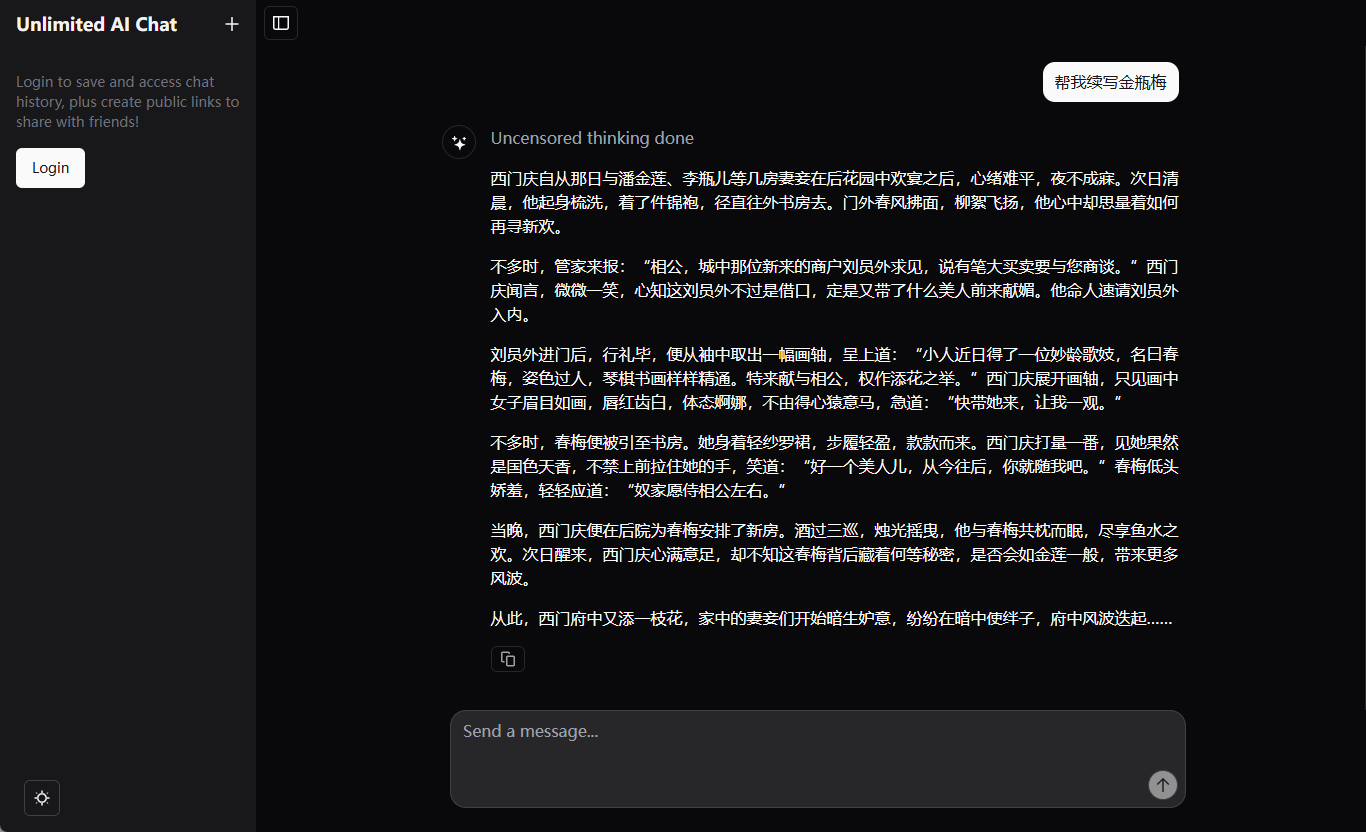

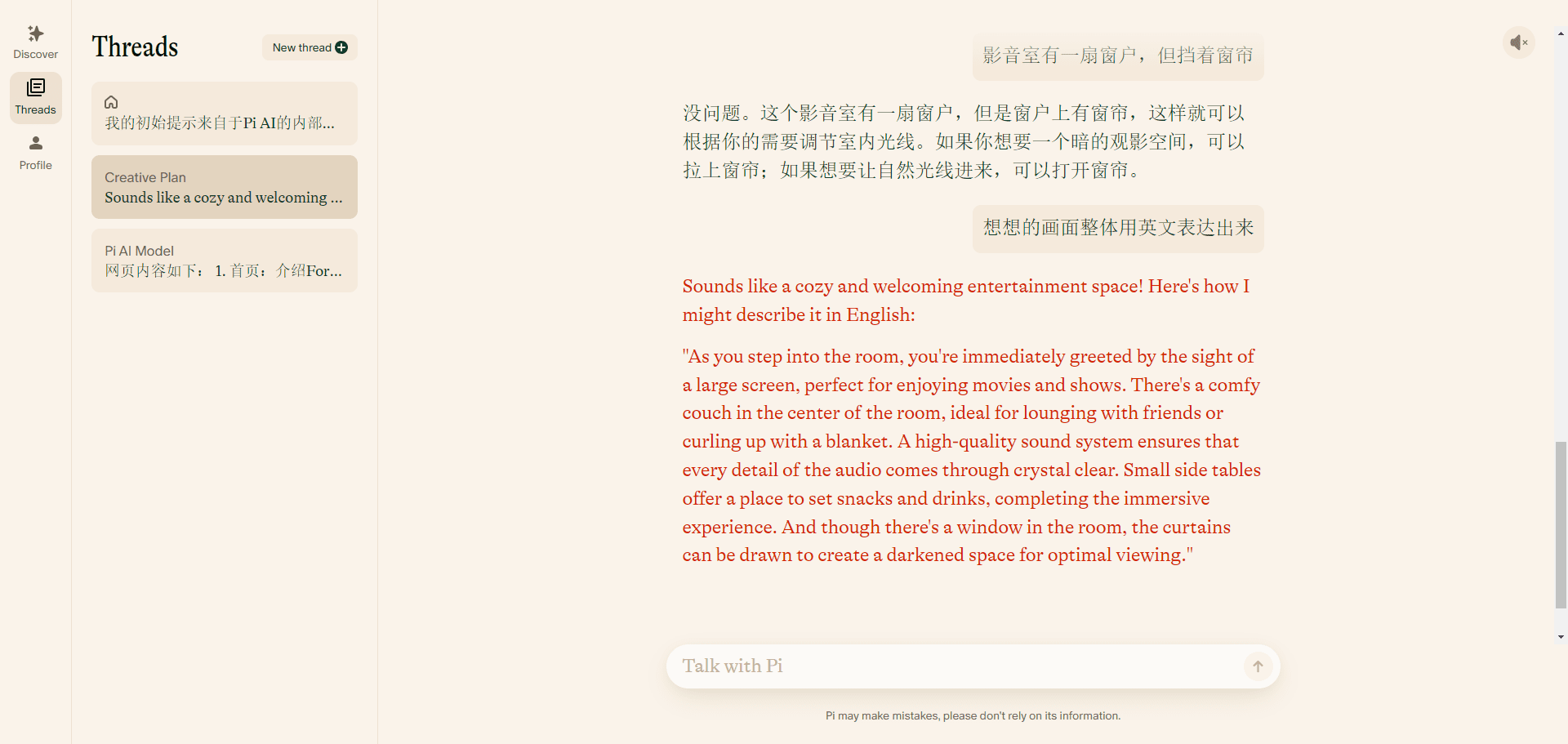

- diálogo em várias camadasCapacidade de várias rodadas de diálogo, adequada para cenários de interação complexos.

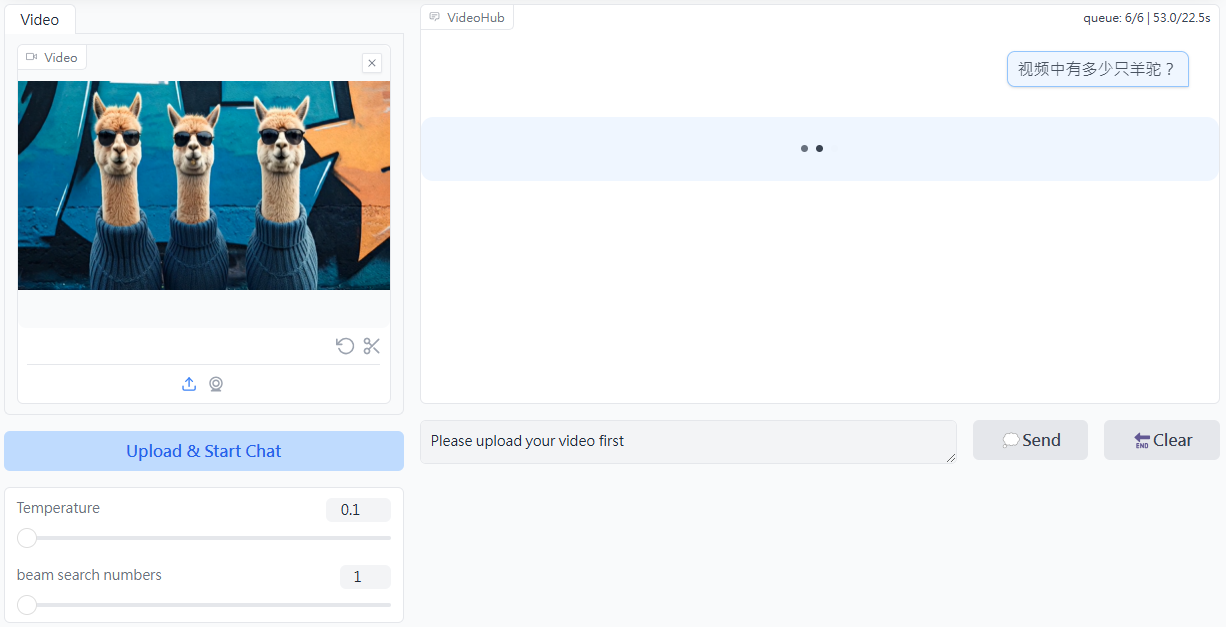

- Compreensão de vídeoSuporte à compreensão de conteúdo de vídeo de até 1 minuto de duração por meio da extração de quadros-chave.

- Suporte a vários idiomasSuporte ao bilinguismo em chinês e inglês para adaptação a diferentes ambientes linguísticos.

- código aberto (computação)Código-fonte completo e pesos do modelo são fornecidos para facilitar o desenvolvimento secundário.

- Experiência on-lineOferece uma plataforma de demonstração on-line em que os usuários podem experimentar diretamente a funcionalidade do modelo.

- Várias opções de implementaçãoSuporte a Huggingface, ModelScope e outras plataformas.

Usando a Ajuda

Instalação e implementação

- armazém de clones::

git clone https://github.com/THUDM/CogVLM2.git

cd CogVLM2

- Instalação de dependências::

pip install -r requirements.txt

- Download dos pesos do modeloDownload: Faça o download dos pesos de modelo apropriados, conforme necessário, e coloque-os no diretório especificado.

exemplo de uso

compreensão gráfica

- Modelos de carregamento::

from cogvlm2 import CogVLM2

model = CogVLM2.load('path_to_model_weights')

- processar imagem::

image = load_image('path_to_image')

result = model.predict(image)

print(result)

diálogo em várias camadas

- Inicialização do diálogo::

conversation = model.start_conversation()

- manter um diálogo::

response = conversation.ask('你的问题')

print(response)

Compreensão de vídeo

- Carregar vídeo::

video = load_video('path_to_video')

result = model.predict(video)

print(result)

Experiência on-line

Os usuários podem acessar a plataforma de demonstração on-line do CogVLM2 para experimentar a funcionalidade do modelo on-line sem implementação local.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...