CogView4: um modelo gráfico de código aberto para gerar imagens bilíngues de alta definição em chinês e inglês

Introdução geral

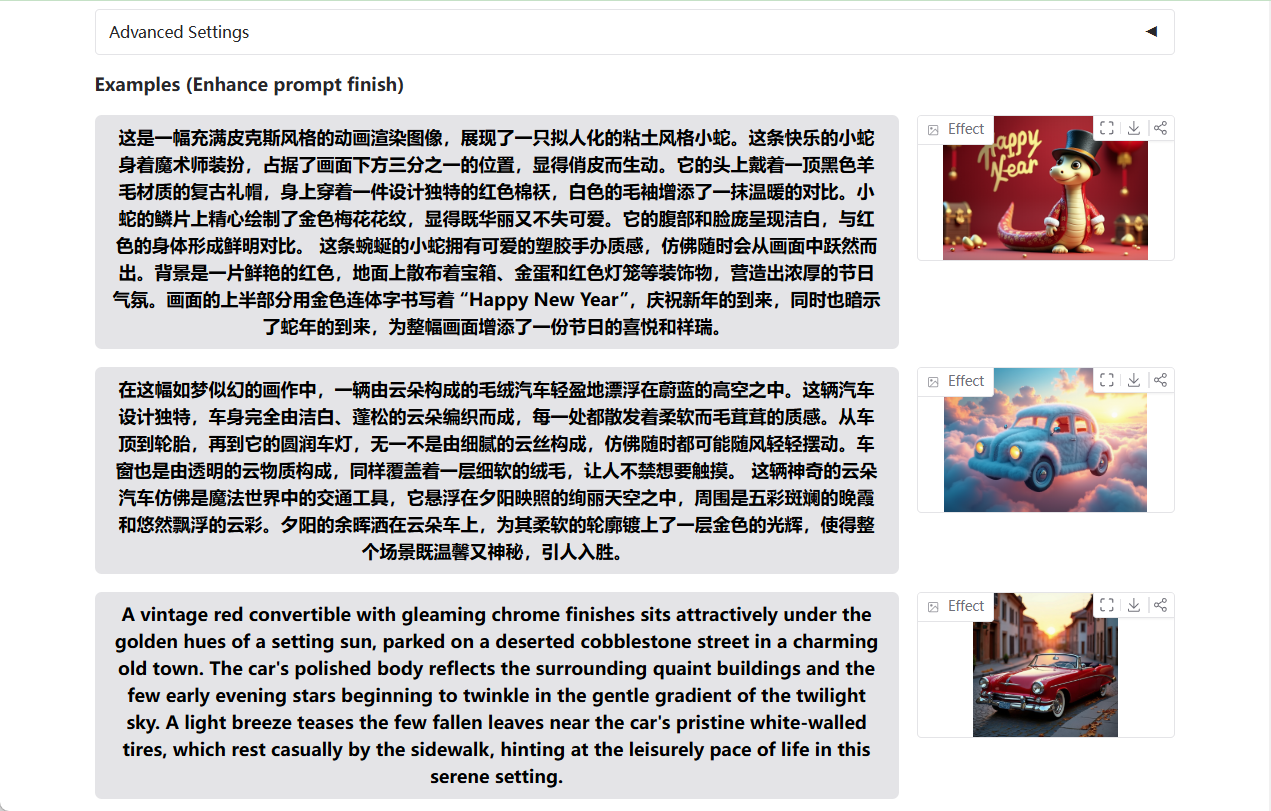

O CogView4 é um modelo de texto para gráfico de código aberto desenvolvido pelo KEG Lab (THUDM) da Universidade de Tsinghua, com foco na conversão de descrições de texto em imagens de alta qualidade. Ele oferece suporte à entrada de dicas bilíngues e é especialmente bom para entender dicas chinesas e gerar imagens com caracteres chineses, o que é ideal para design de anúncios, criação de vídeos curtos e outros cenários. Como o primeiro modelo de código aberto a suportar a geração de caracteres chineses na tela, o CogView4 se destaca no alinhamento semântico complexo e no seguimento de comandos. Ele se baseia no codificador de texto GLM-4-9B, suporta a entrada de palavras prontas de qualquer comprimento e pode gerar imagens com resolução de até 2048. O projeto está hospedado no GitHub, com código e documentação detalhados, e atraiu muita atenção e participação de desenvolvedores e criadores.

O modelo mais recente do CogView4 será lançado em 13 de março discurso intelectualmente estimulante Site oficial.

Experiência on-line: https://huggingface.co/spaces/THUDM-HF-SPACE/CogView4

Lista de funções

- Imagens bilíngues de geração de palavras-chaveEle é compatível com descrições em chinês e inglês e pode compreender e gerar com precisão imagens que correspondam às dicas, sendo que as cenas chinesas apresentam um desempenho particularmente bom.

- Geração de caracteres chineses na telaGeração de texto chinês claro em imagens, adequado para a criação de pôsteres, anúncios e outros trabalhos criativos que exigem conteúdo de texto.

- Saída de resolução arbitráriaA empresa oferece suporte à geração de imagens de qualquer tamanho, desde baixa resolução até 2048x2048, para atender a uma ampla variedade de necessidades.

- Suporte a palavras-chave extralongasO sistema aceita entrada de texto de qualquer tamanho e pode manipular até 1024 tokens, facilitando a descrição de cenários complexos.

- Alinhamento semântico complexoCaptura com precisão os detalhes das palavras selecionadas e gera imagens de alta qualidade que correspondem à semântica.

- Personalização de modelos de código abertoCódigo completo e modelos pré-treinados são fornecidos, e os desenvolvedores podem desenvolvê-los ou otimizá-los de acordo com suas necessidades.

Usando a Ajuda

Processo de instalação

O CogView4 é um projeto de código aberto baseado em Python que requer um ambiente configurado localmente para ser executado. Veja a seguir as etapas detalhadas de instalação:

1. preparação ambiental

- sistema operacionalWindows, Linux ou macOS são compatíveis.

- Requisitos de hardwareGPUs NVIDIA (pelo menos 16 GB de memória de vídeo) são recomendadas para acelerar a inferência; as CPUs também podem ser executadas, mas são mais lentas.

- dependência de software::

- Python 3.8 ou superior

- PyTorch (recomenda-se instalar a versão da GPU, torch>=2.0)

- Git (para clonagem de repositórios)

2. clonagem de armazéns

Abra um terminal e digite o seguinte comando para fazer o download do código-fonte do projeto CogView4:

git clone https://github.com/THUDM/CogView4.git

cd CogView4

3. instalação de dependências

O projeto fornece o arquivo requirements.txt. Execute o seguinte comando para instalar as bibliotecas necessárias:

pip install -r requirements.txt

Para a aceleração de GPU, certifique-se de instalar a versão correta do PyTorch consultando o site oficial do PyTorch para obter os comandos de instalação, por exemplo:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu118

4. download de modelos pré-treinados

O modelo CogView4-6B precisa ser baixado manualmente do Hugging Face ou do link oficial. Visite a página do GitHub do THUDM para encontrar o endereço de download do modelo (por exemplo THUDM/CogView4-6B), extraia-o para o diretório raiz do projeto no diretório checkpoints pasta. Ou faça o download automaticamente por código:

from diffusers import CogView4Pipeline

pipe = CogView4Pipeline.from_pretrained("THUDM/CogView4-6B")

5. ambiente de configuração

Se a memória de vídeo for limitada, ative as opções de otimização de memória (por exemplo enable_model_cpu_offload), conforme descrito nas instruções de uso abaixo.

Como usar o CogView4

Após a instalação, os usuários podem chamar o CogView4 para gerar imagens por meio de um script Python. Veja a seguir o procedimento detalhado:

1. geração de imagens básicas

Crie um arquivo Python (por exemplo generate.py), digite o seguinte código:

from diffusers import CogView4Pipeline

import torch

# 加载模型到 GPU

pipe = CogView4Pipeline.from_pretrained("THUDM/CogView4-6B", torch_dtype=torch.bfloat16).to("cuda")

# 优化显存使用

pipe.enable_model_cpu_offload() # 将部分计算移至 CPU

pipe.vae.enable_slicing() # 分片处理 VAE

pipe.vae.enable_tiling() # 分块处理 VAE

# 输入提示词

prompt = "一辆红色跑车停在阳光下的海边公路,背景是蔚蓝的海浪"

image = pipe(

prompt=prompt,

guidance_scale=3.5, # 控制生成图像与提示的贴合度

num_images_per_prompt=1, # 生成一张图像

num_inference_steps=50, # 推理步数,影响质量

width=1024, # 图像宽度

height=1024 # 图像高度

).images[0]

# 保存图像

image.save("output.png")

Execute o script:

python generate.py

O resultado gerará uma imagem de 1024x1024 e a salvará como um arquivo output.png.

2. geração de imagens com caracteres chineses

O CogView4 suporta a geração de texto em chinês em imagens, por exemplo:

prompt = "一张写有‘欢迎体验 CogView4’的广告海报,背景是蓝天白云"

image = pipe(prompt=prompt, width=1024, height=1024).images[0]

image.save("poster.png")

Após a execução, as palavras "Welcome to CogView4" serão claramente exibidas na imagem, o que é adequado para a produção de materiais promocionais.

3. ajuste da resolução

O CogView4 suporta saída em qualquer resolução, por exemplo, gerando imagens de 2048x2048:

image = pipe(prompt=prompt, width=2048, height=2048).images[0]

image.save("high_res.png")

Observação: Resoluções mais altas exigem mais memória de vídeo e recomenda-se uma GPU com 24 GB ou mais de memória de vídeo.

4. lidar com sinais muito longos

O CogView4 pode lidar com descrições complexas, como:

prompt = "一个热闹的古代中国集市,摊位上摆满陶瓷和丝绸,远处有山峦和夕阳,人们穿着传统汉服在购物"

image = pipe(prompt=prompt, num_inference_steps=50).images[0]

image.save("market.png")

Suporta até 1024 tokens, analisa totalmente textos longos e gera imagens detalhadas.

5. otimização do desempenho

Se a memória de vídeo for insuficiente, ajuste os parâmetros:

- inferior

torch_dtypepor causa detorch.float16 - crescente

num_inference_stepspara melhorar a qualidade (padrão 50, recomendado 50-100) - fazer uso de

pipe.enable_model_cpu_offload()Mover alguns modelos para a computação da CPU

Funções em destaque

Gerar imagens bilíngues

O suporte bilíngue do CogView4 é o seu maior atrativo. Por exemplo, insira palavras de dicas mistas:

prompt = "A futuristic city with neon lights and flying cars, 写着‘未来之城’的标志"

image = pipe(prompt=prompt).images[0]

image.save("future_city.png")

A imagem resultante conterá a descrição em inglês da cidade do futuro e o logotipo chinês "Future City", demonstrando uma forte compreensão semântica.

Controle de detalhes de alta qualidade

Por meio de ajustes guidance_scale(intervalo de 1 a 10, padrão 3,5), que controla a adequação da imagem à pista. Quanto mais alto o valor, mais o detalhe se ajusta à sugestão, mas pode sacrificar a criatividade:

image = pipe(prompt=prompt, guidance_scale=7.0).images[0]

Geração de lotes

Gerar várias imagens de uma só vez:

images = pipe(prompt=prompt, num_images_per_prompt=3).images

for i, img in enumerate(images):

img.save(f"output_{i}.png")

advertência

- Requisitos de memória VGAMemória de vídeo: São necessários aproximadamente 16 GB de memória de vídeo para gerar imagens de 1024 x 1024 e mais de 24 GB para 2048 x 2048.

- tempo de inferência: 50 etapas de raciocínio levam cerca de 1 a 2 minutos (dependendo do hardware).

- Suporte à comunidadeSe você tiver problemas, peça ajuda na página de problemas do GitHub ou consulte o LEIAME oficial.

Com essas etapas, os usuários podem começar a usar o CogView4 rapidamente, gerar imagens de alta qualidade e aplicá-las em projetos criativos!

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...