CAG: um método de geração aprimorado por cache que é 40 vezes mais rápido que o RAG

O CAG (Cache Augmented Generation), que é 40 vezes mais rápido que o RAG (Retrieval Augmented Generation), revoluciona a aquisição de conhecimento: em vez de recuperar dados externos em tempo real, todo o conhecimento é pré-carregado no contexto do modelo. É como condensar uma enorme biblioteca em um kit de ferramentas que você pode consultar quando precisar, e a implementação do CAG é elegante:

- O documento é primeiro pré-processado para garantir que ele se encaixe na janela de contexto do LLM

- O conteúdo processado é então codificado no cache Key-Value

- Por fim, esse cache é armazenado na memória ou no disco rígido para ser recuperado a qualquer momento

Os resultados são convincentes: em conjuntos de dados de referência, como HotPotQA e SQuAD, o CAG não é apenas 40 vezes mais rápido, mas também significativamente mais preciso e coerente. Isso se deve à sua capacidade de capturar o contexto globalmente, sem problemas de erros de recuperação ou dados incompletos.

Em termos de aplicações práticas, essa tecnologia é promissora em áreas como diagnóstico médico, análise financeira e atendimento ao cliente. Ela permite que os sistemas de IA mantenham um alto desempenho e, ao mesmo tempo, evitem a carga de manutenção de arquiteturas complexas.

No final das contas, a inovação do CAG é que ele transforma o "leve-o-que-você-quiser" em "leve-o-que-você-quiser", o que não apenas melhora a eficiência, mas também abre novas possibilidades para a implementação de IA. Esse pode ser o padrão para a próxima geração de arquiteturas de IA.

Referências:

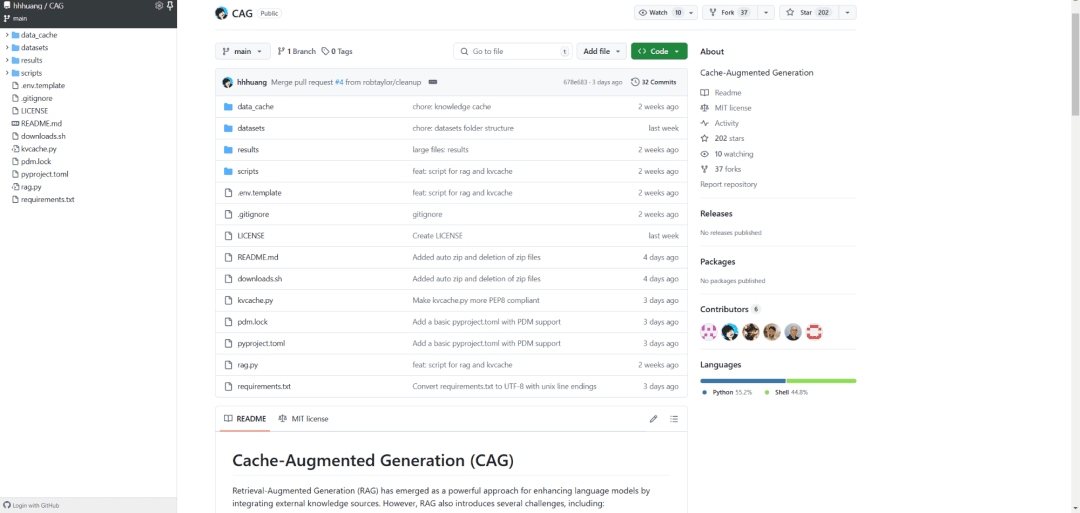

[1] https://github.com/hhhuang/CAG

[2] https://arxiv.org/abs/2412.15605

[3] LLMs de contexto longo enfrentam dificuldades com o aprendizado longo no contexto: https://arxiv.org/pdf/2404.02060v2

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...