Infelizmente, o relatório técnico do Kimi k1.5 lançado junto com o DeepSeek-R1 melhora o contexto longo e a inferência multimodal

Relatório técnico do Kimi k1.5 Leituras rápidas

1. raciocínio multimodal avançado:

Kimi O modelo k1.5 atinge o desempenho de inferência de última geração em vários benchmarks e modalidades, incluindo tarefas de inferência matemática, de código, textual e visual.

Ele não só lida com texto simples, mas também entende combinações de imagens e texto, permitindo um verdadeiro raciocínio multimodal.

Tanto a versão com CoT longo quanto a versão com CoT curto demonstram um bom desempenho.

A liderança foi alcançada em conjuntos de dados como AIME, MATH 500, Codeforces e outros.

Ele também tem um bom desempenho em benchmarks visuais, como o MathVista.

2. avanços no treinamento de RL de contexto longo:

Ao expandir a janela de contexto para 128k, o desempenho do modelo continua a melhorar, verificando que o comprimento do contexto é uma dimensão fundamental para o dimensionamento do aprendizado por reforço.

- Uma técnica de implementação parcial é usada para melhorar significativamente a eficiência do treinamento de RL de contexto longo, possibilitando o treinamento de processos de inferência mais longos e mais complexos.

- Foi demonstrado que os contextos longos são essenciais para a resolução de problemas complexos.

3. métodos long2short válidos:

- Propõe-se um método long2short eficaz para aproveitar o conhecimento dos modelos de contexto longo para melhorar o desempenho dos modelos de contexto curto e aprimorar o Token Eficiência.

- O aprimoramento do desempenho de modelos curtos é obtido por meio de técnicas como fusão de modelos, amostragem de rejeição mais curta e DPO, e é mais eficiente do que treinar modelos curtos diretamente.

É demonstrado que o desempenho dos modelos curtos pode ser aprimorado com a migração do conhecimento prévio do raciocínio dos modelos de CoT longos.

4. estrutura de treinamento de RL otimizada:

Métodos aprimorados de otimização de políticas são propostos para obter um desempenho robusto sem depender de técnicas complexas.

Várias estratégias de amostragem, penalidades de comprimento e otimização da receita de dados são exploradas para melhorar a eficiência e a eficácia do treinamento de RL.

A eficácia da metodologia e das técnicas de treinamento propostas foi verificada por meio de estudos de ablação.

5. processo de treinamento detalhado e projeto de sistema:

- Uma receita de treinamento detalhada para o Kimi k1.5 foi divulgada, incluindo as fases de pré-treinamento, ajuste fino e aprendizado intensivo.

- São apresentadas estratégias de implantação híbrida para otimizar a utilização de recursos durante o treinamento e a inferência.

- O pipeline de dados e os mecanismos de controle de qualidade para garantir a qualidade dos dados de treinamento são descritos em detalhes.

- Desenvolveu um sandbox de código seguro para execução e avaliação do código gerado.

6. exploração do tamanho do modelo e do comprimento do contexto:

O efeito do tamanho do modelo e do comprimento do contexto sobre o desempenho é investigado, e constatamos que os modelos maiores têm melhor desempenho, mas os modelos menores que usam contextos mais longos podem se aproximar ou até mesmo igualar o desempenho dos modelos maiores, demonstrando o aprimoramento do desempenho do modelo pelo treinamento em RL.

resumos

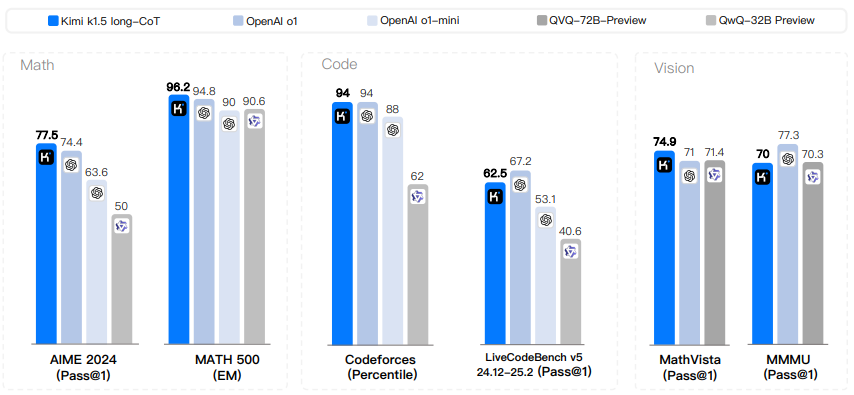

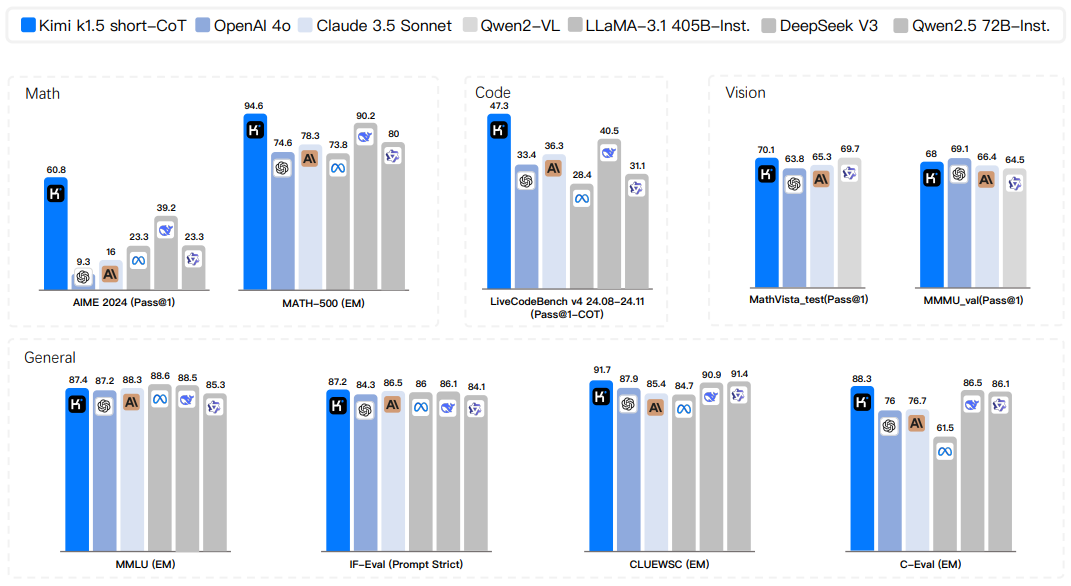

O pré-treinamento do modelo de linguagem usando previsões do próximo token demonstrou ser eficaz no dimensionamento computacional, mas é limitado pela quantidade de dados de treinamento disponíveis. O aprendizado por reforço estendido (RL) abre uma nova dimensão para o aprimoramento contínuo da IA, prometendo dimensionar os dados de treinamento para modelos de idiomas grandes (LLMs), aprendendo a explorar recompensas. No entanto, os trabalhos publicados anteriormente não produziram resultados competitivos. Em vista disso, relatamos as práticas de treinamento do Kimi k1.5, nosso mais recente LLM multimodal treinado usando RL, incluindo suas técnicas de treinamento de RL, formulação de dados multimodais e otimizações de infraestrutura. A extensão de contexto longo e os métodos aprimorados de otimização de políticas são elementos-chave de nossa abordagem, que estabelece uma estrutura de RL simples e eficaz sem depender de técnicas mais complexas, como a pesquisa em árvore de Monte Carlo, funções de valor e modelos de recompensa de processo. Notavelmente, nosso sistema atinge o desempenho de inferência de última geração em vários benchmarks e modalidades - por exemplo, 77,5 no AIME, 96,2 no MATH 500, 94º percentil no Codeforces, MathVista 74,9 no MathVista, correspondendo ao 01 do OpenAI. Além disso, apresentamos métodos long2short eficazes que usam técnicas de CoT longas para aprimorar o modelo de CoT curto, produzindo resultados de inferência de CoT curto de última geração - por exemplo, 60,8 no AIME, 94,6 no MATH500, 47,9 no LiveCodeBench e 47,3 no LiveCodeBench, superando significativamente os modelos de CoT curta existentes, como GPT-40 e Claude Sonnet 3.5 (até +550%).

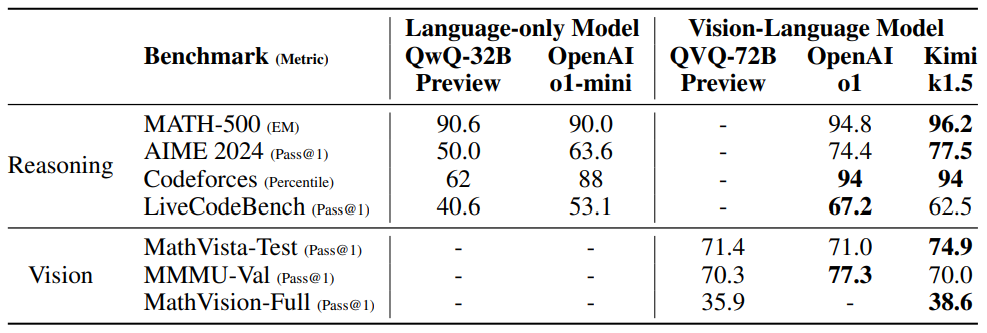

Figura 1: Resultados do Kimi k1.5 long-CoT.

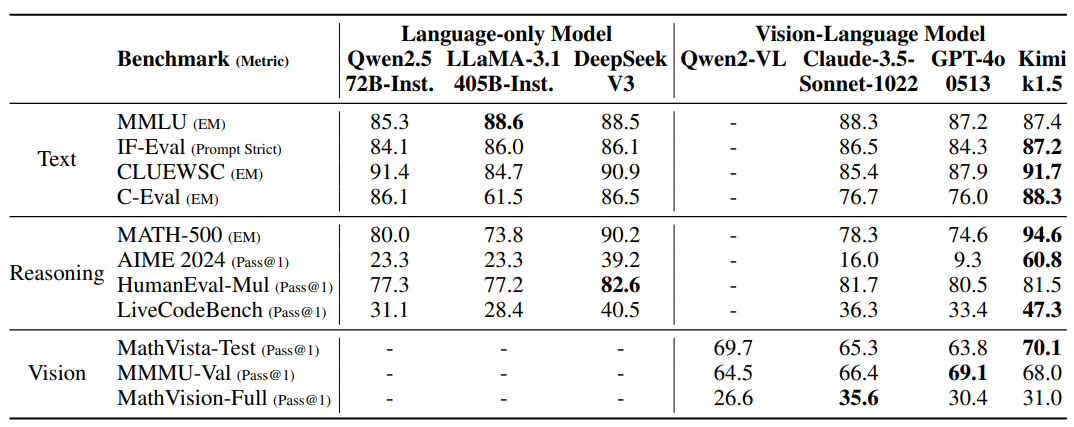

Figura 2: Resultados do Kimi k1.5 short-CoT.

1 Introdução

O pré-treinamento de modelos de linguagem usando a previsão do próximo token foi investigado no contexto do lema da expansão, em que o dimensionamento dos parâmetros do modelo e dos tamanhos dos dados leva a melhorias contínuas na inteligência. (Kaplan et al. 2020; Hoffmann et al. 2022) Entretanto, essa abordagem é limitada pela quantidade de dados de treinamento de alta qualidade disponíveis. (Villalobos et al. 2024; Muennighoff et al. 2023) Neste relatório, apresentamos a receita de treinamento para o Kimi k1.5, nosso mais recente LLM multimodal treinado usando o aprendizado por reforço (RL). Usando RL com LLM, o modelo aprende a explorar recompensas e, portanto, não se limita a conjuntos de dados estáticos pré-existentes.

Há vários elementos-chave relacionados ao design e ao treinamento do k1.5.

- extensão de contexto longoA janela de contexto da RL foi ampliada para 128k e observamos melhorias contínuas no desempenho à medida que o comprimento do contexto aumentava. Uma ideia importante por trás de nossa abordagem é usar a distribuição parcial para melhorar a eficiência do treinamento, ou seja, evitar o custo de gerar novamente novas trajetórias do zero, reutilizando grandes partes de trajetórias anteriores para obter amostras de novas trajetórias. Nossas observações sugerem que o comprimento do contexto é uma dimensão fundamental para o dimensionamento contínuo da RL no LLM.

- Otimização aprimorada da estratégiaDescrição: Derivamos a formulação de RL com CoT longo e usamos uma variante de descida de espelho on-line para otimização robusta da estratégia. O algoritmo é aprimorado ainda mais por nossa estratégia de amostragem eficiente, penalidade de comprimento e otimização da formulação de dados.

- Estrutura simplificadaConclusão: A combinação de extensões de contexto longo e métodos aprimorados de otimização de políticas cria uma estrutura de RL simplificada para aprendizado usando LLM. Como podemos estender o comprimento do contexto, a CoT aprendida apresenta propriedades de planejamento, reflexão e correção. O aumento do comprimento do contexto aumenta o número de etapas de pesquisa. Como resultado, mostramos que é possível obter um desempenho robusto sem depender de técnicas mais sofisticadas (por exemplo, pesquisa em árvore de Monte Carlo, funções de valor e modelos de recompensa de processo).

- multimodalNosso modelo é treinado em conjunto usando dados textuais e visuais, o que lhe dá a capacidade de raciocinar em conjunto sobre ambas as modalidades.

Além disso, propomos uma abordagem long2short eficaz que usa técnicas de CoT longa para aprimorar modelos de CoT curta. Especificamente, nossa abordagem consiste em aplicar uma penalidade de comprimento com ativação de CoT longa e fusão de modelos.

Nossa versão do long-CoT alcança o desempenho de inferência de última geração em vários benchmarks e modalidades - por exemplo, 77,5 no AIME, 96,2 no MATH 500, 94º percentil no Codeforces, 74,9 no MathVista, correspondendo ao OpenAI 01. 74,9 no MathVista, compatível com o OpenAI 01. Nosso modelo também alcança resultados de inferência de Short-CoT de última geração - por exemplo, 60,8 no AIME, 94,6 no MATH500 e 47,3 no LiveCodeBench - que superam substancialmente os modelos de Short-CoT existentes, como GPT-40 e Claude Sonnet 3.5 (até +550%). Os resultados são mostrados nas Figuras 1 e 2.

2 Método: Aprendizado por reforço usando LLM

O desenvolvimento do Kimi k1.5 consistiu em várias fases: pré-treinamento, ajuste fino supervisionado (SFT) do vanilla, ajuste fino supervisionado do long-CoT e aprendizado por reforço (RL). Este relatório se concentra na RL, começando com uma visão geral do gerenciamento do conjunto de dicas da RL (Seção 2.1) e do ajuste fino supervisionado de longo prazo da CoT (Seção 2.2), seguido de uma discussão aprofundada das estratégias de treinamento da RL na Seção 2.3. Informações mais detalhadas sobre o pré-treinamento e o ajuste fino supervisionado da vanilla podem ser encontradas na Seção 2.5.

2.1 Gerenciamento do conjunto de pistas de RL

Por meio de nossos experimentos preliminares, descobrimos que a qualidade e a diversidade dos conjuntos de dicas de RL desempenham um papel fundamental para garantir a eficácia do aprendizado por reforço. Conjuntos de dicas cuidadosamente construídos não apenas orientam o modelo para uma inferência robusta, mas também reduzem o risco de ataques de recompensa e padrões superficiais de ajuste excessivo. Especificamente, três propriedades fundamentais definem conjuntos de dicas de RL de alta qualidade:

- Cobertura diversificadaDicas: As dicas devem abranger várias disciplinas, como STEM, codificação e raciocínio geral, para aumentar a adaptabilidade do modelo e garantir sua ampla aplicabilidade em diferentes domínios.

- Dificuldade equilibrada: Os conjuntos de sugestões devem incluir problemas fáceis, médios e difíceis distribuídos de forma homogênea para promover o aprendizado incremental e evitar o ajuste excessivo a níveis de complexidade específicos.

- Capacidade de avaliação precisaDicas: As dicas devem permitir uma avaliação objetiva e confiável pelo validador para garantir que o desempenho do modelo seja medido com base em um raciocínio sólido e não em padrões superficiais ou suposições aleatórias.

Para obter uma cobertura diversificada no conjunto de dicas, usamos filtros automáticos para selecionar perguntas que exigem raciocínio rico e são fáceis de avaliar. Nosso conjunto de dados inclui perguntas de vários domínios, como domínios STEM, competições e tarefas de raciocínio geral, e contém dados de questionário de texto simples e de texto com imagem. Além disso, desenvolvemos um sistema de rotulagem para classificar os prompts por domínio e disciplina para garantir uma representação equilibrada de diferentes áreas temáticas (M. Li et al. 2023; W. Liu et al. 2023).

Usamos uma abordagem baseada em modelo que utiliza a própria capacidade do modelo para avaliar de forma adaptativa a dificuldade de cada solicitação. Especificamente, para cada solicitação, o modelo SFT gera dez respostas usando uma temperatura de amostragem relativamente alta. Em seguida, a taxa de aprovação é calculada e usada como um indicador da dificuldade da sugestão - quanto menor a taxa de aprovação, maior a dificuldade. Essa abordagem permite que a avaliação da dificuldade seja alinhada com os recursos intrínsecos do modelo, tornando-a muito eficaz no treinamento de RL. Ao utilizar essa abordagem, podemos pré-selecionar a maioria dos casos triviais e explorar facilmente diferentes estratégias de amostragem durante o treinamento de RL.

Para evitar possíveis ataques de recompensa (Everitt et al. 2021; Pan et al. 2022), precisamos garantir que possamos verificar com precisão o processo de raciocínio e a resposta final para cada pista. Observações empíricas mostraram que alguns problemas de raciocínio complexos podem ter respostas relativamente simples e fáceis de adivinhar, o que leva a uma validação direta espúria, em que o modelo chega à resposta correta por meio de um processo de raciocínio incorreto. Para resolver esse problema, excluímos perguntas propensas a esses erros, como perguntas de múltipla escolha, verdadeiro/falso e baseadas em provas. Além disso, para tarefas gerais de pergunta-resposta, propomos um método simples, porém eficaz, para identificar e remover dicas facilmente atacáveis. Especificamente, solicitamos ao modelo que adivinhe as possíveis respostas sem nenhuma etapa de inferência de CoT. Se o modelo prevê a resposta correta em N tentativas, a dica é considerada muito fácil de ser atacada e é removida. Descobrimos que a configuração N = 8 remove a maioria das dicas facilmente atacáveis. O desenvolvimento de modelos de verificação mais avançados continua sendo uma direção aberta para pesquisas futuras.

2.2 Ajuste fino supervisionado do Long-CoT

Com um conjunto de dicas de RL aprimorado, empregamos a engenharia de dicas para criar um conjunto de dados de aquecimento de CoT longo pequeno, mas de alta qualidade, contendo caminhos de inferência verificados com precisão para entradas de texto e imagem. Essa abordagem é semelhante à Rejection Sampling (RS), mas se concentra na geração de caminhos de inferência de CoT longos por meio da engenharia de dicas. O conjunto de dados de aquecimento resultante foi projetado para encapsular os principais processos cognitivos que são essenciais para o raciocínio humanoide, como planejamento (em que o modelo delineia sistematicamente as etapas de pré-execução); avaliação (que inclui avaliação crítica das etapas intermediárias); reflexão (que permite que o modelo reconsidere e melhore sua abordagem); e exploração (que incentiva a consideração de soluções alternativas). Ao executar um SFT leve nesse conjunto de dados de aquecimento, podemos orientar efetivamente o modelo para internalizar essas estratégias de inferência. Como resultado, o modelo de CoT longo ajustado apresenta uma capacidade aprimorada de gerar respostas mais detalhadas e logicamente coerentes, melhorando assim seu desempenho em uma variedade de tarefas de inferência.

2.3 Aprendizado aprimorado

2.3.1 Definição do problema

Dado um conjunto de dados de treinamento D = {(xi, yi)}^n_i=1, que contém a pergunta xi e a resposta verdadeira correspondente yi, nosso objetivo é treinar o modelo de estratégia πθ para resolver com precisão o problema de teste. Em um contexto de raciocínio complexo, o mapeamento do problema x para a solução y não é uma tarefa fácil. Para enfrentar esse desafio, a abordagem de cadeia de raciocínio (CoT) sugere o uso de uma série de etapas intermediárias z = (z1, z2, ... , zm) para fazer a ponte entre x e y, em que cada zi é uma sequência coerente de tokens que pode servir como uma etapa intermediária importante na solução de problemas (J. Wei et al., 2022). Na solução do problema x, a mente de amostragem autorregressiva zt ~ πθ(-|x, z1, ... , zt-1) e, em seguida, a amostragem da resposta final y ~ πθ(-|x, z1,... , zm). Usamos y, z ~ πθ para denotar esse processo de amostragem. Observe que tanto os pensamentos quanto as respostas finais são amostrados como sequências linguísticas.

Para aprimorar ainda mais os recursos de inferência do modelo, empregamos algoritmos de planejamento para explorar vários processos de pensamento para gerar CoTs aprimorados durante o raciocínio (Yao et al. 2024; Y. Wu et al. 2024; Snell et al. 2024). O insight central dessas abordagens é a construção explícita de árvores de busca de pensamento guiadas por estimativas de valor. Isso permite que o modelo explore várias continuações do processo de pensamento ou volte atrás para investigar novas direções quando encontrar um beco sem saída. Mais detalhadamente, deixe T ser uma árvore de pesquisa em que cada nó representa uma solução parcial s = (x, z1:|s|). Aqui s consiste no problema x e em uma sequência de pensamentos z1:|s| = (z1, ... , z|s|) que levam ao nó, em que |s| denota o número de pensamentos na sequência. O algoritmo de planejamento usa o modelo de crítica v para fornecer feedback v(x, z1:|s|), que ajuda a avaliar o progresso atual na solução do problema e a identificar quaisquer erros na solução parcial existente. Observamos que o feedback pode ser fornecido por pontuações discriminantes ou sequências linguísticas (L. Zhang et al. 2024). Orientado pelo feedback de todos os s ∈ T , o algoritmo de planejamento expande a árvore de pesquisa selecionando os nós com maior probabilidade de expansão. O processo acima é repetido iterativamente até que uma solução completa seja obtida.

Também podemos abordar os algoritmos de planejamento a partir de uma perspectiva algorítmica. Dado o histórico de pesquisa anterior disponível na tésima iteração (s1, v(s1), ... , st-1, v(st-1)), o algoritmo de planejamento A determina iterativamente a próxima direção de busca A(st|s1, v(s1), ... , st-1, v(st-1)) e fornece feedback sobre o progresso da pesquisa atual A(v(st)|s1, v(s1),... , st). , st) para fornecer feedback. Como tanto o pensamento quanto o feedback podem ser considerados etapas intermediárias de raciocínio e como esses componentes podem ser representados como sequências de tokens linguísticos, usamos z em vez de s e v para simplificar a representação. Assim, consideramos o algoritmo de planejamento como atuando diretamente em uma sequência de etapas de inferência A(-|z1, z2, ...). ) como um mapeamento de uma série de etapas de inferência A(-|z1, z2, . . . ). Nessa estrutura, todas as informações armazenadas na árvore de pesquisa usada pelo algoritmo de planejamento são distribuídas no contexto completo fornecido ao algoritmo. Isso oferece uma perspectiva interessante para gerar CoTs de alta qualidade: em vez de construir explicitamente a árvore de pesquisa e implementar o algoritmo de planejamento, podemos treinar um modelo para aproximar esse processo. Aqui, a quantidade de pensamento (ou seja, o token linguístico) é análoga ao orçamento computacional tradicionalmente alocado aos algoritmos de planejamento. Avanços recentes em janelas de contexto longas promovem a escalabilidade contínua durante as fases de treinamento e teste. Se for viável, essa abordagem permite que o modelo execute pesquisas implícitas diretamente no espaço de inferência por meio de previsões autorregressivas. Como resultado, o modelo não apenas aprende a resolver um conjunto de problemas de treinamento, mas também desenvolve a capacidade de resolver problemas individuais com eficiência, melhorando assim a generalização para problemas de teste não vistos.

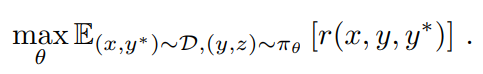

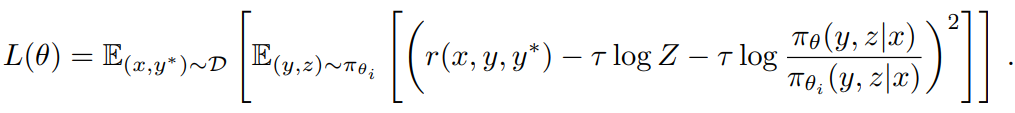

Portanto, consideramos modelos de treinamento para gerar CoTs usando o aprendizado por reforço (RL) (OpenAI 2024). Seja r um modelo de recompensa que fornece uma base para a correção da resposta y proposta para uma determinada pergunta x com base na resposta verdadeira y*, atribuindo um valor r(x, y, y*) ∈ {0, 1}. Para problemas verificáveis, a recompensa é determinada diretamente por critérios ou regras predefinidos. Por exemplo, em problemas de codificação, avaliamos se a resposta passa no caso de teste. Para perguntas com respostas verdadeiras de forma livre, treinamos o modelo de recompensa r(x, y, y*) para prever se a resposta corresponde à resposta verdadeira. Dada uma pergunta x, o modelo πθ gera o CoT e a resposta final por meio de um processo de amostragem z ~ πθ(-|x), y ~ πθ(-|x, z). A qualidade da CoT gerada depende do fato de ela poder produzir respostas finais corretas. Em resumo, consideramos os seguintes objetivos para otimizar a estratégia

Ao estender o treinamento de RL, pretendemos treinar um modelo que aproveite tanto a CoT simples baseada em dicas quanto a CoT aprimorada por planejamento. O modelo ainda faz uma amostragem autorregressiva das sequências linguísticas durante a inferência, evitando assim a paralelização complexa exigida pelos algoritmos de planejamento avançados durante a implantação. No entanto, uma diferença importante em relação às abordagens simples baseadas em dicas é que o modelo não deve apenas seguir uma série de etapas de inferência. Em vez disso, ele também deve aprender as principais habilidades de planejamento, incluindo a identificação de erros, o retrocesso e o aprimoramento da solução, utilizando todo o conjunto de pensamentos exploratórios como informações contextuais.

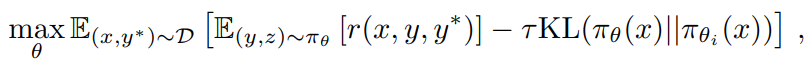

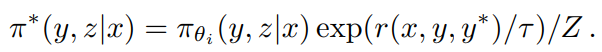

2.3.2 Otimização da estratégia

Aplicamos uma variante da estratégia on-line de descida de espelho como nosso algoritmo de treinamento (Abbasi-Yadkori et al. 2019; Mei et al. 2019; Tomar et al. 2020). O algoritmo é executado iterativamente. Na i-ésima iteração, usamos o modelo atual πθi como modelo de referência e otimizamos o seguinte problema de otimização de política de regularização de entropia relativa que

em que τ > 0 é um parâmetro que controla o grau de regularização. Esse objetivo tem uma solução de forma fechada

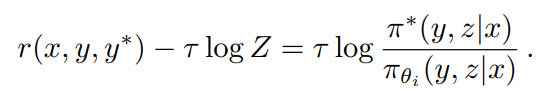

em que Z = Σy',z' πθi (y', z'|x) exp(r(x, y', y*)/τ) é o fator de normalização. Tomando o logaritmo de ambos os lados, obtemos que, para qualquer (y, z), as seguintes restrições são satisfeitas, o que nos permite explorar os dados da política off-line durante a otimização

Isso inspirou as seguintes perdas de reposição

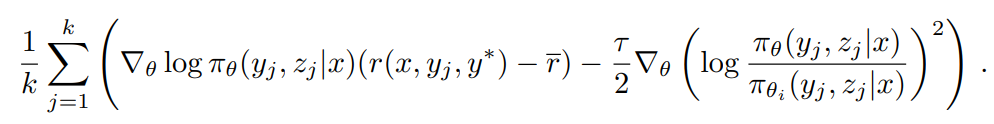

Para aproximar τ log Z, usamos as amostras (y1, z1), ... , (yk, zk) ~ πθ: τ log Z ≈ log 1/k Σ^k_j=1 exp(r(x, yj, y*)/τ). Também descobrimos que usar a média empírica da recompensa de amostragem τ = mean(r(x, y1, y*), ... , r(x, yk, y*)) produz resultados práticos válidos. Isso é razoável porque, à medida que τ → ∞, τ log Z se aproxima da recompensa esperada sob πθi . Por fim, derivamos nosso algoritmo de aprendizado usando o gradiente da perda de substituição. Para cada problema x, k respostas são amostradas usando a política de referência πθi , e o gradiente é dado por

Para aqueles que estão familiarizados com os métodos de gradiente de estratégia, esse gradiente é semelhante ao gradiente de estratégia de (2) que usa a média das recompensas amostradas como linha de base (Kool et al. 2019; Ahmadian et al. 2024). A principal diferença é que a resposta é amostrada de πθi em vez da estratégia on-line, e a regularização l2 é aplicada. Assim, podemos ver isso como uma extensão natural do algoritmo de gradiente de política regularizado on-line usual para o caso de política off-line (Nachum et al. 2017). Fazemos uma amostragem de um lote de problemas de D e atualizamos o parâmetro para θi+1 , que é usado posteriormente como a política de referência para a próxima iteração. Também redefinimos o otimizador no início de cada iteração, pois cada iteração considera um problema de otimização diferente devido à mudança na estratégia de referência.

Excluímos a rede de valores do sistema de treinamento, que também foi utilizada em um estudo anterior (Ahmadian et al. 2024). Embora essa escolha de projeto melhore significativamente a eficiência do treinamento, também levantamos a hipótese de que o uso tradicional de funções de valor para alocação de crédito na RL clássica pode não ser apropriado para o nosso contexto. Considere uma situação em que o modelo gera um CoT parcial (z1, z2, ... Suponhamos que zt+1 leve diretamente à resposta correta, enquanto z't+1 contenha alguns erros. Se a função de valor do oráculo fosse acessível, ela indicaria que zt+1 mantém um valor mais alto do que z't+1. De acordo com os princípios padrão de alocação de crédito, a escolha de z't+1 seria penalizada porque tem uma vantagem negativa sobre a estratégia atual. Entretanto, explorar z't+1 é valioso para treinar o modelo para gerar CoT longos. Ao usar a lógica da resposta final derivada da CoT longa como um sinal de recompensa, o modelo pode aprender com o padrão de tentativa e erro de adotar z't+1, desde que se recupere com sucesso e chegue à resposta correta. A principal conclusão a ser tirada desse exemplo é que devemos incentivar o modelo a explorar vários caminhos de raciocínio para aumentar sua capacidade de resolver problemas complexos. Essa abordagem exploratória gera uma grande quantidade de experiência que apoia o desenvolvimento de habilidades críticas de planejamento. Em vez de melhorar a precisão dos problemas de treinamento até o nível mais alto, nosso principal objetivo é concentrar-se em equipar o modelo com estratégias eficazes de solução de problemas, o que, em última análise, melhorará seu desempenho nos problemas de teste.

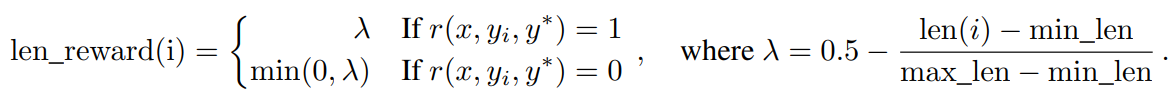

2.3.3 Penalidades de comprimento

Observamos um fenômeno de excesso de raciocínio em que o comprimento da resposta do modelo aumenta significativamente durante o treinamento de RL. Embora isso leve a um melhor desempenho, processos de raciocínio excessivamente longos são caros durante o treinamento e a inferência, e os seres humanos geralmente não gostam de pensar demais. Para resolver esse problema, introduzimos um bônus de comprimento para limitar o rápido crescimento do comprimento do Token e, assim, melhorar a eficiência do Token do modelo. Dadas k respostas amostradas (y1, z1) para o problema x, ... (yk, zk) e a resposta verdadeira y*, deixe len(i) ser o comprimento de (yi, zi), min_len = min_i len(i) e max_len = max_i len(i). Se max_len = min_len, definimos o bônus de comprimento como zero para todas as respostas, pois elas têm o mesmo comprimento. Caso contrário, o bônus de comprimento é dado por

Essencialmente, incentivamos respostas mais curtas e penalizamos respostas mais longas nas respostas corretas, enquanto penalizamos explicitamente respostas mais longas nas respostas incorretas. Essa recompensa baseada no comprimento com parâmetros de ponderação é então adicionada à recompensa original.

Em nossos experimentos preliminares, as penalidades de comprimento podem retardar a fase inicial do treinamento. Para atenuar esse problema, sugerimos o aquecimento gradual da penalidade de comprimento na fase inicial do treinamento. Especificamente, otimizamos com a estratégia padrão sem uma penalidade de comprimento e, em seguida, aplicamos uma penalidade de comprimento constante no restante do treinamento.

2.3.4 Estratégia de amostragem

Embora o próprio algoritmo de RL tenha propriedades de amostragem relativamente boas (problemas mais difíceis proporcionam gradientes maiores), sua eficiência de treinamento é limitada. Portanto, alguns métodos de amostragem a priori bem definidos podem gerar maiores ganhos de desempenho. Utilizamos vários sinais para aprimorar ainda mais a estratégia de amostragem. Em primeiro lugar, os dados de treinamento de RL que coletamos naturalmente têm rótulos de dificuldade diferentes. Por exemplo, os problemas de competições de matemática são mais difíceis do que os problemas de matemática do ensino fundamental. Segundo, como o processo de treinamento de RL coleta amostras dos mesmos problemas várias vezes, também podemos rastrear a taxa de sucesso de cada problema como um indicador de dificuldade. Propomos dois métodos de amostragem para aproveitar esse conhecimento prévio e melhorar a eficiência do treinamento.

Amostragem de cursos Primeiro, treinamos em tarefas mais fáceis e, em seguida, passamos gradualmente para tarefas mais desafiadoras. Como o modelo inicial de RL tem desempenho limitado, gastar um orçamento computacional limitado em problemas muito difíceis geralmente produz poucas amostras corretas, o que leva a uma menor eficiência de treinamento. Ao mesmo tempo, os dados que coletamos contêm naturalmente rótulos de grau e dificuldade, o que torna a amostragem baseada em dificuldade uma maneira intuitiva e eficaz de melhorar a eficiência do treinamento.

amostragem prioritária Além da amostragem do curso, usamos uma estratégia de amostragem prioritária para nos concentrarmos em problemas com desempenho ruim do modelo. Mantemos o controle da taxa de sucesso si para cada problema i e amostramos os problemas de forma proporcional a 1/si, de modo que os problemas com taxas de sucesso mais baixas recebam uma probabilidade maior de amostragem. Isso direcionará o esforço do modelo para suas áreas mais fracas, acelerando assim o aprendizado e melhorando o desempenho geral.

2.3.5 Informações mais detalhadas sobre receitas de treinamento

Geração de casos de teste para codificação Como não há casos de teste disponíveis para muitos problemas de codificação na Web, criamos uma maneira de gerar automaticamente casos de teste que podem ser usados como bônus para treinar modelos usando RL. Nosso foco é principalmente em problemas que não exigem árbitros especiais. Também presumimos que as respostas reais a essas perguntas estejam disponíveis para que possamos usá-las para gerar casos de teste de maior qualidade.

Aprimoramos nossa abordagem com a biblioteca de geração de casos de teste amplamente reconhecida CYaRon¹. Usamos nossa base Kimi k1.5 para gerar casos de teste com base em declarações de problemas. As instruções de uso do CYaRon e as descrições de problemas servem de entrada para o gerador. Para cada problema, primeiro usamos o gerador para gerar 50 casos de teste e coletamos aleatoriamente 10 envios de respostas reais para cada caso de teste. Executamos os casos de teste em relação aos envios. Um caso de teste é considerado válido se pelo menos 10 dos 7 envios produzirem uma correspondência. Após essa rodada de filtragem, temos um conjunto selecionado de casos de teste. Se pelo menos 10 de 9 envios forem aprovados no conjunto de casos de teste selecionados, a pergunta e seus casos de teste selecionados associados serão adicionados ao nosso conjunto de treinamento.

Estatisticamente, em uma amostra de 1.000 perguntas de concursos on-line, aproximadamente 614 perguntas não exigiram um árbitro especial. Desenvolvemos 463 geradores de casos de teste que produziram pelo menos 40 casos de teste válidos, resultando em nosso conjunto de treinamento com 323 problemas.

Modelagem das recompensas da matemática Um desafio na avaliação de soluções matemáticas é que diferentes formas de escrita podem representar a mesma resposta básica. Por exemplo, a² - 4 e (a + 2)(a - 2) podem ser soluções válidas. Usamos duas abordagens para melhorar a precisão da pontuação do modelo de recompensa:

- RM clássico: inspirados na abordagem InstructGPT (Ouyang et al. 2022), implementamos um modelo de recompensa de cabeçalho baseado em valor e coletamos cerca de 800.000 pontos de dados para ajuste fino. Em última análise, o modelo usa "pergunta", "referência" e "resposta" como entradas e gera um escalar que indica se a resposta está correta ou não.

- Chain of Thought RM: estudos recentes (Ankner et al. 2024; McAleese et al. 2024) mostraram que os modelos de recompensa aumentados com raciocínio de cadeia de pensamento (CoT) podem superar significativamente as abordagens clássicas, especialmente em tarefas que exigem critérios de correção refinados (por exemplo, matemática). Portanto, coletamos um conjunto de dados do mesmo tamanho, com aproximadamente 800.000 exemplos rotulados com CoT, para ajustar o modelo Kimi. Com base nas mesmas entradas que o RM clássico, a abordagem de cadeia de raciocínio gera explicitamente processos de inferência em etapas no formato JSON e, em seguida, fornece o julgamento final de correção, resultando em um sinal de recompensa mais robusto e interpretável.

Em nossa amostragem manual, a precisão do RM clássico foi de cerca de 84,4, enquanto a precisão do RM de cadeia de pensamento chegou a 98,5.

Dados visuais Para aprimorar os recursos de inferência de imagens do mundo real do modelo e obter um alinhamento mais eficiente entre as entradas visuais e os LLMs (Large Language Models), nossos dados de Aprendizado por Reforço Visual (Vision RL) são extraídos de três categorias diferentes: dados do mundo real, dados de inferência visual sintética e dados renderizados de texto.

- Os dados do mundo real abrangem uma ampla gama de problemas científicos em todos os níveis de ensino que exigem compreensão e raciocínio de gráficos; tarefas de adivinhação de localização que exigem percepção visual e raciocínio; e tarefas analíticas que envolvem a compreensão de diagramas complexos. Esses conjuntos de dados aprimoram a capacidade do modelo de realizar o raciocínio visual em cenários do mundo real.

- Os dados sintéticos de raciocínio visual são gerados por humanos e incluem imagens e cenas criadas por programas projetados para aprimorar habilidades específicas de raciocínio visual, como a compreensão de relações espaciais, padrões geométricos e interações de objetos. Esses conjuntos de dados sintéticos proporcionam um ambiente controlado para testar as habilidades de raciocínio visual de um modelo e fornecem um suprimento infinito de exemplos de treinamento.

- Os dados renderizados em texto são criados pela conversão de conteúdo textual em um formato visual, permitindo que o modelo mantenha a consistência ao processar consultas baseadas em texto em diferentes modalidades. Ao converter documentos de texto, trechos de código e dados estruturados em imagens, garantimos que o modelo forneça uma resposta consistente, independentemente de a entrada ser texto simples ou texto renderizado como imagem (por exemplo, uma captura de tela ou foto). Isso também ajuda a aprimorar a capacidade do modelo de lidar com imagens com muito texto.

Cada tipo de dado é essencial para a criação de um modelo de linguagem visual abrangente que possa gerenciar com eficácia uma variedade de aplicativos do mundo real e, ao mesmo tempo, garantir um desempenho consistente em todos os modos de entrada.

2.4 Long2short: compactação de contexto para modelos Short-CoT

Embora o modelo long-CoT atinja um desempenho robusto, ele consome mais tokens de tempo de teste do que o LLM short-CoT padrão. No entanto, o conhecimento a priori do pensamento no modelo long-CoT pode ser transferido para o modelo short-CoT para melhorar o desempenho mesmo com um orçamento limitado de tokens de tempo de teste. Propomos várias abordagens para esse problema long2short, incluindo fusão de modelos (Yang et al., 2024), amostragem de rejeição mais curta, DPO (Rafailov et al., 2024) e RL long2short. Uma descrição detalhada dessas abordagens é apresentada a seguir:

Fusão de modelos Descobriu-se que a fusão de modelos ajuda a manter os recursos de generalização. Também descobrimos que ela melhora a eficiência do Token ao mesclar modelos de CoT longos com modelos de CoT curtos. Essa abordagem combina modelos de CoT longos com modelos mais curtos para obter novos modelos sem treinamento. Especificamente, mesclamos os dois modelos simplesmente calculando a média de seus pesos.

Amostragem de rejeição mínima Observamos que nosso modelo gera respostas de comprimentos muito diferentes para o mesmo problema. Com base nisso, criamos o método de amostragem de rejeição mais curta. Esse método coleta amostras do mesmo problema n vezes (n = 8 em nossos experimentos) e seleciona a resposta correta mais curta para o ajuste fino supervisionado.

DPO Semelhante à amostragem de rejeição mais curta, utilizamos o modelo Long CoT para gerar várias amostras de resposta. A solução correta mais curta é selecionada como amostra positiva, enquanto as respostas mais longas são consideradas como amostras negativas, incluindo a resposta incorreta mais longa e a resposta correta mais longa (1,5 vez mais longa que a amostra positiva selecionada). Esses pares positivos e negativos constituem os dados de preferência emparelhados usados para o treinamento de OPD.

Long2short RL Após a fase de treinamento de RL padrão, selecionamos um modelo que oferece o melhor equilíbrio entre desempenho e eficiência de token como modelo base e realizamos uma fase separada de treinamento de RL long2short. Na segunda fase, aplicamos a penalidade de comprimento introduzida na Seção 2.3.3 e reduzimos significativamente o comprimento máximo de lançamento para penalizar ainda mais as respostas que são mais longas do que o necessário, mas que podem estar corretas.

2.5 Outros detalhes do treinamento

2.5.1 Pré-treinamento

O modelo básico Kimi k1.5 é treinado em um corpus multimodal diversificado e de alta qualidade. Os dados linguísticos abrangem cinco domínios: inglês, chinês, código, raciocínio matemático e conhecimento. Os dados multimodais, incluindo legendas, intercalação de texto e imagem, OCR, conhecimento e conjuntos de dados de controle de qualidade, permitem que nosso modelo adquira competência linguística visual. Um rigoroso controle de qualidade garante a relevância, a diversidade e o equilíbrio do conjunto de dados de pré-treinamento geral. Nosso pré-treinamento foi conduzido em três fases: (1) pré-treinamento visual-linguístico, no qual uma base linguística sólida foi estabelecida, seguida pela integração multimodal gradual; (2) um período de resfriamento, no qual dados selecionados e sintéticos foram usados para consolidar recursos, especialmente para tarefas de inferência e baseadas em conhecimento; e (3) ativação de contexto longo, no qual o processamento de sequência foi ampliado para 131.072 tokens. Para obter informações mais detalhadas, consulte o Apêndice B.

2.5.2 Ajuste fino do supervisório Vanilla

Criamos um corpus de SFT vanilla que abrange vários domínios. Para tarefas sem raciocínio, incluindo perguntas e respostas, escrita e processamento de texto, inicialmente construímos um conjunto de dados inicial por meio de anotação manual. Esse conjunto de dados de sementes é usado para treinar modelos de sementes. Posteriormente, coletamos vários prompts e usamos o modelo seed para gerar várias respostas para cada prompt. Em seguida, o anotador classifica essas respostas e aprimora a resposta com a classificação mais alta para gerar a versão final. Para tarefas de raciocínio, como problemas matemáticos e de codificação, em que a validação baseada na modelagem de regras e recompensas é mais precisa e eficiente do que o julgamento manual, ampliamos o conjunto de dados SFT usando amostragem de rejeição.

Nosso conjunto de dados SFT básico contém aproximadamente 1 milhão de exemplos de texto. Especificamente, 500.000 exemplos para perguntas e respostas gerais, 200.000 para codificação, 200.000 para matemática e ciências, 5.000 para redação criativa e 20.000 para tarefas de contexto longo, como resumos, questionários sobre documentos, tradução e redação. Além disso, criamos 1 milhão de exemplos visuais de texto que abrangem diversas categorias, incluindo interpretação de diagramas, OCR, diálogo baseado em imagens, codificação visual, raciocínio visual e problemas de matemática/ciência com recursos visuais.

Primeiro, treinamos o modelo para uma época com um comprimento de sequência de 32k Token e, em seguida, treinamos para uma época com um comprimento de sequência de 128k Token. Na primeira fase (32k), a taxa de aprendizado diminui de 2 × 10-5 para 2 × 10-6 e, em seguida, volta para 1 × 10-5 na segunda fase (128k), antes de finalmente diminuir para 1 × 10-6. Para aumentar a eficiência do treinamento, empacotamos vários exemplos de treinamento em cada sequência de treinamento.

2.6 Infraestrutura de RL

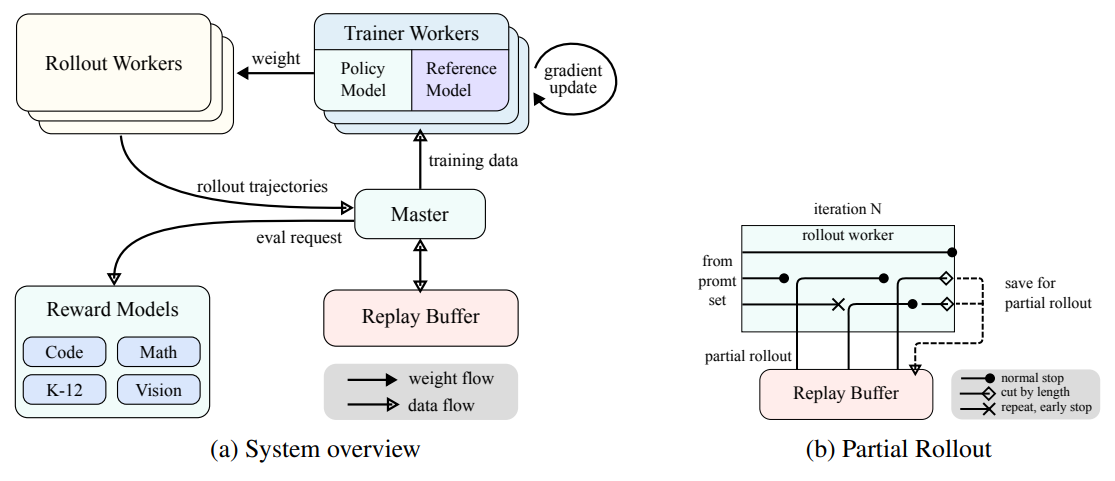

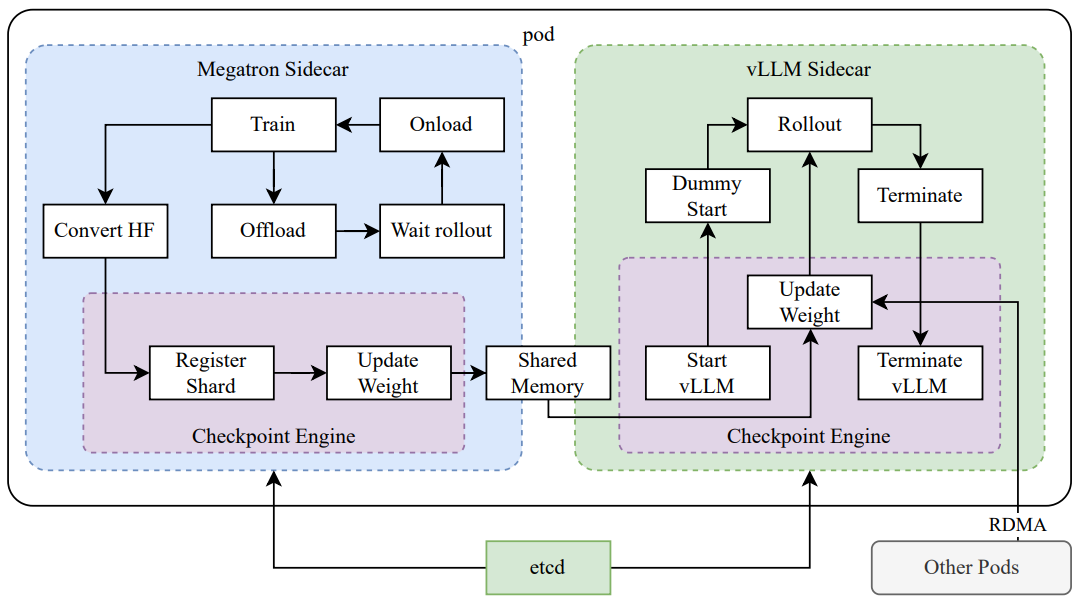

Figura 3: Sistema de treinamento de aprendizagem por reforço em larga escala para LLMs

(a) Visão geral do sistema

(b) Implementação parcial

2.6.1 Sistema de treinamento de aprendizagem por reforço em larga escala para LLMs

No campo da IA, a aprendizagem por reforço (RL) tornou-se um método de treinamento fundamental para modelos de linguagem em larga escala (LLMs) (Ouyang et al. 2022) (Jaech et al. 2024), inspirando-se em seu sucesso no domínio de jogos complexos como Go, Starcraft II e Dota 2, com sistemas como AlphaGo (Silver et al. 2017), AlphaStar (Vinyals et al. 2019) e OpenAI Dota Five (Berner et al. 2019), entre outros sistemas. Seguindo essa tradição, o sistema Kimi k1.5 emprega uma estrutura de RL sincronizada iterativamente que foi cuidadosamente projetada para aprimorar a inferência do modelo por meio de aprendizado e adaptação persistentes. Uma inovação importante nesse sistema é a introdução da técnica de implementação parcial, que foi projetada para otimizar o processamento de trajetórias de inferência complexas.

Conforme mostrado na Fig. 3a, o sistema de treinamento de RL opera por meio de uma abordagem de sincronização iterativa, em que cada iteração consiste em uma fase de implementação e uma fase de treinamento. Durante a fase de implementação, um trabalhador de implementação coordenado por um servidor mestre central gera trajetórias de implementação ao interagir com o modelo para produzir uma sequência de respostas a várias entradas. Essas trajetórias são então armazenadas em um buffer de repetição, o que garante um conjunto de dados de treinamento diversificado e imparcial ao interromper a correlação temporal. Nas fases de treinamento subsequentes, a pasta de trabalho de treinamento acessa essas experiências para atualizar os pesos do modelo. Esse processo cíclico permite que o modelo aprenda continuamente com suas operações e ajuste sua estratégia ao longo do tempo para melhorar o desempenho.

O servidor mestre central atua como um comandante central, gerenciando o fluxo de dados e a comunicação entre fluxos de trabalho de implementação, fluxos de trabalho de treinamento, avaliação com modelos de recompensa e buffers de repetição. Ele garante que o sistema opere de forma coordenada, equilibra a carga e facilita o processamento eficiente dos dados.

A rotina de trabalho de treinamento acessa essas trajetórias de lançamento, concluídas em uma única iteração ou divididas em várias iterações, para computar atualizações de gradiente que melhoram os parâmetros do modelo e aprimoram seu desempenho. Esse processo é supervisionado pelo modelo de recompensa, que avalia a qualidade do resultado do modelo e fornece o feedback necessário para orientar o processo de treinamento. A avaliação do modelo de recompensa é fundamental para determinar a eficácia da estratégia do modelo e orientar o modelo em direção ao desempenho ideal.

Além disso, o sistema inclui um serviço de execução de código, que foi projetado especificamente para lidar com problemas relacionados a códigos e é parte integrante do modelo de recompensa. Esse serviço avalia o resultado do modelo em cenários reais de codificação, garantindo que o aprendizado do modelo esteja estreitamente alinhado com os desafios de programação do mundo real. Ao validar a solução do modelo em relação à execução real do código, esse ciclo de feedback é essencial para aprimorar a estratégia do modelo e melhorar seu desempenho em tarefas relacionadas ao código.

2.6.2 Implementação parcial para RLs de CoT longas

Uma das principais ideias do nosso trabalho é ampliar o treinamento de RL de contexto longo. O rollout parcial é uma técnica fundamental que aborda com eficácia o desafio de lidar com características de CoT longas, gerenciando rollouts para trajetórias longas e curtas. Essa técnica estabelece um orçamento fixo de tokens de saída que limita o comprimento de cada trajetória de rollout. Se a trajetória exceder o limite de tokens durante a fase de rollout, a parte inacabada é salva no buffer de repetição e continuada na próxima iteração. Isso garante que nenhuma trajetória longa monopolize os recursos do sistema. Além disso, como os fluxos de trabalho de distribuição são executados de forma assíncrona, enquanto alguns fluxos de trabalho estão processando trajetórias longas, outros podem processar independentemente tarefas de distribuição novas e mais curtas. A operação assíncrona maximiza a eficiência computacional, garantindo que todos os fluxos de trabalho de distribuição contribuam ativamente para o processo de treinamento, otimizando assim o desempenho geral do sistema.

Conforme mostrado na Figura 3b, o sistema de distribuição parcial funciona decompondo respostas longas em fragmentos ao longo das iterações (da iteração n-m à iteração n). O buffer de repetição atua como um mecanismo de armazenamento central para manter esses fragmentos de resposta, em que somente a iteração atual (iteração n) precisa ser computada on-line. Os segmentos anteriores (iterações n-m a n-1) podem ser reutilizados de forma eficiente a partir do buffer, eliminando a necessidade de implementações repetidas. Essa abordagem segmentada reduz significativamente a sobrecarga computacional: em vez de implementar toda a resposta de uma só vez, o sistema processa e armazena segmentos de forma incremental, permitindo a geração de respostas mais longas e mantendo tempos de iteração rápidos. Durante o treinamento, determinados segmentos podem ser excluídos do cálculo de perda para otimizar ainda mais o processo de aprendizado, tornando o sistema geral eficiente e dimensionável.

A implementação de distribuição parcial também oferece detecção de duplicatas. O sistema identifica sequências duplicadas no conteúdo gerado e as encerra antecipadamente, reduzindo assim a computação desnecessária e mantendo a qualidade do resultado. As duplicatas detectadas podem receber penalidades adicionais, impedindo efetivamente a geração de conteúdo redundante no conjunto de dicas.

2.6.3 Implantação híbrida de treinamento e raciocínio

O processo de treinamento de RL consiste nos seguintes estágios:

Figura 4: Estrutura de implantação híbrida

- fase de treinamentoEm primeiro lugar, o Megatron (Shoeybi et al. 2020) e o vLLM (Kwon et al. 2023) são executados em contêineres separados encapsulados por processos de shim chamados de mecanismos de ponto de verificação (Seção 2.6.3). O Megatron inicia o processo de treinamento. Quando o treinamento é concluído, o Megatron descarrega a memória da GPU e se prepara para transferir os pesos atuais para o vLLM.

- estágio de inferênciaO vLLM inicia com os pesos do modelo virtual e os atualiza com os pesos mais recentes transferidos do Megatron via Mooncake (Qin et al. 2024). Após a conclusão da implementação, o mecanismo de ponto de verificação interrompe todos os processos do vLLM.

- Fase de treinamento de acompanhamentoO Megatron é o primeiro a fazer isso: depois que a memória alocada para o vLLM é liberada, o Megatron descarrega a memória e inicia outra rodada de treinamento.

Achamos difícil oferecer suporte a todos os recursos a seguir ao mesmo tempo com o trabalho existente.

- Estratégias paralelas complexasMegatron: o Megatron pode ter uma estratégia de paralelismo diferente do vLLM. Os pesos de treinamento distribuídos em vários nós no Megatron podem ser difíceis de compartilhar com o vLLM.

- Minimizar os recursos ociosos da GPUPara a política on-line de RL, trabalhos recentes (por exemplo, SGLang (L. Zheng et al. 2024) e VLLM) podem reservar algumas GPUs durante o treinamento, o que, por sua vez, pode levar a GPUs de treinamento ociosas.

- Escalabilidade dinâmicaEm alguns casos, é possível obter acelerações significativas aumentando o número de nós de inferência e mantendo o processo de treinamento constante. Nosso sistema pode utilizar com eficiência o número necessário de nós de GPU livres.

Conforme mostrado na Figura 4, implementamos essa estrutura de implantação híbrida sobre o Megatron e o vLLM (Seção 2.6.3), resultando em uma fase de treinamento para raciocínio em menos de um minuto, e o inverso em cerca de 10 segundos.

Estratégia de implantação híbrida Propomos uma estratégia de implantação híbrida para tarefas de treinamento e inferência que aproveita os contêineres Sidecar do Kubernetes para compartilhar todas as GPUs disponíveis a fim de justapor as duas cargas de trabalho em um único pod. As principais vantagens dessa estratégia são:

- Isso facilita o compartilhamento e o gerenciamento eficientes de recursos e evita que os nós de treinamento fiquem ociosos enquanto aguardam os nós de inferência (quando ambos são implantados em nós separados).

- Usando imagens de implantação diferentes, o treinamento e a inferência podem ser iterados de forma independente para melhorar o desempenho.

- A arquitetura não se limita ao vLLM e outras estruturas podem ser facilmente integradas.

mecanismo de ponto de controle O mecanismo de checkpointing é responsável por gerenciar o ciclo de vida do processo vLLM, expondo APIs HTTP que acionam várias operações no vLLM. Para garantir a consistência e a confiabilidade gerais, usamos um sistema de metadados global gerenciado pelo serviço etcd para transmitir operações e estado.

Quando o vLLM é desinstalado, pode ser difícil liberar totalmente a memória da GPU, principalmente devido aos gráficos CUDA, buffers NCCL e drivers NVIDIA. Para minimizar as modificações no vLLM, nós o encerramos e reiniciamos quando necessário para melhorar a utilização da GPU e a tolerância a falhas.

A solução alternativa na Megatron converte os pontos de verificação próprios para o formato Hugging Face na memória compartilhada. Essa conversão também leva em conta o paralelismo de pipeline e o paralelismo especializado, de modo que somente o paralelismo de tensor é preservado nesses pontos de verificação. Os pontos de verificação na memória compartilhada são então fragmentados e registrados no sistema de metadados global. Usamos o Mooncake para transferir pontos de verificação entre nós pares via RDMA. Algumas modificações no vLLM são necessárias para carregar o arquivo de pesos e executar a transformação tensor-paralela.

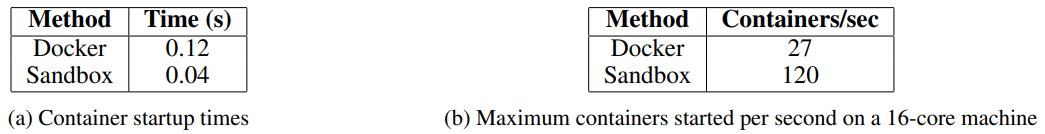

Desenvolvemos a sandbox como um ambiente seguro para a execução de código enviado pelo usuário que é otimizado para execução de código e benchmarking de código. Ao alternar dinamicamente as imagens de contêiner, a sandbox oferece suporte a diferentes casos de uso por meio do MultiPL-E (Cassano, Gouwar, D. Nguyen, S. Nguyen, et al. 2023), DMOJ Judge Server², Lean, Jupyter Notebook e outras imagens.

Para a RL em tarefas de codificação, o Sandbox garante a confiabilidade dos julgamentos dos dados de treinamento, fornecendo um mecanismo de avaliação consistente e repetível. Seu sistema de feedback é compatível com avaliações em vários estágios, como feedback de execução de código e edições em nível de repositório, mantendo um contexto uniforme para garantir comparações de benchmark justas e imparciais entre linguagens de programação.

Implantamos o serviço no Kubernetes para obter escalabilidade e elasticidade, expondo-o por meio de um endpoint HTTP para integração externa. Os recursos do Kubernetes, como reinicializações automáticas e atualizações contínuas, garantem disponibilidade e tolerância a falhas.

Para otimizar o desempenho e oferecer suporte a ambientes de RL, integramos várias tecnologias em nossos serviços de execução de código para melhorar a eficiência, a velocidade e a confiabilidade. Essas tecnologias incluem:

- Usando o CrunUso do crun como tempo de execução do contêiner em vez do Docker, o que reduz significativamente o tempo de inicialização do contêiner.

- Reutilização do CgroupCriamos previamente cgroups para serem usados por contêineres, o que é fundamental em cenários altamente simultâneos, nos quais a criação e a destruição de cgroups para cada contêiner pode ser um gargalo.

- Otimização do uso do discoO sistema de arquivos de sobreposição montado como tmpfs para controlar as gravações em disco fornece um espaço de armazenamento de tamanho fixo e alta velocidade. Essa abordagem favorece as cargas de trabalho temporárias.

Essas otimizações melhoram a eficiência da RL na execução do código, proporcionando um ambiente consistentemente confiável para avaliar o código gerado pela RL, o que é essencial para o treinamento iterativo e o aprimoramento do modelo.

3 experimentos

3.1 Avaliação

Como o k1.5 é um modelo multimodal, realizamos uma avaliação abrangente dos diferentes modos em vários testes de benchmark. A configuração detalhada da avaliação pode ser encontrada no Apêndice C. Nossos testes de referência consistem nas três categorias principais a seguir:

- Avaliação comparativa de textosMMLU (Hendrycks et al., 2020), IF-Eval (J. Zhou et al., 2023), CLUEWSC (L. Xu et al., 2020), C-EVAL (Y. Huang et al., 2023).

- Raciocínio Benchmarking: HumanEval-Mul, LiveCodeBench (Jain et al. 2024), Codeforces, AIME 2024, MATH-500 (Lightman et al. 2023)

- Benchmarking visualMMMU (Yue, Ni, et al. 2024), MATH-Vision (K. Wang et al. 2024), MathVista (Lu et al. 2023).

3.2 Principais resultados

Modelo K1.5 long-CoT O desempenho do modelo Kimi k1.5 long-CoT é mostrado na Tabela 2. A capacidade de inferência de longo prazo do modelo é significativamente aprimorada pelo ajuste fino supervisionado de CoT longo (descrito na Seção 2.2) e pelo aprendizado de co-reforço de texto visual (discutido na Seção 2.3). As extensões computacionais em tempo de teste melhoram ainda mais seu desempenho, permitindo que o modelo alcance resultados de última geração em diversas modalidades. Nossa avaliação revela melhorias significativas na capacidade do modelo de raciocinar, entender e sintetizar informações em contextos ampliados, representando avanços nos recursos de IA multimodal.

Modelo K1.5 short-CoT O desempenho do modelo Kimi k1.5 short-CoT é mostrado na Tabela 3. Esse modelo integra várias técnicas, inclusive o ajuste fino supervisionado tradicional (discutido na Seção 2.5.2), o aprendizado por reforço (explorado na Seção 2.3) e o refinamento de longo a curto prazo (descrito na Seção 2.4). Os resultados mostram que o modelo k1.5 short-CoT oferece desempenho competitivo ou superior em várias tarefas em comparação com os principais modelos proprietários e de código aberto. Isso inclui desafios textuais, visuais e de raciocínio, com vantagens significativas na compreensão de linguagem natural, matemática, codificação e raciocínio lógico.

Tabela 2: Desempenho do Kimi k1.5 long-CoT e dos principais modelos proprietários e de código aberto.

Tabela 3: Desempenho do Kimi k1.5 short-CoT e dos principais modelos proprietários e de código aberto. O desempenho do modelo VLM foi obtido na plataforma de benchmarking OpenCompass (https://opencompass.org.cn/).

3.3 Extensão de contexto longo

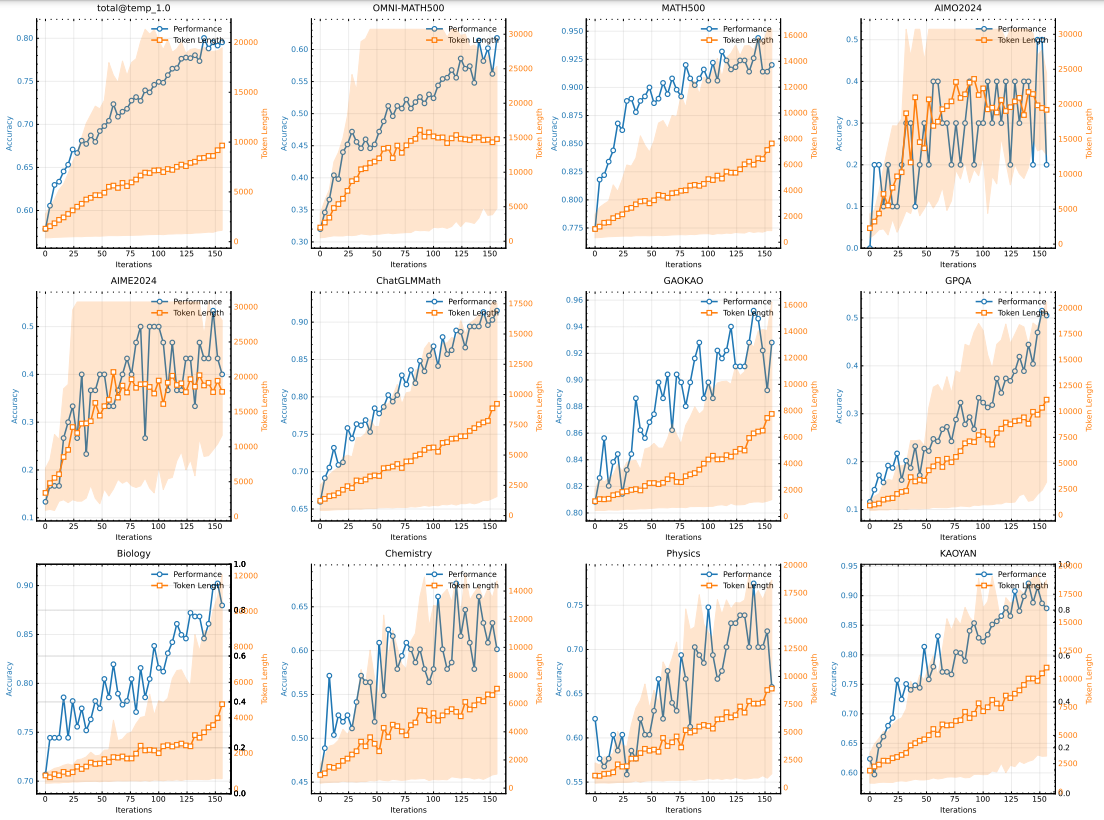

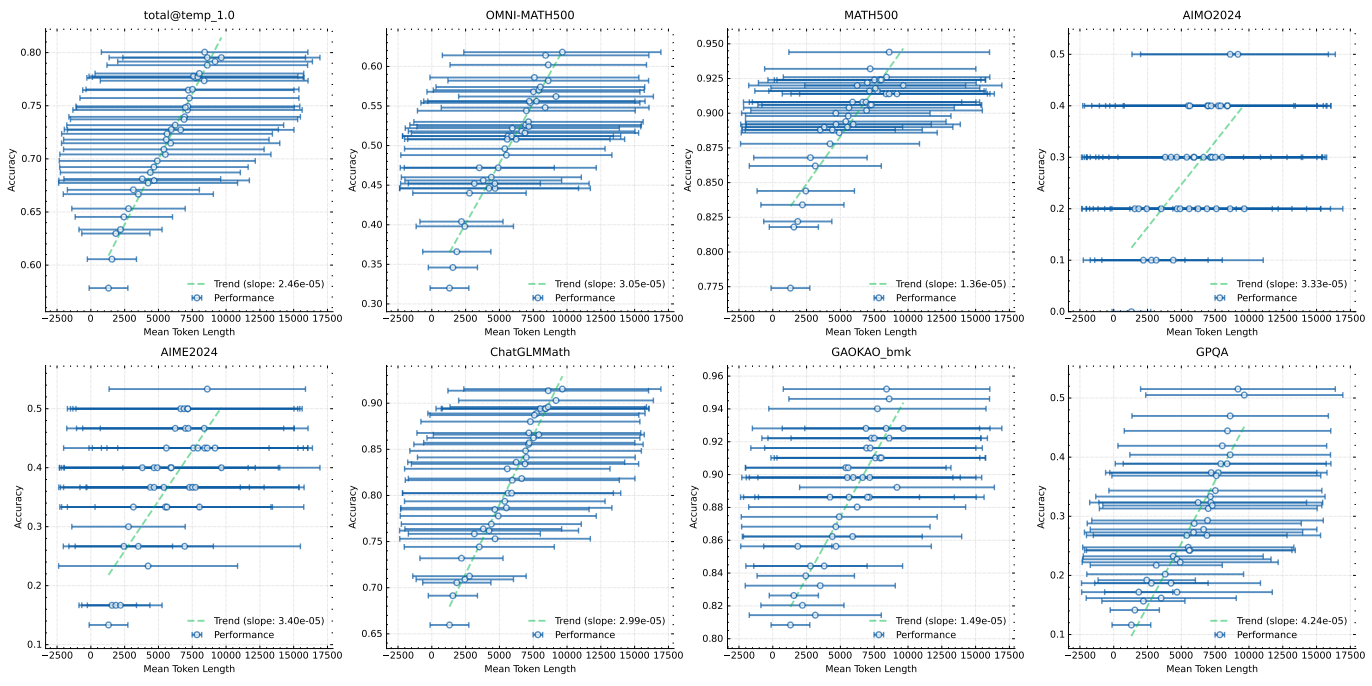

Usamos um modelo de tamanho médio para investigar as propriedades ampliadas da RL com LLM. A Figura 5 ilustra a evolução da precisão do treinamento e do comprimento da resposta ao longo das iterações de treinamento para a variante de modelo pequeno treinada no conjunto de dicas matemáticas. À medida que o treinamento prossegue, observamos um aumento simultâneo no comprimento da resposta e na precisão do desempenho. Notavelmente, o comprimento da resposta aumenta mais rapidamente para os testes de benchmark mais desafiadores, sugerindo que o modelo aprende a gerar soluções mais detalhadas para problemas complexos. A Figura 6 mostra uma forte correlação entre o comprimento do contexto de saída do modelo e sua capacidade de solução de problemas. Nossa execução final de k1.5 estende o comprimento do contexto para 128k e observa uma melhoria contínua nos testes de benchmark de inferência difícil.

Figura 5: Alterações na precisão e no comprimento do treinamento à medida que o número de iterações de treinamento aumenta. Observe que as pontuações acima são do modelo long-cot interno, que tem um tamanho de modelo muito menor do que o modelo k1.5 long-CoT. A área sombreada indica o 95º percentil do comprimento da resposta.

3.4 Long2short

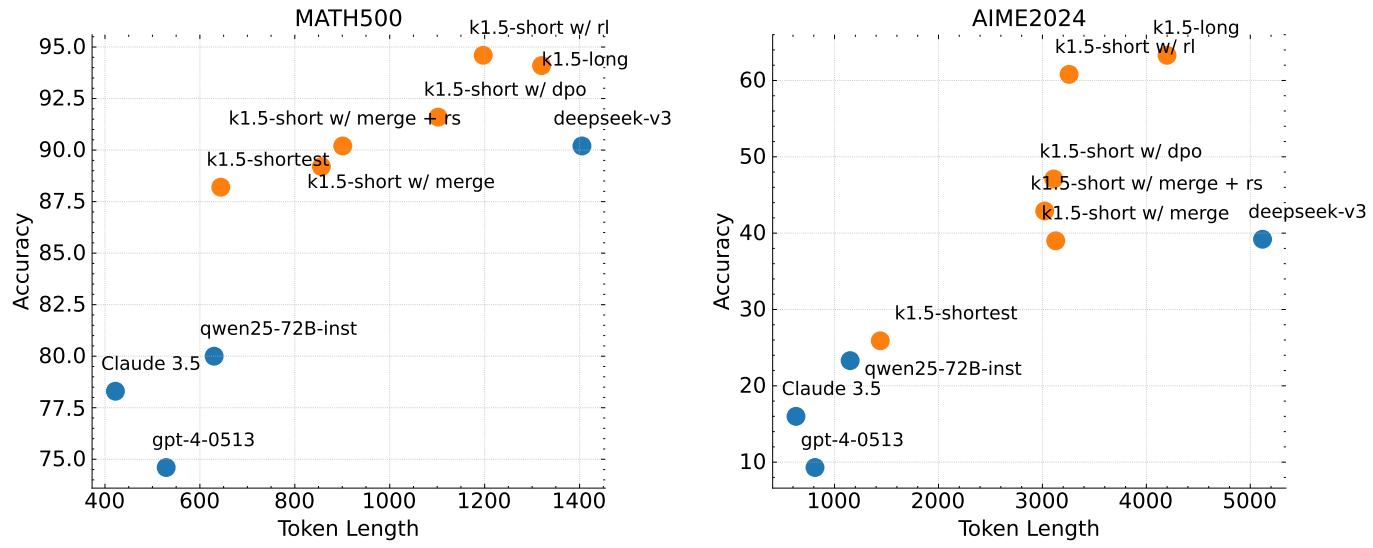

Comparamos o algoritmo de RL long2short proposto com o DPO, a amostragem de rejeição mais curta e os métodos de fusão de modelos apresentados na Seção 2.4, com foco na eficiência de Token do problema long2short (X. Chen et al., 2024) e, em particular, em como fazer com que os modelos long-cot obtidos beneficiem os modelos short. Na Fig. 7, k1.5-long indica o modelo long-cot que escolhemos para o treinamento long2short. k1.5-short w/ rl refere-se ao modelo curto obtido usando o treinamento long2short RL. k1.5-short w/ dpo indica o modelo curto que é treinado para melhorar a eficiência do Token pelo treinamento DPO. k1.5-short w/ merge indica a fusão do modelo. k1.5-short w/ merge indica a fusão do modelo. k1.5-short w/ merge indica a fusão do modelo. k1.5-short w/ merge indica a fusão do modelo. short w/ merge indica o modelo após a fusão do modelo, enquanto k1.5-short w/ merge + rs indica o modelo curto obtido pela aplicação da amostragem de rejeição mais curta ao modelo mesclado. k1.5-shortest indica o modelo mais curto obtido durante o treinamento long2short. Conforme mostrado na Fig. 7, o algoritmo de RL long2short proposto apresenta a maior eficiência de token em comparação com outros métodos, como DPO e fusão de modelos. É importante observar que todos os modelos da família k1.5 (marcados em laranja) apresentam melhor eficiência de token do que os outros modelos (marcados em azul). Por exemplo, o k1.5-short w/ rl obtém uma pontuação Pass@1 de 60,8 no AIME2024 (com uma média de 8 execuções), usando apenas uma média de 3.272 tokens. O k1.5-shortest também obtém uma pontuação Pass@1 de 88,2 no MATH500, consumindo aproximadamente o mesmo número de tokens que outros modelos curtos. modelos curtos.

Figura 6: O desempenho do modelo melhora com o aumento do comprimento da resposta

Figura 7: Desempenho do Long2Short. Todas as famílias k1.5 demonstram melhor eficiência de token do que outros modelos.

3.5 Estudos de ablação

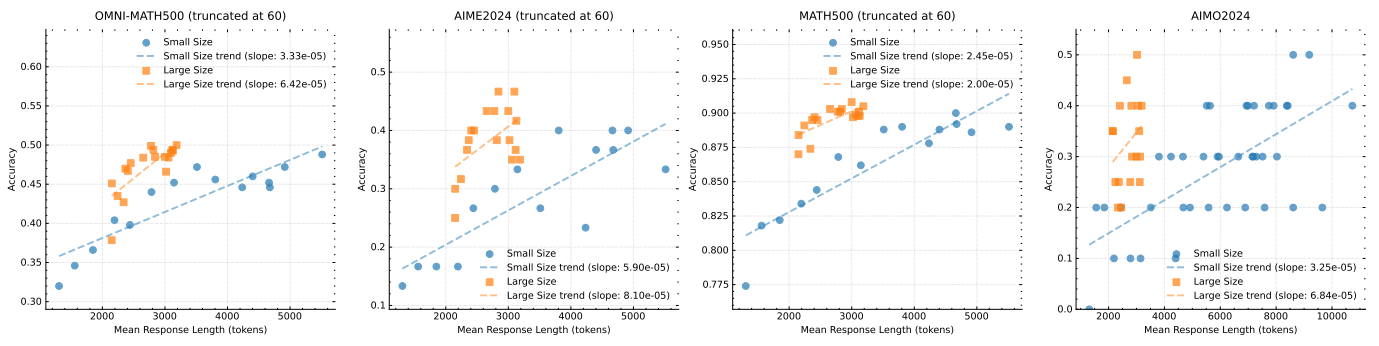

Extensão do tamanho do modelo e do comprimento do contexto Nossa principal contribuição é aplicar a RL para aumentar a capacidade dos modelos de gerar CoTs estendidos e, assim, melhorar sua inferência. Uma pergunta natural é: como isso se compara ao simples aumento do tamanho do modelo? Para demonstrar a eficácia da nossa abordagem, treinamos dois modelos de tamanhos diferentes usando o mesmo conjunto de dados e registramos os resultados da avaliação e os comprimentos médios de inferência em todos os pontos de verificação durante o treinamento de RL. Esses resultados são mostrados na Fig. 8. É importante observar que, embora o modelo maior inicialmente supere o modelo menor, o modelo menor pode alcançar um desempenho comparável explorando o CoT mais longo otimizado pela RL. No entanto, os modelos maiores geralmente apresentam melhor eficiência de token do que os modelos menores. Isso também sugere que, se o objetivo for obter o melhor desempenho possível, a extensão do comprimento do contexto de modelos maiores tem um limite superior mais alto e é mais eficiente em termos de token. No entanto, o treinamento de modelos menores com comprimentos de contexto mais longos pode ser uma solução viável se a computação for orçada no momento do teste.

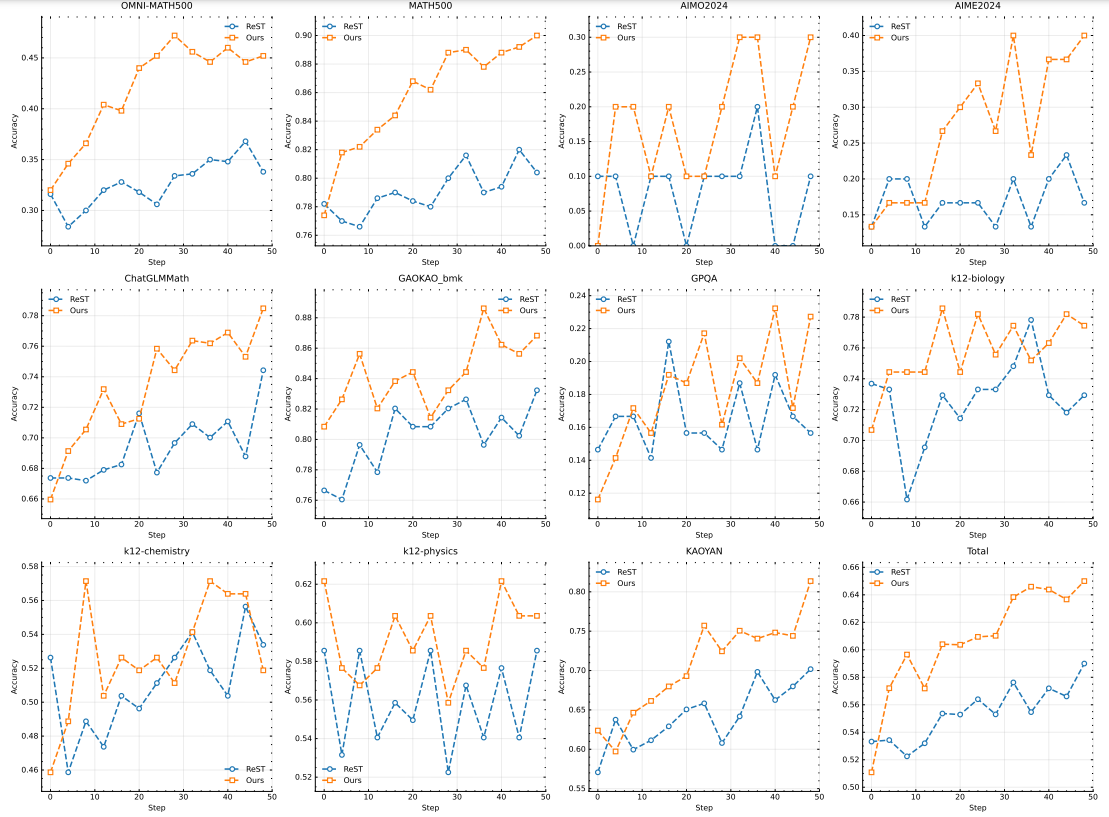

Efeitos do uso de gradientes negativos Investigamos a eficácia do uso do ReST (Gulcehre et al., 2023) como algoritmo de otimização de políticas em nossa configuração. A principal diferença entre o ReST e outros métodos baseados em RL, inclusive o nosso, é que o ReST aprimora iterativamente o modelo ajustando a melhor resposta amostrada do modelo atual sem aplicar um gradiente negativo para penalizar respostas incorretas. Conforme mostrado na Fig. 10, nosso método apresenta maior complexidade de amostragem em comparação com o ReST, sugerindo que a incorporação de gradientes negativos melhora significativamente a eficiência do modelo na geração de CoTs longas. Nossa abordagem não apenas melhora a qualidade da inferência, mas também otimiza o processo de treinamento, resultando em um desempenho robusto usando menos amostras de treinamento. Essa descoberta sugere que a escolha do algoritmo de otimização da estratégia é crucial em nosso cenário, pois a diferença de desempenho entre a ReST e outros métodos baseados em RL não é tão pronunciada em outros domínios como em (Gulcehre et al. 2023). Assim, nossos resultados destacam a importância de escolher uma estratégia de otimização adequada para maximizar a eficiência da geração de CoTs longas.

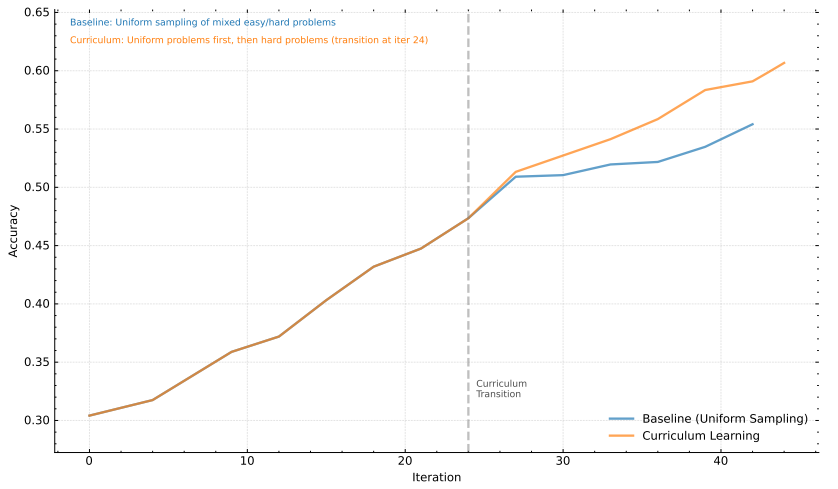

estratégia de amostragem Além disso, demonstramos a eficácia da estratégia de amostragem de cursos apresentada na Seção 2.3.4. Nosso conjunto de dados de treinamento D contém problemas de vários níveis de dificuldade. Com nossa abordagem de amostragem de curso, inicialmente usamos D para uma fase de aquecimento e, em seguida, treinamos o modelo concentrando-nos apenas em problemas difíceis. Esse método é comparado a um método de linha de base que usa uma estratégia de amostragem uniforme sem nenhum ajuste de curso. Conforme mostrado na Fig. 9, nossos resultados mostram claramente que a abordagem de amostragem de curso proposta melhora significativamente o desempenho. Essa melhoria pode ser atribuída à capacidade do método de desafiar progressivamente o modelo, permitindo que ele desenvolva uma compreensão mais forte e a capacidade de lidar com problemas complexos. Ao concentrar os esforços de treinamento em problemas mais difíceis após uma generalização inicial, o modelo pode fortalecer melhor seus recursos de raciocínio e solução de problemas.

Figura 8: Desempenho do modelo versus comprimento da resposta para diferentes tamanhos de modelo

Figura 9: Análise da abordagem de aprendizado do curso para modelar o desempenho.

4 Conclusão

Apresentamos a receita de treinamento e o design do sistema para o k1.5, nosso mais recente LLM multimodal treinado usando RL. Um dos principais insights que extraímos da prática é que o dimensionamento do comprimento do contexto é fundamental para o aprimoramento contínuo dos LLMs. Empregamos algoritmos de aprendizado otimizados e otimizações de infraestrutura, como a implementação parcial, para obter um treinamento eficiente de RL de contexto longo. Como melhorar ainda mais a eficiência e a escalabilidade do treinamento de RL de contexto longo continua sendo um importante caminho a seguir.

Figura 10: Comparação da otimização de políticas usando o ReST.

Outra contribuição que fazemos é combinar várias técnicas para que a otimização da política possa ser aprimorada. Especificamente, formulamos a RL de CoT longa usando LLM e variantes derivadas de descida de espelho on-line para otimização robusta. Também fizemos experiências com estratégias de amostragem, penalidades de comprimento e formulação de dados ideais para obter um desempenho robusto da RL.

Mostramos que, mesmo sem usar técnicas mais sofisticadas (por exemplo, pesquisa em árvore de Monte Carlo, funções de valor e modelos de recompensa de processo), é possível obter um desempenho sólido com extensões de contexto longas e otimização aprimorada de políticas. No futuro, também seria interessante investigar como melhorar a alocação de crédito e reduzir o excesso de reflexão sem comprometer os recursos de exploração do modelo.

Também observamos o potencial dos métodos long2short. Esses métodos melhoram muito o desempenho do modelo Short-CoT. Além disso, os métodos long2short podem ser combinados com o long-CoT RL de forma iterativa para melhorar ainda mais a eficiência do token e extrair o melhor desempenho para um determinado orçamento de comprimento de contexto.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Publicações relacionadas

Nenhum comentário...