BrowserAI: Executando modelos de IA localmente no navegador com WebGPUs

Introdução geral

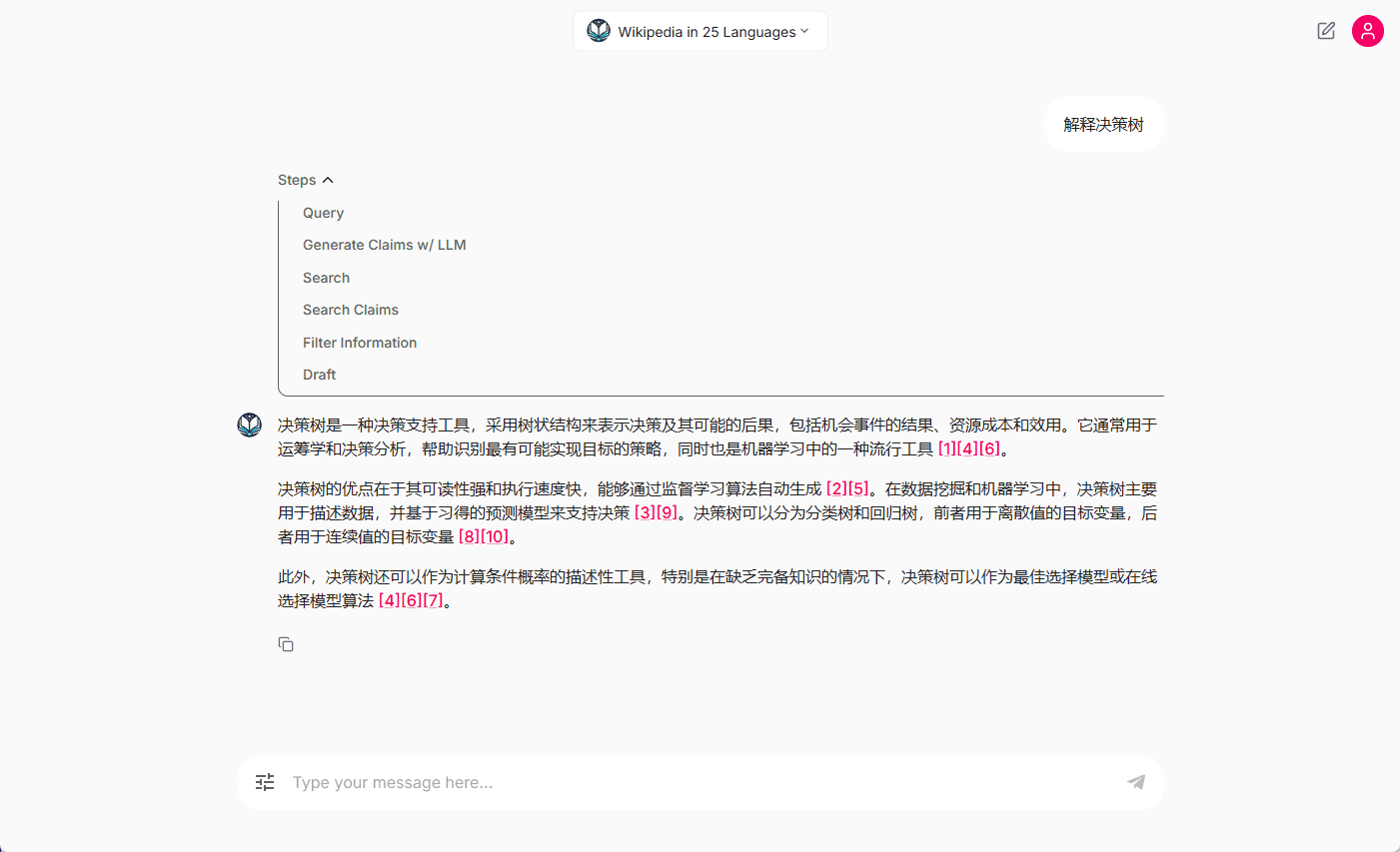

O BrowserAI é uma ferramenta de código aberto que permite aos usuários executar modelos de IA nativos diretamente no navegador. Desenvolvido pela equipe Cloud-Code-AI, ele oferece suporte a modelos de linguagem como Llama, DeepSeek e Kokoro. Os usuários podem executar tarefas como geração de texto, reconhecimento de fala e conversão de texto em fala por meio do navegador, sem a necessidade de um servidor ou de uma configuração complexa. Ele usa a tecnologia WebGPU para acelerar a computação, e todos os dados são processados localmente para proteger a privacidade. O BrowserAI é simples e fácil de usar, portanto, os desenvolvedores podem usá-lo para criar aplicativos de IA, e os usuários comuns também podem experimentar os recursos de IA. O projeto é gratuito e aberto no GitHub, portanto, qualquer pessoa pode baixar o código e usá-lo ou aprimorá-lo.

Diálogo de texto do BrowserAI

Diálogo de voz do BrowserAI

Conversão de texto em fala do BrowserAI

Lista de funções

- Execute modelos locais de IA em seu navegador sem suporte de servidor.

- A geração de texto é suportada para que os usuários possam inserir texto e obter uma resposta em linguagem natural.

- Oferece reconhecimento de fala para converter áudio em texto.

- Suporta conversão de texto em fala, transformando texto em áudio reproduzível.

- Acelerado com WebGPU, ele é executado com desempenho quase nativo.

- A funcionalidade off-line é fornecida e nenhuma conexão com a Internet é necessária após o primeiro download.

- Código-fonte aberto, suporte para que os desenvolvedores personalizem modelos e funcionalidades.

Usando a Ajuda

Processo de instalação

O BrowserAI não exige uma instalação tradicional, mas requer a preparação do ambiente e do código a ser executado. Aqui estão as etapas exatas:

- Verifique seu navegador

- Use um navegador habilitado para WebGPU, como o Chrome 113+ ou o Edge 113+. Na barra de endereços de seu navegador, digite

chrome://gpuVerifique se a WebGPU está ativada. - Certifique-se de que o hardware do seu computador seja compatível com ponto flutuante de 16 bits (alguns modelos exigem isso) e que uma CPU comum possa executá-lo, mas uma GPU é mais rápida.

- Use um navegador habilitado para WebGPU, como o Chrome 113+ ou o Edge 113+. Na barra de endereços de seu navegador, digite

- Código de download

- Acesse https://github.com/Cloud-Code-AI/BrowserAI.

- Clique no botão "Code" e selecione "Download ZIP" para fazer o download ou use o comando

git clone https://github.com/Cloud-Code-AI/BrowserAI.git. - Descompacte o arquivo ou acesse a pasta.

- Instalação do Node.js e das dependências

- Primeiro, instale o Node.js, faça o download e instale-o no site oficial do Node.js e, quando terminar, digite

node -vConfirme a versão. - Abra um terminal e acesse a pasta BrowserAI (por exemplo

cd BrowserAI). - importação

npm installInstale as dependências, o processo pode levar alguns minutos.

- Primeiro, instale o Node.js, faça o download e instale-o no site oficial do Node.js e, quando terminar, digite

- Início de projetos

- No terminal, digite

npm run dev, inicie o servidor local. - Abra seu navegador e digite

http://localhost:3000(consulte o prompt do terminal para saber o número da porta) e entre na interface do BrowserAI.

- No terminal, digite

Como usar os principais recursos

O núcleo do BrowserAI é executar modelos de IA no navegador, o que é descrito em detalhes a seguir.

Função 1: Geração de texto

- procedimento

- Após a inicialização, a interface exibe a caixa de seleção do modelo, que, por padrão, tem a opção

llama-3.2-1b-instructe outras opções. - Clique em "Load Model" (Carregar modelo) e aguarde o carregamento do modelo (de alguns segundos a alguns minutos, dependendo do desempenho do computador).

- Digite o texto na caixa de entrada, como "What's the weather like today?" (Como está o tempo hoje?) e clique em "Generate" (Gerar).

- O sistema gera respostas como "It's a beautiful day to go out" (Está um lindo dia para sair). .

- Após a inicialização, a interface exibe a caixa de seleção do modelo, que, por padrão, tem a opção

- Dicas e truques

- Modelos pequenos (por exemplo

TinyLlama-1.1B) carrega rapidamente e é adequado para computadores de baixo custo. - Digite uma pergunta específica para obter uma resposta mais precisa, como "Escreva um artigo técnico de 50 palavras".

- Modelos pequenos (por exemplo

- cenário do aplicativo

- Escreva os primeiros rascunhos de artigos, gere diálogos ou teste modelos de habilidades linguísticas.

Função 2: Reconhecimento de fala

- procedimento

- Selecione um modelo que ofereça suporte ao reconhecimento de fala, como

whisper-tiny-en. - Clique em "Load Model" (Carregar modelo) para carregar o modelo.

- Clique em "Start Recording" (Iniciar gravação) e fale no microfone, por exemplo, "Hello, BrowserAI" (Olá, BrowserAI).

- Clique em "Stop Recording" (Parar gravação), aguarde alguns segundos e a interface exibirá o texto transcrito, como "Hello, BrowserAI".

- Selecione um modelo que ofereça suporte ao reconhecimento de fala, como

- Dicas e truques

- Verifique se o microfone está funcionando corretamente e se há pouco ruído de fundo para obter melhores resultados.

- Parâmetros opcionais

return_timestampsVeja o registro de data e hora de cada parágrafo.

- cenário do aplicativo

- Grave reuniões, transcreva anotações de voz ou desenvolva aplicativos de entrada de voz.

Função 3: conversão de texto em fala

- procedimento

- opção

kokoro-ttsmodelo, clique em "Load Model" (Carregar modelo). - Digite o texto, como "Bem-vindo à experiência do BrowserAI".

- Selecione a voz (por exemplo

af_bella) e a velocidade (padrão 1,0), clique em "Text to Speech" (Texto para fala). - Gerar áudio e reproduzi-lo automaticamente ou fazer o download do arquivo.

- opção

- Dicas e truques

- As frases são mais naturais, e as velocidades mais lentas (por exemplo, 0,8) são mais claras.

- Teste diferentes opções de voz para encontrar o tom mais adequado.

- cenário do aplicativo

- Crie prompts de voz, gere clipes de podcast ou duble vídeos.

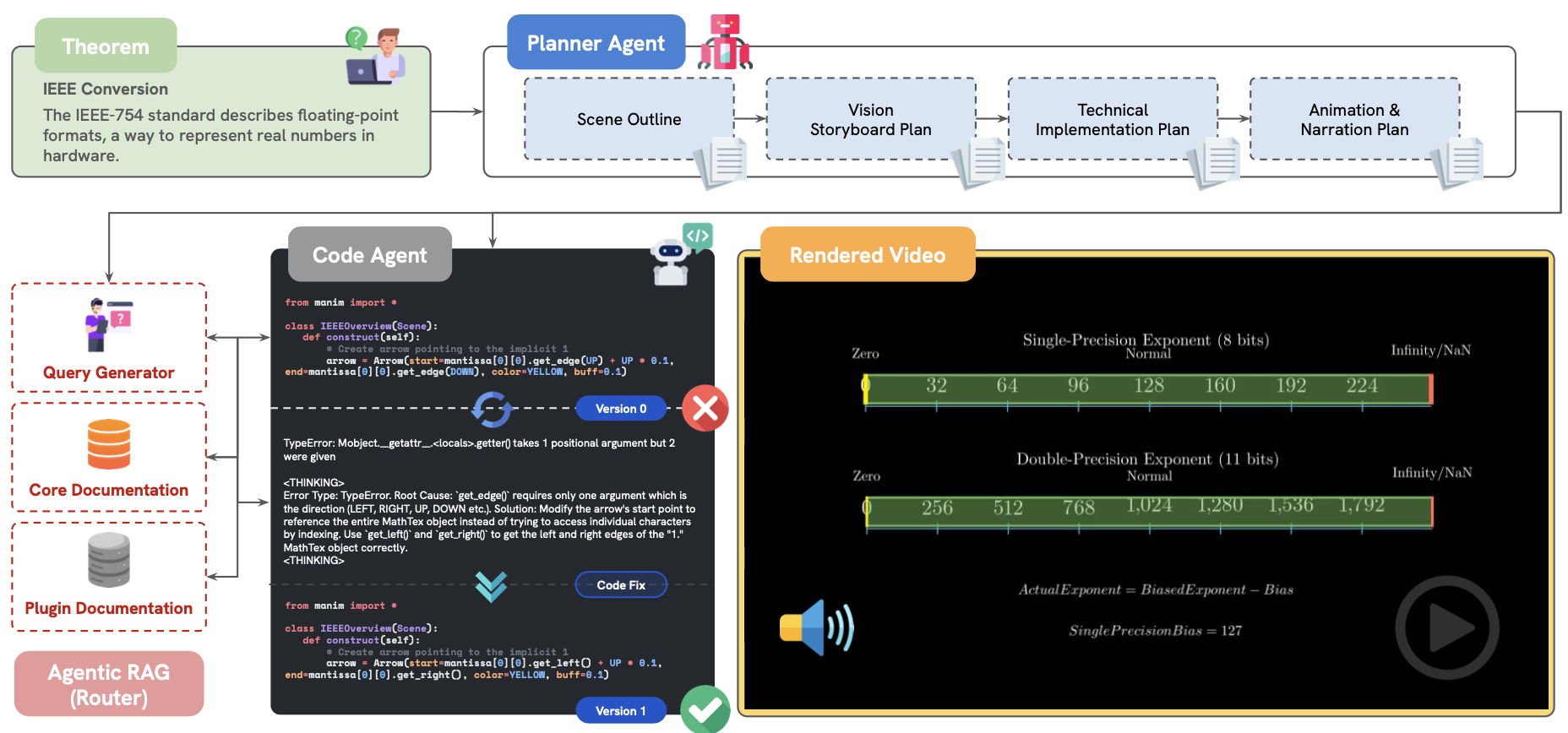

Recurso 4: Personalização do desenvolvedor

- procedimento

- Faça o download do arquivo de modelo que deseja usar (por exemplo, do Hugging Face) e coloque-o no diretório do projeto (consulte

README.md). - compilador

src/index.tsadicione o caminho do modelo. - estar em movimento

npm run devCarregue o novo modelo.

- Faça o download do arquivo de modelo que deseja usar (por exemplo, do Hugging Face) e coloque-o no diretório do projeto (consulte

- Dicas e truques

- Certifique-se de que o modelo seja compatível com o WebGPU e o WebAssembly.

- Se você não conhece o código, levante um problema no GitHub.

- cenário do aplicativo

- Teste de novos modelos, desenvolvimento de aplicativos de IA personalizados.

O código de exemplo usa

Geração de texto

- Apresentando o BrowserAI ao projeto:

import { BrowserAI } from '@browserai/browserai'; const ai = new BrowserAI(); await ai.loadModel('llama-3.2-1b-instruct'); const response = await ai.generateText('你好,今天天气如何?'); console.log(response);

conversão de voz em texto

- Gravar e transcrever áudio:

const ai = new BrowserAI(); await ai.loadModel('whisper-tiny-en'); await ai.startRecording(); const audio = await ai.stopRecording(); const text = await ai.transcribeAudio(audio); console.log(text);

advertência

- performancesModelos grandes (por exemplo

Llama-3.2-3b) São necessários computadores de alto nível, e modelos pequenos são recomendados para o nível mais baixo. - Uso off-lineO modelo funciona mesmo se você se desconectar da Internet após o primeiro carregamento, mas é necessário fazer o download do modelo com antecedência.

- Suporte à comunidadeProblemas podem ser adicionados Discórdia sondagem Arquivo (de computador).

O BrowserAI é simples e avançado. Basta seguir as etapas para configurar seu ambiente e experimentar a conveniência da IA local em seu navegador.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...