Auto-Deep-Research: colaboração de vários agentes para realizar consultas à literatura e gerar relatórios de pesquisa

Introdução geral

O Auto-Deep-Research é uma ferramenta de IA de código aberto desenvolvida pelo Laboratório de Inteligência de Dados da Universidade de Hong Kong (HKUDS) para ajudar os usuários a automatizar tarefas de pesquisa profunda. Ela foi desenvolvida com base na estrutura do AutoAgent e oferece suporte a uma variedade de modelos de linguagem grande (LLMs), como OpenAI, Anthropic, Deepseek e Grok etc., capaz de lidar com interações complexas de dados de arquivos e pesquisas na Web. Em contraste com as ferramentas de alto custo que exigem uma assinatura, como o Deep Research da OpenAI, o Auto-Deep-Research é totalmente gratuito, e os usuários só precisam fornecer sua chave de API LLM para usá-lo. Conhecida por seu alto desempenho e flexibilidade, a ferramenta teve um bom desempenho nos benchmarks GAIA e é adequada para pesquisadores, desenvolvedores ou usuários que precisam de uma solução de pesquisa eficiente.

Lista de funções

- Estudos detalhados automatizadosPesquisa e coleta automaticamente informações relevantes para gerar relatórios detalhados com base nos tópicos inseridos pelo usuário.

- Suporte a vários modelosCompatível com uma variedade de modelos de idiomas grandes, os usuários podem escolher o modelo apropriado de acordo com suas necessidades.

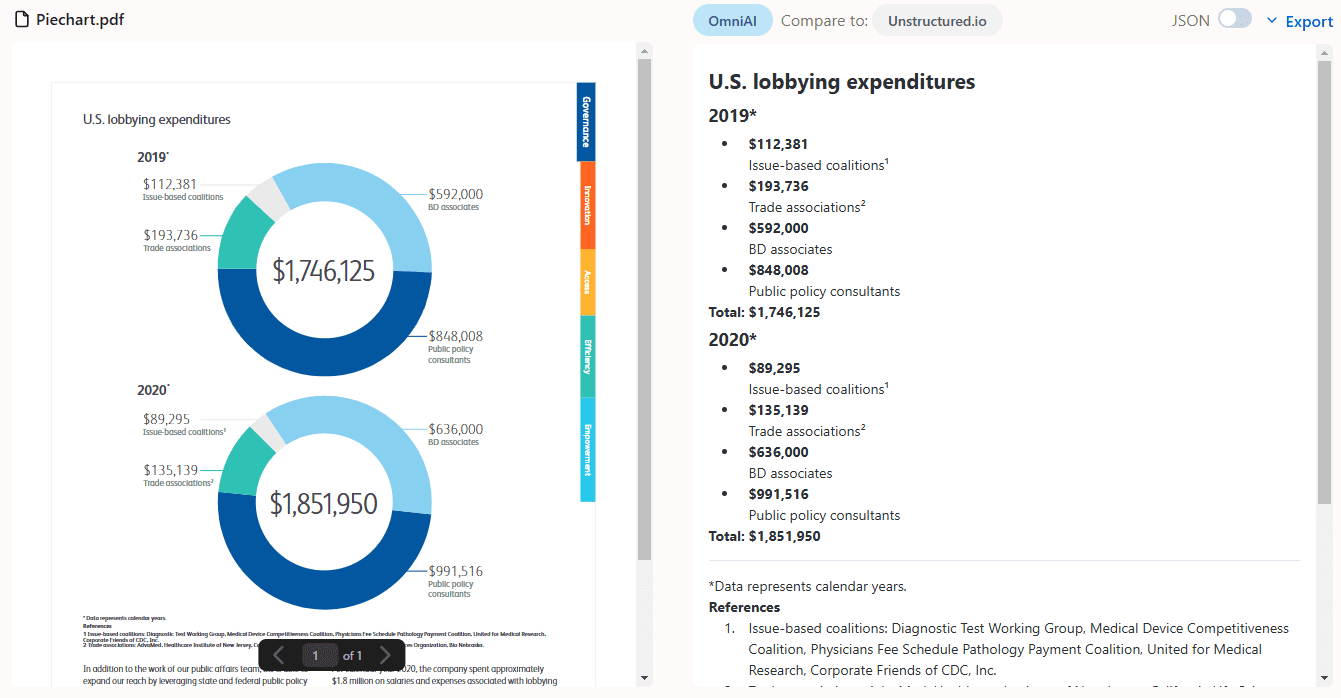

- Interação de dados de arquivosSuporte para upload e processamento de imagens, PDFs, arquivos de texto, etc. para aprimorar as fontes de dados para pesquisa.

- partida com um toqueNão é necessária nenhuma configuração complexa, basta digitar comandos simples e você estará pronto para trabalhar em pouco tempo.

- Recurso de pesquisa na WebCombinação de recursos da Web e dados de mídia social (por exemplo, Plataforma X) para fornecer informações mais abrangentes.

- Código aberto e gratuitoCódigo-fonte completo: O código-fonte completo é fornecido para que os usuários possam personalizar a funcionalidade ou implementar em um ambiente local.

Usando a Ajuda

Processo de instalação

A instalação do Auto-Deep-Research é simples e intuitiva e depende muito dos ambientes Python e Docker. Aqui estão as etapas em detalhes:

1. preparação ambiental

- Instalação do PythonVerifique se o Python 3.10 ou posterior está instalado em seu sistema. Recomendado

condaCrie um ambiente virtual:conda create -n auto_deep_research python=3.10 conda activate auto_deep_research

- Instalando o DockerComo a ferramenta usa o ambiente de tempo de execução em contêineres do Docker, faça o download e instale o Docker Desktop primeiro; não há necessidade de extrair imagens manualmente, a ferramenta tratará disso automaticamente.

2. download do código-fonte

- Clonar um repositório do GitHub localmente:

git clone https://github.com/HKUDS/Auto-Deep-Research.git cd Auto-Deep-Research

3. instalação de dependências

- Instale os pacotes Python necessários executando o seguinte comando no diretório do projeto:

pip install -e .

4. configurar a chave da API

- No diretório raiz do projeto, copie o arquivo de modelo e edite-o:

cp .env.template .env - Abrir com um editor de texto

.envpreencha a chave de API do LLM conforme necessário, por exemplo:OPENAI_API_KEY=your_openai_key DEEPSEEK_API_KEY=your_deepseek_key XAI_API_KEY=your_xai_keyObservação: nem todas as chaves são necessárias, basta configurar o modelo de chave que planeja usar.

5. ferramentas de inicialização

- Digite o seguinte comando para iniciar o Auto-Deep-Research:

auto deep-research - Configurações de parâmetros opcionais, como a especificação de um nome ou modelo de contêiner:

auto deep-research --container_name myresearch --COMPLETION_MODEL grok

Funções principais

Estudos detalhados automatizados

- Insira um tópico de pesquisaNa inicialização, a ferramenta solicita um tópico de pesquisa, como "Artificial Intelligence in Healthcare".

- execução automáticaFerramenta de análise de informações relevantes: A ferramenta analisa informações relevantes usando pesquisas na Web e modelos incorporados sem intervenção do usuário.

- Geração de relatóriosQuando terminar, os resultados serão enviados para o terminal no formato Markdown ou salvos como um arquivo contendo a fonte e a análise detalhada.

Interação de dados de arquivos

- Carregamento de arquivosEspecifique o caminho do arquivo na linha de comando, por exemplo:

auto deep-research --file_path ./my_paper.pdf - Processamento de dadosFerramenta de análise: A ferramenta analisa o conteúdo do PDF, da imagem ou do texto e o incorpora ao estudo.

- análise combinadaDados de arquivos carregados: os dados de arquivos carregados são integrados aos resultados de pesquisa na Web para fornecer conclusões mais abrangentes.

Seleção de um modelo de idioma grande

- Exibir modelos de suporteSuporte para OpenAI, Grok, Deepseek, etc. Consulte a documentação do LiteLLM para obter os nomes dos modelos.

- Especificação de modelosAdicionar parâmetros ao comando de inicialização, por exemplo:

auto deep-research --COMPLETION_MODEL deepseek - teste operacionalAjuste as opções para otimizar a experiência com base no desempenho do modelo e na capacidade de resposta da API.

Funções em destaque

Experiência One Touch Start

- Em vez de configurar manualmente uma imagem do Docker ou parâmetros complexos, basta executar o comando

auto deep-researchA ferramenta extrairá automaticamente o ambiente necessário e o iniciará. - Se for necessário personalizar, isso pode ser feito por meio do

--container_nameContêineres nomeados por parâmetro para facilitar o gerenciamento de várias instâncias.

Pesquisa na Web e integração com mídias sociais

- A ferramenta tem uma função integrada de pesquisa na Web que rastreia automaticamente o conteúdo da Web. Se quiser incorporar dados da plataforma X, você pode mencionar palavras-chave no tópico de pesquisa e a ferramenta tentará pesquisar publicações relevantes.

- Exemplo: digite "latest AI research trends" (últimas tendências de pesquisa em IA) e os resultados poderão conter links para discussões e blogs de tecnologia de X usuários.

advertência

- Segurança da chave de API: Não coloque

.envO arquivo é carregado em um repositório público para evitar a divulgação da chave. - ambiente de redeVerifique se o Docker e as conexões de rede estão funcionando corretamente, pois isso pode afetar a funcionalidade de busca ou extração de imagens.

- otimização do desempenhoSe o hardware local for limitado, é recomendável usar o LLM baseado em nuvem para evitar a execução de modelos grandes que causam atraso.

Com essas etapas, os usuários podem começar a usar facilmente o Auto-Deep-Research, uma ferramenta que oferece suporte eficiente para pesquisa acadêmica e exploração técnica.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...