AssemblyAI: Plataforma de análise de inteligência de áudio e fala para texto de alta precisão

Introdução geral

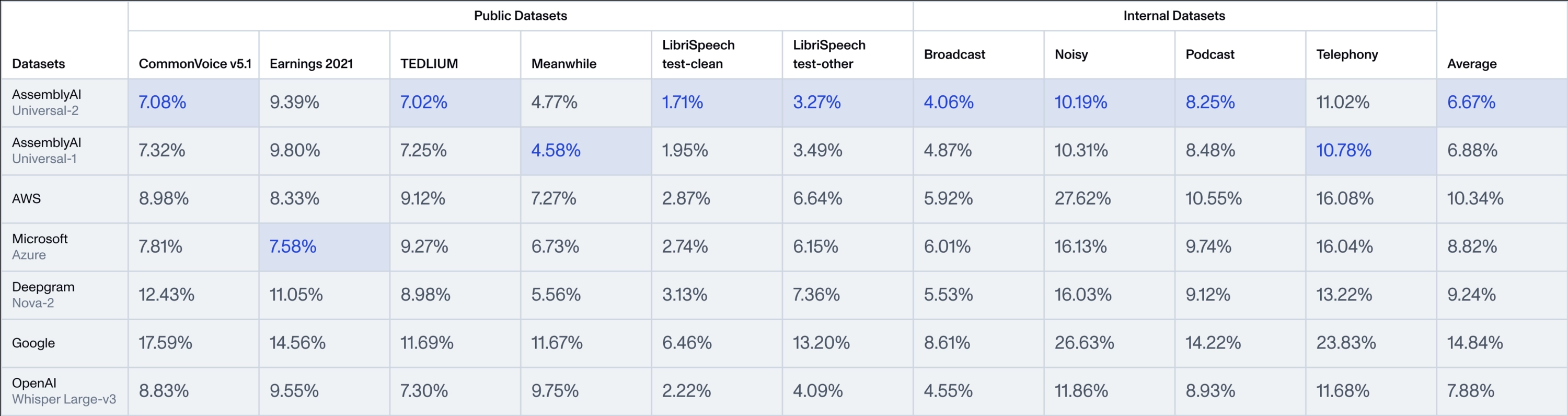

A AssemblyAI é uma plataforma focada na tecnologia de IA de fala, fornecendo aos desenvolvedores e às empresas ferramentas eficientes de análise de áudio e de fala para texto. O principal destaque é a série de modelos Universal, especialmente o recém-lançado Universal-2, que é o modelo de fala para texto mais avançado da AssemblyAI até o momento. O universal-2 baseia-se no Universal-1, com mais de 12,5 milhões de horas de dados de treinamento de áudio multilíngue, e é capaz de capturar com precisão a complexidade de conversas reais e fornecer dados de áudio altamente precisos. O Universal-2 baseia-se no Universal-1 com mais de 12,5 milhões de horas de dados de treinamento de áudio multilíngue para capturar com precisão a complexidade do diálogo real e fornecer dados de áudio altamente precisos. Em comparação com o Universal-1, o Universal-2 melhora 241 TP3T no reconhecimento de nomes próprios (por exemplo, nomes, marcas), 211 TP3T em conteúdo numérico-alfabético misto (por exemplo, números de telefone, caixas de correio) e 151 TP3T na formatação de texto (por exemplo, pontuação, letras maiúsculas), reduzindo significativamente a precisão da "última milha" do modelo tradicional. "O AssemblyAI abre essas tecnologias de ponta para usuários globais por meio de APIs fáceis de usar e tem sido usado pelo Spotify, Fireflies e outras empresas para criar produtos de fala inteligentes que abrangem áreas como gravação de reuniões e análise de conteúdo.

Lista de funções

- conversão de voz em textoConverta arquivos de áudio ou fluxos de áudio ao vivo em texto de alta precisão, com suporte a vários idiomas e formatos de áudio.

- Detecção de alto-falanteIdentificação automática de diferentes alto-falantes no áudio para cenários de diálogo com várias pessoas.

- Análise de sentimentoAnálise de tendências emocionais na fala, como positivas, negativas ou neutras, para aprimorar a experiência do usuário.

- transcrição em tempo realFuncionalidade de fala para texto em tempo real de baixa latência, adequada para agentes de voz ou legendas ao vivo.

- Modelagem de inteligência de áudioInclui recursos avançados, como revisão de conteúdo, detecção de tópicos, pesquisa de palavras-chave e muito mais.

- Estrutura LeMURProcessamento de texto transcrito usando um modelo de linguagem em grande escala, com suporte para geração de resumo, perguntas e respostas e muito mais.

- Geração de subtítulosSuporte à exportação de arquivos de legenda no formato SRT ou VTT para facilitar a criação de conteúdo de vídeo.

- Privacidade de PIIIdentificação e bloqueio automático de informações confidenciais no áudio, como nomes ou números de telefone.

Usando a Ajuda

O AssemblyAI é um serviço de API baseado em nuvem que não requer instalação local para usar seus recursos avançados. Aqui está um guia detalhado para ajudá-lo a começar e a se aprofundar em seus recursos.

Registro e obtenção de chaves de API

- Visite o site oficialAbra seu navegador e digite

https://www.assemblyai.com/Vá para a página inicial. - Registrar uma contaClique em "Sign Up" (Registrar-se) no canto superior direito e digite seu e-mail e senha para concluir o registro. Depois de se registrar, você entrará automaticamente no Dashboard.

- Obter a chaveChave de API: Localize a área "Chave de API" no painel e clique em "Copiar" para copiar a chave. Essa é a única credencial para chamar a API e deve ser mantida em segurança.

- Avaliação gratuitaCrédito gratuito para novos usuários, sem necessidade de vincular métodos de pagamento imediatamente.

Operação da função principal

O núcleo do AssemblyAI é a integração de sua API, e o seguinte é um exemplo de como usar a família de modelos Universal em Python. Você também pode usar outras linguagens (por exemplo, Java, Node.js) consultando a documentação no site.

Conversão de fala em texto (Universal-2)

- preliminarVerifique se há um arquivo de áudio (por exemplo

sample.mp3) ou link de URL. - Instalação do SDKExecuta no terminal:

pip install assemblyai

- exemplo de código::

import assemblyai as aai

aai.settings.api_key = "你的API密钥" # 替换为你的密钥

transcriber = aai.Transcriber()

transcript = transcriber.transcribe("sample.mp3")

print(transcript.text) # 输出文本,如“今天天气很好。”

- Pontos fortes da Universal-2Universal-2: Por padrão, é usado o modelo Universal-2, que reconhece nomes próprios (por exemplo, "Zhang Wei") e números formatados (por exemplo, "6 March 2025") com mais precisão do que o Universal-1, geralmente em questão de segundos. O tempo de processamento geralmente é de apenas alguns segundos.

transcrição em tempo real

- Cenários aplicáveisTransmissão ao vivo, teleconferência e outras necessidades em tempo real.

- exemplo de código::

from assemblyai import RealtimeTranscriber import asyncio async def on_data(data): print(data.text) # 实时输出文本 transcriber = RealtimeTranscriber( api_key="你的API密钥", sample_rate=16000, on_data=on_data ) async def start(): await transcriber.connect() await transcriber.stream() # 开始接收音频流 asyncio.run(start()) - fluxo de trabalhoO recurso de baixa latência do Universal-2 garante resultados rápidos e precisos.

Detecção de alto-falante

- Método de ativação::

config = aai.TranscriptionConfig(speaker_labels=True) transcript = transcriber.transcribe("sample.mp3", config=config) for utterance in transcript.utterances: print(f"说话人 {utterance.speaker}: {utterance.text}") - Exemplos de resultados::

说话人 A: 你好,今天会议几点? 说话人 B: 下午两点。 - chamar a atenção para algoUniversal-2: o Universal-2 tem um desempenho mais consistente em conversas com várias pessoas e reduz a confusão.

Análise de sentimento

- Método de ativação::

config = aai.TranscriptionConfig(sentiment_analysis=True) transcript = transcriber.transcribe("sample.mp3", config=config) for result in transcript.sentiment_analysis: print(f"文本: {result.text}, 情感: {result.sentiment}") - Exemplos de resultados::

文本: 我很喜欢这个产品, 情感: POSITIVE 文本: 服务有点慢, 情感: NEGATIVE

Geração de subtítulos

- código operacional::

transcript = transcriber.transcribe("sample.mp3") with open("captions.srt", "w") as f: f.write(transcript.export_subtitles_srt()) - no final: Gerar

.srtque pode ser importado diretamente para um software de edição de vídeo.

Recursos: Estrutura LeMUR

- Introdução à funçãoLeMUR: o LeMUR processa os resultados da transcrição em conjunto com um grande modelo de linguagem, por exemplo, para gerar resumos.

- procedimento::

- Obter um ID de transcrição:

transcript = transcriber.transcribe("sample.mp3") transcript_id = transcript.id - Gerar um resumo:

from assemblyai import Lemur lemur = Lemur(api_key="你的API密钥") summary = lemur.summarize(transcript_id) print(summary.response) - Exemplo de saída: "O progresso do projeto foi discutido na reunião e está programado para ser concluído na próxima semana."

- Obter um ID de transcrição:

advertência

- Formatos suportadosCompatível com 33 formatos de áudio/vídeo, como MP3, WAV, etc.

- Configurações de idioma: Mais de 99 idiomas são suportados e podem ser acessados por meio de

language_code="zh"Especifique o chinês. - faturamentoCobrado por hora de áudio, consulte o site oficial para obter os preços.

Seguindo essas etapas, você poderá aproveitar ao máximo os recursos avançados do Universal-2 para criar aplicativos de voz eficientes.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...