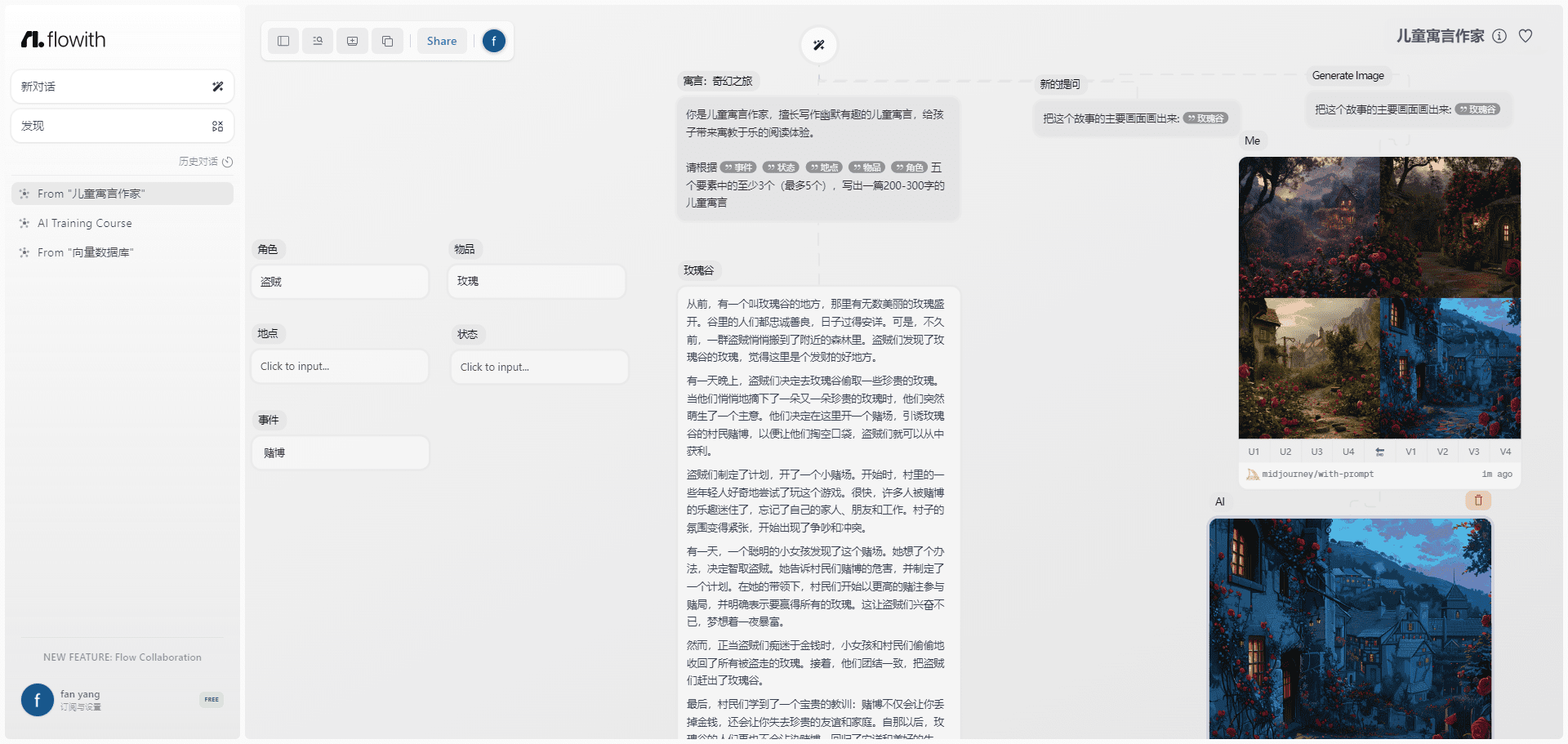

A Snowflake lança o Arctic Embed 2.0 Multilingual Vector Model para pesquisas em chinês de alta qualidade

A Snowflake tem o prazer de anunciar o lançamento do Arctic Embed L 2.0 responder cantando Arctic Embed M 2.0 O Arctic Embed 2.0, que é a próxima iteração do nosso modelo de incorporação de ponta, agora pode oferecer suporte à pesquisa multilíngue. Embora nossas versões anteriores tenham sido bem recebidas por nossos clientes, parceiros e pela comunidade de código aberto, e tenham alcançado milhões de downloads, temos recebido uma solicitação: vocês podem tornar esse modelo multilíngue? O Arctic Embed 2.0 se baseia na sólida base de nossas versões anteriores, adicionando suporte multilíngue sem sacrificar o desempenho ou a escalabilidade em inglês para atender às necessidades de uma comunidade de usuários mais ampla, que abrange uma ampla gama de idiomas e aplicativos. mais ampla de usuários, que abrange uma grande variedade de idiomas e aplicativos.

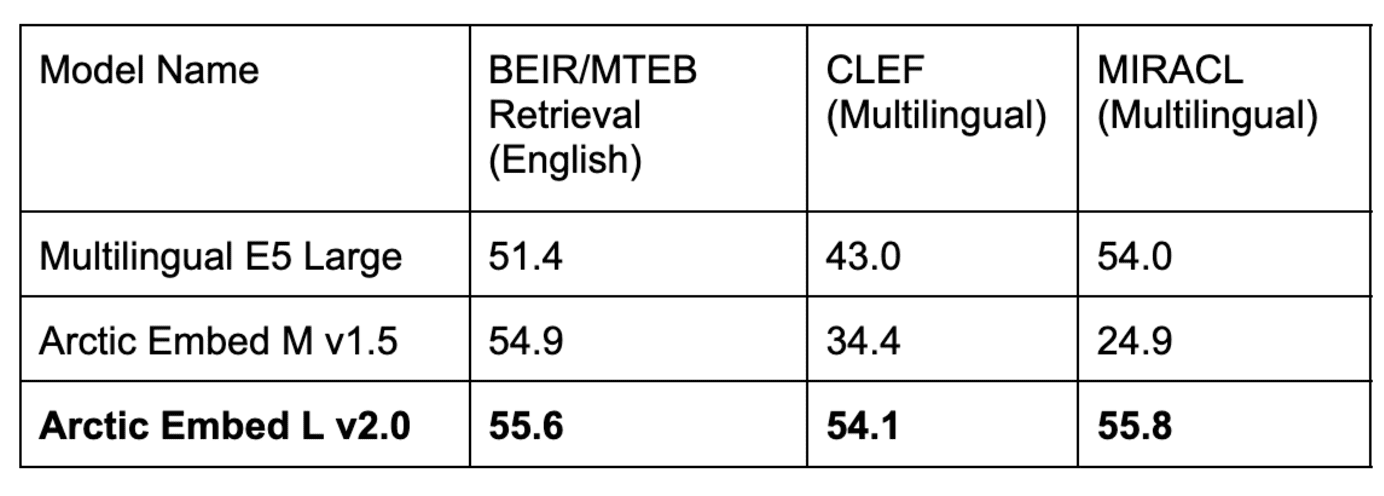

Fig. 1: Desempenho de recuperação unidirecional com uso intensivo de volume de um modelo de incorporação multilíngue de código aberto com menos de 1 bilhão de parâmetros. As pontuações são MTEB Recuperação e o nDCG@10 médio no subconjunto do CLEF (ELRA, 2006) (abrangendo inglês, francês, espanhol, italiano e alemão).

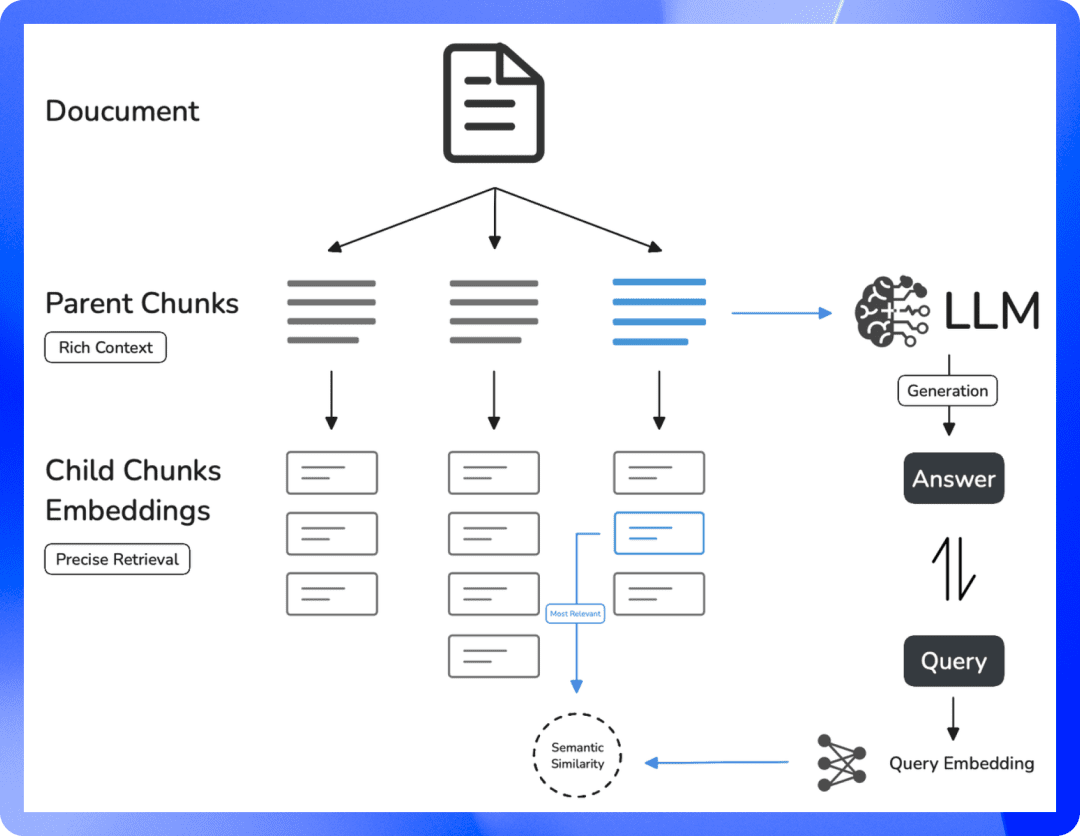

Multilinguismo sem compromisso

Nesta versão do Arctic Embed 2.0, estamos lançando duas variantes disponíveis, uma variante média com foco na eficiência da inferência, que é construída com base no GTE-multilíngue Além disso, com 305 milhões de parâmetros (dos quais 113 milhões não estão incorporados), outra grande variante se concentra na qualidade da recuperação e foi criada com base no XMLR-Grande além da variante de contexto longo com 568 milhões de parâmetros (dos quais 303 milhões não estão incorporados). Ambos os tamanhos suportam até 8.192 Token comprimento do contexto. Ao criar o Arctic Embed 2.0, reconhecemos um desafio enfrentado por muitos modelos multilíngues existentes: a otimização para vários idiomas geralmente acaba sacrificando a qualidade da recuperação em inglês. Isso fez com que muitos modelos no campo tivessem duas variantes para cada versão: inglês e multilíngue. Os modelos do Arctic Embed 2.0 são diferentes. Eles oferecem desempenho superior em idiomas que não sejam o inglês, como alemão, espanhol e francês, além de superarem seus antecessores que falam apenas inglês na recuperação em inglês. Arctic Embed M 1.5.

Equilibrando cuidadosamente a necessidade de multilinguismo com o compromisso da Snowflake com a excelência na recuperação do idioma inglês, criamos o Arctic Embed 2.0 para ser um modelo universal de força de trabalho para uma ampla gama de casos de uso global. Ao longo deste documento, todas as avaliações qualitativas se referem às pontuações médias do NDCG@10 em todas as tarefas, salvo indicação em contrário.

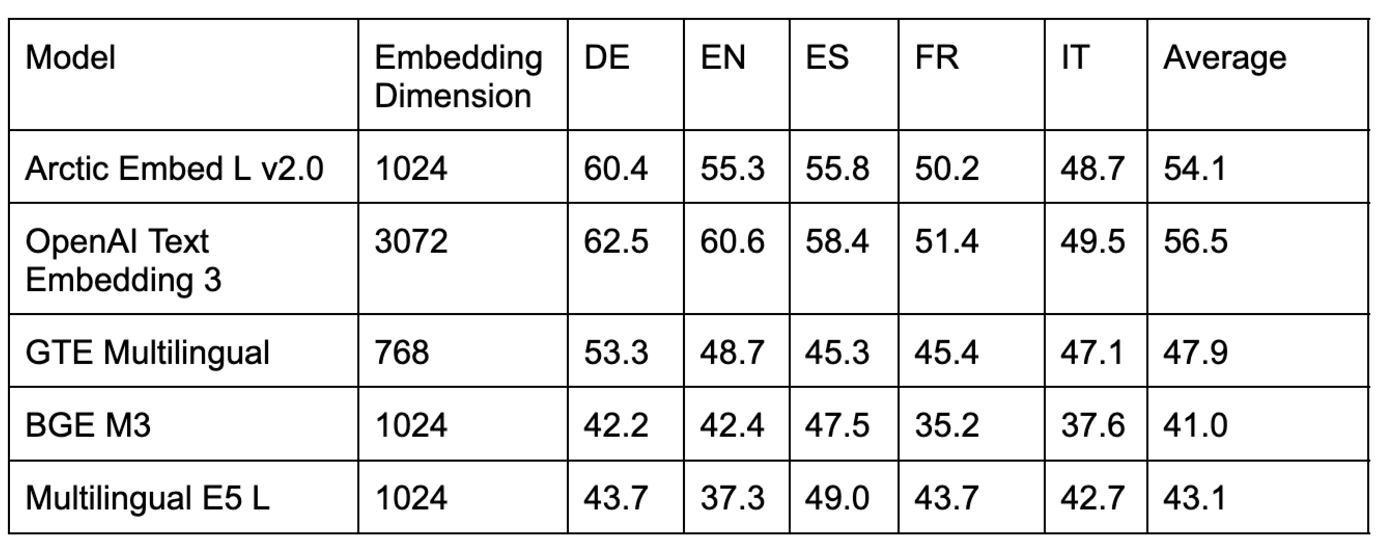

Tabela 1. Nosso modelo Arctic Embed L v2.0 alcança altas pontuações no popular benchmark MTEB Retrieval em inglês, bem como alta qualidade de recuperação em vários benchmarks multilíngues. As iterações anteriores do Arctic Embed tiveram um bom desempenho em inglês, mas um desempenho ruim em multilíngue, enquanto os modelos multilíngues populares de código aberto diminuíram o desempenho em inglês. O desempenho em inglês diminuiu. Todas as pontuações de modelos e conjuntos de dados refletem a média do NDCG@10. As pontuações do CLEF e do MIRACL refletem a média do alemão (DE), inglês (EN), espanhol (ES), francês (FR) e italiano (IT).

O conjunto de recursos diversificado e avançado do Arctic Embed 2.0

- Taxa de transferência e eficiência de classe empresarial: O modelo Arctic Embed 2.0 foi desenvolvido para atender às necessidades de empresas de grande porte. Mesmo o nosso modelo "grande" tem parâmetros bem abaixo de um bilhão e oferece incorporação rápida e de alto rendimento. Com base em testes internos, ele processa facilmente mais de 100 documentos por segundo (em média) em GPUs NVIDIA A10 e atinge menos de 10 milissegundos de latência de incorporação de consulta, permitindo a implementação no mundo real com hardware acessível.

- Qualidade de pesquisa sem comprometimento em inglês e em outros idiomas: Apesar de seu tamanho compacto, ambos os modelos do Arctic Embed 2.0 obtiveram pontuações NDCG@10 impressionantes em uma variedade de conjuntos de dados de referência em inglês e em outros idiomas, demonstrando sua boa capacidade de generalização, mesmo para idiomas não incluídos na solução de treinamento. Essas impressionantes pontuações de referência fazem do Arctic Embed L 2.0 um líder entre os modelos de recuperação de ponta.

- Recuperação dimensionável por meio do aprendizado de representação Matryoshka (MRL): A versão 2.0 do Arctic Embed inclui a mesma funcionalidade de MRL de fácil quantificação introduzida no Arctic Embed 1.5, permitindo que os usuários reduzam os custos e otimizem o tamanho ao realizar pesquisas em grandes conjuntos de dados. Com dois tamanhos de modelo, os usuários podem realizar pesquisas de alta qualidade usando apenas 128 bytes por vetor (96 vezes menor do que a incorporação não compactada do popular modelo de incorporação de texto-3-large da OpenAI ^1^). Assim como o Arctic Embed 1.5, o modelo Arctic Embed 2.0 também supera o desempenho de vários pares habilitados para MRL em um estado compactado, com degradação de qualidade significativamente menor e pontuações de benchmark mais altas.

- Verdadeiramente de código aberto: O modelo Arctic Embed 2.0 é lançado sob a generosa licença Apache 2.0.

A flexibilidade do código aberto encontra a confiabilidade de classe empresarial

Assim como seus antecessores, os modelos do Arctic Embed 2.0 são lançados sob a generosa licença Apache 2.0, permitindo que as organizações modifiquem, implementem e ampliem sob licenças conhecidas. Esses modelos funcionam imediatamente, oferecem suporte a aplicativos em vários setores por meio da incorporação confiável em vários idiomas e têm bons recursos de generalização.

Clément Delangue, CEO da Hugging Face, disse: "Os modelos de incorporação multilíngue são essenciais para permitir que pessoas de todo o mundo, não apenas falantes de inglês, se tornem criadores de IA. Ao liberar esses modelos de última geração como código aberto na Hugging Face, a Snowflake está fazendo uma enorme contribuição para a IA e para o mundo."

De fato, especialmente entre as opções de código aberto, a família Arctic Embed 2.0 merece atenção especial por seus recursos de generalização observados em benchmarks de pesquisa multilíngue. Ao licenciar Conjunto de testes do CLEF (Cross-Language Evaluation Forum) de 2000 a 2003Com o objetivo de medir a qualidade da recuperação fora do domínio de vários modelos de código aberto, nossa equipe encontrou uma tendência infeliz com a recuperação dentro do domínio. MIRACL desempenho ruim em comparação com as pontuações obtidas no conjunto de avaliação. Nossa hipótese é que alguns dos primeiros desenvolvedores de modelos de código aberto podem ter, inadvertidamente, ajustado demais seus cenários de treinamento para melhorar o desempenho do MIRACL em detrimento do desempenho do MIRACL e, portanto, podem ter ajustado demais os dados de treinamento do MIRACL. Fique atento a um relatório técnico futuro sobre como o modelo Arctic Embed 2.0 foi treinado e o que aprendemos durante o processo de treinamento.

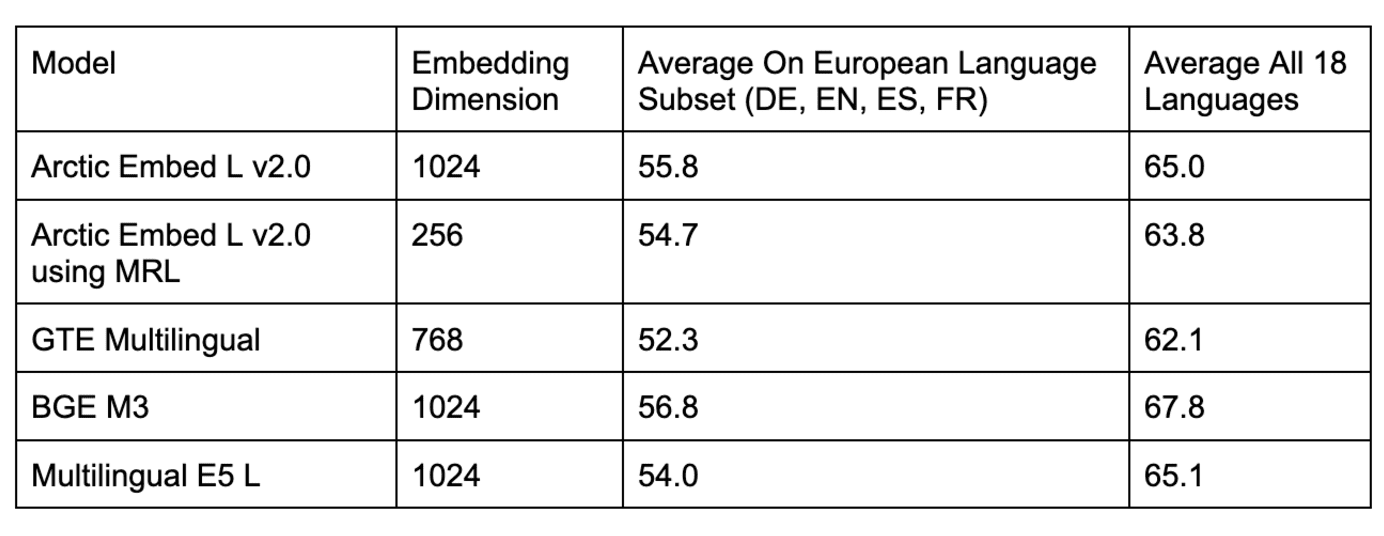

Tabela 2: Comparação de modelos de recuperação multilíngue em vários conjuntos de dados do benchmarking CLEF fora do domínio.

Tabela 3: Comparação de vários modelos de recuperação multilíngue de código aberto no benchmarking MIRACL no domínio.

Conforme mostrado nas Tabelas 2 e 3, vários modelos populares de código aberto para avaliação do MIRACL intra-domínio são comparados com o Arctic Embed L 2.0 As pontuações do Arctic L 2.0 são comparáveis, mas o desempenho é ruim nas avaliações do CLEF fora do domínio. Também comparamos modelos populares de código fechado (por exemplo, o modelo text-embedding-3-large da OpenAI) e descobrimos que o desempenho do Arctic L 2.0 está alinhado com os principais modelos proprietários.

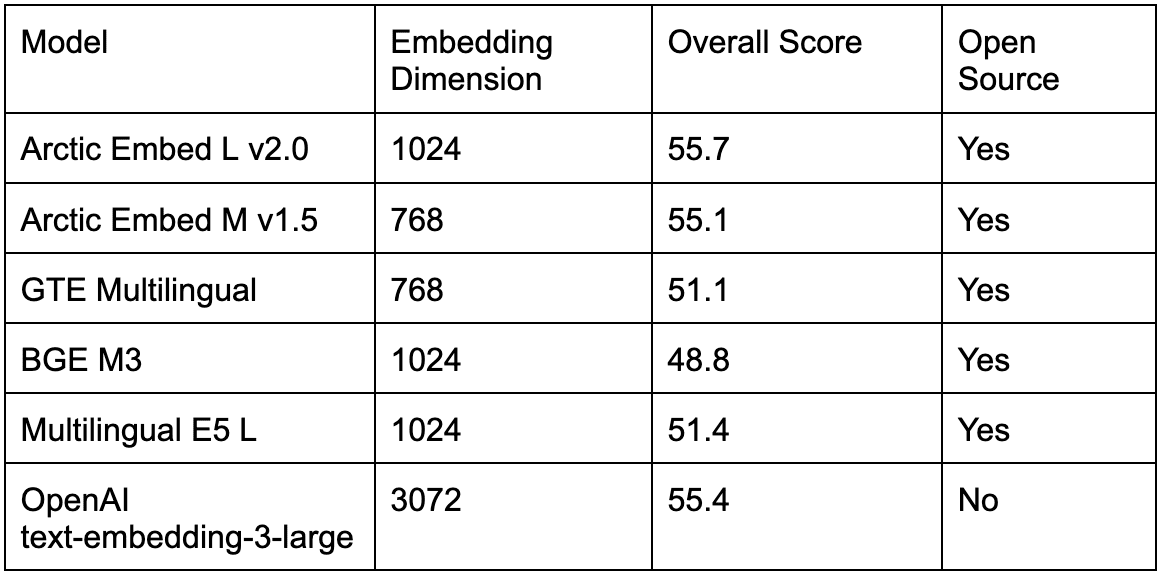

Conforme mostrado na Tabela 4, os modelos multilíngues de código aberto existentes também são melhores no popular teste de referência de recuperação de MTEBs em inglês do que os modelos de código aberto de código aberto. Arctic Embed L 2.0 O resultado foi ainda pior, forçando os usuários que queriam oferecer suporte a vários idiomas a escolher entre uma qualidade de recuperação inferior em inglês ou o aumento da complexidade operacional de usar um segundo modelo para recuperação somente em inglês. Com o lançamento do Arctic Embed 2.0, os profissionais agora podem mudar para um único modelo de código aberto sem sacrificar a qualidade da recuperação em inglês.

Tabela 4: Comparação de vários dos principais modelos de recuperação multilíngue de código aberto e fechado no benchmarking de recuperação de MTEB no domínio.

Compactação e eficiência sem compensações

A Snowflake continua a priorizar a eficiência e a escala em seu projeto de modelo incorporado. Com a ajuda de Arctic Embed L 2.0Isso permite que os usuários compactem os recursos de qualidade de modelos grandes em incorporações compactas que exigem apenas 128 bytes de armazenamento por vetor. Isso possibilita o fornecimento de serviços de recuperação para milhões de documentos a baixo custo em hardware de baixo custo. Também obtivemos eficiência na taxa de transferência de incorporação ao compactar a impressionante qualidade de recuperação do Arctic Embed 2.0 em 100 milhões e 300 milhões de parâmetros não incorporados para seus dois tamanhos (médio e grande), respectivamente - apenas um pequeno aumento em relação à nossa versão anterior somente em inglês.

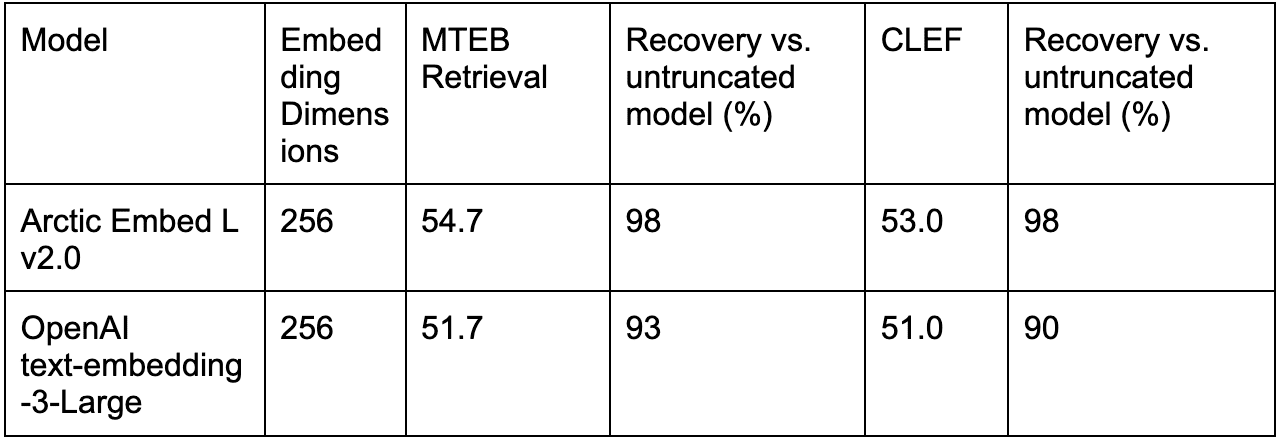

De fato, os mecanismos focados em escala são Arctic Embed L 2.0 Onde ele realmente se destaca, ele alcança melhor qualidade sob compressão em comparação com outros modelos treinados em MRL (por exemplo, text-embedding-3-large da OpenAI).

A Tabela 5 compara o desempenho da incorporação de texto-3-large da OpenAI com a incorporação truncada com o Arctic Embed L 2.0 para somente inglês (MTEB Retrieval) e multilíngue (CLEF).

Conclusão: um novo padrão para pesquisa multilíngue e eficiente

Com o Arctic Embed 2.0, a Snowflake estabeleceu um novo padrão para modelos de incorporação eficientes e multilíngues. Além disso, tornamos as fronteiras da qualidade de incorporação de texto não apenas eficientes, mas também ganhamos código aberto solto. Se o seu objetivo é expandir o alcance para usuários multilíngues, reduzir os custos de armazenamento ou incorporar documentos em hardware acessível, o Arctic Embed 2.0 oferece os recursos e a flexibilidade para atender às suas necessidades.

Nossos próximos relatórios técnicos se aprofundarão nas inovações por trás do Arctic Embed 2.0. Enquanto isso, convidamos você a começar a incorporar com o Snowflake hoje mesmo.

^1^ Esse cálculo usa o formato float32 para a linha de base não compactada, ou seja, 3.072 números de 32 bits cada, para um total de 98.304 bits por vetor, que é exatamente 96 vezes maior do que os 1.024 bits por vetor (equivalente a 128 bytes por vetor) usados ao armazenar vetores de 256 dimensões truncados pelo MRL no modelo Arctic Embed 2.0 no formato int4.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...