Archon: uma estrutura de desenvolvimento para criar e otimizar inteligências de IA de forma autônoma

Introdução geral

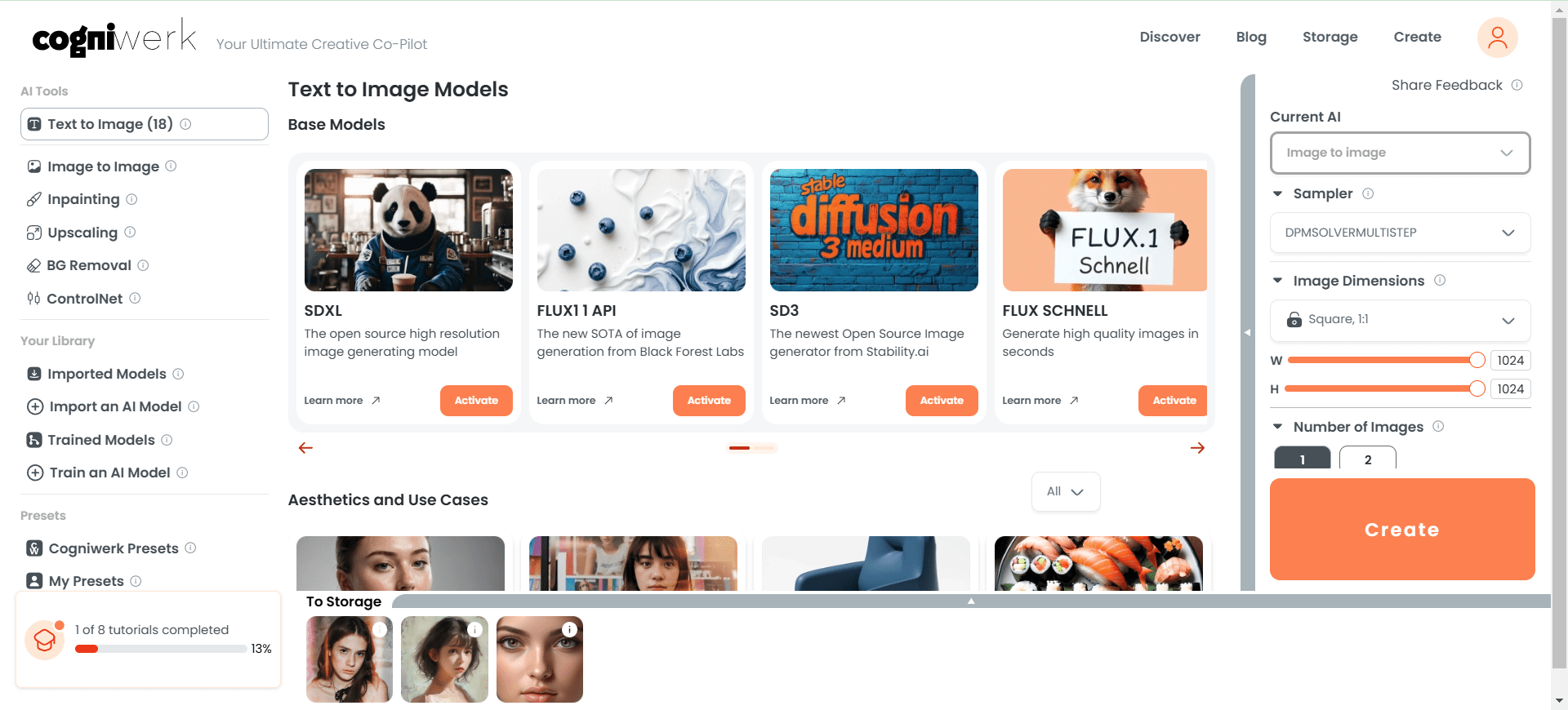

O Archon é o primeiro projeto "Agenteer" do mundo criado pelo desenvolvedor Cole Medin (nome de usuário do GitHub coleam00) - uma estrutura de código aberto focada na criação, otimização e iteração autônomas de inteligências de IA. É uma estrutura de código aberto que se concentra na criação autônoma e na iteração de inteligências de IA. É uma ferramenta prática para desenvolvedores e uma plataforma educacional para demonstrar a evolução dos sistemas corporais inteligentes. O Archon, atualmente na versão V4, usa uma interface de usuário Streamlit totalmente otimizada para fornecer uma interface de gerenciamento intuitiva. Desenvolvido em Python, o projeto integra tecnologias como Pydantic AI, LangGraph e Supabase para evoluir da simples geração de inteligência para a colaboração complexa do fluxo de trabalho. O Archon demonstra os três princípios do desenvolvimento moderno de IA: raciocínio inteligente, incorporação de conhecimento e arquitetura extensível por meio de planejamento, loops de feedback e integração de conhecimento de domínio.

O Archon é o que eu gosto de chamar de "parasita" de outras estruturas de desenvolvimento de inteligência: ele pode criar e otimizar outras estruturas de desenvolvimento de inteligência, mas também é uma inteligência em si.

Lista de funções

- Geração automática de inteligênciasGeração de códigos de corpo de inteligência de IA personalizados com base nos requisitos de entrada do usuário.

- Rastreamento e indexação de documentosRastreamento de documentos, como o Pydantic AI, gerando embeddings de vetores e armazenando-os no Supabase.

- Suporte ao sistema RAGUtilização de técnicas de geração aprimoradas por pesquisa para fornecer sugestões e otimizações precisas de código.

- Gerenciamento da interface do usuário do StreamlitConfigure variáveis de ambiente, bancos de dados e serviços de corpo inteligente por meio de uma interface visual.

- colaboração de inteligência múltiplaBaseado em LangGraph Possibilitando fluxos de trabalho coordenados para raciocínio, codificação e roteamento de tarefas.

- Compatível com local e nuvemSuporte para APIs OpenAI, Anthropic, OpenRouter ou nativas Ollama Modelos.

- Implantação em contêineres do DockerFornece o contêiner principal e MCP Contêineres para garantir que os ambientes de produção estejam prontos para uso imediato.

- Integração de MCPSuporte para integração com IDEs de IA (por exemplo, Windsurf, Cursor) para gerenciar arquivos e dependências.

- Suporte à comunidadeFornecer uma plataforma para comunicação com o usuário por meio do fórum oTTomator Think Tank.

Usando a Ajuda

O Archon é uma estrutura de código aberto rica em recursos, projetada para ajudar os usuários a desenvolver e gerenciar rapidamente as inteligências de IA. Aqui está um guia detalhado de instalação e uso para garantir que você possa começar facilmente.

Processo de instalação

O Archon V4 oferece suporte a dois métodos de instalação: Docker (recomendado) e instalação local do Python. Veja a seguir as etapas:

Caminho 1: instalação do Docker (recomendado)

- Preparação do ambiente

- Certifique-se de que o Docker e o Git estejam instalados.

- Obtenha uma conta do Supabase (para bancos de dados vetoriais).

- Prepare a chave de API do OpenAI/Anthropic/OpenRouter ou execute o Ollama localmente.

- armazém de clones

É executado no terminal:git clone https://github.com/coleam00/archon.git cd archon

- Execução de um script do Docker

Execute o seguinte comando para criar e iniciar o contêiner:python run_docker.py- O script cria automaticamente dois contêineres: o contêiner principal do Archon (que executa a interface do usuário do Streamlit e os serviços do Graph) e o contêiner do MCP (que oferece suporte à integração do IDE de IA).

- se presente

.envas variáveis de ambiente serão carregadas automaticamente.

- interface de acesso

Abra seu navegador e acessehttp://localhost:8501Para fazer isso, acesse a interface do usuário do Streamlit.

Maneira 2: instalação local do Python

- Preparação do ambiente

- Certifique-se de que o Python 3.11+ esteja instalado.

- Obter a conta do Supabase e a chave da API.

- armazém de clones

git clone https://github.com/coleam00/archon.git cd archon - Criação de um ambiente virtual e instalação de dependências

python -m venv venv source venv/bin/activate # Windows: venv\Scripts\activate pip install -r requirements.txt - Iniciar a interface de usuário do Streamlit

streamlit run streamlit_ui.py - interface de acesso

Abra seu navegador e acessehttp://localhost:8501.

Configuração da variável de ambiente

Na primeira vez que você executar o Docker ou uma instalação local, será necessário configurar as variáveis de ambiente. Crie uma variável .env com exemplos de conteúdo:

OPENAI_API_KEY=your_openai_api_key

SUPABASE_URL=your_supabase_url

SUPABASE_SERVICE_KEY=your_supabase_service_key

PRIMARY_MODEL=gpt-4o-mini

REASONER_MODEL=o3-mini

Essas informações estão disponíveis no painel do Supabase e no provedor de API.

Função Fluxo de operação

Depois de instalada, a interface de usuário do Streamlit oferece cinco módulos funcionais principais que orientam você passo a passo na configuração e no uso.

1. ambiente

- procedimento::

- Vá para a guia "Environment" (Ambiente).

- Digite a chave da API (por exemplo, OpenAI ou OpenRouter) e as configurações do modelo (por exemplo

gpt-4o-mini). - Clique em "Save" (Salvar) e a configuração será armazenada no

env_vars.json.

- tomar nota deSe estiver usando o Ollama local, é necessário certificar-se de que o serviço esteja em execução no

localhost:11434O streaming da interface do usuário é compatível apenas com a OpenAI.

2. configurações do banco de dados (Database)

- procedimento::

- Vá para a guia "Database" (Banco de dados).

- Digite o URL do Supabase e a chave de serviço.

- Clique em "Initialise Database" (Inicializar banco de dados) e o sistema criará automaticamente o banco de dados.

site_pagesTabela. - Verifique o status da conexão para confirmar o sucesso.

- estrutura da tabela::

CREATE TABLE site_pages ( id UUID PRIMARY KEY DEFAULT uuid_generate_v4(), url TEXT, chunk_number INTEGER, title TEXT, summary TEXT, content TEXT, metadata JSONB, embedding VECTOR(1536) );

3. rastreamento e indexação de documentação (Documentação)

- procedimento::

- Vá para a guia "Documentation" (Documentação).

- Digite o URL do documento de destino (por exemplo, documento Pydantic AI).

- Clique em "Start Crawling" (Iniciar rastreamento) e o sistema agrupará os documentos, gerará incorporações e as armazenará no Supabase.

- Você pode visualizar o progresso da indexação na interface do usuário quando terminar.

- uso: para RAG O sistema fornece a base de conhecimento.

4. serviço de corpo inteligente (serviço de agente)

- procedimento::

- Vá para a guia "Agent Service".

- Clique em Start Service para executar o fluxo de trabalho do LangGraph.

- Monitore o status do serviço por meio de registros.

- funcionalidadeCoordenar o raciocínio, a codificação e o roteamento de tarefas para garantir que a lógica central da geração de inteligências funcione adequadamente.

5. criação de um corpo inteligente (Chat)

- procedimento::

- Vá para a guia "Chat".

- Insira um requisito, como "Gerar uma inteligência que analise arquivos JSON".

- O sistema combina o conhecimento recuperado pelo sistema RAG para gerar códigos e exibi-los.

- Copie o código para ser executado localmente ou implemente-o por meio de um serviço.

- exemplo típico::

Entrada: "Gerar um corpo inteligente que consulte o clima em tempo real".

Exemplo de saída:from pydantic_ai import Agent, OpenAIModel agent = Agent(OpenAIModel("gpt-4o-mini"), system_prompt="查询实时天气") result = agent.run("获取北京今天的天气") print(result.data)

Opcional: Configuração de MCP

- procedimento::

- Vá para a guia "MCP".

- Configure a integração com um IDE de IA, como o Cursor.

- Inicie o contêiner do MCP e conecte-se ao serviço do Graph.

- usoSuporte para criação automatizada de arquivos e gerenciamento de dependências no IDE para código smartbody.

exemplo de uso

Suponha que você queira desenvolver uma "Inteligência de análise de log":

- No Chat, digite: "Generate a Pydantic AI intelligence that parses Nginx logs" (Gerar uma inteligência de IA Pydantic que analisa os registros do Nginx).

- O Archon recupera a documentação relevante e gera o código:

from pydantic_ai import Agent, OpenAIModel

agent = Agent(OpenAIModel("gpt-4o-mini"), system_prompt="解析Nginx日志")

result = agent.run("分析access.log并提取IP地址")

print(result.data)

- Salve o código localmente e certifique-se de configurar a chave da API antes de executá-la.

advertência

- Compatibilidade de modelosApenas a OpenAI oferece suporte à saída de streaming da UI do Streamlit; outros modelos (por exemplo, Ollama) oferecem suporte apenas a não streaming.

- requisito de rede: O rastreamento de documentos e a chamada de APIs requerem uma rede estável.

- ajustar os componentes durante o testeSe algo der errado, verifique o registro da interface do usuário ou a saída do terminal.

Com essas etapas, você pode aproveitar ao máximo a capacidade do Archon de gerar e gerenciar rapidamente as inteligências de IA, tanto para o aprendizado quanto para o desenvolvimento real.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...