Resultados do ARC-AGI-2 revelados: capacidade de raciocínio do modelo de IA Waterloo para todos

As referências para medir o progresso da inteligência artificial de propósito geral (AGI) são fundamentais. Benchmarks eficazes revelam capacidades, e grandes benchmarks têm maior probabilidade de inspirar direções de pesquisa. A ARC Prize Foundation tem o compromisso de fornecer uma plataforma para o desenvolvimento e a disseminação da AGI por meio de seus ARC-AGI A série de benchmarks desempenha esse papel, direcionando os esforços de pesquisa para que se concentrem na verdadeira inteligência de uso geral. O mais recente ARC-AGI-2 Os benchmarks e seus resultados preliminares de teste são um alerta para as questões atuais de limites e eficiência dos recursos de IA.

ARC-AGI-1 Desde o seu lançamento em 2019, ele tem desempenhado um papel único no acompanhamento do progresso da AGI, tendo ajudado a identificar quando a IA começa a ir além da mera memória de padrões. Posteriormente ARC Prize 2024 A competição também atraiu um grande número de pesquisadores para explorar novas ideias para a adaptação do tempo de teste.

No entanto, o caminho para a AGI ainda é longo. O progresso atual, como OpenAI (usado em uma expressão nominal) o3 O que os sistemas mostram é talvez um avanço limitado na dimensão da "inteligência fluida". Esses sistemas não são apenas ineficientes, mas também exigem muita supervisão humana. Está claro que é preciso mais inovação na fonte para concretizar a AGI.

Um novo desafio: ARC-AGI-2, criado para expor os pontos fracos da IA

Com esse objetivo, a ARC Prize Foundation lançou o ARC-AGI-2 Benchmarks. Ele foi projetado com um objetivo claro em mente: ser significativamente mais difícil para a IA (especialmente para os sistemas de raciocínio) e, ao mesmo tempo, manter uma relativa facilidade de manuseio para os seres humanos. Não se trata apenas de um aumento na dificuldade, mas de um desafio direcionado às barreiras que os métodos atuais de IA têm dificuldade de superar.

Filosofia de design: foco na lacuna de inteligência em que as pessoas são fáceis e a IA é difícil

Ao contrário de muitos outros benchmarks de IA que buscam recursos sobre-humanos, oARC-AGI Concentre-se em tarefas que são relativamente fáceis para os seres humanos, mas extremamente difíceis para a IA atual. Essa estratégia tem como objetivo revelar lacunas nas capacidades que não podem ser preenchidas simplesmente com o "aumento de escala". No centro da inteligência geral está a capacidade de generalizar e aplicar eficientemente o conhecimento a partir de uma experiência limitada, que é o ponto fraco da IA atual.

ARC-AGI-2: Aumento da dificuldade, enfrentando diretamente os pontos fracos do raciocínio da IA

ARC-AGI-2 existir ARC-AGI-1 A fundação da IA aumentou significativamente os requisitos para a IA, enfatizando uma combinação de alta adaptabilidade e eficiência. Ao analisar as falhas da IA de ponta em tarefas anteriores, aARC-AGI-2 Apresentando mais desafios que testam a capacidade de interpretar símbolos, raciocinar de forma combinatória, aplicar regras contextuais e muito mais. Essas tarefas são projetadas para forçar a IA a ir além da correspondência de padrões superficiais para níveis mais profundos de abstração e raciocínio.

Boletim do ARC-AGI-2: um reflexo sombrio da realidade

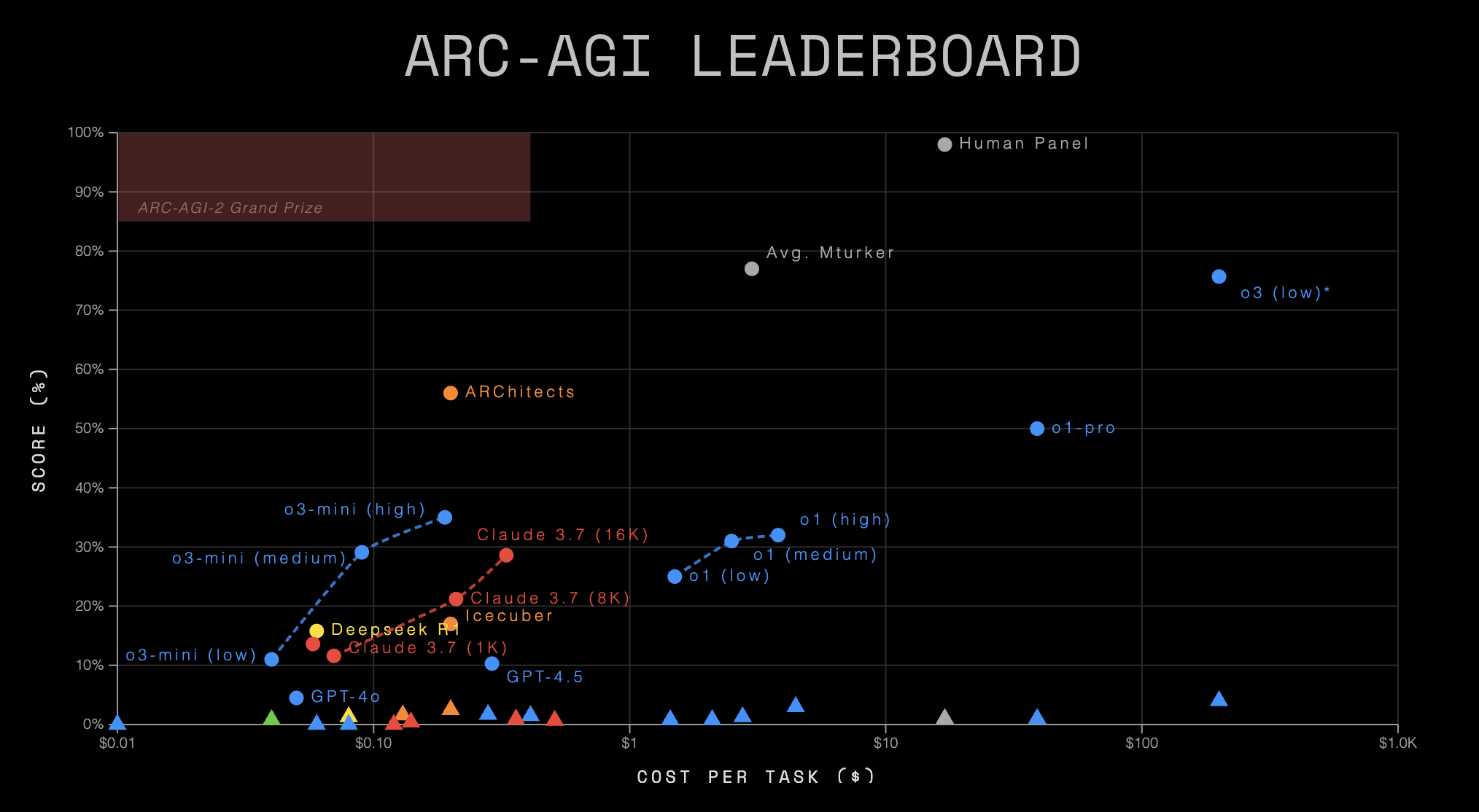

Últimas publicações ARC-AGI Os dados do Leaderboard mostram um quadro sombrio dos recursos atuais de IA. Esses dados não apenas confirmam que ARC-AGI-2 desafiador e, mais profundamente, revela o enorme abismo no poder de raciocínio e na eficiência da IA para fins gerais.

Visão geral dos dados do Leaderboard

| Sistema de IA | Organização | Tipo de sistema | ARC-AGI-1 | ARC-AGI-2 | Custo/Tarefa | Código / Papel |

|---|---|---|---|---|---|---|

| Painel humano | Humanos | N/A | 98.0% | 100.0% | $17.00 | - |

| o3 (baixo)* | OpenAI | CoT + Síntese | 75.7% | 4.0% | $200.00 | 📄 |

| o1 (alto) | OpenAI | CoT | 32.0% | 3.0% | $4.45 | 💻 |

| ARChitects | Prêmio ARC 2024 | Personalizado | 56.0% | 2.5% | $0.200 | 📄💻 |

| o3-mini (médio) | OpenAI | CoT | 29.1% | 1.7% | $0.280 | 💻 |

| Icecuber | Prêmio ARC 2024 | Personalizado | 17.0% | 1.6% | $0.130 | 💻 |

| o3-mini (alto) | OpenAI | CoT | 35.0% | 1.5% | $0.410 | 💻 |

| Gêmeos 2.0 Flash | Empresa de Internet Google | Base LLM | N/A | 1.3% | $0.004 | 💻 |

| o1 (médio) | OpenAI | CoT | 31.0% | 1.3% | $2.76 | 💻 |

| Deepseek R1 | Deepseek | CoT | 15.8% | 1.3% | $0.080 | 💻 |

| Gemini-2.5-Pro-Exp-03-25 ** | Empresa de Internet Google | CoT | 12.5% | 1.3% | N/A | 💻 |

| o1-pro | OpenAI | CoT + Síntese | 50.0% | 1.0% | $39.00 | - |

| Claude 3.7 (8K) | Antrópica | CoT | 21.2% | 0.9% | $0.360 | 💻 |

| Gemini 1.5 Pro | Empresa de Internet Google | Base LLM | N/A | 0.8% | $0.040 | 💻 |

| GPT-4.5 | OpenAI | Base LLM | 10.3% | 0.8% | $2.10 | 💻 |

| o1 (baixo) | OpenAI | CoT | 25.0% | 0.8% | $1.44 | 💻 |

| Claude 3.7 (16K) | Antrópica | CoT | 28.6% | 0.7% | $0.510 | 💻 |

| Claude 3.7 (1K) | Antrópica | CoT | 11.6% | 0.4% | $0.140 | 💻 |

| Claude 3.7 | Antrópica | Base LLM | 13.6% | 0.0% | $0.120 | 💻 |

| GPT-4o | OpenAI | Base LLM | 4.5% | 0.0% | $0.080 | 💻 |

| GPT-4o-mini | OpenAI | Base LLM | N/A | 0.0% | $0.010 | 💻 |

| o3-mini (baixo) | OpenAI | CoT | 11.0% | 0.0% | $0.060 | 💻 |

(Observação: * indica estimativas preliminares na tabela.* indica um modelo experimental)*

Insights: o aviso por trás dos dados

- Humanos vs. IA: uma divisão intransponível

Nada é mais impressionante do que o grande contraste entre o desempenho humano e o da IA. EmARC-AGI-2A equipe humana obteve uma pontuação perfeita de 100%, e o sistema de IA com melhor desempenho - oOpenAI(usado em uma expressão nominal)o3 (low)com pontuação de apenas 4,0%. Outros modelos conhecidos, como oGemini 2.0 FlasheDeepseek R1etc., todos com pontuações em torno de 1,3%. Ainda mais alarmante é o fato de que empresas comoClaude 3.7eGPT-4oeGPT-4o-miniEsses modelos de linguagem grande de base (LLMs de base), que se destacaram em outros domínios, foram usados noARC-AGI-2A pontuação do jogo foi direto para zero. Isso revela de forma implacável que, apesar de ser incrivelmente capaz em tarefas específicas, a IA ainda é fundamentalmente inferior aos humanos quando confrontada com problemas novos que exigem habilidades de raciocínio flexíveis, abstratas e generalizadas. - De AGI-1 a AGI-2: a queda do penhasco nas capacidades de IA

Quase todos os sistemas de IA que participaram do teste, em termos do número de sistemas daARC-AGI-1transiçãoARC-AGI-2tempo, o desempenho despencou. Por exemplo, oo3 (low)caiu de 75,71 TP3T para 4,01 TP3T.o1-prode aproximadamente 50% a 1,0%.ARChitectsde 56,01 TP3T para 2,51 TP3T. Esse fenômeno geral sugere fortemente que aARC-AGI-2Ele aborda com sucesso os "pontos problemáticos" das metodologias atuais de IA, sejam elas baseadas em CoT, Síntese ou outras abordagens personalizadas, que são difíceis de lidar de forma eficaz.ARC-AGI-2O desafio de raciocínio representado. - Tipo de sistema e eficiência: alto custo não leva a alta inteligência

A classificação revela ainda a função dos diferentes tipos de sistemas de IA naARC-AGI-2Diferenças de desempenho e problemas sérios de eficiência no- CoT + Sistema de síntese (

o3 (low),o1-pro) obtiveram as pontuações de IA relativamente mais altas (4,0% e 1,0%), mas a um custo surpreendentemente alto ($200 e $39 por tarefa, respectivamente). Isso sugere que o raciocínio complexo e as estratégias de pesquisa podem ser capazes de "espremer" um pouco da pontuação, mas são extremamente ineficientes. - Sistema CoT puro O desempenho foi misto, com pontuações que geralmente variam de 1%-3% e custos que variam de alguns centavos a alguns dólares. Isso parece indicar que o CoT sozinho não é suficiente para enfrentar o desafio.

- Base LLM (Modelagem de linguagem grande) (

GPT-4.5,Gemini 1.5 Pro,Claude 3.7,GPT-4o) foi um fracasso, com pontuações de 0% ou próximas disso, o que é uma forte refutação da ideia de que "tamanho é tudo", pelo menos no caso doARC-AGIIsso se aplica ao aspecto medido da inteligência fluida generalizada. - Sistemas personalizados (

ARChitects,Icecuber) comoARC Prize 2024alcançando resultados comparáveis ou até ligeiramente melhores (2,5%, 1,6%) do que outros sistemas de IA a um custo muito baixo (~$0,1-$0,2 por tarefa). Isso pode sugerir que algoritmos ou arquiteturas direcionados e leves podem ter mais potencial para resolver esses tipos de problemas do que modelos grandes e de uso geral, e destaca o valor das competições abertas e da inovação da comunidade.

- CoT + Sistema de síntese (

- Crise de eficiência: a inteligência não pode ser apenas uma questão de pontuação

ARC PrizeA inclusão do "custo/tarefa" como uma métrica importante nas classificações é significativa. Os dados mostram que mesmo a IA de melhor desempenho (o3 (low)obter 4%), seu custo por tarefa ($200) também é mais de dez vezes superior ao dos humanos ($17 obter 100%). Embora alguns modelos de baixo custo, comoGemini 2.0 FlashIsso contrasta fortemente com a IA, que tem pontuação muito baixa, ou é cara, ou ambas, embora tenha um custo muito baixo ($0,004) e pontue apenas 1,3%. A inteligência não consiste em obter a resposta certa a qualquer custo; a eficiência é uma propriedade intrínseca. Atualmente, a IA éARC-AGI-2A curva de "custo de capacidade" mostrada acima revela, sem dúvida, uma profunda "crise de eficiência".

Composição do conjunto de dados e detalhes da concorrência

ARC-AGI-2 Contém conjuntos de treinamento e avaliação calibrados de acordo com as linhas de pass@2 Mecanismo de pontuação. As principais alterações incluem um aumento no número de tarefas, a remoção de tarefas vulneráveis à força bruta, uma calibração de dificuldade baseada em testes humanos e o design de novas tarefas direcionadas.

Lançada a competição Prêmio ARC 2025: Recompensa de um milhão de dólares para novas ideias

Com esse boletim de notícias sombrio, oARC Prize 2025 A competição foi realizada em Kaggle A plataforma está ativa (26 de março a 3 de novembro) com um prêmio total de US$ 1 milhão. O ambiente da competição limita o uso da API e dos recursos de computação (~$50/submissão) e exige que os vencedores abram o código-fonte de suas soluções. Isso reforça ainda mais a necessidade de eficiência e inovação.

Os principais pontos da concorrência em 2025, em comparação com 2024, serãoRegistro de alteraçõesIncluindo: o uso de ARC-AGI-2 conjuntos de dados, um novo mecanismo de relatório de tabela de classificação, requisitos aprimorados de código aberto, duplicação dos recursos computacionais e medidas adicionais contra o sobreajuste.

Conclusão: Um novo paradigma é urgentemente necessário para avanços reais

ARC-AGI-2 Os dados da tabela de classificação servem como um espelho que reflete claramente as limitações da IA atual em termos de raciocínio generalizado e eficiência. Eles nos lembram que o caminho para a AGI está longe de ser reto e que o simples escalonamento dos modelos ou o aumento dos recursos computacionais podem não ser suficientes para atravessar o abismo que temos pela frente. Os verdadeiros avanços podem exigir novas ideias, arquiteturas diferentes e, talvez, até mesmo inovadores de fora dos grandes laboratórios.ARC Prize 2025 Essa é uma plataforma que exige um novo paradigma.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...