AnimeGamer: uma ferramenta de código aberto para gerar vídeos de anime e interações de personagens com comandos linguísticos

Introdução geral

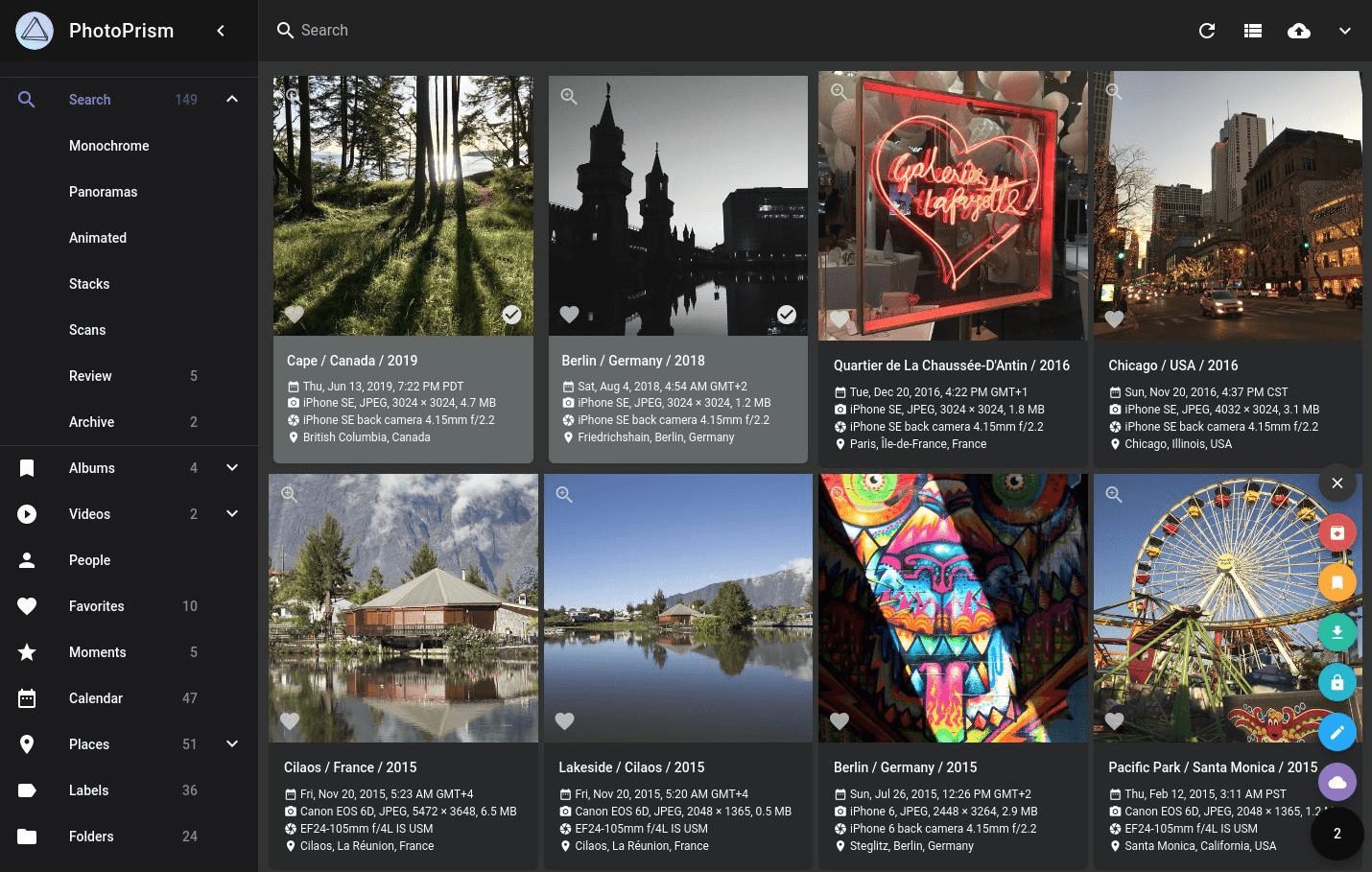

O AnimeGamer é uma ferramenta de código aberto do ARC Lab da Tencent. Os usuários podem gerar vídeos de anime com comandos linguísticos simples, como "Sousuke drive around in a purple car", e fazer com que diferentes personagens de anime interajam entre si, como Kiki de Magical Girl's Adventure e Pazu de Castle in the Sky. Ele se baseia no Multimodal Large Language Model (MLLM), que cria automaticamente segmentos animados coerentes enquanto atualiza o status do personagem, como resistência ou valores sociais. O código e o modelo do projeto são gratuitos e estão abertos no GitHub para que os fãs e desenvolvedores de anime possam usá-los para criar ou experimentar.

Lista de funções

- Gerar vídeo de animação: comandos de linguagem de entrada para gerar automaticamente clipes de animação de movimentos e cenas de personagens.

- Suporte à interação de personagens: permita que diferentes personagens de anime se encontrem e interajam para criar novas histórias.

- Status atualizado do personagem: registro em tempo real das alterações nos valores do personagem, como resistência, social e entretenimento.

- Mantenha o conteúdo consistente: garanta vídeo e status consistentes com base em instruções históricas.

- Extensões de código aberto: o código e os modelos completos são fornecidos e os desenvolvedores têm liberdade para adaptá-los.

Usando a Ajuda

O AnimeGamer requer um pouco de noções básicas de programação, mas as etapas de instalação e uso não são difíceis. Aqui estão instruções detalhadas para ajudá-lo a começar rapidamente.

Processo de instalação

- Preparação do ambiente

Você precisará de um computador habilitado para Python, de preferência com uma GPU (pelo menos 24 GB de memória de vídeo). Instale o Git e o Anaconda e, em seguida, digite no terminal:

git clone https://github.com/TencentARC/AnimeGamer.git

cd AnimeGamer

Crie um ambiente virtual:

conda create -n animegamer python=3.10 -y

conda activate animegamer

- Instalação de dependências

É executado em um ambiente virtual:

pip install -r requirements.txt

Isso instalará as bibliotecas necessárias, como o PyTorch.

- Modelos para download

Faça o download dos três arquivos de modelo para./checkpointsPasta:

- Modelo AnimeGamer:Cara de abraço.

- Modelo Mistral-7B:Cara de abraço.

- Modelo 3D-VAE da CogvideoX: vá para

checkpointspasta, execute:cd checkpoints wget https://cloud.tsinghua.edu.cn/f/fdba7608a49c463ba754/?dl=1 -O vae.zip unzip vae.zip

Verifique se os modelos estão todos no lugar certo.

- instalação de teste

Retorne ao diretório inicial e execute:

python inference_MLLM.py

Nenhum erro significa que a instalação foi bem-sucedida.

Como usar os principais recursos

Em sua essência, o AnimeGamer gera vídeos e interações de personagens usando comandos verbais. Veja como ele funciona:

Gerar vídeos de anime

- mover

- compilador

./game_demoem uma pasta comoinstructions.txt. - Digite um comando, por exemplo, "Sousuke is driving around in a purple car in the forest" (Sousuke está dirigindo um carro roxo na floresta).

- Execute o MLLM para gerar uma representação:

python inference_MLLM.py --instruction "宗介在森林里开紫色车兜风"

- Decodificar para vídeo:

python inference_Decoder.py

- O vídeo será salvo na pasta

./outputsPasta.

- tomar nota de

As instruções devem ser escritas com personagens, ações e cenas claras para que o vídeo esteja mais alinhado com as expectativas.

Interação de personagens

- mover

- Digite um comando interativo, como, por exemplo, "Kiki teach Pazuzu to fly a broom".

- Execute as etapas acima para gerar um vídeo interativo.

- especificidades

Suporta a mistura e a interação com diferentes personagens de anime para criar cenas exclusivas.

Atualizar status do caractere

- mover

- Adicione uma descrição do estado ao comando, por exemplo, "Sousuke está cansado depois de correr".

- estar em movimento

inference_MLLM.pyO status é atualizado para./outputs/state.json.

- chamar a atenção para algo

O status é ajustado automaticamente de acordo com as instruções históricas para manter a consistência.

Personalização e detalhes técnicos

Deseja alterar um recurso? Você pode editá-lo diretamente ./game_demo A técnica da AnimeGamer funciona em três etapas:

- Processando a representação da ação com um codificador, o decodificador de difusão gera o vídeo.

- O MLLM prevê o próximo estado com base em instruções históricas.

- Otimize o decodificador para melhorar a qualidade do vídeo.

Mais detalhes estão no README.md do GitHub.

desenvolvimentos mais recentes

- 2 de abril de 2025: lançamento de modelos de pesos e papéis para The Witch's House e Goldfish Girl on the Cliff (arXiv).

- 1 de abril de 2025: código de inferência lançado.

- Planos futuros: lançar demonstrações interativas e código de treinamento do Gradio.

Perguntas frequentes

- Geração lenta? Confirme se a GPU tem memória suficiente (24 GB) ou atualize os drivers.

- O download do modelo falhou? Faça o download manual do Hugging Face.

- Informar um erro? Verifique a versão do Python (é necessário o 3.10) e as dependências.

Com essas etapas, você poderá gerar vídeos de anime e interações de personagens com o AnimeGamer.

cenário do aplicativo

- criação de anime e mangá

Os fãs de anime podem usá-lo para gerar vídeos, como a interação de diferentes personagens, e compartilhá-los com os amigos. - Testes de jogos

Os desenvolvedores podem usá-lo para criar rapidamente protótipos de conteúdo dinâmico e testar ideias. - aprendizado em ação

Os alunos podem usá-lo para aprender sobre tecnologia multimodal e geração de vídeo e obter experiência prática com IA.

QA

- É necessário ter conhecimento de programação?

Sim, é necessário ter conhecimentos básicos de Python para a instalação e o ajuste, mas comandos simples funcionarão. - Quais funções são suportadas?

Suporte para Magical Girl's Home Companion e Goldfish Hime on the Cliff agora, com expansão no futuro. - Ele está disponível comercialmente?

Sim, mas siga o protocolo Apache-2.0, consulte o GitHub para obter detalhes.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...