Faculdade de Engenharia da IA: Avaliação de sistemas 2,5 RAG

breve

A avaliação é um componente fundamental no desenvolvimento e na otimização dos sistemas RAG (Retrieval Augmented Generation). A avaliação envolve uma revisão dos RAG Todos os aspectos do processo são medidos quanto ao desempenho, à precisão e à qualidade, incluindo a relevância e a autenticidade, desde a eficácia da recuperação até a geração de respostas.

Importância da avaliação RAG

A avaliação eficaz do sistema RAG é importante porque:

- Ajuda a identificar os pontos fortes e fracos do processo de recuperação e geração.

- Orientar o aprimoramento e a otimização de todo o processo do RAG.

- Garantir que o sistema atenda aos padrões de qualidade e às expectativas dos usuários.

- Facilita a comparação de diferentes implementações ou configurações de RAG.

- Ajuda a detectar problemas como alucinações, preconceito ou respostas irrelevantes.

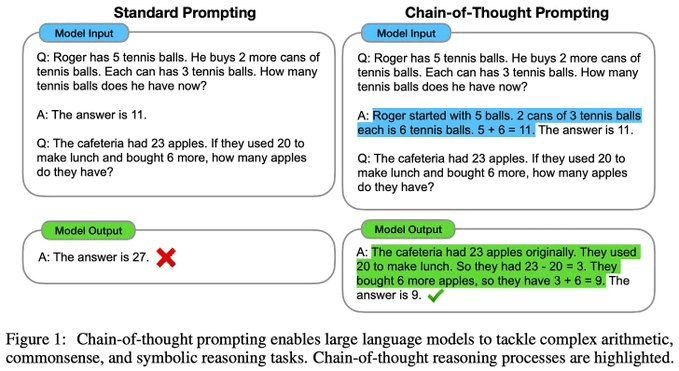

Processo de avaliação RAG

Uma avaliação de um sistema RAG normalmente inclui as seguintes etapas:

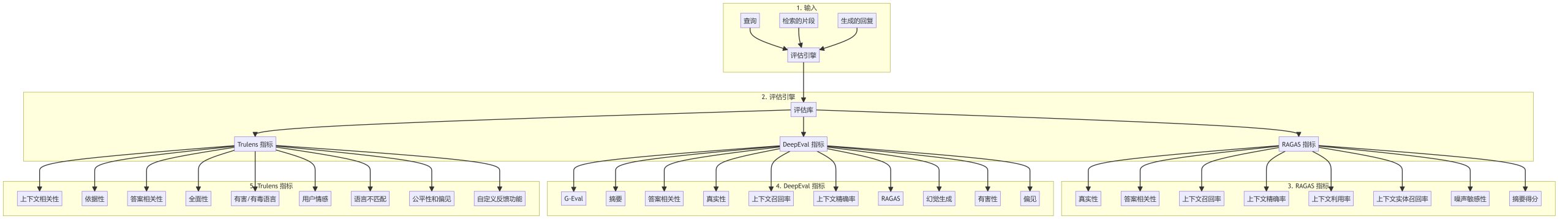

Principais indicadores de avaliação

Indicadores RAGAS

- validadeMedição da consistência da resposta gerada com o contexto de recuperação.

- Relevância das respostasAvalie a relevância da resposta para a consulta.

- recuperação de contexto (computação)Avaliação: avalia se os blocos recuperados abrangem as informações necessárias para responder à consulta.

- Precisão contextualMedida da proporção de informações relevantes nos blocos recuperados.

- Utilização do contextoAvalie a eficiência com que a resposta gerada utiliza o contexto fornecido.

- recuperação de entidades contextuaisAvaliação: Avalie se as entidades importantes do contexto estão cobertas pela resposta.

- sensibilidade ao ruídoMedida da robustez de um sistema em relação a informações irrelevantes ou com ruído.

- Pontuação abstrataAvaliação da qualidade do resumo da resposta: Avalie a qualidade do resumo da resposta.

Indicadores DeepEval

- G-EvalMétricas de avaliação comuns para tarefas de geração de texto.

- resumosAvalie a qualidade dos resumos de texto.

- Relevância das respostasMedida de quão bem a resposta atende à consulta.

- validadeAvalie a precisão da resposta e das informações de origem.

- Recuperação e precisão contextualMeasuring the effectiveness of contextual retrieval: Medindo a eficácia da recuperação contextual.

- Detecção de alucinaçõesIdentificação de informações falsas ou imprecisas em uma resposta.

- toxicológicoDetectar conteúdo potencialmente prejudicial ou ofensivo na resposta.

- preconceitoIdentificar preferências ou tendências injustas no conteúdo gerado.

Indicadores Trulens

- relevância contextualAvaliar o grau de correspondência entre o contexto de recuperação e a consulta.

- aterradoResposta: uma medida que indica se a resposta é apoiada pelas informações recuperadas.

- Relevância das respostasAvalie a qualidade da resposta à consulta.

- abrangênciaResposta completa: mede a integridade da resposta.

- Linguagem nociva/ofensivaIdentificação de conteúdo potencialmente ofensivo ou perigoso.

- sentimento do usuárioAnálise do tom emocional nas interações com o usuário.

- incompatibilidade de idiomaDetectar inconsistências no uso do idioma entre a consulta e a resposta.

- Equidade e preconceitoAvaliação do tratamento justo de diferentes grupos no sistema.

- Funções de feedback personalizadasPermite o desenvolvimento de métricas de avaliação personalizadas para casos de uso específicos.

Práticas recomendadas para avaliação RAG

- Avaliação geralCombinação de vários indicadores para avaliar diferentes aspectos do sistema RAG.

- Avaliação comparativa regularAvaliação contínua do sistema à medida que os processos mudam.

- Participação humanaAnálise abrangente que combina avaliações manuais e indicadores automatizados.

- Indicadores específicos de domínioDesenvolver métricas personalizadas relacionadas a casos de uso ou domínios específicos.

- análise de errosAnálise de padrões em respostas de baixa pontuação e identificação de áreas para melhoria.

- Avaliação comparativaCompare seu sistema RAG com modelos de linha de base e implementações alternativas.

chegar a um veredicto

Uma estrutura de avaliação robusta é essencial para o desenvolvimento e a manutenção de um sistema RAG de alta qualidade. Ao utilizar uma ampla variedade de métricas e seguir as práticas recomendadas, os desenvolvedores podem garantir que seu sistema RAG forneça respostas precisas, relevantes e confiáveis, além de melhorar continuamente o desempenho.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...