O ChatGPT continua no topo de muitos gráficos de IA, mas a concorrência está logo atrás dele

Como você determina os modelos de IA mais avançados disponíveis atualmente? Confira as classificações para descobrir.

As tabelas de classificação compiladas pela comunidade para modelos de IA ganharam popularidade on-line nos últimos meses, fornecendo uma janela em tempo real para a disputa dos principais gigantes da tecnologia no espaço de IA.

Vários placares de líderes documentam quais modelos de IA são os mais avançados na execução de determinadas tarefas. Os modelos de IA são, essencialmente, um conjunto de fórmulas matemáticas envoltas em código projetado para atingir uma finalidade específica.

Como o Gemini do Google (anteriormente Bard) e as startups de Paris IA Mistral Novos participantes, como a Mistral-Medium, galvanizaram a comunidade de IA e estão disputando uma posição no topo da tabela de classificação.

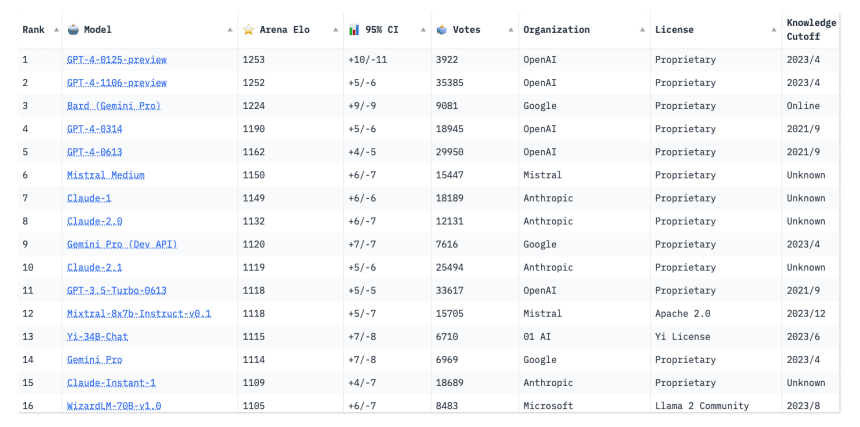

No entanto, o GPT-4 da OpenAI ainda domina.

As pessoas se preocupam com a tecnologia de ponta", diz Ying Sheng, estudante de doutorado em ciência da computação na Universidade de Stanford e cocriador da tabela de classificação da Chatbot Arena. Acho que as pessoas realmente gostam de ver os gráficos mudando constantemente. Isso mostra que o jogo ainda está em andamento e que ainda há espaço para melhorias."

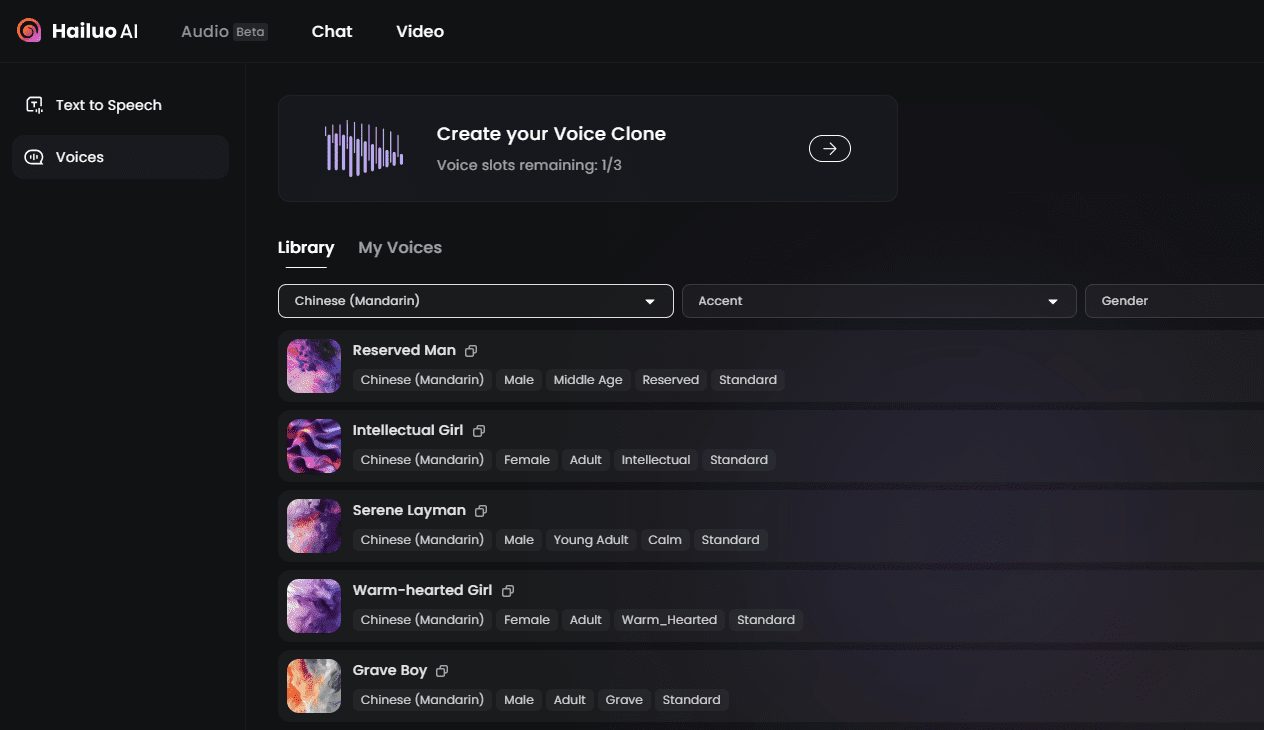

As classificações são baseadas em testes dos recursos dos modelos de IA, projetados para descobrir o que a IA normalmente é capaz de fazer e quais modelos podem ser mais adequados para aplicações específicas, como o reconhecimento de fala. Esses testes, às vezes chamados de testes de benchmarking, medem o desempenho da IA por meio de métricas como a proximidade da vocalização de uma IA com a voz humana ou a humanidade das respostas de um chatbot de IA.

À medida que a IA continua a evoluir, o aprimoramento contínuo desses testes é igualmente essencial.

Vanessa Parli, diretora de pesquisa do Instituto de Inteligência Artificial do Centro para a Dimensão Humana da Universidade de Stanford, disse: "Esses padrões de referência não são perfeitos, mas, no momento, é a única maneira de avaliar o sistema".

O relatório anual do Instituto sobre o Índice de Inteligência Artificial de Stanford monitora o desempenho técnico dos modelos de IA ao longo do tempo com base em várias métricas. De acordo com Parli, o relatório do ano passado pesquisou 50 padrões de referência, mas incluiu apenas 20. Este ano, o relatório eliminará algumas referências desatualizadas para se concentrar em referências mais recentes e abrangentes.

A tabela de classificação do Open LLM [Large Language Model], criada pela Hugging Face, uma plataforma de aprendizado de máquina de código aberto, avaliou e classificou mais de 4.200 modelos até o início de fevereiro, todos enviados por membros da comunidade.

Os modelos participam de sete testes de benchmark importantes criados para avaliar sua capacidade em várias categorias, como compreensão de leitura e resolução de problemas matemáticos. O processo de avaliação inclui questões de matemática e ciências do ensino fundamental que testam o raciocínio de senso comum dos modelos e medem sua tendência a disseminar informações errôneas. Alguns dos testes apresentam um formato de múltipla escolha, enquanto outros exigem que os modelos gerem suas próprias respostas com base em dicas.

O ChatGPT-4 da OpenAI pode ser visto no topo da tabela de classificação da LMSYS Chatbot Arena, seguido de perto pelo Geminivia do Google. LMSYS

Os visitantes podem ver o desempenho específico de cada modelo em um determinado teste de benchmark, bem como sua pontuação total média. Até o momento, nenhum modelo alcançou uma pontuação perfeita de 100 em qualquer benchmark. O Smaug-72B, um modelo de IA recém-desenvolvido pela startup Abacus.AI, de São Francisco, tornou-se o primeiro modelo a atingir 80 pontos em média.

Muitos modelos de linguagem em larga escala já superaram os benchmarks humanos em tais testes, um fenômeno que os pesquisadores chamam de "saturação", diz Thomas Wolf, cofundador e diretor científico da Hugging Face. Isso geralmente ocorre quando a capacidade do modelo aumenta além de um teste específico, como quando um aluno passa do ensino fundamental para o ensino médio e supera progressivamente o estágio anterior de aprendizado, ou quando o modelo memoriza como responder a determinadas perguntas do teste, um conceito conhecido como "superajuste".

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...