Caminho de aprendizado de 6 semanas para se tornar um especialista em engenharia de taco (Transcrição)

apresentar (alguém para um emprego etc.)

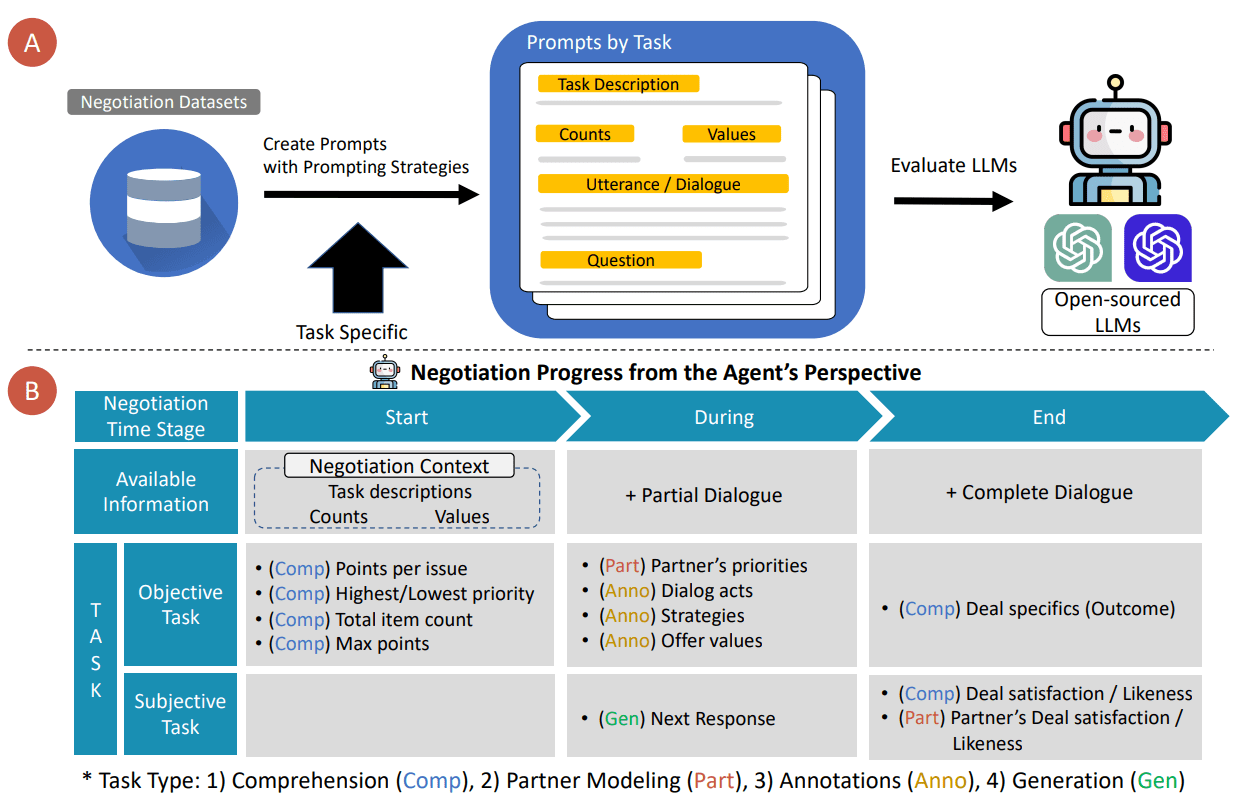

À medida que o campo da inteligência artificial (IA) continua a crescer, a engenharia de dicas se tornou uma carreira promissora. Atualmente, muitas pessoas estão se esforçando para adquirir as habilidades necessárias para interagir de forma eficaz com os modelos de linguagem grande (LLMs). Você tem o mesmo desejo? Está pensando por onde começar e como proceder? Oferecemos este caminho de aprendizado para ajudá-lo a se tornar um especialista em engenharia de prontidão. Este guia abrangente foi criado para ajudá-lo a dominar a engenharia de prompts passo a passo, desde o básico até as técnicas avançadas. Não importa se você é iniciante ou experiente, esse caminho de aprendizagem estruturado fornecerá o conhecimento e as habilidades práticas necessárias para dominar o LLM.

delineado

- Entenda o que é um projeto de sugestão.

- Aprenda a dominar a engenharia de prompt em 6 semanas.

- Descubra o que você precisa aprender a cada semana e como praticar.

diretório (no disco rígido do computador)

- Semana 1: Introdução à engenharia de pistas

- Semana 2: Configuração de LLMs para prompts

- Semana 3: Como escrever prompts eficazes

- Semana 4: Entendendo os padrões de solicitação

- Semana 5: Dicas avançadas de prompts

- Semana 6: Estratégias avançadas de solicitação

- problemas comuns

Semana 1: Introdução à engenharia de pistas

Durante a primeira semana do Prompt Engineering Journey, concentre-se nos seguintes tópicos

O que é o Projeto Tip?

- Compreender o conceito de engenharia de dicas em PNL e sua importância.

- Compreender como escrever prompts eficazes e seu impacto no resultado da modelagem de linguagem.

- Conheça os antecedentes históricos e a evolução da engenharia de tacos e como ela evoluiu ao longo do tempo.

Como funciona o LLM?

- Explore os fundamentos do LLM e entenda como ele funciona em uma linguagem simples e não técnica.

- Saiba como o LLM é treinado e funciona, compreendendo-o com analogias e exemplos simples.

- Saiba mais sobre diferentes LLMs, como GPT-4o, Llama e Mistral, e seus recursos exclusivos e cenários de aplicação.

O papel da engenharia

- Entenda as descrições de cargos e as habilidades específicas necessárias para cargos como engenheiro de dicas, cientista de dados e outros.

- Aprenda sobre a aplicação prática da engenharia de pistas por meio de projetos reais e tarefas de amostra.

Aplicações práticas da engenharia de tacos

- A pesquisa apresenta estudos de caso de aplicações bem-sucedidas da engenharia de pistas em vários setores.

Exemplo:LLMs no local de trabalho: um estudo de caso sobre o uso de engenharia de dicas para categorização de cargos. - Discuta o impacto da engenharia de dicas no desempenho dos modelos de IA e entenda como ela pode melhorar a eficácia desses modelos.

colocar em prática

- Explore os gráficos do LLMAprenda sobre vários benchmarks, como MMLU-Pro, HuamnEval, Chatbot Arena e muito mais. Explore diferentes gráficos de LLM e saiba mais sobre os modelos líderes atuais em diferentes benchmarks.

Exemplo:Hugging Face Space para open-llm-leaderboardeClassificação do LLM | Análise Artificial - Identificar as principais habilidades e analisar dicas Estudos de caso de engenhariaIdentificação das habilidades e qualificações comuns exigidas dos engenheiros de estímulo: Comece identificando as habilidades e as qualificações comuns exigidas dos engenheiros de estímulo examinando as descrições de cargos e os perfis profissionais. Pesquise e resuma as aplicações práticas da engenharia de estímulos em vários setores, concentrando-se em como os estímulos são projetados e nos resultados que alcançam.

Exemplo:Estudo de caso - Projeto TipeO impacto dos aplicativos de IA geradora orientados por IA em 13 casos de uso no mundo real.

Semana 2: Configuração de um modelo de linguagem grande para prompts

Nesta semana, aprenderemos a configurar o Modelo de Linguagem Grande (LLM) para solicitar diferentes maneiras. Os usuários podem usar qualquer um dos métodos mencionados.

Acessado diretamente no site do LLM

- Saiba como usar esses modelos diretamente na plataforma web do LLM.

- Saiba como criar uma conta e como navegar na interface da popular plataforma Big Language Modelling.

Executando o LLM de código aberto localmente

- Explore o processo de configuração de um LLM de código aberto (por exemplo, Llama3, Mistral, Phi3 etc.) para ser executado em uma máquina local, usando o Hugging Face ou o Ollama e msty.app ou Open WebUI.

- Compreender os requisitos de hardware e software de diferentes LLMs de código aberto.

Acesso programático via API

- Saiba como se registrar para obter acesso à API. Por exemplo, fornecer acesso à API para LLMs por meio da plataforma, como GPT-4o, Claude, Gemini etc., bem como usar a API Hugging Face Inference para acessar modelos como Llama, Phi, Gemma e outros.

- Saiba como configurar chaves de API e integrá-las a vários aplicativos para a geração de solicitações.

Configurar chave de API no AI Content Labs

colocar em prática

- Acesso ao LLM pelo siteCriar uma conta e tentar gerar prompts diretamente no site do LLM.

- Configurando o LLM de código aberto localmenteSiga o guia para baixar, instalar e configurar um LLM local de código aberto e testá-lo usando vários prompts.

- Registrar a chave da APIConclusão do processo de obtenção de uma chave de API de um provedor como o OpenAI e criação de um script simples para gerar um prompt usando essa chave.

Semana 3: Como escrever prompts eficazes

Nesta semana, aprenderemos a criar uma variedade de tipos de dicas para inicializar modelos de linguagem com eficiência, concentrando-nos em comandos claros, exemplos, iterações, delimitadores, formatos estruturados e parâmetros de temperatura.

Escreva instruções claras e específicas

- Aprenda a escrever instruções claras e específicas para orientar o modelo na geração do resultado desejado.

- Compreender a importância da clareza e da especificidade para evitar ambiguidades e melhorar a precisão das respostas.

Exemplos específicos de uso

- Aprenda técnicas para usar exemplos específicos em prompts para fornecer contexto e melhorar a relevância dos resultados do modelo.

- Saiba como demonstrar o formato esperado ou o tipo de resposta com exemplos.

Transformar a sugestão e iterar

- Explore as vantagens da transformação de dicas e da iteração para melhorar a qualidade do resultado.

- Saiba como pequenas mudanças nos prompts podem levar a melhorias significativas nos resultados.

Uso de delimitadores

- Saiba como usar separadores de forma eficaz em prompts para separar diferentes seções ou tipos de entrada.

- Saiba como aprimorar a estrutura e a legibilidade dos prompts com exemplos de uso de separadores.

Especificação de um formato de saída estruturado

- Compreender a importância de especificar um formato de saída estruturado no prompt para garantir a consistência e a organização das respostas.

- Aprenda técnicas para definir claramente o formato de saída esperado.

Parâmetros de temperatura operacional

- Aprenda o conceito de parâmetro de temperatura na modelagem de linguagem e como ele afeta a criatividade e a aleatoriedade do resultado.

- Saiba como ajustar os parâmetros de temperatura para encontrar um equilíbrio entre variedade e coerência e controlar a resposta do modelo.

colocar em prática

- Escreva instruções claras e específicasCrie prompts com instruções claras e específicas e observe como a clareza afeta o resultado do modelo.

- Exemplos específicos de usoInclua um exemplo específico no prompt para comparar a diferença de relevância do resultado com e sem o exemplo.

- Transformar a sugestão e iterarTente variar os prompts e iterar para ver como pequenas mudanças melhoram os resultados.

- Uso de delimitadoresUse delimitadores para separar diferentes seções no prompt e analise o impacto na estrutura e na legibilidade da resposta.

Semana 4: Entendendo os padrões de solicitação

Nesta semana, aprenderemos sobre padrões de dicas, uma técnica de alto nível que fornece uma abordagem reutilizável e estruturada para resolver problemas comuns na saída do Modelo de Linguagem Grande (LLM).

Visão geral do modo Cue

- Compreender o conceito de padrões de dicas e sua função na elaboração de dicas eficazes para LLMs (por exemplo).

- Conheça as semelhanças entre os padrões de dicas e os padrões de design na engenharia de software, em que os padrões de dicas fornecem soluções reutilizáveis para problemas específicos e recorrentes.

- O objetivo de explorar o modelo de prompts é facilitar a engenharia de prompts, fornecendo uma estrutura para escrever prompts que podem ser reutilizados e adaptados a diferentes cenários.

semântica de entrada

- Saiba mais sobre as categorias semânticas de entrada e como o LLM entende e processa a entrada fornecida.

- Saiba mais sobre o padrão de prompt Criação de Meta-Linguagem, que envolve a definição de uma linguagem ou notação personalizada que interage com o LLM.

Personalização da saída

- Entenda a categoria Output Customisation, que se concentra na adaptação dos resultados do LLM a necessidades ou formatos específicos.

- Explore o modo de prompt "Template" para garantir que a saída do LLM siga o modelo ou formato exato.

- Saiba mais sobre o modelo de sugestão de "função", em que o LLM assume uma função ou perspectiva específica ao gerar o resultado.

identificação errônea

- Aprendizado de categorias de reconhecimento de erros com foco na detecção e resolução de possíveis erros na saída do LLM.

- Saiba mais sobre o modo de prompt "Fact Checklist" que gera uma lista de fatos na saída para validação.

- Explore o modelo de solicitação "reflexiva", que solicita que o LLM reflita sobre seus resultados e identifique possíveis erros ou áreas a serem aprimoradas.

Otimização de pistas

- Saiba mais sobre a categoria Otimização de prompts, com foco na otimização dos prompts enviados aos LLMs para garantir a qualidade dos prompts.

- Saiba mais sobre o modelo de prompting 'Question Optimisation' que orienta os LLMs a otimizar as perguntas dos usuários para obter respostas mais precisas.

- Explore o modelo de solicitação de abordagem alternativa para garantir que o LLM ofereça várias maneiras de concluir uma tarefa ou resolver um problema.

Interação e controle contextual

- A compreensão das categorias de interação aprimora a dinâmica da interação entre o usuário e o LLM, tornando o diálogo mais envolvente e eficaz.

- Aprenda o modelo de estímulo "Interação reversa", no qual o LLM conduz o diálogo fazendo perguntas.

- Aprenda sobre a categoria de controle contextual com foco na manutenção e no gerenciamento de informações contextuais no diálogo.

- Explore o modelo de estímulo "Context Manager" para garantir a coerência e a relevância do diálogo contínuo.

exercício

- Explorar diferentes padrões de dicasAnálise de vários padrões de dicas para entender como eles lidam com problemas específicos e recorrentes na saída do LLM.

- Exemplo de análise de padrões de dicasExaminar exemplos de uso de padrões de dicas no mundo real para entender como eles podem atingir metas e resultados específicos.

- Identificar e classificar padrões de dicasPadrões de dicas: Pratique o reconhecimento de diferentes padrões de dicas em um determinado exemplo e classifique-os na categoria apropriada.

- Combine vários modos de sinalizaçãoExplore como vários modos de sinalização podem ser combinados para resolver problemas de sinalização mais complexos e melhorar o resultado geral.

Semana 5: Técnicas avançadas de solicitação

Nesta semana, vamos nos aprofundar em técnicas avançadas de estímulo para aumentar ainda mais a eficácia e a sofisticação dos estímulos. Aqui estão alguns exemplos.

Dica N-shot

- Aprenda a dica do N-shot, que envolve o fornecimento de zero, um ou mais exemplos (N-shots) para orientar a resposta do modelo.

- Saiba como as dicas do N-shot podem melhorar a precisão e a relevância dos resultados do modelo, fornecendo contexto e exemplos.

cadeia de pensamento

- Explore as técnicas de Cadeia de Pensamento (COT) para raciocinar passo a passo sobre um problema por meio de um modelo guiado.

- Saiba como o método pode ajudar a gerar resultados mais coerentes e logicamente consistentes.

autoconsistência

- A compreensão dos métodos autoconsistentes envolve a solicitação do modelo para gerar várias soluções e, em seguida, selecionar a mais consistente.

- Saiba como essa técnica melhora a confiabilidade e a precisão das respostas geradas.

árvore de pensamento

- Aprenda sobre a técnica da Árvore de Pensamento, que incentiva os modelos a considerar vários caminhos e possíveis resultados para um determinado problema.

- Saiba como criar pistas para facilitar esse processo de pensamento ramificado e melhorar as habilidades de tomada de decisão.

mapa mental

- Explore a abordagem de mapeamento mental na qual os modelos criam redes de ideias e conceitos interconectados.

- Saiba como usar essa tecnologia para gerar uma resposta mais abrangente e multifacetada.

exercício

- Implementação da dica N-shotForneça alguns exemplos (N-shots) para o modelo e observe como ele melhora a relevância e a precisão da resposta.

- Experimente a cadeia de pensamentosCrie prompts que orientem o raciocínio passo a passo do modelo sobre o problema e analise a coerência do resultado.

- Aplicação da autoconsistênciaSolução de problemas: Peça ao modelo que gere várias soluções para o problema e selecione a mais consistente para aumentar a confiabilidade.

- Usando uma árvore de pensamentoDesenvolva prompts para incentivar os modelos a considerar vários caminhos e resultados e avaliar seus processos de tomada de decisão.

Semana 6: Estratégias avançadas de design de tacos

Nesta semana, exploraremos estratégias avançadas de design de dicas para aprimorar ainda mais o poder e a precisão da interação com modelos de linguagem.

Reagir

- fazer Reagir técnicas para aprender novas tarefas e tomar decisões ou raciocinar, permitindo que o modelo "aja" e "raciocine".

- Saiba como usar essa abordagem para gerar resultados mais interativos e envolventes.

Reafirmação e sugestões de resposta

- A compreensão da técnica "reafirmar e responder" envolve solicitar que o modelo reafirme uma determinada entrada e, em seguida, responda.

- Saiba como essa abordagem melhora a clareza e oferece várias visualizações da mesma entrada.

Auto-otimização

- Explore os métodos de "auto-otimização" que levam os modelos a revisar e melhorar suas próprias respostas para aumentar a precisão e a consistência.

- Examine como essa técnica pode melhorar a qualidade do resultado ao incentivar a autoavaliação.

Dicas de iteração

- Aprenda a abordagem de "iterative cueing" para otimizar continuamente o resultado do modelo por meio de iterative cueing e feedback.

- Saiba como a qualidade e a relevância das respostas podem ser aprimoradas ao longo do tempo por meio dessa técnica.

tecnologia de cadeia

- cadeia de verificaçãoUso de perguntas de validação e suas respostas para reduzir o fenômeno das alucinações.

- cadeia de conhecimentoCrie prompts que se baseiam no conhecimento dinâmico para gerar respostas abrangentes.

- cadeia emocionalEstímulos emocionais: Adicione estímulos emocionais no final do prompt para tentar melhorar o desempenho do modelo.

- cadeia de densidadeGerar vários resumos que são progressivamente mais detalhados, mas não aumentam de tamanho.

- cadeia simbólicaRepresentam ambientes complexos usando representações espaciais simbólicas condensadas em etapas de inferência intermediárias encadeadas.

colocar em prática

- Implementação da tecnologia ReactCrie prompts que solicitem que o modelo reaja ou responda a estímulos específicos e avalie a interatividade do resultado.

- Uso de reafirmações e prompts de respostaTente fazer com que o modelo reafirme a entrada e, em seguida, responda, e analise o resultado quanto à clareza e variedade.

- Auto-otimização de aplicativosDesenvolva dicas para incentivar os modelos a revisar e melhorar suas respostas para aumentar a precisão e a consistência.

- Explore a tecnologia de cadeiaCrie uma série de dicas usando várias técnicas de encadeamento (por exemplo, cadeias de raciocínio de linguagem natural, cadeias de conhecimento) e avalie a coerência e a profundidade das respostas.

chegar a um veredicto

Seguindo esse caminho de aprendizado, qualquer pessoa pode se tornar um especialista em engenharia de dicas. Isso lhe dará uma compreensão profunda de como projetar dicas eficazes e usar técnicas avançadas para otimizar o desempenho de grandes modelos de linguagem. Esse conhecimento permitirá que você lide com tarefas complexas, melhore os resultados dos modelos e contribua para o crescente campo da IA e do aprendizado de máquina. A prática contínua e a exploração de novas abordagens garantirão que você esteja na vanguarda desse campo dinâmico e empolgante.

A engenharia de dicas é uma parte essencial da criação e do treinamento de modelos de IA generativa. Domine a engenharia de dicas e todos os outros aspectos da IA generativa com o nosso abrangente e completo Programa Capstone de IA generativa. Este curso abrange desde os fundamentos da IA até técnicas avançadas para ajudá-lo a ajustar seus modelos de IA generativa para uma variedade de necessidades. Veja o curso agora!

problemas comuns

P1: O que é engenharia de prontidão? Por que ela é importante?

A. A engenharia de dicas refere-se ao projeto de entradas para orientar o modelo de macrolinguagem na geração do resultado desejado. Isso é essencial para melhorar a precisão e a relevância das respostas geradas pela IA.

P2: Quais são as ferramentas e plataformas comuns para usar o Big Language Model?

A. As ferramentas e plataformas comumente usadas incluem os modelos GPT da OpenAI, Hugging Face, Ollama e Llama e Mistral e outros modelos de código aberto de grandes linguagens.

P3: Como os iniciantes começam a aprender sobre engenharia de tacos?

A. Os iniciantes podem começar entendendo os conceitos básicos de Processamento de Linguagem Natural (NLP) e Modelagem de Linguagem Grande, experimentando com prompts simples e explorando gradualmente as técnicas mais avançadas mencionadas neste caminho de aprendizagem.

Q4: Quais são as principais habilidades necessárias para trabalhar na área de engenharia de prontidão?

A. As principais habilidades incluem proficiência em PNL, compreensão de grandes modelos de linguagem, capacidade de criar prompts eficazes e familiaridade com programação e integração de API.

P5: Como a engenharia de dicas afeta os aplicativos do mundo real?

A. A engenharia de dicas eficaz pode melhorar significativamente o desempenho dos modelos de IA em vários setores, desde o atendimento ao cliente e a geração de conteúdo até a análise de dados e o suporte a decisões.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...