2025 AI Agent Landing Outlook: uma análise dos três elementos de planejamento, interação e memória

Os agentes de IA estão se tornando uma mudança de paradigma muito esperada no espaço tecnológico de IA em rápida evolução. O AI Share, uma organização líder em análise de tecnologia de IA, recentemente mergulhou fundo na tendência dos agentes de IA e fez referência a uma série de artigos detalhados publicados pela equipe da Langchain para ajudar os leitores a entender melhor o futuro dos agentes.

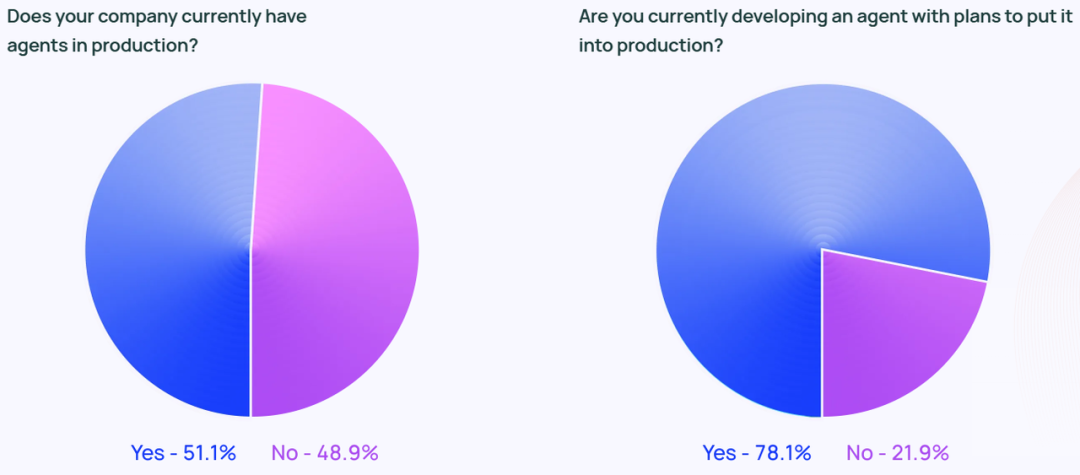

Este artigo integra as principais conclusões do relatório State of AI Agent publicado pela Langchain, que pesquisou mais de 1.300 profissionais do setor, abrangendo desenvolvedores, gerentes de produtos, executivos corporativos e outras funções. As descobertas revelam o estado atual do desenvolvimento de agentes de IA e os gargalos em 2024: embora 90% das empresas estejam planejando e aplicando ativamente agentes de IA, os usuários só podem implantar agentes em processos e cenários de aplicativos específicos devido às limitações de seus recursos atuais. As pessoas estão mais preocupadas em melhorar os recursos dos agentes e a observabilidade e confiabilidade de seus comportamentos, em vez de fatores como custo e latência. A capacidade de observação e controle do comportamento do agente é mais importante do que o custo e a latência.

Além disso, este artigo compila uma análise detalhada dos principais elementos do agente de IA da série In the Loop no site oficial da LangChain, com foco em Planejamento, inovação interativa UI/UX e memória. Esses três elementos centrais. O artigo analisa profundamente cinco padrões de interação de produtos nativos com base em Modelos de Linguagem Ampla (LLMs) e faz uma analogia com três mecanismos de memória complexos de seres humanos, com o objetivo de fornecer percepções úteis para que os leitores entendam a natureza e os principais elementos dos agentes de IA. Para ficar mais próximo da prática industrial, este artigo também inclui a análise dos principais elementos na seção de Reflexão Entrevistas com fundadores de IA e outros exemplos em primeira mão são usados para antecipar os principais avanços que podem chegar aos agentes de IA em 2025.

Com base na estrutura de análise acima, a AI Share acredita que os aplicativos de agentes de IA deverão ter um crescimento explosivo em 2025 e avançar gradualmente em direção a um novo paradigma de colaboração entre humanos e computadores. Em termos da capacidade de planejamento do AI Agent, os modelos emergentes representados pelo modelo o3 mostram uma forte capacidade de reflexão e raciocínio, o que indica que o desenvolvimento da tecnologia de modelos está evoluindo rapidamente do estágio de Raciocinador para o de Agente. Com o aprimoramento contínuo da capacidade de raciocínio, a possibilidade de o AI Agent realmente alcançar a aterrissagem em larga escala dependerá da inovação da interação do produto e do mecanismo de memória, o que também será uma oportunidade importante para as startups alcançarem a diferenciação e o avanço. No nível da interação, o setor espera uma revolução na interação humano-computador semelhante ao "momento da GUI" na era da IA; no nível da memória, o Contexto se tornará a palavra-chave central para o lançamento do Agente, seja a personalização do Contexto no nível individual ou a unificação do Contexto no nível empresarial. O Context (contexto) se tornará a palavra-chave central da aterrissagem do Agente, seja a personalização em nível individual ou a unificação em nível empresarial.

01 Estado do agente de IA: Estado atual do desenvolvimento do agente de IA

Tendências de adoção de agentes: todas as empresas estão planejando ativamente a implantação de agentes

A concorrência no espaço do agente está ficando mais acirrada a cada dia. No último ano, surgiram muitas estruturas populares de agentes. Por exemplo, o ReAct combinando LLM para raciocínio e ação, orquestração de tarefas usando a estrutura Multi-agente e métodos como o LangGraph Essa é uma estrutura mais gerenciável.

O burburinho sobre o agente não se limita ao burburinho da mídia social. De acordo com a pesquisa, aproximadamente 51% das organizações pesquisadas já estão usando Agentes em seus ambientes de produção. A pesquisa da Langchain também divide os dados por tamanho de empresa, mostrando que as empresas de médio porte com 100 a 2.000 funcionários são as mais ativas em implantações de produção de Agentes, com incríveis 63%.

Além disso, 78% dos entrevistados indicaram que planejam implantar agentes em seus ambientes de produção em um futuro próximo. Isso mostra claramente que há um grande interesse em Agentes de IA em todos os setores, mas como criar uma verdadeira pronto para produção (para uso em ambientes de produção) Agent, continua sendo um desafio para muitas empresas.

Embora o setor de tecnologia seja frequentemente considerado o precursor da tecnologia de agentes, o interesse por agentes está crescendo rapidamente em todos os setores. Entre os entrevistados que trabalham em empresas que não são de tecnologia, 90% das organizações têm ou planejam colocar Agentes em seus ambientes de produção, o que é quase a mesma porcentagem das empresas de tecnologia (89%).

Caso de uso do agente

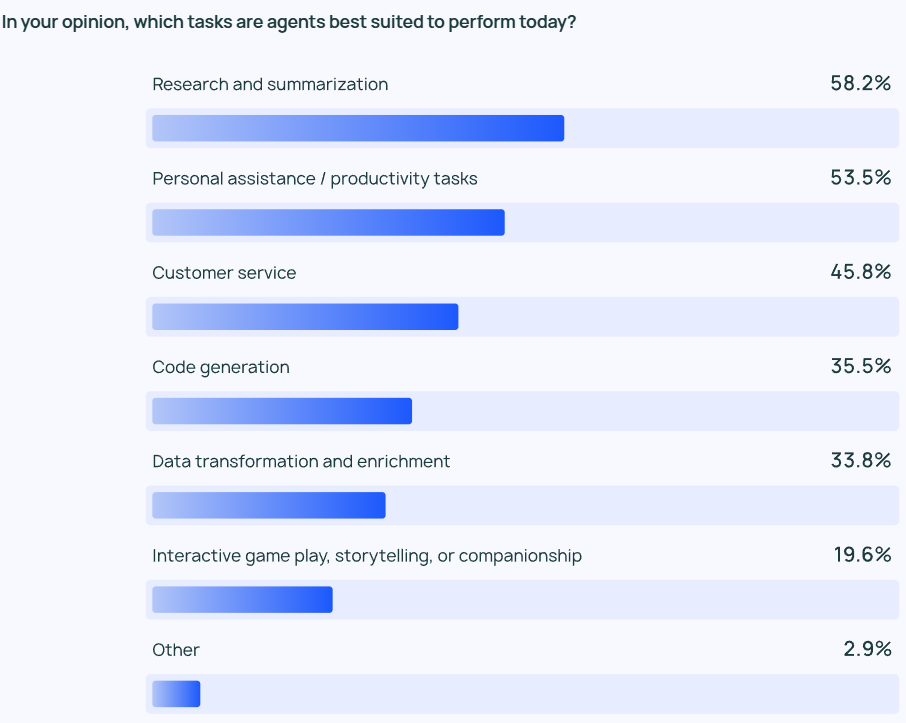

Os resultados da pesquisa mostram que o agente mais comum caso de uso (cenário de aplicativo) incluindo pesquisa de informações e resumo de conteúdo (58%), seguido pela simplificação do fluxo de trabalho por meio de agentes personalizados (53,5%).

Isso reflete o fato de que os usuários esperam que os produtos Agent os ajudem em tarefas que consomem muito tempo e exigem muito trabalho. Os usuários podem contar com os AI Agents para extrair rapidamente informações importantes e insights de grandes quantidades de informações, em vez de terem que examinar grandes quantidades de dados e realizar revisões de dados ou análises de pesquisa por conta própria. Da mesma forma, os AI Agents podem ajudar nas tarefas diárias, aumentando a produtividade pessoal e permitindo que os usuários se concentrem em aspectos mais importantes de seu trabalho.

Não são apenas os usuários individuais que precisam de ganhos de eficiência, mas também as organizações e as equipes. O atendimento ao cliente (45,8%) é outra grande área de aplicação do Agent. Os agentes ajudam as organizações a lidar com as consultas dos clientes, resolver problemas e reduzir os tempos de resposta dos clientes entre as equipes. O quarto e o quinto cenários de aplicativos mais populares são códigos de baixo nível e processamento de dados.

Monitoramento: os aplicativos de agente precisam ser observáveis e controláveis.

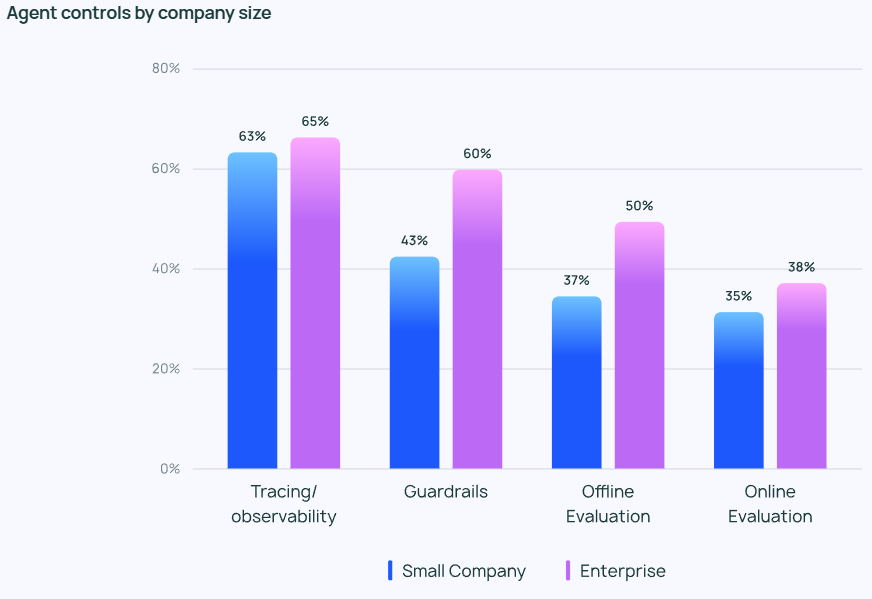

À medida que os agentes se tornam mais avançados, é fundamental gerenciar e monitorar com eficiência o seu comportamento. As ferramentas de rastreamento e observabilidade estão se tornando uma opção obrigatória na pilha de tecnologia de agente de um usuário corporativo, ajudando os desenvolvedores a obter informações sobre o comportamento e o desempenho do agente. Muitas empresas também usam guarda-corpo para evitar que o comportamento do agente se desvie da trilha predefinida.

Ao testar aplicativos LLM, oAvaliação off-line (39,8%) foi usado com mais frequência do que o Avaliação on-line (32,5%), o que reflete os muitos desafios ainda enfrentados no monitoramento do LLM em tempo real. Nas respostas ao questionário aberto da LangChain, muitas empresas indicaram que também providenciariam para que especialistas humanos verificassem ou avaliassem manualmente os resultados das respostas dos agentes como uma camada adicional de segurança.

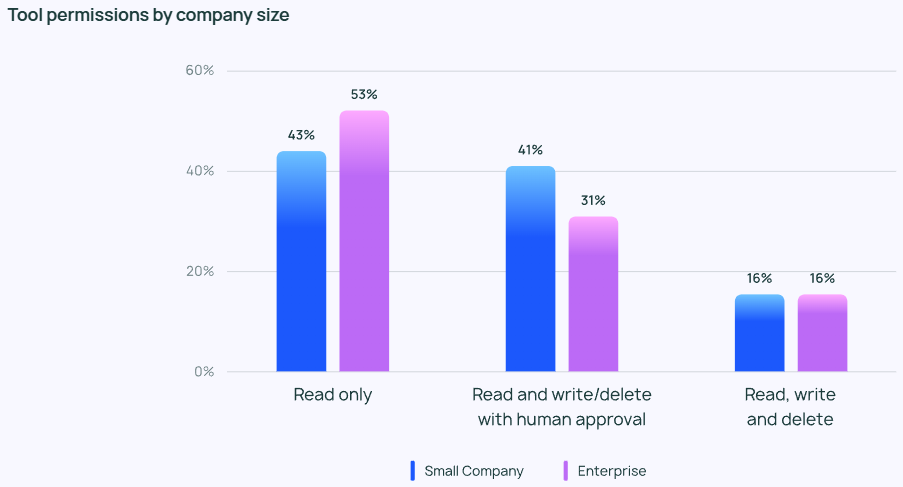

Apesar do entusiasmo com os agentes, as pessoas geralmente são conservadoras no que diz respeito ao controle de privilégios dos agentes. Poucos entrevistados permitem que os agentes leiam, gravem e apaguem livremente. Em vez disso, a maioria das equipes concede aos agentes apenas permissões de "somente leitura" ou exige aprovação manual quando os agentes realizam operações mais arriscadas, como gravação ou exclusão.

O foco nos controles do agente varia de acordo com o tamanho da empresa. As organizações maiores (mais de 2.000 funcionários) costumam ser mais cautelosas, confiando muito nas permissões "somente leitura" para minimizar riscos desnecessários. Elas também tendem a colocar guarda-corpo Combinado com avaliações off-line, ele procura evitar quaisquer problemas que possam afetar negativamente o cliente.

Empresas menores e startups (com menos de 100 funcionários), por sua vez, estão mais interessadas em rastrear agentes para obter insights sobre o desempenho real de seus aplicativos de agentes (em vez de outros controles). A pesquisa da LangChain mostra que as empresas menores tendem a analisar os dados para entender os resultados, enquanto as organizações maiores se concentram na criação de um sistema holístico de controle.

Barreiras e desafios para colocar o agente em produção

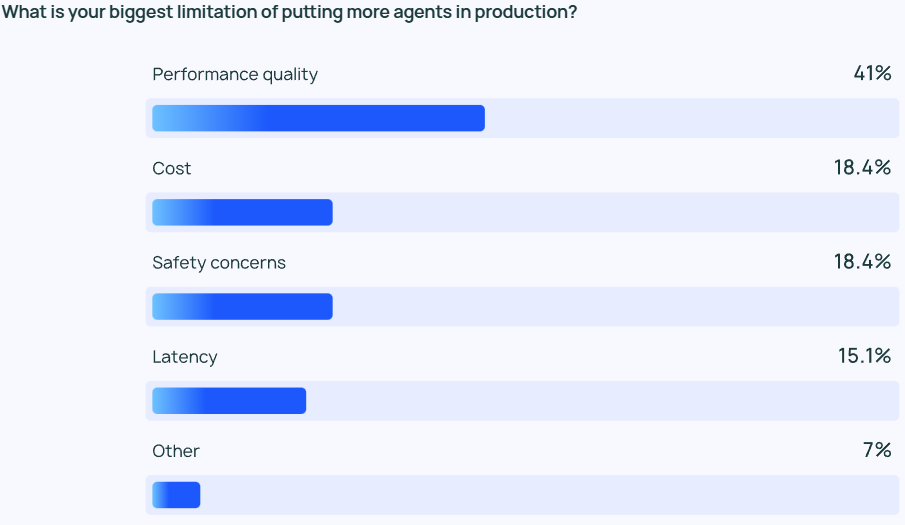

Garantir que os resultados do LLM sejam de alta qualidade desempenho continua sendo uma tarefa desafiadora. As respostas do agente não só precisam ser altamente precisas, mas também estilisticamente corretas. Essa é uma das principais preocupações dos desenvolvedores de agentes, mais de duas vezes mais importante do que outros fatores, como custo e segurança.

O LLM Agent é essencialmente um modelo de saída de conteúdo baseado em probabilidade, o que significa que sua saída é um tanto imprevisível. Essa imprevisibilidade aumenta a probabilidade de erro, o que dificulta para a equipe de desenvolvimento garantir que o agente forneça respostas precisas e contextualizadas de forma consistente.

Para empresas menoresQualidade do desempenho Essa disparidade destaca o fato de que o desempenho confiável e de alta qualidade é fundamental para conduzir a transição dos agentes de uma organização da fase de desenvolvimento para a fase de produção.

A segurança também é essencial para as grandes organizações que precisam aderir a requisitos de conformidade rigorosos e lidar com os dados dos clientes com cuidado.

Além dos desafios de qualidade, as respostas ao questionário aberto da LangChain revelaram que muitas organizações ainda têm reservas quanto a continuar investindo no desenvolvimento e teste de agentes. Dois obstáculos proeminentes foram comumente citados: primeiro, o desenvolvimento de um agente requer muita experiência e a necessidade de acompanhar as tecnologias de ponta; segundo, o custo de tempo para desenvolver e implantar um agente é alto, mas ainda há incerteza quanto à sua capacidade de operar de forma confiável e proporcionar os benefícios esperados.

Outros temas emergentes

Na sessão de perguntas abertas, os entrevistados classificaram o AI Agent como altamente capaz de demonstrar os seguintes recursos:

- Gerenciar tarefas em várias etapas. O agente de IA é capaz de raciocinar mais profundamente e gerenciar o contexto, o que lhe permite executar tarefas mais complexas.

- Automação de tarefas repetitivas. O AI Agent ainda é considerado uma ferramenta essencial para lidar com tarefas automatizadas, o que ajuda os usuários a liberar seu tempo para se concentrar em trabalhos mais criativos.

- Planejamento de missão e colaboração. Melhores recursos de planejamento de tarefas garantem que o agente certo esteja trabalhando no problema certo no momento certo, o que é especialmente importante em sistemas multiagentes.

- Raciocínio semelhante ao humano. Diferentemente dos LLMs tradicionais, um agente de IA pode rastrear seu processo de tomada de decisão, incluindo a análise e a revisão de decisões anteriores com base em novas informações.

Além disso, os entrevistados identificaram duas expectativas principais para o futuro dos agentes de IA:

- O que esperar de um agente de IA de código aberto. Tem havido muito interesse em agentes de IA de código aberto, com muitos acreditando que a inteligência coletiva pode acelerar o ritmo da inovação na tecnologia de agentes.

- Expectativas de modelos mais potentes. Muitos aguardam ansiosamente o próximo salto dos agentes de IA com modelos maiores e mais potentes, quando os agentes poderão lidar com tarefas mais complexas com maior eficiência e autonomia.

Durante a sessão de perguntas e respostas, muitos entrevistados também mencionaram o maior desafio no desenvolvimento do Agente: entender o comportamento do Agente. Alguns engenheiros disseram que tinham dificuldade em entender o comportamento de um Agente quando o apresentavam à empresa. partes interessadas Eles encontram dificuldades ao explicar os recursos e o comportamento de um agente de IA. Embora os plug-ins de visualização possam ajudar a explicar o comportamento do agente até certo ponto, o LLM continua sendo uma "caixa preta" na maioria dos casos. O ônus adicional da interpretabilidade ainda recai sobre a equipe de engenharia.

02 Análise dos principais elementos de um agente de IA

Antes do lançamento do relatório State of AI Agent, a equipe da Langchain já havia explorado o espaço do agente com base na estrutura Langraph que desenvolveu e publicado vários artigos sobre a análise dos principais componentes do AI Agent no blog In the Loop. Neste artigo, compilaremos o conteúdo principal da série de artigos In the Loop e analisaremos em profundidade os principais elementos do agente.

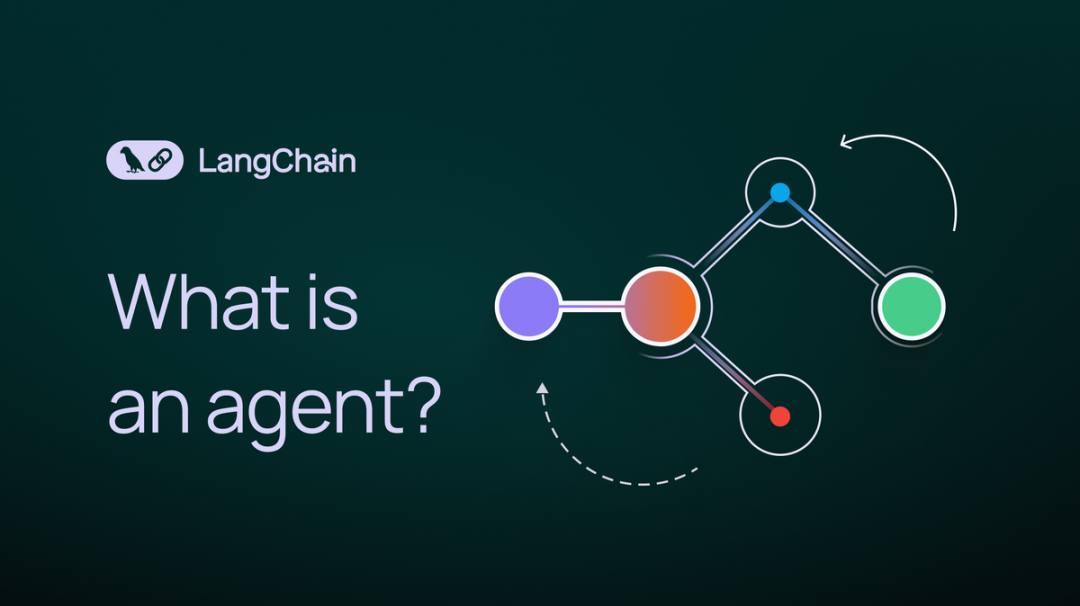

Para entender melhor os elementos principais de um agente, primeiro precisamos ter uma boa compreensão do Sistema agêntico Definição. O fundador da LangChain, Harrison Chase, dá a seguinte definição de um agente de IA:

💡

O AI Agent é um sistema que usa o LLM para controlar as decisões de fluxo de controle de aplicativos.

Um agente de IA é um sistema que usa um LLM para decidir o fluxo de controle de um aplicativo.

Com relação à forma como o Agente é implementado, o artigo apresenta o Arquitetura cognitiva O conceito. arquitetura cognitiva É a forma como o agente pensa e como o sistema orquestra o código ou os prompts que impulsionam o LLM. A compreensão da arquitetura cognitiva nos ajuda a entender como o agente funciona:

- Cognitivo. O agente usa o LLM para raciocínio semântico a fim de determinar como codificar ou solicitar o LLM.

- Arquitetura. Os sistemas de agentes ainda envolvem uma grande quantidade de práticas de engenharia semelhantes às arquiteturas de sistemas tradicionais.

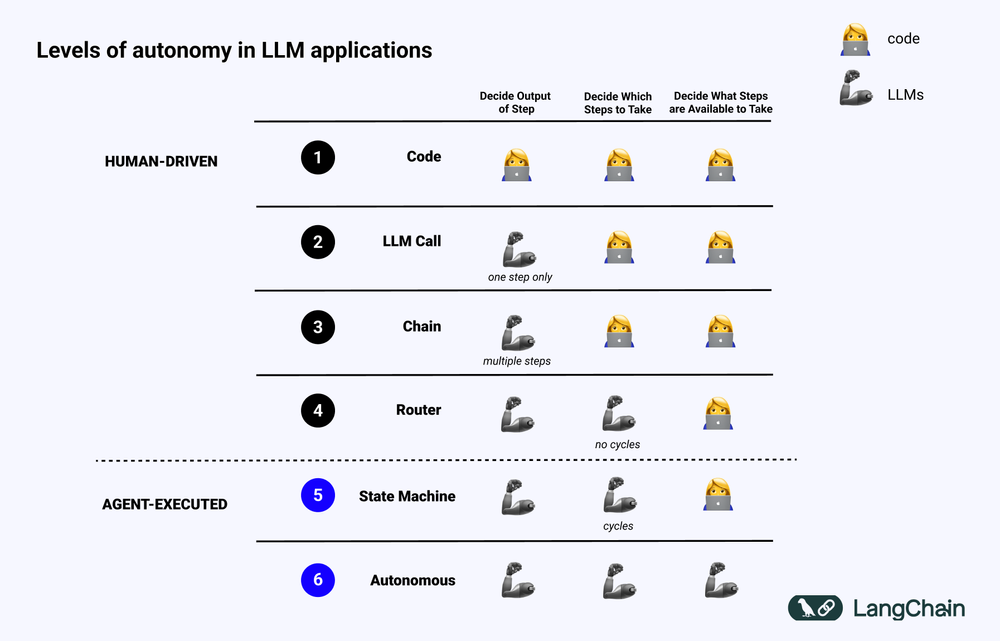

O diagrama abaixo mostra os diferentes níveis de Arquitetura cognitiva Exemplo:

- Código de software padronizado (Código). Toda lógica é Código rígido Na implementação da arquitetura cognitiva, os parâmetros de entrada e saída são solidificados diretamente no código-fonte. Essa abordagem não constitui uma arquitetura cognitiva devido à falta de cognitivo Parte.

- Chamada para o LLM. Com exceção de uma pequena quantidade de pré-processamento de dados, a maior parte da funcionalidade de um aplicativo depende de uma única chamada LLM. Um Chatbot simples geralmente se enquadra nessa categoria.

- Cadeia. Uma série de chamadas de LLM em que a Cadeia tenta dividir um problema complexo em etapas e chamar LLMs diferentes para resolvê-los um a um. O complexo RAG (Search Enhanced Generation) se enquadram nessa categoria: por exemplo, o primeiro LLM é chamado para pesquisar e consultar, e o segundo LLM é chamado para gerar a resposta.

- Roteador. Em todos esses três sistemas, o usuário tem conhecimento prévio de todas as etapas que o programa executará. Entretanto, na arquitetura do roteador, o LLM pode decidir de forma autônoma quais LLMs chamar e quais etapas executar. Isso aumenta a aleatoriedade e a imprevisibilidade do sistema.

- Máquina de estado. Ao combinar o LLM com o Roteador, a imprevisibilidade do sistema é ainda maior. Como essa combinação cria um loop, o sistema pode, teoricamente, invocar o LLM um número infinito de vezes.

- Sistema de agência. Também conhecido como "Agente Autônomo (Agente Autônomo)" Ao usar uma máquina de estado, ainda há limitações nas operações que o sistema pode realizar e nos processos que as seguem. Ao usar uma máquina de estado, ainda há algumas restrições sobre as operações que podem ser realizadas pelo sistema e o fluxo após a realização das operações. Entretanto, ao usar um agente autônomo, essas restrições são eliminadas. O LLM tem total autonomia para decidir quais etapas tomar e como programar os diferentes LLMs, o que pode ser feito por meio do uso de diferentes prompts, ferramentas ou códigos.

Em resumo, quanto mais um sistema "Agêntico" Quanto mais o LLM desempenhar um papel na determinação de como o sistema se comporta, maior será o papel do LLM na determinação de como o sistema se comporta.

Elementos-chave do Agente: capacidade de planejamento

A confiabilidade do agente é um ponto problemático na prática atual dos aplicativos. Muitas empresas criaram agentes com base no LLM, mas comentam que os recursos de planejamento e raciocínio dos agentes são insuficientes. Então, o que significa a capacidade de planejamento e raciocínio do agente?

Agente Planejamento responder cantando Raciocínio Competência, que se refere à capacidade do LLM de pensar e tomar decisões sobre quais ações devem ser tomadas. Isso envolve tanto a curto quanto a longo prazo raciocínio . O LLM precisa avaliar todas as informações disponíveis e, em seguida, decidir: Que medidas preciso tomar para atingir meu objetivo final? Qual é o primeiro passo mais importante a ser dado neste momento?

Na prática, os desenvolvedores geralmente usam Chamada de função para permitir que o LLM selecione a ação a ser executada. Chamada de função é um recurso adicionado pela primeira vez à API do LLM em junho de 2023 pela OpenAI. Com a chamada de função, os usuários podem fornecer estruturas JSON para diferentes funções e fazer com que o LLM corresponda a uma (ou mais) dessas estruturas.

Para concluir com êxito uma tarefa complexa, um sistema de agente geralmente precisa executar uma série de operações de forma sequencial. Planejamento e raciocínio de longo prazo Um desafio muito complexo para o LLM: em primeiro lugar, o LLM precisa considerar um planejamento de ação de longo prazo e, em seguida, refiná-lo para as ações de curto prazo que precisam ser tomadas no momento; em segundo lugar, à medida que o agente realiza mais e mais operações, os resultados das operações serão continuamente realimentados para o LLM, resultando em um crescimento contínuo da janela de contexto, o que pode fazer com que o LLM fique "distraído " e reduzir o desempenho.

A maneira mais direta de melhorar as capacidades de planejamento é garantir que os LLMs tenham todas as informações necessárias para raciocinar e planejar racionalmente. Embora isso pareça simples, a realidade é que as informações transmitidas ao LLM geralmente são insuficientes para permitir que ele tome decisões acertadas. Adicionar uma etapa de pesquisa ou otimizar o Prompt pode ser uma melhoria simples.

Além disso, considere ajustar o arquitetura cognitiva . Há duas classes principais de arquiteturas cognitivas que podem ser usadas para melhorar a capacidade de raciocínio do agente: Arquitetura cognitiva genérica responder cantando Arquiteturas cognitivas específicas do domínio.

1. arquitetura cognitiva genérica

Arquitetura cognitiva genérica pode ser aplicado a uma variedade de cenários de tarefas diferentes. Duas arquiteturas genéricas representativas foram propostas por acadêmicos: Arquitetura "Planeje e resolva" responder cantando Arquitetura de Reflexão.

Arquitetura "Planeje e resolva" Ela foi apresentada pela primeira vez no artigo Plan-and-Solve Prompting: Improving Zero-Shot Chain-of-Thought Reasoning by Large Language Models. Nessa arquitetura, um agente primeiro faz um plano detalhado e, em seguida, executa cada etapa do plano passo a passo.

Arquitetura de Reflexão foi apresentada no artigo Reflexion: Language Agents with Verbal Reinforcement Learning. Nessa arquitetura, um agente executa uma tarefa e, em seguida, acrescenta um "Reflexão". etapas para avaliar se suas tarefas foram executadas corretamente. Sem entrar nos detalhes específicos dessas duas arquiteturas, o leitor interessado deve consultar os dois artigos originais mencionados acima.

Embora as arquiteturas "Plan and Solve" e Reflexion mostrem algum potencial teórico para aprimoramento, elas geralmente são muito gerais para serem úteis no uso de agentes na produção. (Nota do tradutor: Na época deste artigo, a família de modelos o1 ainda não havia sido lançada).

2. arquitetura cognitiva específica do domínio

Em contraste com as arquiteturas cognitivas genéricas, muitos sistemas de agentes optam por usar o Arquiteturas cognitivas específicas do domínio . Isso geralmente se reflete em uma etapa de categorização ou planejamento específica do domínio, bem como em uma etapa de validação específica do domínio. As ideias de planejamento e reflexão apresentadas em arquiteturas cognitivas genéricas podem ser emprestadas e aplicadas em arquiteturas cognitivas específicas do domínio, mas geralmente precisam ser adaptadas e otimizadas de uma forma mais específica do domínio.

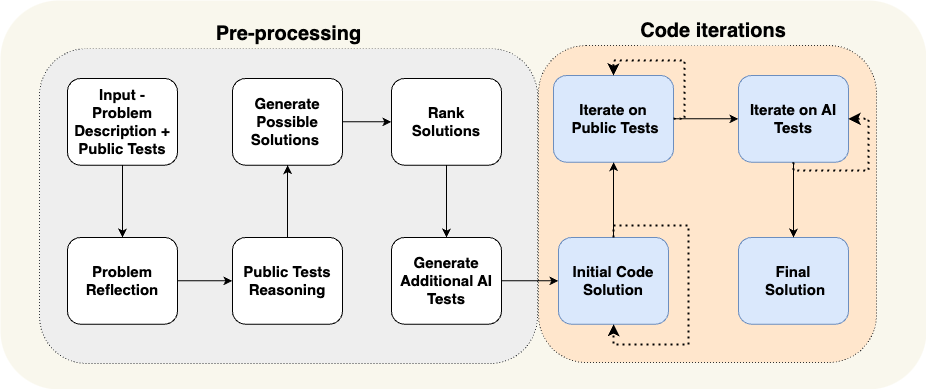

Um artigo da AlphaCodium fornece um excelente exemplo de uma arquitetura cognitiva específica de um domínio. A equipe da AlphaCodium fez isso usando o que eles chamam de "Engenharia de fluxo". (essencialmente outra forma de descrever arquiteturas cognitivas), alcançando o desempenho mais avançado na época.

Conforme mostrado na figura acima, o design do processo do agente AlphaCodium é altamente relevante para o problema de programação que ele está tentando resolver. Eles informam o agente detalhadamente sobre as tarefas que precisam ser realizadas em etapas: primeiro propor um caso de teste, depois propor uma solução, depois iterar em mais casos de teste e assim por diante. Essa arquitetura cognitiva é altamente específica do domínio, não é genérica e é difícil generalizá-la diretamente para outros domínios.

Estudo de caso: A visão do fundador da Reflection AI, Laskin, sobre o futuro dos agentes

Na entrevista da Sequoia Capital com Misha Laskin, fundador da Reflection AI, Misha Laskin compartilha sua visão do futuro do agente: combinando Capacidade de pesquisa para RL (Reinforcement Learning) Em conjunto com o LLM, a Reflection AI está focada na criação de modelos de agentes com desempenho superior. Misha Laskin e o cofundador Ioannis Antonoglou (chefe do AlphaGo, AlphaZero, Gemini RLHF) estão se concentrando no treinamento de modelos de agentes especialmente projetados para o Fluxo de trabalho agêntico Modelagem do design. As principais ideias das entrevistas são apresentadas a seguir:

- A profundidade é o principal elemento que falta em um agente de IA. Embora os modelos de linguagem atuais sejam excelentes em termos de amplitude de conhecimento, eles não têm a profundidade necessária para concluir tarefas complexas de forma confiável. Misha Laskin argumenta que resolver o "problema da profundidade" é fundamental para criar agentes de IA realmente capazes. "Capacidade", nesse contexto, refere-se à habilidade de um agente de planejar e executar tarefas complexas em várias etapas.

- A combinação de Learn e Search é a chave para um desempenho sobre-humano. Com base no sucesso do AlphaGo, Misha Laskin enfatizou que a ideia mais profunda da IA é a combinação eficaz de **Aprender** (com base no LLM) e **Pesquisar** (encontrar o caminho ideal). Essa abordagem é fundamental para criar agentes que superem os humanos em tarefas complexas.

- O pós-treinamento e a modelagem de recompensas representam grandes desafios. Ao contrário dos jogos com mecanismos de recompensa explícitos, as tarefas do mundo real geralmente não apresentam sinais de recompensa explícitos. Como desenvolver um sistema confiável modelo de recompensa O principal desafio é criar um agente de IA confiável.

- Os agentes universais podem estar mais próximos do que imaginamos. Misha Laskin prevê que talvez estejamos a apenas três anos de alcançar o "AGI digital (Inteligência Artificial Geral Digital)." Esse cronograma acelerado destaca a urgência de desenvolver rapidamente os recursos do agente e, ao mesmo tempo, abordar questões de segurança e confiabilidade. Esse cronograma acelerado ressalta a urgência de desenvolver rapidamente os recursos do agente e, ao mesmo tempo, abordar questões de segurança e confiabilidade.

- O caminho para os Agentes Universais requer um método. O Reflection AI concentra-se na ampliação dos limites funcionais do agente, começando com ambientes específicos, como navegadores, editores de código e sistemas operacionais de computador. Seu objetivo final é desenvolver Agentes universais Isso permite que eles executem tarefas em uma variedade de áreas diferentes e não se limitam a tarefas específicas.

Inovação em interação UI/UX

A Interação Humano-Computador (HCI) se tornará uma direção de pesquisa fundamental em IA nos próximos anos. Os sistemas de agentes são muito diferentes dos sistemas de computadores tradicionais, e novos recursos, como latência, falta de confiabilidade e interfaces de linguagem natural, representam novos desafios. Portanto, um novo tipo de UI/UX (interface do usuário/experiência do usuário) Os paradigmas surgirão. Embora os sistemas de agentes ainda estejam nos estágios iniciais de desenvolvimento, há vários paradigmas emergentes de UX. Cada um deles é discutido a seguir.

1. interação de conversação (interface de usuário de bate-papo)

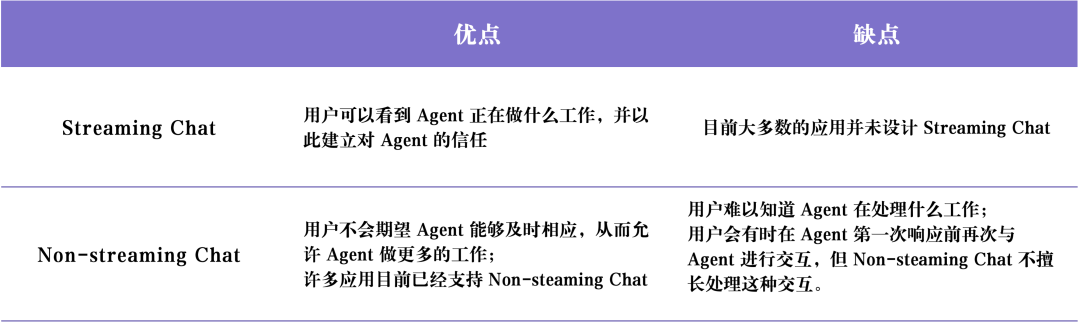

Interação de conversação (interface de usuário de bate-papo) Normalmente, há dois tipos principais: Bate-papo por streaming responder cantando Chat sem streaming .

Bate-papo por streaming é o paradigma de UX mais comum atualmente. Essencialmente, trata-se de um Chatbot que utiliza o processo de pensamento e o comportamento do Agente e o encaminha em um formato de diálogo semelhante ao humano. Fluxo de volta para o usuário. ChatGPT É um representante típico do bate-papo em fluxo contínuo. Esse modo de interação parece simples, mas é muito eficaz pelos seguintes motivos: primeiro, os usuários podem usar a linguagem natural para ter um diálogo direto com os LLMs, e quase não há barreiras de comunicação entre os usuários e os LLMs; segundo, geralmente leva tempo para os LLMs concluírem suas tarefas, e o processamento de streaming permite que as famílias conheçam o andamento da execução das tarefas em segundo plano em tempo real; terceiro, os LLMs às vezes podem cometer erros, e a interface de bate-papo fornece uma maneira amigável para os usuários corrigirem e orientarem naturalmente os LLMs, que se acostumaram a ter conversas de acompanhamento e a usar o bate-papo de streaming. Em terceiro lugar, os LLMs às vezes podem cometer erros, e a interface de bate-papo oferece uma maneira amigável de os usuários corrigirem e orientarem naturalmente os LLMs, que se acostumaram a ter conversas de acompanhamento e iterações durante o processo de bate-papo para esclarecer gradualmente os requisitos e resolver problemas.

No entanto.Bate-papo por streaming Há também algumas limitações. Em primeiro lugar, o streaming de bate-papo ainda é uma experiência de usuário relativamente nova e ainda não é comumente adotada pelas nossas plataformas de bate-papo comuns (por exemplo, iMessage, Facebook Messenger, Slack etc.); em segundo lugar, a experiência de usuário do streaming de bate-papo é um pouco insuficiente para tarefas com um longo tempo de execução, e os usuários podem precisar ficar na interface de bate-papo por um longo tempo esperando que o agente conclua a tarefa; em terceiro lugar, o streaming de bate-papo geralmente precisa ser acionado por usuários humanos, o que significa que ainda é necessário um grande envolvimento humano (Human-in-the-tray) durante a execução das tarefas. Em terceiro lugar, os chats de streaming geralmente são acionados por usuários humanos, o que significa que ainda há muito envolvimento humano no processo de execução do agente.

Chat sem streaming A principal diferença em relação ao bate-papo em fluxo contínuo é que as respostas do agente são retornadas em lotes. O LLM funciona silenciosamente em segundo plano, de modo que o usuário não precisa esperar impacientemente por uma resposta imediata do agente. Isso significa que o bate-papo sem streaming pode ser mais fácil de integrar aos fluxos de trabalho existentes. Os usuários estão acostumados a enviar mensagens de texto para seus amigos, então por que não "enviar mensagens de texto" com IA? O bate-papo sem streaming tornará a interação com sistemas de agentes mais complexos mais natural e fácil. Como os sistemas complexos de agentes geralmente levam muito tempo para serem executados, os usuários podem ficar frustrados se esperarem uma resposta imediata do agente. O bate-papo sem fluxo remove parte da expectativa de uma resposta imediata, facilitando a execução de tarefas mais complexas.

A tabela a seguir resume Bate-papo por streaming responder cantando Chat sem streaming As vantagens e desvantagens do

2. ambiente de fundo (Ambient UX)

Os usuários podem enviar mensagens ativamente para a IA, conforme discutido anteriormente Chat UI (Interface de bate-papo) Mas se o agente estiver sendo executado silenciosamente em segundo plano, como podemos interagir com ele? Mas como interagir com um agente se ele estiver sendo executado silenciosamente em segundo plano?

Para aproveitar todo o potencial do sistema de agentes, precisamos mudar o paradigma de HCI para um que permita a IA no sistema de agentes. Ambiente de back-end (Ambient UX) executadas em segundo plano. Quando as tarefas são processadas em segundo plano, os usuários geralmente podem tolerar tempos de conclusão de tarefas mais longos (porque reduzem a necessidade do latência expectativas). Isso permite que o agente tenha mais tempo para realizar mais tarefas e, em geral, faça mais raciocínios com mais cuidado e eficiência do que no Chat UX.

Além disso, em Ambiente de back-end (Ambient UX) A execução de um agente em uma interface de bate-papo ajuda a ampliar os recursos dos próprios usuários humanos. Normalmente, as interfaces de bate-papo limitam os usuários a uma tarefa de cada vez. No entanto, se o agente estiver sendo executado em um ambiente em segundo plano, é possível oferecer suporte a vários agentes trabalhando em várias tarefas ao mesmo tempo.

A chave para fazer com que um agente trabalhe de forma confiável em segundo plano é criar a confiança do usuário no agente. Como você cria essa confiança? Uma ideia simples: mostre ao usuário exatamente o que o Agent está fazendo. Mostrar todas as etapas que o Agent está executando em tempo real permite que o usuário observe o que está acontecendo. Embora essas etapas possam não ser tão imediatas quanto a transmissão de uma resposta, elas devem permitir que o usuário clique nelas a qualquer momento e veja o progresso da execução do Agente. Além disso, é importante não apenas permitir que o usuário veja o que o Agente está fazendo, mas também que o usuário corrija os erros do Agente. Por exemplo, se o usuário descobrir que o Agente tomou uma decisão errada na etapa 4 (de 10), ele terá a opção de voltar à etapa 4 e corrigir o comportamento do Agente de alguma forma.

Essa abordagem combina o modelo de interação usuário-agente De "In-the-loop" para "On-the-loop". . "On-the-loop". O modelo exige que o sistema seja capaz de mostrar ao usuário todas as etapas intermediárias executadas pelo Agente, permitindo que o usuário pause o fluxo de trabalho durante a execução de uma tarefa, forneça feedback e, em seguida, permita que o Agente continue a executar as tarefas subsequentes com base no feedback do usuário.

Engenheiro de software de IA Devin é representativo da implementação de aplicativos do tipo UX. O tempo de execução de um Devin normalmente é longo, mas o usuário pode ver claramente todas as etapas que o Agente executa, voltar ao estado de desenvolvimento em um momento específico e emitir instruções corretivas a partir desse estado. O fato de um Agente estar sendo executado em segundo plano não significa que ele precise executar tarefas de forma totalmente autônoma. Às vezes, um Agente pode não saber o que fazer em seguida ou pode não ter certeza de como responder à pergunta de um usuário. Nesse caso, o agente precisa chamar a atenção do usuário humano de forma proativa e buscar ajuda dele.

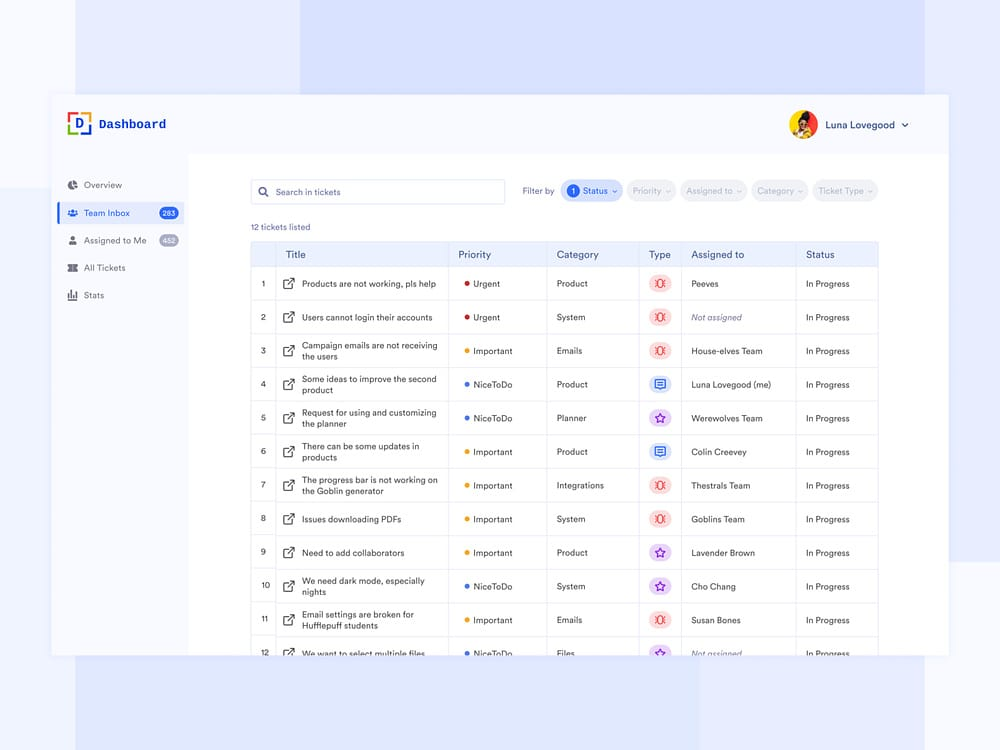

E-mail do agente assistente Sim Ambient UX (ambiente de fundo) Outro caso de uso para a LangChain. O fundador da LangChain, Harrison Chase, está construindo um agente assistente de e-mail. Embora o agente possa responder a e-mails simples automaticamente, em alguns casos ele exige que Harrison se envolva manualmente em tarefas que não se prestam à automação, como: revisar relatórios complexos de bugs da LangChain, revisar relatórios de erros complexos do LangChain, decidir se deve participar de uma reunião etc. Nesses casos, o Email Assistant Agent precisa de uma maneira eficiente de comunicar ao Harrison que precisa de assistência humana para continuar a concluir a tarefa. Observe que, em vez de pedir respostas diretamente ao Harrison, o Agente pede ao Harrison que dê sua opinião sobre determinadas tarefas e, em seguida, o Agente pode usar esse feedback humano para escrever um e-mail de qualidade ou agendar um convite no calendário de reuniões.

Atualmente, Harrison tem esse agente assistente de e-mail configurado em seu espaço de trabalho do Slack. Quando o agente precisa de assistência humana, ele envia uma pergunta para o Slack de Harrison, que pode ser respondida por Harrison no Painel, uma interação que se integra perfeitamente ao fluxo de trabalho diário de Harrison. Esse tipo de interação se integra perfeitamente ao fluxo de trabalho diário de Harrison. Esse tipo de UX é semelhante à UX que os clientes usam para dar suporte ao Dashboard. A interface do Dashboard mostra claramente todas as tarefas para as quais o assistente precisa de ajuda humana, a prioridade da solicitação e outros dados relevantes.

3. experiência do usuário em planilhas

UX de planilhas É uma interação muito intuitiva e fácil de usar, especialmente adequada para trabalhos de processamento em lote. Na interface da planilha, cada tabela, ou mesmo cada coluna, pode ser tratada como um agente separado para pesquisar e processar tarefas específicas. Esse recurso de processamento em lote permite que os usuários ampliem facilmente sua interação com vários agentes.

UX de planilhas Há também outras vantagens. O formato de planilha é uma UX com a qual a maioria dos usuários está familiarizada, portanto, é fácil de integrar aos fluxos de trabalho existentes. Esse tipo de UX é ideal para cenários de enriquecimento de dados em que cada coluna da planilha pode representar um atributo de dados diferente que precisa ser expandido.

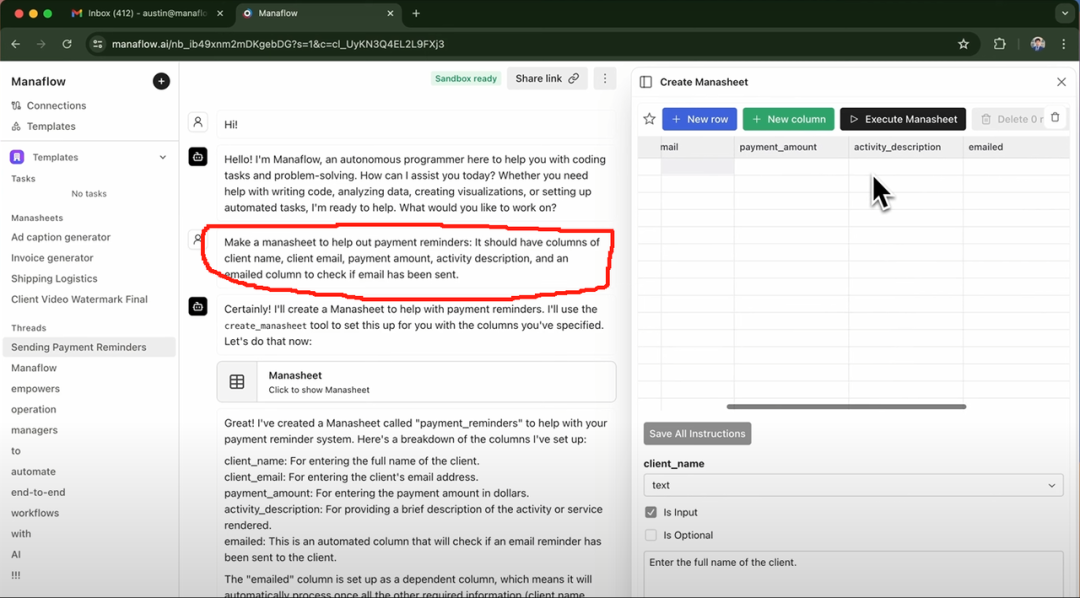

Exa AI, Clay AI, Manaflow e outros usaram o UX de planilhas A seguir, um exemplo de Manaflow. A seguir, um exemplo de Manaflow UX de planilhas Como isso se aplica aos fluxos de trabalho de interação com o agente.

Estudo de caso: como a Manaflow usa planilhas para interações com agentes

O Manaflow foi inspirado pela Minion AI, a empresa para a qual seu fundador, Lawrence, trabalhou. O principal produto da Minion AI é o Web Agent. O Web Agent pode controlar a Google Chrome e permite que os usuários interajam com vários aplicativos da Web por meio do Web Agent, como reservar voos on-line, enviar e-mails, reservar lavagens de carro etc. Inspirada pela Minion AI, a Manaflow optou por permitir que o agente manipule diretamente ferramentas como planilhas. A equipe da Manaflow acredita que os agentes não são bons em trabalhar diretamente com interfaces de interface de usuário humanas, e que os agentes são realmente bons em Codificação O Manaflow é o primeiro de seu tipo no mundo. Como resultado, o Manaflow permite que o agente chame scripts Python, interfaces de banco de dados e interfaces de API diretamente da interface da interface do usuário e, em seguida, opere diretamente no banco de dados, incluindo leitura de dados, agendamento, envio de e-mail e assim por diante.

O fluxo de trabalho do Manaflow é o seguinte: a principal interface interativa do Manaflow é uma planilha eletrônica (Manasheet). Cada coluna da Manasheet representa uma etapa do fluxo de trabalho, e cada linha corresponde a um agente de IA que executa uma tarefa específica. Cada fluxo de trabalho da Manasheet é programável em linguagem natural (permitindo que usuários não técnicos descrevam tarefas e etapas em linguagem natural). Cada Manasheet tem um gráfico de dependência interna que determina a ordem de execução de cada coluna. Essas ordens de execução são atribuídas aos agentes em cada linha, que executam tarefas em paralelo, lidando com processos como transformação de dados, chamadas de API, recuperação de conteúdo e envio de mensagens:

As Manasheets podem ser geradas de várias maneiras. A maneira mais comum é inserir um comando de linguagem natural, como o da caixa vermelha acima. Por exemplo, se você quiser enviar e-mails em massa com informações sobre preços para seus clientes, poderá inserir um Prompt por meio da interface do Chat, e o Agent gerará automaticamente uma Manasheet. A Manasheet mostra o nome do cliente, o endereço de e-mail, o setor e se o e-mail foi enviado ou não, entre outras informações importantes. Os usuários podem simplesmente clicar no botão "Execute Manasheet" para executar tarefas de envio de e-mails em massa.

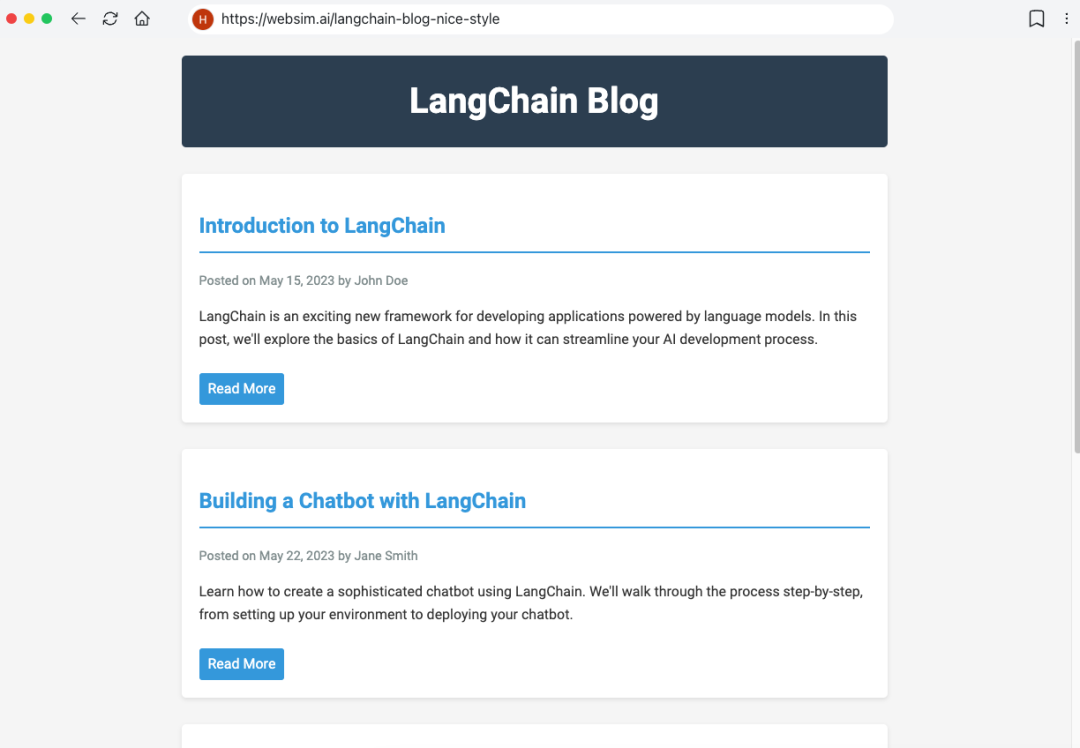

4. interface do usuário generativa

"IU generativa". Há duas implementações principais diferentes.

A primeira maneira é o modelo gerar de forma autônoma o Componentes da interface do usuário . Isso é semelhante a Websim e outros produtos. Em segundo plano, o Agente escreve principalmente o código HTML bruto, o que lhe dá controle total sobre o que a interface do usuário exibe. No entanto, a desvantagem dessa abordagem é que a qualidade do aplicativo Web resultante é altamente incerta e a experiência do usuário pode ser variável.

Outra abordagem mais restrita é predefinir um conjunto de componentes de interface do usuário comumente usados e, em seguida, passá-los pelo Chamadas de ferramentas para renderizar dinamicamente os componentes da IU. Por exemplo, se o LLM chamar a API de clima, ele acionará a renderização do componente da interface do usuário do mapa meteorológico. Como os componentes da interface do usuário renderizados são predefinidos (e o usuário tem mais opções), a interface do usuário resultante será mais refinada, mas sua flexibilidade será um pouco limitada.

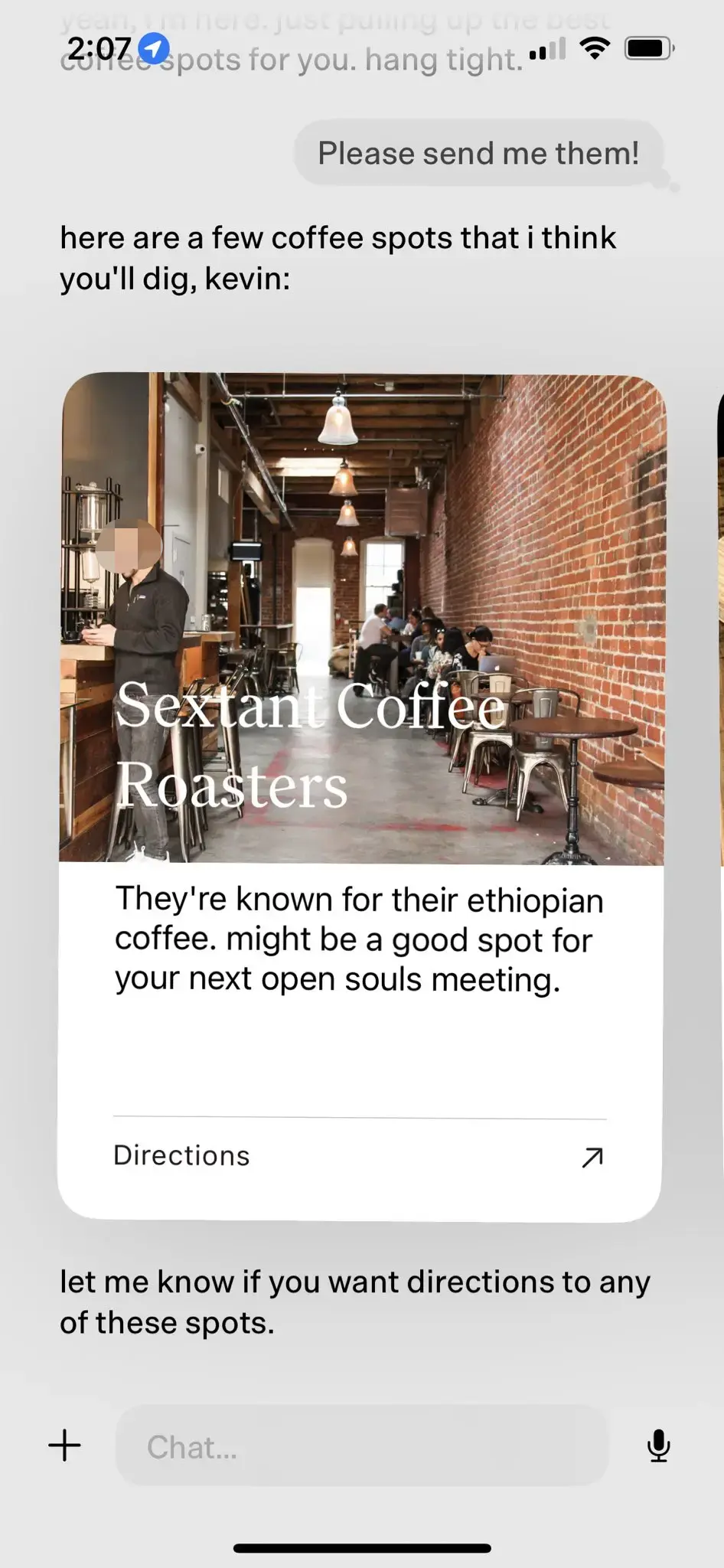

Estudo de caso: ponto do produto de IA pessoal

Produtos pessoais de IA ponto Sim UI generativa O melhor exemplo disso. O dot foi aclamado como o "melhor produto de IA pessoal" em 2024.

ponto Sim Novo Computador O principal produto da empresa. O objetivo do dot é ser um companheiro digital de longo prazo para os usuários, não apenas uma ferramenta eficiente de gerenciamento de tarefas. Como diz Jason Yuan, cofundador da New Computer, o cenário de aplicação do dot é "quando você não sabe para onde ir, o que fazer ou o que dizer, você recorre ao dot". Aqui estão alguns casos de uso típicos do dot:

- Jason Yuan, fundador da New Computer, sempre pede ao dot recomendações de bares tarde da noite na esperança de "ficar bêbado". Depois de meses de conversas em bares tarde da noite, um dia Jason Yuan fez uma pergunta semelhante a dot, e dot começou a dizer a Jason que "não podia continuar assim".

- O repórter da Fast Company, Mark Wilson, também passou alguns meses com o dot. Em um determinado momento, ele compartilhou com o dot um "O" manuscrito que havia escrito em uma aula de caligrafia. Surpreendentemente, dot imediatamente mostrou uma foto do "O" escrito à mão por Mark Wilson algumas semanas antes e o elogiou por sua "grande melhoria" na caligrafia.

- À medida que os usuários usam o dot por períodos de tempo cada vez mais longos, o dot é capaz de obter uma compreensão mais profunda de seus interesses e preferências. Por exemplo, quando o dot descobre que um usuário gosta de visitar cafeterias, ele ativamente empurra cafeterias de qualidade próximas para o usuário, detalha os motivos da recomendação e pergunta ao usuário se ele precisa navegar no final.

No caso da recomendação de café acima, o dot realiza o efeito natural de interação humano-computador com base no LLM-native por meio de componentes de IU predefinidos.

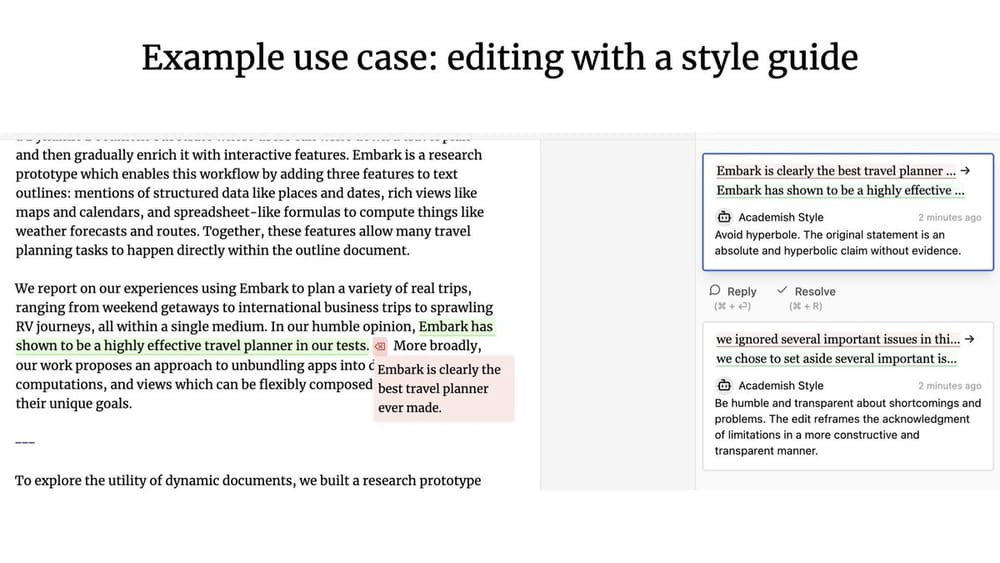

5. UX colaborativa

Que tipo de modelo de interação humano-computador é criado quando um agente e um usuário humano trabalham juntos? Semelhante ao Google Docs, vários usuários podem colaborar em tempo real para escrever ou editar o mesmo documento. E se um dos colaboradores for um agente?

Geoffrey Litt com Ink & Switch Projeto Patchwork É homem-máquina. UX colaborativa O projeto Patchwork é um ótimo exemplo do que é a OpenAI. (Nota do tradutor: a atualização do produto Canvas, lançada recentemente pela OpenAI, pode ter sido inspirada pelo projeto Patchwork).

UX colaborativa Em contraste com o que foi discutido anteriormente Ambient UX (ambiente de fundo) Qual é a diferença? Nuno, o engenheiro fundador da LangChain, enfatiza que a principal diferença entre os dois é a disponibilidade do Concorrência ::

- existir UX colaborativa Nesse caso, o usuário humano e o LLM geralmente precisam trabalhar simultaneamente e usar o produto do trabalho um do outro como entrada.

- existir Ambient UX (ambiente de fundo) Nesse caso, o LLM é executado continuamente em segundo plano, enquanto o usuário pode se concentrar em outras tarefas sem precisar ficar de olho no status do agente em tempo real.

Memória

Memória É fundamental melhorar a experiência do usuário do Agent. Imagine se o seu colega nunca se lembra de nada do que você disse a ele e fica pedindo que você repita a mesma coisa várias vezes. É comum esperar que os sistemas LLM sejam inerentemente capazes de lembrar, provavelmente porque os LLMs são, de certa forma, muito próximos da cognição humana. Entretanto, os LLMs não têm inerentemente recursos de memória.

Agente Memória O design precisa ser adaptado às necessidades específicas do próprio produto. Diferentes paradigmas de UX também oferecem diferentes métodos de coleta de informações e atualização de feedback. Com base nos mecanismos de memória dos produtos do agente, podemos observar diferentes tipos de padrões de memória de alto nível que, até certo ponto, imitam os tipos de memória humana.

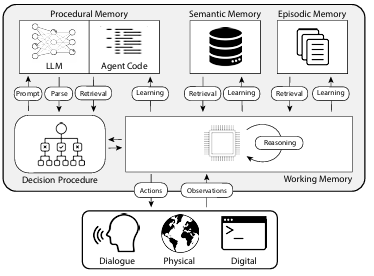

O artigo "CoALA: Cognitive Architectures for Language Agents" mapeia os tipos de memórias humanas para os mecanismos de memória dos agentes, categorizados conforme mostrado na figura abaixo:

1. memória processual

Memória processual É uma maneira de falar sobre Como realizar tarefas da memória de longo prazo, semelhante ao conjunto central de instruções do cérebro humano.

- Memória processual humana. Por exemplo, lembre-se de como andar de bicicleta.

- Memória processual do agente. O artigo do CoALA descreve a memória processual como uma combinação de pesos LLM e código do agente que determina fundamentalmente como o agente funciona.

Na prática, a equipe da Langchain não encontrou nenhum sistema de agente que atualize automaticamente seus LLMs ou reescreva seu código. No entanto, existem alguns sistemas de agentes que podem atualizar dinamicamente seus Prompt do sistema O caso a favor.

2 Memória semântica

Memória semântica É uma reserva de conhecimento de longo prazo para armazenar conhecimento factual.

- Memória semântica em seres humanos. Consiste em várias informações, como fatos, conceitos e relações entre eles, aprendidas na escola.

- Memória semântica para agentes. O artigo do CoALA descreve a memória semântica como um repositório de conhecimento factual.

Na prática, a memória semântica de um agente geralmente é obtida com o uso do LLM para extrair informações do diálogo ou do processo de interação do agente. A maneira exata como as informações são armazenadas geralmente depende do aplicativo específico. Em seguida, nos diálogos subsequentes, o sistema recupera essas informações armazenadas e as insere no Prompt do sistema para influenciar a resposta do agente.

3 Memória episódica

Memória episódica Usado para recordar eventos passados específicos.

- Memória situacional em seres humanos. A memória situacional é usada quando uma pessoa se lembra de eventos específicos (ou "episódios") vividos no passado.

- Memória situacional para o agente. O documento CoALA define a memória situacional como uma sequência que armazena as ações passadas de um agente.

A memória de cenário é usada principalmente para garantir que o Agente funcione conforme o esperado. Na prática, a memória situacional geralmente é atualizada por meio da função Prompt de poucas fotos para conseguir isso. Se, na fase inicial, o sistema passar pelo Prompt de poucas fotos Se o Agente for instruído a concluir a operação corretamente, ele poderá reutilizar diretamente esse método de operação ao enfrentar problemas semelhantes no futuro. Por outro lado, se não houver um método eficaz para orientar o Agente a operar corretamente, ou se o Agente precisar experimentar novos métodos de operação, então o Memória semântica se tornará ainda mais importante.Memória episódica A função nesses cenários é relativamente limitada.

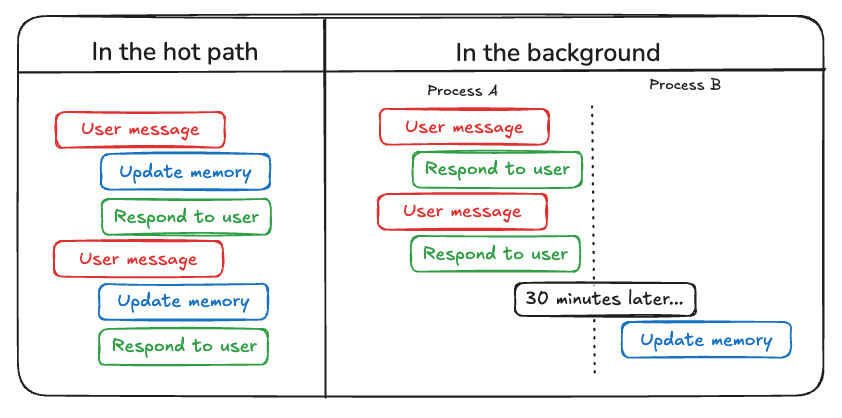

Além de considerar os tipos de memórias que precisam ser atualizadas no Agent, os desenvolvedores precisam considerar Como atualizar a memória do agente . Atualmente, há dois métodos principais para atualizar a memória do agente:

O primeiro método é "no caminho quente (atualização do caminho quente)" . Nesse modelo, o sistema do agente lembra as informações factuais relevantes em tempo real antes de gerar uma resposta (geralmente obtida por meio de uma chamada de ferramenta). Atualmente, o ChatGPT usa essa abordagem para atualizar sua memória.

O segundo método é "em segundo plano (atualização em segundo plano)" . Nesse modo, um processo em segundo plano é executado de forma assíncrona no final da sessão e atualiza a memória do agente em segundo plano.

"no caminho quente (atualização do caminho quente)" A desvantagem do método é que, antes de qualquer resposta ser retornada, uma certa quantidade de latência . Além disso, ele precisa incorporar lógica de memória junto com lógica do agente Totalmente integrado.

"em segundo plano (atualização em segundo plano)" O método evita efetivamente o problema acima, não aumenta a latência da resposta e o lógica de memória podem permanecer relativamente independentes. No entanto "em segundo plano (atualização em segundo plano)" Ele também tem suas próprias deficiências: a memória não é atualizada imediatamente, e é necessária uma lógica adicional para determinar quando iniciar o processo de atualização em segundo plano.

Outra abordagem para atualizar as memórias envolve o feedback do usuário, que é semelhante ao Memória episódica particularmente relevantes. Por exemplo, se um usuário der uma classificação alta a uma interação com o agente (Feedback positivo), o agente pode salvar esse feedback para ser usado em cenários semelhantes no futuro.

Com base na compilação acima, o AI Share acredita que o desenvolvimento simultâneo e o progresso contínuo dos três elementos principais, ou seja, capacidade de planejamento, inovação na interação e mecanismo de memória, darão origem a aplicações mais práticas de agentes de IA em 2025 e nos levarão a uma nova era de trabalho colaborativo homem-máquina.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...