RTX4090グラフィックスカードでDeepSeek-R1の大型モデルを動かすのに最適なバージョンはどれですか?

RTX 4090グラフィックカードでDeepSeek-R1を実行。Q4_K_M定量化671Bフルブラッドバージョンの推奨優先順位KTransformersに依存するのであれば、14Bまたは32Bの定量化バージョンが続く。 アンクロス 量的バージョンも紹介された。 オーラマ インストール・チュートリアル DeepSeek R1 671B 現地展開チュートリアル:Ollamaと動的定量化に基づくあなたのニーズが「極端なパワー」なのか「よりスピード」なのかによる。あなたのニーズが「極端なパワー」なのか「よりスピード」なのかによる。

1️ȃ RTX 4090 フルブラッドバージョン(671B)も走るのか?

そうだね!清華チームの Kトランスフォーマー 4090グラフィックスカード1枚でフルブラッド版を走らせる。

- 必要VGAメモリQ4_K_M Quantised Editionは14GBのビデオメモリしか必要としませんが、4090の24GBで十分です。

- ペース前処理速度は最大286ワード/秒、生成速度は約14ワード/秒と、すでに一般人には見られないほどだ。

- シナリオ複雑な推論を必要とするタスク、例えばコードの記述や複数ラウンドの対話など。

2️⃣ 遅すぎる場合は?小さいバージョンを試してください

14ワード/秒では遅すぎると感じる場合は、より小型のモデルを選ぶことができる:

- 14B定量化バージョン必要なグラフィック・メモリは約6.5GBで、日々の執筆や翻訳をより高速に行うことができます。

- 32B量子化バージョン14.9GBのビデオメモリを必要とし、長いテキスト処理(論文全体の分析など)をサポートします。

3️⃣ なぜフルブラッドが代わりに走るのか?

ここに技術的なトリックがある:定量的+計算オフロード.

- 定量的例えば4ビットの量子化(Q4)は、70%のメモリフットプリントを削減します。

- 荷降ろしの計算重要でない計算タスクはCPUに任せて、GPUに得意なことをさせる。

4️⃣ 他のグラフィックス・ソリューションとの比較

ここでも、フルブラッドバージョンを走らせる:

- H100グラフィックス・クラスタ何十万ドルもかかり、スピードは速くなるが、一般人には手が届かない。

- 自作グラフィックカード相性だけでは十分ではない。

評決を下す4090は圧倒的にコストパフォーマンスが高い。

5️⃣ 配備のヒント

- 支出

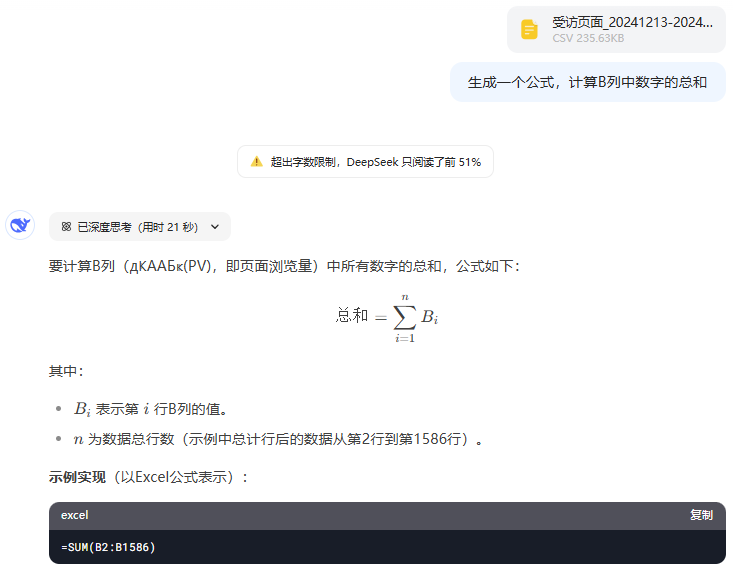

KTransformersこのフレームワークはワンクリックでデプロイでき、ChatGPTと同じインターフェイスを備えています。 - メモリが不足している場合は、「6人のエキスパートだけをアクティブにする」モードを試してみるとよい。

最もスマートなAIには671B Quantizedを、スムーズな対話には14B/32Bを、4090はすべてを兼ね備えている!

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません