XRAG:検索機能拡張生成システムの最適化のための視覚的評価ツール

はじめに

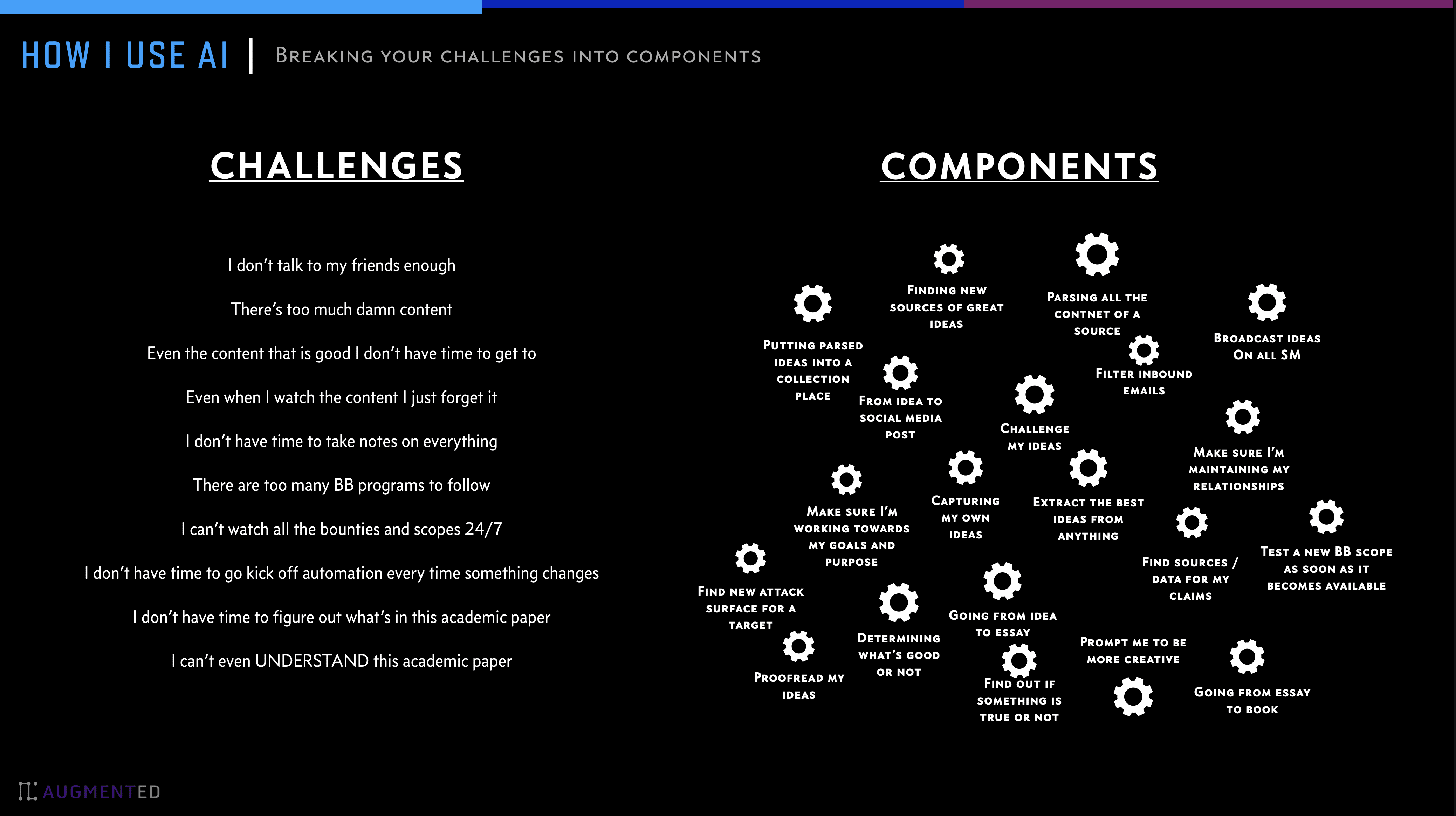

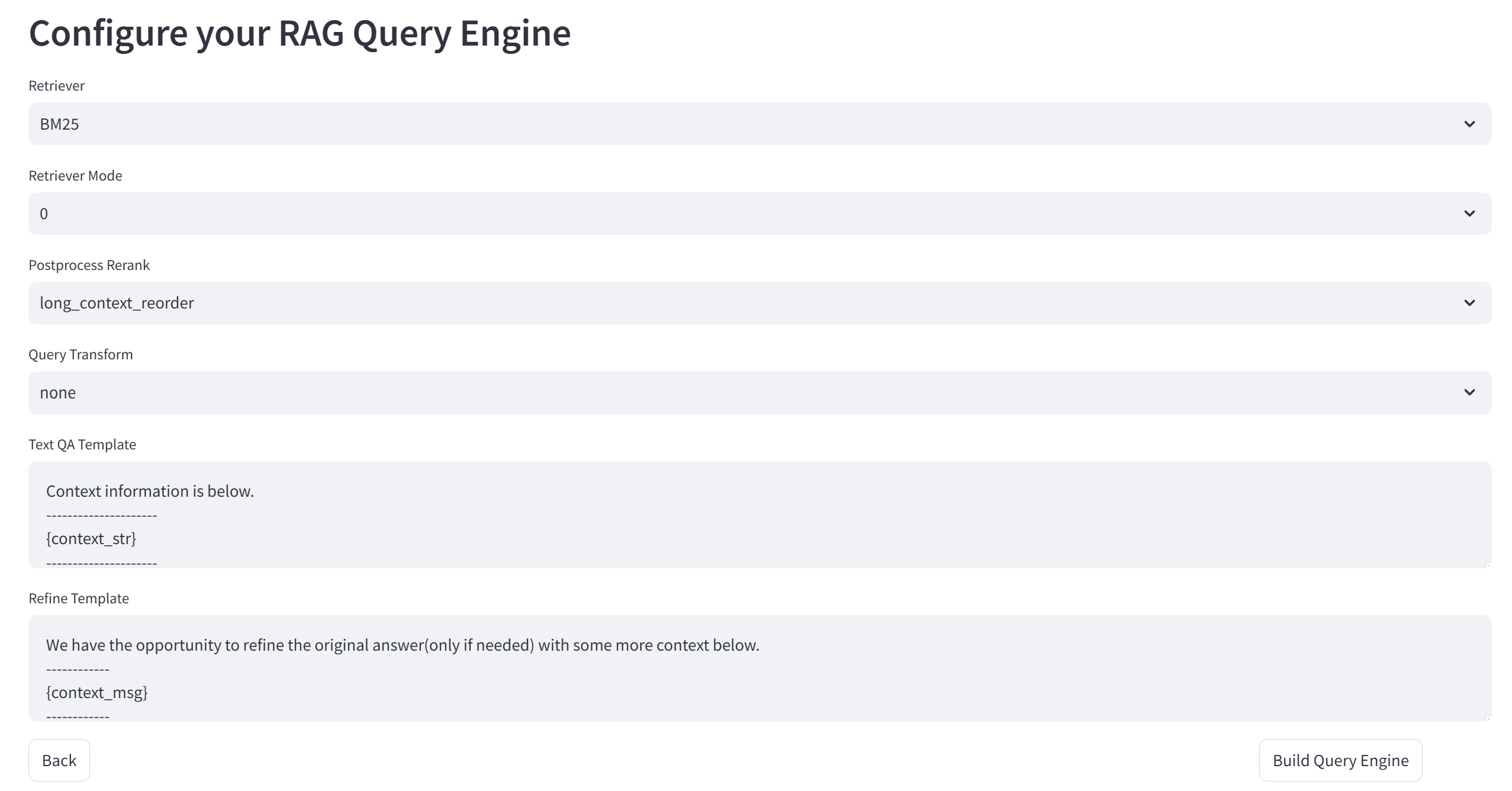

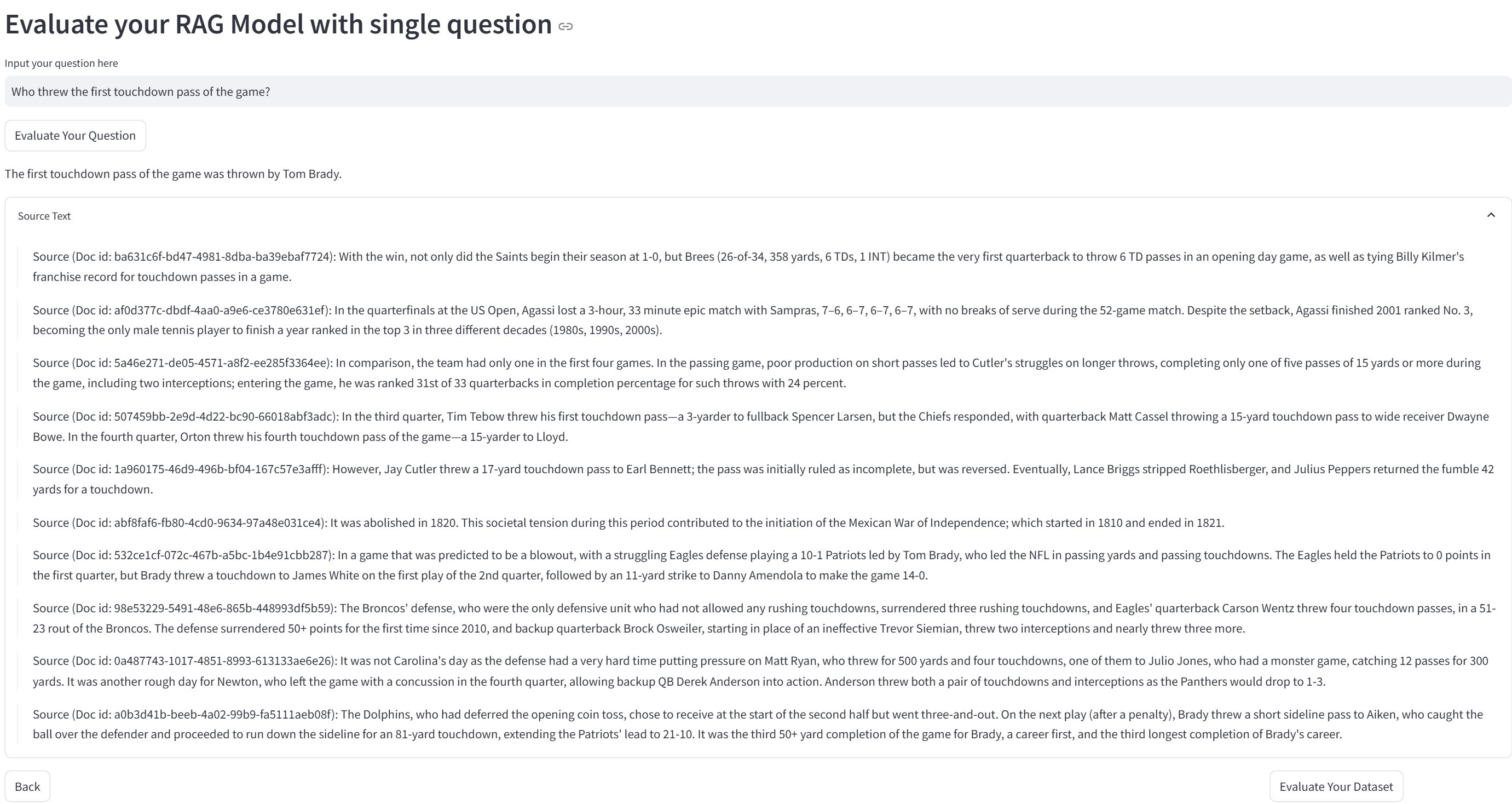

XRAG (eXamining the Core)は、高度な検索補強生成(RAG)システムの基本コンポーネントを評価するために設計されたベンチマークフレームワークである。各コアモジュールのプロファイリングと分析により、XRAGは、異なる構成とコンポーネントがRAGシステムの全体的な性能にどのように影響するかについての洞察を提供します。このフレームワークは、複数の検索手法と評価指標をサポートしており、研究者や開発者がRAGシステムのあらゆる側面を最適化し、改善するのに役立つように設計されている。

XRAGは包括的なRAG評価ベンチマークとツールキットをサポートし、50以上のテストメトリクスとRAGの包括的な評価と障害点の最適化をカバーし、4種類の高度なRAGモジュール(クエリ再構成、高度な検索、質問と回答モデル、後処理)の比較をサポートし、モジュール内の複数の特定の実装を統合し、OpenAI Big Model APIをサポートします。XRAGバージョン1.0はまた、シンプルなWeb UIデモ、軽いインタラクティブなデータアップロードと統一された標準フォーマットを提供し、RAGの障害検出と最適化メソッドを統合する。 記事とコードは現在オープンソースです。

機能一覧

- 統合評価の枠組みLLMベースの評価、詳細な評価、従来の評価基準など、多面的な評価をサポート。

- 柔軟なアーキテクチャ複数の検索方法とカスタマイズされた検索戦略をサポートするモジュラー設計。

- マルチLLMサポートOpenAIモデルとのシームレスな統合と、ネイティブモデル(Qwen、LLaMAなど)のサポート。

- 豊富な評価指標:: 従来のメトリクス(F1、EM、MRRなど)とLLMベースのメトリクス(真実性、関連性など)が含まれる。

- 高度な検索方法サポートBM25、ベクトル意味検索、木構造検索、その他の検索方法。

- ユーザーフレンドリーなインターフェースコマンドラインインターフェイスとウェブUIを提供し、インタラクティブな評価と視覚化をサポート。

ヘルプの使用

設置プロセス

- クローン倉庫::

git clone https://github.com/DocAILab/XRAG.git

cd XRAG

- 依存関係のインストール::

pip install -r requirements.txt

- 設定環境必要に応じて変更

config.tomlファイルでモデルのパラメータとAPIの設定を行う。

使用ガイドライン

- ウェブUIの起動::

xrag-cli webui

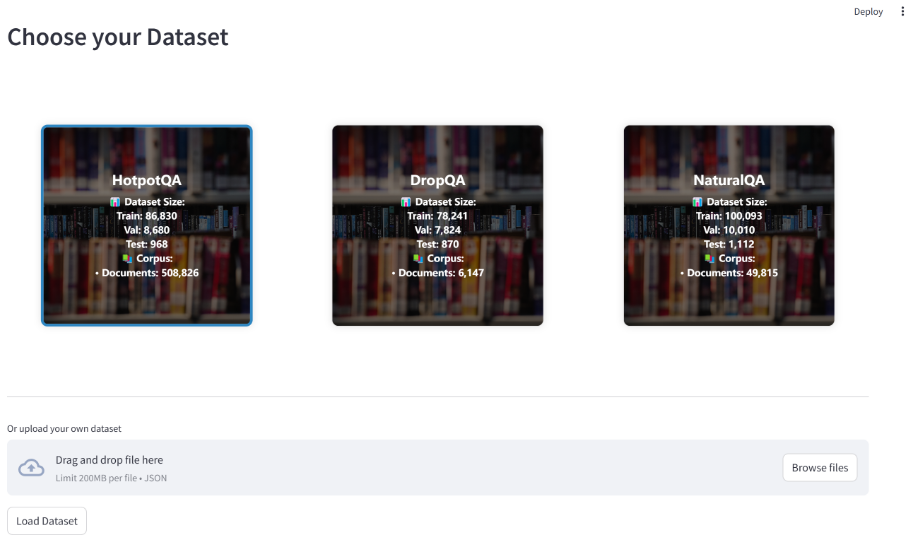

複数のベンチマークデータセット(HotpotQA、DropQA、NaturalQAなど)をサポートするWeb UIを介して、データセットのアップロードと設定を行います。

- 運用評価コマンドラインツールを使用して評価を実行します:

xrag-cli evaluate --dataset <dataset_path> --config <config_path>

評価結果については、詳細なレポートと可視化チャートが作成される。

- カスタマイズされた検索戦略修正

src/xragディレクトリのコードを使用して、検索ストラテジーや評価モデルを追加または調整することができます。

主な機能

- データセットのアップロードと設定Web UI経由でデータセットをアップロードし、必要に応じて設定します。

- 評価ランアセスメント指標と検索方法を選択し、アセスメントを実行して結果を表示します。

- 結果の分析評価結果を分析し、生成されたレポートやビジュアルダイアグラムを通じてシステムパフォーマンスを最適化します。

Ollamaフレームワーク:XRAGで効率的な局所検索推論を可能にする

OllamaはXRAG-Ollamaの局所検索推論フレームワークにおいて重要な役割を果たしている。Ollamaはオープンソースで使いやすく、ローカルなビッグモデルを実行するフレームワークとして、XRAGに強力なローカライズ検索推論機能を提供し、XRAGが検索強化生成を最大限に活用できるようにする。

なぜXRAGの配備をローカライズするのか?

- 外部リスクの低減: ローカル展開を使用することで、外部サービスへの依存を減らし、不安定なサードパーティ製サービスやデータ漏洩に関連する潜在的なリスクを低減することができる。

- オフライン可用性地域化されたRAGシステムは、インターネット接続に依存しないため、ネットワークが停止した場合でも正常に動作し、サービスの継続性と安定性を保証します。

- データの自律的管理例えば、プライベートデータをローカルのベクターデータベースに組み込むことで、データが組織独自のセキュリティ基準やビジネス要件に沿って処理されることを保証します。

- データプライバシーとセキュリティローカル環境でRAGシステムを稼動させることで、機密データがネットワーク経由で送信され漏洩するリスクを回避し、データが常にローカル管理下にあることを保証します。これは、機密情報を扱う組織にとって特に重要です。

なぜオーラマなのか?

Ollamaは、ローカルマシン上で大規模言語モデル(LLM)を構築・実行するための、軽量で拡張可能なフレームワークです。モデルを作成、実行、管理するためのシンプルなAPIと、様々なアプリケーションで簡単に使用できる構築済みモデルのライブラリを提供します。DeepSeek、Llama 3.3、Phi 3、Mistral、Gemma 2など幅広いモデルをサポートしているだけでなく、最新のハードウェアアクセラレーション計算を利用することができるため、XRAGの高性能推論をサポートする。 さらに、Ollamaはモデルの量子化をサポートしており、グラフィックス・メモリ要件を大幅に削減することができる。例えば、4ビット量子化はFP16精度のウェイトパラメータを4ビット整数精度に圧縮し、モデルのウェイト量と推論に必要なグラフィックスメモリを大幅に削減します。これにより、平均的な家庭用コンピュータで大規模なモデルを実行することが可能になります。

Ollamaと組み合わせることで、XRAGは複雑な環境設定や大量の計算リソースに依存することなく、大規模な言語モデルをローカルで効率的に実行することができ、導入コストや運用コストを大幅に削減することができる。同時に、このローカル・デプロイメント・ソリューションにより、開発者はデータ処理を完全にコントロールすることができ、生データのクリーニングから、ベクトル化処理(ChromaDBによるプライベートナレッジベースの構築など)、最終的なアプリケーションの実装まで、カスタマイズの全チェーンをサポートする。そのローカル・インフラストラクチャ・ベースのデプロイメント・アーキテクチャは、当然ながらオフライン運用が可能であり、サービスの継続性を保証するだけでなく、特殊な環境(機密ネットワークなど)におけるシステムの信頼性に対する厳しい要件も満たしている。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません