DeepSeek-R1に基づくWeChatインテリジェントチャットボットのWindowsネイティブ展開

新年明けましておめでとうございます!新年明けましておめでとうございます!最近、私の友人の輪は ディープシーク-R1 DeepSeekは国産のオープンソースモデルです!DeepSeek-R1のチュートリアルをローカルに展開する方法について、オンラインではかなり多くなっていますが、今日は、実践的な例と組み合わせて、DeepSeek-R1を実際に試してみて、それが実際にどれほど強力なものであるかを確認するために、手を携えて、何か違うことをやってみましょう!最初のステップは、DeepSeek-R1を使用してローカル環境に新しいシステムをデプロイすることです!

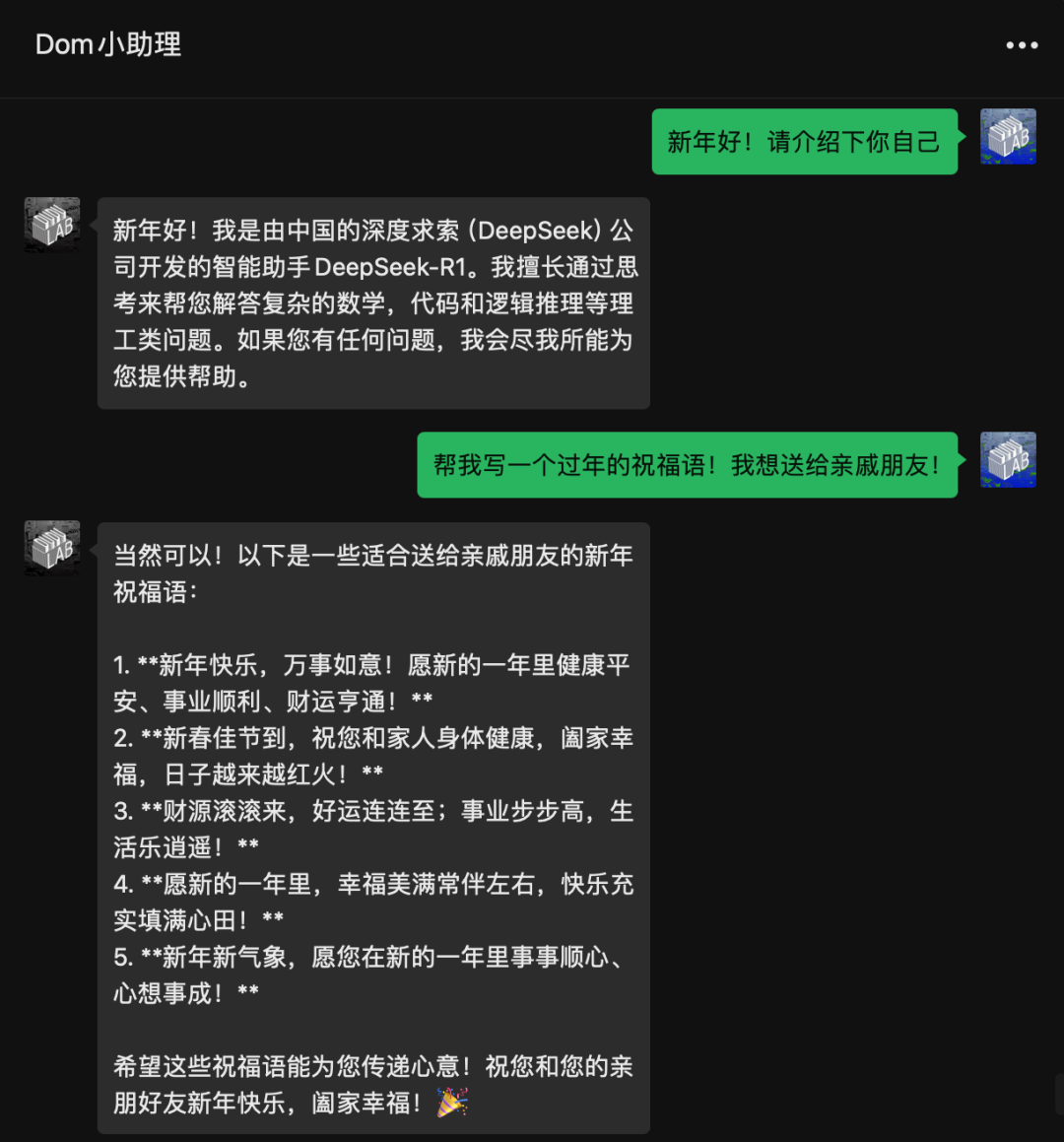

今回は主にWeChatインテリジェントチャットボットを行うためにWeChatにアクセスするためにローカルのDeepSeekR1を使用する方法を共有します!Ollamaのローカル展開、WeChatへのアクセス、設定の変更です。

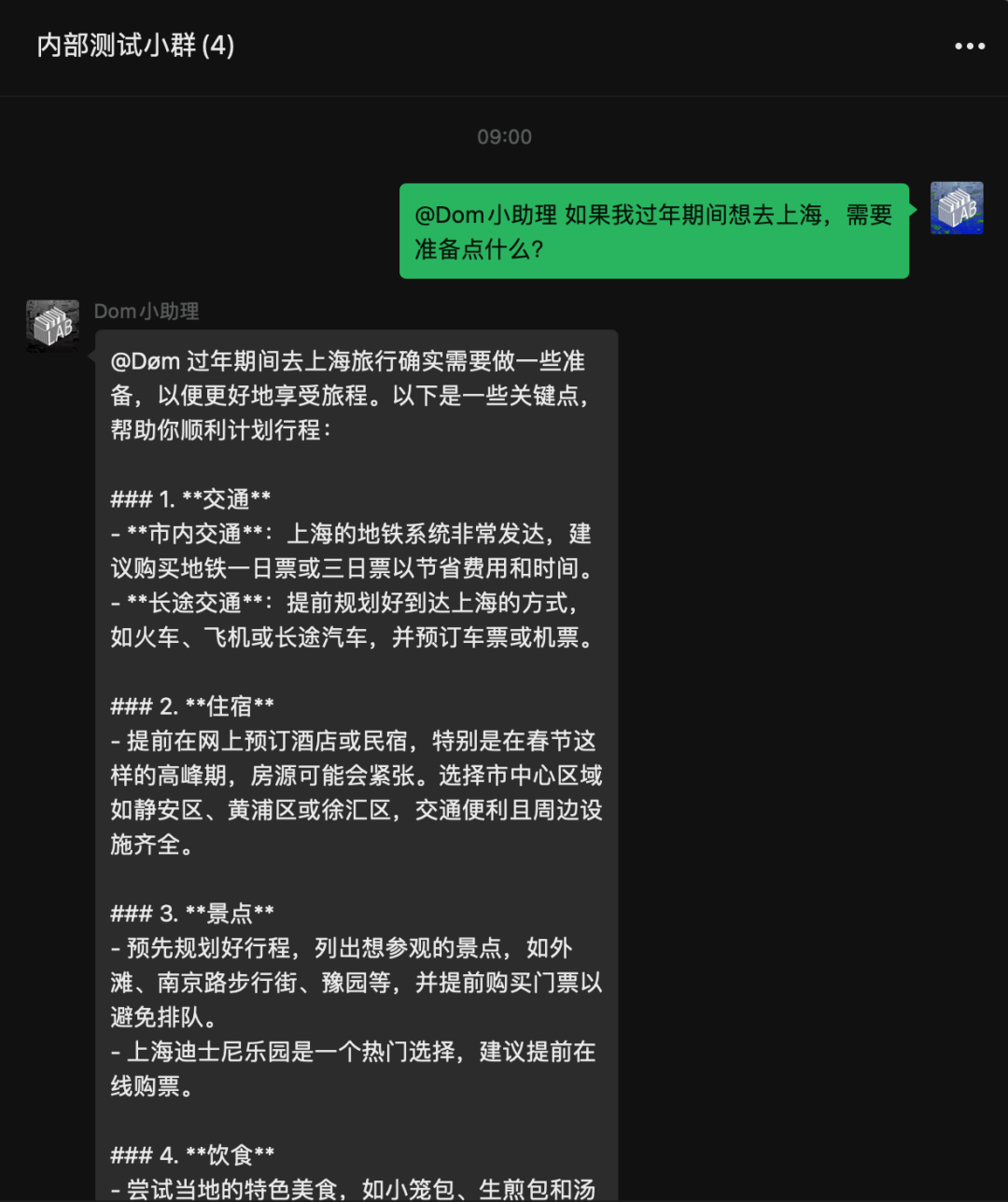

これがアクセスの効果だ!すべてローカライズされています!DeepSeekのapiにアクセスする必要はありません。

すべてのプロセスは難しくなく、10分ほどで終わります。複雑な作業はすべてカプセル化したので、必要なのはダウンロードしてインストールして実行するだけだ!

DeepSeek-R1のローカル展開

まず、DeepSeek-R1 をローカルに展開する必要があります。DeepSeek-R1 をローカルにインストールできない場合は、次の手順に進んでください:無料のGPUパワーでDeepSeek-R1オープンソースモデルをオンライン展開

注意しなければならないのは、1.5B、7B、8BなどはR1の推論によって強化されたQwen/llamaの「蒸留」バージョンであり、本物のR1ではないことである。単純に、純血のR1ではなく、Qwen2.5-1.5Bまたはllama+R1の混合体験であると理解できる。671Bフルボリューム版が本物のR1だが、もちろん、私たちの一般消費者向けグラフィックカードは671Bフルボリューム版を取ることができないので、まず蒸留版を使ってプレイする。

オッラマの設置

ここでは、私のネットワーク・ドライブにあるOllamaというツールを使う。

公式サイト

https://ollama.com/

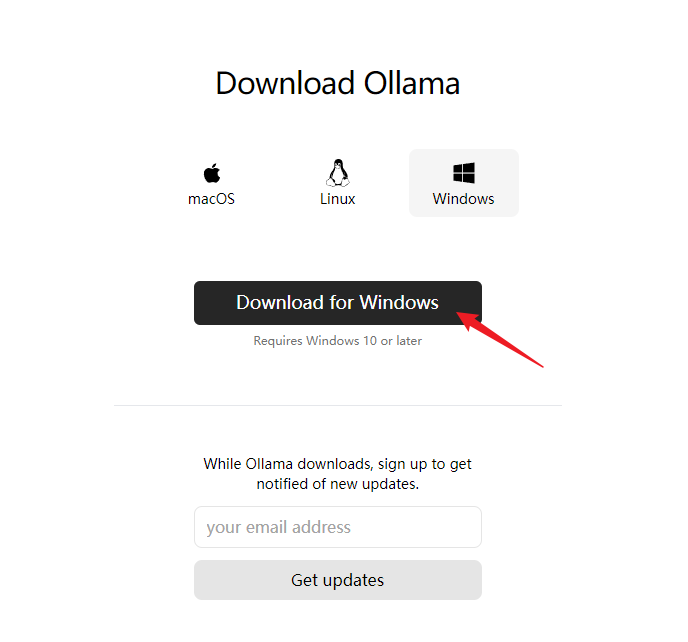

ダウンロードウィンドウズ版(ここでは、WeChatへのアクセス、WeChatの制限のために、現時点では、唯一のサポートWindowsプラットフォーム)と言うために

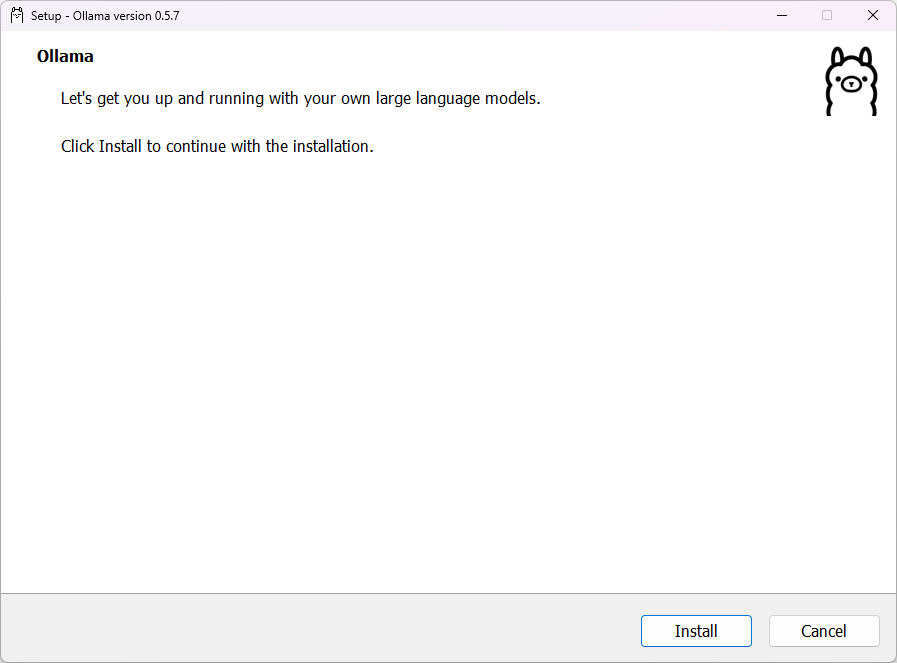

インストールパスとモデルパスの設定

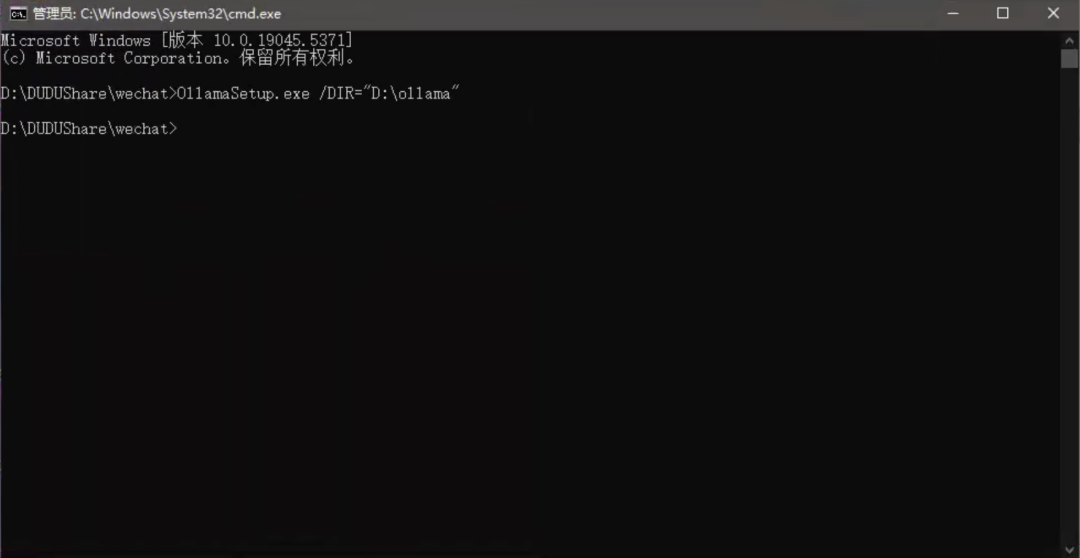

デフォルトではCドライブにインストールされます。インストーラーを開いてインストールします。/DIR=でインストールパスを指定する。

OllamaSetup.exe /DIR="D:ollama"

CドライブにOllamaをインストール済みで、インストール・ディレクトリを変更したい場合。

このパスをOllamaフォルダをインストールしたいディレクトリに移動する。

C:Users你的用户名AppDataLocalProgramsOllama

例えば

E:Ollama

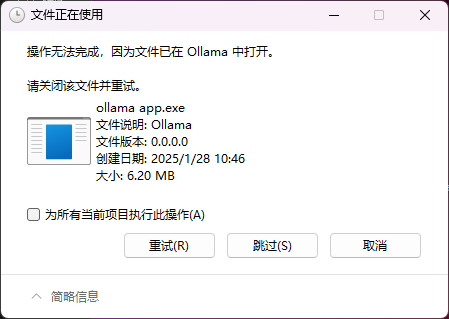

引っ越しの際に次のような問題が発生することがある。Ollamaデフォルトですでに始まっている。

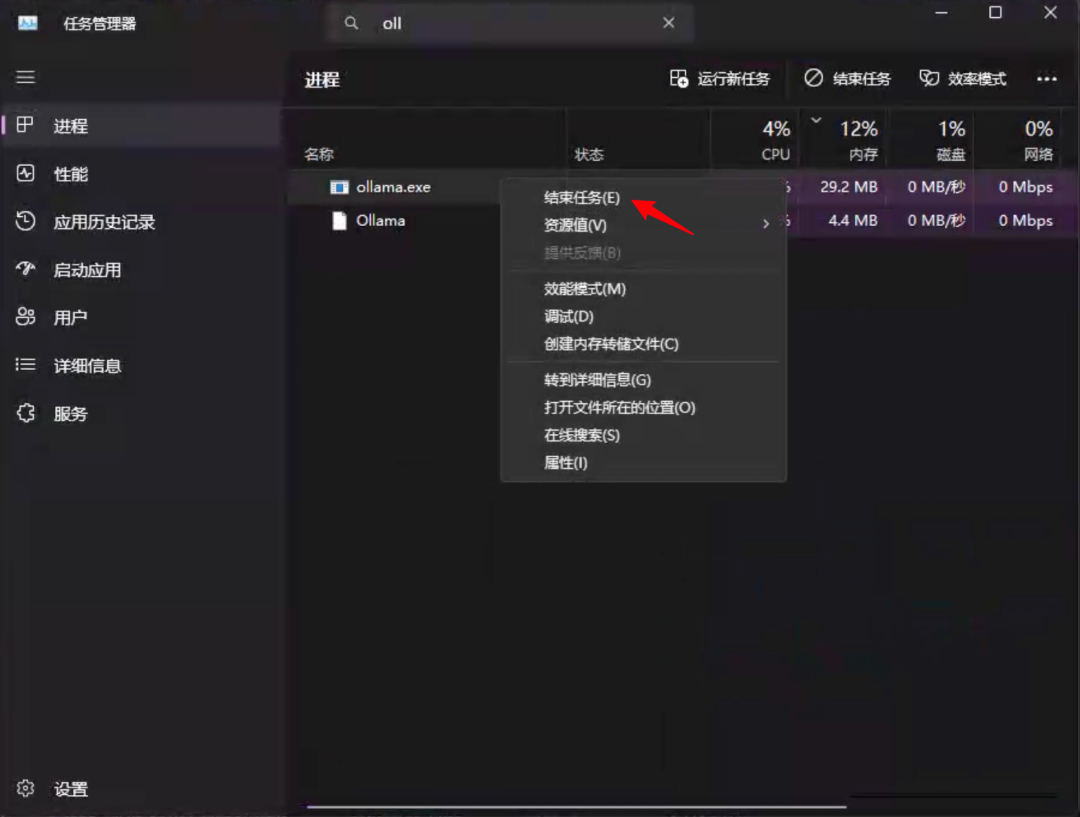

タスクマネージャーで見つける必要があるOllama歌で応えるollama.exe両方のプロセスについて、右クリック结束任务.まず閉鎖する必要があるOllama再閉鎖ollama.exe.

次に環境変数を変更する必要がある。

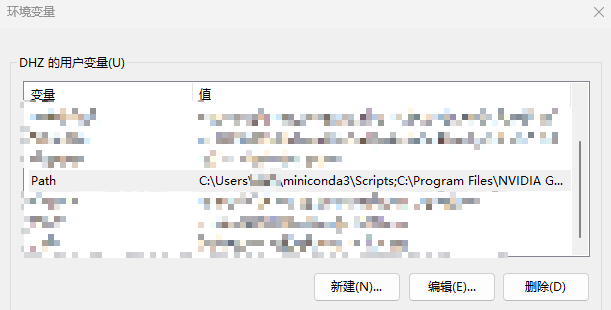

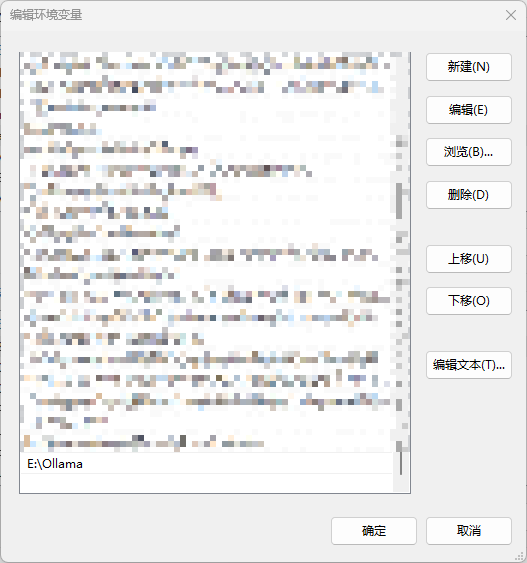

設定-詳細システム設定-環境変数-検索パスを開き、ダブルクリックして編集します。

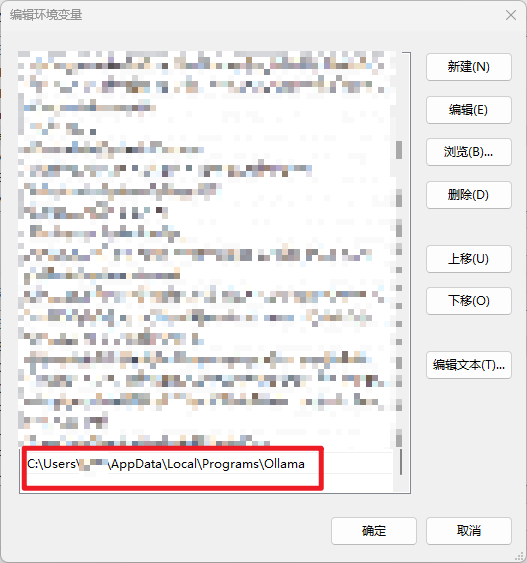

Cドライブでこれを見つける。Ollamaトレール

指定したディレクトリに変更する

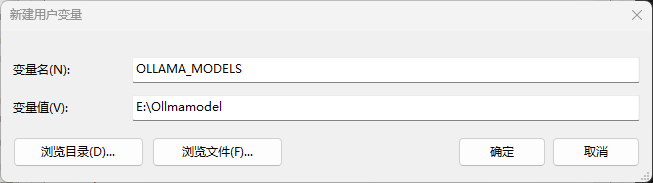

新しいユーザー変数の追加OLLAMA_MODELSこれはダウンロードしたモデルが保存される場所です。もし設定しなければ、デフォルトではCドライブのユーザーフォルダに保存されます。

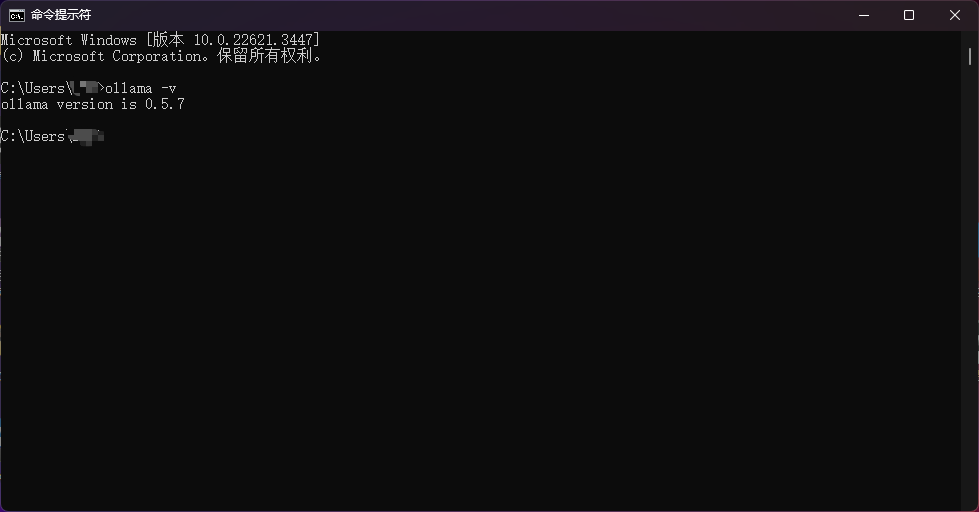

以上の設定が終わったら、コマンドラインで次のように入力する。ollama -vうまくいったことを確認する。

ダウンロードモデル

https://ollama.com/library/deepseek-r1:1.5b

R1で現在入手可能な全モデルをご覧になるには、このページをクリックしてください。

モデルの実行に必要なビデオメモリは以下の通り。

- deepseek-r1:1.5b - 1-2gビデオメモリ

- deepseek-r1:7b - 6-8G グラフィックメモリ

- deepseek-r1:8b - 8Gビデオメモリ

- deepseek-r1:14b - 10-12Gビデオメモリ

- deepseek-r1:32b - 24G-48ビデオメモリー

- deepseek-r1:70b - 96G-128 ビデオメモリー

- deepseek-r1:671b - 496GB以上のビデオメモリが必要です!

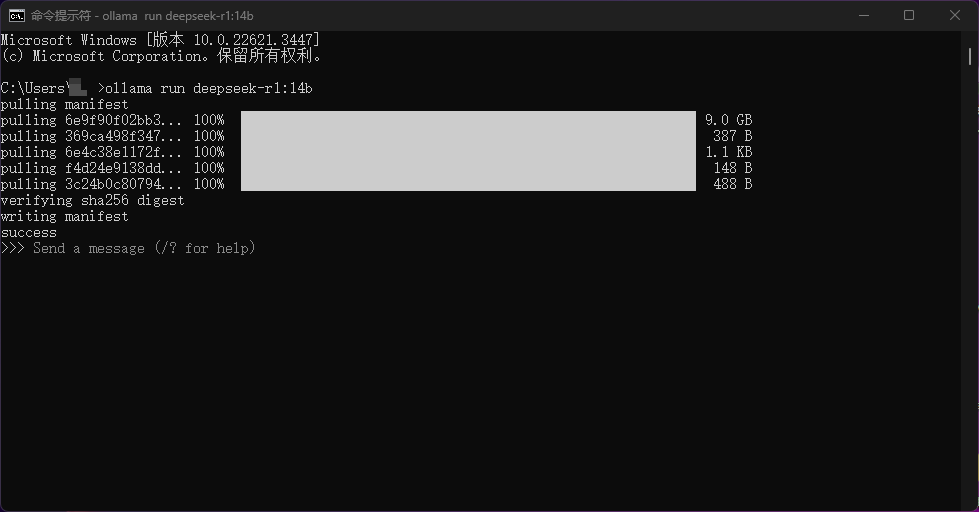

コンピュータの設定に従って対応するモデルを選択し、コマンドラインにコマンドを貼り付けて実行すると、モデルが自動的にダウンロードされる。例えば、私がここで実行したのはollama run deepseek-r1:14b

また、1.5Bのモデルと14Bのモデルをウェブディレクトリに用意しましたので、もしインターネットに接続されていない場合は、モデルを直接解凍してモデルパスに入れて実行してください!ollamaダウンロード

WeChatにアクセスするためのボットを導入する。

このステップを実行したとき、あなたは成功に近づいている!残りのステップはとてもシンプルだ!

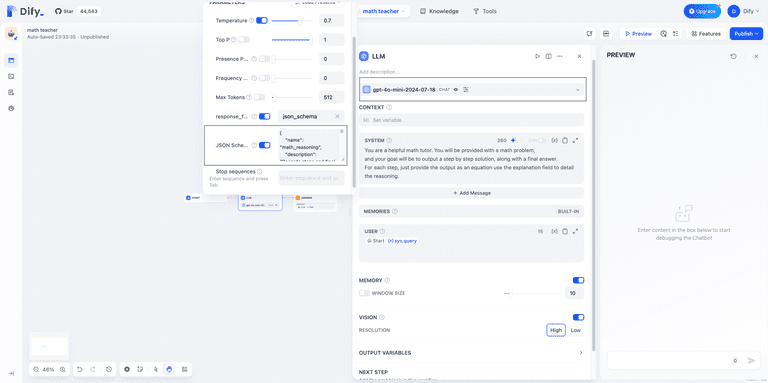

を使う必要がある。NGCBotこのプロジェクトはDeepSeekWeChatへのアクセス

プロジェクトの住所

https://github.com/ngc660sec/NGCBot

オリジナルのプロジェクトは、Xunfei Starfire、kimi、gpt、deepseekなどのプラットフォームのapiへのアクセスをサポートしています。しかし、ローカルのDeepSeekアクセスはサポートされていないため、元のプロジェクトとオープンソースに以下の変更を加えました!メンテナンスへの参加は大歓迎だ!

- 地元のディープシークをサポート

- シールドは考える

- 文脈に沿った対話支援

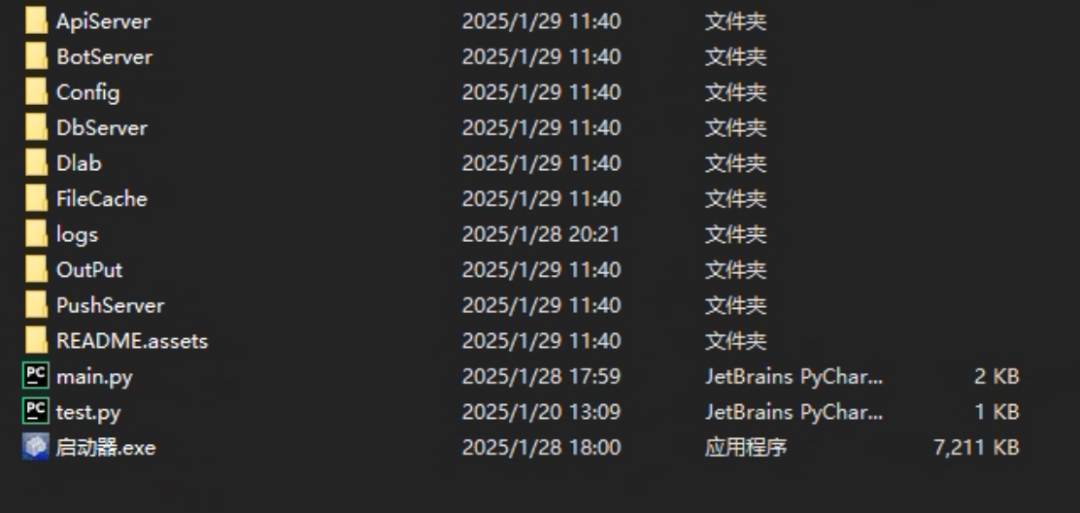

のネットワークドライブにネットブックを置きます。NGCBot.zip開梱

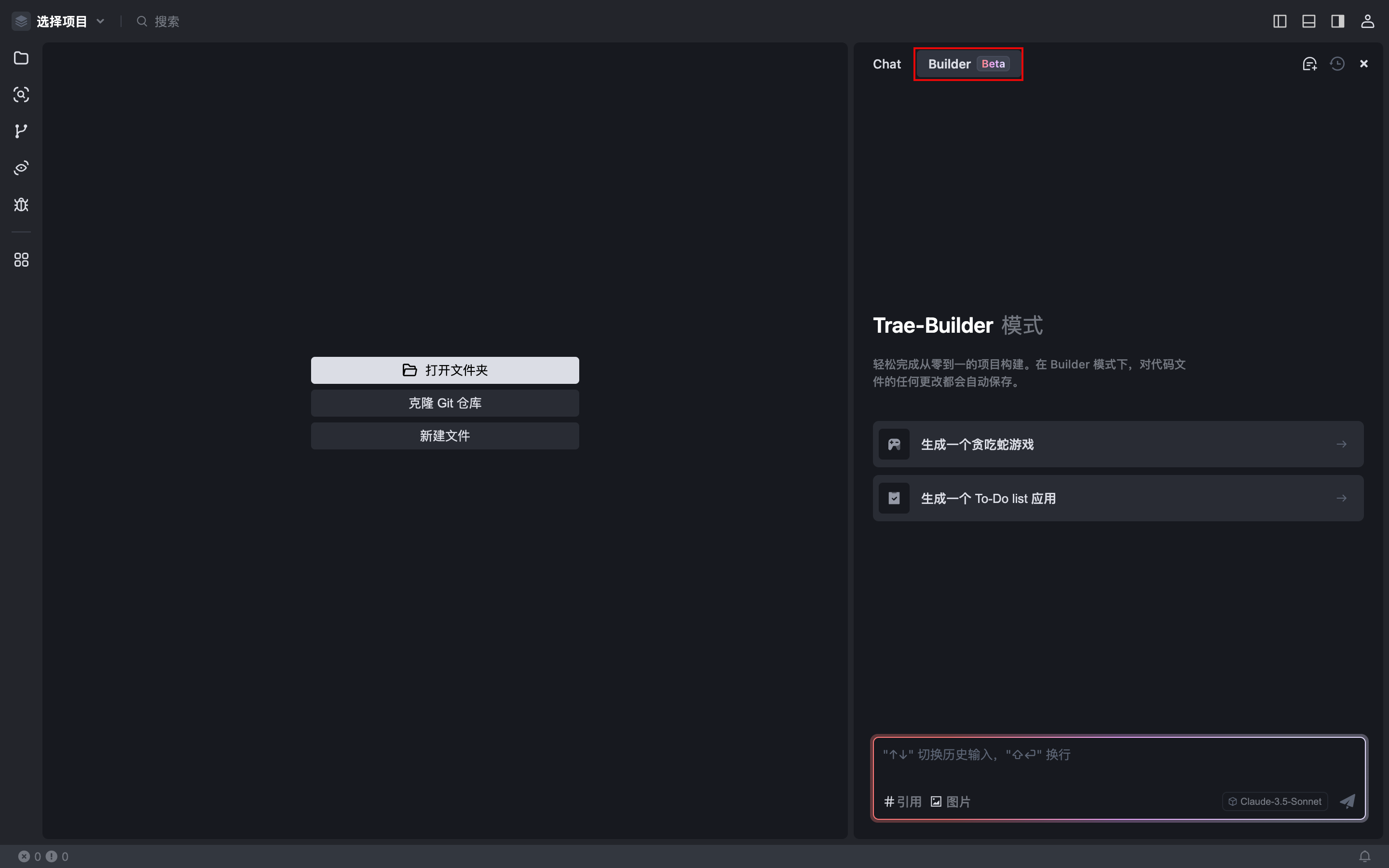

ランチャーを解凍し、ダブルクリックしてプロジェクトを開く。

プロジェクトは自動的にWeChatを開き、この時点でプロンプトが表示される:只支持64位微信または当前微信版本不支持

これは、私たちのコンピュータにインストールされているWeChatのバージョンが新しすぎるためです。NGCBot特定のバージョンをインストールする必要がある。

用意したWeChatのバージョンをインストールし、再度NGCBotプロジェクト、スワイプでWeChatにログイン、完了!

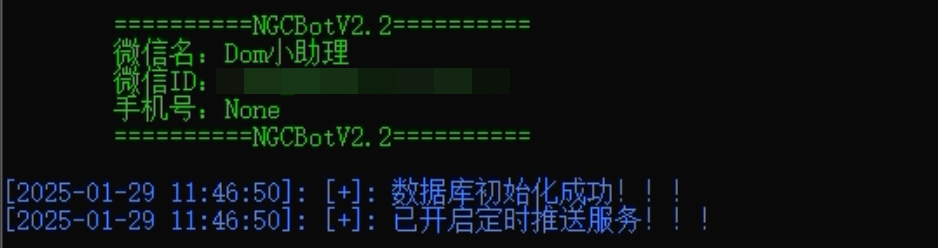

イニシエータに以下のように表示された場合、サービスが正常に初期化されたことを示す。

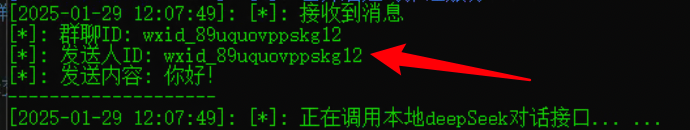

この時点で、WeChatにログインしている人にメッセージを送ってテストする。

完了した!

ボット構成の変更

いや、ロボットは完成した!そんなに喜ぶな!他にも知っておいてほしいことがある。NGCBotコンフィギュレーション設定!

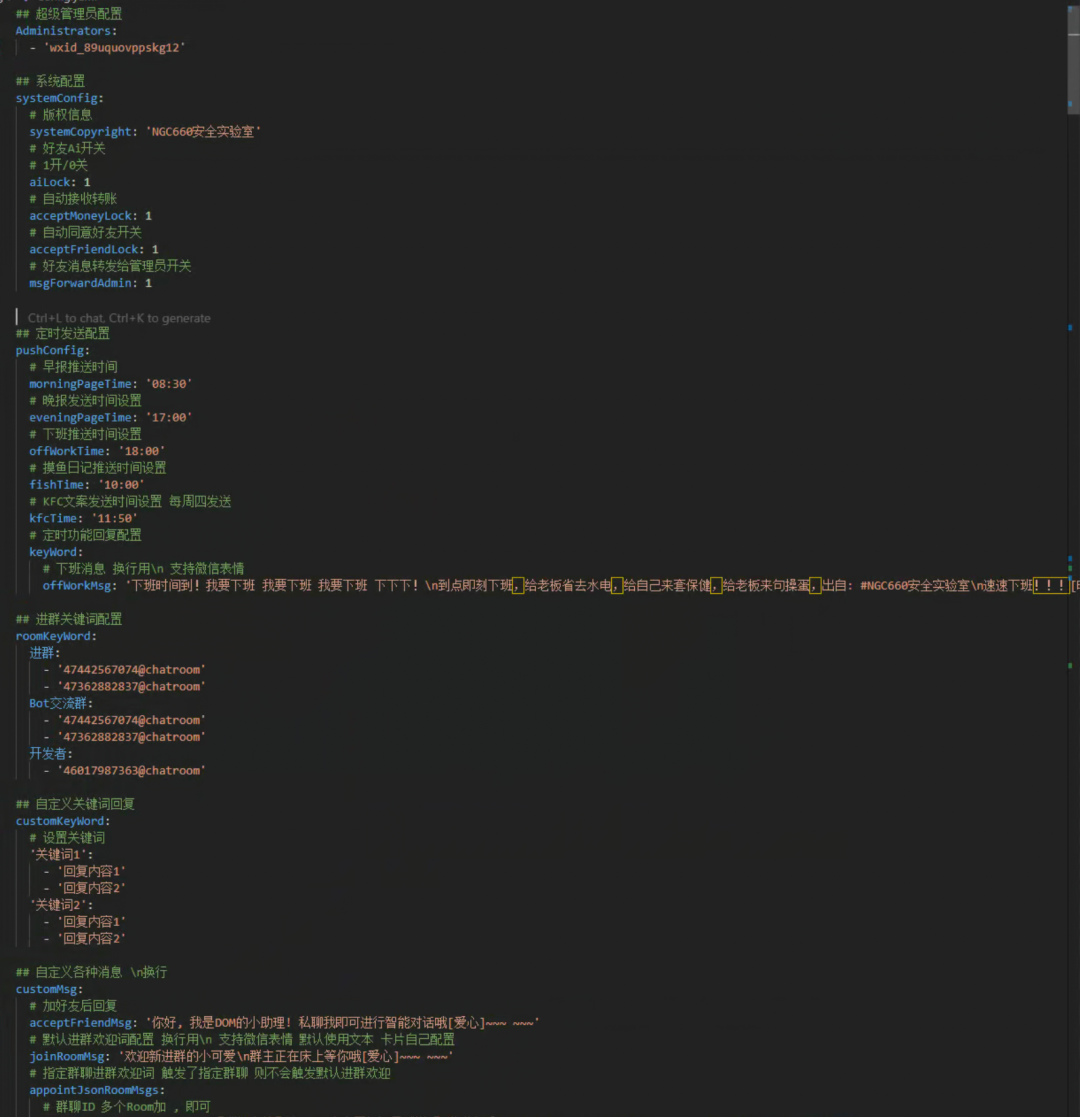

見せるNGCBotをプロジェクト・ルート・ディレクトリに置く。Config/Config.yaml書類

ここでは必要な2つの設定のみを説明し、残りは公式の詳細を確認してほしい。

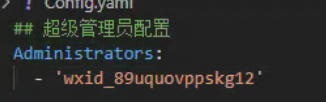

まず1つ目は、次のような変更である。超级管理员配置ここに、あなたのもう一つのウェイボー、管理ウェイボーのIDを記入してください。

このIDは、他のマイクロシグナルからこのマイクロシグナルにボットに送信されたメッセージをコピーすることで取得できる。

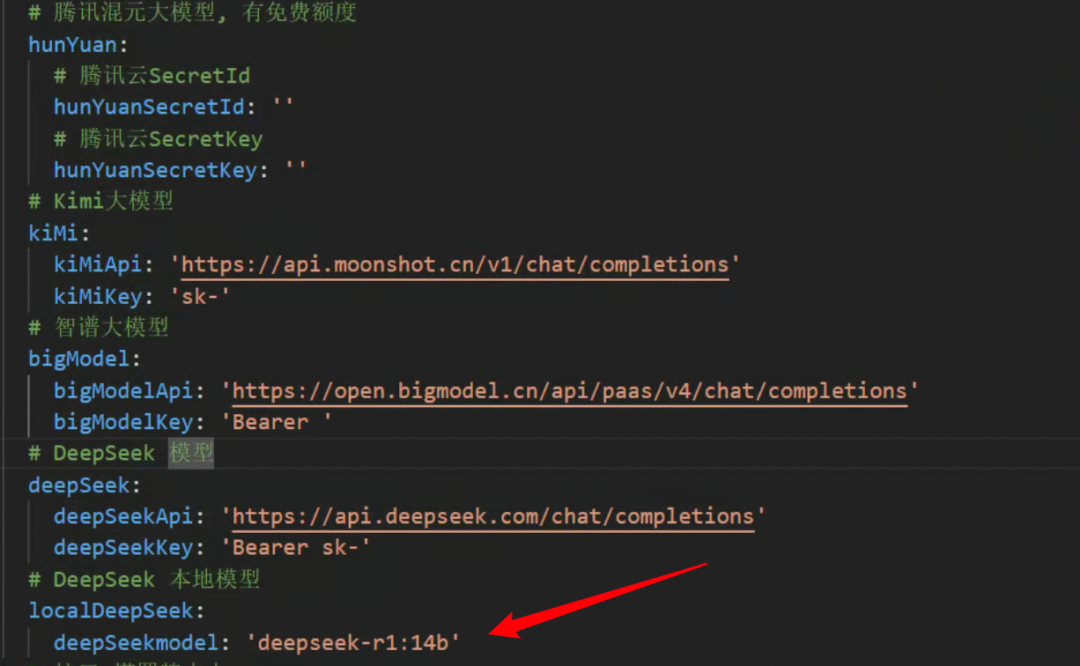

2つ目は、次のように修正することだ。localDeepSeek下げるdeepSeekmodelのモデル名。

ollamaでインストールしたモデルがここに記入されている。

上記の手順が完了すると、DeepSeek-R1 マイクロソフト・チャットボットのローカル・バージョンが作成されます。

課題

- Q:MACにアクセスできますか?

- A: いいえ。

NGCBotこのプロジェクトはウィンドウズしかサポートしていないが、Ollamaはデプロイできる。 - Q: 常にWeChatに接続する必要がありますか?オフにすることはできないのですか?

- A: はい、ウィンドウズ版WeChatにログインするのと同じです。継続的に利用したい場合は、クラウドサーバーでの利用をお勧めします。

- Q:これは以前のものと同じですか?

chatgpt-on-wechat何が違うのか? - A:プロトコルが違う。

chatgpt-on-wechatインターフェイスを使用しているため、現在このフックベースNGCBotプロジェクトはまだ非常に安定している。

統合パック取得

トゥッティラボ・バージョン

クォーク:https://pan.quark.cn/s/bc26b60912da

百度:https://pan.baidu.com/s/1QKFWV1tMti9s4m9K_HAPFg?pwd=428a

最後に書く

私は1年前にプライベートメッセージを受け取った。chatgpt-on-wechatこのプロジェクト・インターフェースは、WeChatの関係者によってブロックされた。COZEシェアするNGCBotこのプロジェクトは、ハハハ、ちょうどいいDeepSeek-R1全面的に!ということで......。......COZEはひとまず後回しにしよう!皆さん、あけましておめでとうございます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません