WikiChat:ウィキペディアのデータを使って知識を検索するためのチャットツール

はじめに

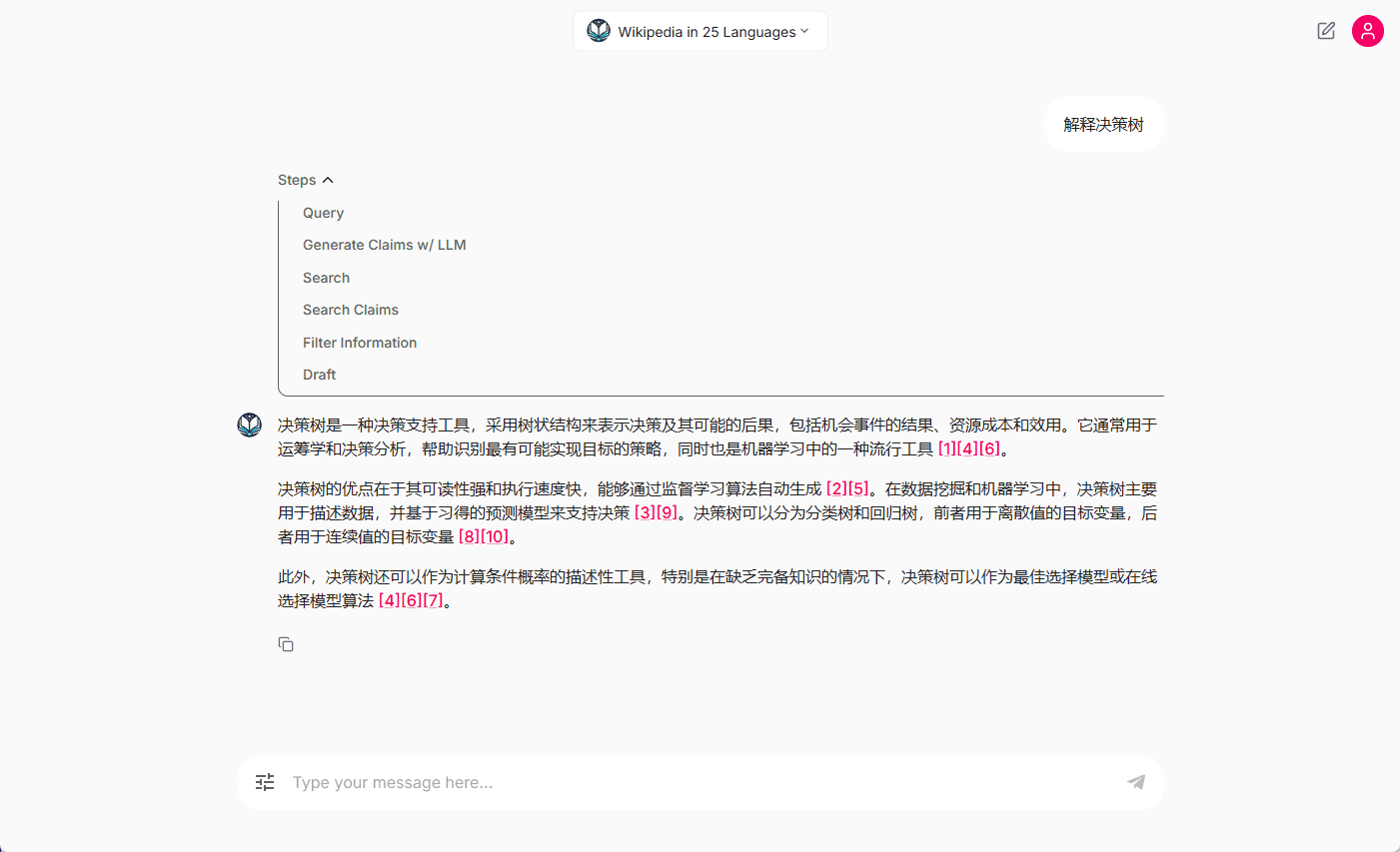

WikiChatはスタンフォード大学で開発された実験的なチャットボットで、ウィキペディアからデータを取得することで、大規模な言語モデルの事実性を改善することを目的としています。WikiChatは、ウィキペディアと7段階のパイプラインを使用することで、応答の正確性を保証します。WikiChatはまた、高品質のウィキペディア前処理スクリプトを提供し、スケーラブルなベクトル検索のために最先端の多言語検索モデルBGE-M3とQdrantを使用しています。

機能一覧

- 多言語サポートウィキペディアからの情報取得は、デフォルトで10ヶ国語に対応しています。

- 情報検索の向上テーブル、インフォボックス、リストなどの構造化データからの情報検索をサポート。

- 高品質のウィキペディア前処理スクリプト最先端の多言語検索モデルBGE-M3を使用。

- 無料の多言語ウィキペディア検索API高品質な検索APIを無料で提供(ただし料金制限あり)。

- 拡張LLMの互換性統一されたインターフェイスで100以上のLLMをサポート。

- 最適化されたパイプラインより迅速で費用対効果の高い配管オプションを提供。

- LangChainの互換性LangChainと完全互換。

- マルチユーザーアクセスの展開シンプルなフロントエンドとバックエンドをデプロイし、Azureに接続するためのコードを提供する。 コスモス ダイアログを保存するDBデータベース。

ヘルプの使用

設置プロセス

- 依存関係のインストール::

git clone https://github.com/stanford-oval/WikiChat.git cd WikiChat conda env create --file conda_env.yaml conda activate wikichat python -m spacy download en_core_web_sm - DockerのインストールインストールはDockerの公式ドキュメントに従ってください。

- LLMの設定::

- ボックスにデータを書き込む(アンケートやウェブフォームで)

llm_config.yamlファイルの関連フィールド。 - という名前のファイルを作成する。

API_KEYSファイルを開き、必要なAPIキーを設定する。

- ボックスにデータを書き込む(アンケートやウェブフォームで)

- コンフィギュレーション情報検索::

- デフォルトのウィキペディア検索APIを使用する。

- あるいは、ウィキペディアの索引をダウンロードしてホストする。

- または、独自のインデックスを作成する。

- WikiChatの運営::

inv demo --retriever-endpoint "http://0.0.0.0:<port number>/search"

機能 操作の流れ

- 多言語サポートウィキチャットはデフォルトで英語、中国語、スペイン語、ポルトガル語、ロシア語、ドイツ語、フランス語、イタリア語、日本語、ペルシャ語を含む10ヶ国語でウィキペディアから情報を取得します。

- 情報検索最先端の多言語検索モデルBGE-M3を使用し、テーブル、インフォボックス、リストなどの構造化データからの情報検索をサポート。

- 無料検索API180M以上のベクトル埋め込みをサポートし、高品質、フリー、多言語のウィキペディア検索APIを提供します。

- 拡張LLMの互換性OpenAI、Azure、Anthropic、Mistral、HuggingFace、Together.aiなど、100以上のLLMが統一インターフェースでサポートされています。 グロック モデルだ。

- パイプラインの最適化WikiChatの "Generate "と "Extract Statement "フェーズを統合することで、パフォーマンスを最適化する、より高速でコスト効率の良いパイプラインオプションを提供します。

- LangChainの互換性LangChainと完全に互換性があり、複数のLLMのシームレスな統合をサポートします。

- マルチユーザーアクセスの展開シンプルなフロントエンドとバックエンドをデプロイし、会話を保存するためにAzure Cosmos DBデータベースに接続するコードを提供する。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません