人工知能フェアネス(AIフェアネス)とは何か?

人工知能の公正さ:定義と核心的意味合い

AIの公平性とは、AIシステムがその設計、開発、配備、運用のライフサイクルを通じて、すべての個人や集団を公平かつ偏りなく扱うことを保証する学際的な分野である。AIシステムが、人種、性別、年齢、宗教的信条、社会経済的地位などの微妙な特性に基づいて、特定のグループの人々に対して差別的または偏った決定や出力を生成しないようにすることが中核的な目標である。技術的な指標だけでなく、社会的なコミットメントや倫理的な要件でもある。

履歴書をスクリーニングするAIツールの学習データが、主に一方の性別の過去の採用記録から得られたものだとすると、不注意にも他方の性別の求職者の履歴書を低く評価することを学習してしまい、不公平な採用結果につながる可能性が高い。AIの公平性とは、このような問題を特定し、定量化し、排除することである。

AIの公平性は、コードやアルゴリズムにとどまらず、データそのものに埋め込まれた歴史的な偏見や、アルゴリズムモデルがどのようにこれらの偏見を増幅させる可能性があるのかを深く考察する必要がある。AIの公平性は、既存の社会的不平等を定着させたり悪化させたりするのではなく、社会の多様性に奉仕し、機会の平等を促進するAIシステムの技術的ビジョンを確立しようとするものである。AIの公平性を理解することは、未来のテクノロジーを責任を持って創造し、利用する方法を理解するための重要な第一歩である。

人工知能の公正さ:中核概念と多次元的理解

AIの公平性は非常に豊かであり、相互に関連し、わずかに分化した複数の次元で理解することができ、それらはAIシステムの公平性を評価するための3次元の枠組みを形成している。

- グループの公平性:は、最も直感的な公平性の概念である。集団の公平性は、AIシステムが異なる保護集団(例えば、男性対女性、異なる人種集団)を平等に扱うことを要求する。これは統計的に、ローン承認率、顔認識精度、犯罪リスク予測におけるエラー率などがグループ間でほぼ同じであることを保証するなど、グループ間で主要な指標がバランスよく分布していることに反映される。

- 個人の公平性:AIの目から見て、同じような個人は同じように扱われるべきだということが強調されている。個人の公平性は、ミクロレベルの正義に関係している。例えば、ほとんど同じ資格、経験、経歴を持つ2人の求職者は、性別や人種に関係なく、AIの採用システムにおいて同様に評価されるべきである。個人の公正さは、アルゴリズムが関連性のない繊細な特徴を無視することを学習することを必要とする。

- アンチ・クラシフィケーション(反クラシフィケーション):は、AIモデルが意思決定プロセスにおいて敏感な特徴(例えば、人種、性別)を使用することを完全に控えることを要求する、より厳格な基準である。差別の可能性を根源から断ち切り、意思決定がこれらの特徴とはまったく無関係であることを保証するというものだ。

- 機会均等:これは、より洗練された実践的な衡平性の概念である。機会の均等化とは、同一の結果を求めるのではなく、「チャンス」を均等にすることである。例えば、採用活動においては、真に有能な候補者のうち、AIによって選考に成功した者の割合が、異なるグループ間で等しいことが求められる。これは、「真の才能」を識別するモデルの能力が、異なるグループ間で等しく正確であることを意味する。

- 反実仮想的公平性:反因果的差別は、公正さについて考えるために因果推論を利用する。ある個人の微妙な特性(例えば性別)が変化しても、他のすべてが変わらない場合、AIの判断は変わるのか?もし判断が変わるのであれば、その特徴に基づく因果的差別が存在することになる。このような考え方は、より隠れたバイアスを明らかにするのに役立つ。

- 手続きの公平性:結果だけでなく、意思決定プロセスの公正さに焦点を当てる。手続き上の公正さとは、AIシステムの意思決定プロセスが透明で、説明可能で、異議申し立てや上告が可能であることを要求する。たとえ結果が統計的に公正に見えたとしても、それが理解不能な「ブラックボックス」であれば、そのプロセスの公正さを信頼することは難しい。

人工知能の公平性:緊急の社会的重要性

AIにおける公平性の推進と実現は、決して技術者の机上の空論ではなく、技術発展の根源である信頼と正義に関わる、広範囲かつ緊急の社会的意義を持つ。

- 歴史的バイアスの自動化と増幅を防ぐ:社会の多くの分野には歴史的な不平等があり、こうした不平等はデータとして記録されている。AIが無批判にこのデータから学習すれば、自動的にバイアスを受け継いで増幅し、より効率的で陰湿な方法で差別が繰り返されるようになり、「ゴミを入れればゴミが出る」という悪循環が生まれる。

- 基本的人権と社会正義の擁護:公正な扱いは、すべての人間の基本的権利である。医療、司法、信用、雇用、その他人生の重大な決定などの分野で偏ったAIシステムを使用することは、特定の集団の重大な利益を直接害し、彼らにふさわしい機会を奪い、社会的亀裂や対立を悪化させる可能性がある。

- AIに対する社会的信頼の構築:テクノロジーが社会に広く受け入れられるためには、信頼が礎となる。AIシステムが繰り返し差別的であることが露呈すれば、一般大衆はそれを恐れ、抵抗するようになり、最終的にはこの分野全体のイノベーションや応用を妨げることになる。信頼を勝ち取るためには、公正さが必要なのだ。

- ビジネスの利益とブランド価値を高める:公正なAIシステムは、組織がより良い包括的な意思決定を行い、より幅広い人材プールや顧客基盤を活用し、差別的な不祥事によるブランドイメージの低下を回避するのに役立つ。公正な倫理を実践することは、長期的に持続可能なビジネス戦略である。

- テクノロジー・フォー・グッド(TFG)の推進:人工知能は第4次産業革命の中心的推進力として歓迎されている。その公平性を確保することで、この革命の成果が包括的なものとなり、新たな特権階級や抑圧された集団を生み出すのではなく、社会的な隔たりを埋め、人間の幸福を高めるために真に利用できるようになる。

人工知能の公正さ:現実の深刻な課題

公平という理想を現実のものにするには、複雑に絡み合った課題に直面する。

- 公平性の定義における多数性と対立:公正さについて、数学的に唯一「正しい」定義はない。前述したように、集団の公正さと個人の公正さ、階級化防止と機会均等といった基準は、しばしば相反するものである。ある基準を満足させることは、必然的に別の基準に抵触する可能性があり、開発者は特定のシナリオに基づいた難しい価値観のトレードオフを迫られる。

- データに潜む歴史的バイアスの罠:データはAIの糧であるが、過去のデータはしばしば歴史的不公正を反映している。例えば、過去において技術業界は男性に支配されており、その結果、女性よりも男性の方がはるかに多い履歴書データが存在する。このデータでモデルを訓練すると、男性は「優秀なプログラマー」である可能性が高いと仮定し、女性の履歴書を不利に採点することになる。データの偏りをクリーニングし、修正することは大きな課題である。

- アルゴリズム自体の増幅効果:データの偏りが明らかでなくても、複雑なアルゴリズムモデルは、学習と汎化の過程で、敏感な特徴(代理特徴)に関連する特定の偽のパターンを検出し、増幅する可能性があり、予期しない識別結果を生み出す可能性がある。

- 公平性とパフォーマンスのトレードオフ(トレードオフ):多くの場合、特定の公正指標を満たすようにモデルに制約を強いることは、その全体的な予測精度をある程度低下させる可能性がある。例えば、マイノリティのローン承認率を高めるために、基準を緩和しなければならないかもしれないが、それによってローン不履行の全体的なリスクが高まる。公平性」と「効率性」のバランスをとることは、古典的な意思決定のジレンマである。

- 複数の敏感な属性の交差性:現実には、ある人が同時に複数の不利な立場にあるグループに属していることがある(例えば、低所得のアフリカ系アメリカ人女性)。偏見は、これらのアイデンティティの「交差点」において複合的な影響を及ぼし、より複雑で測定が困難なものとなる。単一のグループに対して最適化された公平性の尺度は、交差する差別に対処できないかもしれない。

- 解釈と説明責任の欠如:最先端のAIモデル(例えば、ディープニューラルネットワーク)の多くは、複雑な「ブラックボックス」であり、その内部決定ロジックの解釈は困難である。不公平な結果が発生した場合、問題の根本的な原因をデータ、アルゴリズム、またはモデルのデプロイメントのある時点まで遡ることは困難であり、説明責任と修正を極めて困難にしている。

人工知能の公平性:実装方法と技術的実践

この課題の大きさにもかかわらず、研究者やエンジニアは、機械学習パイプライン(Pipeline)全体に公平性への配慮を注入するためのさまざまな技術的手段を開発してきた。

- 前処理の方法(前処理):モデルに入力する前のデータの処理。これには、トレーニングデータのバイアスを特定し補正すること、不特定多数からデータを再サンプリングすること、データ変換技術によって他の有用な情報をできるだけ保持しながら、敏感な特徴との関連性を除去することなどが含まれる。

- 加工中:これは、公平性制約をモデル学習アルゴリズム自体に直接統合することである。目的関数を設計する際、開発者は正確な予測を要求するだけでなく、最適化目的の1つとして公平性を追加し、学習プロセス中にモデルが公平であることを能動的に「学習」するようにします。

- 後処理の方法(Post-processing):モデルが学習された後、その出力が調整される。例えば、グループごとに異なる判定しきい値(Threshold)が設定される。融資シナリオでは、機会均等を達成するために、歴史的に不利な立場にあるグループに対して、承認しきい値を適切に下げることができる。このアプローチの利点は、モデルを再学習する必要がないことである。

- 定期的な監査と継続的なモニタリング:公平性は「1回で終わり」の設定ではない。モデルが稼動した後は、そのパフォーマンスが時間の経過とともに低下したり、新たなバイアスが生じたりしていないことを確認するために、最新の実世界データを用いて定期的に公平性を監査し、継続的な監視システムを導入する必要がある。

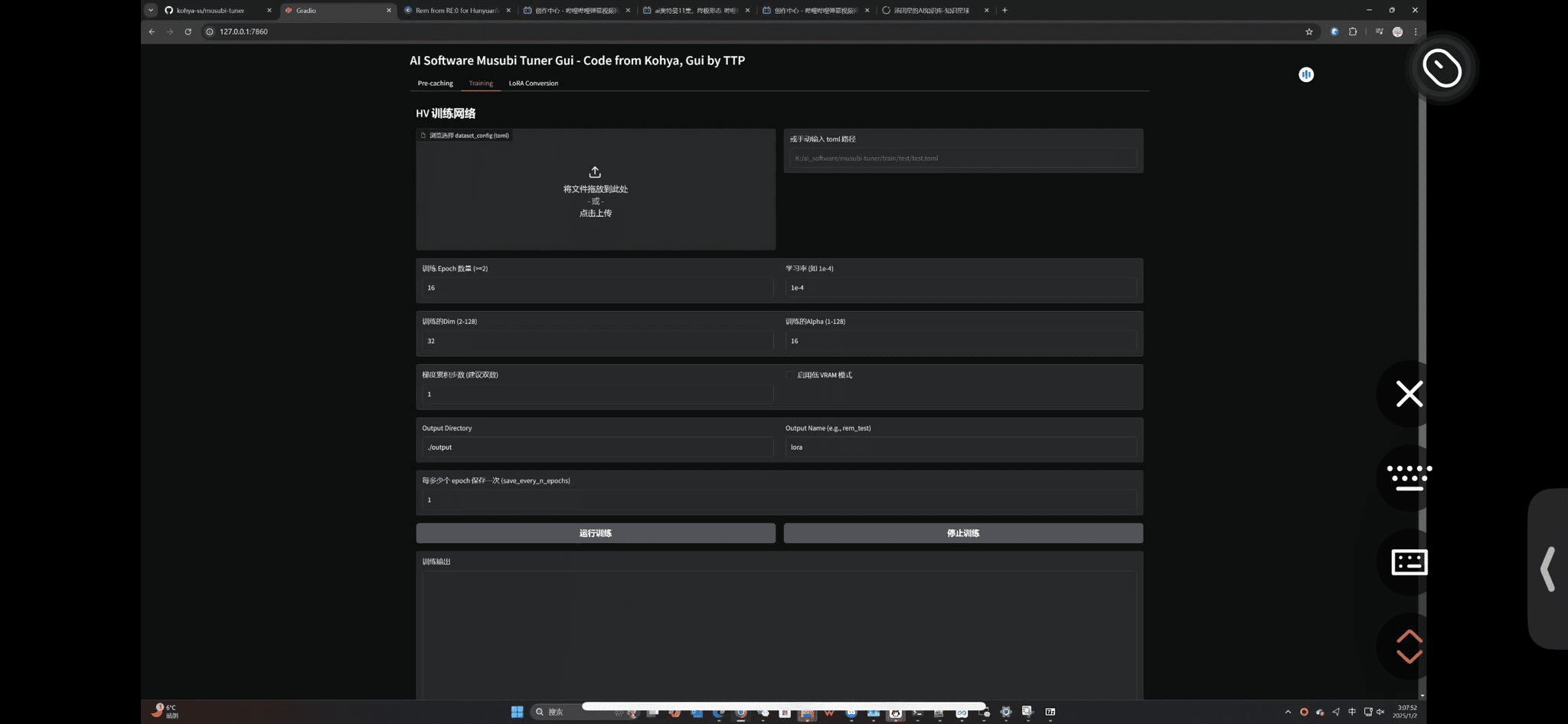

- 公正ツールキットとフレームワークを使用する:IBMのAIF360、マイクロソフトのFairLearn、グーグルのWhat-If Toolなど、公平性の達成を支援するオープンソースのツールキットが業界にいくつか登場している。これらのツールは、統一された測定基準と緩和アルゴリズムを提供し、実践への障壁を大幅に下げている。

- 多様なチームワークを促進する:技術的な解決策を人的な要素から切り離すことはできない。性別、民族性、文化、職業的背景など、より多様性のある開発チームを編成することで、設計プロセスの初期段階で潜在的な偏見の盲点を特定し、公平性の問題を未然に防ぐことができる。

人工知能の公平性:幅広い応用シナリオと実例

AIの公平性の問題は、理論上の夢物語とはほど遠い。文字通り、私たちの生活の隅々にまで登場し、あらゆる事例がその重要性を警告している。

- リクルートと人的資源管理:アマゾンが社内で開発したAI履歴書スクリーニング・ツールは、学習データのほとんどが男性の履歴書であったため、「女性」という単語(例えば「女子チェスクラブのキャプテン」)を含む履歴書を持つ求職者にペナルティを課すことを学習し、女性に対する組織的差別につながった。これは、女性求職者に対する組織的差別につながった。結局、同社はこのプログラムを中止した。

- 刑事司法とリスク評価:米国の一部の裁判所で使用されているCOMPASなどの再犯リスク評価システムは、ProPublicaなどのメディアの調査によって、黒人被告の再犯リスクを組織的に過大評価する一方で、白人被告のリスクを過小評価する傾向があることが判明し、アルゴリズム司法に関する世界的な大論争の引き金となった。

- 金融サービスおよび信用承認:主に過去の融資データに基づいて訓練されたAI与信モデルは、歴史的に特定の郵便番号の地域(多くの場合、マイノリティの居住区)を金融機関からサービスを拒否されないように「レッドライン」してきたため、それらの郵便番号を「高リスク」と関連付け、それらの地域の住民からの融資申し込みを拒否することを学習し、デジタル時代に「レッドライン」を作り出す。そしてこのモデルは、それらの郵便番号を「高リスク」と関連付けることを学習し、それらの地域の住民からのローン申し込みを拒否する。こうしてデジタル時代に「レッドライニング」が生まれる。

- ヘルスケアと診断補助:皮膚がん診断AIの学習に使用される画像データが圧倒的に明るい肌の集団である場合、肌の色の濃い患者に対するモデルの診断精度は著しく低下し、誤診や治療の遅れにつながる可能性があり、深刻な健康格差が生じる。

- 顔認識と監視技術:いくつかの学術研究とMITジェンダー・シェイド・プロジェクトは、市販の顔認識システムの多くが、明るい肌の男性よりも暗い肌の女性を識別する際のエラー率が著しく高いことを示している。法執行機関がこの技術を悪用すれば、誤認識や深刻な結果を招く可能性がある。

- コンテンツ・レコメンデーションとインフォメーション・コクーニング:ソーシャルメディアやニュースのプッシュアルゴリズムは直接的に「意思決定」を行うわけではないが、ユーザーのエンゲージメントに基づく推薦メカニズムは、偏った、嘘の、しかし人目を引くコンテンツを優先する可能性があり、その結果、政治的立場や文化的背景の異なるグループに対する偏見を強化する情報の繭を作り、社会的合意の形成に影響を与える。社会的コンセンサス形成に影響

人工知能の公正さ:不可欠な倫理的・社会的側面

AIの公平性は本質的に社会技術システム(Sociotechnical System)の問題であり、その中核には社会の構造に重大な影響を与える倫理的選択がある。

- バリュー・センシティブ・デザイン(VSD):テクノロジー設計者には、人間の価値観(公平性、プライバシー、自律性など)を後回しにするのではなく、最も初期のコンセプト段階で設計の中核に据えることを求める。テクノロジーは価値中立的なものではなく、初期段階から設計者の選択と嗜好に組み込まれている。

- アルゴリズム・アカウンタビリティ(AA):AIシステムが不公正な判断を下した場合、責任の連鎖が明確でなければならない。開発者なのか、導入者なのか、企業なのか、規制当局なのか、誰が責任を負うのかを明確にする必要がある。アカウンタビリティを確立することは、関係者に公平性を重視させるための重要なメカニズムである。

- デジタルデバイドとエンパワーメント:不公平はアルゴリズム内だけでなく、テクノロジーへのアクセスや使用においても見られる。社会経済的背景に関係なく、すべてのグループがAIテクノロジーにアクセスし、理解し、恩恵を受けられるようにすることは、よりマクロなレベルでの公平性のテーマである。

- 市民参加と民主的熟議:何が公平か」という議論は、技術者や企業だけにとどまらず、哲学者、社会学者、法律の専門家、そして影響を受ける可能性のある地域社会の一般市民も参加すべきである。これは、社会全体による民主的な審議を必要とする公共的な問題である。

- 優れたビジネス倫理のためのテクノロジー:企業は、単に「悪を行わない」というボトムラインではなく、「Tech for Good」というポジティブな倫理を積極的に実践すべきである。短期的な利益よりも公正さなどの倫理原則を優先することが、テック企業が長期的な信頼と社会的ライセンスを勝ち取る道なのだ。

- グローバルで文化的な視点:公正の定義は文化的に相対的なものである。ある文化圏で公正とされるものが、別の文化圏では受け入れられないこともある。グローバルなアプリケーションを開発するAIシステムは、この多様性を考慮に入れ、テクノコロニアリズムを避けなければならない。

人工知能における公平性:進歩的な法的・政策的枠組み

世界中の法律家や規制当局が、AIの公正な発展のためにレッドラインを引き、ガバナンスの枠組みを構築しようと迅速に動いている。

- EUの人工知能法(AI法):この画期的な法律は、AIシステムをさまざまなリスクレベルに分類し、リスクベースの規制アプローチをとっている。人間の安全、生活、権利(ソーシャル・スコアリングなど)に対して「容認できないリスク」をもたらすAIシステムの使用を禁止し、「高リスク」のAIシステム(リクルート、重要インフラなど)には、データガバナンス、透明性、人間の監視、公正要件を含む厳格なコンプライアンス評価を含む厳格な義務を課している、人間による監督、公平性の要件を含む厳格なコンプライアンス評価などである。

- 米国における立法と行政措置:米国には現在、包括的な連邦AI法はないが、各省庁の規制(連邦取引委員会FTCの取締りなど)、州法(イリノイ州の人工知能ビデオ面接法など)、大統領令(人工知能の安全、確実、信頼できる開発と利用に関する大統領令)などを通じてAIの公正性を推進しており、アルゴリズムによる差別から解放される市民の権利を守ることに重点を置いている。

- 中国におけるアルゴリズム・ガバナンスと規制:中国国家インターネット情報弁公室などが公布した「インターネット情報サービスアルゴリズム推薦管理弁法」と「生成人工知能サービス管理暫定弁法」では、アルゴリズム推薦サービスの提供者は、公平・公正・公開と透明性の原則を遵守し、利用者の特性に基づく価格差別やその他の不合理な扱いを禁止し、偏見や差別を特定・是正するためのメカニズムを構築・改善することを明確に求めている。

- 影響評価の義務化:環境影響評価と同様に、多くの規制動向は、リスクの高いAIシステムに対して基本的権利影響評価またはアルゴリズム影響評価を求めており、企業は自社のAIシステムが公正、プライバシー、その他の権利に及ぼす潜在的な影響を体系的に評価し、その結果を公表することを余儀なくされている。

- 「セーフハーバー」とサンドボックス・メカニズム:政策の枠組みの中には、コンプライアンスのベストプラクティスを積極的に採用し、自己テストや評価を積極的に行う企業に対して「セーフハーバー」規定を設けたり、規制のサンドボックスで革新的な製品をテストすることを認めたりすることで、イノベーションと規制のバランスをとっているものもある。

人工知能の公平性:今後の研究の方向性と動向

AIの公平性の分野は急速なペースで進化を続けており、研究者たちは将来の課題に対してより深く、より効果的な解決策を模索している。

- 人工知能(XAI)の深化を説明できる:もはや「ブラックボックス」ではなく、意思決定に明確で理解しやすい根拠を提供できるモデルを推進する。意思決定が説明可能であれば、監査人や企業は不公平につながる具体的な道筋を特定し、修正することが容易になる。

- 因果的公平性のフロンティアの探求:因果推論(Causal Inference:CI)に基づく公平性の枠組みは、現在注目されている研究である。これは、統計的相関関係を超えて、より科学的で基礎的なデバイアス戦略を開発するために、敏感な特徴と意思決定結果の間の因果関係を理解しようとするものである。

- 大規模言語モデル(LLM)の公正監査:ChatGPTのような生成AIの普及に伴い、これらの巨大なAIにおける社会的バイアスを監査することは、全く新しい課題となっている。ジェンダー・ステレオタイプ、文化的バイアス、LLMが出力する可能性のある有害なコンテンツを検出し、緩和する方法を研究することは、極めて緊急の課題である。

- ダイナミクスと長期的なエクイティ:AIシステムによる決定はユーザーの将来の状態を変化させ、それはその後の決定データに影響を与える。長期的かつ多ラウンドの相互作用における公正さに対するAIシステムの影響と、「マシュー効果」を回避する方法を調査することは、複雑な将来の方向性である。

- 連邦政府の学習における公平性:データがローカルに存在せず、モデルのパラメータを交換することによって共同学習が行われる連合学習シナリオでは、各データソースのプライバシーを保護しながら、最終的なグローバルモデルの公平性を確保することは、困難な技術的問題である。

- 標準化と横断的協力:AIの公正性評価指標、プロセス、ツールの標準化を推進し、異なるシステムや業界間で比較ができるようにする。同時に、コンピュータサイエンス、法学、倫理学、社会学、その他の分野間の綿密な相互協力を強化し、この大きな課題を共同で克服する。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません