マイクロソフトAIエージェント入門コース:Agentic RAG

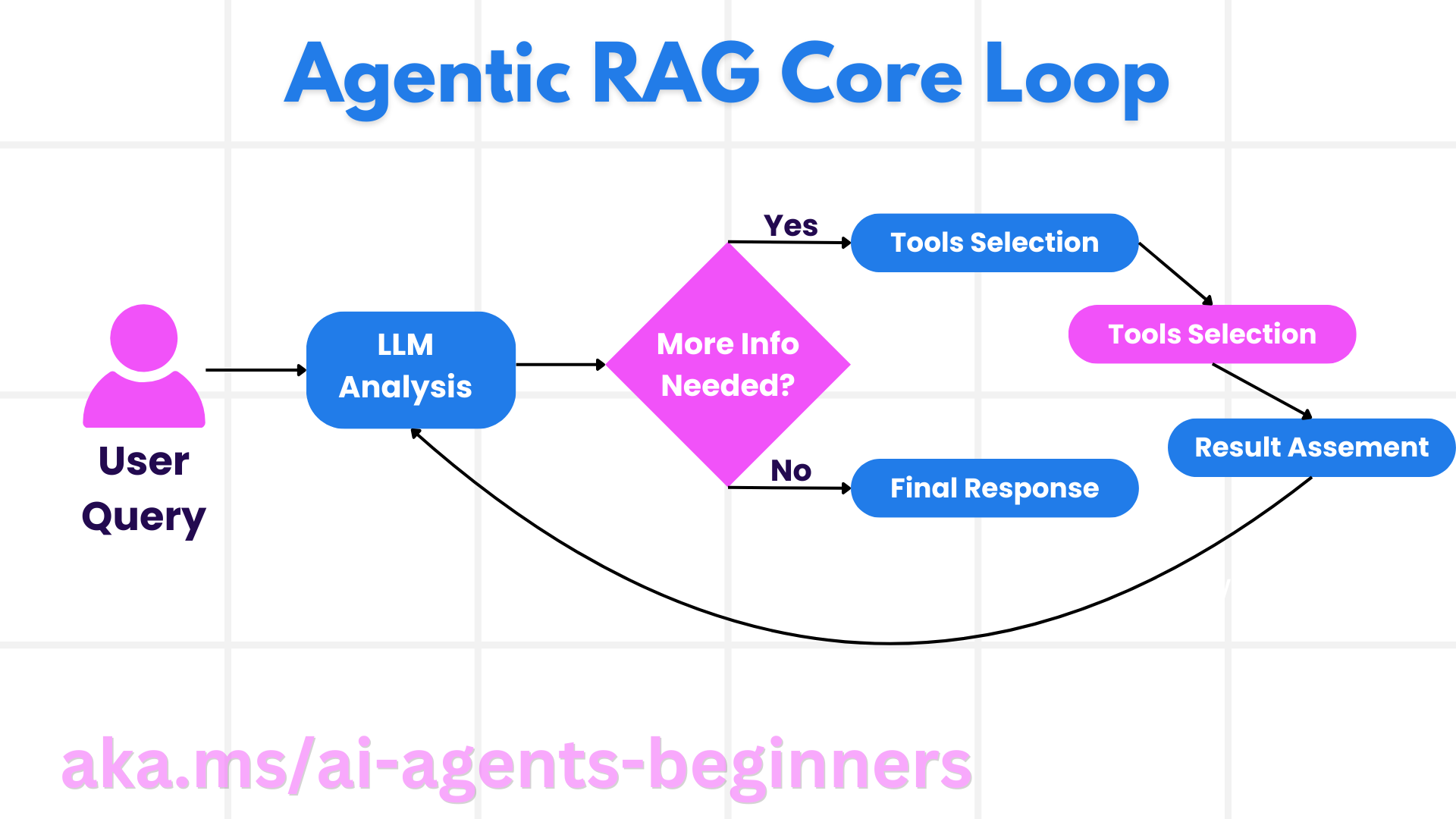

このコースでは、エージェント型検索拡張世代(Agentic Retrieval-Augmented Generation)の包括的な概要を説明する。 ラグ)は、大規模言語モデル(LLM)が外部ソースから情報を取得しながら自律的に次の行動を計画する、新しいAIのパラダイムである。静的な "search-then-read "モデルとは異なり、Agentic RAGは、ツールや関数の呼び出しや構造化された出力を挟みながら、LLMを繰り返し呼び出す。システムは結果を評価し、クエリを最適化し、必要に応じて他のツールを呼び出し、満足のいく解が得られるまでこのサイクルを続ける。

簡単

このコースでは以下のトピックを取り上げる:

- エージェントのRAGを理解する。 大規模言語モデル(LLM)が外部データソースから情報を抽出しながら自律的に次の動きを計画する、AIの新たなパラダイムについて学ぶ。

- 反復的な「メーカー・チェッカー」モデルをマスターする。 ツールや関数の呼び出しや構造化された出力を挟みながら、LLMへの反復呼び出しのループを理解することは、正しさを向上させ、書式の悪いクエリに対処することを目的としている。

- 実用的なアプリケーションを探求する。 正しさ第一」の環境、複雑なデータベースとのやり取り、拡張ワークフローなど、Agentic RAGが輝くシナリオを特定します。

学習目標

このコースを修了すると、次のことができるようになります:

- エージェントのRAGを理解する。 大規模言語モデル(LLM)が外部データソースから情報を抽出しながら自律的に次の動きを計画する、AIの新たなパラダイムについて学ぶ。

- 反復的な「メーカー・チェッカー」モデル。 LLMのループを繰り返し呼び出し、ツールや関数の呼び出し、構造化された出力を挟むことで、クエリーの正しさを向上させ、書式の悪いクエリーに対処する。

- という推論プロセスを持つ。 システムは、あらかじめ定義された経路に依存することなく、問題へのアプローチ方法を決定する推論プロセスの能力を所有していることを理解する。

- ワークフロー。 Agenticモデルがどのように独立した意思決定を行い、市場動向レポートを取得し、競合他社のデータを特定し、社内の販売指標を相関させ、結果を統合し、戦略を評価するかを学びます。

- 反復ループ、ツールの統合、そして記憶。 繰り返しサイクルを回避し、十分な情報に基づいた意思決定を行うために、システムがどのように周期的相互作用パターンに依存して、ステップ間の状態と記憶を維持しているかを理解する。

- 故障モードへの対処と自己修正。 反復や再問い合わせ、診断ツールの使用、人間の監督への依存など、システムの強固な自己修正メカニズムを探る。

- エージェントの境界線 ドメイン固有の自律性、インフラ依存性、ガードレールの尊重を中心に、エージェント型RAGの限界を理解する。

- 実用的な使用例と価値。 正しさ第一」の環境、複雑なデータベースとのやり取り、拡張ワークフローなど、Agentic RAGが輝くシナリオを特定します。

- ガバナンス、透明性、信頼。 説明可能な理由付け、バイアスのコントロール、人間の監視など、ガバナンスと透明性の重要性を理解する。

エージェントRAGとは?

Agentic Retrieval-Augmented Generation(Agentic RAG)は、大規模言語モデル(LLM)が外部ソースから情報を抽出しながら自律的に次のアクションを計画する、新しいAIのパラダイムである。静的な "retrieve-then-read "モデルとは異なり、Agentic RAGは、ツールや関数の呼び出しや構造化された出力を挟みながら、LLMを繰り返し呼び出します。システムは結果を評価し、クエリを最適化し、必要に応じて他のツールを呼び出し、満足のいく解が得られるまでこのサイクルを続ける。この反復的な "メーカー・チェッカー "モデルは、正しさを向上させ、書式の悪いクエリを処理し、高品質の結果を保証する。

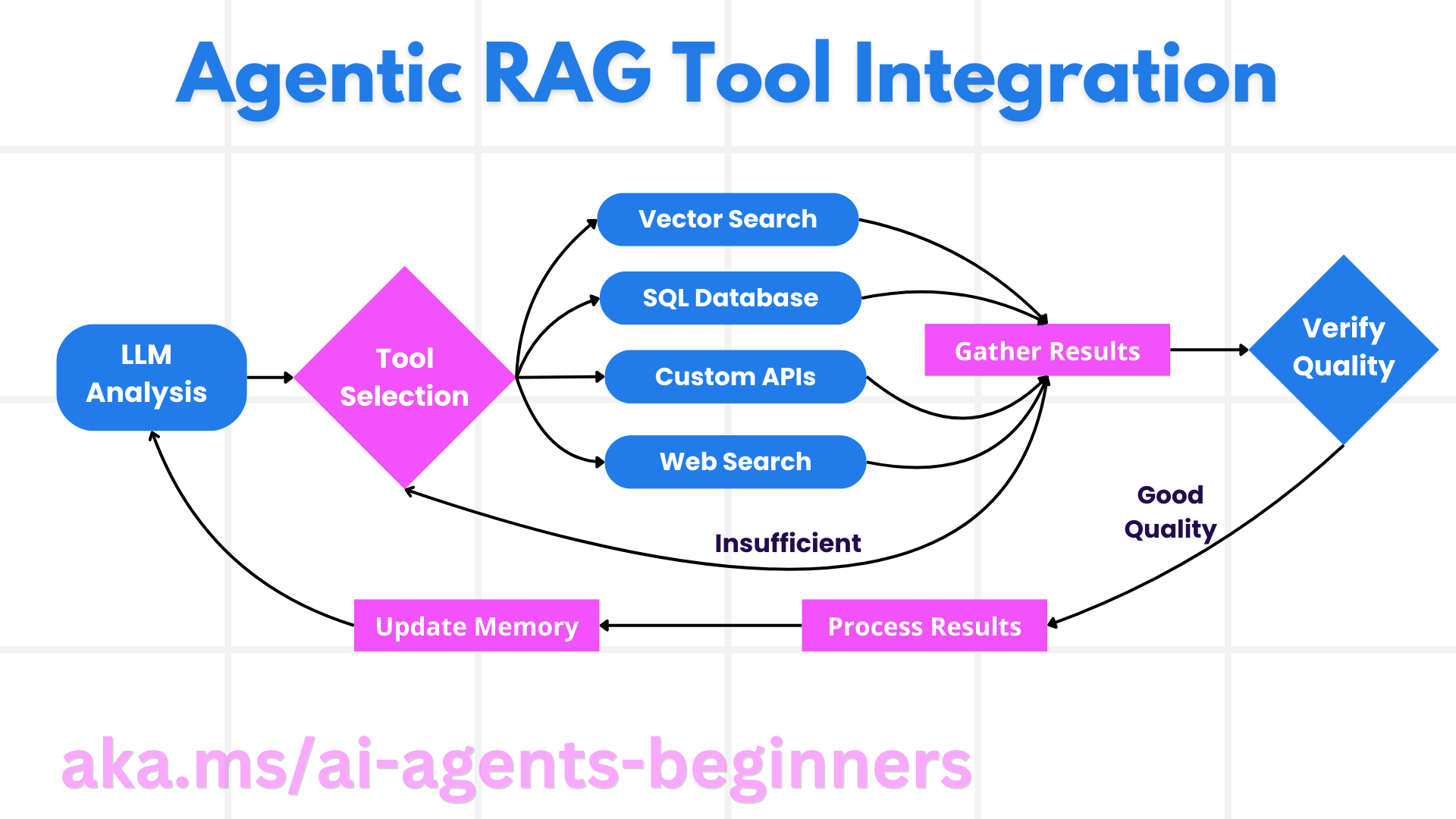

システムは推論プロセスを積極的に所有し、失敗したクエリを書き換えたり、異なる検索方法を選択したり、最終的に答えを決定する前に複数のツール(Azure AI Searchのベクトル検索、SQLデータベース、またはカスタムAPIなど)を統合したりする。エージェント型システムの特徴は、推論プロセスを所有する能力である。従来のRAGの実装は、事前に定義されたパスに依存していますが、Agenticシステムは、見つけた情報の質に基づいてステップの順序を自律的に決定します。

定義 Agentic Retrieval-Augmented Generation (Agentic RAG)

Agentic Retrieval-Augmented Generation(Agentic RAG)は、LLMが外部データソースから情報を抽出するだけでなく、自律的に次の行動を計画する、AI開発における新たなパラダイムである。静的な "retrieve-then-read "モデルや精巧なキューシーケンスとは異なり、Agentic RAGでは、ツールや関数の呼び出しや構造化された出力を挟みながら、LLMへの反復的な呼び出しループが行われる。各ステップにおいて、システムは得られた結果を評価し、クエリを最適化するかどうかを決定し、必要であれば他のツールを呼び出し、満足のいく解が得られるまでこのサイクルを続ける。

この反復的な「メーカーチェッカー」アプローチは、正しさを向上させ、構造化データベース(NL2SQLなど)に対する書式の悪いクエリを処理し、バランスの取れた高品質の結果を保証するように設計されている。精巧なヒントチェーンだけに頼るのではなく、システムは推論プロセスを積極的に所有します。失敗したクエリを書き換えたり、異なる検索方法を選択したり、答えを確定する前に複数のツール(Azure AI Searchのベクトル検索、SQLデータベース、カスタムAPIなど)を統合したりすることができる。これにより、複雑すぎるオーケストレーションフレームワークは不要になる。その代わりに、比較的単純な「LLMコール→ツール使用→LLMコール→...」のループで、複雑で十分に推論された出力を生成することができる。

推論プロセスを持つ

システムを "Agentic "にする際立った特徴は、それ自身の推論プロセスを持つ能力である。伝統的なRAGの実装では、モデルの道筋を事前に定義するために人間に頼ることが多い。しかし、システムが真にエージェント的である場合、問題にどのようにアプローチするかを内部で決定する。単にスクリプトを実行するのではなく、見つけた情報の質に基づいてステップの順序を自律的に決定する。例えば、製品発売戦略の策定を依頼された場合、リサーチと意思決定のワークフロー全体を詳細に説明するプロンプトだけに頼ることはない。その代わりに、エージェンティック・モデルは独自に決定する:

- Bing Web Groundingを使用して、現在の市場動向レポートを取得する。

- Azure AI Searchを使用して、関連する競合他社のデータを特定する。

- Azure SQL Databaseを使用して、過去のインサイドセールス指標を関連付けます。

- Azure OpenAI Serviceで、アナリティクスを統合的な戦略に。

- ストラテジーはギャップや矛盾がないか評価され、必要であれば再検索が促される。これらのステップ(クエリの最適化、ソースの選択、答えに「満足」するまで繰り返し)はすべてモデルによって決定される。

反復ループ、ツール統合、メモリー

エージェンティック・システムは、周期的相互作用モデルに依存している:

- 最初の電話 ユーザーの目標(すなわち、ユーザーのプロンプト)は、LLMに提示される。

- ツールコール。 モデルが不足している情報や曖昧な指示を特定した場合、より多くのコンテキストを収集するためのツールや検索方法(例えば、ベクトルデータベースクエリ(例えば、Azure AI Searchのプライベートデータのハイブリッド検索)や構造化SQLコール)を選択する。

- 評価と最適化。 返されたデータを確認した後、モデルは十分な情報があるかどうかを判断する。十分でない場合は、クエリーを最適化したり、別のツールを試したり、アプローチを調整したりする。

- 満足するまで繰り返す。 このサイクルは、最終的に十分な根拠をもった回答をするのに十分な明確さと根拠があるとモデルが判断するまで続く。

- メモリとステータス。 システムはステップ全体を通して状態と記憶を維持するため、以前の試行とその結果を思い出すことができ、繰り返しのサイクルを避け、より多くの情報に基づいた決定を下しながら進むことができる。

時間が経つにつれて、これは、継続的な人間の介入やキューの再設計を必要とせずに、モデルが複雑なマルチステップタスクを処理することを可能にする理解の進化感覚を作成します。

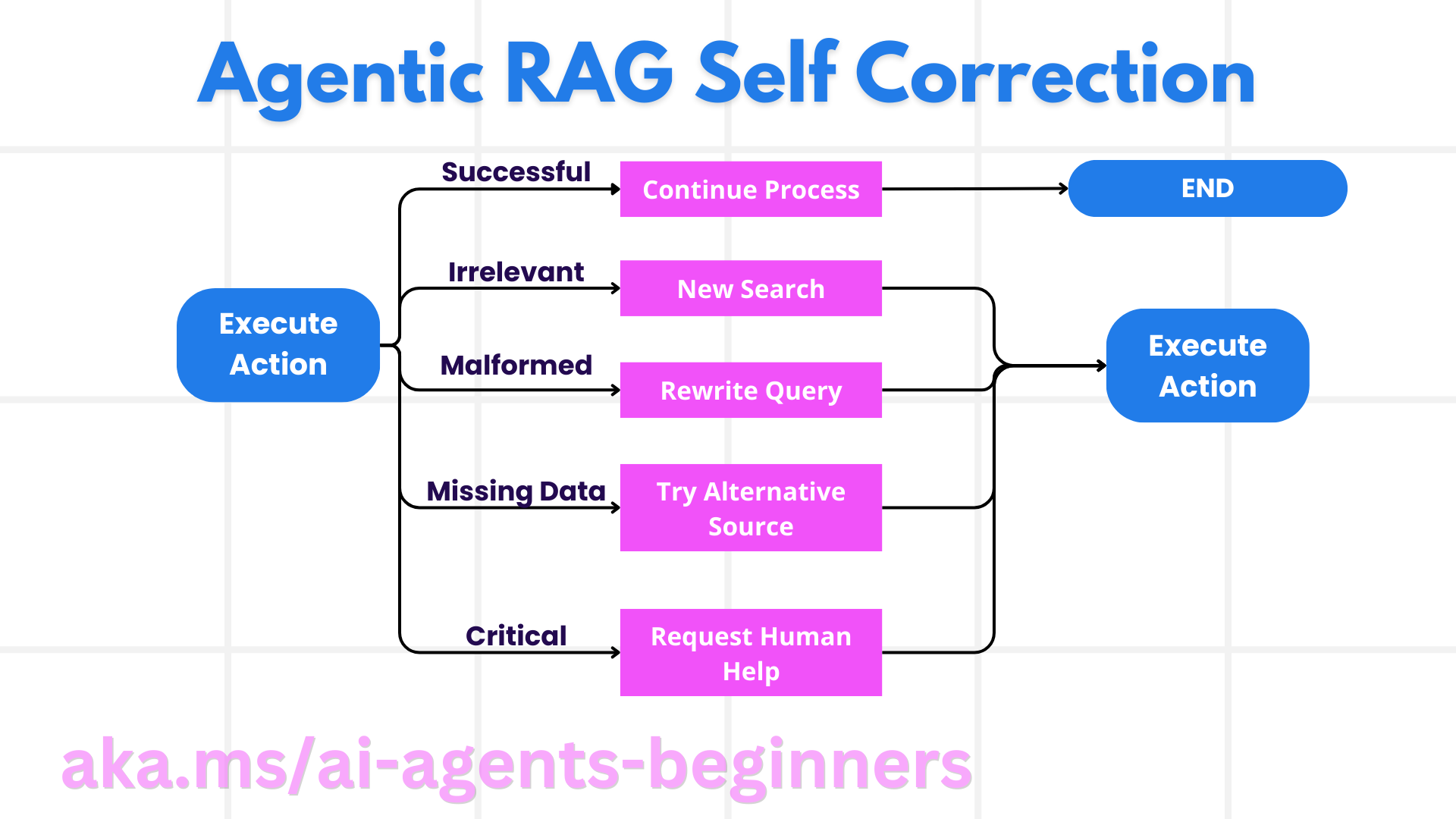

故障モードへの対処と自己修正

Agentic RAGの自律性には、強力な自己修正メカニズムも含まれている。システムが行き詰まったとき(例えば、無関係な文書を検索したり、間違った形式のクエリに遭遇したとき)、システムは次のことができる:

- 反復と再クエリ。 価値の低い応答を返す代わりに、モデルは新しい検索戦略を試したり、データベースのクエリを書き換えたり、別のデータセットを調べたりする。

- 診断ツールの使用。 システムは、推論ステップのデバッグや取得したデータの正しさを確認するために設計された追加関数を呼び出すことができます。Azure AI Tracingのようなツールは、堅牢な観測性と監視を可能にするのに役立ちます。

- 手動監督への依存。 リスクが高い、あるいは失敗を繰り返す場合、モデルは不確実性にフラグを立て、人間のガイダンスを要求することができる。人間が修正フィードバックを提供すれば、モデルはその経験を将来的に採用することができる。

この反復的でダイナミックなアプローチは、モデルの継続的な改善を可能にし、それが単なる一過性のシステムではなく、与えられたセッションでの失敗から学ぶことができるものであることを保証する。

エージェントの境界線

エージェント型RAGはそのタスクにおいて自律的ではあるが、汎用AIと同等ではない。その「エージェント的」能力は、人間の開発者が提供するツール、データソース、ポリシーに限定される。独自のツールを発明したり、設定されたドメインの境界を超えることはできない。その代わり、手元にあるリソースを動的にオーケストレーションすることに長けている。より高度なAIとの主な違いは以下の通り:

- 特定分野における自律性。 エージェント型RAGシステムは、結果を改善するためにクエリの書き換えやツールの選択などの戦略を使用して、既知のドメイン内でユーザーが定義した目標を達成することに重点を置いている。

- インフラへの依存。 システムの能力は、開発者が統合するツールとデータに依存する。人間の介入なしには、これらの境界を超えることはできない。

- ガードレールへの敬意。 倫理規定、コンプライアンス・ルール、ビジネス戦略が重要であることに変わりはない。エージェントの自由は、常にセキュリティ対策や監視の仕組みの対象となる(といいのだが?)

実用的な使用例と価値

Agentic RAGは、反復的な最適化と精度を必要とするシナリオで輝きを放つ:

- 「正しさ優先」の環境 コンプライアンス・チェック、規制分析、または法的調査において、Agenticモデルは、徹底的に吟味された答えが生成されるまで、事実を繰り返し検証し、複数の情報源を参照し、クエリを書き換えることができる。

- 複雑なデータベース相互作用。 クエリがしばしば失敗したり、チューニングが必要な構造化データを扱う場合、システムはAzure SQLまたはMicrosoft Fabric OneLakeを使用して、クエリを自律的に最適化し、最終的な検索がユーザーの意図に一致するようにすることができます。

- 拡張ワークフロー。 エージェントRAGは、新しいデータを継続的に統合し、問題空間についてより多くのことがわかるにつれて戦略を変更することができる。

ガバナンス、透明性、信頼

これらのシステムがより自律的な推論を行うようになるにつれ、ガバナンスと透明性が重要になってくる:

- 解釈可能な推論。 Azure AI Content SafetyやAzure AI Tracing / GenAIOpsなどのツールは、透明性を維持し、リスクを軽減するのに役立ちます。

- 偏差制御とバランス検索。 開発者は、バランスの取れた代表的なデータソースが考慮されるように検索戦略を調整し、Azure Machine Learningを使用して高度なデータサイエンス組織向けにモデルをカスタマイズし、定期的に出力を監査して偏りや歪んだパターンを検出することができます。

- マニュアルの監督とコンプライアンス。 エージェンティックRAGは、リスクの高い意思決定における手作業による判断に取って代わるものではなく、より徹底的なレビューの選択肢を提供することでそれを補強するものである。

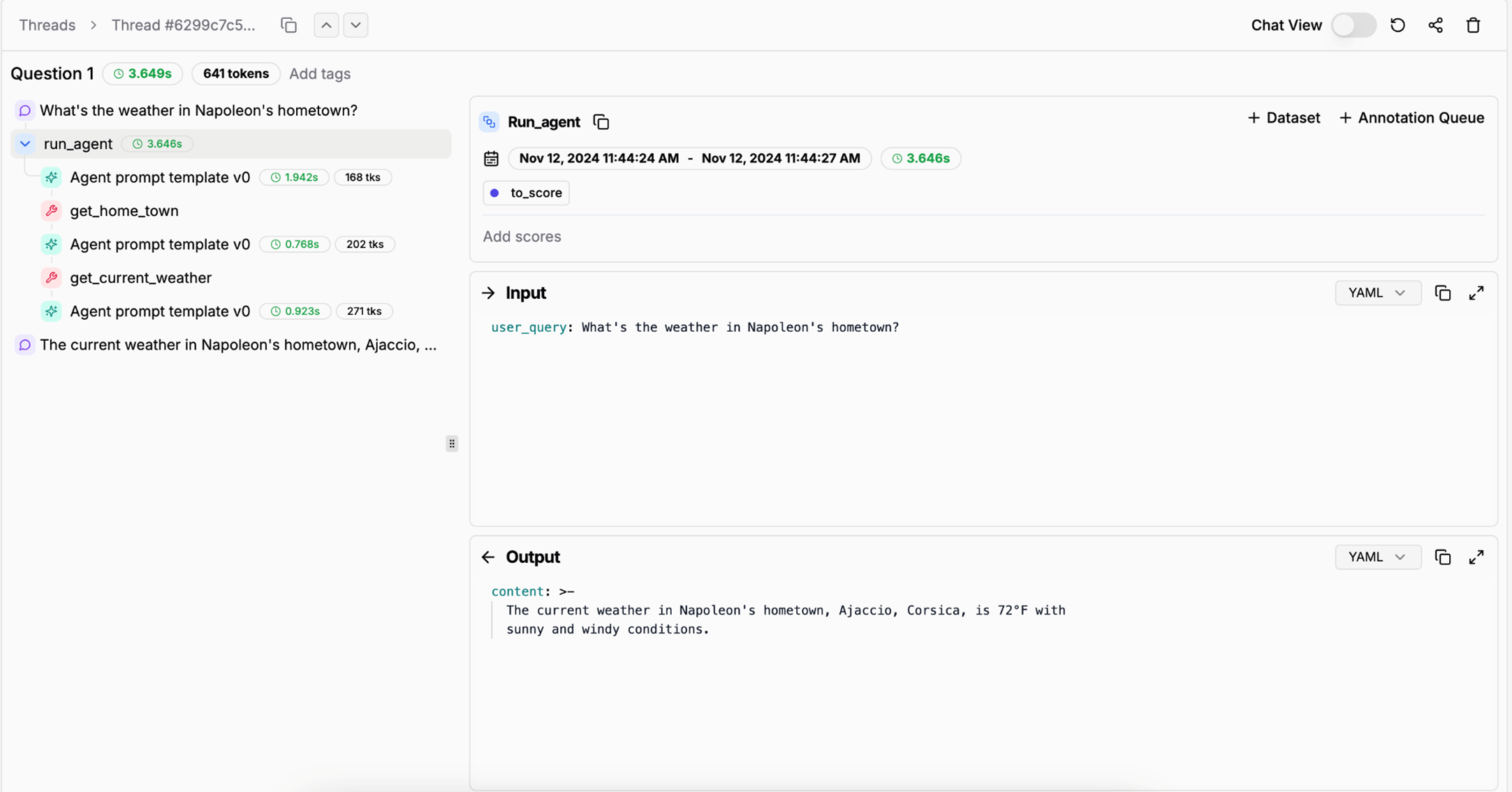

操作の明確な記録を提供するツールが不可欠である。これがないと、マルチステッププロセスのデバッグが非常に困難になる。Agentの実行例については、Literal AI(Chainlitを開発した会社)を参照のこと:

評決を下す

エージェント型RAGは、AIシステムが複雑でデータ集約的なタスクにアプローチする方法の自然な進化を表している。周期的な相互作用モデルを採用し、自律的にツールを選択し、高品質な結果が得られるまでクエリを最適化することで、システムは静的なプロンプト追従型から、より適応的でコンテキストを認識した意思決定者へと変化している。人間が定義したインフラや倫理観に縛られつつも、このようなエージェント機能は、企業やエンドユーザーにとって、より豊かでダイナミック、そして最終的にはより有用なAIインタラクションを提供する。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません