Wan2.1:民生用GPUで高画質ビデオを生成する

はじめに

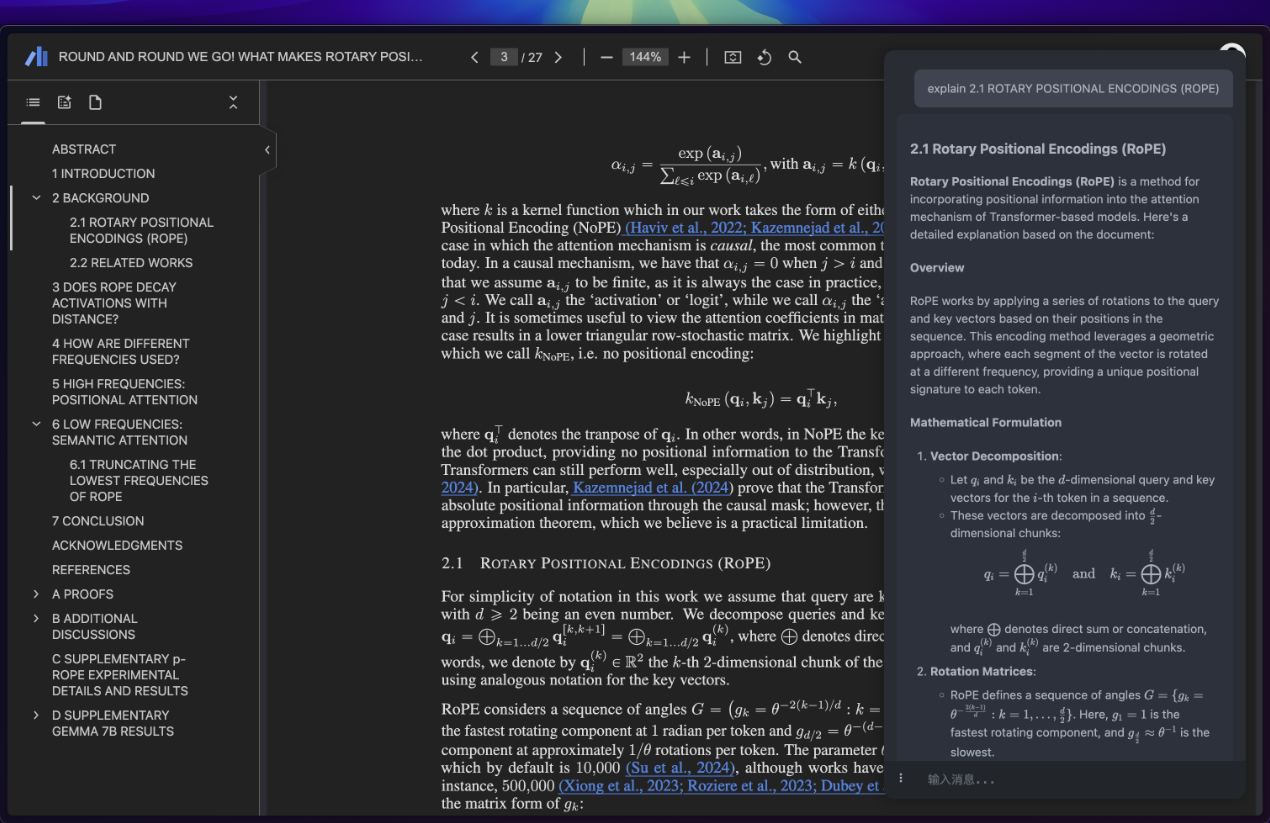

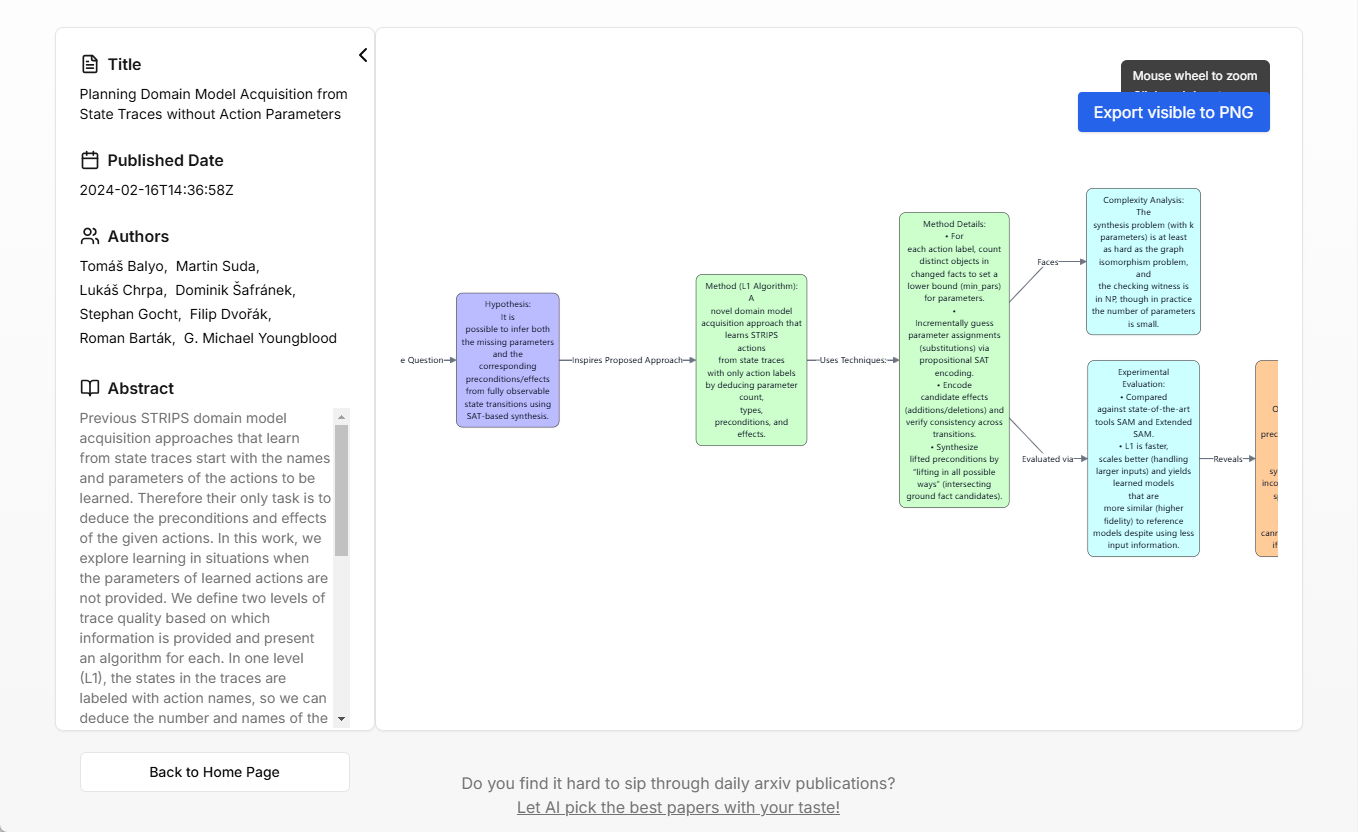

Wan2.1は、Wan-Videoチームによって開発され、GitHubでオープンソース化されたビデオ生成ツールスイートであり、人工知能技術によってビデオ作成の限界を押し広げることに焦点を当てている。Wan2.1のハイライトは、優れたパフォーマンスと、わずか8.19GBのビデオメモリで動作し、RTX 4090上で5秒間の480P動画を生成するT2V-1.3Bモデルのような民生グレードのハードウェアのサポートです。動画をRTX 4090上で生成する。このプロジェクトは効率的なビデオ生成機能を提供するだけでなく、長さの制限なしに1080Pのエンコードとデコードをサポートするため、コンテンツ制作者、開発者、学術研究チームに広く適用できます。

関連記事動画生成モデルVBenchがトップ...チャートのトップ - WanX 2.1がまもなくオープンソースになります!

機能一覧

- テキストからビデオへ入力されたテキスト記述に基づいて、動的なビデオコンテンツを生成します。

- イメージ・トゥ・ビデオ(イメージからビデオへ)静止画を動画に変換し、画像の元の比率と自然な動きを維持します。

- ビデオ編集AI技術で既存の動画を修正・最適化。

- 高解像度出力に対応480Pと720Pの動画が生成でき、長さ制限なしで1080Pをサポートするモデルもある。

- Wan-VAEテクノロジー:: 効率的な時間圧縮を提供し、長いビデオ生成をサポートし、時間情報を保持する。

- コンシューマー向けGPUの最適化:: 一般的なハードウェアで動作するため、使用へのハードルが低い。

- マルチタスク・サポートtext-to-image、video-to-audio、その他の拡張機能を含む。

- 中国語と英語のテキスト生成動画に中国語と英語のわかりやすいテキストを生成します。

ヘルプの使用

Wan2.1は、高品質のビデオコンテンツを素早く生成したいユーザーのための強力なオープンソースのビデオ生成ツールです。以下は、すぐに使い始めるための詳しいインストールと使用ガイドです。

設置プロセス

Wan2.1のインストールには技術的なスキルが必要で、主にGitHubリポジトリからコードとモデルウェイトを入手する。以下はその手順である:

1.環境準備

- オペレーティングシステムWindows、Linux、macOSに対応。

- ハードウェア要件少なくとも8GBのビデオメモリを搭載したGPU(例:RTX 3060 Tiまたは4090)、Nvidia GPUを推奨。

- ソフトウェア依存Python 3.10+、Git、グラフィックドライバ、CUDA(GPUを使用する場合)。

- Pythonのインストール公式サイトからPython 3.10以上をダウンロードし、インストール時に「PythonをPATHに追加」にチェックを入れる。

2.コードとモデルのダウンロード

- ターミナルまたはコマンドラインを開き、以下のコマンドを入力してリポジトリをクローンする:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1

- 依存ライブラリをインストールする:

pip install -r requirements.txt

- Hugging Faceからモデルウェイトをダウンロードする(例としてT2V-1.3B):

pip install "huggingface_hub[cli]"

huggingface-cli download Wan-AI/Wan2.1-T2V-1.3B --local-dir ./Wan2.1-T2V-1.3B

- オプションモデル:T2V-14B(より高性能、より多くのビデオメモリが必要)、I2V-480P/720P。

3.構成環境

- ビデオメモリが少ない場合は、最適化パラメータを有効にする(例

--offload_model True歌で応える--t5_cpu). - を使用して、GPUドライバとCUDAが正しくインストールされていることを確認します。

nvidia-smiチェックする。

4.インストールの検証

以下のコマンドを実行して環境をテストする:

python generate.py --task t2v-1.3B --size 832*480 --ckpt_dir ./Wan2.1-T2V-1.3B --prompt "测试视频生成"

ビデオファイルが出力されれば、インストールは成功です。

機能 操作の流れ

テキストからビデオへ

- 準備したテキスト例:"猫が芝生の上を優雅に歩き、カメラがそれを追う"。

- コマンド実行:

python generate.py --task t2v-1.3B --size 832*480 --ckpt_dir ./Wan2.1-T2V-1.3B --prompt "A cute cat walking gracefully on a lush green field"

- パラメタリゼーション:

--size解像度を設定(例:832)480または1280720).--offload_model True低ビデオメモリの最適化。--sample_shift 8 --sample_guide_scale 6発電の質を向上させる。

- 輸出生成されたビデオはカレント・ディレクトリに保存され、長さは約5秒です。

イメージ・トゥ・ビデオ(イメージからビデオへ)

- 画像の準備JPG/PNG画像をアップロードしてください。

input.jpg). - コマンド実行:

python generate.py --task i2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-I2V-14B-720P --image input.jpg --prompt "Summer beach vacation style"

- 結局このモデルは、元のプロポーションと自然な動きを維持したまま、画像に基づいてダイナミックなビデオを生成します。

ビデオ編集

- 入力ビデオ既存のビデオファイルを用意する。

- 編集業務DiffSynth-Studio (Wan 2.1 は拡張機能をサポートしています) などのツールを使って、コマンドラインから関連するモジュールを呼び出してください。

- サンプルコマンド(コンピューティング)具体的なパラメーターはGitHubのドキュメントを参照。基本的な編集は現在サポートされている。

高解像度出力

- T2V-14BまたはI2V-720Pモデルを使用する場合は、次のように設定します。

--size 1280*720新しいグラフィックカードは、より多くのメモリを必要とする(約17GB)。 - Wan-VAEは、長さの制限なしに1080Pをサポートし、長いビデオ生成に適しています。

中国語と英語のテキストを生成する

- プロンプトに「英語と中国語で "Welcome "と書かれた看板」など、テキストによる説明を含める。

- Text to Videoコマンドを実行すると、モデルは自動的に動画に明確なテキストを埋め込みます。

ヒントとコツ

- パフォーマンスを最適化するローエンドハードウェアには1.3Bモデル、解像度480Pを、ハイエンドハードウェアには14B、解像度720Pをお勧めします。

- キュー・ワードの提案アクション、シーン、ライティングなど、詳細な描写で生成の質を高める。

- 地域支援GitHub IssuesまたはDiscordのディスカッショングループに参加してください。

以上の手順で、Wan2.1を使用して、クリエイティブなプレゼンテーションや学術研究用のプロ級のビデオコンテンツを簡単に作成することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません