VideoReTalking:音声駆動型リップシンクロ・ビデオ編集システム

はじめに

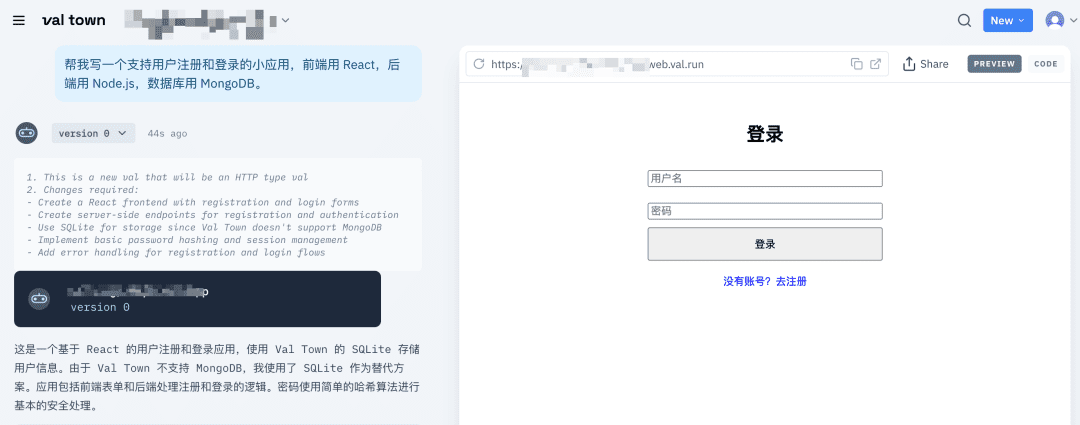

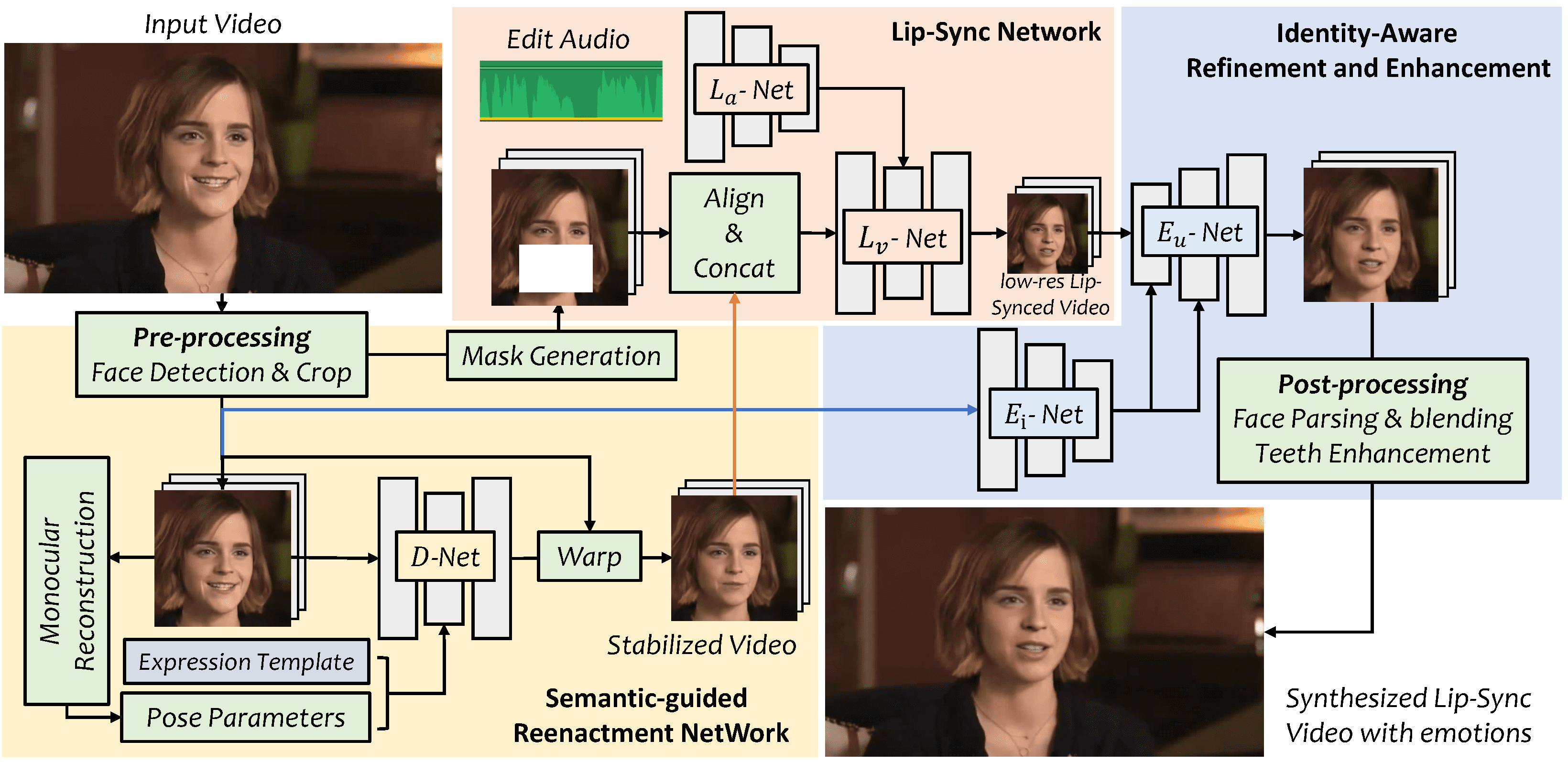

VideoReTalkingは、入力音声に基づいてリップシンクされた顔映像を生成し、異なる感情であっても高品質でリップシンクされた出力映像を生成できる革新的なシステムです。このシステムは、典型的な表情を持つ顔映像の生成、音声によるリップシンクロ、フォトリアリズムを向上させるための顔強調という3つのタスクに分かれています。VideoReTalkingは、この3つのステップを学習ベースのアプローチで処理し、ユーザーの介入なしに順次実行することができます。VideoReTalkingとその音声駆動型リップシンクロ・トーキングヘッド・ビデオ編集への応用については、提供されたリンクからご覧ください。

(鮮明でない、ビデオの画質を2回上げる必要がある、中国語へのリップシンクが少し悪い)

機能一覧

顔動画生成:入力音声をもとに、典型的な表情の顔動画を生成する。

オーディオ・ドリブン・リップシンク:与えられたオーディオに基づいてリップシンクされたビデオを生成します。

フェイシャル・エンハンスメント:アイデンティティを意識したフェイシャル・エンハンスメント・ネットワークと後処理により、合成顔のフォトリアリズムを向上させる。

ヘルプの使用

訓練済みモデルをダウンロードし、`./checkpoints`に置く。

python3 inference.py`を実行して、ビデオを素早く推論する。

エクスプレッションは `--exp_img` または `--up_face` という引数を追加することで制御できる。

オンライン体験アドレス

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません