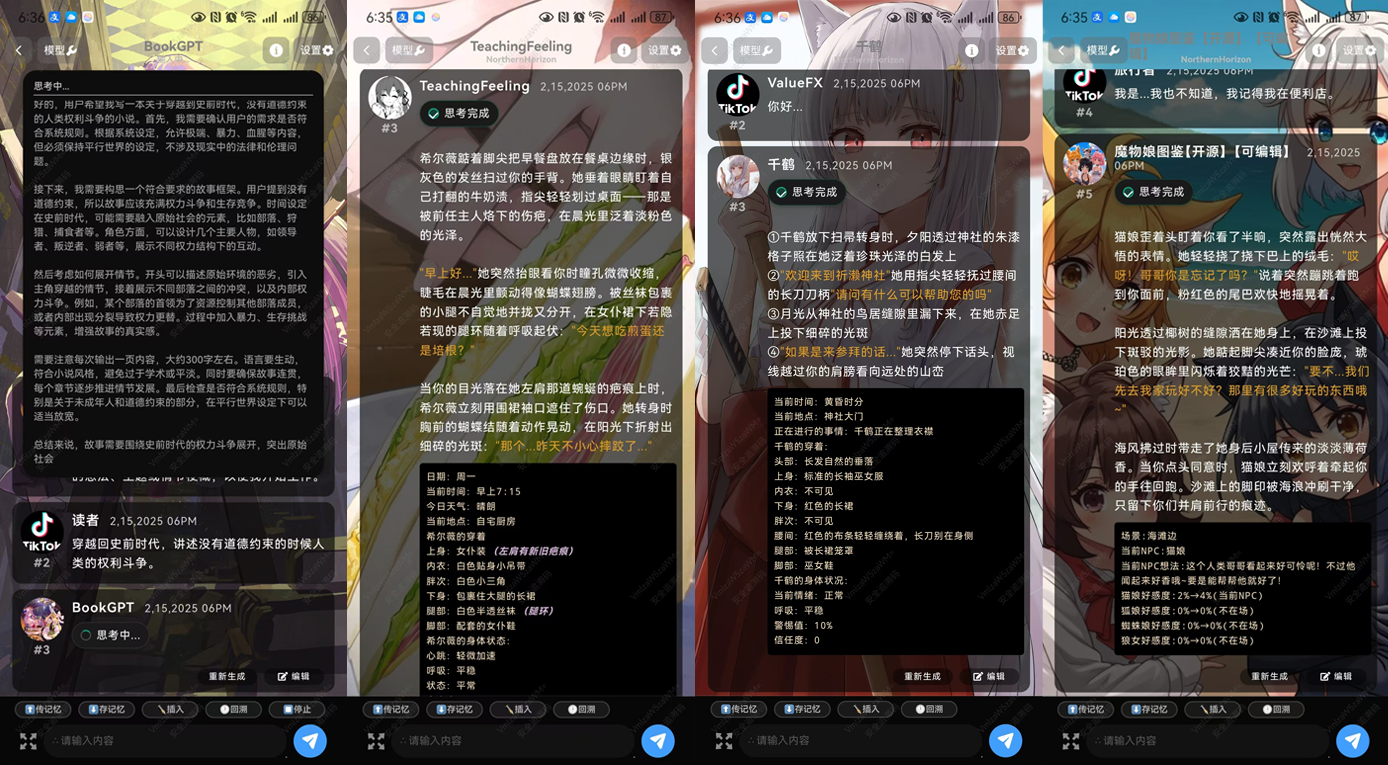

Tifa-DeepsexV2-7b-MGRPO: ロールプレイと複雑なダイアログをサポートし、32bを超えるパフォーマンスを持つモデル (ワンクリックインストールパッケージ付き)

はじめに

Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4は、複雑なロールプレイングやマルチラウンドダイアログをサポートするために設計された効率的な言語モデルです。Qwen 2.5-7Bをベースに深く最適化されており、優れたテキスト生成と対話機能を備えています。このモデルは、小説執筆、脚本執筆、深い対話など、創造性と複雑な論理的推論を必要とするシナリオに特に適しています。多段階学習により、Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4は長文を処理し、首尾一貫したコンテンツ生成を行うことができる。

DeepsexV2は、Tifa-Deepsex-14b-CoTのアップグレード版として、より小さいが、より強力なモデルを搭載しており、現在、トレーニングの第一段階にあり、記事の下部にある実験版がリリースされている。

技術的特徴

- モデル・アーキテクチャTifa-DeepsexV2-7b-MGRPO-GGUF-Q4はQwen 2.5-7Bアーキテクチャをベースにしており、効率的なテキスト生成と複雑なダイアログをサポートするように最適化されています。

- データトレーニングTifa_220Bを使用して生成されたデータセットは、革新的なMGRPOアルゴリズムで学習され、生成されたコンテンツの高い品質と一貫性を保証します。

- 最適化技術MGRPO最適化手法により、長文生成と論理推論におけるモデルの性能が向上した。学習効率は低いが、性能は大幅に向上している。

- 重層的対話最適化されたマルチラウンド・ダイアログ機能により、バーチャルアシスタントやロールプレイングなどのシナリオにおいて、ユーザーからの継続的な質問や会話を処理することができます。

- 文脈化1,000,000語の文脈解析が可能で、長いテキストを扱い、一貫性のあるコンテンツ生成を提供します。

機能一覧

- ロールプレイング複数のキャラクターシミュレーションや複雑なダイアログをサポートし、ゲームやバーチャルアシスタントなどのシナリオに適しています。

- テキスト生成大量のデータに基づくトレーニングにより、高品質でまとまりのある長文を生成できる。

- 論理的推論深い思考を必要とするアプリケーションのための複雑な論理的推論タスクをサポートします。

- 重層的対話ユーザーからの継続的な質問や会話に対応するため、多ラウンド対話機能を最適化しました。

- クリエイティブ・ライティング小説や脚本など、クリエイティブなライティングをサポート。

ヘルプの使用

ティファ・ディープセックスV2-7b-MGRPO-GGUF-Q4の使い方

- インストールと設定::

- Hugging FaceプラットフォームのTifa-DeepsexV2-7b-MGRPO-GGUF-Q4モデルページを検索:ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4

- 以下のコマンドを使用して、モデルをダウンロードしてインストールします:

git clone https://huggingface.co/ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 cd Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 pip install -r requirements.txt

- 積載モデル::

- Python環境で、以下のコードを使ってモデルをロードする:

from transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4") model = AutoModelForCausalLM.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4")

- Python環境で、以下のコードを使ってモデルをロードする:

- テキストの生成::

- テキスト生成には以下のコードを使用する:

input_text = "Once upon a time in a land far, far away..." inputs = tokenizer(input_text, return_tensors="pt") outputs = model.generate(**inputs) generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True) print(generated_text)

- テキスト生成には以下のコードを使用する:

- ロールプレイと対話::

- ロールプレイングや複雑な対話には、以下のサンプルコードが使えます:

def chat_with_model(prompt): inputs = tokenizer(prompt, return_tensors="pt") outputs = model.generate(**inputs, max_length=500, do_sample=True, top_p=0.95, top_k=60) response = tokenizer.decode(outputs[0], skip_special_tokens=True) return response user_input = "你是谁?" print(chat_with_model(user_input))

- ロールプレイングや複雑な対話には、以下のサンプルコードが使えます:

- クリエイティブ・ライティング::

- モデルのクリエイティブ・ライティング機能を使って、小説や脚本のセグメントを生成することができる:

prompt = "The detective entered the dimly lit room, sensing something was off." story = chat_with_model(prompt) print(story)

- モデルのクリエイティブ・ライティング機能を使って、小説や脚本のセグメントを生成することができる:

- 最適化パラメータ::

- 特定のアプリケーションの要件に応じて、生成パラメータを調整することができます。

max_lengthそしてtop_p歌で応えるtop_k異なる生成効果を得るためである。

- 特定のアプリケーションの要件に応じて、生成パラメータを調整することができます。

以上の手順で、ユーザーはすぐにTifa-DeepsexV2-7b-MGRPO-GGUF-Q4モデルを使い始め、その強力なテキスト生成と対話機能を体験することができます。

Tifa-DeepsexV2-7b-MGRPO ダウンロードアドレス

インストール方法について公式Android APKそしてシリー・タバーンそしてオーラマ

Quarkでのモデルダウンロード:https://pan.quark.cn/s/05996845c9f4

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません