Tifa-Deepsex-14b-CoT:ロールプレイングと超長編小説の生成に特化した大型モデル。

はじめに

Tifa-Deepsex-14b-CoTは、Deepseek-R1-14Bの深層最適化に基づき、ロールプレイング、架空のテキスト生成、Chain of Thought (CoT)推論能力に焦点を当てた大規模モデルである。多段階の学習と最適化により、オリジナルモデルの問題点であった長文テキスト生成における一貫性の不足とロールプレイ能力の弱さを解決し、特に長距離の文脈相関を必要とする創造的なシナリオに適したモデルとなっている。高品質のデータセットとインクリメンタルな事前学習を融合させることで、このモデルは文脈の関連性を大幅に強化し、非回答を減らし、中国語と英語の混在を排除し、ロールプレイングと小説生成のパフォーマンスを向上させるためにドメイン固有の語彙を増加させる。さらに、このモデルは、深い対話と複雑なオーサリングを必要とするシナリオのために、128kの超長文コンテクストをサポートしています。

Deepseek-R1-14Bは、長編小説やロールプレイング・シナリオに深く最適化されたバージョンで、シンプルなAndroidクライアントがダウンロード可能です。現在のアップグレード ディープセックス2 版。

機能一覧

- ロールプレイシナリオのための詳細な対話をサポートし、キャラクターの性格や背景に合った応答を生成します。

- 首尾一貫した長い物語や筋書きを作るために、フィクションの文章を作るスキルを提供する。

- 論理的な推論や複雑な問題解決を必要とするシナリオに対応する思考連鎖(CoT)推論スキル。

- 128kの超長文コンテキストをサポートし、長文テキスト生成の高い一貫性と一貫性を確保。

- 最適化されたモデルにより、回答が拒否される現象が減少し、多様なオーサリングのニーズに対してセキュリティが適度に保たれる。

- さまざまなハードウェア環境に対応するため、さまざまな定量化バージョン(F16、Q8、Q4など)を提供し、導入と使用を容易にする。

ヘルプの使用

インストールと展開

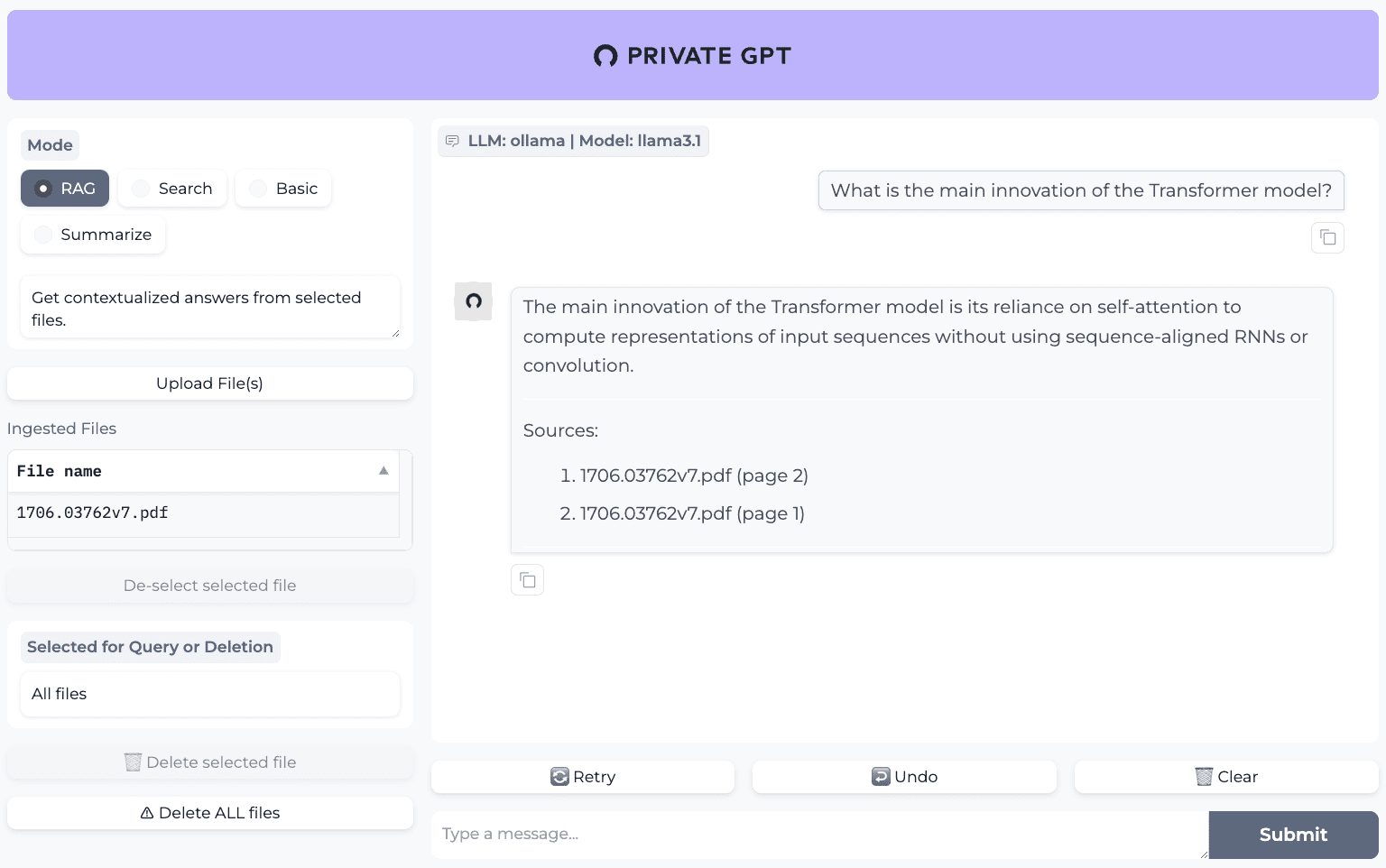

Tifa-Deepsex-14b-CoTモデルはHugging Faceプラットフォーム上でホストされており、ユーザーはハードウェア環境と要件に基づいて適切なモデルのバージョン(例:F16、Q8、Q4)を選択する必要があります。以下は、詳細なインストールと展開のプロセスです:

1.モデルのダウンロード

- ハギング・フェイスのモデル・ページはhttps://huggingface.co/ValueFX9507/Tifa-Deepsex-14b-CoT。

- ハードウェアの対応状況に応じて、適切な定量化バージョン(例:Q4_K_M.gguf)を選択します。対応するファイルをクリックして、モデルウェイトをダウンロードしてください。

- Demo APKを使用する必要がある場合は、公式に提供されているデモアプリケーションを直接ダウンロードすることができます(手動でキャラクターカードをインポートし、カスタムAPIを選択する必要があります)。

2.環境準備

- Python環境がインストールされていることを確認する(Python 3.8以上を推奨)。

- transformersやhuggingface_hubなど、必要な依存ライブラリをインストールする。これらは以下のコマンドでインストールできる:

pip install transformers huggingface-hub - GGUFフォーマットのモデルを使用している場合は、以下のものをインストールすることをお勧めします。 ラマ.cpp または関連するサポート・ライブラリ。は以下のコマンドでクローンし、コンパイルすることができる:

git clone https://github.com/ggerganov/llama.cpp cd llama.cpp make

3.モデル・ローディング

- 変圧器を使ってモデルに負荷をかける:

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "ValueFX9507/Tifa-Deepsex-14b-CoT" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained(model_name) - GGUFフォーマットを使用している場合は、llama.cppを介して実行することができます:

./main -m Tifa-Deepsex-14b-CoT-Q4_K_M.gguf --color -c 4096 --temp 0.7 --repeat_penalty 1.1 -n -1 -p "你的提示词"ここで-c 4096は、必要に応じてより大きなコンテキスト長(例えば128k)に調整できるが、ハードウェアの制限に注意すること。

4.構成と最適化

- モデルの出力に影響を与えないように、返されるコンテキストから思考ラベル(例)を取り除くようにします。これは以下のコードで実現できる:

content = msg.content.replace(/<think>[\s\S]*?<\/think>/gi, '') - フロントエンドインターフェースを使用する場合は、コンテキスト処理を適応させるためにフロントエンドコードを手動で修正する必要があります。

機能 操作の流れ

ロールプレイング機能

- キャラクター設定の入力:キャラクターの背景、性格、会話シーンなどをプロンプトで指定します。例

你是一个勇敢的冒险者,名叫蒂法,正在探索一座神秘的古城。请描述你的冒险经历,并与遇到的 NPC 进行对话。 - 応答の生成: モデルは、キャラクターの設定に基づいて、そのキャラクターらしい会話や語りを生成します。ユーザーは入力を続けることができ、モデルは文脈の一貫性を維持します。

- パラメーターの調整:temperature(生成されるテキストのランダム性を制御する)とrepeat_penalty(繰り返される内容を制御する)を調整して出力を最適化する。

斬新なジェネレーション機能

- 物語の背景を設定する:例えば、物語の始まりや概要を説明する:

在一个遥远的王国,有一位年轻的法师试图解开时间的秘密。请续写这个故事。 - ストーリーの生成:このモデルは、プロンプトに基づいて首尾一貫した長いストーリーを生成し、複数段落の出力をサポートします。

- 長いコンテキストのサポート:128kコンテキストのサポートにより、ユーザーは長いストーリーのコンテキストを入力することができ、モデルはプロットの一貫性を維持します。

思考連鎖推論

- 複雑な問題の入力:例

如果一个城市每天产生100吨垃圾,其中60%可回收,40%不可回收,但回收设施每天只能处理30吨可回收垃圾,剩余的可回收垃圾如何处理? - 推論プロセスの生成:モデルは問題を段階的に分析し、論理的で明確な答えを提供し、長期的な推論をサポートする。

ほら

- ハードウェア要件:このモデルの実行には高度なグラフィックメモリが必要です。少なくとも16GBのグラフィックメモリを搭載したGPUまたは高性能CPUを推奨します。

- セキュリティとコンプライアンス:このモデルはトレーニング中も特定のセキュリティ設定を保持するため、ユーザーは使用シナリオが関連法規に準拠していることを確認する必要があります。

- コンテキストの管理:非常に長いコンテキストを使用する場合は、ハードウェアの制限を超えないように、プロンプトの単語をセグメントで入力することをお勧めします。

これらのステップにより、ユーザーはロールプレイング、小説作成、複雑な推論など、ティファ-Deepsex-14b-CoTモデルを簡単に使い始めることができ、高品質な生成結果を得ることができます。

ティファ-ディープセックス-14b-CoT バージョン差

ティファ-ディープセックス-14b-CoT

- RLの報酬アルゴリズムがロールプレイングデータに与える影響をテストするためのモデルの検証。初期バージョンは、柔軟ではあるが制御されていない出力を持っており、研究使用のみを目的としている。

ティファ-ディープセックス-14b-CoT-チャット

- 標準的なデータで学習し、実績のあるRLストラテジーを使用し、さらにアンチリピート強化学習を追加した、通常の使用に適したもの。出力されるテキストの質は正常で、いくつかのケースでは発散思考が見られる。

- 0.4Tの新規コンテンツ、TifaMaxによって生成された100KのSFTデータ、DeepseekR1によって生成された10KのSFTデータ、および2Kの高品質なマニュアルデータの増分トレーニング。

- TifaMaxによって生成された30K DPO強化学習データにより、重複の防止、文脈上の関連付けの強化、政治的安全性の向上を実現。

ティファ-ディープセックス-14b-CoT-クレイジー

- 主に671Bの全血R1から抽出されたデータを使用し、R1の長所だけでなくR1の危険性も受け継いだ出力分散性の高い、文学的性能の高いRL戦略が多数使用されている。

- 0.4Tの新規コンテンツ、TifaMaxによって生成された40KのSFTデータ、DeepseekR1によって生成された60KのSFTデータ、および2Kの高品質なマニュアルデータの増分トレーニング。

- TifaMaxによって生成された10K PPOデータとDeepseekR1によって生成された10K PPOデータ。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません