Think&Cite: ツリー検索技術によるテキスト引用の精度向上

抄録

大規模言語モデル(Large Language Models: LLM)は、性能は良いものの、幻覚を見たり、事実と異なる情報を生成したりする傾向がある。この課題は、LLMに裏付けとなる証拠を含むコンテンツを生成するよう促す、属性テキスト生成の取り組みを動機づけてきた。本論文では、Think&Citeと呼ばれる新しいフレームワークを提案し、属性文生成を統合検索を伴う多段階推論問題として定式化する。具体的には、自己誘導モンテカルロ木探索(Self-Guided Monte Carlo Tree Search: SG-MCTS)を提案する。これは、LLMの自己反映能力を利用し、MCTSの中間状態を反映することで、木展開プロセスを誘導する。信頼性の高い包括的なフィードバックを提供するために、我々はProgress Reward Model (PRM)を導入し、生成と属性の両方の観点から、ルートノードから現在の状態までの木探索の進捗を測定する。我々は3つのデータセットで広範な実験を行い、その結果、我々の手法がベースライン手法を大幅に上回ることを示した。

1 はじめに

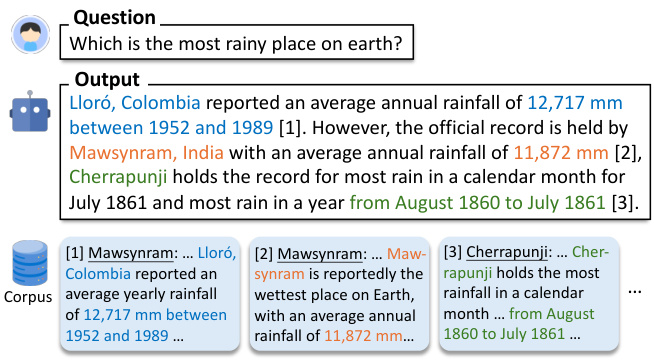

大規模言語モデル(LLM)(Zhao et al.このような進歩にもかかわらず、LLMはしばしば錯覚的で不正確な情報を含む応答を生成する(Ji et al.)この問題は、LLMの信頼性を損ない、さらに重要なことに、ユーザーのLLMに対する信頼を損なう。LLMの信頼性を向上させるために、図1に示すように、LLMが証拠となる引用を含む回答を生成できるようにする、属性テキスト生成という新しい生成パラダイムが提案されている(Gao et al.

図1:質問が与えられると、モデルはコーパスの一節を裏付けとして引用してテキストを生成する。

既存の研究(Slobodkin et al., 2024; Sun et al., 2024; Fierro et al., 2024)のほとんどは、テキストを生成する際にLLMに引用文献を提供するよう促すだけである。さらに、他の研究(Li et al., 2024; Huang et al., 2024)では、注釈付き引用を含むテキストを含む大量の教師付き学習データ上でLLMの微調整を試みている。こうした最近の試みにもかかわらず、信頼できる引用を含む忠実なコンテンツを生成するように学習するLLMの開発は、依然として未解決の課題である。第一に、既存の手法は自己回帰的な生成パラダイムを使用している。このパラダイムは「システム1」として特徴付けることができ、高速で直感的な思考様式であるが、精度は不十分である(Kahneman, 2011)。その結果、中間的な生成エラー(誤答や誤引用など)があると、最終的な回答が不正確になる可能性がある。複雑な推論研究(Zhang et al., 2024; Wang et al., 2024)に触発され、より深く、注意深く、論理的な思考を必要とする外部証拠を引用する「システム2」パラダイムのモデルを開発することを目指した(Kahneman, 2011)。liuら(2023)は、既存のLLMに対する長い回答には、しばしば裏付けのない記述や不正確な引用が含まれていることを発見した。我々は、これまでの研究で明示的な生成計画が欠けていたことが、このようなシステムの進歩を妨げてきたと主張する。

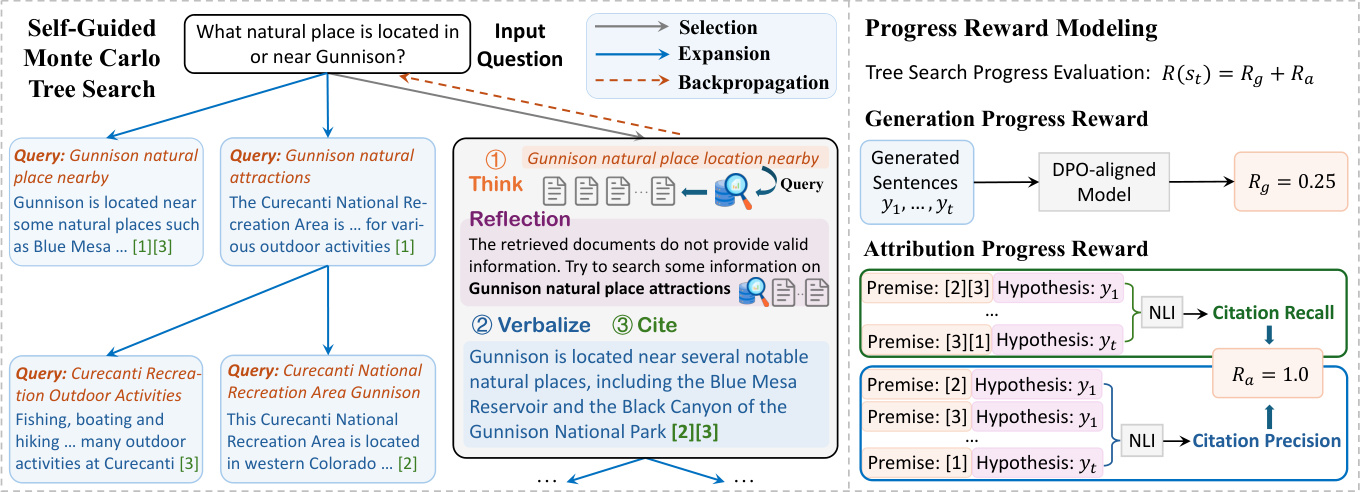

本稿では、検索アルゴリズムを属性文生成に統合する新しいフレームワークThink&Citeを紹介する。我々は生成タスクを多段階推論問題として概念化し、モデルは反復的なthink-express-referenceパラダイムを通して各段階で文章を生成する。この生成プロセスを強化するために、我々は自己誘導型モンテカルロ木探索(Self-Guided Monte Carlo Tree Search: SG-MCTS)を提案する。第一に、我々のアプローチはLLMの自己反映能力を利用し、MCTSの中間状態をリアルタイムに反映させることで、木展開プロセスをガイドし、不十分な推論経路を積極的に回避する。これは、主に最終結果や完全な軌跡を反映する先行研究とは対照的である。第二に、ルートノードから現在の状態までの木探索の進捗を、生成と属性の両方の観点から測定する進捗報酬モデル(PRM)を提案する。個々のステップのみを評価するのとは対照的に、進捗に基づく報酬モデルは、MCTS探索プロセスを導くための信頼性の高い包括的な評価を提供する。

我々の知る限り、属性テキスト生成のタスクに木探索アルゴリズムを適用したのは我々が初めてである。我々のアプローチの有効性を検証するため、3つのデータセットで広範な実験を行った。その結果、我々のモデルがこれまでのヒントや微調整されたベースラインを大幅に上回ることが示された。

2 関連作品

帰属を伴うテキスト生成。 大規模言語モデル(LLM)は、その優れた言語生成能力により、帰属を伴うテキスト生成に使用されてきた(Gao et al., 2023b; Huang et al., 2024; Sun et al., 2024; Li et al., 2024; Slobodkin et al., 2024)。 帰属を伴うテキスト生成のためのLLMは、大きく2つのカテゴリーに分けられる。生成された作品は大きく2つのカテゴリーに分けられる。第一のタイプは、選好学習(Li et al., 2024)と強化学習(Huang et al., 2024)を使ってLLMを微調整するもので、より高い報酬を得るために、LLMに支持的で関連性の高い引用を生成するように教える。しかし、このアプローチは、注釈付き原文内引用を含む高品質のデータセットを照合する人間に依存している。もう一つの研究は、LLMに直接、属性-生成計画(Slobodkin et al.しかし、このアプローチでは、テキストと引用を自己回帰的に生成するため、不正確な中間生成はその後のプロセスで失敗しやすい。対照的に、我々のアプローチは、複数の経路を考慮するために、漸進的な報酬を伴う自己誘導型ツリー探索を提案する。

LLMと木探索:木探索アルゴリズムとLLMの統合は大きな注目を集めている。最近の研究では、推論中のLLMの性能を向上させるために、木探索手法を用いることが研究されている(Zhang et al., 2024; Wang et al., 2024; Ye and Ng, 2024)。Sutton(2019)は、学習と探索におけるスケーリングの優位性を他の手法よりも強調している。経験的な証拠はさらに、拡張された推論時間の計算が、追加の訓練を必要とせずにLLMの性能を大幅に向上させることを示唆している(Brown et al., 2024; Snell et al., 2024).A探索(Hart et al., 1968)とモンテカルロ木探索(MCTS)(Browne et al., 2012)は、LLMの性能を向上させる計画技法として使用されているは、複雑な推論問題を解く際のLLMの性能を向上させるための計画手法として用いられる。これらの探索アルゴリズムは、強化学習(Silver et al., 2017)やAlphaGo(Silver et al., 2016)のような多くの実世界アプリケーションで広く使われている。我々の研究は、帰属を伴うテキスト生成のタスクを解決するために、木探索アルゴリズム(すなわち、モンテカルロ木探索)を適用した最初のものである。さらに、LLMの反射力に依存して木展開を改善する、自己誘導型MCTSを提案する。

3 問題の定式化

我々の提案するフレームワークは、事前に訓練されたLLM Mθ 出力内容の証拠となるテキスト内引用を伴う回答の生成は、帰属を伴うテキスト生成と呼ばれる(Slobodkin et al, 2024; Gao et al, 2023a)。

形式的には、入力質問xとテキストパッセージのコーパスDが与えられると、モデルMθ 返信を生成する必要がある y = (y 1 , ..., y T )、回答はT個の文からなり、各文yt Dからの段落リストへの参照(Cと表記t = {C t,1 , ..., C t,m }より多くの引用を組み合わせることの限界的な利点(Gao et al.、2023b)により、本稿では、1文につき最大3つの引用を許可し(m≦3)、これらを角括弧で囲む。また、知識集約的なシナリオに焦点を当て、問題には世界知識が含まれ、LLMのほとんどの文が複数の事実を含み、証拠として裏付けとなる引用を必要とする。先行研究(Gao et al., 2023b; Piktus et al., 2021)に従い、コーパスDを100語の段落に分割して検索を行うことで、人間が検証しやすく、無関係な情報が増えすぎないようにしている。

反復的な "think-express-cite "パラダイムを通して、我々は自己誘導型モンテカルロ木探索(SG-MCTS)を提案する。この生成プロセスを強化するために、我々は自己誘導型モンテカルロ木探索(SG-MCTS)を提案する。SG-MCTSは、2つの革新的な技術によって古典的なMCTSを拡張する。これは、主に最終的な結果や完全な軌跡を反映する先行研究とは対照的である。第二に、ルートノードから現在の状態までの木探索の進捗を、生成進捗と帰属進捗の二つの側面から測定する進捗報酬モデル(PRM)を提案する。個々のステップのみを評価するのに比べ、進捗に基づく報酬モデルは、MCTS探索プロセスを導くための信頼性の高い包括的な評価を提供することができる。

我々の知る限り、帰属を伴うテキスト生成のタスクに木探索アルゴリズムを適用したのは我々が初めてである。我々のアプローチの有効性を検証するために、3つのデータセットで広範な実験を行った。その結果、我々のモデルは、以前の手がかりベースや微調整ベースラインを大幅に上回ることが示された。

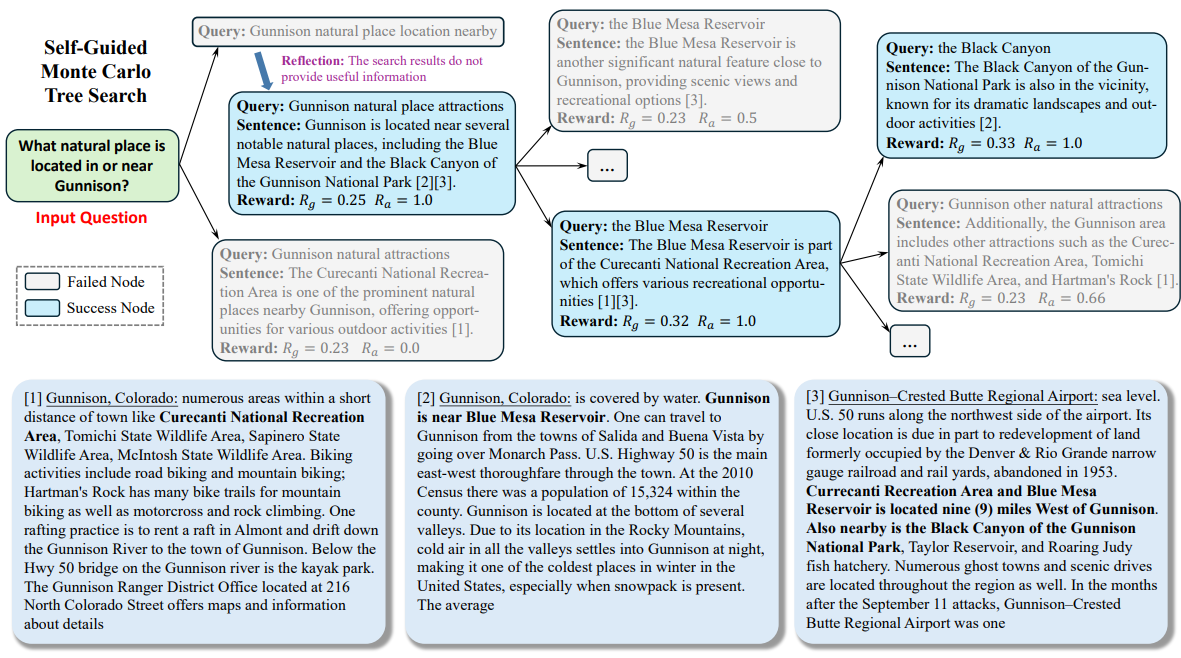

図2:私たちが提案するThink&Citeアプローチの全体的な枠組み。

4 方法論

提案するTHINK&CITEフレームワークは、属性テキスト生成のための言語エージェント上に構築されており、複数の生成パスを計画・探索するために自己誘導モンテカルロ木探索(SG-MCTS)を、探索プロセスに漸近的に細かいシグナルを提供するためにプログレス報酬モデリング(PRM)を用いる。図2は我々のアプローチの全体的なアーキテクチャを示している。

4.1 属性テキスト生成エージェント

先行研究(Yao et al., 2022; Chen et al., 2023)に触発され、帰属を伴うテキスト生成タスクを解決する言語エージェントを開発した。このエージェントは、LLMの推論と計画能力を活用する反復的なthink-verbalise-citeプロセスを実行する。

反復的なThink-Verbalize-Cite。 t番目の文章を生成するために、エージェントはまず、次に生成すべきブループリント(例えば、コンテンツのトピックやアブストラクト)を検索クエリqとして能動的に考える。 t 次に、エージェントは検索ツールを使って、Search操作(すなわち、"Search: {query}")により、与えられたコーパスDから最も関連性の高い上位K個の段落Dを検索する。次に、エージェントは検索ツールを使って、Search操作(すなわち、"Search: {query}")を通して、与えられたコーパスDから最も関連性の高いトップKの段落Dを検索する。 t .検索された文章に基づいて、エージェントは、Generate オペレーション(すなわち、"Generate: {sentence}")によって、Dt 段落リスト Ct 文を表現するために t .履歴クエリ、検索された段落、生成された文、引用(H = {(q i , D i , y i , C i )}^t^ i=1 )は、思考と表現の次のステップのコンテキストとして使われる。エージェントがタスクを解決したと判断した場合、"End "を出力してプロセスを終了することができる。このように、エージェントは、静的な参照コーパスに依存していた以前の研究(Slobodkin et al....、2024)とは異なる。さらに、このパラダイムは、反復検索を強化した生成に関する最近の研究(Jiang et al., 2023; Shao et al., 2023)と類似しているが、我々の研究では、生成されたテキスト内の適切な位置にそれらをマージするために、関連情報を検索し、適切な参照を慎重に選択するために、次の生成のためのコンテンツの青写真を予測するモデルを必要とする点で異なっている。

4.2 自己誘導モンテカルロ木探索

我々は、帰属を伴うテキスト生成を、モデルがテキストの帰属について熟考する多段階推論問題として定式化する。モンテカルロ木探索は、多くの意思決定タスクに有効な探索アルゴリズムとなっている(Silver et al.)本研究では、MCTSの探索プロセスを導くためにLLMの自己反映能力を利用する、自己誘導モンテカルロ木探索(Self-Guided Monte Carlo Tree Search:SG-MCTS)を提案する。これまでの研究(Shinn et al., 2023; Zhou et al., 2024; Yu et al., 2024)では、最終結果や完全な軌跡を反映することが一般的であるが、これは非効率的で疎である。対照的に、我々のアプローチは、MCTSの中間状態を批判し、反映させることで、リアルタイムでツリー拡張を導き、誤った生成経路を積極的に無視することを目的としている。

通常、MCTSは戦略モデルπに基づいている。θ 通常LLM Mである探索木Tを構築する。 θ .このツリーでは、ノード st = [q t , D t , y t , C t はt番目のツリーレベルの状態を表す。 t D. 検索されたパラグラフ t 表現文 yt および引用パラグラフC t .ルートノード s0 = [x] は入力問題を表す。各反復において、SG-MCTSは4つのステップ、すなわち、選択、反射ガイド付き拡張、評価、バックプロパゲーションに従う。

選択段階。 選択フェーズでは、探索木Tt を使用する。木に適用されるUCT(Upper Confidence Constraint)アルゴリズム(Kocsis and Szepesvári, 2006)は、最も高いUCTスコアを持つ最良のノードを選択するために使用される:

UCT t ) = V(s t ) + w √(ln N(p) / N(s)) t )) (1)

ここで、V(s t )は評価段階で推定される。t 価値関数(期待報酬)、N(s t である。t 訪問回数、wはコントロール探索の重み、pはsである。t 親ノードの

反射ガイド付き拡張フェーズ. 拡張フェーズでは,複数の後継ノードs t+1 選択されたノードは、think-verbalize-citeプロセスによって拡張される。 t Thinkステップではまず、検索クエリq̂としてブループリントを生成する。 t+1 次の文の主語と内容が抽出され、それが段落を検索するのに使われる D_Mn_302 t+1 .しかし、ストラテジーモデルは、例えば、非特異的なクエリーや無関係なクエリーを生成することにより、その後の証拠検索を妨げ、最終的に誤った文の生成につながるなど、拡張フェーズで誤りを犯す可能性がある。そこで、我々は リフレクション ステップで、戦略モデルは質問xと検索されたパッセージD̂に基づいている。t+1 リフレクティブ・エクワイアリーq_302t+1 エラーを特定する:

u = M θ (q̂ t+1 , D̂ t+1 , x), (2)

ここで、リフレクションテキストuは、検索の特定の側面に関する提案を含んでいる。リフレクションに基づいて、戦略モデルは新しいクエリqt+1 該当する段落Dを検索する t+1 ::

q t+1 , Dt+1 = M θ (u, q_302↩) t+1 , D̂ t+1 , H), (3)

ここでHは履歴トレースである。上記のプロセスは、検索された証拠が支持的であるとモデルが判断するか、反復の最大回数に達するまで反復できることに留意されたい。最後に、VerbalizeステップとCiteステップがDt+1 次の文を生成する。 t+1 そして正確な引用C t+1 ::

y t+1 , Ct+1 = M θ (q t+1 , D t+1 , H). (4)

新しいノードは、クエリ、検索されたコーパス、生成された文、引用された段落から構成され、以下のように示される。t+1 = [q t+1 , D t+1 , y t+1 , C t+1 ]典型的なMCTSにおける単純な展開と比較して、我々のアプローチは欠陥のある展開ノードを改善し、低品質な生成を回避する。MCTSの木はインクリメンタルに構築されるため、次の操作の品質を向上させることで、モデルは広い探索空間にわたってより好ましい経路をナビゲートすることができ、その結果、木の全体的な探索品質が向上する。

評価フェーズ。 評価フェーズでは、進捗報酬モデル(セクション4.3参照)を使用して、新しい拡張ノードst+1 R(s)の期待報酬 t+1 ).進歩の評価には、生成と帰属という2つの側面がある。進捗インセンティブRの生成g これまでに生成されたセンテンスの測定 y 1 , ..., yt+1 テキストの質権利確定 進捗状況 報酬Ra 生成された文の評価 y 1 , ..., yt+1 および引用パラグラフC 1 , ..., Ct+1 両者間の帰属的整合性。最後に、総報酬は2つの合計として計算される:R(s t+1 ) = R g + R a .

バックプロパゲーション・フェーズ。 バックプロパゲーションの段階では、新しいノードst+1 R(s)の報酬 t+1 )は親ノードsに伝搬される。 t ルート・ノードからその親ノードまでのパス上の各ノードを更新する。 0 , s 1 , ..., st の価値関数である。

N 新しい (s i ) = N オールド (s i ) + 1, 0 ≤ i ≤ t (5)

V 新しい (s i ) = (V オールド (s i )N オールド (s i ) + R(s t+1 )) / N 新しい (s i ) (6)

ここで オールド (s i とV オールド (s i )はノードsi 先にアクセスしたカウント関数とバリュー関数の

4.3 進歩報酬モデル

これまでの結果報酬モデル(Cobbe et al., 2021; Hosseini et al., 2024)やプロセス報酬モデル(Lightman et al., 2024; Dai et al., 2024)は、最終結果や中間ステップの評価に焦点を当ててきた。本研究では、次のステップに進んだ後、ルートsから測定木を探索することを提案する。0 を状態 st+1 進歩アトリビューション付きテキストには、テキストコンテンツとその引用が含まれるため、生成されたテキストコンテンツの品質と引用の関連性をそれぞれ評価するために、生成プログレス報酬とアトリビューションプログレス報酬という2つの側面のプログレス報酬を設計した。

4.3.1 進捗インセンティブを生み出す

直接選好最適化(DPO)(Rafailovら、2023)では、マーカーレベルの対数比は次のように解釈できる。

最大エントロピー強化学習(RL)定式化の下では、暗黙的なマーカーレベルの報酬が得られる。そこで、既存のDPOアライメントモデルを利用し、次の文の生成yt+1 生成後の文章1:t+1 = y 1 , ..., yt+1 Rの品質スコア g .

具体的には、文レベルのマルコフ決定過程(MDP)を定義する。t = (x, y 1 , ..., y t )はこれまでに生成された入力と文を表し、初期状態s0 = xは入力問題である。アクションat = yt+1 は次に生成される文を表す。したがって、RLHFの最適化目的は、文レベルでの最大エントロピーRL問題として書き直すことができる:

E でπθ(-|st)~ [∑^T^t=1 r'(s t , a t )] + βE s0x~ [H(π θ (-|s 0 ))],

ここで、文レベルの報酬関数r'は次のように計算できる:

r'(s t , a t ) = { βlog π レフ (a t |s t ) の場合t+1 これで終わりではない

{ r'(y|x) + βlog π レフ (a t |s t もし t+1 もう限界だ。

最大エントロピーRL式は、最適値関数VとQ関数Qを次のように導く:

Q(s t , a t ) = r'(s t , a t ) + V(s t+1 ),

V(s t ) = log ∑.a exp(Q(s t a)), t ≤ T のとき。

したがって、最適政策πは次のように導かれる:

⇒ βlog π(a t |s t ) = Q(s t , a t ) - V(s t ),

⇒ βlog (π(a t |s t ) / π レフ (a t |s t )) = V(s t+1 ) - V(s t ).

このことが、DPO戦略を用いて報酬の部分和を導き出し、部分的な回答yを定式化する動機となった。1:t+1 プログレス・インセンティブR g ::

∑^t^k=0 βlog (π(a k |s k ) / π レフ (a k |s k )) = V(s t+1 ) - V(s 0 ),

⇒ R g (y 1:t+1 ) = ∑^t^k=0 wk log (π(y k+1 |x, y 1:k ) / π レフ (y k+1 |x, y 1:k )),

ここで1:k は y 1 , ..., y k wk = 1 / (t+1) は各文レベルの対数尤度比の重みである。

4.3.2 属性進歩報酬

我々は、以前の研究(Gao et al, 2023b)で使用された2つの引用メトリクス、引用リコールと精度を使用して、帰属の進捗報酬Rを表す。 a .

具体的には、引用想起は部分的な反応yを測定する。1:t+1 対応する引用パッセージによってサポートされる可能性のあるセンテンスのNLIモデル(Honovich et al., 2022)を用いて、引用された文章がモデル回答を導き出せるかどうかをチェックした。各文yi (1≦i≦t+1)である。i の引用箇所は、前提文と生成文yとして結合される。i を NLI モデルの仮定とする。引用の精度は、対応する文をサポートする引用のパーセンテージを評価する。精度を計算するために、上記と同じ NLI モデルを使用する。各引用 c i,j (1) Ci y のすべての引用は、生成された文 y を含む。i そして (2) Ci \ {c i,j という文がない。 i 各引用について精度スコア(0 か 1)を計算し、全引用について平均する。最後に、F1 スコアを、帰属する進歩報酬 R a (y 1:t+1 , C 1 , ..., C t+1 )を使用して、生成された文章と引用された文章との間でバランスのとれた帰属品質メトリックを提供する。

5 実験

5.1 実験セットアップ

データセット。 評価にはALCEベンチマークテスト(Gao et al., 2023b)を使用し、以下の3つのデータセットから構成される:(1) ASQA (Stelmakh et al., 2022)、(2) QAMPARI (Amouyal et al., 2022)、(3) ELI5 (Fan et al., 2019)。2022)、(3)How/Why/Whatの質問を含む長文QAデータセットであるELI5(Fan et al.ASQAとQAMPARIについては、ほとんどの質問がウィキペディア経由で回答できるため、2018/12/20のウィキペディアのスナップショットをコーパスとして使用する。ELI5では、質問がテーマ的に多様であるため、Sphere (Piktus et al., 2021) (Common Crawlのフィルタリング版)をコーパスとして使用します。Gao et al. (2023b)に従い、WikipediaとSphereにはGTR (Ni et al., 2022)を使用する。 BM25 (Robertson et al., 2009)を使用して、各問題のコーパスとして最初の100パッセージを検索した。詳細は付録Aを参照のこと。

評価指標。 オリジナルのALCEベンチマークテストの評価指標を使用する。出力の正しさを評価するために、ASQAのExact Match (EM)Recall、QAMPARIのRecall-5、ELI5のStatement Recallを使用し、出力中のゴールデン・アンサー(重要な情報)の割合を測定します。さらに、QAMPARIデータセットの正しさの指標としてPrecisionを計算し、生成された回答における正答率を測定する。出力の引用の質を評価するために、出力中の文章が引用された文章から推測できる割合を測定するCitation Recallと、出力文章をサポートするのに役立つ引用の割合を測定するCitation Precisionを計算します。

ベースライン 私たちは、私たちのアプローチを チャットGPT とGPT-40を以下のベースラインと比較した:

バニラ ラグ モデルには、与えられた最初の5段落に基づいて回答を生成し、それに従って引用するよう直接指示した。私たちは、2つのプレゼンテーション(Brown et al.)

要約/スニペット RAG は、全文ではなく、段落の要約またはスニペットを提供します。このモデルは、最初の 10 段落の要約または抜粋に基づいて、引用を含む回答を生成します。

Interactは、モデルがSummary/Snippet RAGメソッドで特定の段落の全文にさらにアクセスすることを可能にします。モデルは、対応する文書の全文を取得するために、"Check: Document [1] [2]"というアクションを提示することができます。

インライン検索では、上位100件から最も関連性の高いパラグラフを取得するために、モデルがアクション「Search: {query}」をリクエストすることができます。このメソッドは直接比較として機能するという点で、私たちのメソッドと似ています。

ReRankは、各質問に対してランダムに4つの回答を抽選し、引用想起指標に基づいて最良の回答を選択します。

上記のベースラインは、(Gao et al., 2023b)で報告されているように、オリジナルのALCEベンチマークテストに適用され、評価されている。FG-Reward(Huangら、2024)は、帰属応答を生成するためにLLaMA-2-7B(Touvronら、2023)を微調整する訓練信号として、きめ細かい報酬の使用を提案している。VTG(Sunら、2024)は、帰属応答を生成するために、変化する記憶と2層のバリデータを使用している。APO(Liら、2024)は、嗜好ペアデータセットを照合し、嗜好最適化をLLaMA-2-13Bに適用して、帰属を伴うテキスト生成を行った。

実装の詳細 本アプローチの性能を評価するために、戦略モデルとしてLLaMA-3.1-8B-InstructとGPT-40を使用する。報酬モデルには、生成的進歩報酬を計算するためにDPOモデルLlama-3-8B-SFR-Iterative-DPO-R¹を使用し、属性的進歩報酬を計算するためにNLIモデルT5-XXL-TRUE-NLI-Mixture (Honovich et al., 2022)を使用する。各検索クエリに対して、コーパスから上位3つの文章を参照候補D t .SG-MCTSでは、各親ノードに対して3つの子ノードを拡張し、最大ツリーレベルを6に設定し、MCTSの最大反復回数を30に設定する。

5.2 主な結果

表1は、3つのデータセットにおける我々の手法とベースラインの結果を示している。

まず、3つのRAG(Retrieval Augmented Generation)メソッドは、要約やスニペットを使用することで正しさを向上させることができるものの、中程度のパフォーマンスを示すことが観察される。ReRankは、3つのデータセットで一貫して引用の質を改善する(例えば、バニラRAGは、ASQAで73.6%から84.8%に引用のリコールを改善する)。直接比較すると、Inline Searchは我々のアプローチと似ているが、他のキューベースラインと比較するとパフォーマンスが悪い。これは、エビデンスの質と関連性を考慮することなく、単に検索クエリを要求するためである。

第二に、LLMを注釈付き引用の教師付き訓練データで微調整することにより、FG-RewardとAPOはASQAとELI5データセットで引用品質の向上を示すが、QAMPARIでは性能の向上は見られない。さらに、VTGは、証拠の論理的裏付けを評価するために、生成的バリデータとインメモリバリデータを採用しており、強力な引用品質を実現している(例えば、ASQAでは引用想起86.71 TP3T)。しかし、ファインチューニングされたLLMは、教師付きトレーニングデータの質と量によって制限され、証拠をサポートするには、正しいソースにリンクするために多大なコストが必要となります。さらに、これらの方法は依然として自己回帰生成に依存しており、これは高速ではあるが、正確性に欠ける思考様式である。その結果、中間的な生成エラー(誤った表現や不十分な引用など)があれば、最終的な回答に問題が生じることになる。

| エーエスキューエー | カンパリ | エリ5 | |

|---|---|---|---|

| 正しさ | 引用 | 正しさ | 引用 |

| EM Rec. | レク。 | プリキュア。 | リコール-5 |

| チャットGPT | |||

| バニラRAG | 40.4 | 73.6 | 72.5 |

| w/ ReRank | 40.2 | 84.8 | 81.6 |

| 概要 RAG | 43.3 | 68.9 | 61.8 |

| w/インターアクト | 39.1 | 73.4 | 66.5 |

| スニペットRAG | 41.4 | 65.3 | 57.4 |

| w/インターアクト | 41.2 | 64.5 | 57.7 |

| インライン検索 | 32.4 | 58.3 | 58.2 |

| GPT-40 | |||

| バニラRAG | 41.3 | 68.5 | 75.6 |

| w/ ReRank | 42.1 | 83.4 | 82.3 |

| 概要 RAG | 46.5 | 70.2 | 67.2 |

| w/インターアクト | 48.1 | 73.1 | 72.8 |

| スニペットRAG | 45.1 | 68.9 | 66.5 |

| w/インターアクト | 45.2 | 67.8 | 66.7 |

| インライン検索 | 40.3 | 65.7 | 66.9 |

| FGリワード | 40.1 | 77.8 | 76.3 |

| VTG | 41.5 | 86.7 | 80.0 |

| エーピーオー | 40.5 | 72.8 | 69.6 |

| 我々の(LLaMA) | 45.2 | 82.3 | 80.6 |

| 我々の(GPT-40) | 50.1 | 89.5 | 87.1 |

表1:3つのデータセットにおける属性文生成の評価結果。「Rec. "と "Prec. "はリコールとプレシジョンの略である。太字と下線は、それぞれ各データセットで最も良い結果と2番目に良い結果を示す。

Think&Citeは、属性テキスト生成タスクを多段階推論問題として定式化し、最良の解を探索するために、じっくりと内省するモードを導入している。自己誘導型MCTSアルゴリズムを提案することで、Think&CiteはLLMの自己反省能力を利用し、木展開プロセスを誘導する。さらに、提案する進捗報酬モデルは、モデルがより良い生成応答を探索するのに役立つ、包括的で信頼できるフィードバックを提供することができる。

5.3 さらなる分析

他のデータセットでも同様の結果が得られたので、GPT-40を用いたASQAにおける本手法のさらなる分析を報告する。

アブレーションの研究。 提案したフレームワークの有効性を検証するために、アブレーションにおける主要な設計要素を分析した。(1)w/oSG-MCTSは自己ガイドMCTSを除去し、直接ステップバイステップで答えを生成する。(2)w/o Reflectionはリフレクションステップを除去し、バニラMCTSアルゴリズムを採用する。 g (4)AP報酬なし 権利確定プログレス報酬を削除 R a その結果を表2に示す。結果を表2に示す。すべてのバリエーションはオリジナルの方法よりも性能が悪く、各コンポーネントの有効性を示している。特に、w/o SG-MCTSの性能は著しく悪く、これは検索アルゴリズムを帰属を伴うテキスト生成に統合することが非常に有益であることを示唆している。バニラMCTS(w/o Reflection)の使用は、検索結果に反映させることなく偽参照を導入するため、引用の質を悪化させる。同様に、GP Rewardを使用しない場合とAP Rewardを使用しない場合の両方がパフォーマンスを低下させ、生成と引用品質のチェックの両方が不可欠であることを示唆している。

| 方法 | 正しさ | 引用 |

|---|---|---|

| EM Rec. | レク。 | プリキュア。 |

| Think&Cite | 50.1 | 89.5 |

| w/oSG-MCTS | 42.1 | 78.2 |

| 反射なし | 46.5 | 83.6 |

| w/oGPRewardの場合 | 47.1 | 86.2 |

| w/oAPReward | 46.7 | 81.3 |

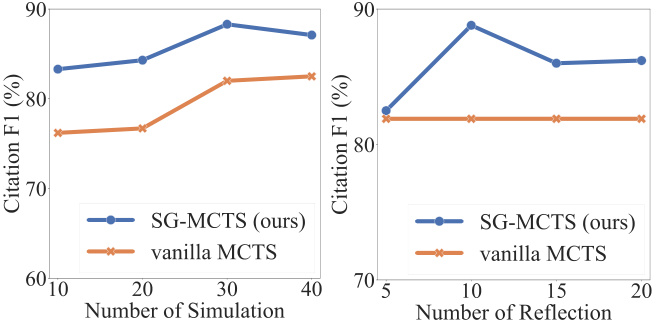

自己反省とシミュレーション。 各シミュレーションにおいて、SG-MCTSは4つの重要なステップに従い、エラークエリを批判・改善することで、拡張の中間状態の品質を向上させる自己反省を採用している。リフレクションの有効性を確認するため、シミュレーションの最大回数を増やす場合と、リフレクション操作の最大回数を増やす場合の性能を比較した。まず、最大シミュレーション回数を{10, 20, 30, 40}に変更し、最大反射回数を10回に固定した。 同様に、最大反射回数を{5, 10, 15, 20}に変更し、最大シミュレーション回数を30回に固定した。 図3に、引用リコールと精度に基づくF1スコアを示す。この図から、シミュレーションの回数と反射の回数の両方を増やすと、帰属を伴うテキスト生成の性能が向上することがわかる。これは、より広範な探索によって正しい生成が見つかる確率が向上するため、予想されることである。SG-MCTSがリフレクションなしのバニラMCTSを上回るのは、親ノードで誤った検索が行われ、拡張された子ノードでの推論プロセスが誤った経路をたどる可能性があるためである。リフレクションステップは、不十分なクエリによる不正確な検索を改善するため、その後の探索をより正確に進めることができる。

図3:シミュレーション回数(左側)または反射ステップ数(右側)に関するASQAの結果。

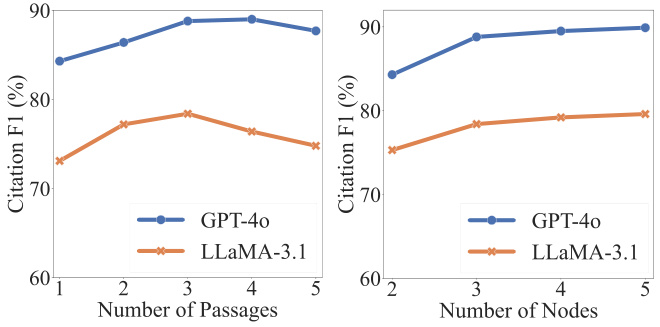

ハイパーパラメータの分析。 2つのハイパーパラメータが、正しさと引用の質にとって重要である。t 検索された段落数|D t | ツリー検索における子ノードと拡張子ノードt+1 検索された段落数。図 4 に示すように、検索される段落の数を増やすことで、引用の質は最初は改善される。しかし、ある閾値を超えてさらに増やすと、パフォーマンスが悪化する。これは主に、より多くの段落をマージすると、生成されたコンテンツの信頼性に悪影響を及ぼすノイズが導入されるためである。一方、拡張ノードの数を増やすと、一貫した改善が見られるが、改善はその後安定する。より多くのノードを展開すると計算コストが高くなるため、各親ノードに対して3つの子を抽出する。

図4:段落数(左側)または拡張ノード数(右側)に関するASQAの結果。

5.4 ケーススタディ

本手法のワークフロー全体の理解を容易にするため、ASQAで定性分析を行った。付録Cにその例を示す。検索プロセスを通して、LLMは入力問題をルートノードとして扱い、徐々に検索ツリーを拡張して終了状態に到達する。示されるように、このモデルはまずクエリ(すなわち、「ガニソン近郊の自然名所の位置」)を生成し、パッセージを検索する。その段落には質問に答えるために必要な有効な情報が含まれていないため、モデルは新しいクエリ(すなわち、"Gunnison natural attraction sites")を検索するために反映し、提案する。検索された段落に基づいて、モデルは文章を生成し、2番目と3番目の段落を参照する(つまり、「[2][3]」)。多段階の生成プロセスに従うことで、モデルはトピックについて深く考え、正確な引用を伴う信頼性の高いコンテンツを出力することができる。

6 結論

Think&Citeは、反復的なthink-express-cite生成のパラダイムに基づいている。Think&Citeは、反復的なthink-express-cite生成パラダイムを基盤としている。生成プロセスを強化するために、我々は自己誘導型モンテカルロ木探索を提案する。これは、木展開を誘導するために、MCTSの中間状態を批判し修正するLLMの自己反映能力を利用する。さらに、木探索の進捗を測定し、信頼性の高いフィードバックを提供するために、進捗報酬モデルを提案する。3つのデータセットを用いた広範な実験により、我々の提案するThink&Citeが、従来のヒンティングやファインチューニングの手法を凌駕することを示す。

制限

我々の実験の範囲は、ツリーベースの検索手法の多大な計算コストによって制限されている。将来的には、より広範な属性テキスト生成データセットを探索することができるだろう。我々のモデルでは、モンテカルロ木探索を自己誘導型生成に用いている。将来的には、我々の提案するフレームワークの一般性と頑健性を評価するために、さらなる探索アルゴリズムを探求することも可能である。

付記

データセット

我々は3つのデータセットからなるALCEベンチマークで我々のアプローチを評価する。具体的には、ASQAデータセット(Stelmakh et al., 2022)は、ウィキペディアから見つけることができる答えを持つ948の質問を含み、QAMPARIデータセット(Amouyal et al., 2022)は、ウィキペディアに基づく1,000の質問を含み、ELI5データセット(Fan et al., 2019)は、1,000の質問を含み、答えはスフィア(Piktus et al., 2021)から見つけることができる。質問とその回答はSphere (Piktus et al., 2021)で見つけることができる。これら3つのデータセットの詳細を表3に示す。

| データセット | コーパス(#パッセージ) | 問題の種類 |

|---|---|---|

| エーエスキューエー | ウィキペディア(2100万) | 事実 |

| カンパリ | ウィキペディア(2100万) | 事実(集計) |

| エリ5 | スフィア(8億9900万ドル) | なぜ/どのように/何を |

B ヒント

ASQA、QAMPARI、ELI5データセットの文脈学習キューをそれぞれ表4、表5、表6に示す。これらのキューでは、まずLLMに対して、反復的思考-表現-参照のパラダイムにおける4つの操作を定義した。次に、ALCEベンチマーク(Gao et al.)

C ケーススタディ

図5にASQAの例を示す。

あなたの目標は、与えられた質問に対して、提供された検索結果のみを使って、正確で、興味深く、簡潔な答えを書くことであり、それらを正しく引用することです。公正でジャーナリスティックな口調で書くこと。事実には必ず引用を明記すること。4つのアクションを使用することができます:

- """検索:キーワード"""は、いくつかのキーワードを要求し、検索と生成履歴に基づいて最も関連性の高い文書を検索する。

- """Reflect: "ideas"""と検索結果を振り返り、質問の答えとなる有効な文書が得られなかった場合。

- """出力: 文"""検索された文書を元に長い解答を出力する。回答では、[1][2][3]を用いて正しく引用されている。1文につき、最低1文書、最大3文書を引用する。複数の文書がその文をサポートしている場合、最も十分でない文書のサブセットのみが引用される。

- """End"""、クイズタスクを終了します。

いくつか例を挙げよう:

質問 : 最長飛距離記録を樹立したのは?

検索 : 最長飛距離記録

ドキュメント[1](キャプション:デービッド・エイカーズ)は、63ヤードのフィールドゴールをクロスバーの上に蹴り、最長フィールドゴール記録を樹立した。

ドキュメント[2] (肩書き:ディルク・ボルゴニョーネ) ディルク・ボルゴニョーネ、ディルク・ロナルド・ボルゴニョーネ(1968年1月9日生まれ)は、元日本代表...

ドキュメント[3](タイトル:ラッセル・エルクセーベン)コロラド大学戦。試合序盤のトラブルにもかかわらず...。

反省 : 検索結果は質問に答えるための有効な情報を提供しなかった。NFLの最長フィールドゴール記録を検索した方がよい。

検索 : NFL最長フィールドゴール記録

資料[4] (タイトル:フィールドゴール)自陣のエンドゾーンに向かって。NFL史上最長のフィールドゴール記録は64ヤード。

資料[5](タイトル:フィールドゴールの射程)両端のエンドゾーン)は66ヤードしかなかった。室内フットボールでプレーしていたスカッチャは、64ヤードのゴールを試みたが...。

Document[6] (Title: Range of Shots) この実績は公式記録ではありません。上記のショットは全て成功した...

出力 : NFLの試合におけるフィールドゴールの最長記録はマット・プラターが記録した64ヤード[4]。

検索 : 大学競技における最長不倒距離記録

資料[7] (タイトル:フィールドゴール)自陣のエンドゾーンに向かって。NFL史上最長のフィールドゴール記録は64ヤード。

ドキュメント[8] (タイトル:射程距離)35ヤードから40ヤードライン(横風の場合はより近く)では、通常、よりリスクの高いショットを試みる。

資料[9](タイトル:フィールドゴールの射程距離)NFL、1989年以来NCAAによって禁止されている)は68ヤードで、ファブリツィオ・スカッチャが保持している...

出力 : しかし、あらゆるレベルの競技におけるフィールドゴールの最長記録は、1976年のアビリーン・クリスチャン大学対イースト・テキサス州立大学のフットボールの試合で、大学のキッカー、オーヴェ・ヨハンソンが蹴った69ヤードである[8]。終わり。

あなたの目標は、与えられた質問に対して、提供された検索結果のみを使って、正確で、興味深く、簡潔な答えを書くことであり、それらを正しく引用することです。公正でジャーナリスティックな口調で書くこと。事実には必ず引用を明記すること。4つのアクションを使用することができます:

- """検索:キーワード"""は、いくつかのキーワードを要求し、検索と生成履歴に基づいて最も関連性の高い文書を検索する。

- """Reflect: "ideas"""と検索結果を振り返り、質問の答えとなる有効な文書が得られなかった場合。

- """出力: 文"""検索された文書を元に長い解答を出力する。回答では、[1][2][3]を用いて正しく引用されている。1文につき、最低1文書、最大3文書を引用する。複数の文書がその文をサポートしている場合、最も十分でない文書のサブセットのみが引用される。

- """End"""、クイズタスクを終了します。

いくつか例を挙げよう:

質問 : ネヴィル・シュートの著書は?

検索 : ネヴィル・シュート テーマ 社会障害

ドキュメント[1] (タイトル:ネヴィル・シュート)序盤。おめでとう。彼の作家としての名声により、情報省は彼を...

資料[2] (タイトル:ネヴィル・シュート) 階級(『孤独な道』、『上陸』)、人種......といった社会の壁を越えることがテーマ。

ドキュメント[3] (肩書き:ネヴィル・シュート) 航空機建設会社、エアスピード社。彼の小説は人気を博したが、より有名になったのは...。

作品:ビヨンド・ザ・ブラック・スタンプ[2]、ロンリー・ロード[2]、チェスボード[2]、イン・ザ・ダンプ[2]、ツールルーム・トラスティ[2]、アラウンド・ザ・ベンド[2]

検索 : ネヴィル・シュート シンプルで読みやすいスタイル

文献[4] (ネヴィル・シュート) 航空機建設会社エアスピード社。彼の小説は人気を博したが、より有名になったのは...。

Document[5](市松模様の)ビルマの人々」、どちらもこの本のストーリーの中心をなすものである。シュットはこの本の売れ行きを心配している。

ドキュメンテーション[6] (濡れ衣)彼は短編小説『ゴンドールの不思議な共和国』の中で、投票というアイデアを何度か使っている...。

反省 : 検索結果は質問に答えるための有益な情報を提供しなかった。1950年代のNevil Shuteの本を検索した方がよい。

検索 : ネヴィル・シュートの1950年代の本

ドキュメント[7] (ネヴィル・シュート)初期段階。おめでとう。作家としての彼の名声は、情報省が彼を...

資料[8](ネヴィル・シュート) 階級(『孤独な道』『上陸』)、人種(『チェス盤』)......といった社会の壁を越えることがテーマ。

文献[9] (ネヴィル・シュート) 航空機建設会社エアスピード社。彼の小説は人気を博したが、より有名になったのは...。

出力:マラザン[7]、スティーブン・モリス[7]。

閉じる

あなたの目標は、与えられた質問に対して、提供された検索結果のみを使って、正確で、興味深く、簡潔な答えを書くことであり、それらを正しく引用することです。公正でジャーナリスティックな口調で書くこと。事実には必ず引用を明記すること。4つのアクションを使用することができます:

- """検索:キーワード"""は、いくつかのキーワードを要求し、検索と生成履歴に基づいて最も関連性の高い文書を検索する。

- """Reflect: "ideas"""と検索結果を振り返り、質問の答えとなる有効な文書が得られなかった場合。

- """出力: 文"""検索された文書を元に長い解答を出力する。回答では、[1][2][3]を用いて正しく引用されている。1文につき、最低1文書、最大3文書を引用する。複数の文書がその文をサポートしている場合、最も十分でない文書のサブセットのみが引用される。

- """End"""、クイズタスクを終了します。

いくつか例を挙げよう:

質問 : 双極性障害の原因は何ですか?

検索 : 双極性障害とは?

資料[1](タイトル:双極性障害II型) 個人の知覚と行動の境界を設定する研究。研究は以下のことを示唆している...

資料[2](タイトル:双極性障害の生物学)双極性障害のメカニズムとして、これらの領域に位置する脳領域が仮説されている...。

資料[3](タイトル:双極性障害の生物学)極性に関係なく。双極性障害では炎症が報告されている。

反省 : 検索結果は質問に答えるための有効な情報を提供しなかった。双極性障害の症状で検索した方がよい。

検索 : 双極性障害の症状は?いつまで続く?

資料[4] (タイトル:双極性障害|医学用語辞典での定義) 双極性障害|双極性障害の定義...

資料[5](タイトル:躁病と双極性障害)は、1日のうちに、あるいは数日のうちに、憂うつな状態から「とても幸せ」な状態まで変化することがある。

資料[6] (タイトル:For Individuals - Adam Schwartz) For Individuals 2014 Adam Schwartz 情報は広範囲に及び、カバーされている。

アウトプット : 双極性障害は、多幸感から抑うつ状態まで、極端な気分の変動を引き起こす気分障害である [4] 。気分の変動は数日から数ヶ月に及ぶこともある [5] 。

検索 : 双極性障害の原因は?

資料[7](タイトル:双極性障害) 双極性障害は通常、うつ状態を示す周期性障害である。

資料[8] (タイトル:うつ病 双極性障害の症状2019|うつ病に勝つ) うつ病 双極性障害の症状2019.

文書[9](タイトル:精神障害)には、親の拒絶、親の暖かさの欠如など、親の要因が含まれることがある。

出力:この病気の正確な要因はまだわかっていないが、遺伝が大きな要因であると考えられている[7]。

閉じる

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません