TANGO:全身デジタル人物の協調ジェスチャーポートレート映像を音声で生成するツール

はじめに

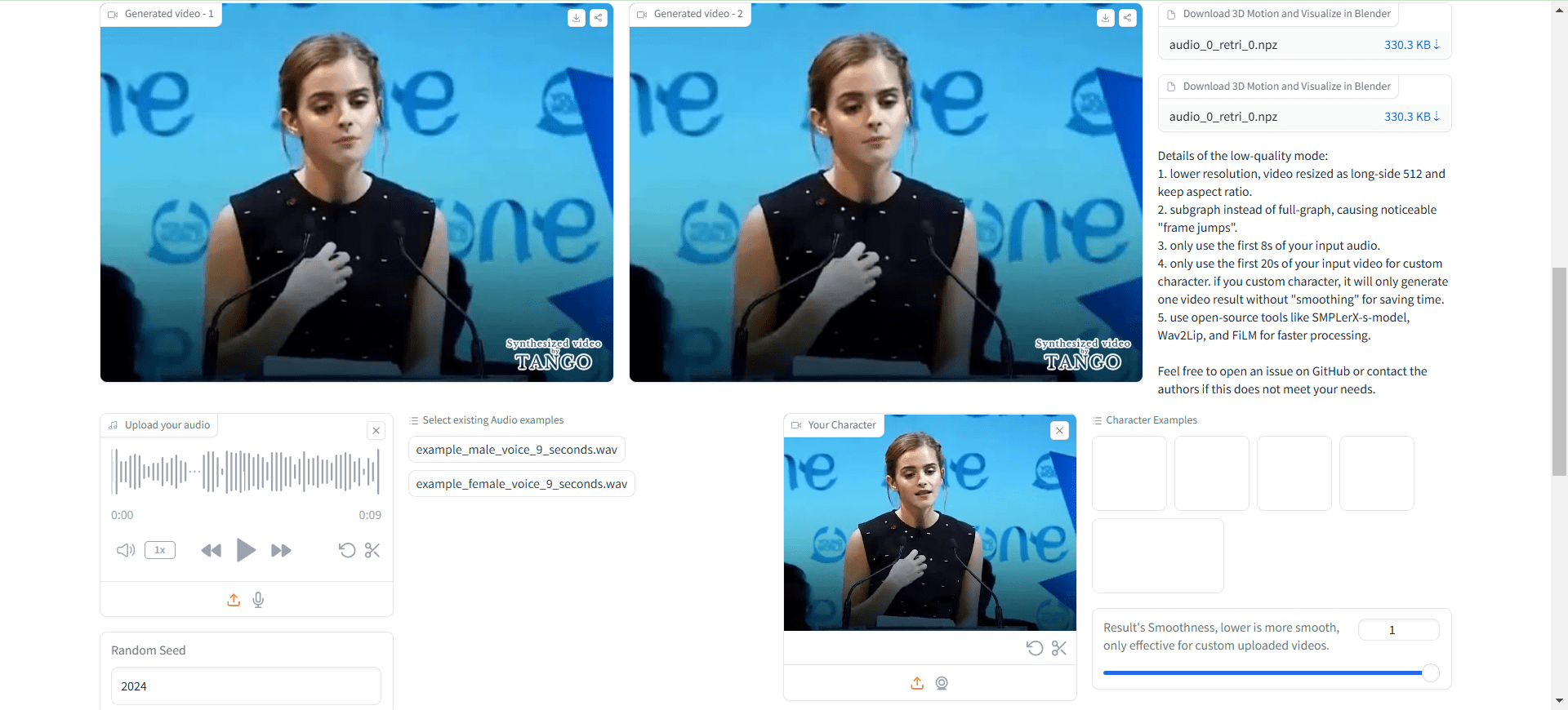

TANGO (Co-Speech Gesture Video Reenactment with Hierarchical Audio-Motion Embedding and Diffusion Interpolation) は、東京大学とサイバーエージェントAI研究所が共同開発したオープンソースです。の共同開発フレームワークです。このプロジェクトでは、階層的な音声モーション埋め込み空間と拡散補間を用いて、入力音声に基づき、自然で滑らかで同期した文字ジェスチャー動画を自動生成します。TANGOでは、まず、暗黙的に階層化された音声モーション埋め込み空間において、対象音声に最も近い参照動画クリップを検索し、次に拡散モデルを用いてアクション補間を行うという革新的なアクショングラフ検索手法により、高品質なジェスチャー・アクション生成を実現しています。アクション生成このプロジェクトは、AIによる人間とコンピュータのインタラクション研究を前進させるだけでなく、バーチャル・アンカーやデジタル・ヒューマンなどのアプリケーションに重要な技術的支援を提供する。

現在のオープンソースのTANGOは8秒までのオーディオしかサポートしていないので、使用する前にオーディオファイルのセグメンテーションを行う必要がある!

ボイス・リップ・シンク・ツールを使って、完全なデジタル・パーソン・プロジェクトに取り組みましょう、Wav2Lip ウルトラライトデジタルヒューマン。完全なワークフローは、Ultralight Digital Humanが対位法、TANGOが体の動きを生成、FaceFusionが顔を変更、完璧!

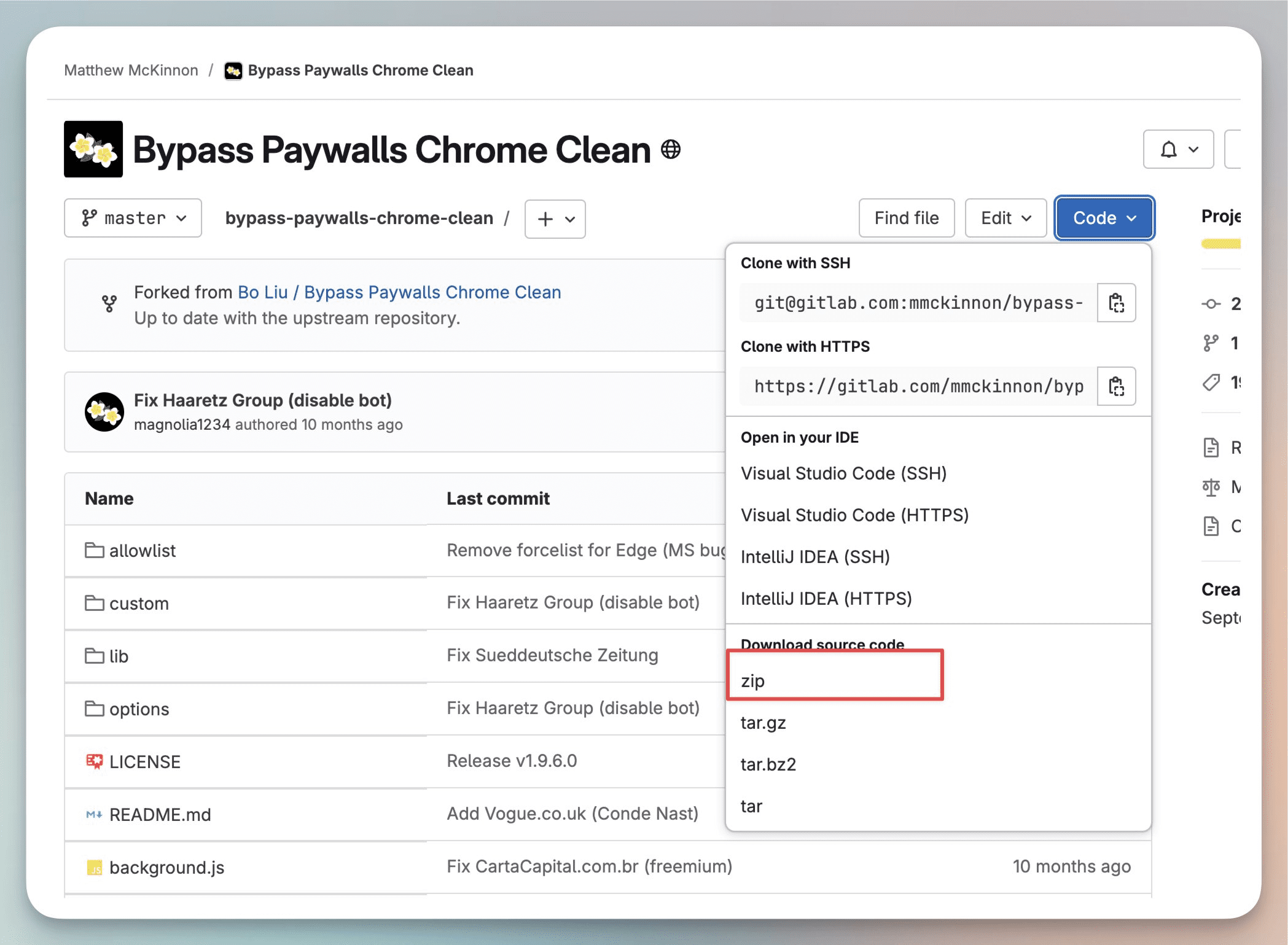

オンライン経験:https://huggingface.co/spaces/H-Liu1997/TANGO

機能一覧

- 高精度のジェスチャー同期:ビデオのジェスチャーと音声を正確に同期させます。

- 多言語サポート:CGIの顔や合成音など、さまざまな言語やサウンドに対応。

- オープンソースで無料:コードは完全に公開されており、ユーザーは自由に使用、変更することができる。

- インタラクティブ・デモ:ユーザーがビデオやオーディオファイルをアップロードして体験できるオンライン・デモを提供します。

- 事前学習モデル:様々な事前学習モデルを提供し、ユーザーが直接使用したり、二次学習することができます。

- 完全なトレーニングコード:ジェスチャー同期識別器とTANGOモデルのトレーニングコードを含む。

ヘルプの使用

1.環境構成

1.1 基本要件

- Pythonバージョン:3.9.20

- CUDAバージョン:11.8

- ディスク容量:35GB以上(モデルや計算済みのダイアグラムを保存するため)

1.2 インストールの手順

# 克隆项目仓库

git clone https://github.com/CyberAgentAILab/TANGO.git

cd TANGO

git clone https://github.com/justinjohn0306/Wav2Lip.git

git clone https://github.com/dajes/frame-interpolation-pytorch.git

# 创建虚拟环境(可选)

conda create -n tango python==3.9.20

conda activate tango

# 安装依赖

pip install -r ./pre-requirements.txt

pip install -r ./requirements.txt

2.ご利用の流れ

2.1 クイックスタート

- 推論スクリプトを実行する:

python app.py

初回実行時には、必要なチェックポイントファイルと事前に計算されたダイアグラムが自動的にダウンロードされる。約8秒の映像の生成にかかる処理時間は約3分。

2.2 カスタムロールの作成

- 新しいキャラクターのアクションフィギュアを作る必要がある場合:

python create_graph.py

特に、このプロジェクトでは、デフォルトで以下のようなTANGOウォーターマーク付きの動画を生成します:

基本的には、ローカルのffmpegを呼び出して、オリジナルのビデオと透かし入り画像を新しいビデオに合成する。

透かしを入れたくない場合は、以下のように変更できます。app.py真ん中だ:

gr.Video(value="./datasets/cached_audio/demo1.mp4", label="Demo 0", , watermark="./datasets/watermark.png") # 修改为 gr.Video(value="./datasets/cached_audio/demo1.mp4", label="Demo 0")

ローカルホスト以外からのアクセス、要修正:

demo.launch(server_name="0.0.0.0", server_port=7860)

もう一度開くと、読み込まれたビデオに透かしはない。

出来上がったビデオには音声がないので、手動で音声を合成する必要がある。

/usr/bin/ffmpeg -i outputs/gradio/test_0/xxx.mp4 -i gen_audio.wav -c:v libx264 -c:a aac result_wav.mp4

体の動きには何の問題もないが、口の形が完全に間違っている。

これは違う。 超軽量デジタルヒューマン それが役に立った?

使用プロセス

- ローカルサーバーへのアクセス:ブラウザで開く

http://localhost:3000. - ビデオとオーディオのアップロード:入力ボックスに同期したいオーディオとビデオファイルをアップロードします。

- ジェスチャー同期を実行:「同期」ボタンをタップすると、システムは自動的にジェスチャー同期プロセスを実行します。

- 結果の表示とダウンロード : 同期が完了した後、結果をプレビューしたり、同期されたビデオファイルをダウンロードすることができます。

- インタラクティブデモの使用:デモページにビデオやオーディオファイルをアップロードして、ジェスチャー同期効果をリアルタイムで体験できます。

- プロジェクトの管理 : アップロードされたすべてのプロジェクトをマイプロジェクトページで閲覧・管理できます。

高度な機能

- インテリジェントなジェスチャー同期:AIが提供するインテリジェントなジェスチャー同期により、ビデオコンテンツのプレゼンテーションを改善します。

- 多言語サポート:プロジェクトのニーズに応じて、さまざまな言語と音声を選択できます。

- カスタム開発: TANGOはオープンソースなので、ユーザーはニーズに合わせて開発することができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません