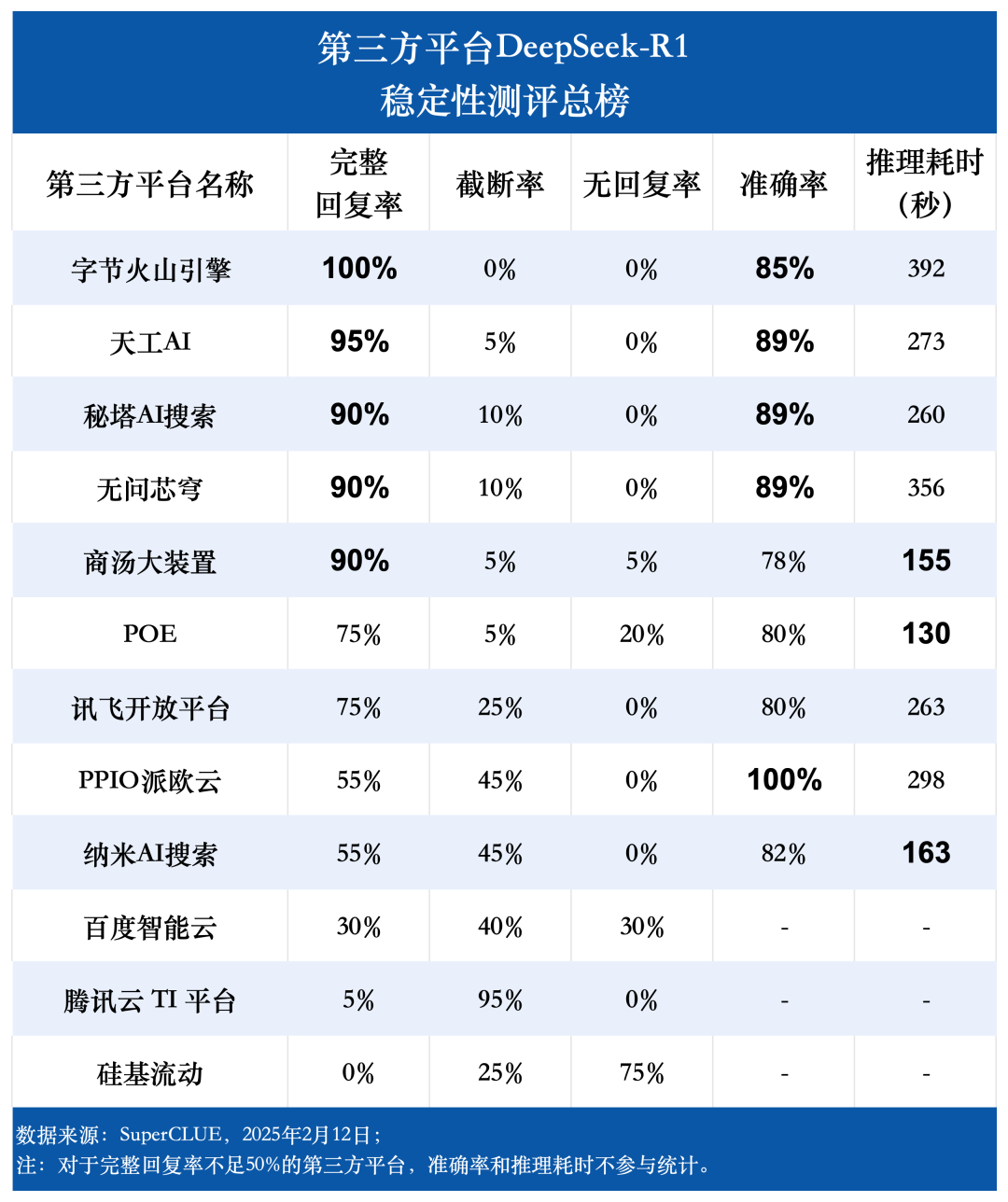

SuperCLUEレビュー:DeepSeek-R1 サードパーティ製プラットフォームの安定性 クロスオーバー、適切なプラットフォームを選べばパフォーマンスは急上昇!

サードパーティ製プラットフォームにおけるDeepSeek-R1の安定性評価レポート

人工知能分野の急速な発展により、数多くの優れた推論モデルが誕生している。DeepSeek-R1は、その卓越した性能と複雑なタスクを処理する能力により、業界で急速に注目されるようになった。しかし、ユーザーの急増や外部からのサイバー攻撃の増加に伴い、DeepSeek-R1の安定性の問題が徐々に露呈してきました。この課題に対処するため、いくつかのサードパーティプラットフォームが、DeepSeek-R1用の独自のソリューションを発表しました。 ディープシーク-R1 モデルの最適化サービスを提供し、ユーザーにより安定した効率的な体験を提供するよう努めています。

ユーザーが各プラットフォームのサービス品質を十分に理解し、ニーズに基づいて十分な情報を得た上で選択できるようにするため、DeepSeek-R1をサポートする多くのサードパーティプラットフォームに関する調査を実施した。安定性評価この評価は、代表的な 12 のサードパーティプラットフォームで実施されました。この評価では、12 の代表的なサードパーティ製プラットフォームを選択し、20 のオリジナル小学校オラクル推論問題を設計して、各プラットフォームでの DeepSeek-R1 モデルの実際のパフォーマンスを調べました。評価の次元は、回答率、推論時間、精度などの主要な指標をカバーしています。本レポートは、Web ベースのプラットフォームの最初の評価結果を提示することを目的としており、リリース時点の各プラットフォームの安定性レベルを反映しています。将来的には、ウェブベース、API、APP、さらにはローカル・デプロイ版など、さまざまなプラットフォームについて、より包括的な評価を実施する予定である。

DeepSeek-R1の安定性評価経験の概要

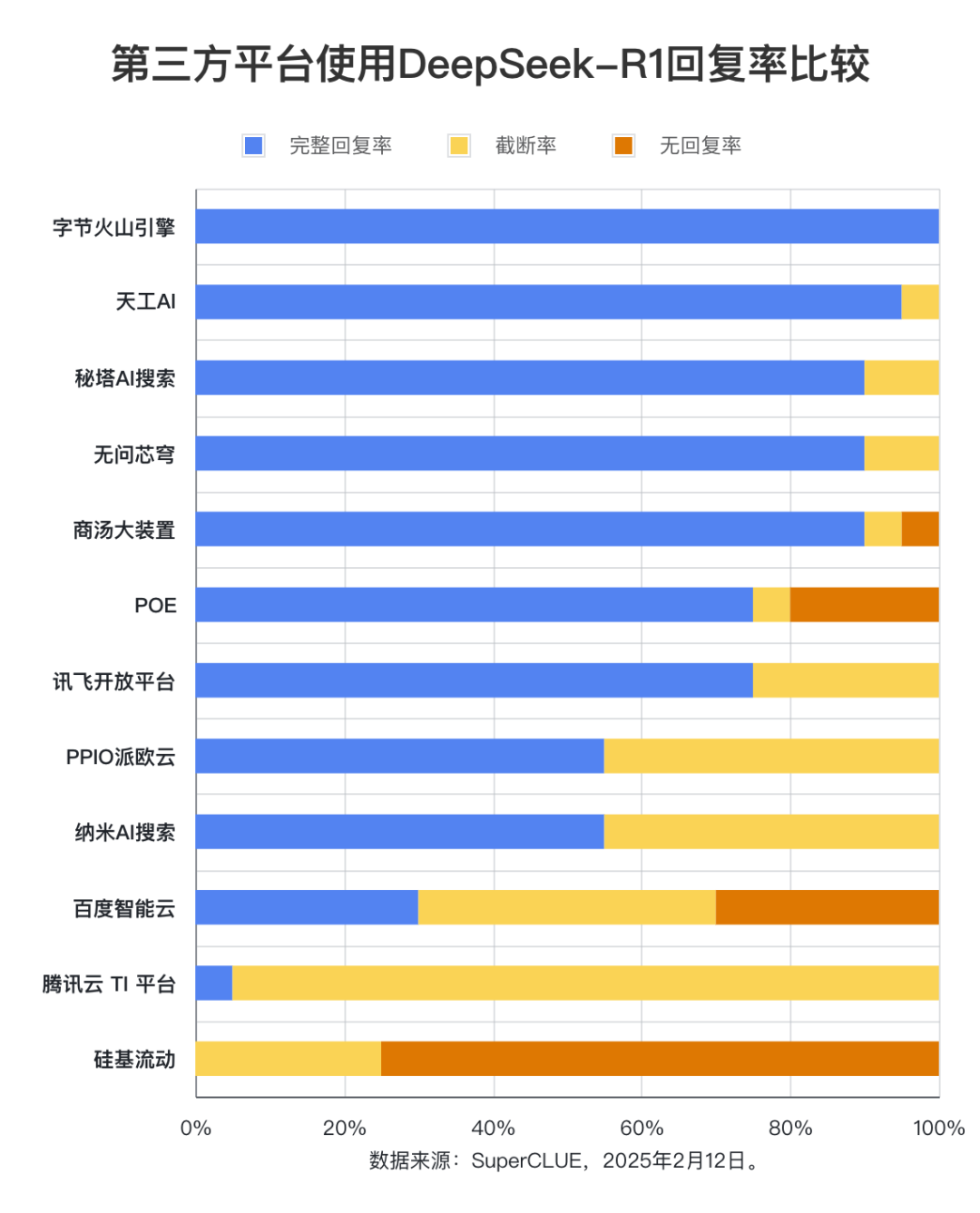

評価ポイント1:サードパーティプラットフォームDeepSeek-R1の完全回答率には有意差がある。

評価結果によると、Byte Volcano Engine(100%)、Tiangong AI(95%)、Secret Pagoda AI Search、Unquestioning Core Dome、Shangtang Big Device(いずれも90%)は、完全応答率の点で卓越した性能を持ち、優れた安定性を示している。対照的に、Baidu Intelligent Cloud、Tencent Cloud TI Platform、Silicon Mobilityはいずれも完全応答率が50%を下回っており、安定性を改善できる可能性が示唆された。この発見は、ユーザー選択プロセスにおけるプラットフォームの安定性の重要性を浮き彫りにしている。

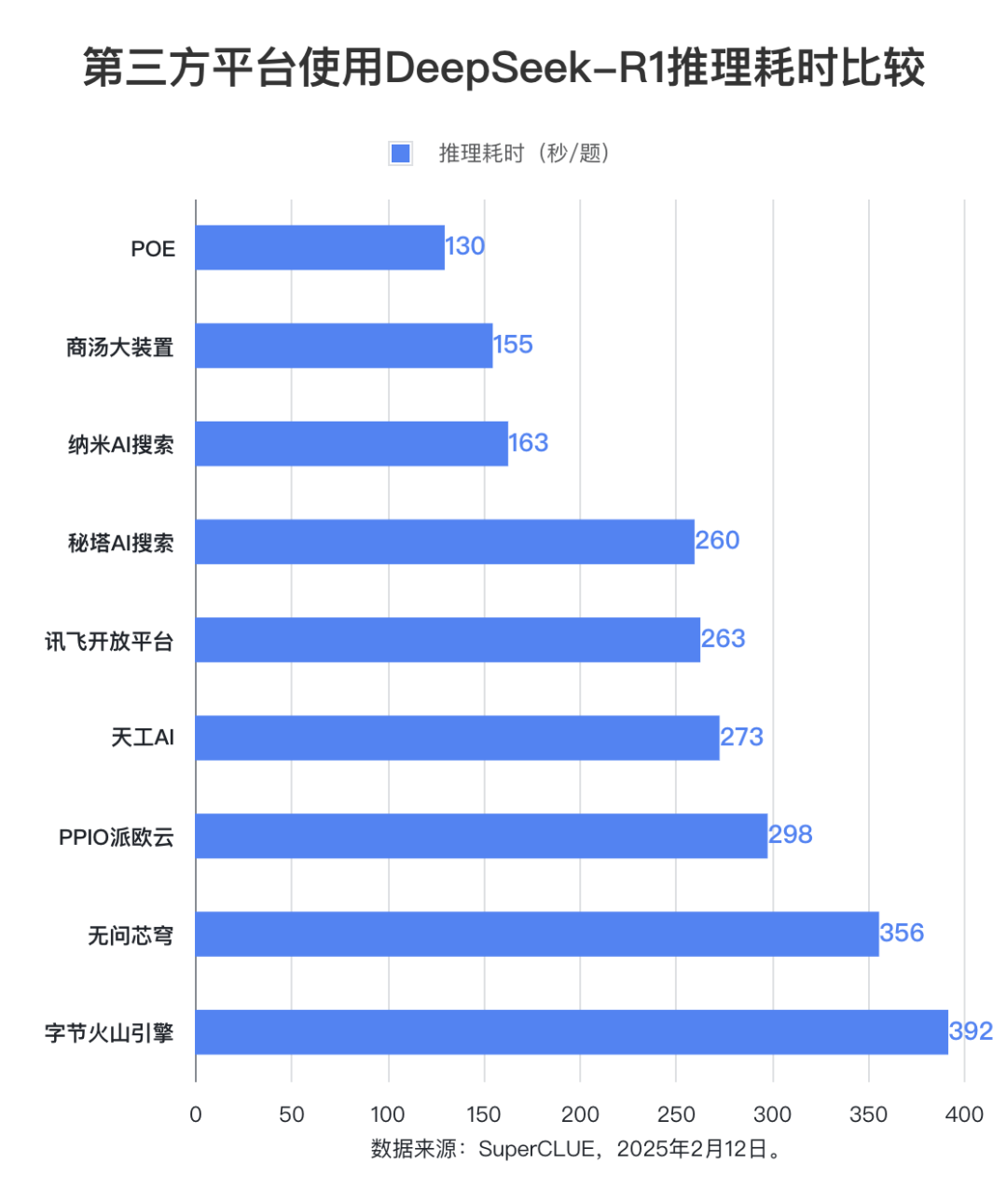

評価ポイント2: DeepSeek-R1モデルの推論時間はプラットフォーム間で大きな差があり、最も長いプラットフォームと最も短いプラットフォームの差は約3倍です。

推論時間では、POEプラットフォームが最も優れており、1問あたりの平均時間は130秒であった。Shangtang Big DeviceとNano AI Searchが僅差で続き、1問あたりの平均時間はそれぞれ155秒と163秒でした。Byte Volcano Engineは1問あたりの平均時間が最も長く、392秒に達しました。

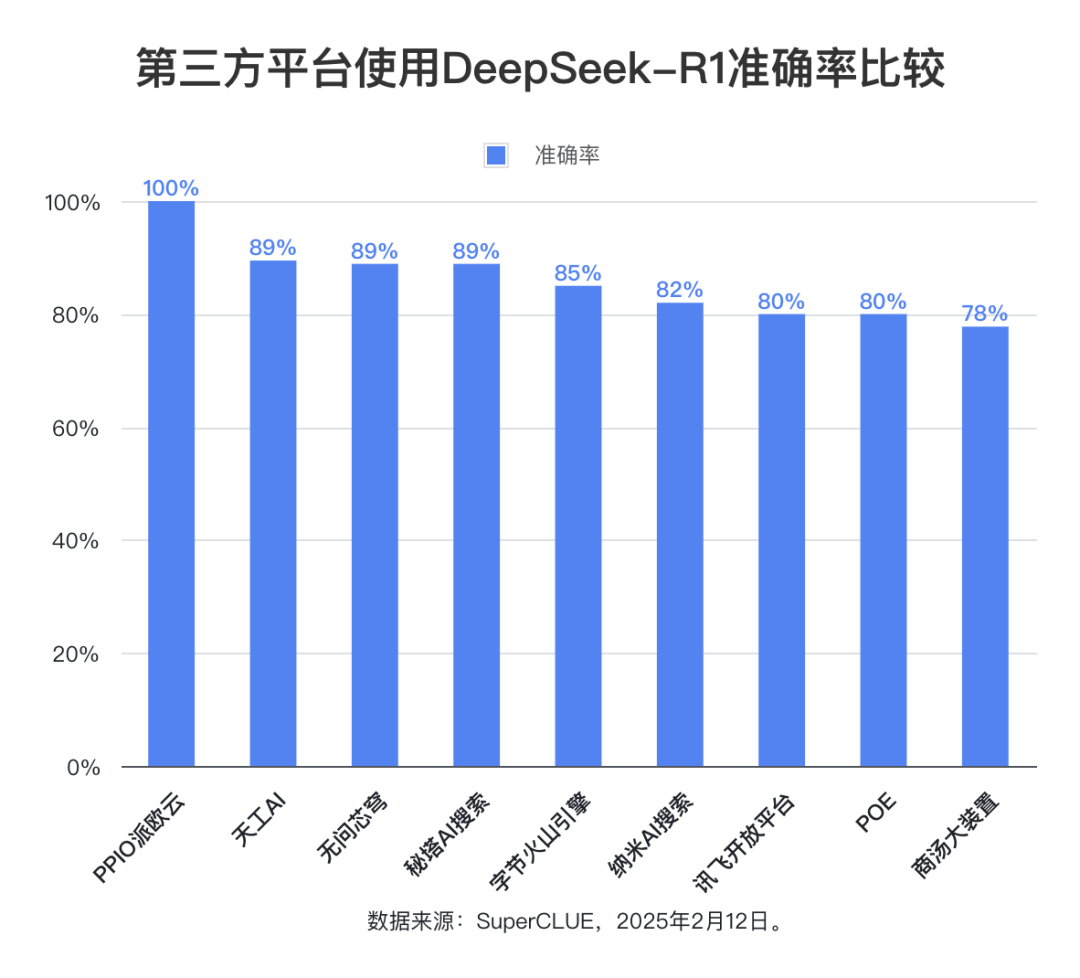

評価ポイント3:DeepSeek-R1モデルの全体的な精度はすべてのプラットフォームで高く、これはモデル自体の強力で信頼できる性能を反映しています。

評価データによると、完全応答率が50%より低いプラットフォームを除く、他の9つのプラットフォームの平均精度率は85.76%と高く、最高精度率は100%に達し、最低精度率も78%に留まっています。これは、DeepSeek-R1モデル自体が優れた性能と信頼性を持ち、あらゆる種類のサードパーティアプリケーションに対して安定した高精度のサポートを提供できることを完全に証明しています。これは、DeepSeek-R1モデル自体が優れた性能と信頼性を持ち、様々なサードパーティアプリケーションに安定した高精度のサポートを提供できることを完全に証明している。

リストの概要

完全奏効率+切断率+無奏効率=100%

- 完全奏効率このモデルは、切り捨てや無回答などの問題なしに完全な回答を与えますが、回答が正しいかどうかは考慮しません。完全回答の問題数を問題総数で割った値。

- 切捨て率回答プロセスに中断があり、完全な回答ができなかったモデル。切り捨てられた質問数を質問総数で割って算出。

- 無回答率: 特別な理由(無回答/リクエストエラーなど)で回答できなかったモデル。無回答の質問数を質問総数で割った値。

- 精度模範解答がある問題では、標準解答と一致した解答の割合。最終解答の正しさのみが評価され、解答プロセスは問われない。

- 推論に要した時間(秒/問)完全な模範解答がある問題で、各解答を推論するためにモデルが費やした平均時間。

方法論

1. 各サードパーティープラットフォームについて、評価の公平性と比較可能性を確保するため、小学校のOU問題20問を使用した標準化テストが実施された。2. 推理問題の出力内容は通常長いことを考慮し、最大出力の調整をサポートするために、以下のような工夫をしています。 トークン max_tokensを持つプラットフォームでは、このパラメータを最大値に設定し、残りのパラメータはプラットフォームのデフォルト設定のままにしておく。3. 推論時間消費の統計的方法:推論タイミング機能があるプラットフォームでは、プラットフォームが提供する統計的結果が使用され、この機能がないプラットフォームでは、手動タイミングが使用される。

評価結果

(1) 完全奏効率

評価データによると、バイト火山エンジン、天宮AI、秘密タワーAI検索、不問核心ドーム、上堂大机の完全応答率はいずれも90%以上に達した。その中で、バイト火山エンジンの完全応答率は100%で、最も性能が高い。 対照的に、百度インテリジェントクラウド、騰訊クラウドTIプラットフォーム、シリコン型モビリティの完全応答率は著しく低く、50%以下である。 切捨て率では、騰訊クラウドTIプラットフォームの応答率は95%に達する。シリコン型モビリティは、テストにおいて、応答しない、または要求エラーが発生するケースが最も多く、75%である。応答速度は75%に達した。

(2) 精度

正確率の統計範囲は、モデルが完全な回答をした質問に限定され、モデルによって正しく回答された質問の割合が反映されます。評価結果によると、DeepSeek-R1モデルを使用した9つのサードパーティプラットフォームの平均精度率は85.76%に達しており、DeepSeek-R1モデル自体の高い品質と信頼性、およびさまざまなアプリケーションシナリオに対して安定した精度の高いサポートを提供する能力がさらに確認されました。

(3) 時間のかかる推論

1問あたりの平均推論時間では、POEプラットフォームが130秒と最も優れている。Shangtang Big DeviceとNano AI Searchの推論時間も比較的短く、どちらも200秒以内です。No Question VaultとByte Volcano Engineの推論時間は比較的長く、どちらも350秒を超えています。その他のプラットフォームは250~300秒である。

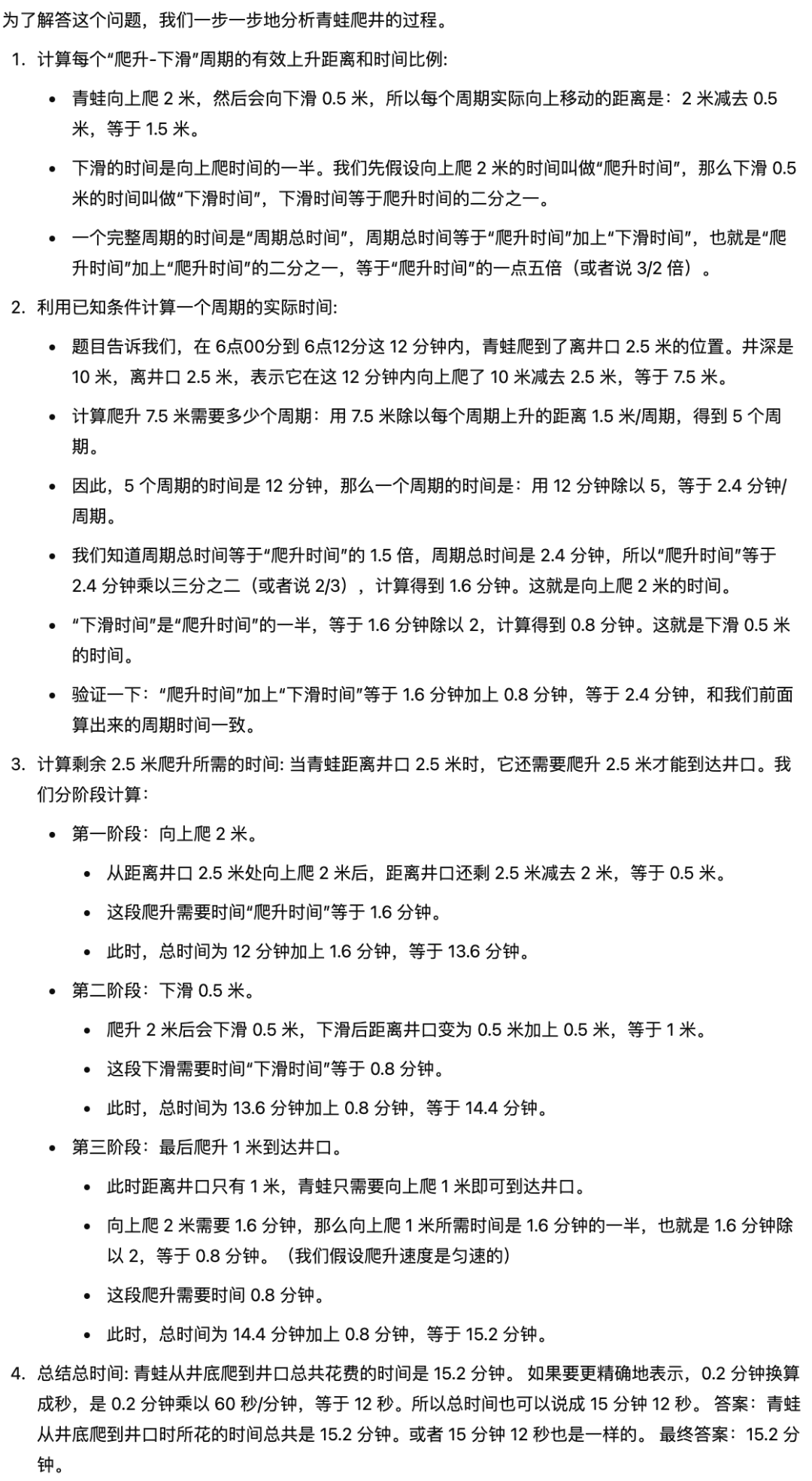

例

タイトル あるカエルが午前6時に10メートルの井戸を登った。2メートル登るごとに、壁が滑って0.5メートル滑った。0.5メートル滑るのにかかる時間は、井戸を2メートル登るのにかかる時間の2分の1である。午前6時12分、井戸の口から2.5メートル。カエルが井戸の底から井戸の口まで登るのに何分かかったか?

標準回答:15.2分(=15分12秒)

参考回答(モデル:Gemini-2.0-Flash-Expより):

原因分析

1. モデルの最大出力長の制限は、応答の中断につながる重要な要因の一つである。統計によると、いくつかのプラットフォームは、max_tokensパラメータの柔軟な調整を提供していません(Baidu Intelligent Cloud、Tencent Cloud TIプラットフォームなど)。このため、長い回答を生成するときにモデルが切り捨てられやすくなります。特に今回の評価では、小学校のオリンピックの問題が複雑で、問題を解くのが面倒なため、モデルによって生成する必要があるコンテンツの長さが大幅に増加し、トークン制限の問題がさらに増幅されました。その結果、出力トランケーションの発生が悪化した。

2. プラットフォームのユーザー負荷も、モデルサービスの安定性に影響を与える潜在的な要因である。

プラットフォームごとのユーザー数の違いを考慮すると、ユーザー数の多いプラットフォームほど、サーバーの過負荷による不安定性のリスクが高くなる可能性がある。プラットフォームサービスの安定性の欠如は、間接的にモデル生成応答の完全性と推論速度に影響を与える可能性があります。

結論と提言

1. DeepSeek-R1 モデルの展開および実行時のサードパーティ製プラットフォームの安定性パフォーマンスには大きな違いがあります。ユーザは、プラットフォームを選択する際に、以下のことをお勧めします。総合評価 各プラットフォームの技術アーキテクチャ、リソーススケジューリング機能、ユーザー負荷自らのニーズの統合(応答速度、推論時間の消費、その他の指標など)を考慮する必要がある。より高い安定性を求めるユーザーにとっては、ユーザー数は比較的少ないが、よりバランスの取れたリソース配分のプラットフォームを優先することで、高い同時実行性によるパフォーマンス変動のリスクを減らすことができる。

2. 評価データによると、「バイト火山エンジン」、「天宮AI」、「秘密タワーAIサーチ」、「問答無用コア・ドーム」、「上堂ビッグデバイス」などのプラットフォームがある。90%以上の完全奏効率が達成されたこれらのプラットフォームは、モデル出力の完全性と信頼性を保証する上で優れていることが示唆される。高い応答率を確保する必要があるアプリケーションシナリオでは、上記のプラットフォームを優先的に技術サポートすることが推奨される。

3. ある手間のかかる推論側面。上堂のPOEプラットフォームと大型設備 低レイテンシーという特性は、リアルタイム性が要求されるアプリケーションに適している。ユーザーは、パフォーマンスとコストの最適なバランスを達成するために、プラットフォームを選択する際に、特定のビジネス要件に従って推論時間消費の感度を優先することをお勧めします。

各プラットフォームのDeepSeek-R1体験サイトを添付します:

バイト火山エンジン:https://console.volcengine.com/ark/region:ark+cn-beijing/experience/chat

シリコンベースのフロー: https://cloud.siliconflow.cn/playground/chat/17885302724

百度スマートクラウド: https://console.bce.baidu.com/qianfan/ais/console/onlineTest/LLM/DeepSeek-R1

シークレットタワーAI検索: https://metaso.cn/

問答無用のコアドーム: https://cloud.infini-ai.com/genstudio/experience

PPIO パイオクラウドhttps://ppinfra.com/llm

ナノAI検索: https://bot.n.cn/chat?src=AIsearch

殷堂の偉大な装置 https://console.sensecore.cn/aistudio/experience/conversation

スカイワークスのAI: https://www.tiangong.cn/

POEだ:https://poe.com/

テンセント・クラウドTIプラットフォーム: https://console.cloud.tencent.com/tione/v2/aimarket/detail/deepseek_series?regionId=1&detailTab=deep_seek_v1

サイバローム・オープンプラットフォームhttps://training.xfyun.cn/experience/text2text?type=public&modelServiceId=2501631186799621

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません