Step-Audio:マルチモーダル音声インタラクションフレームワーク。

はじめに

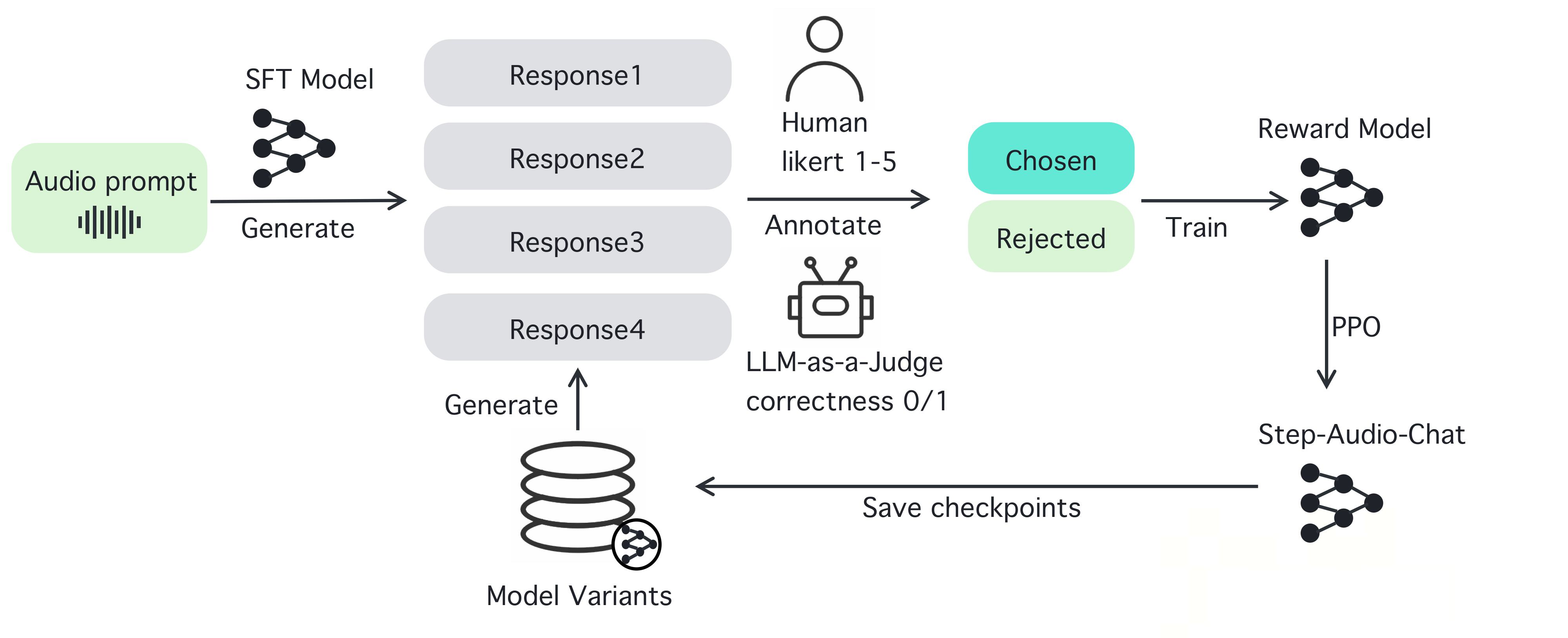

Step-Audioはオープンソースのインテリジェント音声インタラクションフレームワークで、プロダクション環境ですぐに使える音声理解と音声生成機能を提供するように設計されています。Step-Audioは、130Bパラメータのマルチモーダルモデルを通して、音声認識、意味理解、対話、音声クローン、音声合成を実装しています。その生成データエンジンは、リソース効率に優れたStep-Audio-TTS-3Bモデルを訓練し公開するために高品質の音声を生成することで、従来のTTS手動データ収集への依存を排除します。

機能一覧

- リアルタイム音声認識(ASR):音声をテキストに変換し、高精度の認識をサポート。

- テキスト音声合成(TTS):テキストを自然な音声に変換し、さまざまな感情やイントネーションに対応。

- 多言語サポート:中国語、英語、日本語、広東語や四川語などの方言に対応。

- 感情とイントネーションのコントロール:音声出力の感情(例:嬉しい、悲しい)や韻のスタイル(例:RAP、ハミング)を調整する。

- ボイスクローニング:入力された音声を元に、似たような音声を生成します。

- ダイアログ管理: ダイアログの連続性を維持し、コンテキストマネージャーでユーザーエクスペリエンスを向上させます。

- オープンソース・ツールチェーン:開発者が直接使用したり、二度開発したりできる、完全なコードとモデルの重みを提供する。

ヘルプの使用

Step-Audioは、開発者がリアルタイムの音声アプリケーションを構築するための強力なオープンソースのマルチモーダル音声インタラクションフレームワークです。以下は、Step-Audioをインストールして使用するための詳細なステップバイステップガイドです。

設置プロセス

Step-Audioを使用するには、NVIDIA GPUがある環境にソフトウェアをインストールする必要があります。以下、詳しい手順です:

- 環境準備::

- システムにPython 3.10がインストールされていることを確認してください。

- 仮想環境を管理するために Anaconda または Miniconda をインストールする。

- NVIDIA GPUドライバとCUDAサポートがインストールされていることを確認し、4xA800/H800 GPU (80GB RAM)が最高の世代品質を実現するために推奨されます。

- クローン倉庫::

- ターミナルを開き、以下のコマンドを実行してStep-Audioリポジトリをクローンします:

git clone https://github.com/stepfun-ai/Step-Audio.git cd Step-Audio

- ターミナルを開き、以下のコマンドを実行してStep-Audioリポジトリをクローンします:

- 仮想環境の構築::

- Python仮想環境を作成し、有効化する:

conda create -n stepaudio python=3.10 conda activate stepaudio

- Python仮想環境を作成し、有効化する:

- 依存関係のインストール::

- 必要なライブラリとツールをインストールする:

pip install -r requirements.txt git lfs install - 追加モデルの重みをクローンする:

git clone https://huggingface.co/stepfun-ai/Step-Audio-Tokenizer git clone https://huggingface.co/stepfun-ai/Step-Audio-Chat git clone https://huggingface.co/stepfun-ai/Step-Audio-TTS-3B

- 必要なライブラリとツールをインストールする:

- インストールの確認::

- 簡単なテストスクリプトを実行する(サンプルコードのように)

run_example.py)を使用して、すべてのコンポーネントが正常に動作していることを確認します。

- 簡単なテストスクリプトを実行する(サンプルコードのように)

インストールが完了したら、Step-Audioの様々な機能を使い始めることができます。以下は、主な機能や特徴的な機能を操作するための詳しい説明です。

主な機能

1.リアルタイム音声認識(ASR)

Step-Audioの音声認識機能は、ユーザーの音声入力をテキストに変換するため、音声アシスタントやリアルタイム書き起こしシステムの構築に適しています。

- 手続き::

- マイクが接続され、設定されていることを確認してください。

- 付属の

stream_audio.pyライブオーディオストリーミングを開始するスクリプト:python stream_audio.py --model Step-Audio-Chat - 話すとリアルタイムで音声をテキストに変換し、端末に結果を出力する。認識精度はログで確認できます。

- 注目の機能中国語と英語の混在入力や、広東語や四川語などの地域化された音声など、多言語・方言認識に対応。

2.音声合成(TTS)

TTS機能により、あらゆるテキストを自然な音声に変換することができ、幅広い感情、発話速度、スタイルをサポートします。

- 手続き::

- 合成するテキストを準備する。

input.txt. - 利用する

text_to_speech.pyスピーチを生成するスクリプト:python text_to_speech.py --model Step-Audio-TTS-3B --input input.txt --output output.wav --emotion happy --speed 1.0 - パラメータの説明

--emotion感情を設定する(例:幸せ、悲しい、中立)。--speed(0.5:ゆっくり、1.0:普通、2.0:速い)。--output出力音声ファイルのパスを指定します。

- 合成するテキストを準備する。

- 注目の機能例えば、RAPやハミングのような発話スタイルの生成に対応:

python text_to_speech.py --model Step-Audio-TTS-3B --input rap_lyrics.txt --style rap --output rap_output.wav

这将生成一段带有 RAP 节奏的音频,非常适合音乐或娱乐应用。

#### 3. 多语言与情感控制

Step-Audio 支持多种语言和情感控制,适合国际化应用开发。

- **操作步骤**:

- 选择目标语言和情感,例如生成日语悲伤语气语音:

python generate_speech.py --language japanese --emotion sad --text "私は悲しいです" --output sad_jp.wav

- 方言支持:如果需要粤语输出,可以指定:

python generate_speech.py -方言 広東語 --テキスト "I'm so hung up on you" --出力 広東語.wav

- **特色功能**:通过指令可以无缝切换语言和方言,适合构建跨文化语音交互系统。

#### 4. 语音克隆

语音克隆允许用户上传一段语音样本,生成相似的声音,适用于个性化语音设计。

- **操作步骤**:

- 准备一个音频样本(如 `sample.wav`),确保音频清晰。

- 使用 `voice_clone.py` 进行克隆:

python voice_clone.py --input sample.wav --output cloned_voice.wav --model Step-Audio-Chat

- 生成的 `cloned_voice.wav` 将模仿输入样本的音色和风格。

- **特色功能**:支持高保真克隆,适用于虚拟主播或定制语音助手。

#### 5. 对话管理与上下文保持

Step-Audio 内置上下文管理器,确保对话的连续性和逻辑性。

- **操作步骤**:

- 启动对话系统:

python chat_system.py --model Step-Audio-Chat

- テキストまたは音声を入力すると、システムが文脈に基づいて応答を生成します。例

- ユーザー:「今日の天気はどうですか?

- SYSTEM:「場所を教えてください、調べますから。

- ユーザー:「北京にいます。

- SYSTEM:"北京は今日は晴れ、気温は15℃です。"

- 注目の機能複数回の対話をサポートし、文脈情報を保持し、接客ボットやインテリジェント・アシスタントに適しています。

ほら

- ハードウェア要件最適なパフォーマンスを得るためには、80GB以上のメモリを推奨します。

- ネットワーク接続安定したネットワークを確保するために、モデルの重みの一部をHugging Faceからダウンロードする必要があります。

- エラー検出インストールエラーやランタイムエラーが発生した場合は、ログファイルを確認するか、GitHubのIssuesページを参照してください。

Step-Audioはオープンソースであるため、必要に応じてコードを変更したり、モデルを最適化したりすることができます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません