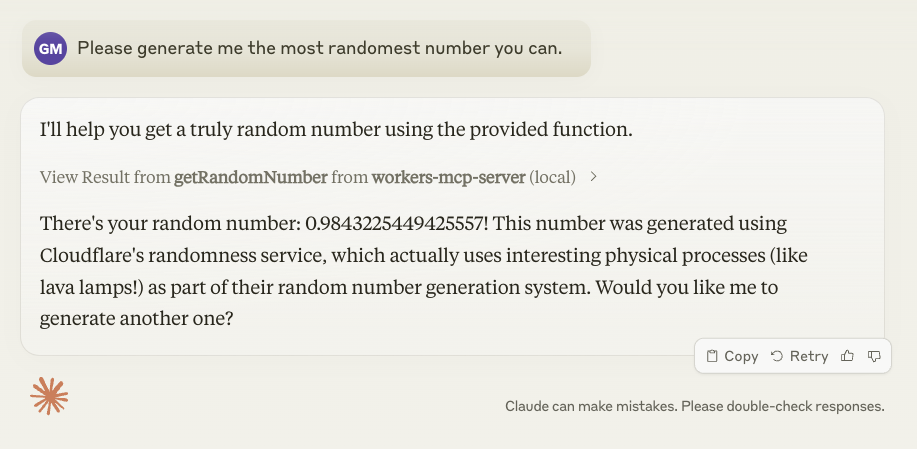

シンバ:文書整理のためのナレッジマネジメントシステムで、あらゆるRAGシステムにシームレスに統合されます。

はじめに

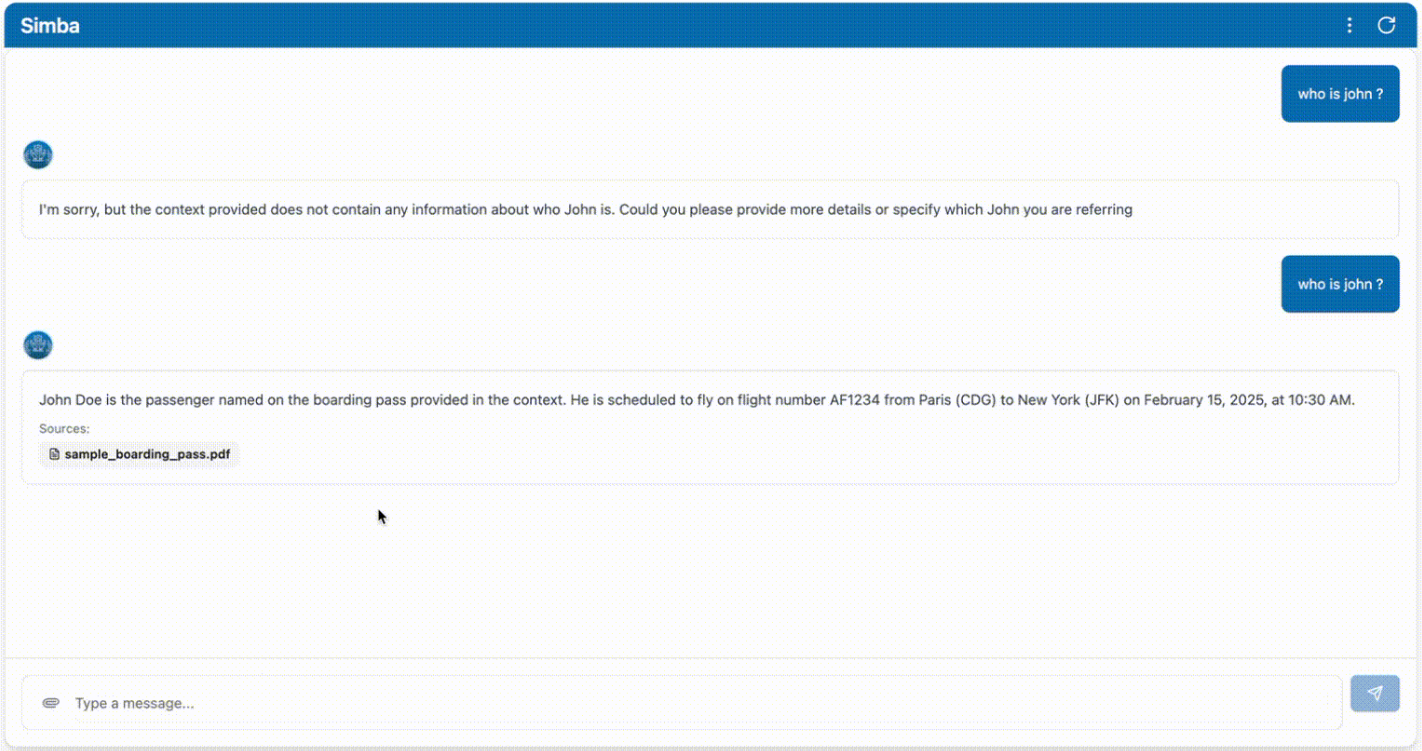

Simbaはポータブルな知識管理システム(KMS)で、あらゆるRAG(Retrieval Augmented Generation)システムとシームレスに統合できるように設計されています。GitHubユーザーのGitHamza0206によって作成されたこのプロジェクトは、様々なアプリケーションシナリオのための効率的な知識管理ソリューションを提供します。Simbaは、知識管理プロセスを簡素化し、情報の検索と生成の精度と効率を向上させることを目標に設計されています。RAGシステムとの統合により、Simbaは複雑なデータの取り扱いとコンテンツの生成を強力にサポートします。

機能一覧

- ナレッジ・マネジメント知識の保存、分類、検索をサポートする包括的な知識管理機能を提供します。

- RAGシステム・インテグレーション検索強化生成システムとのシームレスな統合により、情報生成の精度を向上。

- ポータビリティ展開と使用が容易なポータブルシステムとして設計されています。

- オープンソースプロジェクトオープンソースプロジェクトなので、ユーザーは自由にソースコードにアクセスし、カスタマイズすることができます。

- 効率的な検索最適化された情報検索により、必要な知識を素早く見つけることができます。

- ユーザーフレンドリーなインターフェース操作プロセスを簡素化する直感的なユーザーインターフェースを提供します。

ヘルプの使用

設置プロセス

- クローン倉庫まず、Gitコマンドを使ってSimbaプロジェクトのGitHubリポジトリをクローンする。

git clone https://github.com/GitHamza0206/simba.git

- 依存関係のインストールプロジェクト・ディレクトリに移動し、必要な依存パッケージをインストールする。

cd simba

地域開発

- バックエンド設定::

- バックエンドのディレクトリに移動する:

cd backend- お使いのオペレーティング・システムにRedisがインストールされていることを確認してください:

redis-server- 環境変数の設定:

cp .env.example .envそれから.envファイルを編集し、値を記入する:

OPENAI_API_KEY="" LANGCHAIN_TRACING_V2= #(optional - for langsmith tracing) LANGCHAIN_API_KEY="" #(optional - for langsmith tracing) REDIS_HOST=redis CELERY_BROKER_URL=redis://redis:6379/0 CELERY_RESULT_BACKEND=redis://redis:6379/1- 依存関係をインストールします:

poetry install poetry shellMac/Linuxでも:

source .venv/bin/activateWindowsの場合:

.venv\Scripts\activate- バックエンド・サービスを実行する:

python main.pyあるいはオートリローディングを使う:

uvicorn main:app --reload次に

http://0.0.0.0:8000/docsSwagger UIへのアクセス(オプション)。- Celeryを使ってパーサーを実行する:

celery -A tasks.parsing_tasks worker --loglevel=info- 必要に応じて修正する

config.yamlドキュメンテーション

project: name: "Simba" version: "1.0.0" api_version: "/api/v1" paths: base_dir: null # Will be set programmatically markdown_dir: "markdown" faiss_index_dir: "vector_stores/faiss_index" vector_store_dir: "vector_stores" llm: provider: "openai" #or ollama (vllm coming soon) model_name: "gpt-4o" #or ollama model name temperature: 0.0 max_tokens: null streaming: true additional_params: {} embedding: provider: "huggingface" #or openai model_name: "BAAI/bge-base-en-v1.5" #or any HF model name device: "cpu" # mps,cuda,cpu additional_params: {} vector_store: provider: "faiss" collection_name: "migi_collection" additional_params: {} chunking: chunk_size: 512 chunk_overlap: 200 retrieval: k: 5 #number of chunks to retrieve features: enable_parsers: true # Set to false to disable parsing celery: broker_url: ${CELERY_BROKER_URL:-redis://redis:6379/0} result_backend: ${CELERY_RESULT_BACKEND:-redis://redis:6379/1} - フロントエンドの設定::

- Simbaのルートディレクトリにあることを確認してください:

bash

cd frontend - 依存関係をインストールします:

bash

npm install - フロントエンドサービスを実行する:

bash次に

npm run devhttp://localhost:5173フロントエンド・インターフェースにアクセスする。

- Simbaのルートディレクトリにあることを確認してください:

Dockerによる起動(推奨)

- Simbaのルートディレクトリに移動します:

export OPENAI_API_KEY="" #(optional)

docker-compose up --build

プロジェクト体制

simba/

├── backend/ # 核心处理引擎

│ ├── api/ # FastAPI端点

│ ├── services/ # 文档处理逻辑

│ ├── tasks/ # Celery任务定义

│ └── models/ # Pydantic数据模型

├── frontend/ # 基于React的UI

│ ├── public/ # 静态资源

│ └── src/ # React组件

├── docker-compose.yml # 开发环境

└── docker-compose.prod.yml # 生产环境设置

コンフィグ

config.yamlファイルはバックエンドアプリケーションの設定に使用されます。以下を変更できます:

- モデルの埋め込み

- ベクトルきおくそうち

- チャンク

- 取り出す

- 官能性

- リゾルバ

詳しくはbackend/README.md.

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません