SILICONFLOW(シリコンフロー):人類のAGIを加速する、無料の大規模モデルインターフェースを統合

はじめに

SiliconCloudは、優れたオープンソースの基本モデルに基づいて、費用対効果の高いGenAIサービスを提供しています。

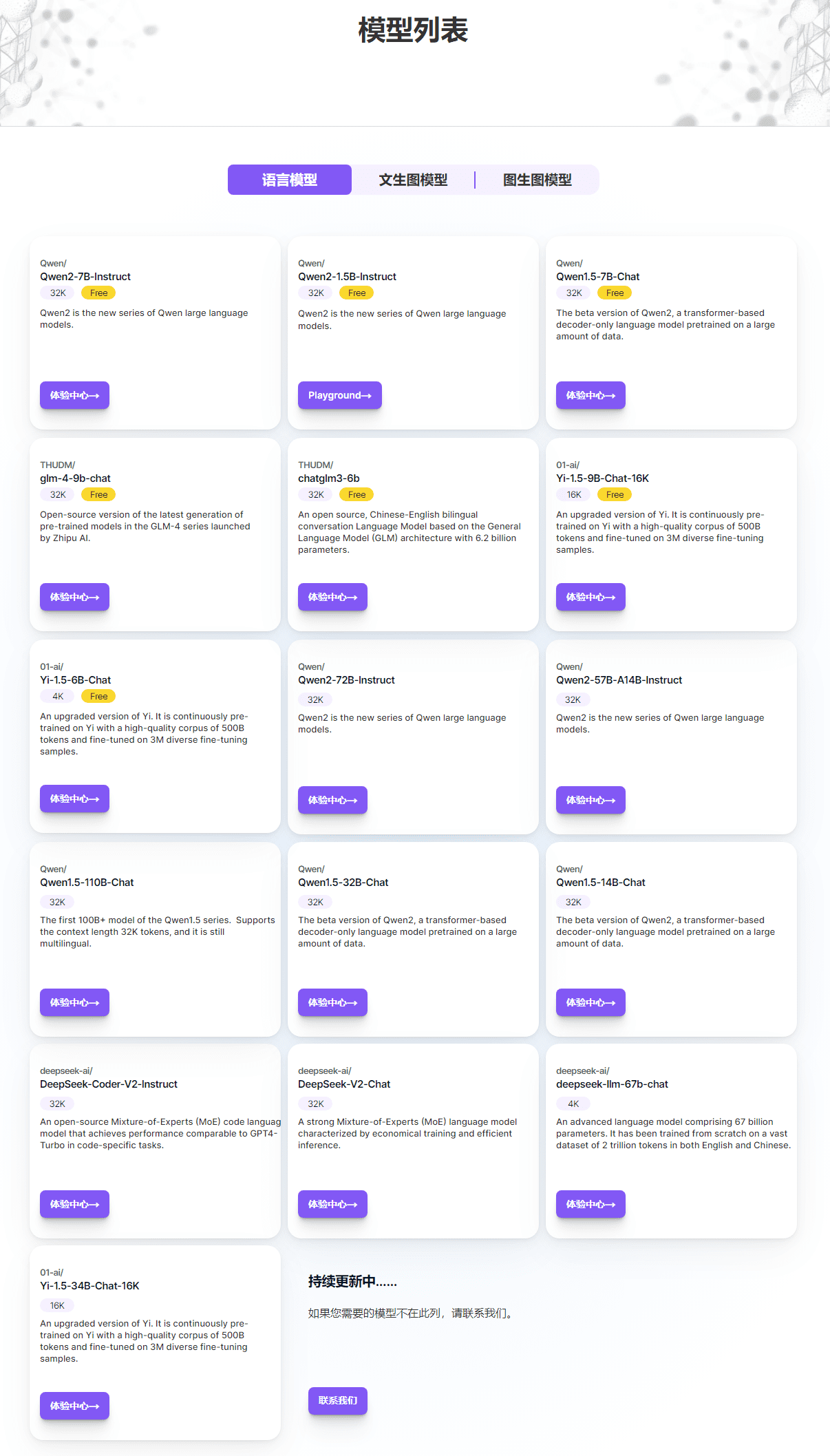

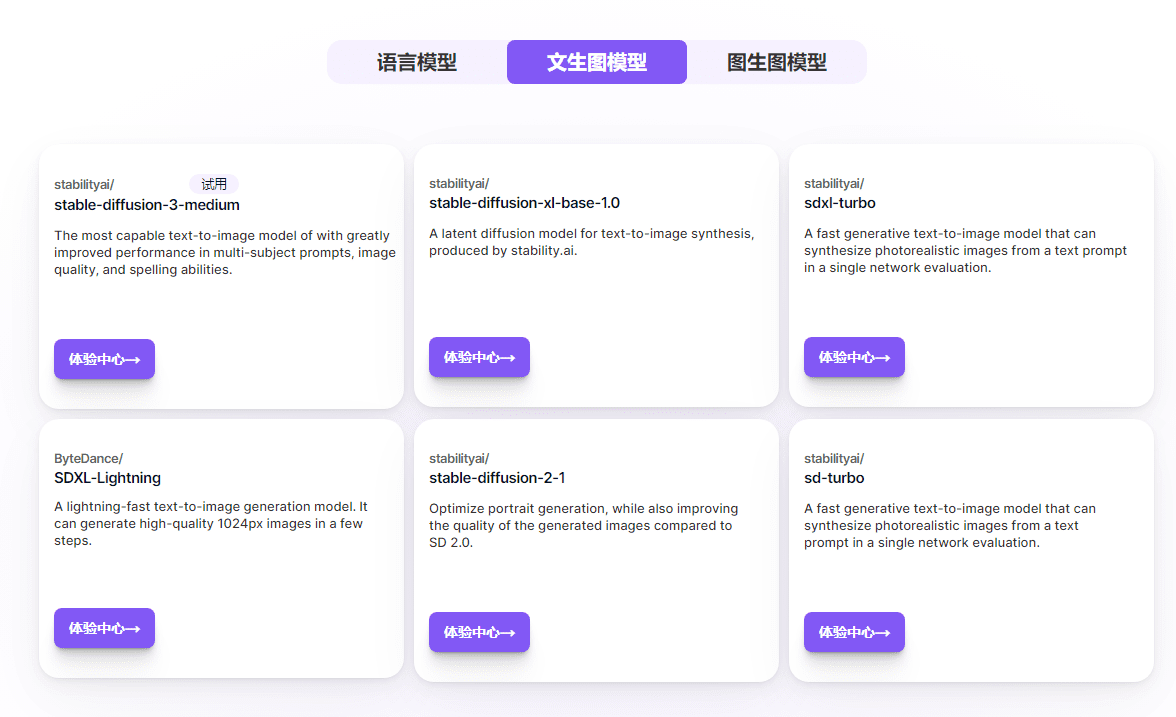

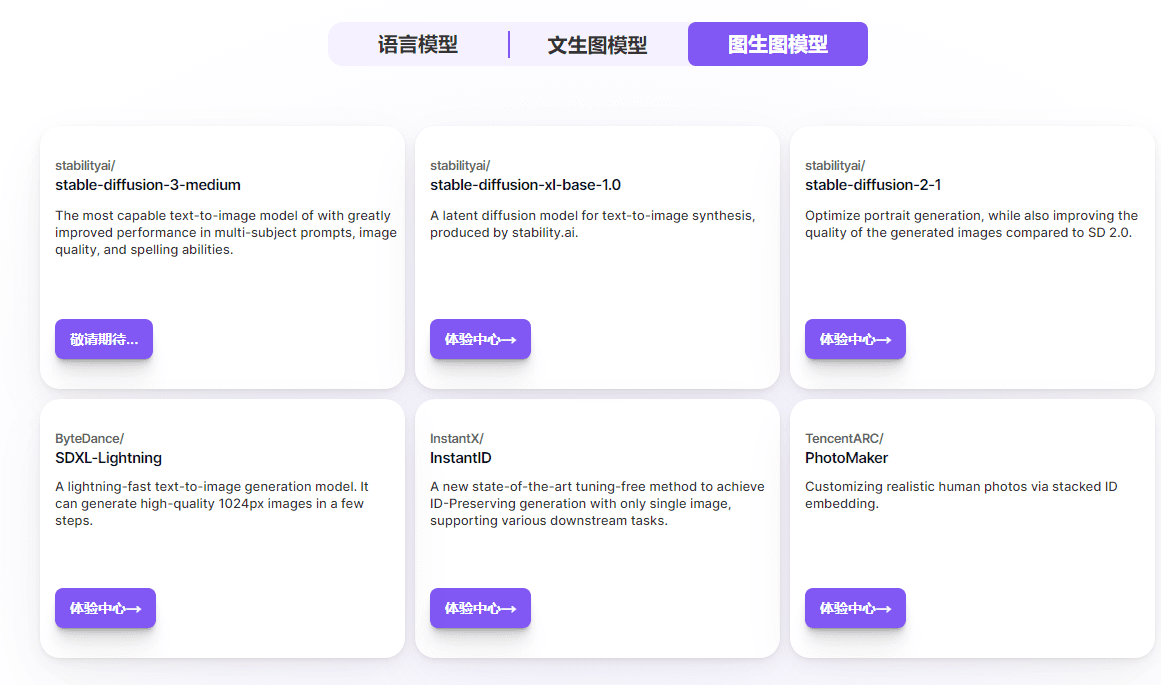

独自のビッグモデルAPIのみを提供する多くのビッグモデルクラウドサービスプラットフォームとは異なり、SiliconCloudは、Qwen、DeepSeek、GLM、Yi、Mistral、LLaMA 3、SDXL、InstantIDなど、オープンソースのビッグ言語モデルや画像生成モデルを幅広く取り揃えており、ユーザーは、さまざまなアプリケーションシナリオに適したモデルを自由に切り替えることができます。ユーザーは、異なるアプリケーションシナリオに適したモデルを自由に切り替えることができます。

さらに、SiliconCloudは、GenAIアプリケーションにより効率的なユーザーエクスペリエンスをもたらすために、すぐに使える大規模モデル推論アクセラレーションサービスを提供します。

開発者にとって、SiliconCloudはトップクラスのオープンソースモデルにワンクリックでアクセスできます。これにより、開発者はアプリケーション開発における試行錯誤のコストを大幅に削減しながら、アプリケーション開発のスピードと経験を向上させることができます。

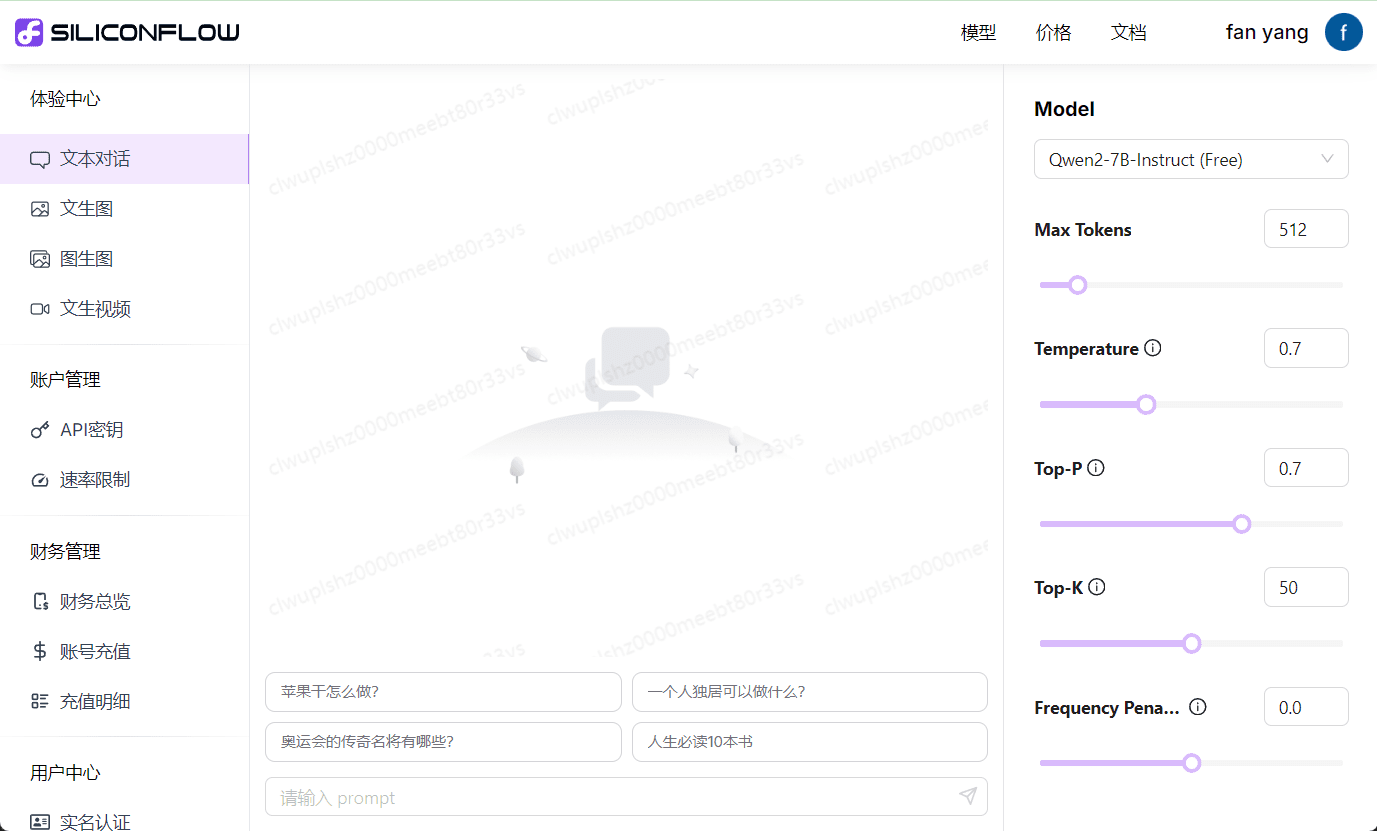

SiliconCloud Modelsのページでは、現在サポートしている言語モデル、テキストからグラフへのモデル、グラフからグラフへのモデルを見ることができ、"Experience Centre "をクリックすると、実際にそのモデルを使ってテストすることができます。

モデル一覧

無料モデルリスト

| クウェン/クウェン2-7B-インストラクター | 32K |

|---|---|

| クウェン/クウェン2-1.5B-インストラクター | 32K |

| クウェン/Qwen1.5-7B-チャット | 32K |

| thudm/glm-4-9b-チャット | 32K |

| THUDM/chatglm3-6b | 32K |

| 01-ai/Yi-1.5-9B-Chat-16K | 16K |

| 01-ai/Yi-1.5-6B-チャット | 4K |

| google/gemma-2-9b-it | 8K |

| インターンルーム/インターンルーム2_5-7b-チャット | 32K |

| メタラマ/メタラマ-3-8B-インストラクト | 8K |

| メタラマ/メタラマ-3.1-8B-インストラクト | 8K |

| mistralai/Mistral-7B-Instruct-v0.2 | 32K |

SiliconCloud API の使用

ベースURL:https://api.siliconflow.cn/v1

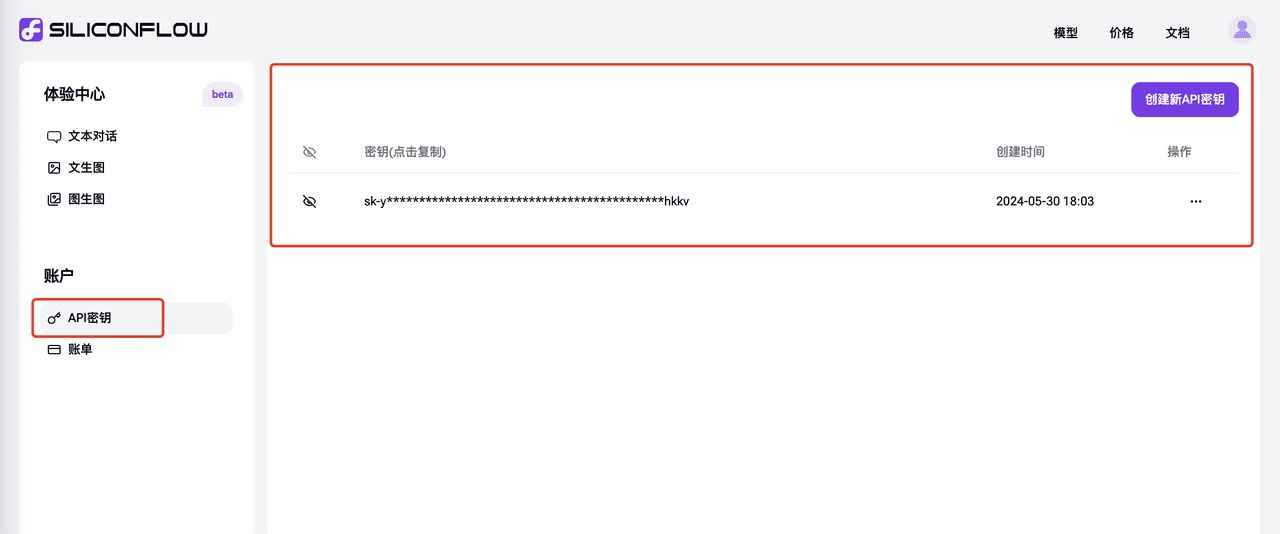

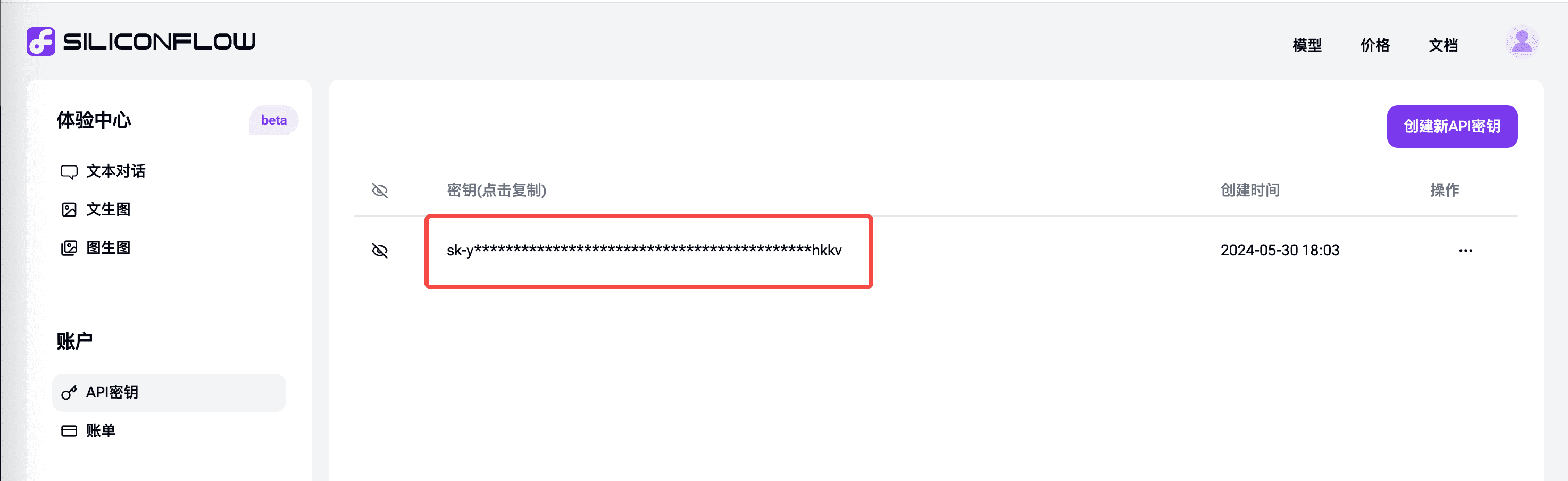

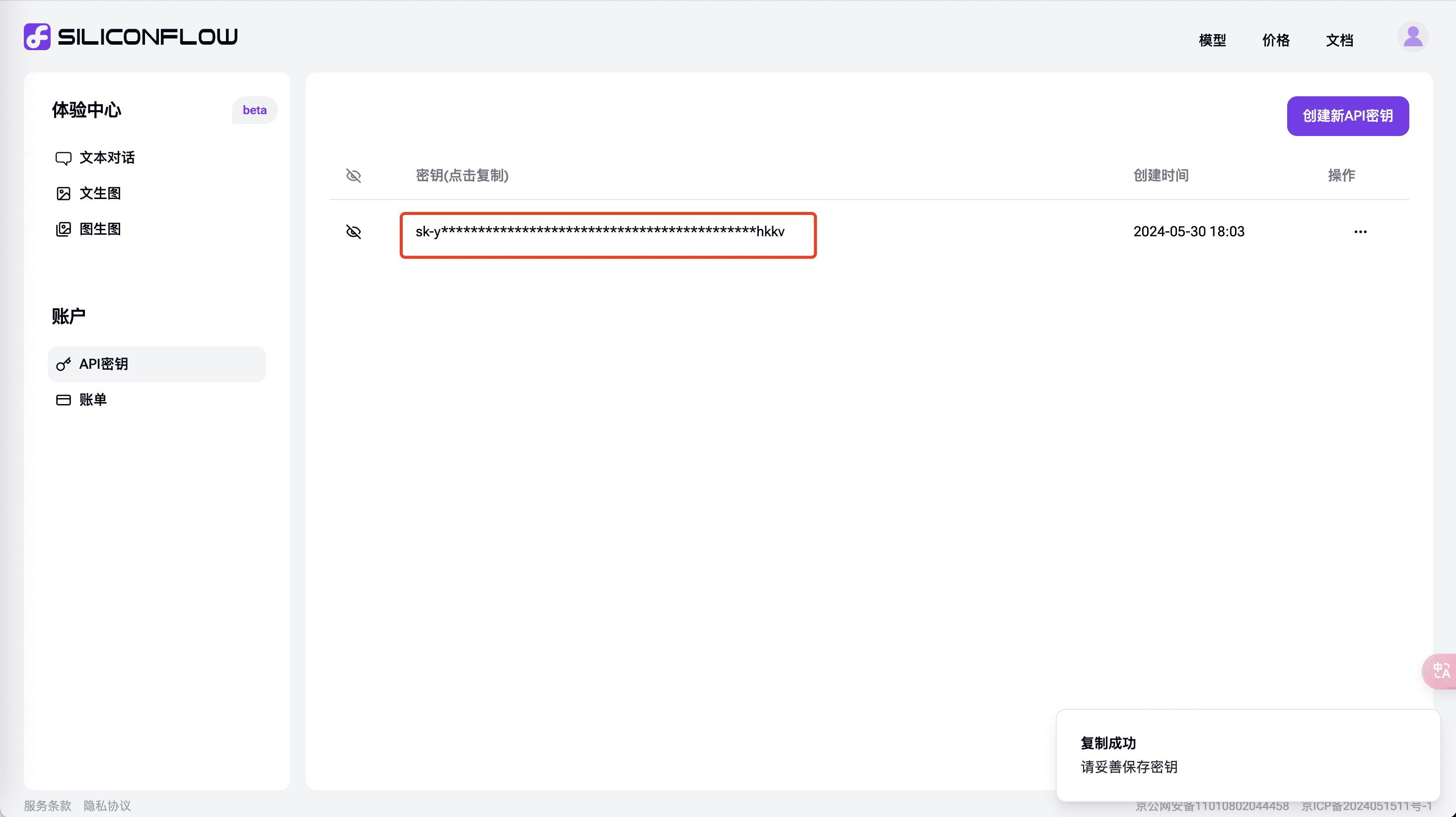

APIキーの生成

APIキー "タブで 新しいAPIキーを作成]をクリックし、[コピー]をクリックしてAPIシナリオで使用します。

イマーシブ翻訳のためのSiliconCloud APIの使用

SiliconCloudのAPI機能を使って、没入型翻訳で高速なクロスランゲージ翻訳を実現する

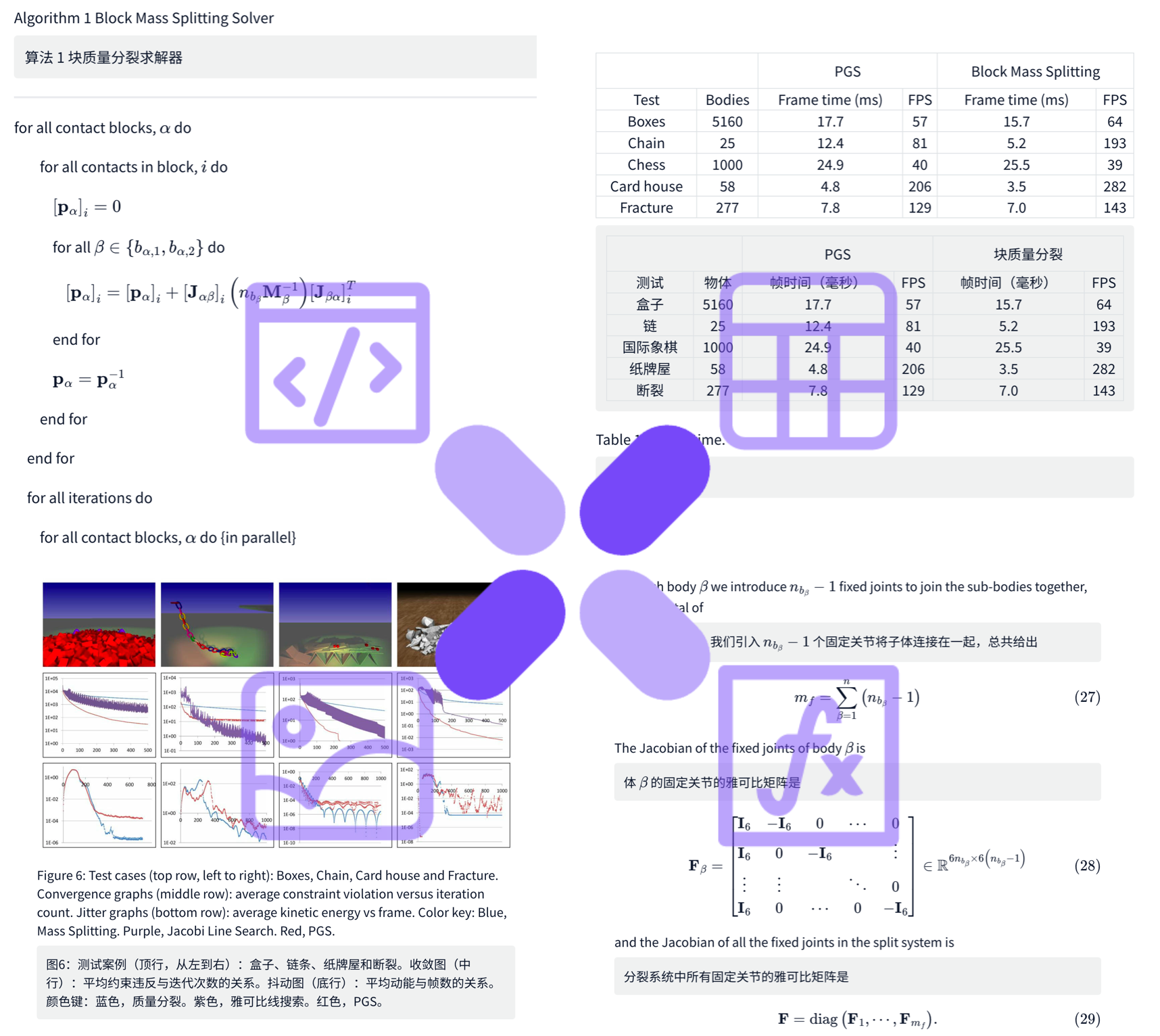

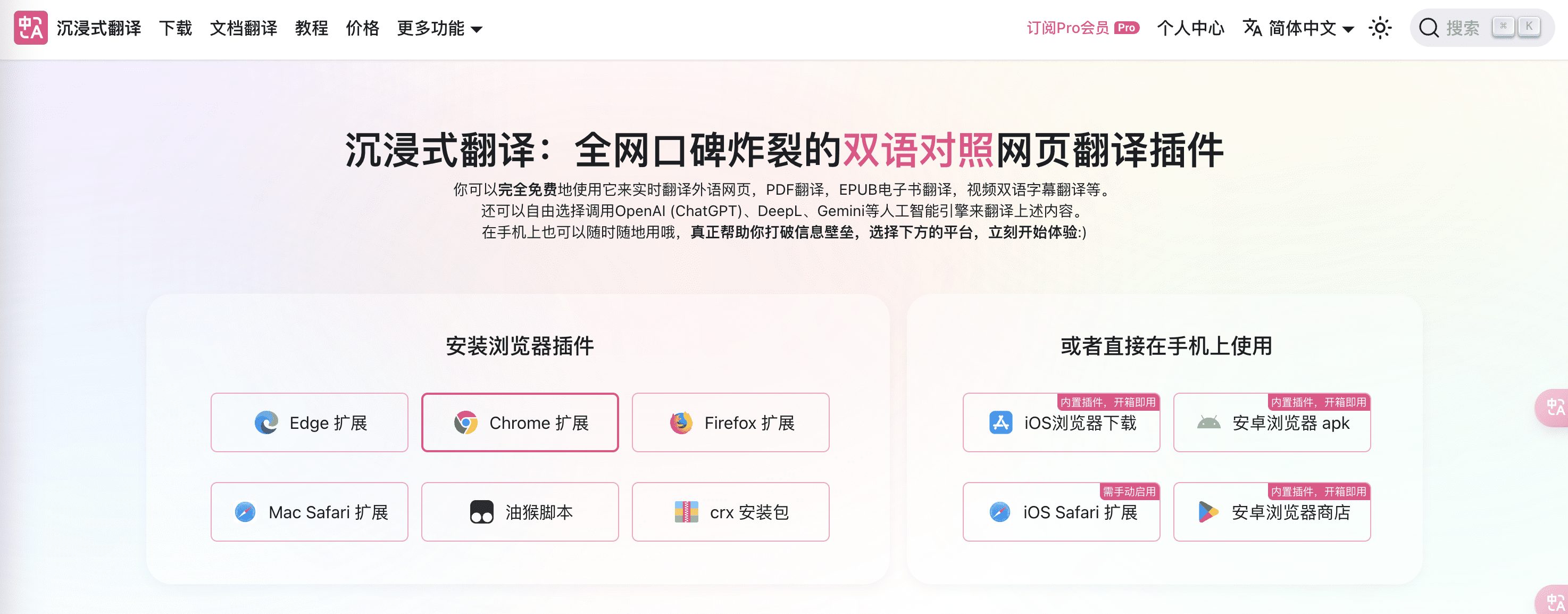

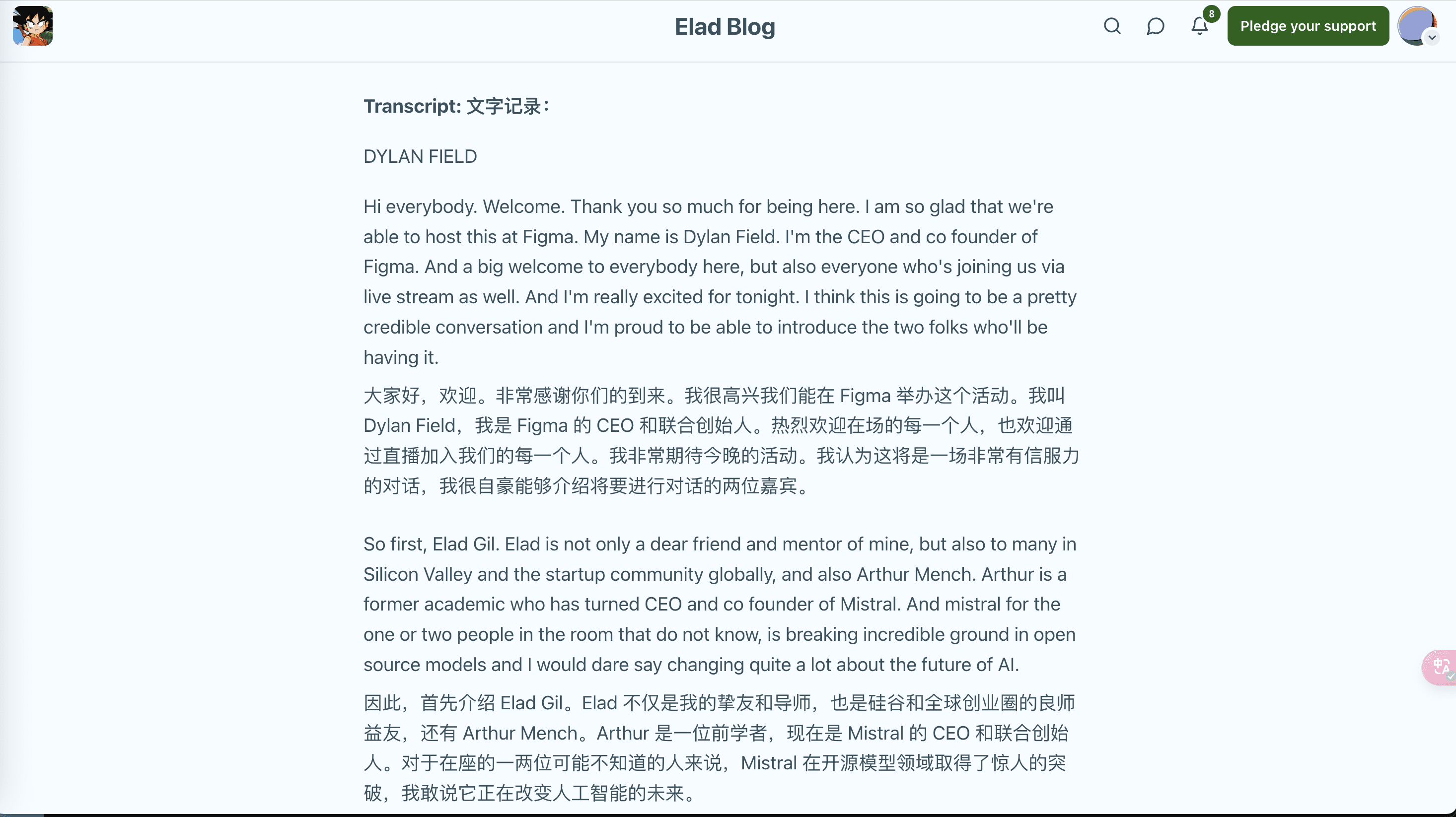

オンライン上で爆発的な評価を得ているバイリンガルウェブページ翻訳プラグインであるImmersive Translationは、Big Language Modelの言語横断理解能力を組み合わせて、外国語コンテンツをリアルタイムで翻訳します。これは、ウェブページの閲覧、PDF翻訳、EPUB電子書籍翻訳、ビデオのバイリンガル字幕翻訳などのシナリオに適用でき、さまざまなブラウザプラグインやアプリの使用をサポートしています。2023年の発売以来、この高い評価を得ているAI対訳ウェブページ翻訳エクステンションは、100万人以上のユーザーが言語の壁を越え、自由にグローバルな知恵を引き出すのに役立っています。

SiliconFlowのSiliconCloudは最近、GLM4、Qwen2、DeepSeek V2、Yiなど、数多くのモデルをいち早く提供しており、モデルも非常に高速です。この2つをどのように組み合わせれば、没入型翻訳シナリオの能力を向上させることができるのでしょうか?

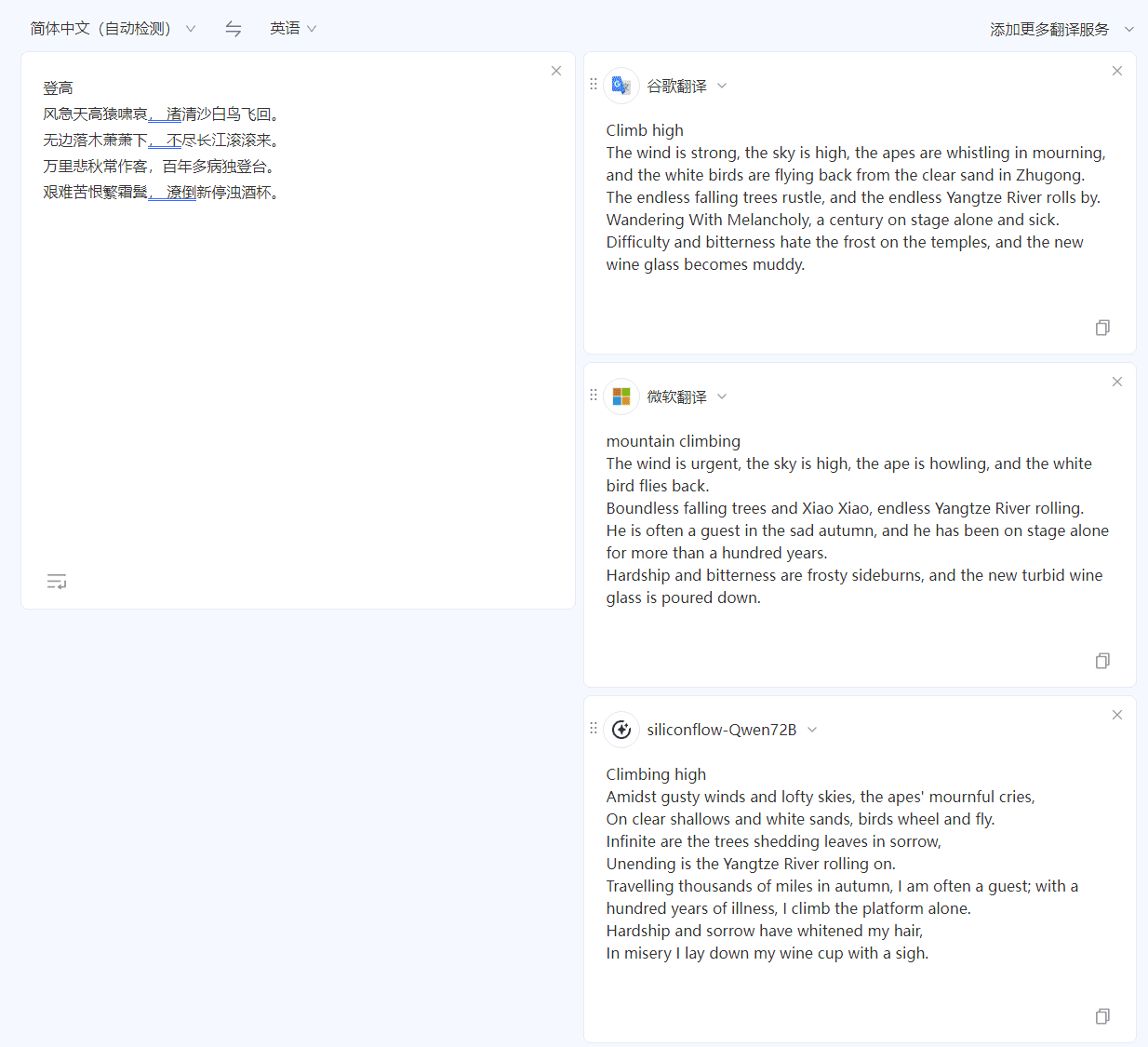

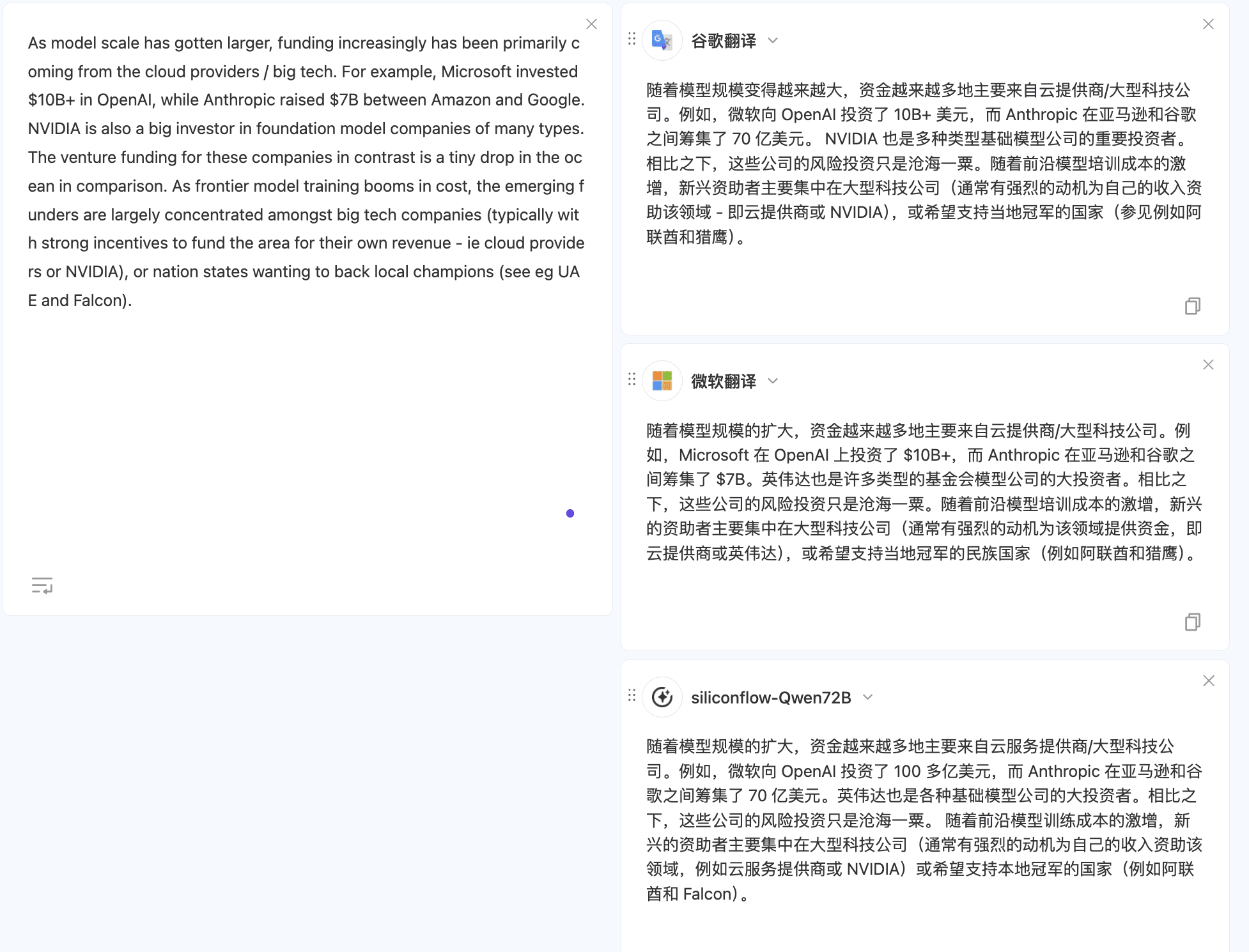

まず治療の有効性を見る

身近な中英翻訳を例にとってみよう。杜甫の名作「昇天覇」を用いて「中英翻訳」テストを行ったところ、グーグル翻訳やマイクロソフト翻訳と比較して、シリコンモビリティが提供するQWen 72Bモデルの方が、より中国語を正確に理解することができ、翻訳文も原文の文体に近いものとなった。

シリコンモビリティが提供するモデルは、同じテキストを英語から中国語に翻訳する際にも、よりスムーズな翻訳でより良い結果を出す。

他のシナリオを試すには、次のようにします。翻訳文書のマルチモデル比較 SiliconCloud関連モデルのコンフィギュレーションについては、「コンフィギュレーション手順」のセクションで詳しく説明しています。

設定手順:デフォルト設定

- Immersive翻訳のウェブサイトから「ブラウザプラグインのインストール」を選択し、指示に従ってください。すでに対応するプラグインをインストールしている場合は、この手順を飛ばしてください。

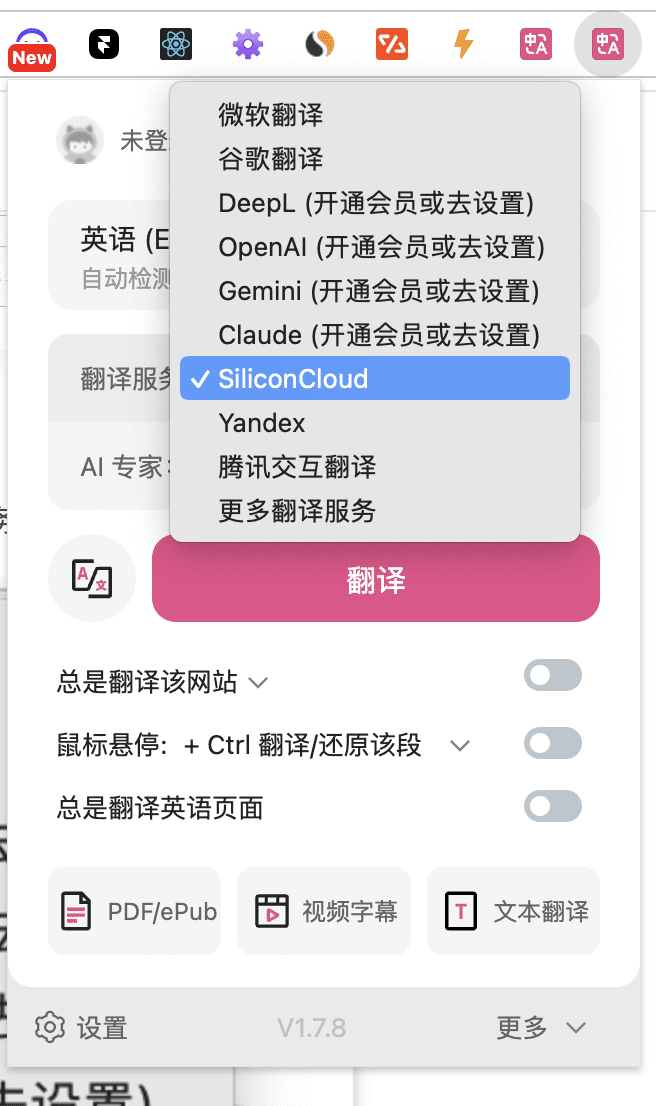

- SiliconCloudの翻訳サービスを利用するには、Immersive Translationアイコンの "Translation Service "を "SiliconCloud "に設定します。

以上でデフォルト設定は完了。

デフォルト設定以外のSiliconCloudの無料モデルを選択します:

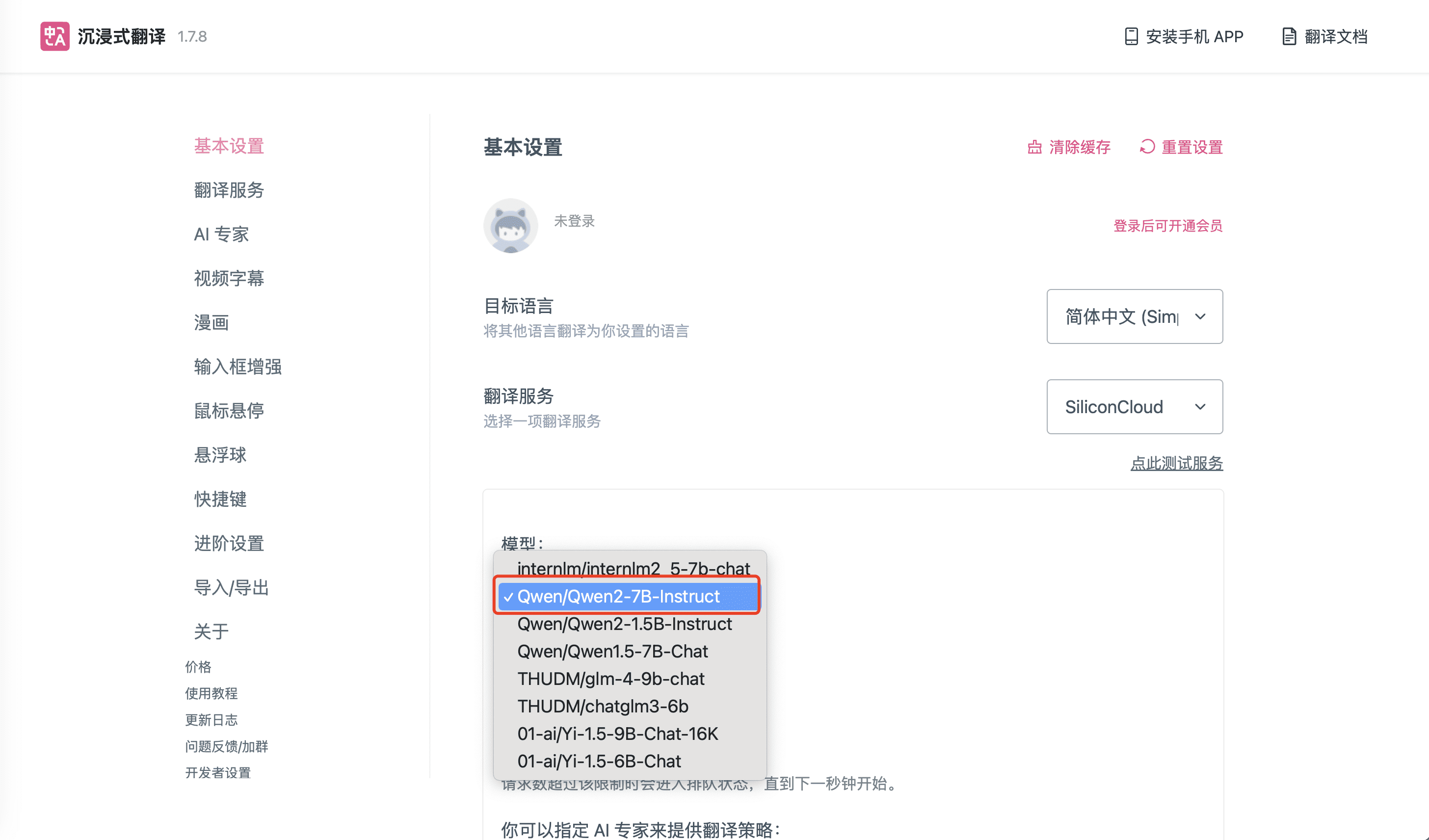

- 上記設定のデフォルトモデルは、SiliconCloudの「Qwen/Qwen2-7B-Instruct」です。他のSiliconCloudモデルに切り替える必要がある場合は、上のアイコンの「設定」をクリックしてください。他のSiliconCloudモデルに切り替える必要がある場合は、上のアイコンの「設定」をクリックしてSiliconCloud関連の設定を行います。

SiliconCloudのデフォルト設定以外のサイズモデルを選択します:

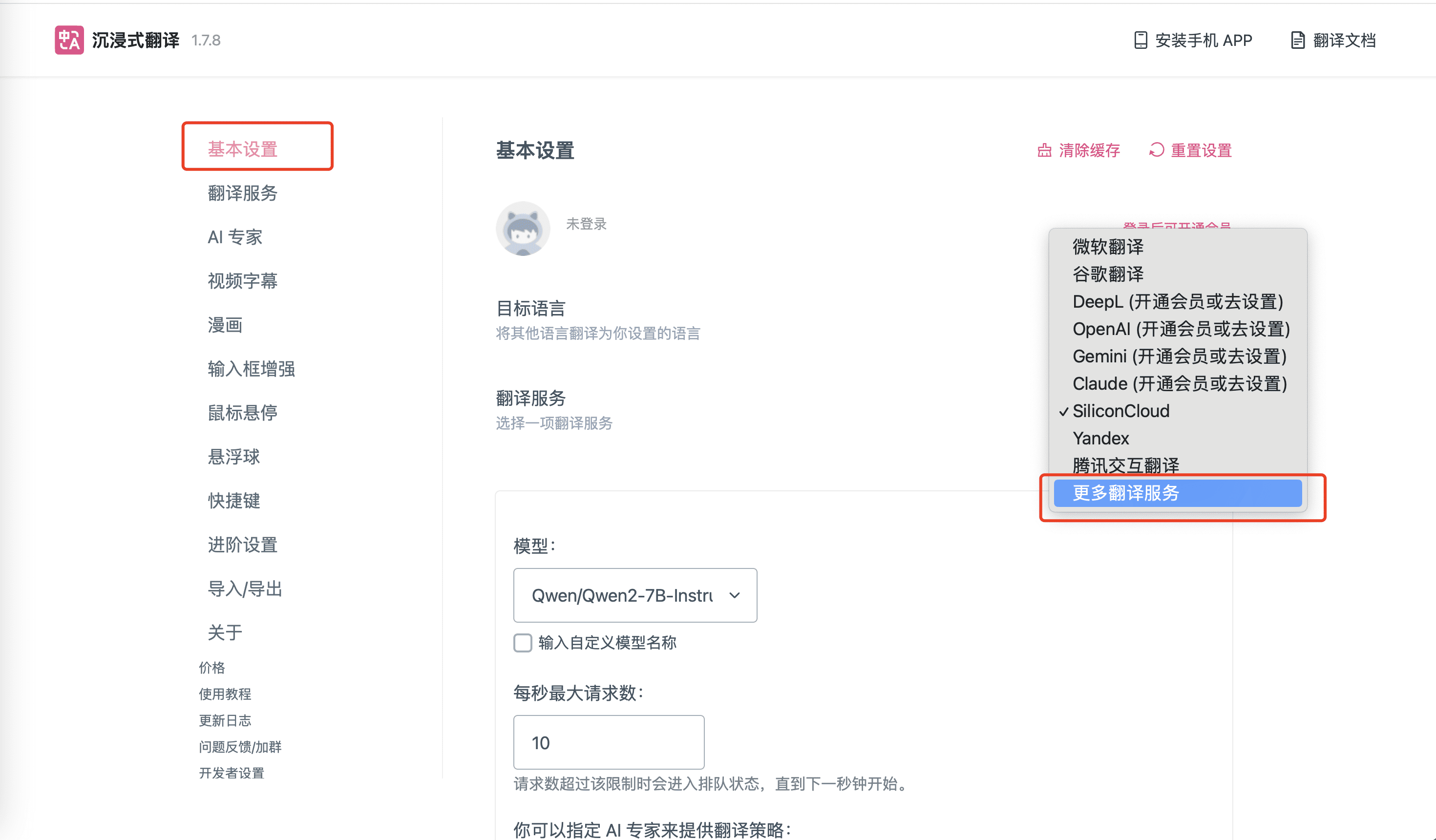

- 上記8モデル以外のSiliconCloudモデルを使用する必要がある場合は、Immersive Translationエクステンションアイコンをクリックし、下図に示すように、対応する "設定 "オプションを見つけ、"その他の翻訳サービス "を選択します。

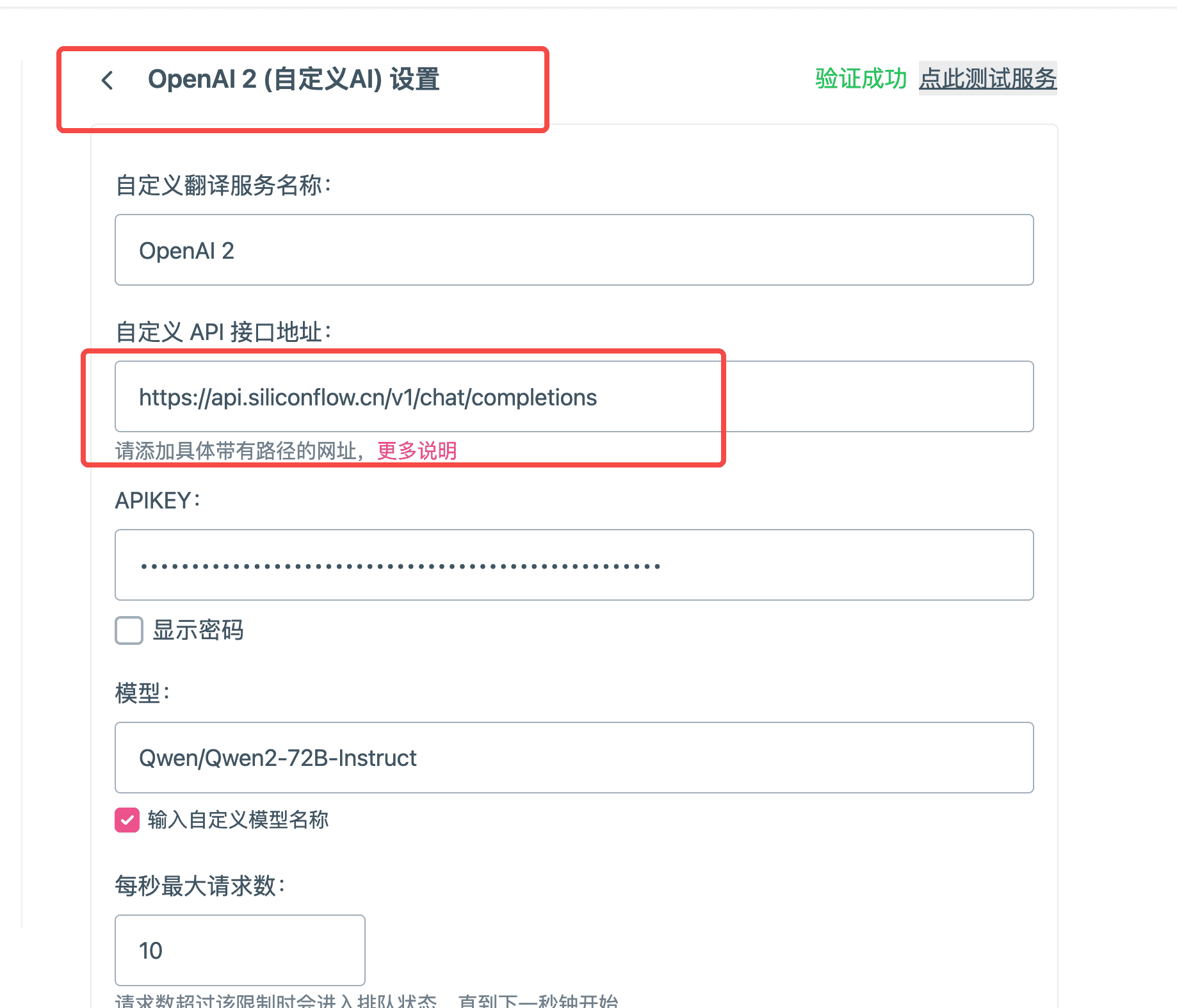

- SiliconCloud モデルに関する情報を追加します!

- カスタマイズされた翻訳サービス名:お客様の実際の状況に応じて名前を記入するだけで、ここでは「Qwen/Qwen2-72B-Instruct」と記入します。

- カスタムAPIインターフェースのアドレス:

APIKEY:よりAPIキー のコピーオーバーをクリックします。

- モデル名:siliconcloudでのモデル名で、ここでは "Qwen/Qwen2-72B-Instruct "とする。プラットフォームモデル一覧現在サポートされているすべてのモデル名を取得する。

- 右上のTestをクリックし、テストが成功したことを確認する。

- 関連するモデル設定項目が完了したので、SiliconCloudが提供する大規模な言語モデルを使用して、Immersive Translatorプラグインで翻訳を提供することができます。

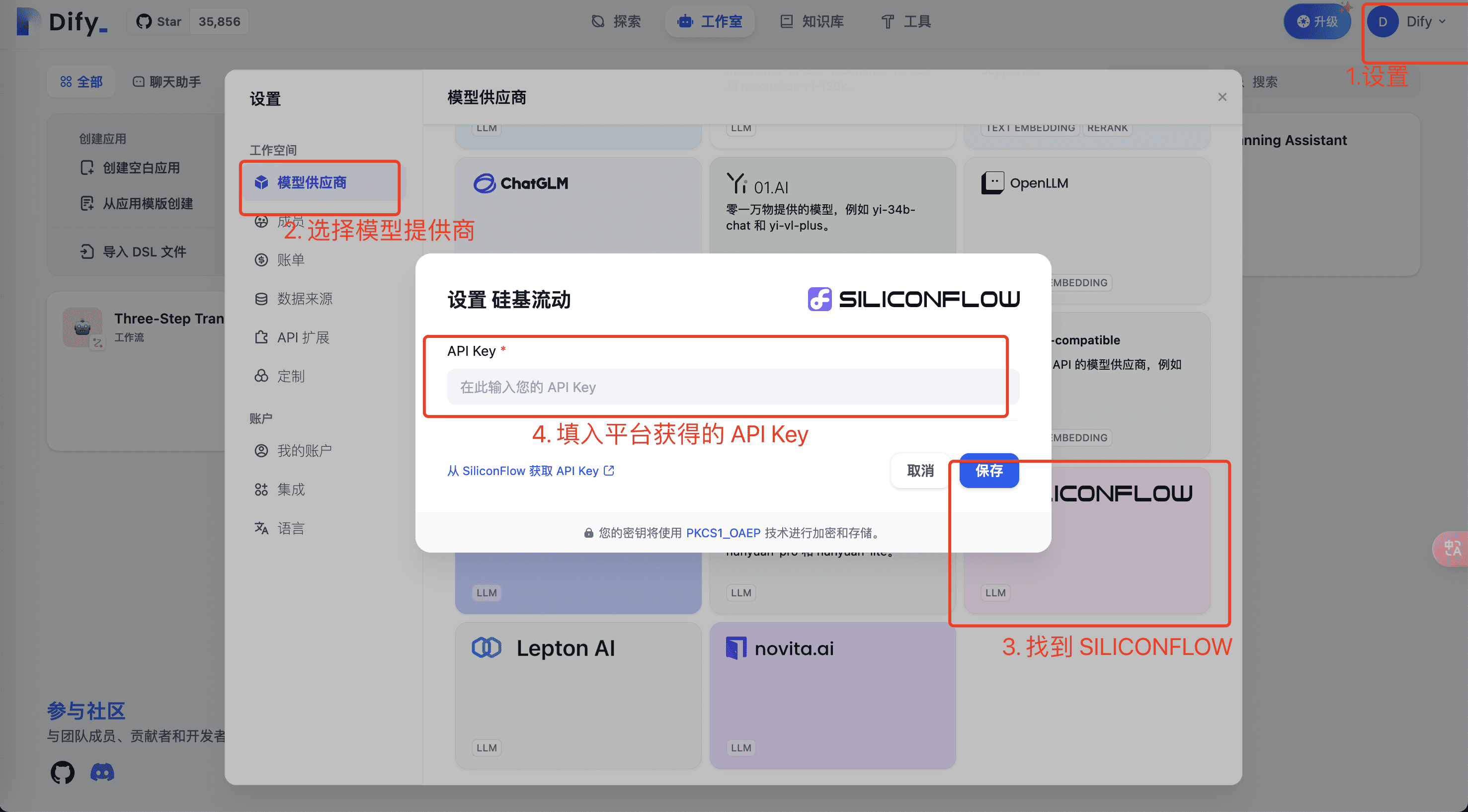

dedify で SiliconCloud API を使用する

利用する ディファイ に組み込まれたSiliconCloudモデルのAPIです。

GLM4、Qwen2、DeepSeek V2、Yiなどの最新機種を初回で提供してくれるし、機種も非常に速い!

- Setupで、SiliconCloudプラットフォームアカウントのモデルとAPI Keyを設定して、大きなモデルを設定します。

- SiliconCloud プラットフォームの関連モデルと API キー情報を入力し、[保存] をクリックして確認します。を使用します。SiliconCloud APIKey現在のユーザーのAPI Keyを取得し、上記の環境にコピーする。

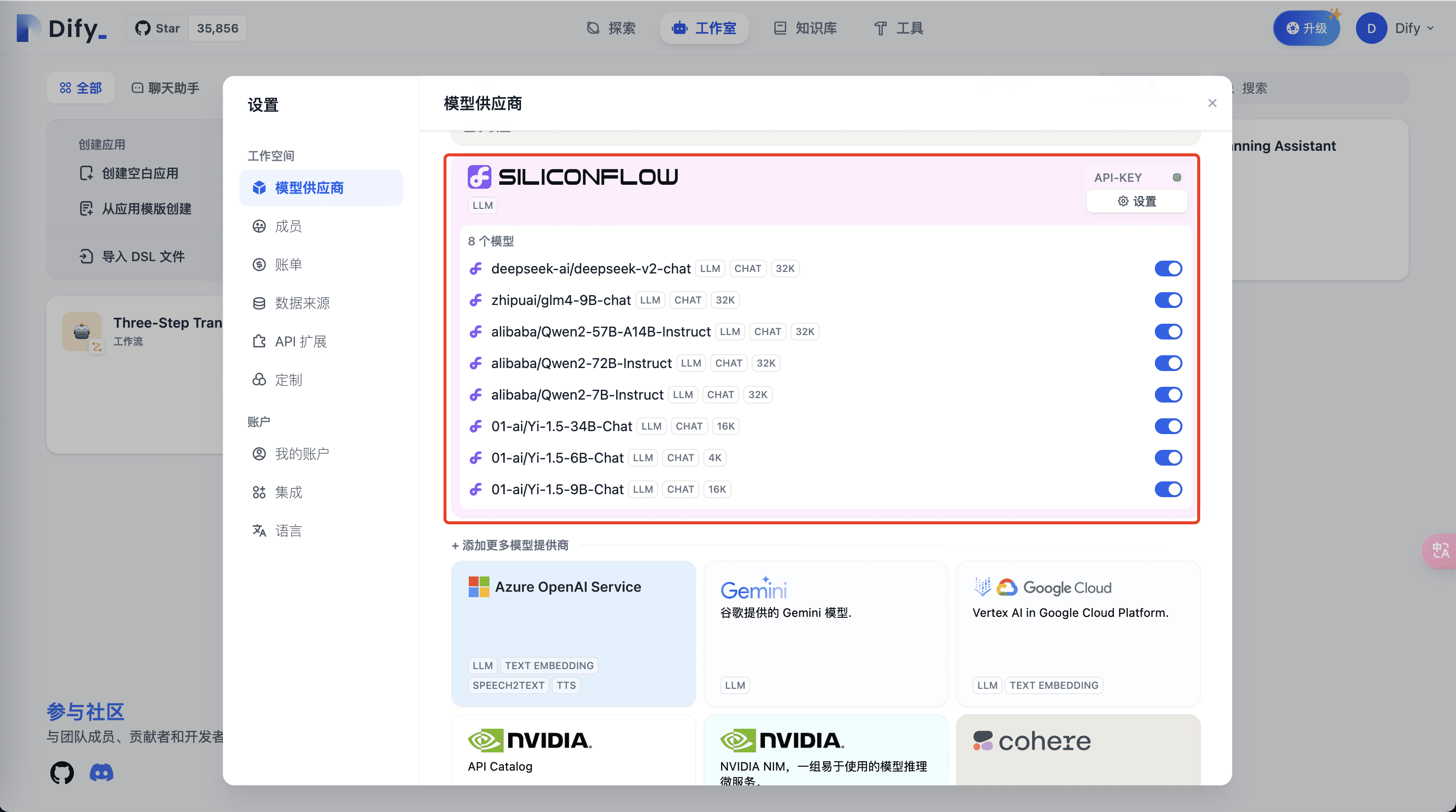

- 次に、モデル・プロバイダの上部にSiliconFlow関連のモデルが表示されます。

- アプリケーションでのSiliconCloud対応モデルの使用

以上の手順で、SiliconFlowが提供する豊富で高速なLLMモデルをDify開発アプリケーションで使用する準備が整いました。

現在difyのソースコードにないSiliconCloudモデル

現在、SiliconCloudにはまだ新しいモデルが導入されており、両者の反復リズムのため、Difyで最初に紹介できないモデルもあり、ここでは以下のプロセスに従って設定されています。

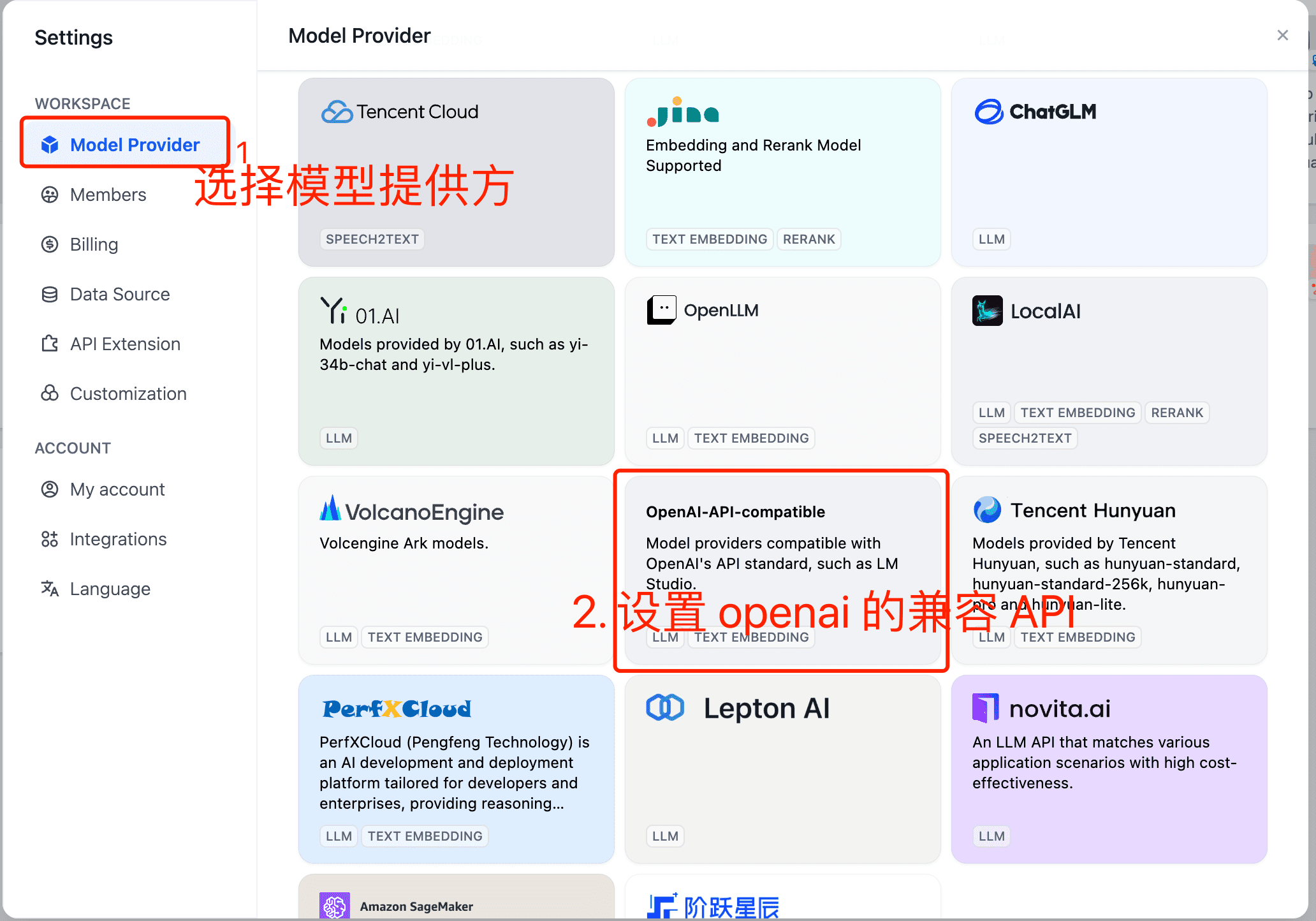

- difyの設定を開き、設定を行う。

- 設定で、Model Providerを選択し、"openai compatible API "を設定する。

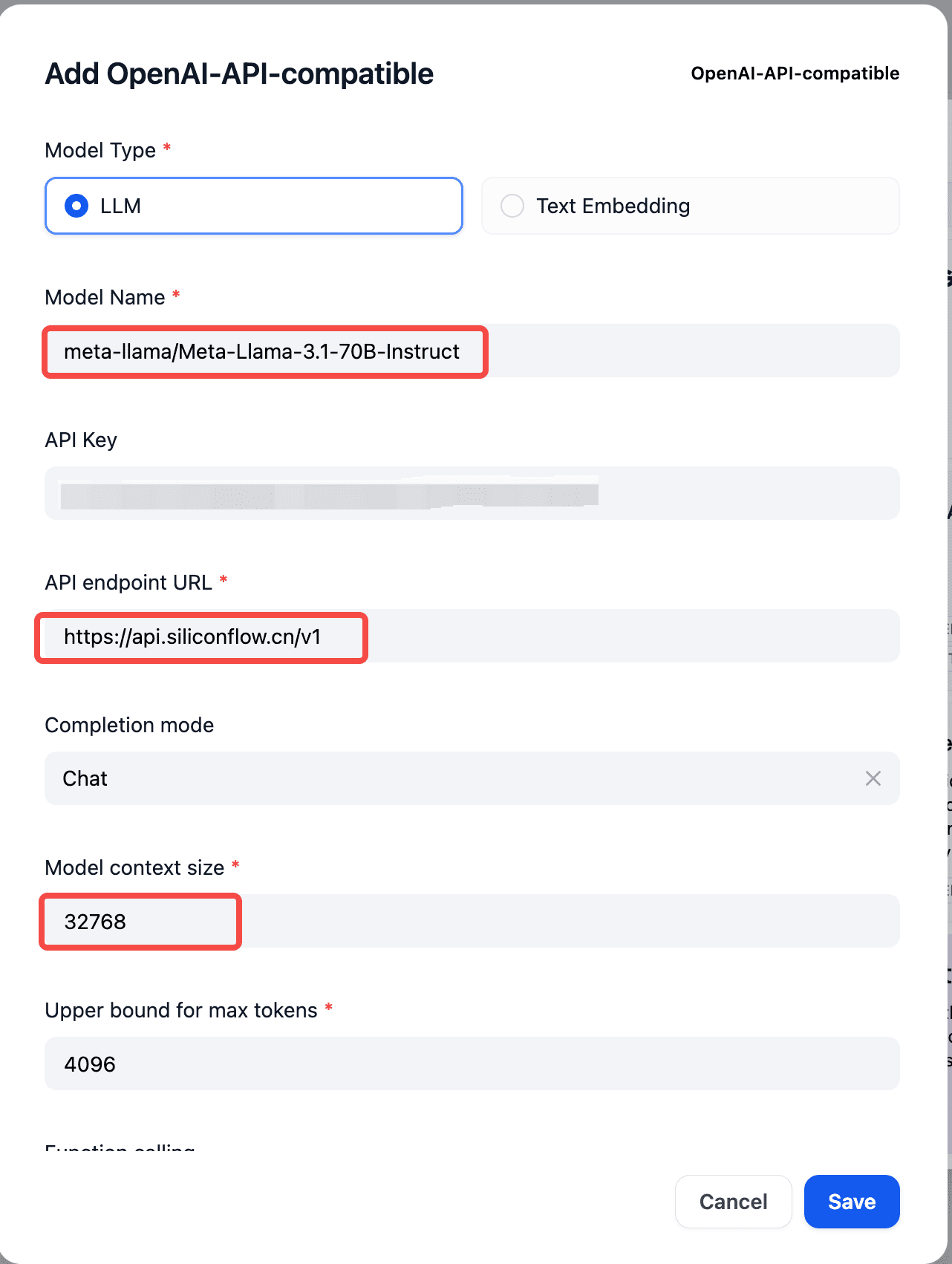

- で、対応する SiliconCloud のモデル名、API キー、API エンドポイント API を設定します。

モデル名:fromhttps://docs.siliconflow.cn/reference/chat-completions-1 文書を見てください。

APIキーhttps://cloud.siliconflow.cn/account/ak 海外モデルをご使用の場合は、以下の点にご注意ください。https://docs.siliconflow.cn/docs/use-international-outstanding-models 実名認証に関する文書規則。

APIエンドポイントのURL:https://api.siliconflow.cn/v1

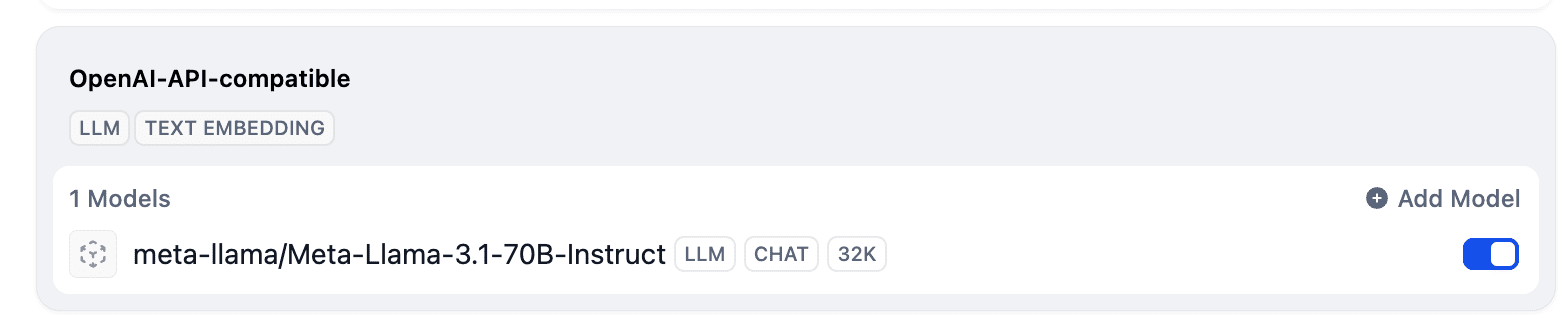

- セットアップが完了すると、モデルリストに上記の追加されたモデルが表示されます。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません