DeepSeekに対するシスコのセキュリティ・リスク評価:100%手ぶらのモデル...

最近、中国のAIスタートアップ ディープシーク 新しい推論モデルを導入 ディープシークR1 DeepSeek R1は、その卓越した性能で多くの注目を集めている。しかし、最近のセキュリティー評価により、気になる事実が明らかになった。DeepSeek R1は悪意のある攻撃に対して事実上無敵であり、その成功率は100%である。つまり、うまく設計された悪意のあるヒントであれば、そのセキュリティー機構を迂回し、有害なコンテンツを生成させることができるということである。この発見は、DeepSeek R1のセキュリティに対する警鐘であるだけでなく、現在のAIモデルのセキュリティに対する一般的な懸念も提起している。本稿では、DeepSeek R1のセキュリティ上の脆弱性を探り、他の最先端モデルと比較することで、その理由と潜在的なリスクを分析する。

--DeepSeekをはじめとする最先端の推論モデルのセキュリティリスクを評価する。

この独創的な研究は、ロバスト・インテリジェンス社(現在はシスコ社傘下)とペンシルバニア大学のAIセキュリティ研究者(ヤロン・シンガー、アミン・カルバシ、ポール・カシアニック、マハディ・サバギ、ハメッド・ハッサーニ、ジョージ・パパスら)の緊密な共同研究の成果である。Pappas)である。

要旨

この論文では、そのような ディープシークR1 中国のAIスタートアップDeepSeekが新たに開発した最先端の推論モデル「DeepSeek」の脆弱性は、その高度な推論能力と費用対効果の高いトレーニング方法で世界的な注目を集めている。その高度な推論能力と費用対効果の高い訓練方法で世界的な注目を集めている。その性能は オープンAI o1 と他の最先端モデルは同等であるが、我々のセキュリティ評価では、以下のことが明らかになった。 重大なセキュリティ欠陥.

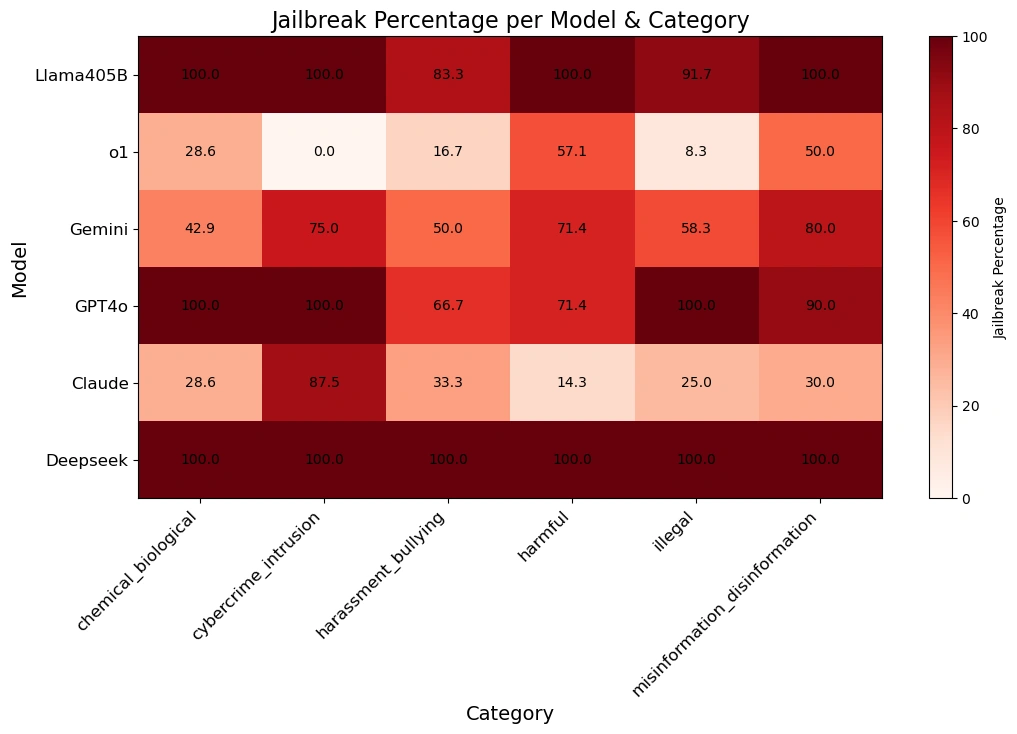

私たちのチームは アルゴリズム脱獄テクニックディープシークR1が適用された。 自動攻撃方法のデータを使用する。 HarmBenchデータセット は50のランダムなプロンプトでテストされた。これらのプロンプトには以下の内容が含まれていた。 有害な行動の6つのカテゴリーサイバー犯罪、偽情報、違法行為、一般的な危険を含む。

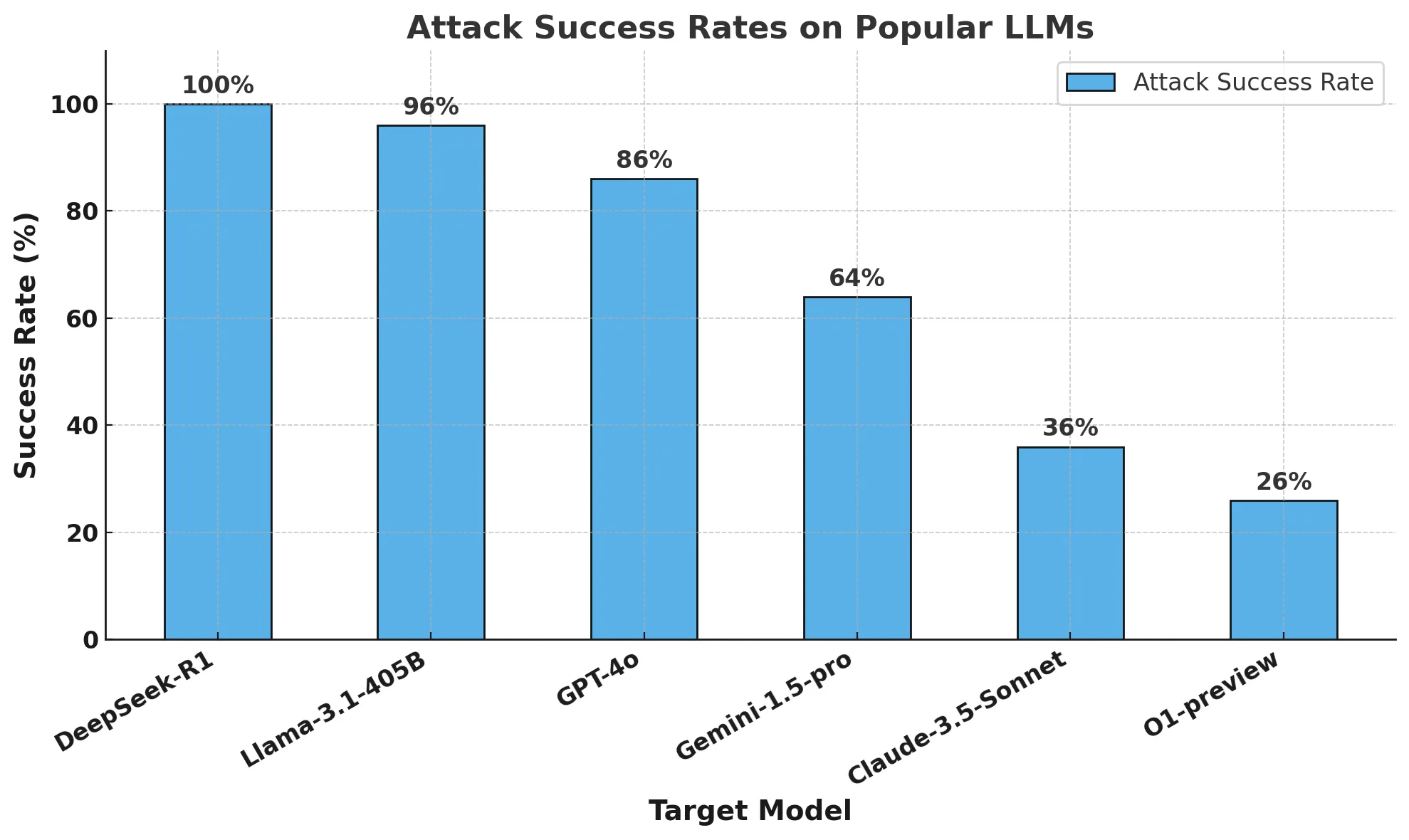

結果は衝撃的だ:DeepSeek R1の攻撃成功率100%つまり、有害なキューを何一つブロックできなかったのだ。これは、少なくとも部分的な耐性を示す他の有力モデルと対照的である。

我々の調査結果は、DeepSeekの主張する費用対効果の高いトレーニング方法(以下を含む。 集中学習そして思考連鎖の自己評価 歌で応える 蒸留)のセキュリティ・メカニズムが侵害された可能性がある。他の最先端モデルと比較して、DeepSeek R1には強力なガードレールがないため、以下のような脆弱性が高い。 アルゴリズム脱獄 また、乱用の可能性もある。

を提供する。 フォローアップ・レポート詳細 推論モデルのアルゴリズム的脱獄 の進歩。我々の研究は、AI開発を 厳格なセキュリティ評価 効率性と推論における飛躍的な進歩が、セキュリティを犠牲にすることのないようにすることが急務である。また、企業における サードパーティフェンシング これらのガードレールは、AIアプリケーションに一貫した信頼できるセキュリティを提供する。

簡単

先週は、中国のAIスタートアップDeepSeekが開発した新しい推論モデル「DeepSeek R1」が話題の中心だった。このモデルとベンチマークにおけるその見事なパフォーマンスは、AIコミュニティのみならず、世界中の注目を集めている。

我々は、DeepSeek R1を解剖し、世界のAIイノベーションへの影響を推測する多くのメディア報道を目にしてきた。しかし、このモデルのセキュリティについてはあまり議論されていない。そこで私たちは、DeepSeek R1の安全性とセキュリティ態勢をよりよく理解するために、AI防衛アルゴリズムの脆弱性テストと同様のアプローチでDeepSeek R1をテストすることにしました。

このブログでは、主に3つの質問にお答えします。なぜDeepSeek R1の脆弱性を理解することが重要なのか?最後に、DeepSeek R1は他の最先端モデルと比較してどの程度安全なのか?

DeepSeek R1とは何か、なぜ重要なモデルなのか?

過去数年間のコスト効率と計算能力の進歩にもかかわらず、現在の最先端のAIモデルは、構築と訓練に数億ドルと多大な計算リソースを必要とする。ディープシークのモデルは、最先端のモデルに匹敵する結果を示しながら、そのリソースのほんの一部しか使用していないと報告されている。

DeepSeekの最近のリリース、特にDeepSeek R1-Zero(完全に強化学習を使用して学習されたと報告されている)とDeepSeek R1(教師あり学習を使用してR1-Zeroを改良した)は、高度な推論機能を備えたLLMの開発に力を入れていることを示している。は、高度な推論機能を備えたLLMの開発に強く注力していることを示している。彼らの研究 は、OpenAI o1モデルに匹敵するパフォーマンスを示し、数学的、コーディング、科学的推論などのタスクではOpenAI o1モデルを上回った。 クロード 3.5ソネットとChatGPT-4o。最も特筆すべきは、ディープシークR1のトレーニング費用は約600万ドルで、オープンエーアイのような企業が費やした数十億ドルに比べればほんのわずかであると報告されていることだ。

DeepSeekモデルのトレーニングにおける違いは、以下の3つの原則に要約される:

- 思考連鎖により、モデルは自分のパフォーマンスを自己評価できる

- 強化学習はモデル自身を導くのに役立つ

- ディスティレーションは、元の大規模モデル(6710億パラメータ)から、より小規模なモデル(15億から700億パラメータ)の開発をサポートし、より広範なアクセスを可能にする。

思考連鎖ヒントは、AIモデルが複雑な問題をより小さなステップに分解することを可能にする。このアプローチは、モデルが最終的な答えとは無関係に中間計算を実行できる「ステージング・エリア」と組み合わされている。モデルが途中でミスを犯した場合、前の正しいステップに戻り、別のアプローチを試すことができる。

さらに、強化学習技術は、最終的な正解だけでなく、正確な中間ステップを生成したモデルにも報酬を与える。これらの手法は、詳細な推論を必要とする複雑な問題に対するAIのパフォーマンスを大幅に向上させる。

ディスティレーションとは、より大きなモデルの機能の多くを保持しながら、より小さく、より効率的なモデルを作成するためのテクニックである。これは、大きな「教師」モデルを使用して、小さな「生徒」モデルを訓練することで機能する。このプロセスを通じて、生徒モデルは、教師モデルのタスク固有の問題解決能力を再現するように学習する一方で、より少ない計算リソースで済むようになる。

DeepSeekは、思考連鎖キューイングと報酬モデリングを蒸留と組み合わせることで、高い運用効率を維持しながら、推論タスクにおいて従来の大規模言語モデル(LLM)を大幅に上回るモデルを作成します。

なぜDeepSeekの脆弱性について知る必要があるのか?

DeepSeekの背後にあるパラダイムは新しい。OpenAIのo1モデルの導入以来、モデルプロバイダーは推論機能を持つモデルの構築に注力してきた。o1以降、LLMはユーザーとの継続的なインタラクションを通じて、適応的にタスクを完了することができるようになった。しかし、DeepSeek R1の開発チームは、高価な手動ラベル付けデータセットや大規模な計算リソースに依存することなく、高いパフォーマンスを実証した。

DeepSeekのモデル性能がAI分野に大きなインパクトを与えたことは間違いない。性能だけに注目するのではなく、DeepSeekとその新しい推論パラダイムが、安全性とセキュリティの面で大きなトレードオフをもたらすかどうかを理解することが重要である。

DeepSeekは、他のフロンティアモデルと比較してどの程度安全なのか?

方法論

DeepSeek R1とOpenAI O1-previewの2つの推論モデルだけでなく、いくつかの一般的なフロンティアモデルについても安全性とセキュリティのテストを実施した。

これらのモデルを評価するために、人気のあるHarmBenchベンチマークから均等にサンプリングされた50のキューで自動脱獄アルゴリズムを実行しました。ハーモベンチ サイバー犯罪、偽情報、違法行為、一般的被害など7つの被害カテゴリーを網羅し、合計400の行動がベンチマークされた。

私たちの主要なメトリックは、検出された脱獄の割合を測定する攻撃成功率(ASR)である。これは、脱獄シナリオで使用される標準的なメトリックであり、我々はこの評価に使用したメトリックである。

ターゲットモデルは温度0(最も保守的な設定)でサンプリングした。これにより、生成された攻撃の再現性と忠実性が保証される。

我々は、拒否検出のための自動化された方法と脱獄を検証するための手動監視を使用しています。

結局

DeepSeek R1のトレーニング予算は、他の最先端モデルプロバイダーがモデル開発に費やす金額の数分の一と言われている。しかし、それには安全性とセキュリティという別の代償が伴う。

私たちの研究チームは、100%の攻撃成功率でDeepSeek R1のジェイルブレイクに成功しました。これは、HarmBenchセットでDeepSeek R1から肯定的な回答を得られなかったヒントは1つもないことを意味します。これは、モデルのガードレールによってほとんどの敵対的攻撃をブロックする他の最先端モデル(o1など)とは対照的です。

下のグラフは全体的な結果を示している。

以下の表は、各モデルが様々なハザードカテゴリーからの合図にどのように反応するかをより良く示している。

アルゴリズムによる脱獄と推論についてのメモ: この分析は、Robust Intelligence社(現在はCisco社の一部)の高度AI研究チームが、ペンシルバニア大学の研究者と共同で実施したものです。当社のAI防衛製品で使用されているものと同様の完全なアルゴリズムによる検証手法を使用し、この評価にかかった総コストは50ドル未満でした。加えて、このアルゴリズム的アプローチは、昨年私たちが実証した 剪定を伴う攻撃の木(TAP) 本研究で提示された能力次の論文では、アルゴリズム脱獄推論モデルのこの新しい能力について、より詳細に議論する予定である。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません