無料のGPUパワーでDeepSeek-R1オープンソースモデルをオンライン展開

Tencent Cloud Cloud StudioとDeepSeek DeepSeek-R1に感謝する。

AIとビッグモデル技術の急速な発展に伴い、より多くの開発者や研究者が、これらの先進技術をよりよく理解し、応用するために、ビッグモデルを自分自身で体験し、微調整したいと考えています。しかし、GPU演算の高コストがボトルネックとなり、誰もがビッグモデルを探求することができない。幸いなことに、Tencent Cloud StudioはGPU演算リソースを無料で提供しており、DeepSeekが導入したDeepSeek-R1ビッグモデルと組み合わせることで、1セントも費やすことなく、これらの強力なモデルをクラウド上で簡単に展開し、実行することができます。

この記事では、Tencent Cloudの使用方法について詳しく説明します。 クラウドスタジオ DeepSeek-R1マクロモデルをデプロイして対話するための無料のGPUリソースを紹介します。Cloud Studioの使用から始め、Ollamaのインストールと設定をステップ・バイ・ステップで行います。 ディープシーク-R1 と話しかければ、DeepSeek-R1 + 以下のセットを無料で手に入れることができる。 ルー・コード 無料のプログラミング・ポートフォリオ・プログラム。

1.クラウドスタジオ

1.1 Cloud Studioの紹介

Tencent Cloud Cloud Studioはクラウドベースの統合開発環境(IDE)で、開発者がより効率的にコーディング、デバッグ、デプロイできるよう、豊富な開発ツールとリソースを提供している。最近、Cloud StudioはGPUコンピューティングリソースの無料提供を開始し、ユーザーは16Gのビデオメモリ、32GのRAM、8コアのCPUで構成されたGPUサーバーを毎月1万分間無料で利用できる。(使用後にマシンを閉じて、次の微調整をポイントし、それを開くことを忘れないでください、環境は自動的に保存され、毎月10,000分は、単に使い切ることはできません)。

1.2 登録とログイン

Cloud Studioを使用するには、まずTencent Cloudアカウントを登録する必要があります。登録が完了し、Cloud Studioにログインすると、様々な開発テンプレートから選択できるクリーンなユーザーインターフェースが表示されます。これらのテンプレートは、基本的なPython開発から複雑な大規模モデルのデプロイまで、幅広いシナリオをカバーしています。Proバージョンを忘れずに入力してください。

1.3 Ollamaテンプレートの選択

われわれのゴールは、このような ディープシーク-R1 を選択すればよい。 オーラマ Templates.Ollamaは、大規模なモデルを管理・実行するためのツールで、モデルのダウンロード、インストール、実行のプロセスを簡素化します。Ollamaテンプレートを選択すると、Cloud Studioが自動的にOllama環境を設定してくれるため、手動でインストールする必要がありません。

ブートを待ち、Enterをクリックする(Ollamaはすでに環境にデプロイされているので、インストールコマンドを直接実行するだけでよい)。

2.オーラマ

2.1 Ollamaの紹介

Ollamaは、様々な大規模モデルの管理と実行に特化したオープンソースツールです。様々なモデル形式をサポートし、モデルの依存関係を自動的に処理することができるため、モデルの展開と実行が非常にシンプルになります。Ollamaの公式ウェブサイトでは、豊富なモデルリソースを提供しており、ユーザーは必要に応じて適切なモデルを選択してダウンロードし、実行することができます。

2.2 モデルのパラメータと選択

Ollamaの公式サイトでは、各モデルの下部に7B、13B、70Bなど、各モデルのパラメータ数が表記されている。ここでの "B "は10億を表し、モデルのパラメータ数を示している。パラメータ数が多いほど、モデルの複雑さと能力は高くなるが、その分コンピューティングリソースも多く消費する。

Tencent Cloud Studioが提供する無料のGPUリソース(16Gのビデオメモリ、32GのRAM、8コアのCPU)の場合、8Bまたは13Bのモデルを選択して展開することができます。それ以上のハードウェア構成をお持ちの場合は、より良い結果を得るために、より大きなパラメータを持つモデルを試すこともできます。

2.3 Ollamaのインストール

Cloud StudioでOllamaテンプレートを選択すると、システムが自動的にOllamaをインストールしてくれます。他の環境でOllamaを使っている場合は、以下のコマンドでインストールできます:

curl -fsSL https://ollama.com/install.sh | shインストールが完了したら、以下のコマンドを使用して、Ollamaが正常にインストールされたことを確認できます:

ollama --version次のステップは、OllamaがDeepSeek-R1を展開することだ。

3.DeepSeek-R1の無料展開

3.1 DeepSeek-R1 の概要

DeepSeek-R1は、DeepSeek社の高性能な大規模モデルで、特にテキスト生成、対話システム、Q&Aの分野で、多くの自然言語処理タスクで優れた性能を発揮します。DeepSeek-R1のパラメータ数は8Bから70Bまであり、ユーザーはハードウェア構成に応じて導入に適したモデルを選択できます。

3.2 ダウンロードと配備

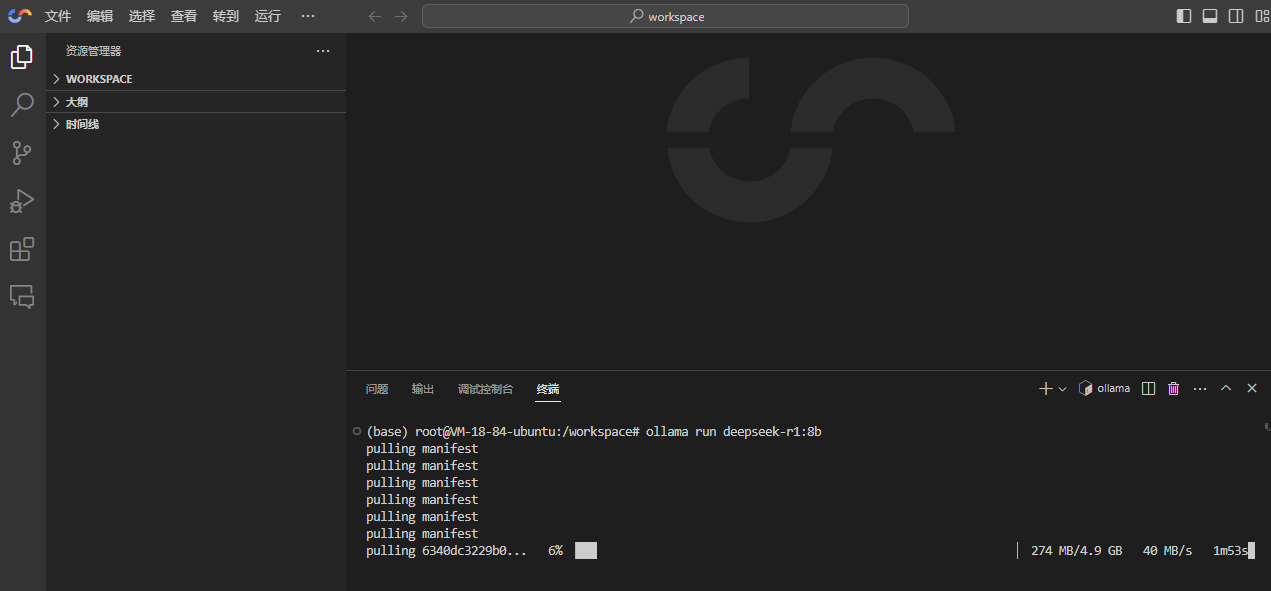

DeepSeek-R1のデプロイは、Cloud StudioがすでにOllamaを自動的にインストールしているため、非常に簡単です。以下のコマンドを実行するだけです:

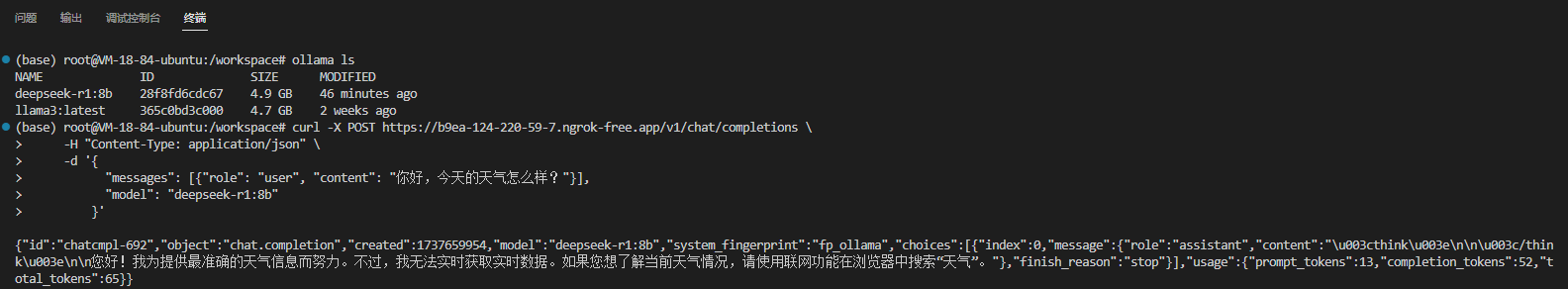

ollama run deepseek-r1:8b

DeepSeek-R1で使用可能なすべてのモデルはこちら:https://ollama.com/library/deepseek-r1 、推奨! ollama run deepseek-r1:14b (これがクウェンの蒸留モデルだ)。

3.3 モデル走行

モデルのダウンロードが完了するのを待つと、Ollama は自動的に DeepSeek-R1 を起動し、対話モードに入ります。この時点で、ターミナルに質問やコマンドを直接入力して、DeepSeek-R1 と対話できます。

4.DeepSeek-R1とチャットを始める

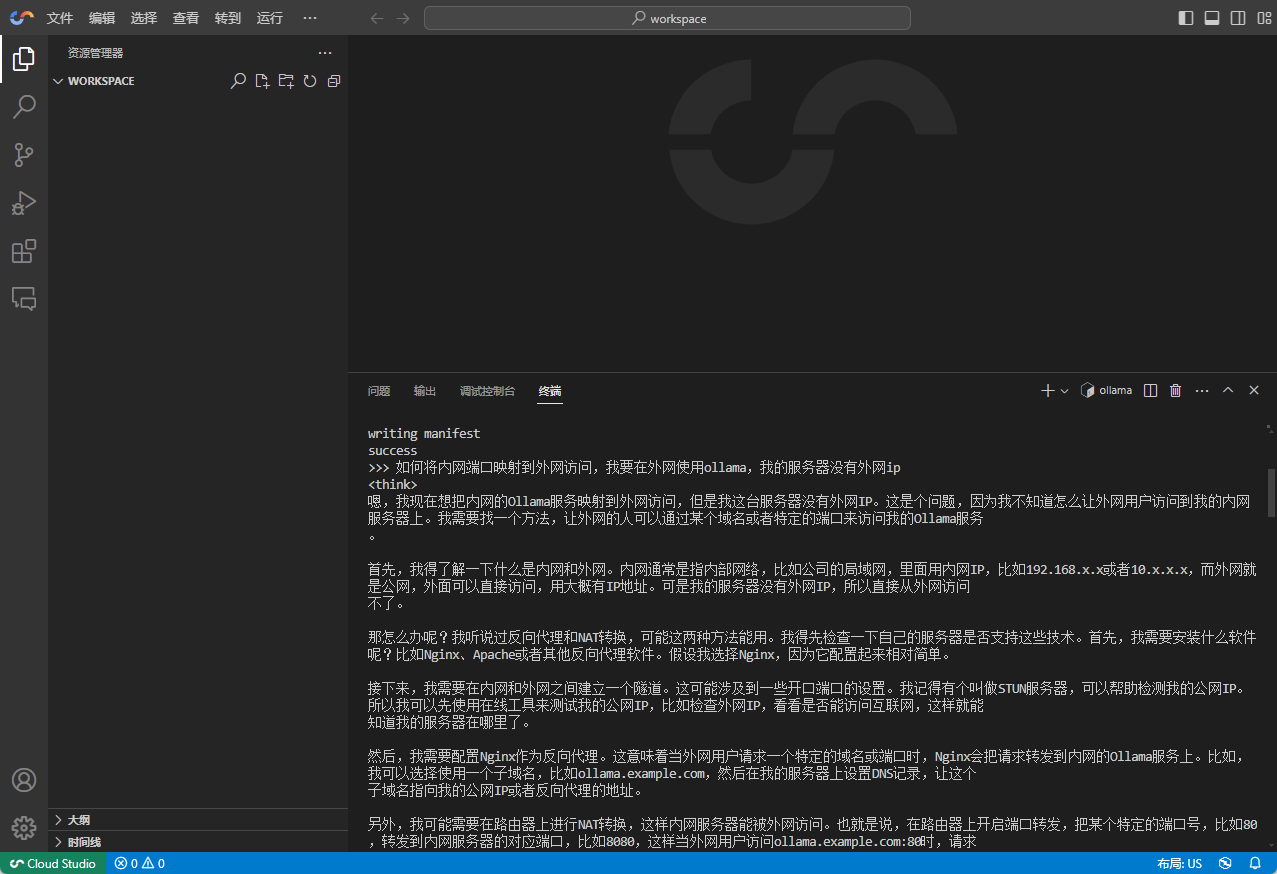

4.1 基本的な対話

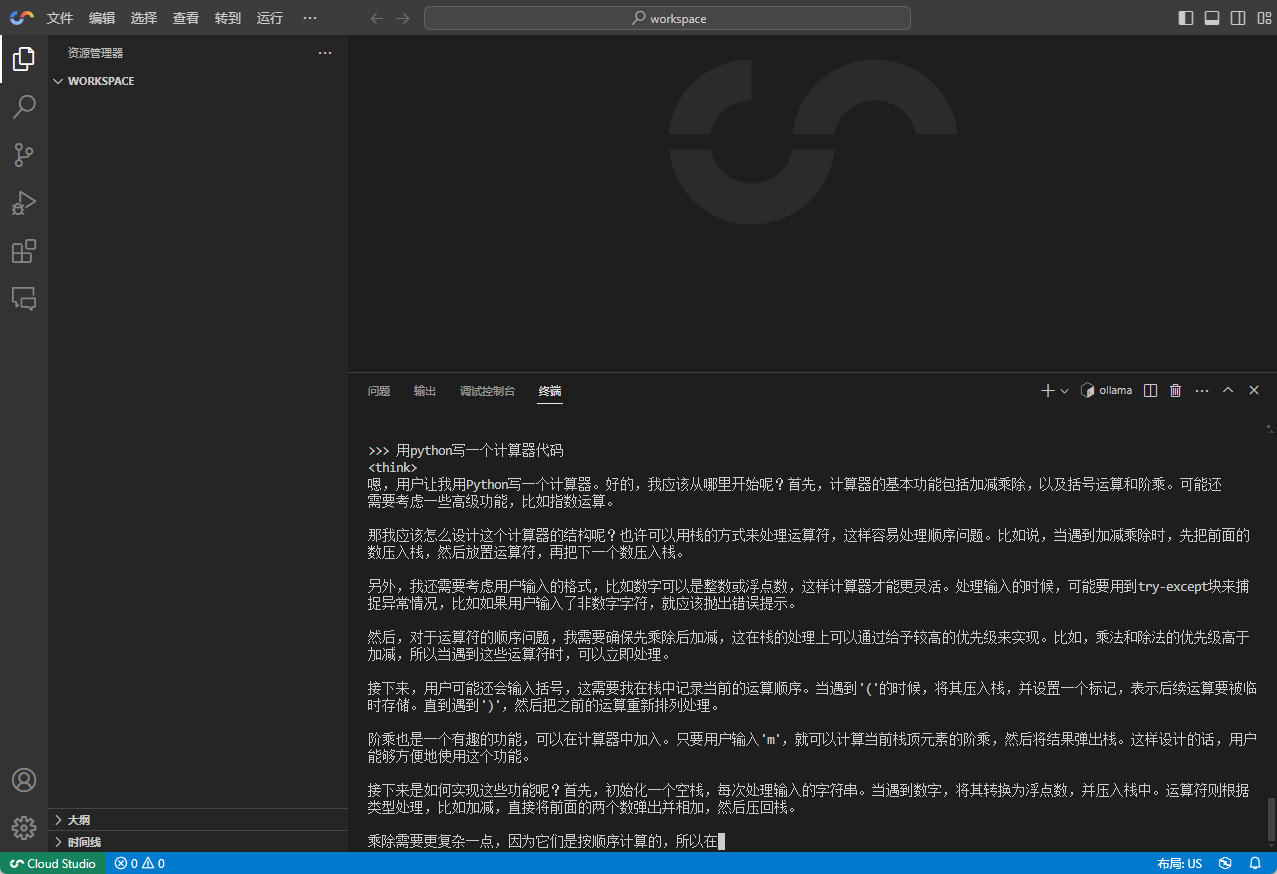

DeepSeek-R1との対話は非常にシンプルで、端末に質問や指示を入力するだけで、モデルが即座に返答を生成する。

4.2 複雑なタスク

- 例えば、DeepSeek-R1 によるコード生成

4.3 モデルの微調整

DeepSeek-R1 のパフォーマンスに満足できない場合や、特定のタスクでモデルのパフォーマンスを向上させたい場合は、モデルの微調整を行うことができます。Ollama は、ユーザがモデルの微調整を実行するのに役立つシンプルなインタフェースを提供します。

4.4 AIプログラミングツールでの使用

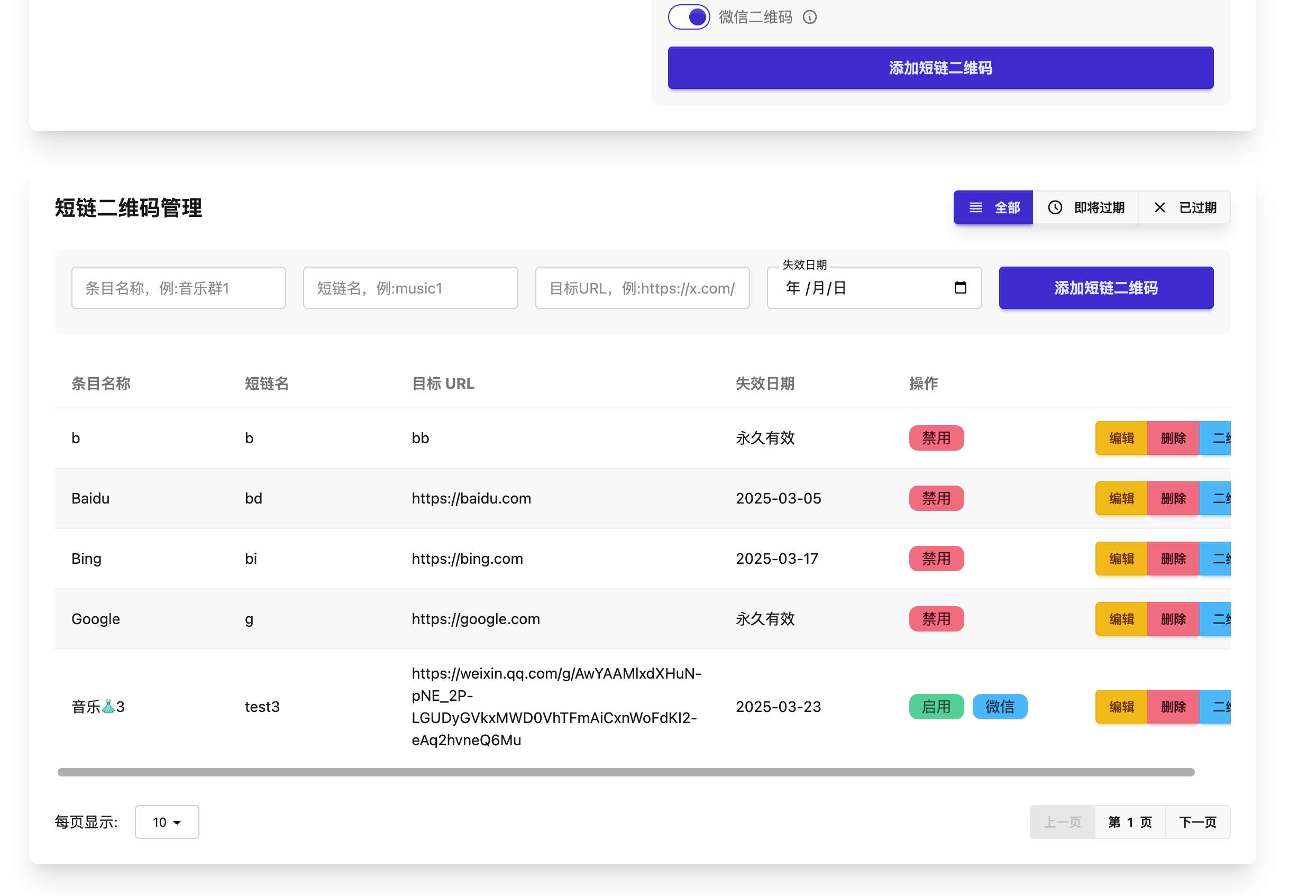

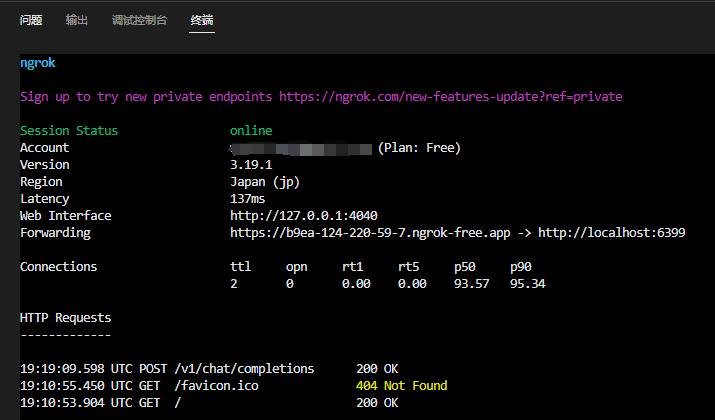

端末でサービスを利用することがメインシナリオではないのは確かで、実用化するためには他のチャットツールやAIプログラミングツールでサービスを利用する必要がある。Cloud Studioは外部アクセスアドレスを提供していない。この場合、ngrok/Cpolarが良い解決策になる。

唯一のアイデアを提供し、詳細な説明ではありません:イントラネットOllamaポートを照会する最初のステップは、ngrokをインストールする2番目のステップは、ngrokにOllamaポートをマップする3番目のステップは、サービスを開始するには、次のアドレスを取得します:

注:あなたの ollama serve このサービスはすでに始まっている。 6399 ポートで実行するには、次のコマンドを使用して Ngrok を起動し、ポートをエクストラネットにマッピングします:ngrok http 6399

エクストラネットが機能していることを確認する。

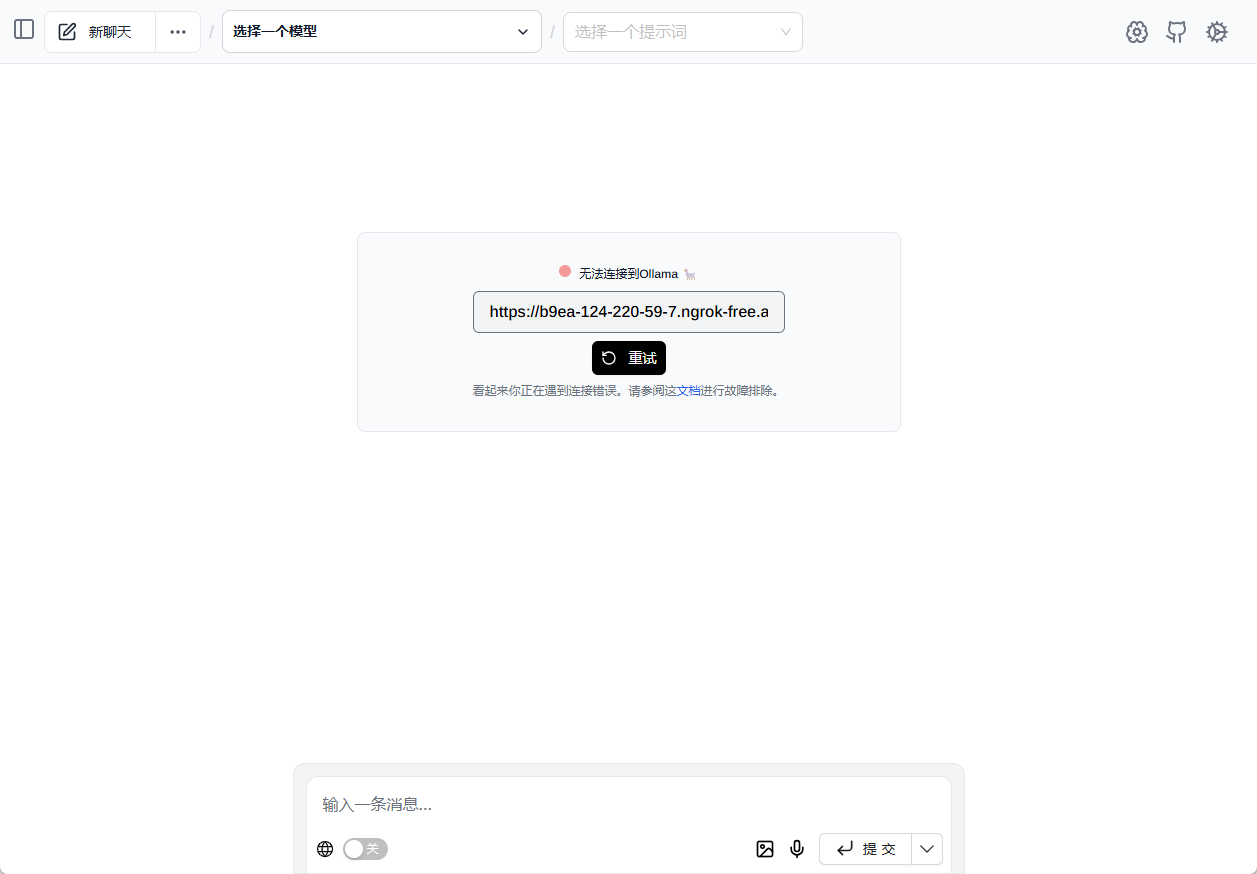

Ollama関連の機能を体験するには、ネイティブ・ブラウザ・プラグインの使用をお勧めします。 ページアシスト : (https://xxx.ngrok-free.app/ を直接入力すると、すべての Ollama モデルが自動的に読み込まれます。)

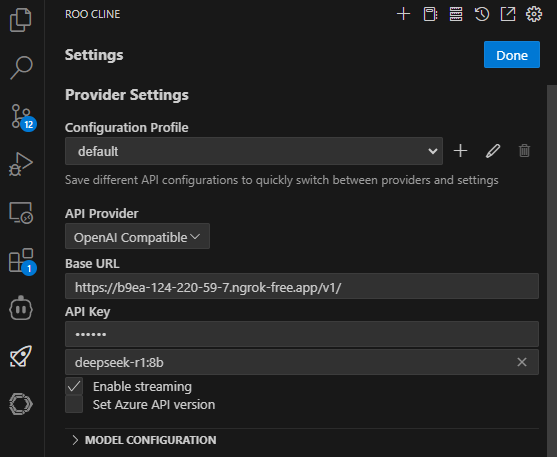

ある ルー・コード(ルー・クライン) クライアントでAPIを設定する: (Roo Codeは優れたAIプログラミングプラグインです)

元のURLとAPI KEYにv1が追加されていることに注意。

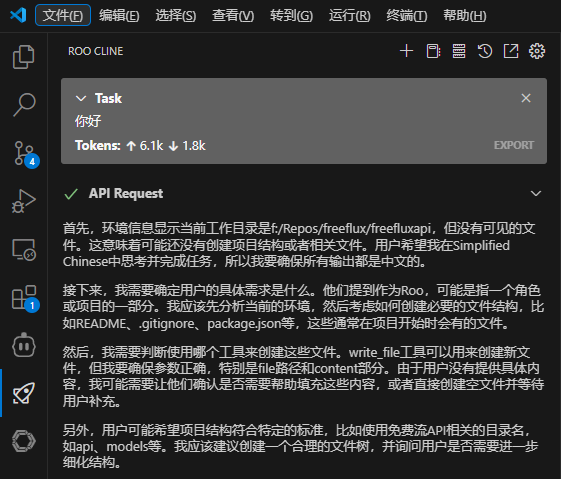

ダイアログを保存してテストする:

5.まとめ

Tencent Cloud Cloud Studioの無料のGPUリソースをOllamaとDeepSeek-R1と組み合わせることで、高額なハードウェアコストを心配することなく、クラウド上で大きなモデルを簡単に展開し、実行することができます。簡単な会話でも複雑な作業でも、DeepSeek-R1は強力なサポートを提供します。この記事が、DeepSeek-R1をスムーズに導入し、ビッグモデル探索の旅を始める一助となれば幸いです。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません