効率的なPDFテキスト抽出のための視覚言語モデリング - olmOCR

言語モデル(LM)は、AI技術の革新の中心的な原動力となっている。事前学習から実世界での応用まで、言語モデルはプレーンテキストデータに依存して機能する。何兆もの トークン レベルの学習や、データ集約的なAIアプリケーションをサポートするためには、テキストデータの品質が極めて重要である。低品質なテキストデータは、不安定な学習プロセスやモデル性能の低下につながるだけでなく、ユーザーから要求されたときに最適とは言えない出力を生成する可能性がある。

しかし、言語モデリングに必要なすべてのデータが、ウェブページのような容易に解析可能な形式で存在するわけではない。実際、多くの領域において、貴重な情報は電子文書ファイル、特にPDF形式に保存されている。PDF形式は、もともとテキストの論理構造を保持するのではなく、固定サイズのページ上にコンテンツを表示するように設計されているため、データ処理において独自の課題を提起している。たとえばPDFでは、テキストを一連の文字コードとして保存し、ページ上の各文字の位置と書式に関する情報を記録します。この保存は非常に効率的ですが、見出し、段落、表、数式などのテキスト単位をそこから復元し、正しい読み順に並べることが非常に難しくなります。

電子ドキュメントのより良い取り扱いのために、私たちは自信を持って提供します。 olmOCRolmOCRは、PDFや文書イメージを明確で構造化されたプレーンテキストに変換するために設計された高性能ツールキットです:

優れた性能

を確保するために olmOCR さまざまな文書から正確にテキストを抽出するために、開発チームは、さまざまなソースからの25万ページのPDFを使用してモデルを微調整しました。これらのPDF文書は、ネイティブのデジタル文書やパブリックドメインの書籍をスキャンしたものなど、幅広いソースから提供されました。このような多様なデータセットにより、olmOCRは様々な文書に対して優れたパフォーマンスを維持することができます。

極めて高い費用対効果

100万ページのPDF文書を処理するolmOCRツールキットのコストは約190ドルで、GPT-4o APIを使って同じページ数をバッチ処理するコストの約1/32です。 文書処理の経済的障壁を大幅に下げます。

マークダウン形式の出力

olmOCRは、解析と処理が容易なMarkdown形式でテキストを出力します。数式、表、手書きの内容まで扱うことができ、最も複雑な複数カラムのドキュメントレイアウトでも、正しい読み順で出力されます。

箱から出してすぐに使用可能

olmOCRは完全に最適化されたパイプラインで、SGLangと ブイエルエルエム 推論エンジンは連動して動作する。シングルGPUから数百のGPUまでスケールし、一般的な解析の失敗やメタデータのエラーを処理するヒューリスティックを内蔵している。

完全なオープンソース

olmOCRはQwen2-VL-7B-Instructで構築されている。開発チームは、モデルの重み、微調整されたデータセット、学習・推論コードを含むツールキットの全コンポーネントをオープンソース化している。

olmOCRと他の主要な文書抽出ツールとの比較や、olmOCRのビルドプロセスの詳細については、リンクを参照してください。olmOCRを試す準備ができたら、GitHubリポジトリにアクセスして、プロジェクトでolmOCRを使い始めてください!

インタラクティブ・ツールの比較

サンプル文書を比較することで、olmOCRが他の主要な文書抽出ツールと比較してどのように動作するかを視覚化できます。以下のタブを使用して、さまざまなツールの出力を表示し、処理品質の主な違いを把握することができます。

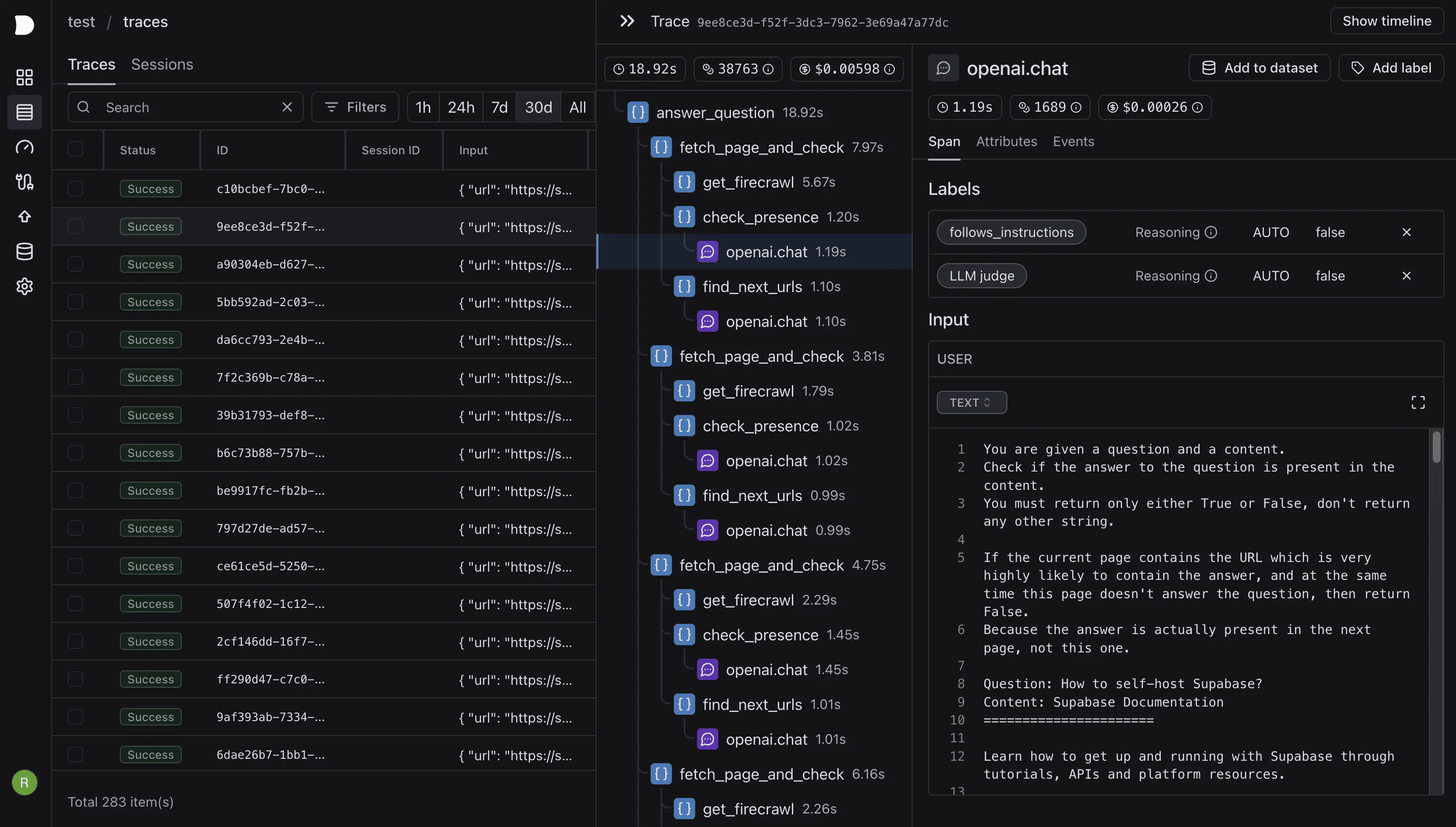

olmOCR構築への道

従来のOCR技術は、複雑なレイアウトを持つPDF文書を扱う場合、しばしば多くの課題に直面します。olmOCRを訓練するための高品質なデータを得るために、開発チームは革新的に次のような方法を開発しました。 ドキュメントアンカー PDFファイルからテキストを抽出する技術です。この手法では、PDFファイル内の既存のテキストとメタデータを最大限に活用し、テキスト抽出の品質を大幅に向上させます。

図1: 典型的なページにおけるドキュメント・アンカー技法の動作を示す。関連する画像位置とテキスト・ブロックが抽出され、一緒にリンクされ、モデル・プロンプトに挿入される。アンカーされたテキストは、VLM(Visual Language Model)запроситьからドキュメントのプレーン・テキスト・バージョンを要求する際に、ページのラスタライズ画像とともに使用される。

文書アンカリング技術の助けを借りて、開発チームはGPT-4oを使って25万ページをマークアップした。このデータセットは、ウェブからクロールされた一般公開のPDF文書や、Internet Archiveからスキャンされたパブリックドメインの書籍など、幅広いソースから得られたものである。データセットの種類は様々で、学術論文が60%、パンフレットが12%、法律文書が11%、図表が6%、スライドが5%、その他の文書が4%である。

モデルのトレーニングのために、olmOCRチームはQwen2-VL-7B-Instructチェックポイントを微調整し、大規模バッチ処理を実現し、推論パイプラインを最適化するためにSGLangを使用した。大規模なバッチ処理を実現し、推論パイプラインを最適化するために、彼らはSGLangを使用した。olmOCRは、わずか190ドルで、GPT-4o APIの1/32のコストで100万ページのPDFを変換することができた。実験結果は、olmOCRが他の一般的なOCRツールと比較して大幅にコストを削減するだけでなく、手動評価においても優れた性能を示すことを示している。実験結果は、olmOCRが他の一般的なOCRツールと比較してコストを大幅に削減するだけでなく、手動評価においても優れた性能を示すことを示しています。

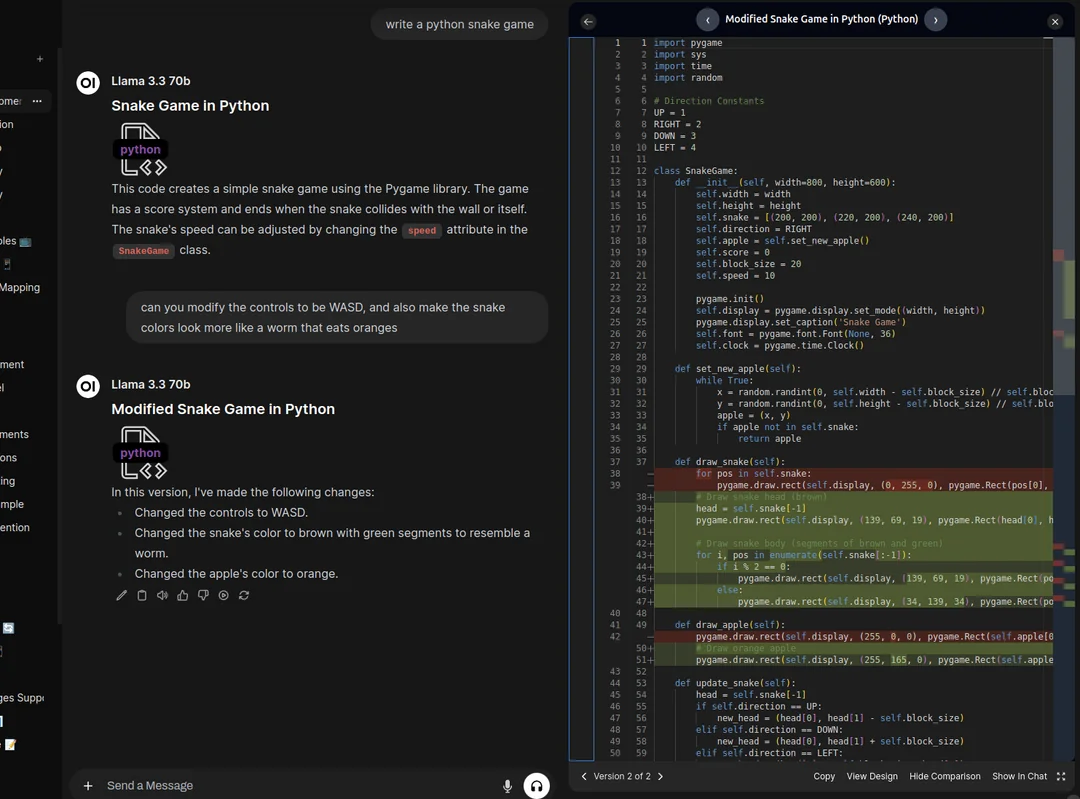

図2:他の一般的なツールに対するolmOCRのELOランキングのボックスプロット。

olmOCRの性能を完全に評価するため、チームはその出力をMarker、MinerU、GOT-OCR 2.0を含む他の一般的なPDF抽出ツールと比較した。2017年のPDF文書において、意味のある比較の452セットが収集され、ELOスコアを計算することで性能が定量化された。その結果、olmOCRのELOスコアは1,800を超え、すべての競合他社を大きく凌駕した。他のツールとの直接比較では、olmOCRのスコアは61.3%であった。 マーカー は、58.6%とGOT-OCRの比較で、また、58.6%とGOT-OCRの比較で優先された。 マイナーU この比率は、71.4%の比較ではさらに高く、明瞭で構造化されたテキストを生成するolmOCRの優れた能力を十分に示している。

より詳細な情報やその他の評価結果は、テクニカルレポートでご覧いただけます。

olmOCRの使い方

olmOCRの最初のバージョンには、デモ、モデルの重み、微調整されたデータセット、簡単な技術レポート、そして最も重要なこととして、効率的な推論パイプラインが含まれている。

GitHubリポジトリにアクセスしてolmOCRをインストールし、ドキュメントを確認する。その後、GPUを搭載したマシンで以下のコマンドを実行するだけだ:

python -m olmocr.pipeline ./localworkspace --pdfs tests/gnarly_pdfs/horribleocr.pdf

開発チームは近い将来、より優れたPDF抽出モデルの開発と、その性能をより効果的に評価するために、より定量的なベンチマークを公開したいと考えています。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません