R1-V: 視覚言語モデルの汎化能力のための低コスト強化学習

はじめに

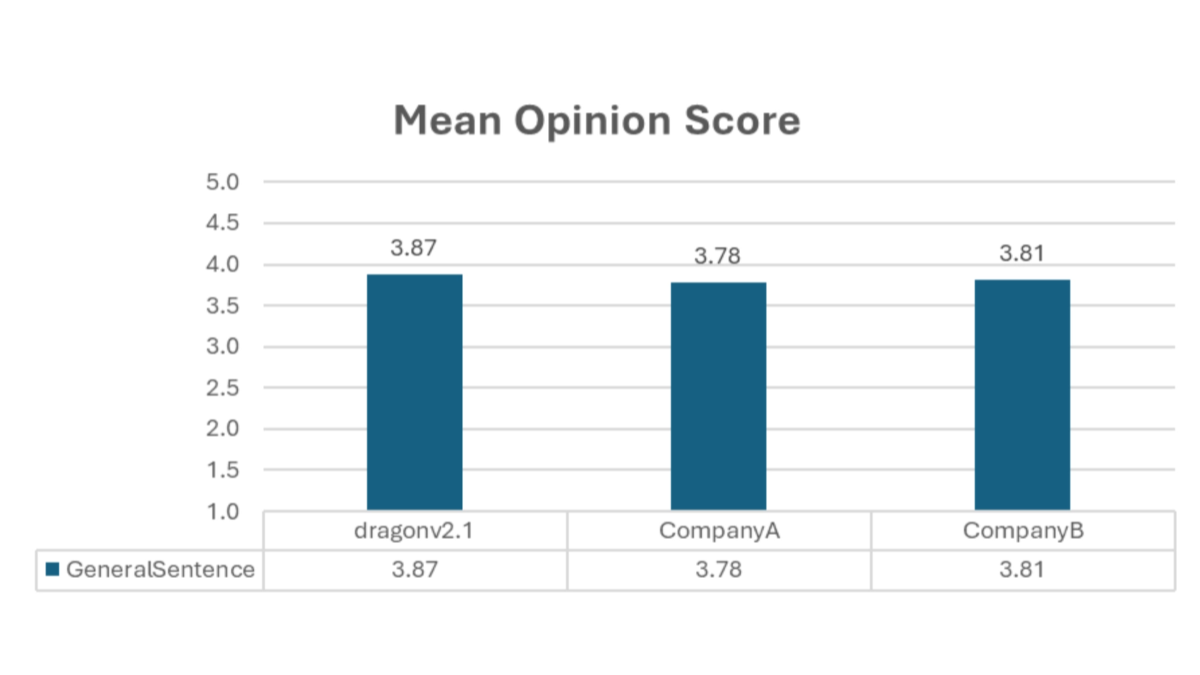

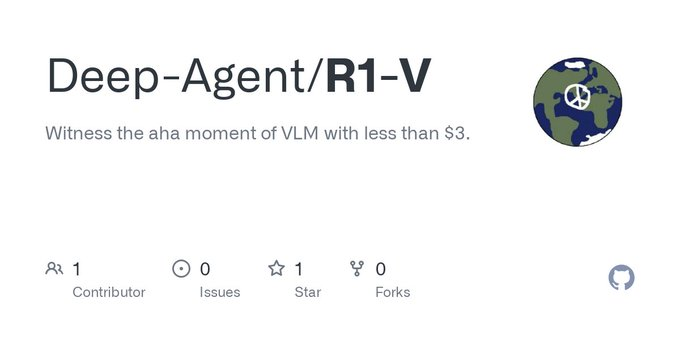

R1-Vは、低コスト強化学習(RL)を通じて視覚言語モデリング(VLM)のブレークスルーを目指すオープンソースプロジェクトである。このプロジェクトでは、検証可能な報酬メカニズムを利用して、VLMに一般的な計数能力を学習させる動機付けを行っている。驚くべきことに、R1-Vの2Bモデルは、わずか100回の学習ステップで72Bモデルを上回った。R1-Vプロジェクトは完全なオープンソースであり、ユーザーはGitHubプラットフォームを通じてR1-Vモデルにアクセスしコードを提供することで、R1-Vモデルを使って実験や開発を行い、AIの無限の可能性を探求することができる。

機能一覧

- 視覚言語モデル画像データとテキストデータを組み合わせて処理・分析。

- 集中学習検証可能な報酬メカニズムによってモデルの一般性を高める。

- 低コストのトレーニング短期間、低コストで効率的なトレーニングが可能。

- ディープラーニング複雑な深層学習タスクをサポートし、モデルの精度と効率を向上させます。

- 自然言語処理多言語サポートによる自然言語テキストの処理と理解。

- コンピュータビジョン画像の内容を分析・理解し、画像の分類やターゲットの検出などのタスクをサポートします。

- オープンソース完全なオープンソースコードは、簡単にダウンロード、変更、貢献することができます。

- 地域支援技術サポートとコミュニケーションのプラットフォームを提供する活発な開発者コミュニティ。

ヘルプの使用

設置プロセス

- クローン倉庫ターミナルで以下のコマンドを実行し、プロジェクトのリポジトリをクローンする:

git clone https://github.com/Deep-Agent/R1-V.git

- 依存関係のインストールプロジェクト・ディレクトリに移動し、必要な依存関係をインストールする:

cd R1-V

pip install -r requirements.txt

- 設定環境プロジェクトの要件に応じて、環境変数やパスを設定する。

使用方法

- 積載モデルコードにR1-Vモデルをロードする:

from r1v import R1VModel

model = R1VModel()

- 画像とテキストの処理画像やテキストデータを処理するためにモデルを使用します:

image_path = 'path/to/image.jpg'

text = '描述图像的文本'

result = model.process(image_path, text)

print(result)

- トレーニングモデル特定のタスクに適合するように、必要に応じてモデルを訓練する:

model.train(data_loader)

詳細な機能操作の流れ

- 画像分類画像を読み込み、分類のためにモデルを使用します:

from PIL import Image

image = Image.open('path/to/image.jpg')

classification = model.classify(image)

print(classification)

- ターゲット検出モデルを使ったターゲット検出

detections = model.detect_objects(image)

for detection in detections:

print(detection)

- テキスト生成画像から説明文を生成します:

description = model.generate_text(image)

print(description)© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません